Les robots d’indexation web, ce sont un peu les petites mains invisibles du web. À chaque fois que tu cherches une nouvelle recette, compares les prix de tes sneakers favorites ou prépares tes prochaines vacances, il y a de grandes chances qu’un robot soit déjà passé par là pour collecter et organiser toutes les infos que tu consultes. Aujourd’hui, plus de vient de robots et de crawlers, pas d’humains. En gros, pendant que tu dors, ces éclaireurs numériques bossent non-stop pour rendre l’info accessible en un clin d’œil.

Mais au fond, c’est quoi un robot d’indexation web ? Pourquoi ils sont devenus indispensables pour les boîtes, les chercheurs, ou toute personne qui a besoin de données fraîches ? Et comment des solutions modernes comme ont rendu ces outils accessibles à tout le monde, même si tu n’es ni dev ni expert tech ? Après des années à bidouiller des outils d’automatisation et d’IA, j’ai vu de mes propres yeux comment ces « araignées » du web sont devenues des alliées incontournables dans la vie pro. Allez, on plonge ensemble dans l’univers des robots d’indexation web : comment ça marche, à quoi ça sert, et pourquoi c’est devenu la clé d’un accès intelligent à la donnée en 2025.

Les robots d’indexation web, éclaireurs de la donnée sur Internet

Alors, concrètement, c’est quoi un robot d’indexation web ? Pour faire simple, un robot d’indexation web (aussi appelé spider ou bot) est un programme automatisé qui parcourt Internet de façon méthodique, page après page, pour collecter des infos. Imagine le stagiaire le plus motivé du monde : il ne dort jamais, ne râle jamais, et peut visiter des millions de pages en une journée.

Un robot d’indexation commence avec une liste d’adresses web (les « seeds »), visite chacune d’elles, puis suit les liens pour découvrir de nouvelles pages. Au fil de son exploration, il copie le contenu, indexe les données et cartographie le web qui change tout le temps (). C’est comme ça que les moteurs de recherche comme Google savent ce qui existe, et que les comparateurs de prix ou les outils d’études de marché gardent leurs infos à jour.

En résumé : les robots d’indexation sont les éclaireurs qui rendent le web consultable, comparable et exploitable.

Les multiples visages des robots d’indexation : types et fonctions principales

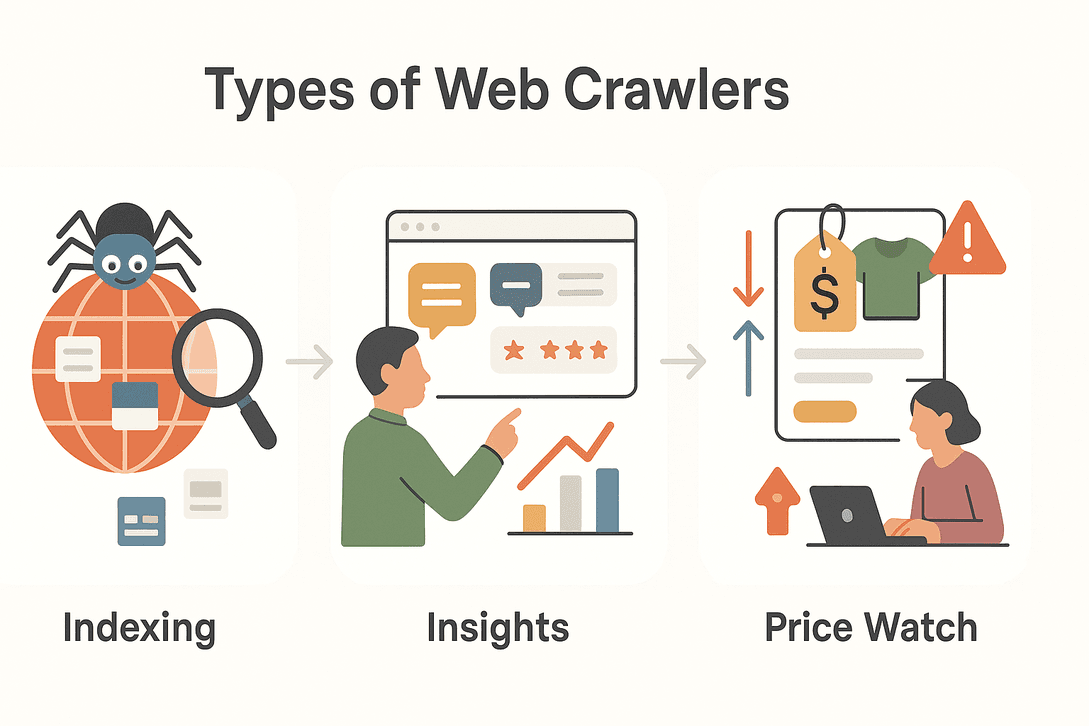

Tous les robots d’indexation n’ont pas le même job. Selon leur mission, ils se déclinent en plusieurs familles, chacune avec sa spécialité. Petit tour d’horizon des principaux types :

Tous les robots d’indexation n’ont pas le même job. Selon leur mission, ils se déclinent en plusieurs familles, chacune avec sa spécialité. Petit tour d’horizon des principaux types :

| Type | Fonction principale | Cas d’usage typique |

|---|---|---|

| Robots d’indexation de moteurs de recherche | Indexer le web pour les résultats de recherche | Googlebot, Bingbot pour l’indexation de nouveaux sites |

| Robots de data mining | Collecter de grands volumes de données pour analyse | Études de marché, recherches académiques |

| Robots de veille tarifaire | Suivre les prix et la disponibilité des produits | Comparateurs e-commerce, tarification dynamique |

| Robots d’agrégation de contenu | Rassembler articles, actualités ou posts | Portails d’actualités, curation de contenu |

| Robots de génération de leads | Extraire des contacts et données d’entreprises | Prospection commerciale, annuaires B2B |

Décryptons quelques-uns de ces types :

Robots d’indexation pour moteurs de recherche

Quand tu poses une question à Google, tu profites du boulot de ces robots. Ils parcourent le web en continu, découvrent de nouvelles pages, mettent à jour les anciennes et indexent le contenu pour qu’il soit dispo dans les résultats de recherche. Sans eux, les moteurs de recherche seraient perdus, incapables de savoir ce qui est nouveau ou ce qui a changé ().

Robots de data mining et d’études de marché

Les entreprises et les chercheurs s’appuient sur ces robots pour collecter des tonnes de données à analyser. Tu veux savoir combien de fois une marque concurrente est citée en ligne ? Ou suivre la perception d’un nouveau produit ? Les robots de data mining fouillent forums, avis, réseaux sociaux, et transforment ce bazar en infos structurées ().

Robots de veille tarifaire et suivi de produits

Dans l’e-commerce, les prix et les stocks bougent tout le temps. Les robots de veille tarifaire surveillent la concurrence, alertent sur les baisses de prix, les ruptures ou les nouveaux produits. Ça permet d’ajuster sa stratégie tarifaire et de rester dans la course ().

Pourquoi les robots d’indexation sont essentiels à l’accès moderne à la donnée

Soyons clairs : le web est bien trop vaste pour être exploré à la main. Il y a , et des milliers de nouvelles pages débarquent chaque minute. Les robots d’indexation permettent de :

- Collecter des données à grande échelle : Visiter des millions de pages en quelques heures.

- Rester à jour : Surveiller en continu les changements, nouveaux contenus ou actus.

- Accéder à de l’info dynamique et en temps réel : Réagir aux évolutions du marché, aux variations de prix ou aux tendances du moment.

- Prendre des décisions pilotées par la donnée : Alimenter moteurs de recherche, études de marché, gestion des risques ou modélisation financière ().

À l’ère où , les robots d’indexation sont les moteurs qui font circuler l’info.

Exemples d’utilisation des robots d’indexation dans différents secteurs

Les robots d’indexation ne sont pas réservés aux géants de la tech ou aux moteurs de recherche. Voilà comment différents secteurs les utilisent :

| Secteur | Cas d’usage | Bénéfice |

|---|---|---|

| Commercial | Génération de leads | Constituer des listes de prospects ciblés à partir d’annuaires |

| E-commerce | Veille tarifaire | Suivre les prix, stocks et nouveautés des concurrents |

| Marketing | Agrégation de contenu | Centraliser actualités, articles et mentions sur les réseaux |

| Immobilier | Agrégation d’annonces | Fusionner les annonces de plusieurs sources |

| Tourisme | Comparaison de tarifs et hôtels | Suivre prix, disponibilités et conditions |

| Finance | Veille des risques | Surveiller actualités, dépôts et tendances pour l’investissement |

Exemple concret :

Une agence immobilière utilise des robots pour extraire les détails, photos et équipements de biens depuis plusieurs sites, offrant ainsi à ses clients une vision complète et à jour du marché ().

Une équipe e-commerce configure des robots pour surveiller les références et prix des concurrents, et ajuste sa stratégie en temps réel ().

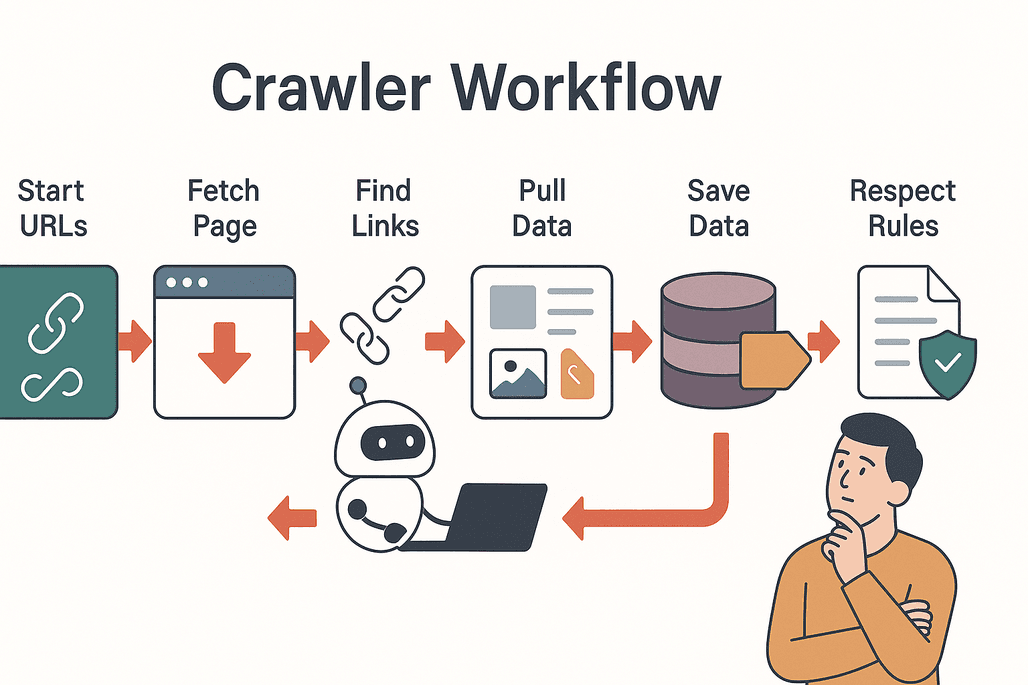

Comment fonctionne un robot d’indexation web : étape par étape

On va démystifier le truc. Voici comment bosse un robot d’indexation classique :

On va démystifier le truc. Voici comment bosse un robot d’indexation classique :

- Démarrage avec des seeds : Le robot commence avec une liste d’URLs de départ.

- Visite et récupération : Il visite chaque page et en télécharge le contenu.

- Extraction des liens : Il repère tous les liens présents sur la page.

- Suivi des liens : Il ajoute les nouveaux liens non visités à sa file d’attente.

- Extraction des données : Les infos importantes (texte, images, prix, etc.) sont copiées et structurées.

- Stockage des résultats : Les données sont enregistrées dans une base ou exportées pour analyse.

- Respect des règles : Le robot consulte le fichier

robots.txtde chaque site pour connaître les restrictions et éviter les zones interdites ().

Bonnes pratiques :

- Parcourir les sites sans les surcharger.

- Respecter la vie privée et la législation.

- Éviter les doublons et les requêtes inutiles.

Défis et points de vigilance avec les robots d’indexation

L’indexation web, ce n’est pas toujours un long fleuve tranquille. Voici les principaux défis :

- Charge serveur : Trop de requêtes peuvent ralentir ou bloquer un site.

- Contenu dupliqué : Les robots peuvent revisiter les mêmes pages ou tourner en rond.

- Vie privée et légalité : Toutes les données ne sont pas exploitables librement ; il faut vérifier les conditions d’utilisation et la législation.

- Barrières techniques : Certains sites utilisent des CAPTCHAs, du contenu dynamique ou des protections anti-bot ().

Conseils pour réussir :

- Adopter un rythme de crawl respectueux.

- Surveiller les évolutions de la structure des sites.

- Se tenir à jour sur la réglementation des données.

Thunderbit : rendre les robots d’indexation accessibles à tous

C’est là que tout change. Avant, mettre en place un robot d’indexation, c’était du code, des configs, et des heures de débogage. Avec , tout devient simple.

Thunderbit, c’est une extension Chrome d’extracteur web IA, pensée pour les pros – zéro code à écrire. Voilà ce que ça propose :

- Instructions en langage naturel : Tu décris ce que tu veux (« Récupère tous les noms et prix des produits de cette page »), l’IA de Thunderbit s’occupe du reste.

- Suggestions de champs par IA : Clique sur « Suggérer des champs IA » et Thunderbit analyse la page pour te recommander les colonnes à extraire.

- Extraction sur sous-pages : Besoin de détails ? Thunderbit peut visiter chaque sous-page (fiche produit, profil LinkedIn…) et enrichir automatiquement ton jeu de données.

- Modèles instantanés : Pour les sites connus (Amazon, Zillow, Shopify…), utilise des modèles prêts à l’emploi pour extraire les données en un clic.

- Export facile : Envoie tes données direct vers Excel, Google Sheets, Airtable ou Notion, sans prise de tête.

- Export gratuit : Télécharge tes résultats en CSV ou JSON, sans frais.

Thunderbit est déjà adopté par , des équipes commerciales aux e-commerçants en passant par les pros de l’immobilier.

Thunderbit vs. robots d’indexation traditionnels

Petit comparatif entre Thunderbit et la méthode classique :

| Fonctionnalité | Thunderbit | Robots traditionnels |

|---|---|---|

| Temps de configuration | 2 clics (l’IA gère tout) | Heures/jours (config manuelle, code) |

| Compétences requises | Aucune (instructions en français) | Élevées (programmation, sélecteurs) |

| Flexibilité | Fonctionne sur tout site, s’adapte aux changements | Fragile face aux modifications de site |

| Extraction sur sous-pages | Intégrée, sans configuration | Script manuel nécessaire |

| Options d’export | Excel, Sheets, Airtable, Notion, CSV, JSON | Généralement CSV/JSON uniquement |

| Maintenance | L’IA s’adapte automatiquement | Corrections manuelles fréquentes |

Avec Thunderbit, pas besoin d’être dev ou d’y passer des heures. Tu pointes, tu cliques, et l’IA fait le reste ().

Démarrer avec les robots d’indexation grâce à Thunderbit

Prêt à tester ? Voici comment te lancer avec Thunderbit en quelques minutes :

- Installe l’.

- Ouvre le site que tu veux explorer.

- Clique sur l’icône Thunderbit puis sur « Suggérer des champs IA ». L’IA te proposera les colonnes pertinentes selon la page.

- Ajuste les champs si besoin, puis clique sur « Extraire ». Thunderbit va collecter les données, y compris sur les sous-pages si tu veux.

- Exporte tes résultats vers Excel, Google Sheets, Airtable, Notion, ou télécharge-les en CSV/JSON.

Et voilà : pas de modèles à créer, pas de code, pas de prise de tête. Que tu veuilles suivre des prix, te constituer une base de prospects ou agréger des actus, Thunderbit rend l’indexation web aussi simple que commander à manger sur une appli.

Conclusion : les robots d’indexation, clé d’un accès intelligent à la donnée

Les robots d’indexation sont les moteurs invisibles de notre monde digital, rendant l’info accessible, consultable et exploitable par tous. Des moteurs de recherche aux équipes commerciales, de l’e-commerce à l’immobilier, ils sont devenus incontournables pour obtenir des données fiables et à jour.

Et grâce à des outils modernes boostés à l’IA comme , plus besoin d’être informaticien pour en profiter. En quelques clics, tu peux transformer le web en une ressource structurée et exploitable, pour prendre de meilleures décisions et saisir de nouvelles opportunités.

Envie de voir ce que les robots d’indexation peuvent apporter à ton activité ? et commence à explorer les données cachées du web dès aujourd’hui. Pour plus d’astuces et d’analyses, passe sur le .

FAQ

1. Qu’est-ce qu’un robot d’indexation web ?

Un robot d’indexation web est un programme automatisé (aussi appelé spider ou bot) qui parcourt Internet de façon systématique, visite les pages, suit les liens et collecte des infos pour l’indexation ou l’analyse.

2. Quelle différence entre robot d’indexation et extracteur web ?

Les robots d’indexation sont faits pour explorer et cartographier de larges parties du web, en suivant les liens de page en page. Les extracteurs web, eux, se concentrent sur l’extraction de données précises sur des pages ciblées. Beaucoup d’outils modernes (comme Thunderbit) combinent les deux.

3. Pourquoi les robots d’indexation sont-ils importants pour les entreprises ?

Ils permettent aux entreprises d’accéder à des infos fraîches à grande échelle : veille concurrentielle, agrégation de contenu, constitution de listes de prospects… Ils facilitent la prise de décision en temps réel et aident à rester compétitif.

4. Est-il légal d’utiliser des robots d’indexation ?

L’indexation web est généralement légale si elle est faite de façon responsable et dans le respect des conditions d’utilisation et de la politique de confidentialité du site. Il est important de consulter le fichier robots.txt et de respecter la réglementation sur la protection des données.

5. Comment Thunderbit simplifie-t-il l’indexation web ?

Thunderbit utilise l’IA pour automatiser la configuration, la sélection des champs et l’extraction des données. Grâce aux instructions en langage naturel et aux modèles instantanés, tout le monde peut explorer et extraire des données de sites web, sans compétences techniques. Les données peuvent être exportées direct vers Excel, Google Sheets, Airtable ou Notion pour une utilisation immédiate.

En savoir plus