Le web, c’est un vrai océan de données, et que tu bosses dans la vente, les opérations ou n’importe quel autre service aujourd’hui, tu as sûrement déjà ressenti la pression de transformer ce bazar en infos vraiment utiles. J’ai vu pas mal d’équipes galérer à automatiser la collecte de données—que ce soit pour trouver des prospects, surveiller les prix ou analyser le marché. Franchement, personne n’a envie de passer ses journées à faire du copier-coller depuis des sites web. C’est là que l’extraction web prend tout son sens, et pourquoi Python est devenu le langage incontournable pour ce boulot.

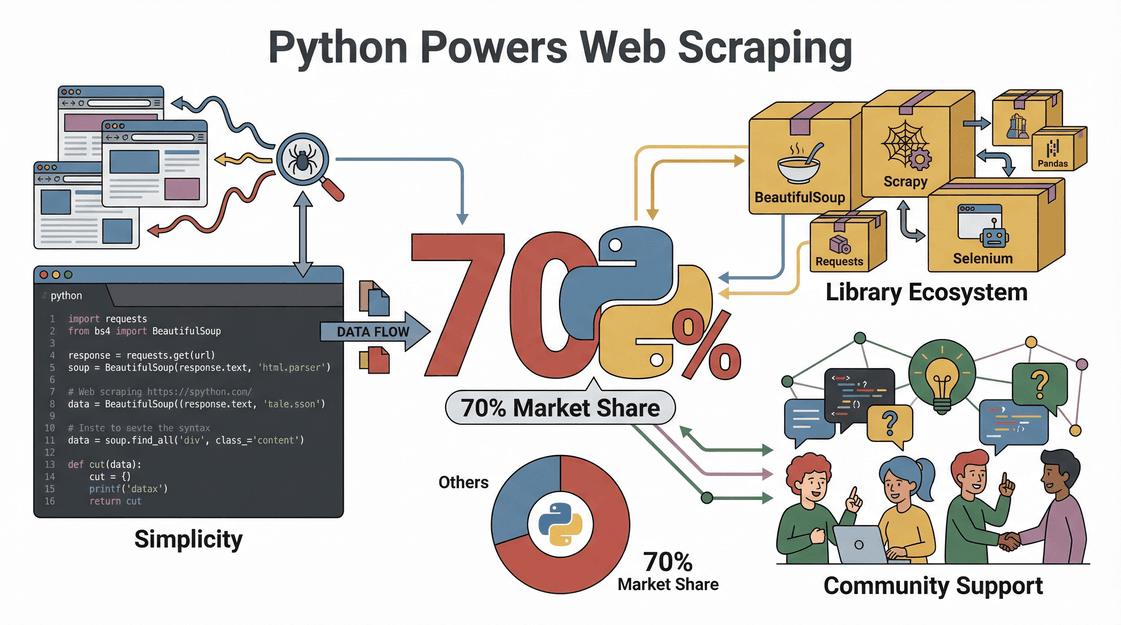

Si Python cartonne autant pour l’extraction web, ce n’est pas juste un effet de mode—les chiffres sont là. Près de tournent sous Python, grâce à sa simplicité, son énorme choix de bibliothèques et une communauté toujours prête à dépanner. Dans ce guide, je vais te montrer étape par étape comment extraire des données web avec Python, de l’installation à ton premier script—et je t’expliquerai aussi comment peut rendre tout ça encore plus simple, surtout si tu préfères cliquer que coder.

Qu'est-ce que l'extraction web et pourquoi utiliser Python ?

On commence par la base. L’extraction web, c’est le fait de récupérer automatiquement des données sur des sites—imagine un assistant digital qui va copier les infos d’une page et les coller dans un tableau, mais en mille fois plus rapide et sans jamais demander de pause café. Les boîtes s’en servent pour tout : .

Mais alors, pourquoi Python est-il le chouchou de l’extraction web ?

- Ultra simple à prendre en main : La syntaxe de Python est limpide, même si tu n’es pas un pro du code.

- Des bibliothèques qui font tout : Requests, BeautifulSoup, Selenium, Scrapy… Python gère tout, du HTML basique aux sites blindés de JavaScript.

- Une communauté hyper active : Si tu bloques, il y a toujours quelqu’un sur Stack Overflow ou GitHub qui a déjà trouvé la solution.

- Rapide et flexible : Les scripts Python s’adaptent à tous les sites et passent sans souci du petit projet à l’extraction massive.

Bref, Python, c’est le couteau suisse de l’extraction web : puissant, souple et super accessible.

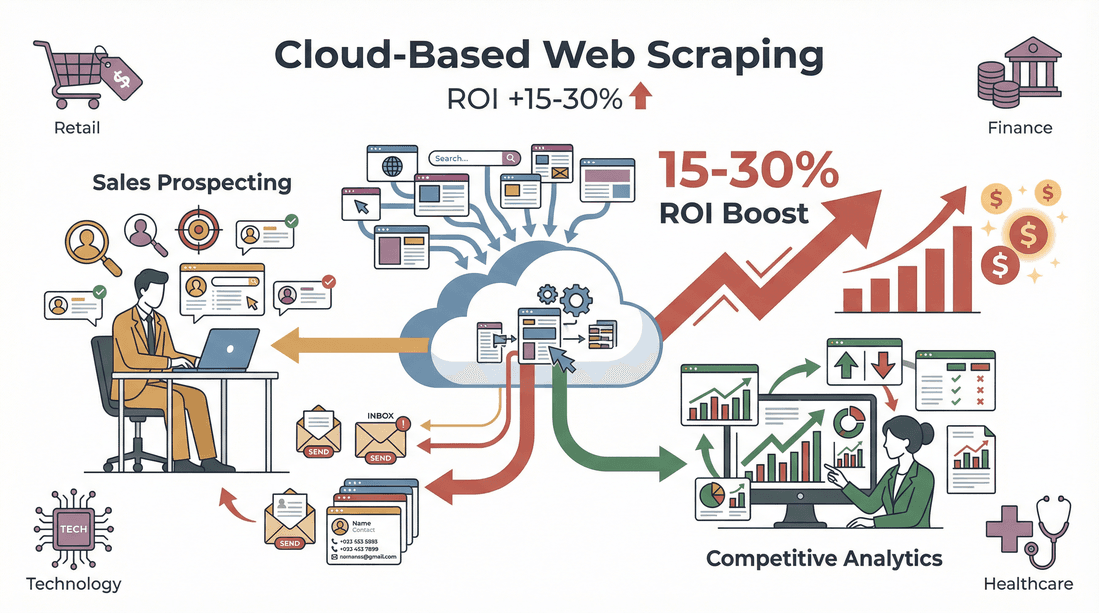

L'intérêt business : comment l'extraction web avec Python booste vos résultats

L’extraction web, ce n’est pas juste un truc de geek—c’est un vrai booster pour les boîtes. Voilà comment Python aide à prendre l’avantage :

| Cas d'usage | Comment Python aide | Impact business |

|---|---|---|

| Génération de leads | Extraire des contacts depuis des annuaires, LinkedIn… | Remplissez votre CRM avec des leads ciblés et récents |

| Veille tarifaire | Suivre les prix des concurrents sur les sites e-commerce | Adaptez vos prix en temps réel et restez compétitif |

| Étude de marché | Agréger avis, articles ou mentions sur les réseaux | Identifiez les tendances et prenez des décisions éclairées |

| Collecte de données immobilières | Extraire les annonces de plusieurs sites | Constituez des bases de données marché à jour |

| Gestion de catalogue produit | Récupérer specs et stocks chez les fournisseurs | Automatisez la mise à jour des stocks et limitez les erreurs manuelles |

Et côté retour sur investissement ? Une a montré que l’automatisation de la collecte de leads a fait gagner 8 heures par semaine aux recruteurs. Dans tous les secteurs, pour la prospection et l’analyse concurrentielle.

Préparer votre environnement Python pour l'extraction web

Avant de te lancer, il faut installer Python. Voici comment je te conseille de préparer ton environnement, même si tu débutes.

1. Installer Python

- Télécharge Python : Va sur le et prends la dernière version (3.10+ c’est top).

- Ajoute Python au PATH : Sous Windows, coche la case « Ajouter Python au PATH » pendant l’installation. Ça t’évitera des galères pour lancer Python depuis le terminal ().

2. Crée un environnement virtuel

Un environnement virtuel, c’est la base pour éviter que tes bibliothèques se marchent dessus.

1# Sous Windows

2python -m venv venv

3venv\Scripts\activate

4# Sous Mac/Linux

5python3 -m venv venv

6source venv/bin/activate3. Choisis ton éditeur de code

- VS Code : Gratuit, léger, plein d’extensions.

- PyCharm : Parfait pour les gros projets, avec de l’aide intelligente.

- Jupyter Notebook : Idéal pour tester et visualiser tes données.

4. Astuces de dépannage

- Si Python n’est pas reconnu, vérifie ton PATH.

- Si tu as une erreur de permission, lance le terminal en admin.

- Sur Mac, il faut parfois installer les outils Xcode (

xcode-select --install).

Choisir les bonnes bibliothèques Python pour l'extraction web

La vraie force de Python, c’est ses bibliothèques. Voici les plus populaires et quand les utiliser :

| Bibliothèque | Idéal pour | Facilité d'utilisation | Vitesse | Support JavaScript | Scalabilité |

|---|---|---|---|---|---|

| Requests | Récupérer des pages web (HTTP) | Facile | Rapide | Non | Bonne |

| BeautifulSoup | Analyser du HTML/XML | Très facile | Moyenne | Non | Bonne |

| lxml | Parsing XML/HTML ultra-rapide | Moyenne | Très rapide | Non | Bonne |

| Selenium | Gérer des sites dynamiques | Moyenne | Lente | Oui (navigateur complet) | Moyenne |

| Scrapy | Extraction automatisée à grande échelle | Moyenne | Très rapide | Partiel/Oui | Excellente |

- Requests : parfait pour les requêtes HTTP simples.

- BeautifulSoup : super accessible pour extraire des données HTML.

- lxml : ultra-rapide pour les gros volumes, un peu plus technique.

- Selenium : ouvre un vrai navigateur, nickel pour les sites blindés de JavaScript.

- Scrapy : le framework costaud pour les gros projets d’extraction.

Pour commencer, le duo Requests + BeautifulSoup, c’est le combo gagnant ().

Tutoriel pas à pas : comment extraire des données web avec Python

Prenons un exemple concret : extraire des infos produits d’un site e-commerce (fictif).

1. Inspecte la structure du site

Ouvre les outils développeur de ton navigateur (F12 ou clic droit > Inspecter). Repère les balises HTML qui contiennent les infos que tu veux—titres, prix, notes… C’est crucial pour bien cibler ce que tu veux extraire ().

2. Envoie une requête HTTP

Utilise Requests pour choper la page.

1import requests

2url = "https://example.com/products"

3response = requests.get(url)

4html = response.text3. Analyse le HTML avec BeautifulSoup

Récupère les données qui t’intéressent.

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3products = soup.find_all("div", class_="product-card")4. Extrais et nettoie les données

Parcours chaque produit pour choper les infos.

1data = []

2for product in products:

3 title = product.find("h2", class_="title").text.strip()

4 price = product.find("span", class_="price").text.strip()

5 rating = product.find("span", class_="rating").text.strip()

6 # Nettoie le prix pour les calculs

7 price_num = float(price.replace("$", ""))

8 data.append({"title": title, "price": price_num, "rating": rating})5. Exporte les données en CSV/Excel

Utilise Pandas pour sauvegarder tout ça.

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4df.to_excel("products.xlsx", index=False)()

Et voilà—tes données sont prêtes à être analysées ou importées dans ton CRM.

Gérer le contenu dynamique et la pagination

Tous les sites ne sont pas aussi simples. Certains chargent les données en JavaScript ou répartissent les résultats sur plusieurs pages. Voici comment gérer ça :

Extraction de contenu dynamique

Si tu récupères des pages vides ou incomplètes, c’est sûrement du contenu dynamique. Utilise Selenium :

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/products")

4html = driver.page_source

5# Utilise BeautifulSoup comme avant()

Gérer la pagination

Pour extraire plusieurs pages, boucle sur les numéros de page ou les boutons « Suivant ».

1for page in range(1, 6):

2 url = f"https://example.com/products?page={page}"

3 response = requests.get(url)

4 # Analyse et extrais comme avant()

Pour les gros volumes, Scrapy peut crawler des centaines de pages tout seul ().

Exporter et exploiter vos données extraites

Une fois tes données récupérées, il faut les utiliser.

- Export en CSV/Excel : Comme vu plus haut, Pandas gère ça en deux lignes.

- Nettoyage et normalisation : Vire les doublons, corrige les erreurs et uniformise les formats ().

- Intégration dans tes outils : Importe ton CSV dans Salesforce, HubSpot ou ton outil d’analyse préféré. Tu peux même automatiser tout ça avec des scripts Python.

Thunderbit : simplifier l'extraction web Python pour les équipes métier

On va être honnête—Python, c’est puissant, mais ce n’est pas toujours le plus rapide si tu n’es pas développeur. C’est pour ça qu’on a créé , une pensée pour les pros qui veulent des résultats sans prise de tête.

Pourquoi Thunderbit change la donne pour les équipes commerciales et opérationnelles ?

- Cartographie IA des champs : Clique sur « Suggestions IA » et Thunderbit analyse la page, propose les colonnes (Nom, Prix, Email…) et configure tout tout seul—fini la galère du mapping manuel.

- Extraction de sous-pages : Thunderbit peut visiter chaque sous-page (fiche produit, profil LinkedIn…) et enrichir ton tableau avec encore plus d’infos.

- Pagination et contenu dynamique : Gère les listes paginées et le scroll infini sans coder.

- Modèles instantanés : Pour les sites connus (Amazon, Zillow, Shopify…), choisis un modèle et clique sur « Extraire ».

- Export gratuit des données : Exporte direct vers Excel, Google Sheets, Airtable ou Notion—zéro friction.

- Aucune maintenance : L’IA de Thunderbit s’adapte aux changements de sites, plus besoin de réparer des scripts qui plantent.

J’ai vu des utilisateurs passer de « Je ne sais pas par où commencer » à « Voilà mon tableau prêt » en moins de cinq minutes. Et oui, il y a une pour tester sans engagement.

Combiner Thunderbit et Python : la boîte à outils ultime pour la collecte de données

Si tu es un utilisateur avancé ou un analyste, pas besoin de choisir entre Thunderbit et Python—utilise les deux ! Voici comment je mixe les deux approches :

- Extraction rapide avec Thunderbit : Récupère vite des données structurées sur des sites complexes ou inconnus, puis exporte-les en CSV ou Excel.

- Traitement avec Python : Charge les données dans Pandas pour les nettoyer, les analyser ou automatiser des traitements avancés.

- Automatisation des workflows : Programme des extractions régulières avec Thunderbit, puis lance des scripts Python pour traiter et envoyer les données où tu veux.

Cette approche hybride te permet d’aller vite, de rester flexible et d’éviter de tout refaire à chaque nouveau projet.

Aspects légaux et éthiques de l'extraction web

On ne va pas se mentir : l’extraction web, c’est légal ? La réponse courte : oui—si tu respectes les règles.

- Respecte robots.txt et les conditions d’utilisation : Certains sites interdisent l’extraction ; vérifie toujours avant de te lancer ().

- N’extrais pas de données personnelles ou protégées : Reste sur les infos publiques et factuelles.

- Modère tes requêtes : N’inonde pas les serveurs. Ajoute des pauses et respecte les limites ().

- Respecte la vie privée : Si tu collectes des emails ou infos perso, assure-toi d’être conforme au RGPD, CCPA et autres lois ().

Thunderbit est pensé pour t’aider à rester dans les clous en n’extrayant que ce qui est visible et accessible dans ton navigateur, et en facilitant le respect des limites des sites.

Dépannage et bonnes pratiques pour l'extraction web Python

Même les meilleurs extracteurs se prennent parfois les pieds dans le tapis. Voici ma checklist dépannage :

- Requêtes bloquées : Change d’user agent, utilise des proxies ou ralentis tes requêtes ().

- Parsing qui plante : Vérifie tes sélecteurs HTML—les sites changent souvent de structure.

- Données manquantes : Vérifie si le contenu n’est pas chargé dynamiquement (utilise Selenium si besoin).

- Captcha ou murs de connexion : Certains sites bloquent les robots ; parfois, il faut passer à l’extraction manuelle.

Bonnes pratiques :

- Teste toujours ton extracteur sur un petit échantillon avant de passer à l’échelle.

- Gère bien les erreurs et exceptions.

- Respecte les règles des sites et évite les données sensibles.

- Documente ton code et garde-le modulaire pour faciliter les mises à jour.

- Prévoyez une maintenance régulière—les sites évoluent, tes extracteurs aussi ().

Conclusion & points clés à retenir

L’extraction web avec Python, c’est un vrai super-pouvoir pour les équipes modernes—ça transforme le web en données propres et prêtes à l’emploi. À retenir :

- Python est le top pour l’extraction web grâce à sa simplicité, ses bibliothèques et sa communauté.

- Le workflow est simple : inspecte le site, récupère la page, analyse le HTML, extrais et nettoie les données, puis exporte en CSV ou Excel.

- Thunderbit rend l’extraction accessible à tous, en automatisant la détection des champs, l’extraction de sous-pages et l’export en quelques clics.

- Combine Thunderbit et Python pour profiter à la fois de la rapidité d’extraction et de la puissance d’analyse.

- Reste dans les clous : respecte les règles des sites, évite les données perso et garde tes extracteurs responsables.

Prêt à te lancer ? Essaie de créer ton premier extracteur Python—ou, si tu veux aller plus vite, et découvre à quel point la collecte de données web peut être simple. Pour plus d’astuces et de guides, va faire un tour sur le .

FAQ

1. C’est quoi l’extraction web et pourquoi Python cartonne autant ?

L’extraction web, c’est automatiser la récupération de données sur des sites. Python cartonne parce qu’il est facile à lire, a des bibliothèques puissantes (Requests, BeautifulSoup…) et une grosse communauté pour t’aider ().

2. Quelles bibliothèques Python utiliser pour l’extraction web ?

Pour la plupart des projets, commence avec Requests (pour choper les pages) et BeautifulSoup (pour analyser le HTML). Pour les sites dynamiques ou blindés de JavaScript, passe à Selenium. Pour les gros projets, Scrapy est top ().

3. Thunderbit vs extraction web Python, ça donne quoi ?

Thunderbit, c’est une extension Chrome boostée à l’IA qui extrait des données en 2 clics—zéro code. Parfait pour les pros qui veulent du rapide, alors que Python offre plus de flexibilité pour les projets sur-mesure ou massifs ().

4. L’extraction web, c’est légal ?

En général oui, si tu restes sur les données publiques, respectes robots.txt et les conditions d’utilisation, et évites les infos perso ou protégées. Vérifie toujours les règles du site avant de te lancer ().

5. Comment combiner Thunderbit et Python pour des workflows avancés ?

Utilise Thunderbit pour extraire vite des données structurées et les exporter en CSV ou Excel. Ensuite, passe par Python (avec Pandas ou d’autres bibliothèques) pour nettoyer, analyser ou automatiser le traitement—tu profites du meilleur des deux mondes.

Prêt à transformer le web en ta meilleure source de données business ? Essaie Python et Thunderbit—et laisse les données bosser pour toi.

En savoir plus