Le web, c’est un vrai océan de données — en 2024, on a carrément dépassé les d’informations numériques dans le monde. C’est dingue : plus de 90 % des données mondiales ont été générées rien que ces deux dernières années. Pour toi, ça veut dire que le prochain avantage business, prospect ou insight stratégique est sûrement déjà en ligne — à condition de savoir comment le choper.

C’est là que l’extraction web entre en scène. Que tu bosses dans la vente, l’e-commerce ou l’analyse de marché, automatiser la collecte et la structuration des données web, c’est un vrai game changer. Et si tu débutes en code, pas de panique : Python rend le web scraping super accessible. Dans ce tutoriel, je t’emmène étape par étape, de l’installation à la préparation des données, et je te montre même une alternative sans code avec pour avoir des résultats en mode express.

Qu’est-ce que le Web Scraping avec Python ?

Pour faire simple : le web scraping, c’est automatiser la récupération de données sur des sites web. Imagine : tu veux récupérer les prix d’une boutique en ligne, te faire une liste de prospects depuis un annuaire, ou surveiller les news de tes concurrents. Plutôt que de tout copier-coller à la main (personne n’a le temps pour ça !), le web scraping te permet d’écrire un script qui fait tout le boulot à ta place.

Le web scraping avec Python, c’est utiliser Python pour automatiser tout ça. Grâce à sa syntaxe limpide et ses bibliothèques puissantes, Python est la star de l’extraction web, même pour les débutants. Tu peux récupérer des pages, analyser leur contenu et sauvegarder des données structurées en quelques minutes.

Les pros utilisent le web scraping pour :

- Générer des leads : Créer des listes de prospects à partir d’annuaires ou de sites d’avis.

- Faire de la veille tarifaire : Suivre les prix des concurrents ou la dispo des produits.

- Études de marché : Agréger des news, des avis ou des mentions sur les réseaux sociaux.

- Opérations : Récupérer des infos fournisseurs, des offres d’emploi ou des annonces immo.

Bref, si la donnée est en ligne, Python peut t’aider à la récupérer — vite et à grande échelle.

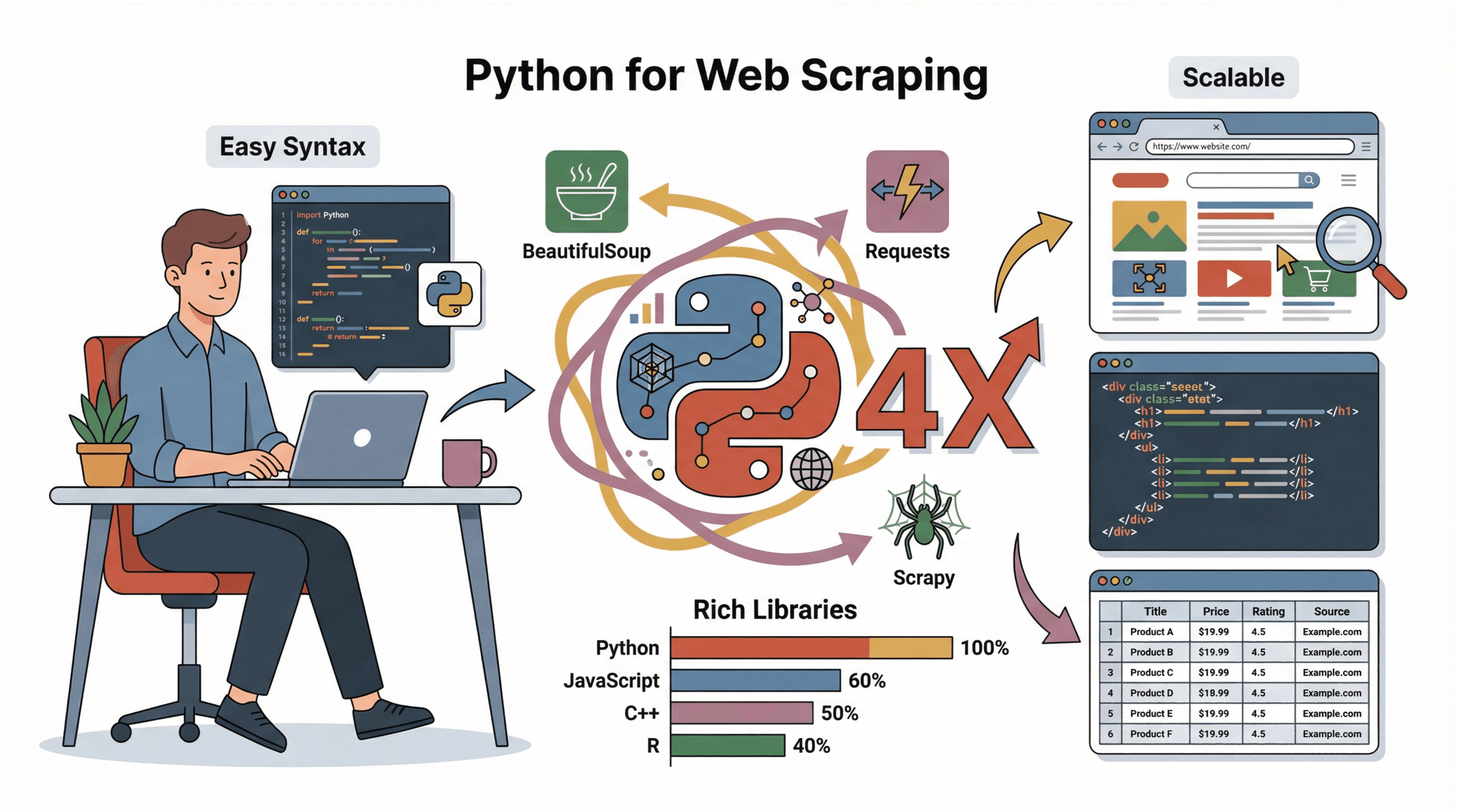

Pourquoi choisir Python pour le Web Scraping ?

J’ai testé pas mal de langages pour l’extraction web (et oui, j’ai eu mon lot de « pourquoi ça bug ?! »). Mais Python sort clairement du lot, et voilà pourquoi :

J’ai testé pas mal de langages pour l’extraction web (et oui, j’ai eu mon lot de « pourquoi ça bug ?! »). Mais Python sort clairement du lot, et voilà pourquoi :

- Super accessible : La syntaxe de Python est claire, même si tu n’as jamais codé.

- Écosystème béton : Des bibliothèques comme , et rendent l’extraction, l’analyse et la sauvegarde des données super simples.

- Communauté ultra-active : Des milliers de tutos, forums et exemples de code pour t’aider.

- Scalable : Python gère aussi bien les petits scripts que les gros projets d’extraction.

Comparé à JavaScript, C++ ou R, Python est plus simple à prendre en main et parfait pour prototyper ou analyser des données (). C’est pour ça qu’il est autant utilisé par les débutants que par les grosses boîtes.

Premiers pas : Installer ton environnement Python pour le scraping

Avant de te lancer dans l’extraction, il faut installer Python et quelques bibliothèques clés. Voici comment faire, même si tu n’as jamais touché à Python :

-

Installer Python :

- Télécharge la dernière version sur .

- Sous Windows, coche « Add Python to PATH » pendant l’installation.

- Sur Mac, passe par avec

brew install python3. - Sous Linux, utilise :

sudo apt install python3 python3-pip.

-

Installer pip (le gestionnaire de paquets Python) :

- Normalement, pip est inclus. Vérifie avec

pip --version. - Sinon, relance l’installateur ou fais

python -m ensurepip --upgrade.

- Normalement, pip est inclus. Vérifie avec

-

Créer un environnement virtuel (optionnel mais conseillé) :

- Dans ton dossier projet, tape :

python -m venv env - Active-le :

- Windows :

.\env\Scripts\activate - Mac/Linux :

source env/bin/activate

- Windows :

- Dans ton dossier projet, tape :

-

Installer les bibliothèques nécessaires :

- Avec l’environnement virtuel activé, lance :

1pip install requests beautifulsoup4 pandas scrapy - Pour les sites dynamiques, installe aussi

selenium.

- Avec l’environnement virtuel activé, lance :

-

Choisir un éditeur de code :

- Pour commencer, , ou sont top.

Astuces si tu galères :

- Si

pipn’est pas reconnu, essaiepython -m pip install .... - Si tu as une erreur de permission, lance le terminal en admin ou utilise

sudosur Mac/Linux. - Sous Windows, redémarre le terminal après l’installation de Python.

Analyser la structure d’un site avant d’extraire les données

Avant de coder, il faut piger comment le site est construit. Voici ma méthode :

-

Ouvre les outils développeur :

- Sur Chrome, clic droit sur un élément > « Inspecter », ou appuie sur

F12. - L’onglet « Éléments » te montre le HTML.

- Sur Chrome, clic droit sur un élément > « Inspecter », ou appuie sur

-

Repère les données à extraire :

- Utilise l’outil de sélection (icône curseur) pour cliquer sur la donnée voulue (ex : titre, prix).

- Le code HTML correspondant sera surligné.

-

Cherche les motifs :

- Repère les balises, classes ou IDs uniques. Exemple :

<h2 class="product-title">Laptop XYZ</h2>. - Vérifie si tes données sont dans une liste (

<ul>,<div class="item">, etc.) ou un tableau.

- Repère les balises, classes ou IDs uniques. Exemple :

-

Check la pagination :

- Cherche des boutons « Suivant » ou des numéros de page dans le HTML. Si tu vois des URLs du style

?page=2, tu pourras les boucler dans ton script.

- Cherche des boutons « Suivant » ou des numéros de page dans le HTML. Si tu vois des URLs du style

-

Le contenu est-il dynamique ?

- Si la donnée n’est pas dans le code source (

Ctrl+U), elle est sûrement chargée en JavaScript. Il faudra alors utiliser Selenium ou trouver une API.

- Si la donnée n’est pas dans le code source (

Pour un tuto visuel, est super clair.

Utiliser Requests pour récupérer le contenu d’une page web

La bibliothèque est parfaite pour télécharger des pages web en Python. Exemple basique :

1import requests

2url = "https://www.bbc.com/news"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status() # Lève une erreur si la réponse est mauvaise

6html = response.textConseils :

- Mets toujours un

User-Agentcrédible pour éviter d’être bloqué (). - Vérifie

response.status_code(200 = OK, 404 = pas trouvé, 403 = interdit, 429 = trop de requêtes).

Analyser le HTML avec BeautifulSoup : extraire les données utiles

Une fois le HTML récupéré, il faut extraire ce qui t’intéresse. rend ça super simple :

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3titles = [h.get_text(strip=True) for h in soup.select("h3")]Tâches fréquentes :

- Extraire du texte :

element.get_text(strip=True) - Récupérer les liens :

[a['href'] for a in soup.select('a')] - Trouver par classe :

soup.find_all('span', class_='price') - Extraire les images :

[img['src'] for img in soup.select('img')] - Gérer les tableaux : Utilise

soup.select('table')et parcours les lignes/cellules.

Astuces pour du HTML un peu crado :

- Utilise

soup.select_one()pour choper le premier élément. - Si un champ manque, vérifie

Noneavant d’accéder à ses attributs. - Pour des structures irrégulières, il faudra parfois bidouiller ou utiliser des regex.

Scrapy : le framework pour un scraping efficace et évolutif

Si tu veux passer à la vitesse supérieure (des centaines ou milliers de pages), est ton meilleur pote. Scrapy, c’est un framework complet pour explorer des sites, gérer les requêtes, suivre les liens et exporter les données.

Pourquoi Scrapy ?

- Rapide : Scrapy télécharge plein de pages en même temps (asynchrone).

- Fonctionnalités intégrées : Gestion des erreurs, cache, export CSV/JSON.

- Scalable : Parfait pour les gros projets ou les extractions régulières.

Workflow Scrapy de base :

- Installer :

pip install scrapy - Créer un projet :

scrapy startproject monprojet - Définir une classe Spider avec

start_urlset une méthodeparse. - Utiliser

yieldpour suivre les liens ou extraire les données. - Lancer :

scrapy crawl nomduspyder -o output.csv

Pour te lancer, checke .

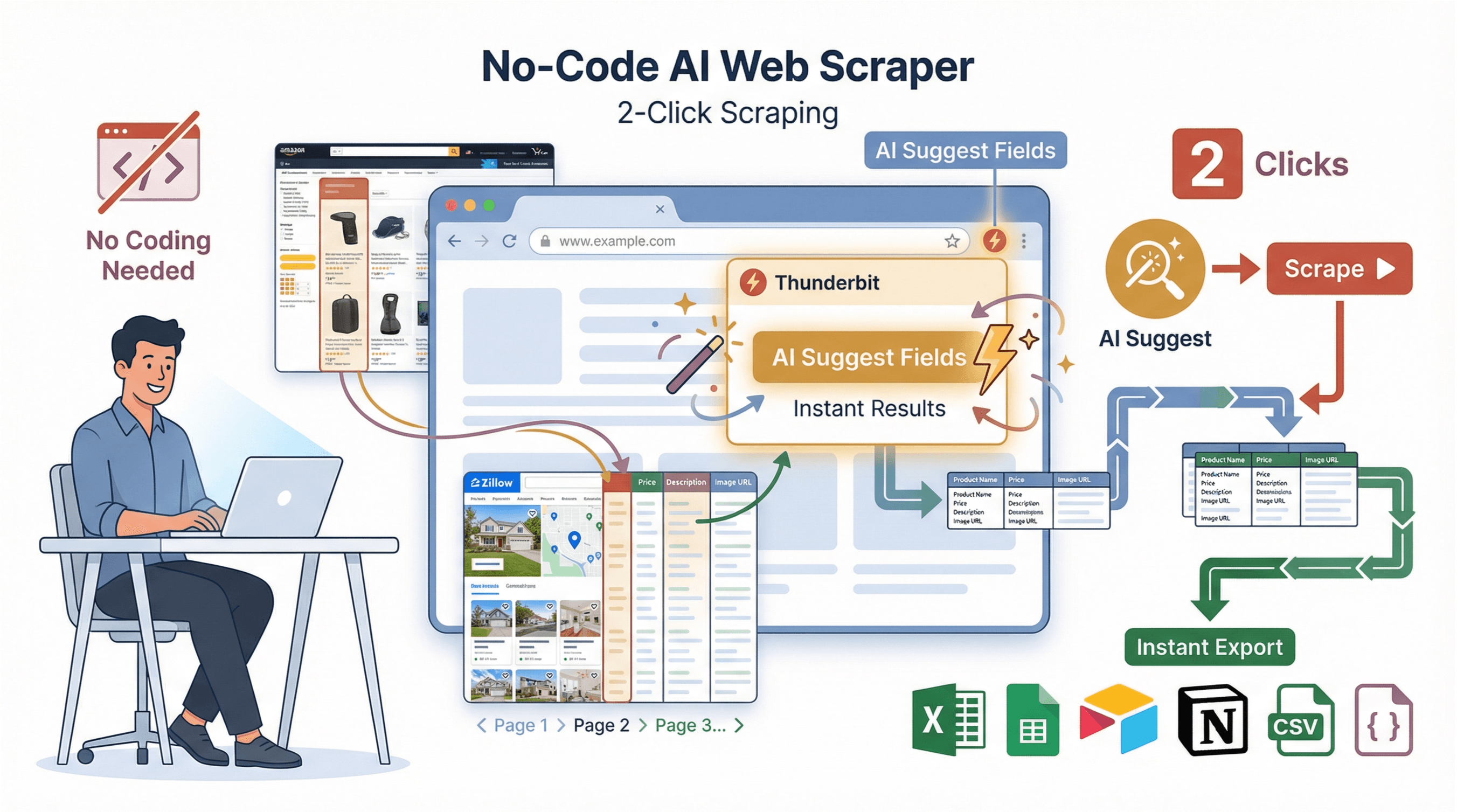

Alternative sans code : l’Extracteur Web IA de Thunderbit pour des résultats instantanés

Soyons francs : tout le monde n’a pas envie de coder, de gérer les dépendances ou de déboguer. C’est pour ça qu’on a créé : une extension Chrome d’extraction web boostée à l’IA, pensée pour les pros qui veulent des résultats en deux clics.

Soyons francs : tout le monde n’a pas envie de coder, de gérer les dépendances ou de déboguer. C’est pour ça qu’on a créé : une extension Chrome d’extraction web boostée à l’IA, pensée pour les pros qui veulent des résultats en deux clics.

Comment marche Thunderbit :

- Suggestion IA des champs : Clique sur « Suggestion IA » et Thunderbit analyse la page pour te proposer les meilleures colonnes à extraire.

- Extraction en 2 clics : Clique sur « Extraire » et Thunderbit gère tout — pagination, sous-pages, même les structures tordues.

- Extraction de sous-pages : Besoin de détails en plus ? Thunderbit peut visiter chaque sous-page (fiche produit, profil, etc.) et enrichir ton tableau automatiquement.

- Modèles instantanés : Pour les sites connus (Amazon, Zillow, Instagram, Shopify), utilise des modèles prêts à l’emploi pour exporter en un clic.

- Export gratuit des données : Exporte vers Excel, Google Sheets, Airtable, Notion, CSV ou JSON — sans payer, sans prise de tête.

Thunderbit vs Python : le match en un clin d’œil

| Fonctionnalité | Python (manuel) | Thunderbit (sans code) |

|---|---|---|

| Temps d’installation | 30–60 minutes | 2 minutes |

| Nécessite du code | Oui | Non |

| Gère la pagination | Avec du code personnalisé | Oui, automatiquement |

| Extraction sous-pages | Boucles manuelles | 1 clic |

| Export des données | Code pour CSV/Excel | 1 clic vers Sheets/Excel/Notion |

| Maintenance | Mises à jour manuelles si le site change | L’IA s’adapte automatiquement |

| Idéal pour | Logique personnalisée, intégration | Résultats rapides, non-codeurs |

Pour aller plus loin, checke .

Nettoyer et stocker les données extraites : les rendre exploitables

Les données brutes extraites sont rarement prêtes à l’emploi. Voici comment les nettoyer et les sauvegarder avec :

1import pandas as pd

2# Supposons que tu as une liste de dictionnaires appelée scraped_data

3df = pd.DataFrame(scraped_data)

4# Supprimer les doublons

5df = df.drop_duplicates()

6# Filtrer les lignes avec des valeurs manquantes

7df = df.dropna(subset=['title', 'price'])

8# Convertir le prix en float (enlève $ et virgules)

9df['price'] = df['price'].str.replace('$', '').str.replace(',', '').astype(float)

10# Sauvegarder en CSV

11df.to_csv('results.csv', index=False)Bonnes pratiques :

- Vérifie toujours les données manquantes ou bizarres.

- Normalise les formats (dates, prix, etc.).

- Stocke en CSV pour partager, ou utilise Excel/Google Sheets pour bosser à plusieurs.

- Pour de gros volumes, pense à une base de données (SQLite, PostgreSQL, etc.).

Tutoriel pas à pas : extraire des données d’un site e-commerce avec Python

On passe à la pratique avec un exemple concret : extraire les titres et prix de produits sur un site e-commerce de démo.

1. Analyse du site

Imaginons que tu veux extraire les données de . En inspectant la page, tu remarques :

- Les titres des livres sont dans des balises

<h3>à l’intérieur de<article class="product_pod">. - Les prix sont dans

<p class="price_color">.

2. Récupérer la page

1import requests

2url = "http://books.toscrape.com/"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status()

6html = response.text3. Analyser et extraire les données

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3books = []

4for article in soup.select("article.product_pod"):

5 title = article.h3.a["title"]

6 price = article.select_one("p.price_color").get_text(strip=True)

7 books.append({"title": title, "price": price})4. Nettoyer et sauvegarder les données

1import pandas as pd

2df = pd.DataFrame(books)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df.to_csv('books.csv', index=False)

5print(f"{len(df)} livres sauvegardés dans books.csv")5. Conseils si tu bloques

- Si

booksest vide, vérifie tes sélecteurs CSS. - En cas d’erreur d’encodage, ouvre le CSV en UTF-8.

- Pour plusieurs pages, boucle sur des URLs du style

http://books.toscrape.com/catalogue/page-2.html.

Astuce pro : Pour les sites dynamiques ou les cas galère, utilise Selenium ou Scrapy — ou laisse Thunderbit faire le taf à ta place.

Conclusion & Points clés à retenir

Le web scraping avec Python, c’est une vraie mine d’or pour les pros, de la génération de leads à la veille concurrentielle. À retenir :

- Python est le top pour l’extraction web grâce à sa simplicité et ses bibliothèques puissantes.

- Requests et BeautifulSoup sont tes alliés pour récupérer et analyser le HTML.

- Scrapy est parfait pour les gros projets d’extraction.

- Thunderbit propose une alternative sans code, boostée à l’IA, pour des résultats immédiats — idéal si tu veux aller droit au but.

- Le nettoyage et le stockage des données sont essentiels pour transformer les données brutes en infos exploitables.

Envie d’aller plus loin ? Lance-toi sur un site d’entraînement ou pour voir à quelle vitesse tu peux structurer les données de n’importe quel site. Pour plus d’astuces et de tutos, passe sur le .

Bonne extraction — et que tes données soient toujours clean, bien rangées et prêtes à l’emploi !

FAQ

1. L’extraction web est-elle légale ?

En général, extraire des données publiques, c’est ok, mais il faut toujours respecter les conditions d’utilisation du site, le fichier robots.txt et les lois sur la vie privée comme le RGPD. N’extrais jamais de données perso sans consentement et ne contourne pas les protections ().

2. Quelle différence entre Requests, BeautifulSoup et Scrapy ?

- Requests sert à récupérer les pages web.

- BeautifulSoup permet d’analyser et d’extraire les données du HTML.

- Scrapy est un framework complet pour explorer et extraire des données à grande échelle, sur plusieurs pages et avec export.

3. Et si le site charge les données en JavaScript ?

Si les données ne sont pas dans le HTML de base, utilise ou Playwright pour automatiser un navigateur, ou regarde les requêtes réseau pour trouver une API.

4. Comment éviter d’être bloqué lors du scraping ?

Utilise des en-têtes crédibles (surtout User-Agent), ajoute des pauses aléatoires entre les requêtes et ne spamme pas le serveur. Pour de gros volumes, fais tourner les IP ou utilise des proxies ().

5. Peut-on extraire des données sans coder ?

Carrément. permet d’extraire n’importe quel site en deux clics grâce à l’IA — sans écrire une ligne de code. Installe juste l’extension Chrome, décris ce que tu veux et exporte tes données direct.

Pour plus de guides et d’astuces avancées, ne rate pas le .

En savoir plus