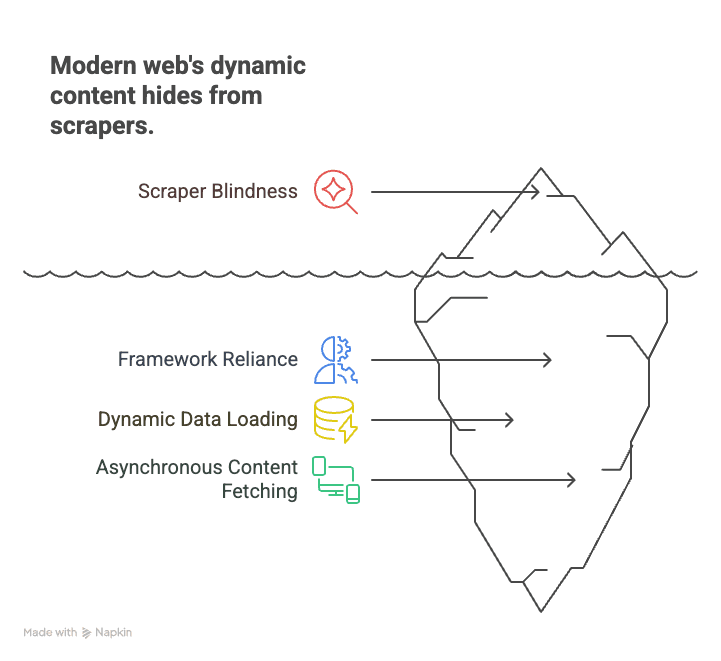

Tu as déjà essayé de récupérer des infos sur un site moderne — genre une plateforme d’annonces, une boutique en ligne ou même ton fil d’actu préféré — et tu t’es retrouvé face à une page vide ? Tu ouvres le HTML, tu cherches… et rien. Les prix, les annonces, les avis ? Introuvables. C’est normal : aujourd’hui, le web ne tourne plus seulement avec du HTML, mais surtout avec du JavaScript. Près de 99% des sites balancent leur contenu via des scripts côté client (). Les extracteurs classiques, eux, lisent juste le code sans voir ce qui s’affiche vraiment — ils passent donc à côté de tout ce qui compte.

Après des années à bosser dans le SaaS et l’automatisation, j’ai vu plein de pros, de commerciaux ou de chercheurs galérer avec cette nouvelle donne. Mais la bonne nouvelle, c’est que le crawling JavaScript n’est plus réservé aux geeks du code. Avec les bons outils (et un coup de pouce de l’IA comme ), tout le monde peut extraire des données, même sur les sites les plus dynamiques. On va voir ensemble ce que c’est que le crawling JavaScript, pourquoi c’est devenu indispensable, et comment t’y mettre — sans taper une seule ligne de code.

C’est quoi le crawling JavaScript ? Pourquoi c’est devenu incontournable pour extraire des données web ?

On part de la base. Le crawling JavaScript, c’est utiliser un outil ou un robot qui charge une page web, fait tourner tous les scripts JavaScript, puis récupère le contenu qui s’affiche après que tout a été exécuté. C’est un vrai saut par rapport au scraping HTML classique, qui ne prend que le code source envoyé par le serveur. Aujourd’hui, ce HTML est souvent vide — le vrai contenu (produits, avis, prix) est injecté par JavaScript, parfois seulement après un scroll, un clic ou une action.

Pourquoi c’est si important ? Parce que le web moderne tourne avec des frameworks comme React, Angular ou Vue. Ces applis monopage (SPA) chargent les infos à la volée, ce qui rend les extracteurs classiques « aveugles » à la majorité du contenu. Par exemple :

- E-commerce : Les prix et stocks s’affichent seulement après avoir filtré ou scrollé.

- Immobilier : Les annonces arrivent au fur et à mesure du scroll, chargées dynamiquement.

- Réseaux sociaux : Les posts, commentaires et likes sont récupérés en arrière-plan, invisibles dans le HTML de base.

Les extracteurs classiques voient une coquille vide et loupent tout. Le crawling JavaScript, c’est comme ouvrir la page dans Chrome, laisser tourner tous les scripts, puis capturer ce qui s’affiche — comme si tu étais devant ton écran.

En résumé : Pour extraire des données de la plupart des sites en 2025, il faut savoir faire du crawling JavaScript. Sinon, tu passes à côté de l’essentiel ().

Les vrais défis du crawling JavaScript (et comment les gérer)

Le crawling JavaScript, ce n’est pas juste « du scraping avec une étape en plus ». Il y a des obstacles bien à lui. Voilà les principaux — et comment les contourner.

Le contenu qui s’affiche dynamiquement

Le souci : La plupart des infos ne sont pas dans le HTML. Elles sont chargées par JavaScript après l’ouverture de la page — parfois après un scroll, un clic ou un appel réseau. Si tu ne récupères que le HTML, tu n’as que des boîtes vides.

La solution : Utilise un navigateur sans interface (headless browser) — un outil qui simule un vrai navigateur, fait tourner tous les scripts et attend que le contenu apparaisse. Des outils comme et sont devenus des classiques. Ils permettent de :

- Ouvrir une page et laisser JavaScript faire son taf.

- Attendre que certains éléments s’affichent (ex : “.product-list”).

- Extraire le contenu final du DOM.

C’est LA méthode pour extraire des sites dynamiques aujourd’hui ().

Les barrières anti-bot et anti-automatisation

Le souci : Les sites sont de plus en plus doués pour bloquer les robots. Tu peux tomber sur :

- CAPTCHAs

- Blocages d’IP ou limitations de fréquence

- Empreintes de navigateur (pour vérifier si tu es humain)

- Pièges à bots (liens bidons pour repérer les robots)

La solution : Adopte un comportement clean et imite l’activité humaine :

- Respecte le robots.txt et les conditions d’utilisation.

- Espace tes requêtes — ajoute des délais aléatoires, évite de spammer le serveur.

- Fais tourner les IP si tu extrais à grande échelle (toujours de façon éthique).

- Utilise de vrais en-têtes de navigateur et évite les signatures de bots trop évidentes.

- N’extrais pas derrière un login et ne contourne pas les CAPTCHAs sans autorisation.

Thunderbit, par exemple, pousse à n’extraire que des données publiques et intègre les bonnes pratiques pour rester dans les clous ().

Scroll infini et actions utilisateur

Le souci : Beaucoup de sites utilisent le scroll infini ou demandent des clics pour charger plus de données. Si ton extracteur ne prend que ce qui est visible au début, tu rates la majorité du contenu.

La solution : Automatise le navigateur pour :

- Simuler le scroll (charger plus de résultats comme un vrai utilisateur).

- Cliquer sur les boutons “Charger plus” ou sur les onglets.

- Attendre que le nouveau contenu s’affiche avant d’extraire.

L’IA de Thunderbit repère ces schémas et gère le scroll ou la pagination pour toi, sans que tu aies à écrire de scripts ().

Performance et passage à l’échelle

Le souci : Faire tourner un navigateur sans interface pour chaque page, ça bouffe des ressources. Extraire des centaines ou milliers de pages peut vite devenir lent et lourd pour ton ordi.

La solution : Utilise le crawling en parallèle — lance plusieurs navigateurs ou onglets en même temps. Ou mieux, passe par le cloud. L’accélérateur cloud de Thunderbit (Lightning Network) peut extraire jusqu’à 50 pages d’un coup, ce qui booste grave les gros volumes ().

Thunderbit : le crawling JavaScript, version simple et puissante

Soyons clairs : la plupart des pros n’ont pas envie de coder, de déboguer des sélecteurs ou de surveiller des scripts. C’est pour ça qu’on a créé — un extracteur web IA pensé pour ceux qui veulent des données sur des sites dynamiques, sans prise de tête.

Voilà comment Thunderbit rend le crawling JavaScript super accessible :

- Suggestion de champs par IA : Clique sur “AI Suggest Fields” et l’IA de Thunderbit analyse la page, propose les meilleures colonnes à extraire et choisit les bons types de données. Plus besoin de deviner.

- Extraction en langage naturel : Dis ce que tu veux en français (“Récupère le nom du produit, le prix et la note”) et Thunderbit s’occupe de tout.

- Gestion du contenu dynamique : Thunderbit bosse dans un vrai navigateur (Chrome ou dans le cloud), exécute tout le JavaScript et attend que le contenu soit chargé — comme un vrai utilisateur.

- Support des sous-pages et de la pagination : Tu veux extraire plusieurs pages ou suivre des liens vers des sous-pages (genre fiches produits) ? Thunderbit le fait tout seul et regroupe tout dans un seul tableau.

- Accélération cloud : Pour les gros volumes, le Lightning Network de Thunderbit extrait jusqu’à 50 pages en même temps dans le cloud, sans charger ton ordi.

- Interface sans code, intuitive : Si tu sais utiliser Excel, tu sauras utiliser Thunderbit. Tout se fait en quelques clics, sans prise de tête technique.

- Export gratuit des données : Exporte tes résultats vers Excel, Google Sheets, Airtable, Notion ou JSON — sans frais cachés.

Thunderbit, c’est déjà plus de 30 000 utilisateurs dans le monde, des équipes commerciales aux pros de l’e-commerce et de l’immobilier ().

Suggestion de champs IA & extraction en langage naturel

C’est là que Thunderbit change la donne. Plus besoin de fouiller dans le HTML ou d’écrire des sélecteurs XPath : tu cliques sur un bouton, l’IA lit la page, comprend sa structure et te propose direct ce qu’il faut extraire. Tu veux un champ précis ? Tape-le en français — l’IA le trouve pour toi.

C’est une révolution pour les débutants. Plus besoin de connaître le HTML, le CSS ou le JavaScript. Tu dis ce que tu veux, l’IA gère tout ().

Pagination et extraction de sous-pages

Thunderbit ne s’arrête pas à une seule page. Il peut :

- Détecter et gérer la pagination (cliquer sur “Suivant” ou scroller pour charger plus de résultats).

- Extraire les sous-pages (fiches produits, profils d’auteurs, avis…) et fusionner les données dans ton tableau principal.

- Gérer le scroll infini en simulant les actions d’un utilisateur, pour récupérer toutes les données, pas juste celles visibles au début.

Par exemple, pour extraire une catégorie e-commerce de 20 pages de produits, Thunderbit cliquera automatiquement sur chaque page et regroupera les résultats. Tu veux les détails de chaque produit ? Utilise l’extraction de sous-pages : Thunderbit visite chaque lien, collecte les infos et enrichit ta base ().

Lightning Network & Accélération cloud : le crawling JavaScript à grande vitesse

Quand il faut extraire des centaines ou milliers de pages, le faire une par une, c’est mort. C’est là que le Lightning Network de Thunderbit entre en jeu.

- Extraction cloud : Laisse les serveurs cloud de Thunderbit (US, UE, Asie) bosser pour toi. Le cloud peut extraire jusqu’à 50 pages en même temps, ce qui accélère vraiment les gros volumes.

- Crawling en parallèle : Au lieu d’attendre que chaque page charge dans ton navigateur, le cloud répartit le boulot sur plein de workers. Extraire 1 000 pages produits ? Le cloud finit en quelques minutes, pas en heures.

- Extraction planifiée : Tu veux surveiller des prix ou des annonces tous les jours ? Programme une extraction en langage naturel (“tous les jours à 9h”) et Thunderbit s’en occupe, en exportant les données vers Google Sheets ou ta base ().

C’est un vrai plus pour les équipes commerciales, e-commerce ou opérations qui ont besoin de données fraîches à grande échelle — sans développeur ni serveur.

Extraction multi-pages et en masse

Thunderbit te permet de :

- Extraire des catalogues ou annuaires entiers (tous les produits d’une catégorie, toutes les annonces d’une région…)

- Exporter les résultats vers Excel, Google Sheets, Airtable ou Notion en un clic.

- Gagner un temps fou — un utilisateur a extrait des centaines d’annonces immobilières, avec les coordonnées des agents, en moins de 10 minutes.

Guide express : comment débuter le crawling JavaScript avec Thunderbit

Prêt à te lancer ? Voilà comment démarrer avec Thunderbit, même si tu n’as jamais fait d’extraction de données.

Configurer ta première extraction

- Installer Thunderbit : Télécharge l’. Crée-toi un compte gratuit.

- Choisir ta cible : Va sur le site à extraire. Si un login est nécessaire, connecte-toi d’abord (Thunderbit fonctionne dans ta session navigateur).

- Ouvrir Thunderbit : Clique sur l’icône Thunderbit dans la barre Chrome. Choisis ta source de données (page actuelle, liste d’URLs ou import de fichier).

- Choisir le mode d’exécution : Pour les petits volumes ou les sites avec connexion, utilise le mode Navigateur. Pour les gros volumes, passe en mode Cloud pour extraire en parallèle.

- AI Suggest Fields : Clique sur “AI Suggest Fields”. L’IA de Thunderbit analyse la page et propose les colonnes à extraire (ex : “Nom du produit”, “Prix”, “URL de l’image”).

- Ajuster les colonnes : Renomme, ajoute ou supprime des champs selon tes besoins. Ajoute des instructions IA personnalisées pour formater ou catégoriser les données.

- Configurer la pagination/scroll : Si le site utilise la pagination ou le scroll infini, active l’option correspondante dans les paramètres Thunderbit.

- Clique sur “Extraire” : Thunderbit charge la/les page(s), exécute tout le JavaScript et extrait les données dans un tableau.

Extraire et exporter les données

- Aperçu des résultats : Thunderbit affiche tes données dans un tableau. Vérifie que tout est là et que c’est propre.

- Export : Clique sur “Exporter” pour télécharger en Excel, CSV, JSON ou envoyer direct vers Google Sheets, Airtable ou Notion.

- Validation : Vérifie quelques lignes avec le site en direct pour être sûr que tout colle.

- Dépannage : Si des données manquent, essaye de scroller la page, d’ajuster les instructions IA ou de passer en mode Cloud pour de meilleures perfs.

Pour des tutos détaillés, check la ou la .

Les bons réflexes pour un crawling JavaScript responsable

Avec un grand pouvoir d’extraction vient une grande responsabilité. Voilà comment rester clean (et dans la légalité) :

- Respecte le robots.txt et les CGU : Vérifie toujours si le site autorise l’extraction. S’il interdit les bots, ne force pas ().

- N’extrais pas de données perso : Le RGPD et le CCPA protègent noms, emails, profils… même s’ils sont publics. N’extrais ces infos qu’avec une raison valable et un consentement.

- Ne contourne pas les logins ou CAPTCHAs : C’est une zone grise (voire illégale). Reste sur les données publiques.

- Espace tes requêtes : N’inonde pas les serveurs. Le mode cloud de Thunderbit espace les requêtes et fait tourner les IP pour éviter les blocages.

- Utilise les données de façon éthique : Ne republie pas de contenu protégé, n’utilise pas les infos à mauvais escient.

- Supprime sur demande : Si quelqu’un te demande de retirer ses données, fais-le.

Thunderbit est pensé pour encourager la conformité : données publiques uniquement, pas de hacking, et des options d’export claires pour un usage responsable.

Évite les galères juridiques

- Limite-toi aux données publiques et non personnelles.

- N’extrais pas de sites qui l’interdisent clairement.

- En cas de doute, demande l’autorisation ou utilise l’API officielle du site.

- Garde une trace de ce que tu extrais et quand.

- Respecte toute demande de retrait sans attendre.

Pour aller plus loin, lis .

Comparatif des solutions de crawling JavaScript : Thunderbit vs outils classiques

| Aspect | Puppeteer/Playwright (Code) | Sitebulb (Crawler SEO) | Thunderbit (IA sans code) |

|---|---|---|---|

| Temps de mise en place | Heures (codage requis) | Modéré (configuration) | Minutes (point & clic) |

| Compétences requises | Élevées (développeurs) | Moyennes | Faibles (tout public) |

| Gestion du contenu JS | Oui (script manuel) | Oui (pour le SEO) | Oui (IA, automatique) |

| Pagination/Sous-pages | Script manuel | Limité | Automatique (IA détecte) |

| Maintenance | Élevée (fragile aux changements) | Modérée | Faible (IA s’adapte) |

| Scalabilité | Manuelle (écrire du code) | Limitée | Cloud intégré (50x) |

| Options d’export | Manuel (écrire du code) | CSV/Excel | Excel, Sheets, Notion |

| Idéal pour | Développeurs, flux sur-mesure | Audits SEO | Utilisateurs métier, analystes |

Thunderbit s’impose comme la solution parfaite pour les pros qui veulent des résultats rapides, sans se prendre la tête avec la technique ().

Conclusion & points clés à retenir

Le crawling JavaScript, ce n’est plus un truc de niche : c’est devenu indispensable pour quiconque a besoin de données web en 2025. Avec près de 99% des sites qui utilisent des scripts côté client, le scraping classique ne suffit plus (). La bonne nouvelle ? Plus besoin d’être développeur pour s’y mettre.

À retenir :

- Le contenu dynamique est partout : Pour extraire des sites modernes, il faut un outil qui exécute JavaScript.

- Les défis existent, mais on peut les gérer : Navigateurs headless, attente intelligente et accélération cloud permettent d’extraire même les données les plus coriaces.

- Thunderbit simplifie tout : Suggestions IA, extraction en langage naturel, gestion des sous-pages et de la pagination, accélération cloud… Thunderbit met la puissance du crawling JavaScript à la portée de tous.

- Reste clean : Respecte toujours les règles des sites, la vie privée et l’éthique.

- Lance-toi dès aujourd’hui : Installe Thunderbit, choisis un site et découvre tout ce que tu peux extraire en quelques clics.

Envie d’aller plus loin ? Va voir le pour d’autres guides, ou mate nos pour des démos pas à pas.

Bon crawling — que tes données soient toujours dynamiques, complètes et prêtes à l’emploi !

FAQ

1. C’est quoi le crawling JavaScript et en quoi c’est différent du scraping classique ?

Le crawling JavaScript utilise un outil qui charge une page web, fait tourner tous ses scripts JavaScript et extrait le contenu qui s’affiche après. Le scraping classique ne prend que le HTML brut, donc il rate la majorité des données sur les sites modernes.

2. Pourquoi j’ai besoin du crawling JavaScript pour l’extraction de données métier ?

Parce que quasiment tous les sites modernes utilisent JavaScript pour charger dynamiquement leur contenu. Sans crawling JavaScript, tu rates les produits, avis, prix et autres infos clés.

3. Comment Thunderbit rend le crawling JavaScript facile pour les débutants ?

Thunderbit s’appuie sur l’IA pour suggérer les champs, gérer le contenu dynamique et automatiser la pagination et l’extraction de sous-pages. Tu peux juste décrire ce que tu veux en français — pas besoin de coder.

4. Le crawling JavaScript, c’est légal ? À quoi je dois faire gaffe ?

Le crawling JavaScript est légal si tu le fais de façon responsable : reste sur les données publiques, respecte le robots.txt et les CGU, et n’extrais pas d’infos perso sans consentement. Thunderbit encourage la conformité et l’usage responsable.

5. Comment passer à l’échelle pour de gros volumes d’extraction JavaScript ?

Le Lightning Network de Thunderbit (extraction cloud) permet d’extraire jusqu’à 50 pages en même temps, ce qui facilite la surveillance de prix ou la génération de leads sur des milliers de pages.

Pour aller plus loin :