Laissez-moi vous dire, il y a peu de choses aussi satisfaisantes dans la vie numérique que de voir une liste bien rangée et complète de toutes les pages d’un site web—c’est un peu comme retrouver toutes ses chaussettes après une lessive, tu vois le genre ? Mais si tu as déjà tenté de récupérer toutes les pages d’un site pour un audit de contenu, une migration ou juste pour explorer les moindres recoins de ton site, tu sais que ce n’est jamais aussi simple qu’on l’espère. J’ai vu des équipes passer des heures, parfois même des jours, à bricoler des listes à partir de sitemaps, de recherches Google et d’exports CMS, pour finalement se rendre compte qu’il leur manquait encore des pages cachées ou dynamiques. Et je ne te parle même pas de la fois où j’ai voulu aider un pote à exporter toutes ses URLs WordPress—disons juste que ça a nécessité beaucoup de café et un brin d’angoisse existentielle.

La bonne nouvelle ? Plus besoin de jouer à cache-cache avec ton propre site. Dans ce guide, je vais te présenter toutes les méthodes principales pour trouver les URLs d’un site web—des plus classiques aux plus innovantes—et te montrer comment des outils boostés à l’IA comme peuvent rendre ce processus bien plus rapide, complet, et (oserais-je dire) agréable. Que tu sois marketeur, dev ou juste la personne désignée pour “récupérer toutes les URLs”, tu trouveras ici des étapes concrètes, des exemples réels et des comparatifs honnêtes pour choisir la meilleure approche pour ton équipe.

Pourquoi récupérer toutes les pages d’un site ? Cas d’usage concrets

Avant de plonger dans le “comment”, parlons du “pourquoi”. Pourquoi tant d’équipes ont-elles besoin de lister toutes les URLs d’un site ? Ce n’est pas qu’une question de SEO—c’est un besoin qui revient pour le marketing, la vente, l’IT et l’exploitation. Voici les situations les plus courantes :

- Audits de contenu & stratégie SEO : Les audits de contenu sont devenus la norme, avec . Une liste exhaustive d’URLs est la base pour évaluer la performance, mettre à jour les anciens contenus et booster le référencement. D’ailleurs, .

- Refonte & migration de site : ), et chaque migration nécessite de cartographier les URLs pour éviter les liens cassés et la perte de SEO.

- Conformité et maintenance : Les équipes opérationnelles doivent repérer les pages orphelines ou obsolètes—parfois d’anciens microsites de campagne encore en ligne, prêts à créer la gêne.

- Analyse concurrentielle : Les équipes marketing et commerciales extraient les pages de sites concurrents pour lister produits, tarifs ou articles de blog, à la recherche d’opportunités.

- Génération de leads & prospection : Les commerciaux compilent des listes de pages de points de vente, d’annuaires ou d’espaces membres pour leurs actions de prospection.

- Inventaire de contenu : Les content managers tiennent à jour la liste de tous les articles, landing pages, PDF, etc. pour éviter les doublons et maximiser la valeur.

Voici un tableau récapitulatif des cas d’usage :

| Scénario | Pour qui ? | Pourquoi une liste complète est essentielle |

|---|---|---|

| Audit SEO / Audit de contenu | Spécialistes SEO, Content marketers | Évaluer chaque contenu ; pages manquantes = analyse incomplète, opportunités ratées |

| Migration/Refonte de site | Développeurs web, SEO, IT, Marketing | Faire correspondre anciennes et nouvelles URLs, mettre en place des redirections, éviter les liens cassés et la perte de SEO |

| Analyse concurrentielle | Marketing, Commercial | Voir toutes les pages concurrentes ; les pages cachées révèlent des opportunités |

| Génération de leads | Équipes commerciales | Rassembler les pages de contact/ressources pour la prospection ; ne rater aucun lead potentiel |

| Inventaire de contenu | Content marketing | Maintenir un référentiel à jour, repérer les manques, éviter les doublons, revoir les anciens contenus |

Et l’impact des pages manquantes ou cachées ? Il est bien réel. Imagine, tu planifies une refonte et tu oublies une landing page cachée qui convertit encore, ou tu fais un audit en passant à côté de 5% de tes pages car elles ne sont pas indexées. C’est du chiffre d’affaires perdu, des pénalités SEO, et parfois une crise de comm’ que tu n’avais pas vue venir.

Les méthodes classiques pour trouver les URLs d’un site web

Passons au concret : comment on fait pour récupérer toutes les pages d’un site ? Il existe plusieurs méthodes éprouvées—certaines sont rapides mais superficielles, d’autres plus complètes (et parfois plus galère). Voici un tour d’horizon :

Recherche Google et opérateurs de recherche

Principe :

Tape site:votresite.com dans Google. Le moteur affiche toutes les pages indexées pour ce domaine. Tu peux affiner avec des mots-clés ou des sous-répertoires (ex : site:votresite.com/blog).

Résultat :

Une liste des pages indexées—c’est-à-dire ce que Google connaît de ton site.

Limites :

- Ne montre que ce qui est indexé, pas tout ce qui existe

- S’arrête généralement après quelques centaines de résultats, même pour les gros sites

- Ignore les pages récentes, cachées ou volontairement non indexées

Quand l’utiliser :

Idéal pour un aperçu rapide ou les petits sites, mais pas pour un audit exhaustif.

Vérification du robots.txt et du Sitemap.xml

Principe :

Va sur votresite.com/robots.txt et cherche les lignes “Sitemap:”. Ouvre le sitemap (souvent votresite.com/sitemap.xml ou /sitemap_index.xml). Les sitemaps listent les URLs que le propriétaire souhaite faire indexer.

Résultat :

Une liste des pages principales—souvent tous les articles, pages produits, etc. .

Limites :

- Les sitemaps n’incluent que les pages que le propriétaire veut indexer—les pages cachées ou orphelines sont souvent absentes

- Les sitemaps peuvent être obsolètes s’ils ne sont pas régénérés

- Certains sites ont plusieurs sitemaps ; il faut parfois les chercher

Quand l’utiliser :

Parfait si tu possèdes le site ou pour un aperçu rapide des pages principales d’un concurrent. Mais garde en tête que tu ne vois que ce que le propriétaire veut montrer.

Outils SEO Spider et extracteurs web

Principe :

Des outils comme Screaming Frog, Sitebulb ou DeepCrawl simulent un robot d’indexation. Tu entres l’URL de ton site, l’outil suit tous les liens internes et dresse la liste des pages trouvées.

Résultat :

Potentiellement toutes les pages reliées du site, avec des infos comme les codes de statut et les balises meta.

Limites :

- Les pages orphelines (non reliées) sont ignorées sauf si tu les ajoutes manuellement

- Les pages dynamiques ou générées en JavaScript peuvent être manquées si l’outil ne gère pas le rendu avancé

- L’exploration de gros sites peut être longue et consommer beaucoup de ressources

- Nécessite des compétences techniques pour la configuration

Quand l’utiliser :

Idéal pour les pros du SEO ou les devs lors d’audits approfondis. Moins adapté aux profils non techniques.

Google Search Console et Analytics

Principe :

Si tu as accès au site, Google Search Console (GSC) et Analytics permettent d’exporter des listes d’URLs.

- GSC : Les rapports de couverture et de performance listent les URLs indexées et exclues (jusqu’à 1 000 par export, plus via l’API).

- Analytics : Affiche toutes les pages ayant reçu du trafic sur une période donnée (GA4 permet jusqu’à 100 000 lignes par export).

Limites :

- GSC et Analytics ne montrent que les pages connues de Google ou ayant reçu du trafic

- Limites d’export (1 000 lignes pour GSC, 100k pour GA4)

- Nécessite d’être propriétaire du site ; inutilisable pour l’analyse concurrentielle

- Les pages sans trafic ou non indexées n’apparaissent pas

Quand l’utiliser :

Parfait pour ton propre site, surtout avant une migration ou un audit. Pas adapté à l’analyse de la concurrence.

Tableaux de bord CMS

Principe :

Si ton site tourne sous WordPress, Shopify ou un autre CMS, tu peux souvent exporter la liste des pages et articles depuis l’interface d’administration (parfois via un plugin).

Résultat :

Une liste de tous les contenus—pages, articles, produits, etc.

Limites :

- Nécessite un accès administrateur

- Peut ne pas inclure les pages dynamiques ou hors contenu

- Si ton site utilise plusieurs systèmes (blog, boutique, docs), il faudra fusionner les exports

Quand l’utiliser :

Idéal pour les propriétaires de site qui font un inventaire ou une sauvegarde. Peu utile pour l’analyse concurrentielle.

Les limites des méthodes traditionnelles pour récupérer les pages d’un site

Soyons clairs : aucune de ces méthodes n’est parfaite. Voici les principaux écueils :

- Complexité technique : Beaucoup de méthodes nécessitent des compétences ou des outils spécialisés. Pour les profils non techniques, c’est un vrai frein. Un audit manuel peut prendre .

- Couverture incomplète : Chaque méthode peut rater certaines pages—Google ignore les non-indexées, les sitemaps ratent les orphelines, les crawlers ratent les pages non reliées ou dynamiques, les exports CMS tout ce qui est hors système.

- Temps et effort manuel : Souvent, il faut croiser plusieurs sources, dédupliquer, nettoyer—c’est fastidieux et source d’erreurs. Certains partagent même des “astuces” comme copier-coller le sitemap dans Excel ou utiliser des scripts en ligne de commande.

- Mise à jour et fraîcheur : Les listes deviennent vite obsolètes. Les méthodes classiques imposent de tout recommencer à chaque changement du site.

- Accès et permissions : Certaines méthodes nécessitent des droits admin ou la propriété du site—impossible pour l’analyse concurrentielle.

- Surcharge d’informations : Les spiders SEO peuvent noyer sous les données techniques alors qu’on veut juste une liste d’URLs.

En résumé, le process traditionnel, c’est un peu “comme essayer de faire un gâteau dont la recette change tout le temps et où le four se verrouille de temps en temps”. (Oui, c’est une vraie analogie de content strategist—et je l’ai vécue.)

Découvrez Thunderbit : la solution IA pour trouver toutes les URLs d’un site

Passons à la partie fun. Et si tu pouvais simplement demander à un assistant “parcours ce site et donne-moi la liste de toutes les pages”, et qu’il le fasse vraiment—sans code, sans prise de tête ? C’est exactement ce que propose .

Thunderbit est une extension Chrome d’extracteur web IA pensée pour les non-techniciens (mais assez puissante pour les pros). Elle utilise l’IA pour “lire” les sites, structurer les données et exporter toutes les URLs—y compris les pages cachées, dynamiques et les sous-pages. Pas besoin de coder ni de paramétrer des réglages complexes. Ouvre le site, clique sur “AI Suggest Fields” et laisse Thunderbit faire le boulot.

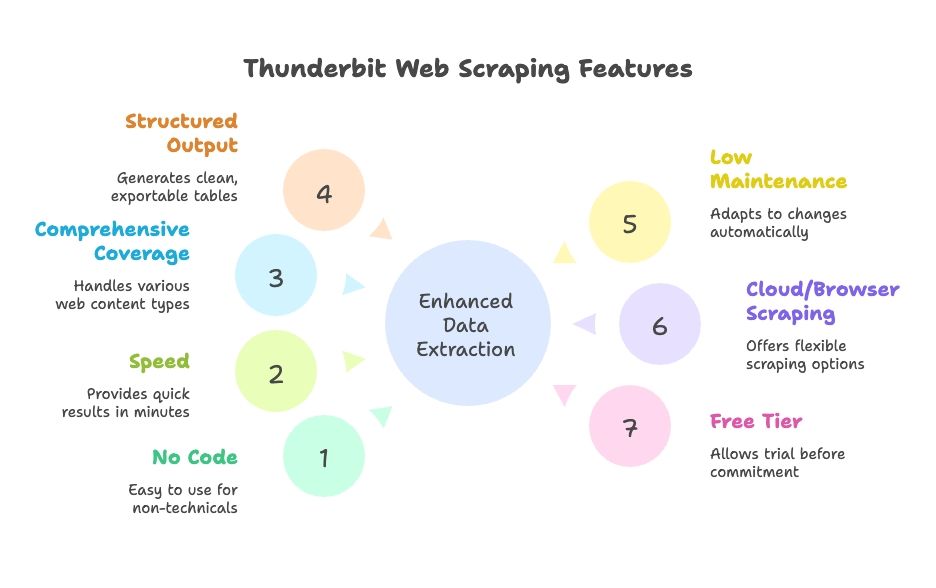

Pourquoi Thunderbit se démarque :

- Aucune compétence technique requise : Interface en langage naturel, guidée par l’IA. Tout le monde peut s’en servir.

- Rapidité : Résultats en quelques minutes, pas en heures.

- Couverture complète : Gère le contenu dynamique, la pagination, le scroll infini et les sous-pages.

- Sortie structurée : Tableaux propres, prêts à exporter vers Google Sheets, Excel, Airtable, Notion, CSV ou JSON.

- Peu d’entretien : L’IA s’adapte automatiquement aux changements du site ; moins de réglages à refaire.

- Extraction cloud ou navigateur : Choisis ce qui colle à ton workflow.

- Version gratuite dispo : Teste avant de t’engager.

Comment Thunderbit simplifie la récupération des pages d’un site

Voyons concrètement comment Thunderbit fonctionne. Voici comment passer de “j’ai besoin de la liste de toutes les pages de mon site” à “voici le tableau, chef” en quelques clics.

Étape 1 : Installer et lancer Thunderbit

Télécharge l’ et épingle-la à ton navigateur. Va sur le site à extraire (par exemple, ta page d’accueil) et clique sur l’icône Thunderbit pour ouvrir l’interface.

Astuce : Thunderbit offre des crédits gratuits aux nouveaux utilisateurs, tu peux donc l’essayer sans sortir la carte bleue.

Étape 2 : Choisir la source de données

Par défaut, Thunderbit extrait la page en cours, mais tu peux aussi saisir une liste d’URLs (comme un sitemap ou des pages de catégorie) si tu veux démarrer sur une section précise.

- Pour la plupart des sites, commence par la page d’accueil ou le sitemap.

- Pour l’e-commerce, commence par une page catégorie ou une liste de produits.

Étape 3 : Utiliser “AI Suggest Fields” pour détecter les URLs

C’est là que la magie de l’IA opère. Clique sur “AI Suggest Fields” (ou “AI Suggest Columns”). L’IA de Thunderbit analyse la page, repère les motifs et suggère des colonnes comme “Titre de la page” et “URL de la page” pour tous les liens trouvés. Tu peux ajuster ces colonnes selon tes besoins.

- Sur une page d’accueil, tu obtiendras la navigation, le pied de page et les liens mis en avant.

- Sur un sitemap, tu auras une liste d’URLs propre.

- Tu peux ajouter ou retirer des colonnes, ou affiner ce que tu veux extraire.

L’IA de Thunderbit fait le gros du travail—plus besoin d’écrire des XPaths ou des sélecteurs CSS. C’est comme avoir un stagiaire robot qui comprend vraiment ce que tu veux.

Étape 4 : Activer l’extraction des sous-pages

La plupart des sites ne listent pas toutes leurs pages sur la page d’accueil. C’est là que la fonction Extraction de sous-pages de Thunderbit intervient. Marque la colonne URL comme lien à “suivre”, et Thunderbit cliquera sur chaque lien trouvé pour extraire encore plus d’URLs. Tu peux même configurer des modèles imbriqués pour une extraction multi-niveaux.

- Pour les listes paginées ou les boutons “voir plus”, active Pagination & Scrolling pour que Thunderbit continue jusqu’à tout trouver.

- Pour les sites avec sous-domaines ou sections (comme un blog sur ), Thunderbit peut aussi les suivre si tu l’indiques.

Étape 5 : Lancer l’extraction

Clique sur “Scrape” et laisse Thunderbit bosser. Il remplit un tableau d’URLs (et d’autres champs choisis) en temps réel. Pour les gros sites, laisse-le tourner en arrière-plan et reviens quand c’est fini.

Étape 6 : Vérifier et exporter

Une fois terminé, vérifie les résultats—Thunderbit permet de trier, filtrer et supprimer les doublons directement dans l’appli. Puis exporte tes données en un clic vers Google Sheets, Excel, CSV, Airtable, Notion ou JSON. Fini le copier-coller ou les formats bancals.

Le process complet ? Pour un site de taille moyenne, tu peux passer de zéro à une liste complète d’URLs en moins de 10 minutes. Pour les gros sites, c’est toujours bien plus rapide (et moins stressant) que de compiler des données de sources multiples.

Découvrir les pages cachées et dynamiques avec Thunderbit

L’un de mes aspects préférés de Thunderbit, c’est sa capacité à détecter les pages que les outils classiques ratent souvent :

- Contenu généré en JavaScript : Thunderbit fonctionne dans un vrai navigateur, il peut donc capturer les pages qui se chargent dynamiquement (comme les listes d’emplois à scroll infini ou les catalogues produits).

- Pages orphelines ou non reliées : Si tu as un indice (sitemap, fonction de recherche), Thunderbit peut l’utiliser pour trouver des pages non reliées ailleurs.

- Sous-domaines ou sections : Thunderbit peut suivre les liens vers des sous-domaines si besoin, pour une vision complète du site.

- Interactions comme un utilisateur : Besoin de remplir un champ de recherche ou de cliquer sur un filtre pour révéler des pages cachées ? L’Auto-remplissage IA de Thunderbit gère aussi ça.

Exemple concret : Une équipe marketing devait retrouver toutes ses anciennes landing pages—beaucoup n’étaient plus reliées mais existaient encore. En extrayant les résultats Google avec Thunderbit et en fournissant des motifs d’URL connus, ils ont retrouvé des dizaines de pages oubliées, évitant ainsi des confusions (et quelques sueurs froides).

Thunderbit vs méthodes traditionnelles : rapidité, simplicité, couverture

Comparons Thunderbit aux méthodes classiques :

| Aspect | Recherche Google “site:” | Sitemap XML | Crawler SEO (Screaming Frog) | Google Search Console | Export CMS | Extracteur Web IA Thunderbit |

|---|---|---|---|---|---|---|

| Vitesse | Très rapide, mais limité | Instantané si dispo | Variable (minutes à heures) | Rapide pour petits sites | Instantané pour petits sites | Rapide, config en minutes, extraction automatisée |

| Facilité d’utilisation | Très facile | Facile | Moyenne (nécessite config) | Moyenne | Facile (si admin) | Très facile, sans code |

| Couverture | Faible (indexé seulement) | Élevée pour les pages prévues | Élevée pour les pages reliées | Élevée pour l’indexé, export limité | Moyenne (contenu uniquement) | Très élevée, gère dynamique & sous-pages |

| Sortie & intégration | Copier-coller manuel | XML (à parser) | CSV avec beaucoup de données annexes | CSV/Excel, jusqu’à 1 000 lignes | CSV/XML, nettoyage possible | Tableau propre, export 1-clic vers Sheets, Excel, etc. |

| Maintenance | Relancer manuellement | À mettre à jour | Re-crawler à chaque changement | Export périodique | Export après modif | Faible—l’IA s’adapte, extraction planifiable |

Thunderbit se distingue par sa simplicité, sa couverture et son intégration. Les méthodes classiques ont chacune leurs atouts, mais demandent plus d’efforts pour croiser les résultats et les maintenir à jour. L’IA de Thunderbit s’adapte aux changements du site, t’évitant de devoir sans cesse ajuster les réglages ou relancer des exports manuels.

Choisir la bonne méthode : pour qui, pour quoi ?

Alors, quelle méthode choisir ? Voici mon avis, après des années à aider des équipes à dompter leurs données web :

- SEO / Développeurs : Si tu as besoin de données techniques poussées (balises meta, liens cassés, etc.) ou d’auditer un site géant, un crawler ou un script maison reste pertinent. Mais même dans ce cas, Thunderbit permet d’obtenir rapidement une liste d’URLs à injecter dans tes outils.

- Marketeurs, content managers, chefs de projet : Thunderbit est un vrai gain de temps. Plus besoin d’attendre l’IT pour lancer un script ou fusionner des exports. Pour un inventaire de contenu, une analyse concurrentielle ou un audit rapide, Thunderbit te rend autonome.

- Commerciaux / Lead gen : Thunderbit facilite la récupération de listes de points de vente, pages d’événements ou annuaires membres—sans coder.

- Petits sites / tâches ponctuelles : Pour les tout petits sites, un contrôle manuel ou le sitemap peut suffire. Mais Thunderbit est si rapide à configurer qu’il vaut souvent mieux l’utiliser pour ne rien rater.

- Budget : Les méthodes classiques coûtent peu (hors temps passé). Thunderbit propose une version gratuite, et ses formules payantes restent abordables pour la plupart des boîtes. N’oublie pas : ton temps a de la valeur !

- Besoins très spécifiques : Si tu as besoin de données ultra-personnalisées ou de logique complexe, un scraper sur-mesure sera parfois nécessaire. Mais l’IA de Thunderbit couvre la majorité des cas avec peu de réglages.

Conseils pour choisir :

- Si ton site fait moins de 1 000 pages, essaie l’export Google Search Console—mais vérifie bien la complétude.

- Si tu n’as pas accès au site ou analyses un concurrent, Thunderbit ou un crawler est ton allié.

- Si tu veux gagner du temps et une solution qui s’adapte, Thunderbit est difficile à battre.

- Pour le travail en équipe, l’export direct vers Google Sheets de Thunderbit est un vrai plus.

Beaucoup d’organisations combinent les approches : Thunderbit pour les tâches rapides et l’autonomie des non-techs, outils classiques pour les audits techniques approfondis.

À retenir : obtenir la liste des pages d’un site pour chaque besoin métier

En résumé :

- Avoir une liste complète des pages de ton site est essentiel pour le SEO, la stratégie de contenu, les migrations et la prospection commerciale. Ça évite les mauvaises surprises, les liens cassés et les opportunités manquées. La majorité des marketeurs réalisent désormais des audits de contenu au moins une fois par an ().

- Les méthodes traditionnelles existent, mais aucune n’est parfaite. Aucune approche ne garantit une liste exhaustive et à jour. Elles demandent souvent des compétences techniques et de croiser plusieurs exports.

- L’extraction boostée à l’IA (Thunderbit) est la solution moderne. Thunderbit utilise l’IA pour faire le “sale boulot” et les clics, rendant l’extraction web accessible à tous. Il gère le contenu dynamique, les sous-pages et exporte les données prêtes à l’emploi—gain de temps et moins d’erreurs. En comparaison directe, Thunderbit fait en quelques minutes ce qui prenait des heures, sans courbe d’apprentissage ().

- Adapte la méthode à tes besoins et à ton équipe. Utilise tous les outils pour les très gros sites, mais pour la majorité des entreprises, Thunderbit seul suffit largement.

- Garde ta liste à jour. Des audits réguliers permettent de détecter les problèmes tôt et de garder un site efficace. La planification avec Thunderbit rend ça possible, alors que les méthodes manuelles sont souvent repoussées par manque de temps.

En conclusion : Plus d’excuses pour ignorer ce qui se cache sur ton site (ou celui de tes concurrents). Avec la bonne méthode, tu peux obtenir une liste exhaustive de toutes les pages et utiliser ces infos pour booster ton SEO, l’expérience utilisateur et ta stratégie business. Travaille plus intelligemment, pas plus dur—laisse l’IA faire le gros du travail, et assure-toi qu’aucune page ne passe à la trappe.

Prochaines étapes

Prêt à ne plus redouter la tâche “récupère-moi toutes les URLs” ? et teste-le sur ton site ou celui d’un concurrent. Tu seras bluffé par le temps (et la tranquillité d’esprit) gagné. Et pour aller plus loin sur l’extraction web, jette un œil à nos autres guides sur le , comme ou .

FAQ

1. Pourquoi aurais-je besoin d’une liste de toutes les pages d’un site ?

Les équipes SEO, marketing, commerciales et IT ont souvent besoin d’une liste complète d’URLs pour des audits de contenu, des migrations, la génération de leads ou l’analyse concurrentielle. Une liste exhaustive et fiable permet d’éviter les liens cassés, de s’assurer que le contenu n’est pas dupliqué ou oublié, et de révéler des opportunités cachées.

2. Quelles sont les méthodes traditionnelles pour trouver toutes les URLs d’un site ?

Les méthodes courantes incluent la recherche Google avec l’opérateur site:, la consultation des fichiers sitemap.xml et robots.txt, l’exploration avec des outils SEO comme Screaming Frog, l’export de données depuis des CMS comme WordPress, et l’extraction des pages indexées ou ayant du trafic via Google Search Console et Analytics. Mais chaque méthode a ses limites en termes de couverture et d’utilisation.

3. Quelles sont les limites des méthodes classiques ?

Les méthodes traditionnelles ratent souvent les pages dynamiques, orphelines ou non indexées. Elles peuvent nécessiter des compétences techniques, prendre des heures à croiser et nettoyer, et ne sont pas adaptées aux gros sites ou aux audits répétés. Il faut parfois être propriétaire du site ou avoir des droits admin, ce qui n’est pas toujours possible.

4. Comment Thunderbit simplifie-t-il la récupération de toutes les pages d’un site ?

Thunderbit est un extracteur web IA qui parcourt les sites comme le ferait un humain—en cliquant sur les sous-pages, en gérant le JavaScript et en structurant automatiquement les données. Il ne nécessite aucun code, fonctionne via une extension Chrome, et peut exporter des listes d’URLs propres vers Google Sheets, Excel, CSV et plus en quelques minutes.

5. Qui devrait utiliser Thunderbit plutôt que les outils classiques ?

Thunderbit est idéal pour les marketeurs, content managers, commerciaux et utilisateurs non techniques qui veulent des listes d’URLs rapides et complètes sans prise de tête. Les outils classiques restent utiles pour les audits techniques poussés ou les besoins de script sur-mesure. Beaucoup d’équipes combinent les deux—Thunderbit pour la rapidité et la simplicité, les outils traditionnels pour l’analyse approfondie.