Je me rappelle encore la toute première fois où j’ai voulu obtenir toutes les pages d’un site web. Je croyais avoir trouvé la combine : cliquer sur chaque lien du menu, les noter à la main, et hop, le tour était joué. Mais très vite, c’est devenu une vraie chasse au trésor : des pages produits bien planquées, des vieilles campagnes oubliées, des articles de blog perdus tout en bas d’un scroll sans fin… C’était comme essayer de dessiner le plan d’une ville en ne marchant que sur les grands boulevards, pour finalement découvrir tout un labyrinthe de ruelles cachées.

Si tu as déjà essayé de trouver toutes les pages d’un site pour un audit de contenu, un projet SEO ou juste pour surveiller la concurrence, tu sais que c’est loin d’être simple. D’ailleurs, , ce qui veut dire que la majorité du contenu d’un site reste invisible, aussi bien pour les visiteurs que pour les moteurs de recherche. Autant dire qu’il y a plein d’opportunités et de pages fantômes qui dorment. Alors, comment faire pour obtenir la liste complète des liens d’un site ? Et pourquoi c’est si important pour planifier son contenu ? On va voir ça ensemble.

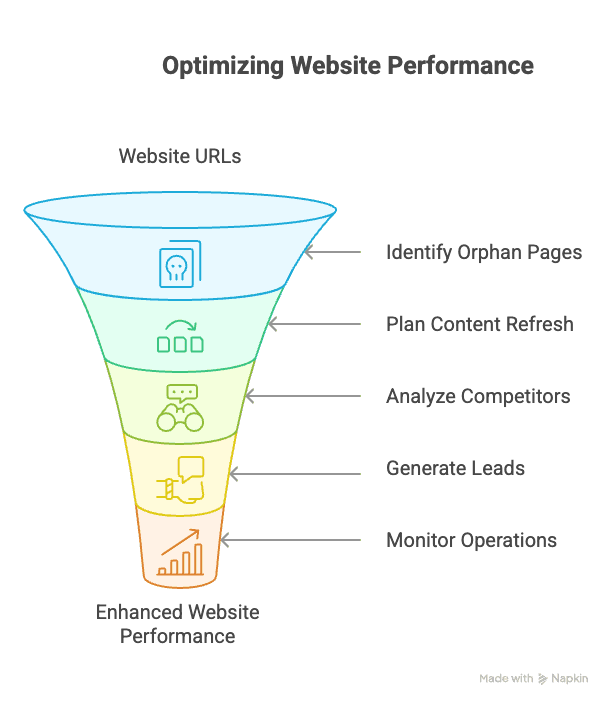

Pourquoi c’est crucial d’avoir la liste complète des liens d’un site pour planifier son contenu

Avant de rentrer dans le comment, parlons du pourquoi. Faire la liste complète des liens d’un site, ce n’est pas réservé aux pros du SEO (même si, je l’avoue, c’est un petit plaisir coupable). C’est un vrai levier stratégique pour toute boîte qui mise sur le contenu, la génération de leads ou la performance digitale.

Voilà pourquoi chaque équipe devrait s’y intéresser :

- Audits de contenu & SEO : Connaître chaque URL, c’est repérer les pages obsolètes, trop légères ou orphelines. Les pages orphelines — sans aucun lien interne — sont un vrai souci. Elles peuvent et plomber l’autorité de ton site.

- Planification & mise à jour du contenu : Avec un inventaire complet, tu vois tout ce qui existe, ce qui doit être rafraîchi et les sujets à creuser. Beaucoup d’entreprises tombent sur des dizaines de pages oubliées lors d’un audit — parfois prêtes à être remises en avant.

- Analyse concurrentielle : Pour analyser toutes les landing pages, catégories produits ou ressources cachées d’un concurrent, il te faut leur sitemap complet, pas juste le menu.

- Vente & génération de leads : Extraire toutes les pages avec des coordonnées ou points de vente, c’est ne rater aucun prospect.

- Opérations & suivi : Les équipes e-commerce peuvent surveiller chaque fiche produit pour les changements de prix ou de stock — même celles qui ne sont pas dans les catégories principales.

Regarde comment ça se décline selon les équipes :

| Équipe / Rôle | Utilisation d’une liste complète de pages | Bénéfice |

|---|---|---|

| SEO / Web Admin | Audit complet du contenu : repérer pages orphelines, liens cassés, doublons ou pages peu fournies. | Améliorer la structure du site, corriger les problèmes SEO, booster l’indexation (les pages orphelines diluent l’autorité). |

| Content Marketing | Recenser tous les articles, landing pages, etc. pour planifier le contenu. | Mettre à jour ou réutiliser d’anciens contenus, assurer la cohérence du message, repérer les sujets à créer. |

| Ventes / Lead Gen | Trouver toutes les pages avec coordonnées, points de vente ou témoignages. | Constituer des listes de prospects ciblées, ne rater aucune opportunité. |

| Veille concurrentielle | Explorer l’ensemble du site concurrent (produits, blog, support). | Découvrir la gamme, les pages de prix et la stratégie de contenu du concurrent (les sitemaps révèlent des URLs cachées). |

| Ops e-commerce | Lister toutes les fiches produits (même non liées en front) pour surveiller prix ou stock. | Suivre les évolutions de prix ou de stock sur tout le catalogue, ne rien manquer hors catégories indexées. |

| IT / Conformité | Découvrir toutes les URLs (y compris anciennes, cachées, ou pages de test en ligne). | Supprimer les pages obsolètes ou non conformes, garantir un site à jour et sécurisé. |

En clair : si tu ne vois que la partie émergée de l’iceberg, tu passes à côté d’infos, de leads et d’occasions à saisir.

Ce que ça veut vraiment dire « obtenir toutes les pages d’un site »

On va casser un mythe : « Obtenir toutes les pages d’un site », ce n’est pas juste cliquer sur « Page suivante » à l’infini. Les sites sont malins : scroll infini, boutons « charger plus », liens générés en JavaScript, paramètres d’URL, sections entières cachées du menu… Certaines pages ne sont accessibles qu’avec l’URL directe ou une action bien précise.

Donc, faire la liste des liens, c’est :

- Naviguer dans des flux à scroll infini (genre Twitter, sites d’actus)

- Cliquer sur des boutons « Charger plus » qui dévoilent du contenu caché

- Détecter les pages générées par des paramètres d’URL (filtres produits…)

- Retrouver les pages orphelines sans lien interne

- Découvrir des sections privées ou non liées (anciennes campagnes, etc.)

C’est moins feuilleter un livre que visiter une maison pleine de pièces secrètes et de passages cachés. Il faut plus qu’une lampe torche : il faut un plan et un peu de flair digital.

Les méthodes classiques pour trouver toutes les pages d’un site

Avant l’arrivée d’outils IA comme , la plupart des gens utilisaient un mix d’astuces manuelles et de logiciels spécialisés pour dresser la liste des liens d’un site. Ces méthodes sont toujours utiles, mais elles ont leurs limites.

Utiliser Google et les opérateurs de recherche

La méthode de base : taper site:exemple.com dans Google. Ça affiche toutes les pages indexées par Google pour ce domaine. Tu peux cibler une section avec site:exemple.com/blog.

Avantages :

- Ultra simple

- Pratique pour une estimation rapide

Inconvénients :

- Ne montre que ce que Google a indexé (souvent une petite partie)

- Ne révèle pas les pages privées, orphelines ou bloquées

Vérifier les sitemaps et le robots.txt

La plupart des sites pros ont un sitemap.xml — un fichier qui liste les URLs pour les moteurs. On le trouve souvent à exemple.com/sitemap.xml ou via le robots.txt.

Avantages :

- Permet de trouver des pages hors navigation

- Peut inclure des pages anciennes ou cachées

Inconvénients :

- Pas toujours à jour ou complet

- Peut lister des pages bloquées aux robots (on les voit, mais on n’y accède pas)

- Certaines pages sont indexées mais absentes du sitemap ()

Utiliser des outils de crawl SEO

Des outils comme Screaming Frog ou WebSite Auditor explorent un site en suivant les liens pour cartographier toutes les pages accessibles.

Avantages :

- Repère les pages profondes

- Permet de vérifier les liens cassés et la structure du site

Inconvénients :

- A du mal avec le contenu dynamique (scroll infini, liens JavaScript)

- Nécessite une configuration et des connaissances techniques

- Les versions gratuites sont limitées (Screaming Frog s’arrête à 500 URLs)

- Ne trouve pas les pages orphelines (pas de lien = pas de découverte)

Les limites des méthodes classiques pour lister les pages d’un site

C’est là que ça se corse. Même après tout ça, il te manquera souvent :

- Pages orphelines : Sans lien interne, absentes du sitemap, non indexées — de vraies pages fantômes.

- Contenu dynamique : Scroll infini, boutons « charger plus », contenu chargé en JavaScript/AJAX.

- Pages derrière des formulaires ou scripts : Certaines pages n’apparaissent qu’après une action utilisateur (ex : recherche interne).

- URLs dupliquées ou paramétrées : Plusieurs chemins vers le même contenu, ou contenu unique accessible via des paramètres d’URL.

Bref, les méthodes classiques, c’est comme pêcher avec un filet troué : tu attrapes beaucoup, mais tu en laisses filer pas mal.

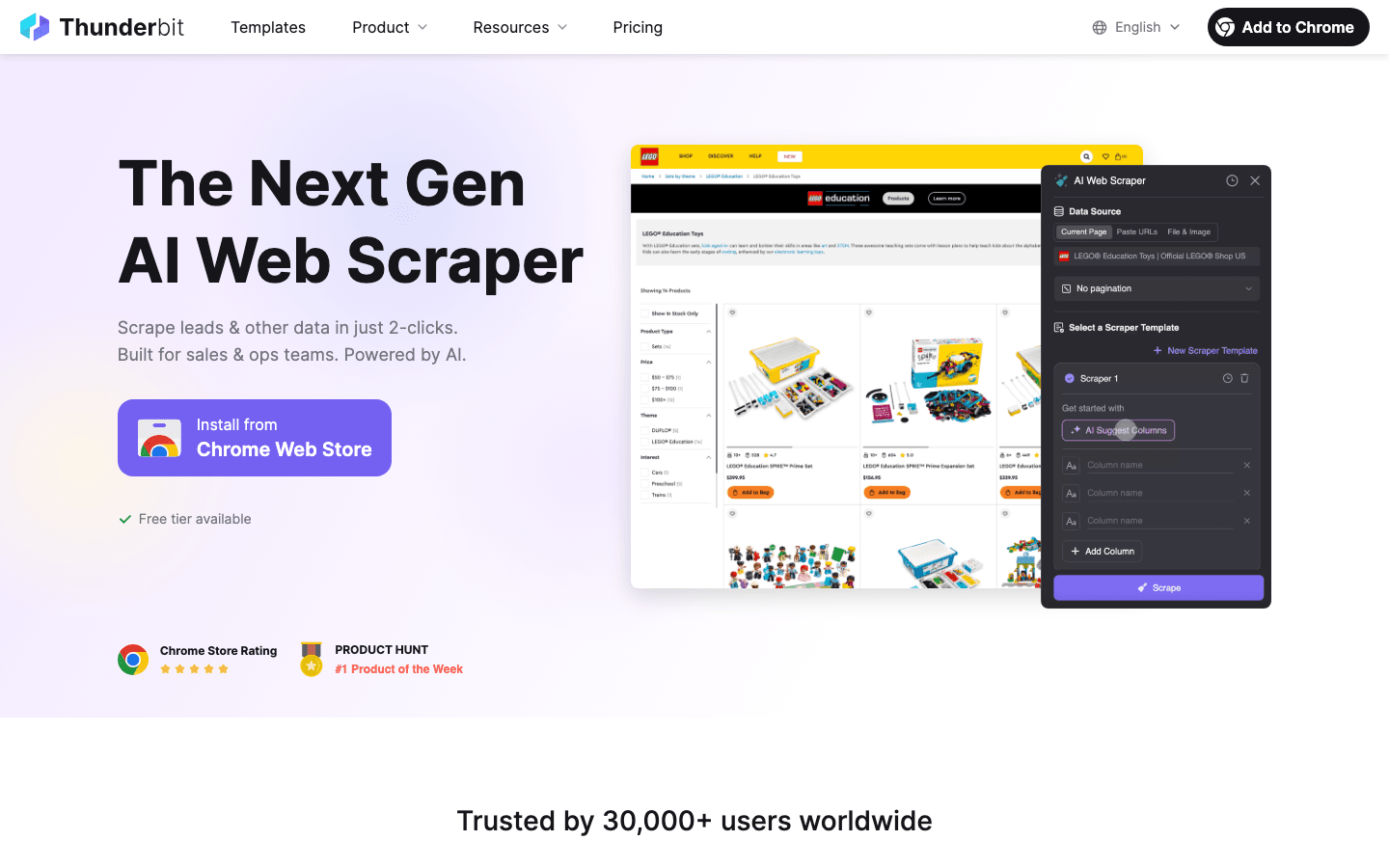

L’approche IA de Thunderbit : une découverte de pages plus futée

C’est là que l’ de Thunderbit change la donne — et franchement, c’est pour ça que je suis super enthousiaste à propos de ce qu’on a créé.

Thunderbit ne se contente pas de suivre les liens. Il « lit » la page comme un humain, la transforme en une structure proche du Markdown avant extraction. Résultat : l’IA comprend le contexte, repère les listes, tableaux, titres, et peut même deviner la logique de navigation. C’est comme filer à l’IA des lunettes et un stabilo.

Pourquoi c’est top ?

- Compréhension sémantique : En prétraitant les pages en Markdown, l’IA de Thunderbit obtient une carte sémantique du site. Elle fait la différence entre un menu latéral et une liste de produits, ou repère un bouton « charger plus » qui n’est pas un lien classique.

- Gestion du contenu dynamique : Thunderbit peut scroller, cliquer et interagir avec la page — comme un vrai utilisateur. Scroll infini ? Aucun souci. Liens générés en JavaScript ? Gérés aussi.

- Découverte de liens par l’IA : L’IA repère les éléments de navigation qui ne sont pas des liens traditionnels (boutons, cartes…) et les suit vers les sous-pages.

- Prompts en langage naturel : Tu peux littéralement demander à Thunderbit « Trouve toutes les pages produits et liste leur titre et prix », il s’occupe du reste.

En clair, Thunderbit comble le fossé entre la navigation humaine et la collecte automatisée de données. C’est puissant, flexible, et — soyons honnêtes — plutôt fun à utiliser.

Gérer la pagination : du scroll infini aux boutons « Charger plus »

Un cas classique : tu es sur un blog ou une liste de produits, et après 10 éléments, il faut scroller sans fin ou cliquer sur « Charger plus ». Les crawlers classiques s’arrêtent à ce qui est chargé au départ. L’IA de Thunderbit, elle, sait aller plus loin.

Comment Thunderbit gère les différents types de pagination

| Type de pagination | Méthode classique | Méthode Thunderbit IA |

|---|---|---|

| Pages numérotées ou liens « Suivant » | Suit si configuré | Détecte et clique automatiquement |

| Bouton « Charger plus » | Nécessite un script personnalisé | L’IA clique jusqu’à la fin |

| Scroll infini (chargement auto) | Ne voit que le premier lot ; scripting requis | L’IA scrolle et charge tout |

| Navigation cachée ou en JS | Souvent ignorée | L’IA interprète et navigue selon le besoin |

Avec Thunderbit, il suffit de cliquer sur « IA Suggérer les champs », puis « Extraire ». L’IA détecte la logique de pagination — bouton, scroll ou paramètre d’URL — et va jusqu’au bout. Plus besoin de régler la profondeur de crawl ou d’écrire des scripts.

Pour plus de détails sur la gestion de la pagination, checke la .

Extraction de sous-pages : aller au-delà de la liste principale

Autre erreur de débutant : extraire une liste de produits ou d’articles, mais oublier de visiter chaque page de détail pour récupérer les infos clés (prix, avis, contacts…). C’est là qu’intervient l’extraction de sous-pages.

Avec la fonction Extraire les sous-pages de Thunderbit, tu peux :

- Visiter automatiquement chaque page de détail liée à ta liste principale

- Extraire des champs en plus (caractéristiques, bio auteur, coordonnées…)

- Fusionner toutes les données dans un seul tableau

Imagine un site immobilier : tu récupères toutes les annonces de la ville, puis Thunderbit visite chaque fiche pour collecter chambres, prix, agent, etc. Tout en une seule opération. Fini le copier-coller d’URLs ou les crawls à répétition.

Pour un guide visuel, mate .

IA ou modèle prêt-à-l’emploi : quel mode choisir ?

Tous les sites ne nécessitent pas l’IA complète. Pour les plateformes standards comme Amazon, Shopify ou Zillow, Thunderbit propose des modèles instantanés. Ce sont des extracteurs préconfigurés qui savent exactement où se trouve la donnée — export en un clic.

Quand utiliser le mode IA :

- Sites inconnus ou sur-mesure

- Structures complexes ou champs personnalisés

- Besoin de transformer ou catégoriser les données à la volée

Quand utiliser un modèle :

- Sites populaires et standardisés (Amazon, LinkedIn, Instagram…)

- Pour la rapidité et la fiabilité

L’interface Thunderbit te suggère même un modèle si dispo. Sinon, passe en mode IA et laisse faire l’intelligence artificielle.

Aligner la découverte de pages sur tes objectifs business

Petit rappel : « Trouver toutes les pages d’un site » n’est pas toujours le vrai objectif. Ce qu’il te faut, ce sont toutes les pages utiles pour ton besoin.

- Équipes commerciales : seules les pages avec coordonnées les intéressent.

- Marketing : tous les articles, landing pages ou URLs de campagne.

- Opérations : pages produits ou conformité.

Thunderbit te permet de décrire ton objectif en langage naturel — « Récupère toutes les pages avec une adresse email », ou « Liste chaque page produit avec prix et référence ». L’IA adapte alors la collecte pour ne pas gaspiller de temps (ou de crédits) sur des pages inutiles.

Astuces pour cibler efficacement l’extraction :

- Sois précis dans les champs et instructions

- Utilise ta connaissance métier (« extraire toutes les pages /ressources/ »)

- Ajuste tes prompts si le résultat est trop large ou trop restreint

Cette approche fait gagner du temps, évite la surcharge de données et garantit une liste de liens vraiment exploitable.

Pas à pas : utiliser Thunderbit pour obtenir toutes les pages d’un site

Envie de tester ? Voilà comment j’utilise Thunderbit pour obtenir la liste complète des liens — sans coder.

- Installer l’ : Installation rapide, version gratuite dispo.

- Aller sur le site cible : Depuis la page d’accueil ou une section précise.

- Ouvrir Thunderbit et choisir la source de données : Par défaut « Page actuelle ».

- Cliquer sur « IA Suggérer les champs » : Thunderbit analyse la page et propose des colonnes (titre, URL, etc.).

- Vérifier et ajuster les champs : Renommer, ajouter ou supprimer selon tes besoins. Définir les types de données.

- Activer l’extraction de sous-pages (si besoin) : Pour les pages de détail, active « Extraire les sous-pages » et indique le champ de lien.

- Cliquer sur « Extraire » : Thunderbit gère la pagination, le scroll infini et les sous-pages tout seul.

- Suivre la progression : Regarde le tableau se remplir. Vérifie quelques entrées pour la qualité.

- Exporter la liste de liens : Télécharge en CSV, ou exporte vers Excel, Google Sheets, Notion ou Airtable.

- Affiner et recommencer : Si une section manque, relance une extraction ou ajuste tes prompts.

Pour plus de détails, le est super complet.

À retenir : construire une liste complète de liens avec Thunderbit

En résumé :

- Les méthodes classiques (Google, sitemaps, crawlers) sont utiles mais laissent de côté plein de pages cachées, dynamiques ou orphelines.

- L’Extracteur Web IA de Thunderbit apporte une vraie compréhension sémantique, gère la navigation complexe, le scroll infini et les sous-pages sans prise de tête technique.

- Aligne l’extraction sur tes objectifs business : ne récupère pas tout, mais ce qui compte vraiment.

- L’atout Thunderbit : En convertissant les pages en Markdown avant extraction, l’IA comprend la structure du site, même si la mise en page change ou si le contenu est dynamique.

- Accessible à tous : Pas besoin de coder, pas de script, il suffit de décrire ce que tu veux et Thunderbit s’occupe du reste.

- Des résultats exploitables : Exporte des données structurées vers tes outils préférés pour tes audits, projets SEO ou campagnes de prospection.

Si tu n’as pas encore testé la découverte de pages par l’IA, essaie . Tu risques d’être surpris par ce que cache ton propre site… ou par ce que tes concurrents gardent dans leur grenier numérique.

FAQ

1. Pourquoi dresser une liste complète des pages d’un site est-il important pour la planification de contenu ?

Une liste exhaustive permet d’identifier le contenu obsolète ou orphelin, de faciliter les audits, de repérer les problèmes SEO et de détecter des opportunités de mise à jour ou de réutilisation. Elle aide aussi à la génération de leads, à l’analyse concurrentielle et au suivi opérationnel.

2. Quelles sont les limites des méthodes traditionnelles pour trouver toutes les pages d’un site ?

Les outils classiques comme les opérateurs Google, les sitemaps ou les crawlers SEO ratent souvent le contenu dynamique, les pages orphelines ou celles cachées derrière des scripts et interactions. Ils n’arrivent généralement pas à tout découvrir à cause de la complexité de navigation et du rendu des pages.

3. En quoi l’Extracteur Web IA de Thunderbit est-il différent des outils de crawl classiques ?

Thunderbit utilise l’IA pour comprendre la structure sémantique d’une page en la convertissant en Markdown avant extraction. Il gère le scroll infini, les liens JavaScript et les boutons « Charger plus », en simulant le comportement d’un utilisateur humain.

4. Quelles équipes bénéficient d’une liste complète de liens, et comment ?

SEO, content marketing, ventes, e-commerce, conformité… Tous y gagnent. Par exemple, le SEO repère et corrige les pages orphelines, les commerciaux extraient les pages contacts, les ops surveillent les fiches produits non accessibles via la navigation.

5. Quand utiliser le mode IA de Thunderbit ou un modèle ?

Utilise le mode IA pour les sites complexes, sur-mesure ou dynamiques. Privilégie un modèle pour les plateformes connues comme Shopify ou Amazon, où les extracteurs préconfigurés garantissent rapidité et fiabilité.

Pour aller plus loin :