Je me rappelle encore la toute première fois où j’ai voulu extraire une liste de prospects depuis un site web. Je me suis dit : « JavaScript, c’est mon truc, ça va rouler ! » Mais après quelques heures, j’étais perdu dans des sélecteurs imbriqués, du contenu qui disparaissait dès que je pensais l’avoir attrapé, et j’ai découvert à quel point les systèmes anti-bot pouvaient être coriaces. Je ne suis clairement pas le seul : affirment aujourd’hui que la donnée est devenue vitale pour leur business, et l’extraction web est au centre de cette révolution. Mais plus les sites deviennent complexes, plus l’extraction web javascript devient à la fois puissante… et prise de tête.

Dans ce guide, je te partage tout ce que j’ai appris sur l’extraction de données web avec javascript : des bases aux galères, et comment des outils modernes boostés à l’IA comme peuvent t’éviter bien des migraines de sélecteurs. Que tu veuilles récupérer des fiches produits pour ton équipe e-commerce ou alimenter ton pipe commercial, on va plonger ensemble dans les coulisses de l’extraction web javascript (avec un bon coup de pouce de l’IA).

Extraction de données web avec JavaScript : les bases et les galères

On commence par l’essentiel : l’extraction de données web avec javascript, c’est automatiser la récupération d’infos sur des sites, soit avec des scripts dans le navigateur, soit côté serveur avec Node.js. JavaScript, c’est la langue du web, donc logique de s’en servir, surtout avec tout l’écosystème dispo : Cheerio (pour analyser du HTML statique), Puppeteer ou Playwright (pour piloter un navigateur sans interface).

Pourquoi JavaScript cartonne pour l’extraction web ?

- Accès direct au DOM : Dans le navigateur, tu manipules la page comme si tu étais un vrai utilisateur.

- Écosystème riche : Node.js propose des bibliothèques puissantes pour les requêtes HTTP, l’analyse et l’automatisation.

- Flexibilité : Tu peux automatiser connexions, clics, scrolls… tout ce que tu fais dans Chrome, tu peux le scripter.

Mais il y a un hic : les sites modernes changent tout le temps. Ils utilisent JavaScript pour charger le contenu à la volée, réorganiser le DOM, et déployer des barrières anti-bot. Résultat : ton script marche aujourd’hui, mais demain il plante. Tu passes ton temps à bidouiller les sélecteurs, gérer les pop-ups et courir après des données qui arrivent en retard. C’est un peu comme jouer à la taupe, mais avec plus d’accolades.

Pourquoi les sites modernes rendent l’extraction web javascript si galère

Avant, il suffisait de choper le HTML et de piocher dedans. Aujourd’hui, c’est une autre histoire. Des sites comme Facebook Marketplace, Amazon ou même les annonces immobilières locales s’appuient sur des frameworks JavaScript qui génèrent le contenu à la volée, cachent les infos derrière des scrolls infinis, et imbriquent tout dans des structures DOM bien tordues.

L’analyse HTML classique ne suffit plus. Par exemple, extraire des avis produits ou des commentaires imbriqués, ce n’est plus juste trouver le bon <div> : il faut piger les relations entre les éléments, le contexte de chaque champ, et parfois même le sens des données.

C’est là qu’une pré-analyse intelligente devient indispensable. Plutôt que de juste récupérer du HTML brut, il faut une approche qui comprend vraiment la page : où est le nom du produit, le prix, l’avis utilisateur ? C’est chaud pour du JavaScript pur… mais c’est là que les outils boostés à l’IA font toute la différence.

Les outils classiques pour l’extraction web javascript

Côté outils, la boîte à outils classique pour l’extraction web javascript, c’est souvent :

- Cheerio : Parfait pour analyser du HTML statique. C’est un peu le jQuery du serveur.

- Puppeteer/Playwright : Pour automatiser un navigateur sans interface. Ces outils lancent un vrai navigateur, exécutent le JavaScript, et te permettent d’interagir avec la page comme un humain (ou un robot super motivé).

Un workflow typique :

- Charger la page (avec ou sans navigateur sans interface).

- Attendre que le contenu s’affiche (par exemple avec

waitForSelector). - Analyser le DOM pour extraire les données.

- Structurer et exporter les résultats.

Ça a l’air simple, non ? Mais voilà le souci : à chaque changement de mise en page, tes sélecteurs cassent. Si un pop-up débarque, ton script bloque. Si l’ordre des champs change, tes données sont mélangées. La maintenance devient vite un vrai casse-tête.

Comparatif des principales bibliothèques d’extraction web javascript

| Fonctionnalité | Cheerio | Puppeteer | Playwright |

|---|---|---|---|

| Idéal pour | HTML statique | Pages dynamiques | Pages dynamiques |

| Automatisation navigateur | Non | Oui | Oui |

| Gère le contenu JS | Non | Oui | Oui |

| Vitesse | Rapide | Plus lent | Plus lent |

| Simplicité API | Simple | Moyenne | Moyenne |

| Contournement anti-bot | Limité | Moyen | Moyen |

| Multi-navigateurs | Non | Chrome uniquement | Chrome, Firefox, WebKit |

| Cas d’usage | Sites simples, APIs | Sites interactifs | Sites interactifs |

Cheerio est ultra-rapide pour les pages statiques ou les APIs qui renvoient du HTML, mais il ne sait pas exécuter de JavaScript. Puppeteer et Playwright sont incontournables pour le dynamique, mais plus lourds à mettre en place. Ils permettent d’automatiser connexions, clics, scrolls, mais il faudra écrire la logique pour chaque site.

Thunderbit : l’extraction web IA qui change la donne pour JavaScript

C’est là que ça devient vraiment intéressant. Chez Thunderbit, on a pigé que l’extraction web, ce n’est pas juste récupérer du HTML : il faut comprendre la page comme le ferait un humain. C’est pour ça qu’on a créé , une extension Chrome Extracteur Web IA qui apporte une vraie compréhension sémantique à l’extraction de données.

Comment ça marche ?

- Thunderbit transforme la page web en une version Markdown — une version plus propre et structurée de la page.

- Notre IA analyse ce Markdown pour repérer les champs, les relations et le contexte : elle sait faire la différence entre un prix, un avis, ou un simple emoji décoratif.

- Résultat : tu récupères des données structurées et étiquetées, résistantes aux changements de mise en page, au contenu dynamique et aux DOM qui bougent.

Pour les pros, ça veut dire moins de nettoyage manuel, moins de scripts qui plantent, et plus de temps pour l’analyse. Pour les devs, tu peux te concentrer sur l’automatisation de la navigation (connexions, clics, scrolls) et laisser Thunderbit gérer l’extraction complexe.

Tutoriel pas à pas : extraction web javascript (classique et avec Thunderbit)

Passons à la pratique. Voici un exemple concret : extraire des fiches produits d’un site e-commerce fictif. D’abord, la méthode classique avec Puppeteer. Ensuite, comment accélérer tout ça avec Thunderbit.

Étape 1 : Préparer ton environnement d’extraction javascript

Avant tout, installe . Une fois prêt, installe Puppeteer :

1npm install puppeteerSi tu préfères Playwright (qui gère plusieurs navigateurs) :

1npm install playwrightPas besoin d’être un crack : copie-colle les bouts de code, je t’explique chaque étape.

Étape 2 : Naviguer et interagir avec des pages dynamiques

Les sites modernes adorent cacher les données derrière des connexions, pop-ups ou scrolls infinis. Voici comment automatiser ces étapes avec Puppeteer :

1const puppeteer = require('puppeteer');

2(async () => {

3 const browser = await puppeteer.launch({ headless: true });

4 const page = await browser.newPage();

5 // Aller à la page de connexion

6 await page.goto('https://example.com/login');

7 await page.type('#username', 'your_username');

8 await page.type('#password', 'your_password');

9 await page.click('#login-button');

10 await page.waitForNavigation();

11 // Aller aux produits

12 await page.goto('https://example.com/products');

13 // Scroll pour charger plus d’articles

14 await page.evaluate(async () => {

15 for (let i = 0; i < 5; i++) {

16 window.scrollBy(0, window.innerHeight);

17 await new Promise(resolve => setTimeout(resolve, 1000));

18 }

19 });

20 // Attendre le chargement des produits

21 await page.waitForSelector('.product-card');

22 // ... (on extrait les données à l’étape suivante)

23})();Ce script se connecte, va sur la page des produits et scrolle pour charger plus d’articles. L’important, c’est d’attendre que les éléments soient là — sinon, tu risques de ne rien extraire.

Étape 3 : Extraire les données avec JavaScript

On passe à l’extraction. Imaginons que chaque produit soit dans une div .product-card :

1const products = await page.$$eval('.product-card', cards =>

2 cards.map(card => ({

3 name: card.querySelector('.product-title').innerText,

4 price: card.querySelector('.product-price').innerText,

5 link: card.querySelector('a').href,

6 }))

7);

8console.log(products);Les pièges classiques :

- Les sélecteurs cassent vite. Si

.product-titledevient.title, le script plante. - Données cachées. Parfois, les prix ou avis sont chargés en AJAX après le rendu.

- Anti-bot. Trop de requêtes, et tu risques d’être bloqué.

Étape 4 : Booster l’extraction avec l’IA Thunderbit

C’est là que Thunderbit entre en jeu. Plutôt que de jongler avec des sélecteurs fragiles, envoie le HTML rendu (ou même une capture d’écran) à Thunderbit pour une extraction intelligente.

Comment ça se passe concrètement ?

- Utilise Puppeteer ou Playwright pour automatiser la navigation, la connexion, etc.

- Une fois sur la page à extraire, récupère le HTML :

1const pageContent = await page.content();- Envoie ce HTML à Thunderbit (via l’) pour extraction par l’IA.

Thunderbit va :

- Transformer la page en Markdown pour une analyse sémantique plus simple.

- Utiliser l’IA pour repérer champs, relations et contexte.

- Générer des données structurées exportables vers Excel, Google Sheets, Airtable ou Notion.

Fini la galère des sélecteurs qui changent ou du nettoyage interminable.

Gérer le contenu dynamique et le chargement asynchrone

Le contenu dynamique, c’est le cauchemar de tout extracteur web javascript. Les sites chargent souvent les données après le rendu initial : scroll infini, boutons « Charger plus », avis en AJAX…

Stratégies classiques :

- Utiliser

waitForSelectorpour attendre l’apparition des éléments. - Attendre que le réseau soit calme avant d’extraire.

- Déclencher manuellement scrolls ou clics pour charger plus de données.

Mais ces méthodes sont fragiles. Si la logique de chargement change, ton script casse.

L’approche Thunderbit : En convertissant la page en Markdown et en laissant l’IA analyser la structure, Thunderbit dépend moins de la hiérarchie DOM ou des IDs. Même si la mise en page change, tant que le contenu est là, l’IA de Thunderbit saura généralement l’extraire. Résultat : moins de maintenance, plus de fiabilité.

Construire un pipeline de données solide : du script à l’analyse métier

L’extraction, ce n’est pas juste une tâche ponctuelle : c’est le début d’un vrai pipeline de données. Voici comment je vois les choses :

- Automatise la navigation et l’extraction avec JavaScript (Puppeteer/Playwright).

- Confie la structuration à Thunderbit pour un étiquetage intelligent.

- Exporte les résultats vers Excel, Google Sheets, Airtable, Notion…

- Planifie des tâches récurrentes avec l’ de Thunderbit : indique juste la fréquence (« chaque lundi à 9h »), colle tes URLs, et laisse Thunderbit gérer le reste.

- Boucle la boucle en intégrant les données structurées à tes process métier : prospection, veille tarifaire, études de marché…

Ce combo — JavaScript pour l’automatisation, Thunderbit pour l’extraction IA — te permet de monter des pipelines fiables, réplicables et qui ne te bouffent pas tout ton temps pour alimenter ton business en données fraîches.

Conclusion : quelle approche d’extraction web javascript choisir ?

Alors, c’est quoi la meilleure façon de faire de l’extraction web javascript ? Mon avis :

- L’extraction JavaScript classique (Cheerio, Puppeteer, Playwright) est top pour les sites simples ou si tu veux tout contrôler. Mais ça demande beaucoup de maintenance : sélecteurs fragiles, mises en page qui changent, anti-bot de plus en plus malins.

- L’extraction boostée à l’IA avec Thunderbit ajoute une vraie couche de compréhension sémantique. Plus robuste face aux changements, moins de nettoyage manuel, et tu peux te concentrer sur l’analyse plutôt que sur le débogage.

Quand utiliser quoi ?

- Pour des extractions ponctuelles sur des pages simples, Cheerio ou Puppeteer suffisent.

- Pour des sites complexes ou dynamiques — ou si tu veux un workflow qui tienne la route — combine tes scripts JavaScript avec l’extraction IA de Thunderbit.

- Pour les utilisateurs métier qui veulent éviter le code, l’extension Chrome Thunderbit est la solution la plus rapide pour passer d’une page web à un tableur en deux clics.

Envie d’autres exemples ? Va jeter un œil au pour des tutos détaillés sur , , et bien plus.

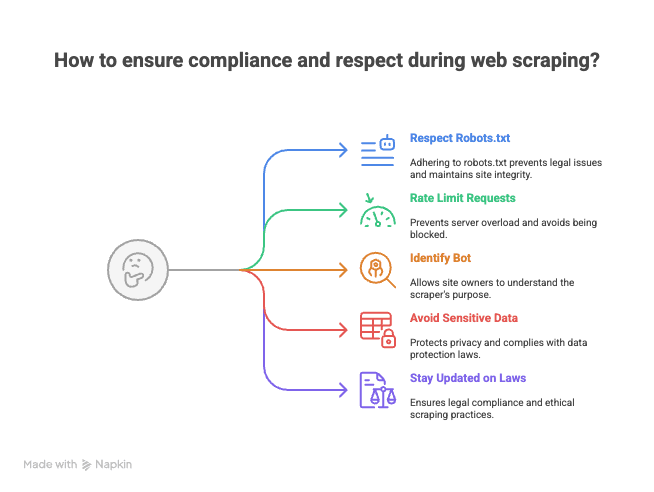

Bonus : conseils pour rester clean et respectueux en extraction web

Avant de lancer tes scripts sur le web, petit rappel (expérience vécue après quelques « gentils » messages d’admins de sites) :

- Respecte le robots.txt et les conditions d’utilisation. Tous les sites n’aiment pas être extraits.

- Limite la fréquence de tes requêtes. N’inonde pas les serveurs — espace tes demandes pour éviter d’être bloqué (ou pire, blacklisté).

- Identifie ton bot. Utilise un User-Agent personnalisé pour que les propriétaires sachent qui tu es.

- N’extrais pas de données sensibles ou personnelles. Reste sur l’info publique et respecte la vie privée.

- Renseigne-toi sur la législation et les bonnes pratiques. L’extraction web, c’est parfois une zone grise selon les pays.

Souviens-toi : un grand pouvoir d’extraction implique de grandes responsabilités (et parfois, un courrier d’avocat).

L’extraction web javascript, c’est à la fois un art et une science. Avec les bons outils — et un peu d’IA — tu peux transformer le web en une vraie mine de données structurées. Et si tu galères, tu sais où me trouver (probablement en train de déboguer des sélecteurs, café à la main et onglet Thunderbit ouvert).

Bonne extraction !

FAQ

1. C’est quoi l’extraction web avec JavaScript et pourquoi c’est populaire ?

L’extraction web avec JavaScript, c’est automatiser la récupération de données de sites en lançant des scripts dans le navigateur ou via Node.js côté serveur. C’est populaire parce que JavaScript donne un accès direct au DOM, propose plein de bibliothèques pour les requêtes HTTP et l’automatisation, et permet de simuler des actions comme les connexions, clics ou scrolls.

2. Quels sont les plus gros défis de l’extraction sur des sites modernes et dynamiques ?

Les sites modernes utilisent souvent des frameworks JavaScript pour charger le contenu dynamiquement, cacher les données derrière des scrolls infinis ou des pop-ups, et changent souvent de structure. Du coup, les méthodes classiques sont fragiles : les scripts cassent dès que les sélecteurs changent ou que les données arrivent en retard.

3. Comment comparer Cheerio, Puppeteer et Playwright pour l’extraction web javascript ?

- Cheerio est parfait pour le HTML statique et super rapide, mais ne gère pas le contenu généré par JavaScript ni l’automatisation du navigateur.

- Puppeteer et Playwright sont faits pour les pages dynamiques, permettent d’automatiser le navigateur et gèrent le contenu JavaScript, mais sont plus lents et demandent plus de configuration. Playwright gère plusieurs navigateurs, Puppeteer surtout Chrome.

4. Quels avantages Thunderbit offre par rapport aux méthodes classiques ?

Thunderbit utilise l’IA pour comprendre sémantiquement les pages web en les transformant en Markdown structuré, puis en extrayant les champs de données étiquetés. Cette approche est plus robuste face aux changements de mise en page, réduit le nettoyage manuel et limite la maintenance par rapport à l’extraction basée sur les sélecteurs.

5. Quelles sont les bonnes pratiques pour rester clean et respectueux lors de l’extraction web ?

- Toujours vérifier et respecter le robots.txt et les conditions d’utilisation du site.

- Limiter la fréquence des requêtes pour ne pas surcharger les serveurs.

- Identifier ton bot avec un User-Agent personnalisé.

- Ne pas extraire de données sensibles ou personnelles, rester sur l’info publique.

- Se tenir informé des aspects légaux et des bonnes pratiques dans ton pays.

Pour aller plus loin :