Je vais être honnête : la première fois que j’ai voulu récupérer toutes les URLs d’un gros site, je me suis dit « Franchement, ça doit être simple ! ». Quelques heures plus tard, j’étais encore en train de cliquer partout, à copier-coller des liens dans un tableur, en me demandant pourquoi j’avais choisi ce métier. Si tu as déjà essayé de trouver toutes les pages d’un site web — que ce soit pour un audit, une liste de prospects ou surveiller la concurrence — tu sais à quel point c’est galère. C’est interminable, tu fais des erreurs, et franchement, c’est du temps perdu qui pourrait être bien mieux utilisé.

Mais la bonne nouvelle, c’est qu’aujourd’hui il existe des solutions bien plus futées. Des outils boostés à l’IA comme changent la donne pour les pros, permettant de trouver toutes les URLs d’un domaine en quelques minutes au lieu d’y passer des jours. D’ailleurs, les boîtes qui passent à des extracteurs web IA constatent sur la collecte de données, et parfois jusqu’à par rapport à la méthode artisanale. Ce ne sont pas que des stats : c’est des heures, voire des jours, de ta vie que tu récupères.

Alors, voyons pourquoi trouver toutes les pages d’un site est si compliqué, pourquoi les IA généralistes comme GPT ou Claude ne sont pas la solution, et comment des agents IA spécialisés — comme Thunderbit — rendent cette mission ultra simple. Et oui, je vais te montrer étape par étape comment extraire toutes les URLs dont tu as besoin, même si tu n’as aucune compétence technique.

Pourquoi c’est galère de trouver toutes les URLs d’un domaine ?

Soyons clairs : les sites web ne sont pas faits pour te donner une liste toute propre de leurs pages. Ils sont pensés pour les visiteurs, pas pour ceux qui veulent lister toutes les pages d’un site d’un coup. Voilà pourquoi c’est un vrai casse-tête :

- Copier-coller à la main : Cliquer sur chaque menu, chaque liste, chaque répertoire, copier les URLs une par une… c’est le meilleur moyen de finir avec des crampes (et d’en zapper la moitié).

- Pagination et scroll infini : Beaucoup de sites répartissent leur contenu sur plusieurs pages ou chargent plus de résultats au fur et à mesure qu’on descend. Si tu rates un bouton « Suivant » ou que tu ne scrolles pas assez, tu passes à côté de pans entiers du site.

- Structures de pages variées : Certains liens sont affichés d’une façon, d’autres dans un format complètement différent. S’y retrouver devient vite un enfer.

- Pages cachées ou orphelines : Toutes les pages ne sont pas accessibles depuis le menu principal. Certaines sont planquées, accessibles seulement via un sitemap ou la recherche interne.

- Erreurs humaines : Plus il y a de pages à copier, plus tu risques de faire des doublons, des fautes, ou d’en oublier.

Et si le site a des centaines ou des milliers de pages ? Laisse tomber. L’extraction manuelle, c’est mission impossible. Comme le disent les pros de la data, au-delà des cas simples, .

Qu’est-ce qu’on entend par « trouver toutes les pages d’un site » ?

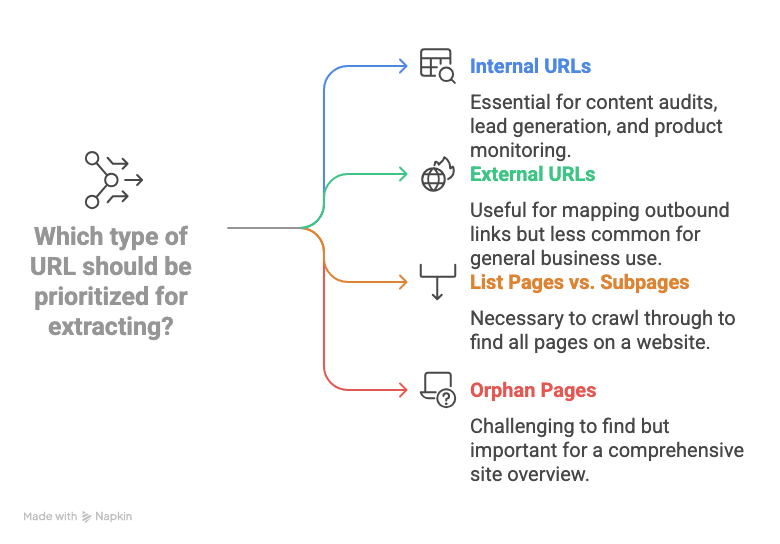

Avant de passer aux solutions, soyons clairs sur ce qu’on cherche vraiment :

- URLs internes : Ce sont les liens qui pointent vers des pages du même site (ex : /a-propos, /produits/widget-123). Pour la plupart des usages pros — audit, prospection, veille — c’est ça qui compte.

- URLs externes : Liens qui mènent vers d’autres sites. Sauf cas particulier, on ne s’en occupe pas ici.

- Pages de liste vs sous-pages : Beaucoup de sites ont des pages « hub » ou « liste » (catégories, archives, annuaires) qui renvoient vers des pages détaillées (produits, profils…). Pour vraiment trouver toutes les pages, il faut parcourir ces listes et récupérer chaque sous-page.

- Pages orphelines : Pages non reliées à la navigation classique. On peut parfois les repérer via le sitemap ou la recherche interne, mais elles passent souvent à la trappe.

En bref, trouver toutes les URLs d’un domaine, c’est obtenir la liste complète des pages internes, de la page d’accueil jusqu’aux recoins les plus profonds, dans un format exploitable (tableur, CSV…).

Les méthodes classiques pour lister toutes les URLs d’un site

Il existe quelques techniques traditionnelles, mais elles ont toutes leurs limites :

Copier-coller manuel et extensions navigateur

La méthode « old school » : cliquer sur chaque lien, copier chaque URL, coller dans un tableur… et espérer ne rien zapper. Certains utilisent des extensions pour extraire tous les liens d’une page, mais il faut recommencer pour chaque page, et gérer la pagination ou les sections cachées à la main. Pratique pour un mini-site, pas pour un site costaud.

Recherche Google et sitemaps

- Recherche Google site: : Tape site:votredomaine.com dans Google, tu verras une partie des pages indexées. Mais Google ne montre que ce qu’il a indexé (souvent limité à 1 000 résultats), donc tu rates les pages récentes, cachées ou jugées peu intéressantes. le dit : ce n’est pas exhaustif.

- Sitemaps XML : Beaucoup de sites proposent un /sitemap.xml listant les URLs importantes. Pratique… si le sitemap est à jour et complet. Mais tous les sites n’en ont pas, certains les découpent en plusieurs fichiers, et les pages orphelines n’y sont pas toujours.

Crawlers techniques et scripts

- Outils SEO (ex : Screaming Frog) : Ils explorent le site comme un moteur de recherche et sortent la liste des URLs. Puissants, mais il faut les configurer, les installer, et parfois payer une licence pour les gros sites.

- Scripts Python (ex : Scrapy) : Les développeurs peuvent coder des scripts pour crawler et extraire les URLs. Mais soyons honnêtes : si tu n’es pas à l’aise avec le code, c’est mort. Et dès que le site change, il faut tout refaire.

En résumé : Les méthodes classiques sont soit trop manuelles, soit incomplètes, soit trop techniques pour la plupart des pros. Pas étonnant que beaucoup abandonnent en cours de route.

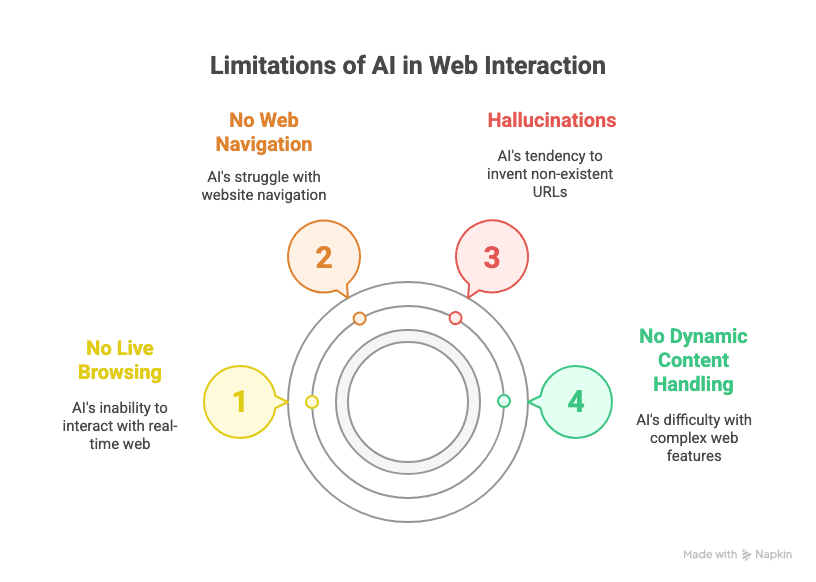

Pourquoi les IA généralistes ne suffisent pas pour extraire toutes les URLs

Tu te dis peut-être : « Je n’ai qu’à demander à ChatGPT ou Claude de me lister toutes les pages d’un site ! » Si seulement c’était aussi simple… Voilà la réalité :

- Pas de navigation en direct : Les IA généralistes comme GPT ou Claude ne peuvent pas naviguer sur le web en temps réel. Elles ne « voient » pas l’état actuel d’un site, elles se basent sur leurs données d’entraînement ou ce que tu leur donnes.

- Pas de navigation web réelle : Même avec des plugins, ces IA ne savent pas cliquer sur « Suivant », gérer le scroll infini ou suivre tous les liens d’un site.

- Hallucinations : Demande-leur toutes les URLs d’un domaine, elles vont souvent inventer des liens plausibles… mais qui n’existent pas (j’ai vu des /a-propos sortis de nulle part !).

- Pas de gestion du contenu dynamique : Les sites qui chargent du contenu en JavaScript, nécessitent une connexion ou ont une navigation complexe sont hors de portée pour ces IA.

Comme le dit , « Si tu veux extraire des centaines ou des milliers de pages… ChatGPT seul ne suffit pas. » Il faut un outil fait pour ça.

Les agents IA verticaux : le futur de l’extraction web

C’est là que mon expérience dans le SaaS et l’automatisation prend tout son sens : les agents IA verticaux — des IA spécialisées dans un domaine précis, comme l’extraction de données web — sont la seule solution fiable et scalable pour les pros. Pourquoi ?

- Les LLM généralistes sont top pour rédiger ou chercher, mais ils hallucinent facilement et ne gèrent pas les workflows complexes et répétitifs avec la fiabilité attendue en entreprise.

- Les outils SaaS pros doivent automatiser des tâches structurées et répétitives. C’est là que les agents IA verticaux excellent : ils font une chose, mais ils la font parfaitement, avec un minimum d’erreurs.

- Des exemples dans tous les secteurs : Thunderbit pour l’extraction web, Devin AI pour le développement logiciel, Alta pour l’automatisation commerciale, Infinity Learn’s IL VISTA pour l’éducation, Rippling pour les RH, Harvey pour le juridique… la liste est longue.

En clair : pour trouver toutes les pages d’un site de façon fiable, il te faut un agent IA vertical, pas un chatbot généraliste.

Découvrez Thunderbit : l’extraction d’URLs par IA accessible à tous

C’est là que entre en scène. En tant qu’extension Chrome Extracteur Web IA, Thunderbit a été pensé pour les pros : pas de code, pas de prise de tête technique, juste des résultats. Ce qui le rend unique :

- Interface en langage naturel : Décris simplement ce que tu veux (« Liste toutes les URLs de ce site »), l’IA de Thunderbit s’occupe du reste.

- Suggestion automatique de champs : Thunderbit analyse la page et propose automatiquement des colonnes (ex : « URL de la page ») — pas besoin de manipuler des sélecteurs CSS ou XPath.

- Gère la pagination et le scroll infini : Thunderbit peut cliquer sur « Suivant » ou scroller tout seul, pour ne rater aucune page.

- Navigation dans les sous-pages : Besoin d’aller plus loin ? Thunderbit peut suivre les liens vers les sous-pages et extraire les infos qui s’y trouvent.

- Export structuré : Exporte tes résultats direct vers Google Sheets, Excel, Notion, Airtable ou CSV — gratuitement et en un clic.

- Aucune compétence technique requise : Si tu sais naviguer sur un site, tu sais utiliser Thunderbit. C’est aussi simple que ça.

Et comme Thunderbit est un agent IA vertical, il est conçu pour la stabilité et la répétabilité — parfait pour automatiser des tâches récurrentes en entreprise.

Tutoriel : comment trouver toutes les URLs d’un domaine avec Thunderbit

Prêt à voir comment ça marche ? Voici un guide pas à pas, sans jargon, pour extraire toutes les URLs dont tu as besoin.

1. Installe l’extension Chrome Thunderbit

Commence par . Compatible avec Chrome, Edge, Brave et tous les navigateurs Chromium. Épingle-la dans ta barre d’outils pour l’avoir sous la main.

2. Ouvre la page de liste ou d’annuaire cible

Va sur le site dont tu veux extraire les URLs. Ça peut être la page d’accueil, un sitemap, un annuaire ou n’importe quelle page qui liste les liens qui t’intéressent.

3. Lance Thunderbit et configure tes champs

Clique sur l’icône Thunderbit pour ouvrir l’extension. Crée un nouveau modèle d’extraction. C’est là que la magie opère :

- Clique sur « Suggestion IA de champs ». L’IA de Thunderbit scanne la page et propose des colonnes — cherche celle nommée « URL de la page », « Lien » ou équivalent.

- Si le champ exact n’apparaît pas, ajoute simplement une colonne nommée « URL de la page » (ou un nom pertinent). L’IA de Thunderbit reconnaît ces termes et les associe aux bonnes données.

4. Active la pagination ou le scroll (si besoin)

Si la page cible a plusieurs pages (ex : « Page 1, 2, 3… » ou un bouton « Charger plus »), active la pagination dans Thunderbit :

- Passe en mode « Cliquer sur la pagination » pour les sites avec bouton « Suivant », ou « Scroll infini » pour ceux qui chargent au fil du scroll.

- Thunderbit te demandera de sélectionner le bouton « Suivant » ou la zone de scroll — clique dessus, l’IA s’occupe du reste.

5. Lance l’extraction et vérifie tes résultats

Appuie sur le bouton « Extraire ». Thunderbit va parcourir toutes les pages et collecter chaque URL trouvée. Les résultats s’affichent dans un tableau directement dans l’extension. Pour les gros sites, ça peut prendre quelques minutes, mais c’est toujours bien plus rapide qu’à la main.

6. Exporte ta liste d’URLs

Une fois l’extraction terminée, clique sur Exporter. Tu peux envoyer tes données directement vers :

- Google Sheets

- Excel/CSV

- Notion

- Airtable

Les exports sont gratuits et gardent toute la mise en forme. Fini le copier-coller interminable.

Comparatif : Thunderbit face aux autres solutions d’extraction d’URLs

| Méthode | Facilité d’utilisation | Précision & couverture | Scalabilité | Options d’export |

|---|---|---|---|---|

| Copier-coller manuel | Douloureux | Faible (beaucoup d’oublis) | Aucune | Manuel (Excel, etc.) |

| Extracteurs de liens navigateur | OK pour 1 page | Moyenne | Faible | Manuel |

Recherche Google site: | Facile | Moyenne (incomplet) | Limité à ~1 000 | Manuel |

| Sitemap XML | Facile (si existe) | Bonne (si à jour) | Bonne | Manuel/Script |

| Outils SEO (Screaming Frog) | Technique | Élevée | Élevée (payant) | CSV, Excel |

| Scripts Python (Scrapy, etc.) | Très technique | Élevée | Élevée | Sur-mesure |

| Thunderbit | Très facile | Très élevée | Élevée | Google Sheets, CSV, etc. |

Thunderbit te donne la précision et la puissance d’un crawler pro avec la simplicité d’une extension navigateur. Pas de code, pas de prise de tête, juste des résultats.

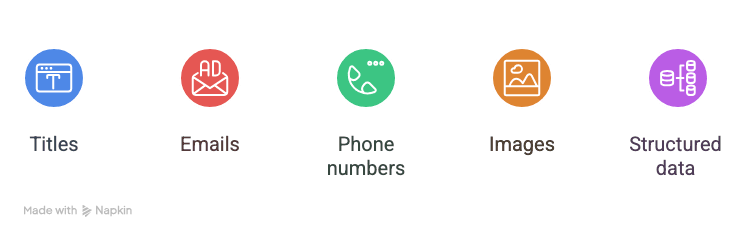

Bonus : extraire bien plus que des URLs avec Thunderbit

C’est là que ça devient vraiment intéressant. Thunderbit ne se limite pas aux URLs : tu peux extraire :

- Titres

- Emails

- Numéros de téléphone

- Images

- Toute donnée structurée présente sur la page

Par exemple, pour une liste de prospects, Thunderbit peut récupérer l’URL du profil, le nom, l’email et le téléphone de chaque contact — en une seule opération. Pour un audit produit, il extrait l’URL, le nom, le prix et le stock. Thunderbit gère même , en cliquant sur chaque lien pour aller chercher les détails.

Et oui, les extracteurs d’emails et de téléphones de Thunderbit sont 100 % gratuits. Un vrai plus pour les équipes commerciales et marketing.

À retenir : comment trouver toutes les pages d’un site avec l’IA

En résumé :

- Extraire toutes les URLs d’un domaine est très difficile avec des outils manuels ou généralistes.

- Les IA généralistes comme GPT ne savent pas naviguer sur le web, gérer la pagination ou le contenu dynamique.

- Les agents IA verticaux comme Thunderbit sont faits pour l’extraction web : fiables, répétables, et accessibles à tous.

- Thunderbit simplifie tout : installe l’extension, laisse l’IA suggérer les champs, active la pagination, lance l’extraction et exporte. Zéro code, zéro prise de tête.

- Tu peux extraire bien plus que des URLs : titres, emails, téléphones, etc. — parfait pour la prospection, l’audit ou la veille.

Marre de copier-coller des liens ou de te battre avec des outils techniques ? . Il y a une version gratuite, histoire de voir par toi-même combien de temps (et d’énergie) tu vas gagner.

Et si tu veux découvrir d’autres usages de Thunderbit — comme , , ou — va faire un tour sur le pour plus de tutos et d’astuces.

Prêt à dire adieu à la collecte manuelle de données ? L’avenir de l’extraction web, ce sont les agents IA verticaux — et Thunderbit montre la voie. Essaie-le, et transforme ton prochain audit, ta liste de prospects ou ta veille en une formalité.

Pour aller plus loin

P.S. : Si jamais tu es tenté de copier-coller 1 000 URLs à la main, rappelle-toi : il existe une IA pour ça maintenant. Tes poignets (et ton boss) te diront merci !