Le monde d’aujourd’hui déborde de données, et la course pour en tirer profit devient de plus en plus féroce. Chaque jour, des milliards de pages web sont aspirées pour dénicher des infos, surveiller les prix, générer des leads ou faire avancer la recherche—que ce soit pour alimenter la guerre des prix dans l’e-commerce ou booster l’intelligence artificielle (). Le marché mondial de l’extraction web est d’ailleurs en passe de dépasser les 9 milliards de dollars d’ici fin 2025. Si tu n’utilises pas d’extracteur web efficace, tu rates sûrement des occasions en or ().

Après plusieurs années à bosser dans le SaaS et l’automatisation, j’ai vu à quel point le choix du bon extracteur web peut tout changer. Et franchement, Rust m’a bluffé par ses qualités. Dans ce guide, je t’explique pourquoi Rust est un super choix pour créer un extracteur web, comment te lancer étape par étape, et comment le coupler à des outils IA comme pour mixer vitesse, sécurité et simplicité.

Pourquoi miser sur Rust pour ton extracteur web ?

Allons droit au but : pourquoi choisir Rust ? On me pose souvent la question, surtout de la part de ceux qui ont l’habitude de scraper avec Python ou Node.js. Voilà ce qui fait la différence avec Rust :

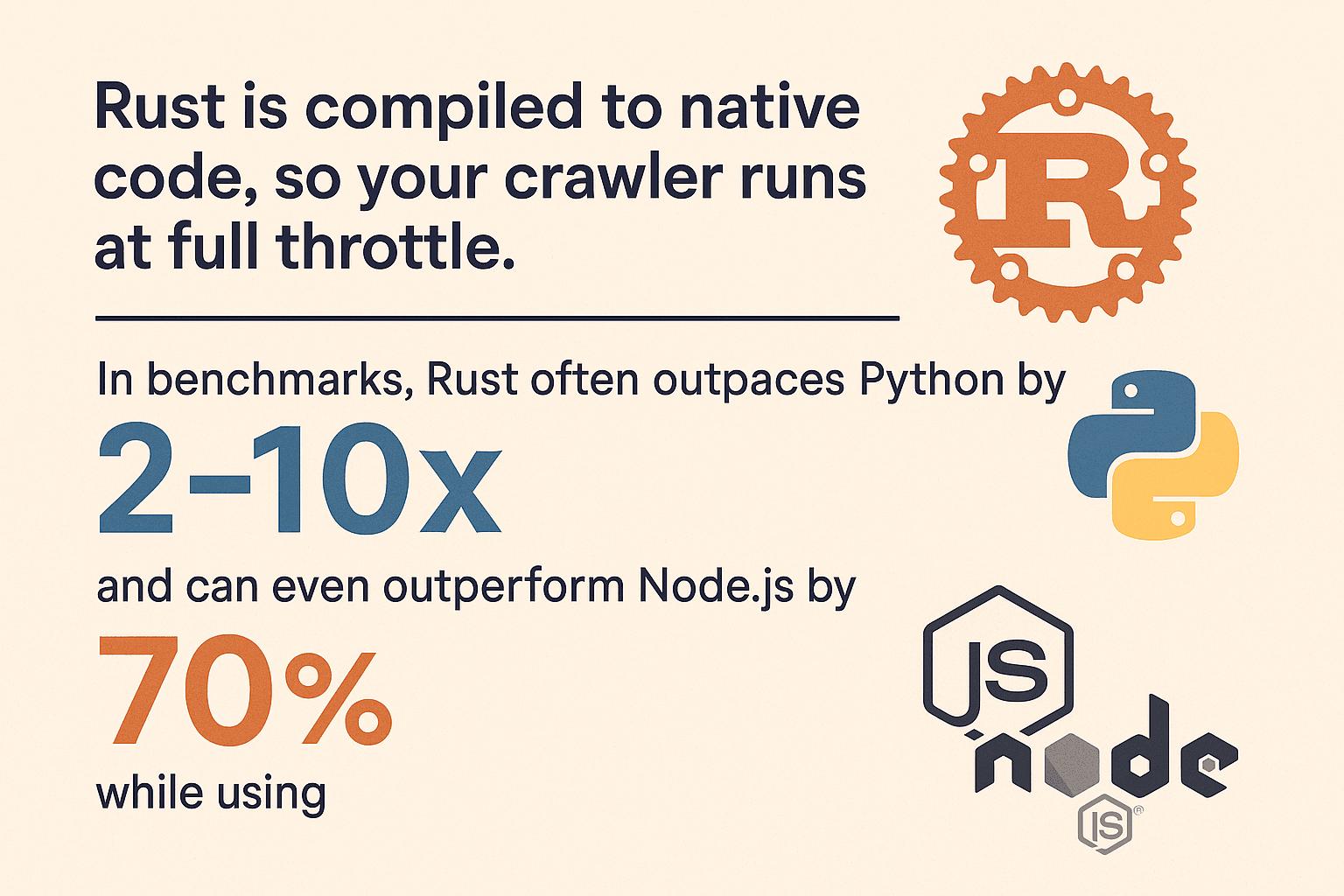

- Vitesse de dingue : Rust compile en natif, donc ton extracteur tourne à fond. Sur les benchmarks, Rust explose souvent Python (de 2 à 10 fois plus rapide), et peut même dépasser Node.js de 70 % tout en utilisant 90 % de mémoire en moins (, ).

- Sécurité mémoire : Avec le système de propriété de Rust, finis les crashs bizarres ou les fuites de mémoire. Le compilateur repère les bugs avant qu’ils ne te gâchent la vie.

- Concurrence sans prise de tête : Rust a été pensé pour la concurrence. Tu veux récupérer 100 pages en même temps ? Aucun souci—le système de types de Rust sécurise tes threads et évite les embrouilles de données.

- Fiabilité : La gestion des erreurs de Rust (avec

ResultetOption) t’oblige à anticiper les plantages. Ton extracteur ne va pas s’arrêter au moindre pépin. - Sécurité : Pas de dépassement de tampon, pas de pointeur nul. Les garanties de Rust rendent ton extracteur bien plus costaud face aux sites web malicieux ou mal fichus.

Comparé à Python (facile, mais lent et gourmand en RAM) ou Node.js (rapide en I/O, mais mono-thread et lourd), Rust offre des perfs et une stabilité de haut vol, surtout si tu veux passer à l’échelle ().

Préparer ton environnement Rust pour l’extraction web

Prêt à te lancer ? Voilà comment installer et configurer Rust :

1. Installer Rust et Cargo

Rust s’installe via , qui gère les versions de Rust et l’outil de build cargo. Télécharge l’installateur adapté à ton système et suis les instructions. Sur Windows, il faudra peut-être installer les outils de compilation Visual C++.

Vérifie l’installation :

1rustc --version

2cargo --versionSi tu vois les numéros de version, c’est tout bon.

2. Créer un nouveau projet

Ouvre ton terminal et tape :

1cargo new rust_web_crawler

2cd rust_web_crawlerTu obtiens un projet tout neuf avec un Cargo.toml et un src/main.rs.

3. Ajouter les dépendances essentielles

Pour scraper, il te faut :

- (client HTTP)

- (analyse HTML avec sélecteurs CSS)

- (runtime async, pour l’extraction en asynchrone)

- (pour exporter les données)

Ajoute-les avec :

1cargo add reqwest scraper csv tokio --features fullOu modifie ton Cargo.toml :

1[dependencies]

2reqwest = { version = "0.11", features = ["blocking"] }

3scraper = "0.16"

4csv = "1.1"

5tokio = { version = "1.28", features = ["full"] }4. Choisir ton IDE et tes outils

Perso, j’adore VS Code avec l’extension . Tu as l’auto-complétion, la doc intégrée et tout le linting qu’il faut. Pour les gros projets, JetBrains CLion ou IntelliJ avec le plugin Rust sont aussi top.

5. Astuces de dépannage

- Si

cargon’est pas reconnu, vérifie que le dossier.cargo/binest bien dans ton PATH. - Sur Windows, installe les outils C++ manquants si besoin.

- En cas d’erreur de dépendance, lance

cargo updateou vérifie l’orthographe dansCargo.toml.

Étape par étape : ton premier extracteur web en Rust

On va construire un extracteur simple qui récupère une page, extrait des infos produits et les exporte en CSV. C’est une base que tu pourras enrichir ensuite.

Récupérer des pages web avec Rust

Commence par importer reqwest :

1use reqwest::blocking::get;

2fn main() {

3 let url = "https://www.scrapingcourse.com/ecommerce/";

4 let response = get(url);

5 let html_content = response.unwrap().text().unwrap();

6 println!("{}", html_content);

7}En prod, remplace les unwrap() par une gestion d’erreur propre :

1let response = match reqwest::blocking::get(url) {

2 Ok(resp) => resp,

3 Err(err) => {

4 eprintln!("Request failed for {}: {}", url, err);

5 return;

6 }

7};Analyser et extraire les données

On utilise maintenant scraper pour analyser le HTML et sortir les infos produits.

1use scraper::{Html, Selector};

2let document = Html::parse_document(&html_content);

3let product_selector = Selector::parse("li.product").unwrap();

4for product in document.select(&product_selector) {

5 let name = product

6 .select(&Selector::parse("h2").unwrap()).next()

7 .map(|e| e.text().collect::<String>());

8 let price = product

9 .select(&Selector::parse(".price").unwrap()).next()

10 .map(|e| e.text().collect::<String>());

11 let url = product

12 .select(&Selector::parse("a").unwrap()).next()

13 .and_then(|e| e.value().attr("href"))

14 .map(|s| s.to_string());

15 let image = product

16 .select(&Selector::parse("img").unwrap()).next()

17 .and_then(|e| e.value().attr("src"))

18 .map(|s| s.to_string());

19 println!("Name: {:?}, Price: {:?}, URL: {:?}, Image: {:?}", name, price, url, image);

20}Cette méthode, inspirée de , marche pour la plupart des sites e-commerce ou annuaires.

Gérer les URLs et éviter les doublons

Pour un extracteur complet, il faut suivre les liens et éviter de repasser plusieurs fois sur la même page. Voici un schéma classique :

1use std::collections::{HashSet, VecDeque};

2let mut to_visit = VecDeque::new();

3let mut visited = HashSet::new();

4to_visit.push_back(start_url.to_string());

5visited.insert(start_url.to_string());

6while let Some(url) = to_visit.pop_front() {

7 // Fetch and parse page...

8 for link in extracted_links {

9 let abs_link = normalize_url(&link, &url); // Utilise le crate `url` !

10 if !visited.contains(&abs_link) {

11 visited.insert(abs_link.clone());

12 to_visit.push_back(abs_link);

13 }

14 }

15}N’oublie pas de normaliser les URLs (avec le crate ) pour gérer les chemins relatifs, les slashs finaux et les fragments.

Booster l’extraction web avec la concurrence

C’est là que Rust sort le grand jeu. Extraire les pages une par une, c’est lent—passons au mode turbo.

Option 1 : Multi-threading

Lance plusieurs threads, chacun gère la file d’attente. Utilise Arc<Mutex<>> pour partager l’état. Pour les petits crawls, ça suffit.

Option 2 : Async/Await avec Tokio

Pour une vraie rapidité, passe à l’asynchrone. Avec tokio et reqwest en async, tu peux lancer des centaines de requêtes en parallèle sans exploser la RAM.

1use reqwest::Client;

2use futures::future::join_all;

3let client = Client::new();

4let urls = vec![/* ... */];

5let fetches = urls.into_iter().map(|url| {

6 let client_ref = &client;

7 async move {

8 match client_ref.get(url).send().await {

9 Ok(resp) => {

10 let text = resp.text().await.unwrap_or_default();

11 // Parse text...

12 }

13 Err(e) => eprintln!("Error fetching {}: {}", url, e),

14 }

15 }

16});

17join_all(fetches).await;L’asynchrone en Rust, c’est pas juste rapide—c’est aussi super safe. Pas de conflits de données, pas de bugs chelous. Juste de la perf pure ().

Exporter et stocker les données extraites

Une fois tes données collectées, tu voudras sûrement les exporter. Le crate rend ça super simple :

1use csv::Writer;

2use std::fs::File;

3let file = File::create("products.csv").expect("could not create file");

4let mut writer = Writer::from_writer(file);

5writer.write_record(&["Name", "Price", "URL", "Image"]).unwrap();

6for prod in &products {

7 let name = prod.name.as_deref().unwrap_or("");

8 let price = prod.price.as_deref().unwrap_or("");

9 let url = prod.url.as_deref().unwrap_or("");

10 let image = prod.image.as_deref().unwrap_or("");

11 writer.write_record(&[name, price, url, image]).unwrap();

12}

13writer.flush().unwrap();Tu peux aussi sérialiser tes structures avec ou exporter en JSON pour des données plus complexes.

Gagne du temps avec Thunderbit pour l’extraction web

Parlons un peu de . Même si j’adore coder, parfois on veut juste les données, vite fait bien fait. Thunderbit, c’est une extension Chrome boostée à l’IA qui te permet d’extraire des données en quelques clics, sans taper une ligne de code.

Thunderbit, c’est un Extracteur Web IA pour Chrome qui aide les pros à extraire des données de sites web grâce à l’intelligence artificielle. Un vrai outil de productivité pour gagner du temps et automatiser les tâches répétitives sur le web.

Pourquoi Thunderbit sort du lot ?

- Suggestion de champs par IA : Thunderbit scanne la page et te propose direct les colonnes à extraire—noms, emails, prix, etc. ().

- Extraction en un clic : Clique sur « Extraire » et Thunderbit te sort les données dans un tableau.

- Extraction de sous-pages : Besoin d’infos sur des pages de détail ? Thunderbit visite chaque lien et enrichit ton tableau tout seul ().

- Gestion de la pagination et du scroll infini : Thunderbit gère les pages paginées ou à défilement infini sans broncher.

- Export gratuit des données : Tu peux exporter vers Excel, Google Sheets, Notion, Airtable ou CSV—sans aucune limite.

- Auto-remplissage IA : Automatise le remplissage de formulaires ou la connexion grâce à l’IA, pour extraire même derrière une authentification.

Thunderbit, c’est l’allié parfait pour les pros comme pour les devs, surtout face à des sites dynamiques ou blindés de JavaScript.

Quand utiliser Thunderbit ou Rust ?

- Thunderbit : Parfait pour prototyper vite, faire des extractions ponctuelles ou permettre à des non-devs d’accéder aux données.

- Rust : Idéal pour des extracteurs costauds, sur-mesure ou intégrés, où la perf et le contrôle sont clés.

Et franchement, le top c’est de combiner les deux.

Rust face aux autres technos d’extraction web : le match

Un peu de technique : où se place Rust par rapport aux autres solutions ?

| Langage/Framework | Vitesse | Utilisation mémoire | Concurrence | Stabilité | Écosystème |

|---|---|---|---|---|---|

| Rust | 🚀🚀🚀 | 🟢 Faible | 🟢 Excellente | 🟢 Haute | Moyen |

| Python (Scrapy) | 🚀 | 🔴 Élevée | 🟡 Limitée | 🟡 Moyenne | 🟢 Large |

| Node.js | 🚀🚀 | 🔴 Élevée | 🟢 Bonne | 🟡 Moyenne | 🟢 Large |

| Go | 🚀🚀 | 🟢 Faible | 🟢 Excellente | 🟢 Haute | Moyen |

- Rust est souvent 2 à 10 fois plus rapide que Python et consomme moins de 10 % de la mémoire (, ).

- Node.js est bon pour l’I/O, mais limité par son mono-thread et peut ramer sur du lourd.

- Go est un vrai challenger, mais la sécurité mémoire et les abstractions sans surcoût de Rust font la différence pour des extracteurs solides et performants.

Si tu veux scraper à grande échelle ou viser la perf max, Rust est difficile à battre.

Associer Thunderbit et Rust pour un workflow au top

Voici mon combo préféré : Thunderbit + Rust.

- Prototypage express : Utilise Thunderbit pour cartographier un site et choper des exemples de données. Ça t’aide à piger la structure avant de coder.

- Répartition des tâches : Laisse Thunderbit gérer les pages dynamiques, complexes ou protégées (merci l’Auto-remplissage IA et l’extraction de sous-pages), pendant que ton extracteur Rust s’occupe des pages statiques ou des API.

- Extraction planifiée : Programme des extractions régulières avec Thunderbit, puis laisse ton backend Rust traiter ou fusionner les résultats.

- Autonomiser les non-devs : Permets à tes équipes opérationnelles ou marketing d’utiliser Thunderbit pour leurs besoins ponctuels, et libère tes devs pour les tâches plus techniques.

- Résilience : Si ton extracteur Rust casse à cause d’un changement de page, l’IA de Thunderbit s’adapte souvent direct—sans toucher au code.

Cette approche hybride te donne le meilleur des deux mondes : la rapidité et la flexibilité de Thunderbit, la puissance et le contrôle de Rust.

Conseils et bonnes pratiques pour les extracteurs web Rust

Créer un extracteur solide, ce n’est pas que du code—il faut anticiper la réalité du web.

Les galères classiques

- Anti-bots : Utilise des User-Agents crédibles, respecte le

robots.txt, limite la fréquence de tes requêtes et pense aux proxies pour les gros volumes (). - CAPTCHAs et connexions : Pour les sites avec CAPTCHA ou login compliqué, utilise l’Auto-remplissage IA de Thunderbit ou un navigateur headless (genre ou )—seulement si besoin.

- Sites blindés de JavaScript : Si les données arrivent en AJAX, cherche les appels API cachés. Si tu dois exécuter du JS, pense à Thunderbit ou à un navigateur headless.

- Gestion des erreurs : Toujours une gestion d’erreur sérieuse (

Result,Option), des timeouts et des logs pour déboguer. - Pièges de la concurrence : Utilise des structures thread-safe (

Arc<Mutex<>>ouDashMap) et évite les goulets d’étranglement sur l’état partagé. - Gestion mémoire : Écris tes données sur disque si tu scrapes des millions de pages—ne garde pas tout en RAM.

- Éthique et conformité : Respecte les conditions d’utilisation des sites, ne surcharge pas les serveurs et fais gaffe aux lois sur la data.

Les bons réflexes

- Code modulaire : Sépare la récupération, l’analyse et le stockage pour faciliter la maintenance.

- Paramètres configurables : Utilise des fichiers de config ou des arguments CLI pour les URLs, la concurrence, les délais, etc.

- Logging : Utilise le crate

logpour un suivi structuré. - Tests : Rédige des tests unitaires pour ta logique d’analyse à partir d’exemples HTML.

- Monitoring : Surveille la santé de ton extracteur—CPU, RAM, erreurs—surtout pour les tâches longues.

Pour plus d’astuces, va voir le guide de et le tuto Rust de .

Conclusion & points clés à retenir

Créer un extracteur web en Rust, ce n’est pas juste un défi technique—c’est un vrai atout stratégique à l’ère de la data. À retenir :

- Rust, c’est la référence pour l’extraction web : rapide, sûr et taillé pour la concurrence.

- Chaque étape compte : Prépare ton environnement, récupère et analyse les pages, gère les URLs, ajoute la concurrence et exporte tes données.

- Thunderbit, c’est ton joker pour extraire vite sans coder—parfait pour les sites complexes ou dynamiques.

- Combine les deux pour être au top : Thunderbit pour le prototypage et les pages complexes, Rust pour l’échelle et la personnalisation.

- Reste pragmatique : Parfois, quelques clics valent mieux que des centaines de lignes de code.

Envie de passer à la vitesse supérieure ? Teste Rust—et laisse faire le sale boulot quand il faut. Pour plus d’astuces sur l’extraction et l’automatisation, checke le .

Bonne extraction—et que tes données soient toujours propres, rapides et un peu plus malignes.

FAQ

1. Pourquoi utiliser Rust pour créer un extracteur web plutôt que Python ou Node.js ?

Rust offre des perfs bien supérieures, une sécurité mémoire et une gestion de la concurrence au top. Python et Node.js sont pratiques pour des scripts rapides, mais Rust est parfait pour des extracteurs costauds, fiables et scalables ().

2. Quelles sont les bibliothèques essentielles pour créer un extracteur web en Rust ?

Il te faut reqwest pour les requêtes HTTP, scraper pour l’analyse HTML, tokio pour la concurrence asynchrone et csv pour l’export des données. Le crate url est aussi super utile pour normaliser les URLs.

3. Comment gérer les sites blindés de JavaScript ou protégés par login avec Rust ?

Pour les sites JS, cherche les appels API cachés ou utilise un navigateur headless avec des crates comme fantoccini. Pour les pages protégées, gère les cookies avec reqwest ou utilise l’Auto-remplissage IA de Thunderbit pour automatiser la connexion.

4. Quel est l’avantage de combiner Thunderbit et Rust ?

Thunderbit accélère l’extraction grâce à l’IA et au no-code—parfait pour prototyper, gérer les pages dynamiques ou pour les non-devs. Rust est idéal pour des extracteurs sur-mesure et performants. Ensemble, tu gagnes en rapidité et tu passes à l’échelle sans prise de tête.

5. Comment éviter d’être bloqué ou banni lors de l’extraction ?

Respecte le robots.txt, utilise des en-têtes crédibles, limite la fréquence de tes requêtes et pense aux proxies pour les gros volumes. Scrape toujours de façon éthique et respecte les conditions d’utilisation et la législation sur la data ().

Tu veux voir Thunderbit en action ? et commence à extraire plus intelligemment dès aujourd’hui. Pour d’autres articles sur l’automatisation web, checke le .

Pour aller plus loin