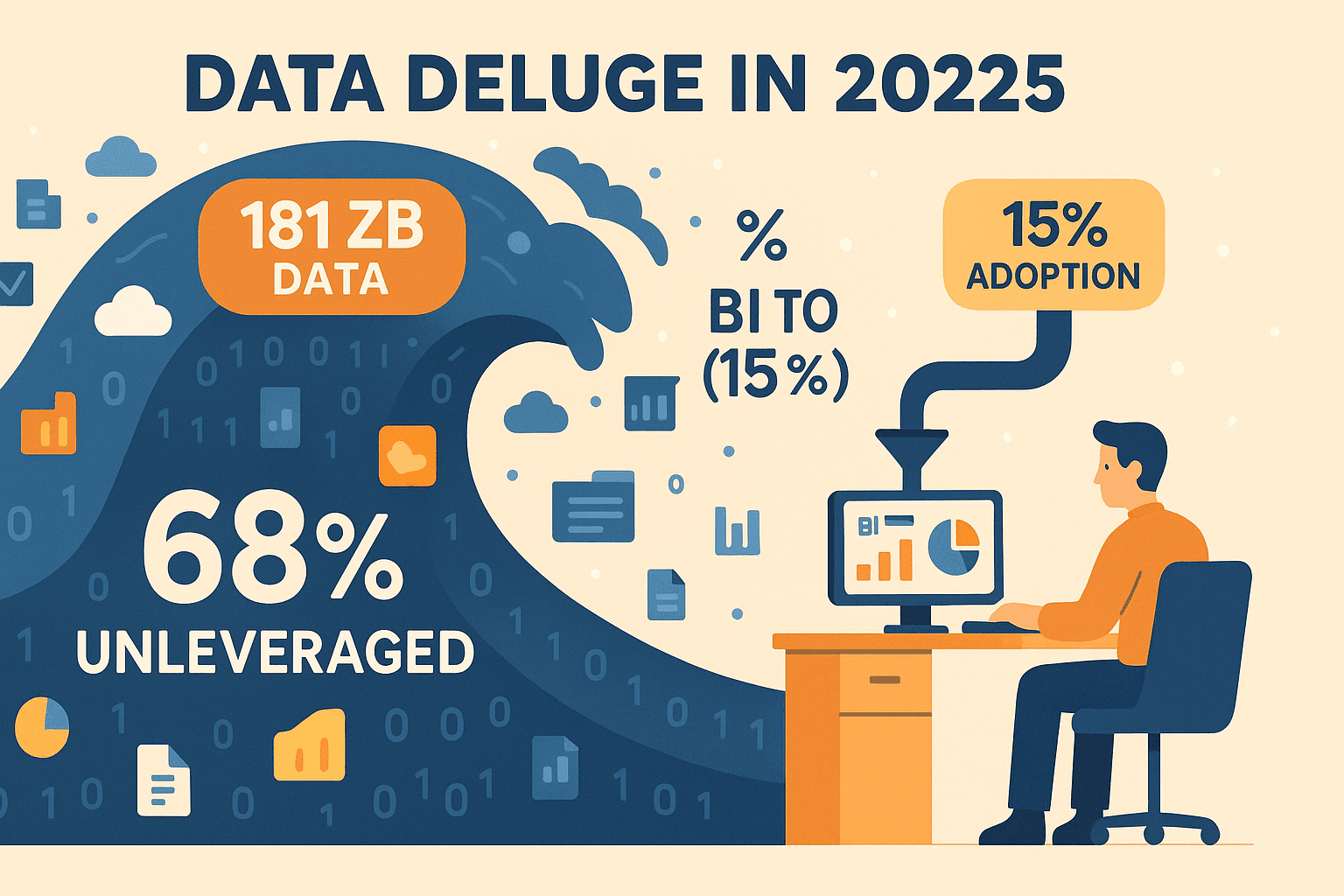

On vit dans un monde où les données débordent de partout : d’ici 2025, on prévoit que seront produits chaque année. Mais le plus fou, c’est que la majorité de ces données dort dans les serveurs sans jamais être utilisée. En fait, jusqu’à , et seulement 15 % des salariés se servent vraiment d’un outil d’analyse de données. Après des années passées dans le SaaS et l’automatisation, j’ai vu à quel point un bon logiciel de data mining peut transformer ce « bazar numérique » en vraie valeur : des décisions plus futées, une croissance boostée et moins d’incertitudes.

Trouver la bonne solution d’exploration de données, c’est vite le casse-tête : il y a trop de choix, chaque outil balance des termes techniques et des fonctions parfois obscures. Pourtant, la plupart des boîtes veulent surtout un outil efficace, flexible et simple à prendre en main. Que tu sois commercial à la chasse aux prospects, e-commerçant qui veut comprendre ses clients, ou pro de l’immobilier à la recherche d’insights marché, le bon outil d’analyse de données peut tout changer. Voilà pourquoi j’ai préparé ce guide pratique des 15 meilleurs logiciels de data mining pour les entreprises en 2025. Tu y trouveras ce qui fait la force de chaque solution, à qui elle s’adresse, comment l’aligner avec tes objectifs business, et des exemples concrets pour t’aider à faire le bon choix.

Pourquoi les entreprises ont besoin du bon logiciel de data mining en 2025

Soyons clairs : le data mining, ce n’est plus réservé aux geeks en blouse blanche. C’est devenu l’arme secrète de toute boîte qui veut tirer des vrais insights de montagnes de données brutes : tendances clients, prix des concurrents, détection de schémas cachés dans tes process… Les entreprises qui s’y mettent voient des résultats concrets, du à des percées dans la lutte contre la fraude (une banque a réduit ses pertes de 70 % grâce au data mining).

Mais il y a un hic : à la base, ces plateformes étaient pensées pour les profils techniques. Les équipes commerciales ou opérationnelles se perdaient vite dans des menus compliqués, du code et des messages d’erreur incompréhensibles. Résultat : adoption faible, opportunités ratées, et beaucoup de « je reste sur Excel ». Les solutions modernes changent la donne : interfaces intuitives, automatisation IA, requêtes en langage naturel… Aujourd’hui, même les moins à l’aise avec la tech peuvent transformer la donnée en décisions.

Comment avons-nous sélectionné les meilleurs logiciels de data mining ?

Avec tous les outils qui existent, comment j’ai choisi les 15 incontournables pour 2025 ? J’ai mis en avant les critères qui comptent vraiment pour les utilisateurs métiers :

- Facilité d’utilisation : Est-ce que les non-développeurs peuvent s’y mettre vite ? Les interfaces drag-and-drop, suggestions IA et prompts en langage naturel ont été privilégiés.

- Puissance analytique : L’outil gère-t-il aussi bien les stats de base que le machine learning avancé ? Bonus pour l’AutoML et l’analytique en temps réel.

- Visualisation : Peut-on visualiser facilement les données et les résultats (graphiques, dashboards, rapports interactifs) ?

- Intégration : L’outil se connecte-t-il à tes sources de données (bases, tableurs, cloud) et permet-il l’export vers tes applis préférées ?

- Automatisation : Planification, automatisation des workflows, déploiement de modèles… tout ce qui simplifie la vie (et te libère le week-end).

- Communauté & support : Les outils open source avec une communauté active et les plateformes commerciales avec un support solide ont chacun leurs atouts.

- Coût & évolutivité : Du gratuit à l’offre entreprise, j’ai évalué le rapport qualité/prix et la capacité à accompagner la croissance.

J’ai aussi pris en compte les retours d’utilisateurs métiers : ce qu’ils aiment ou pas dans ces plateformes. C’est parti !

Top 15 des logiciels de data mining pour les entreprises en 2025

1. Thunderbit

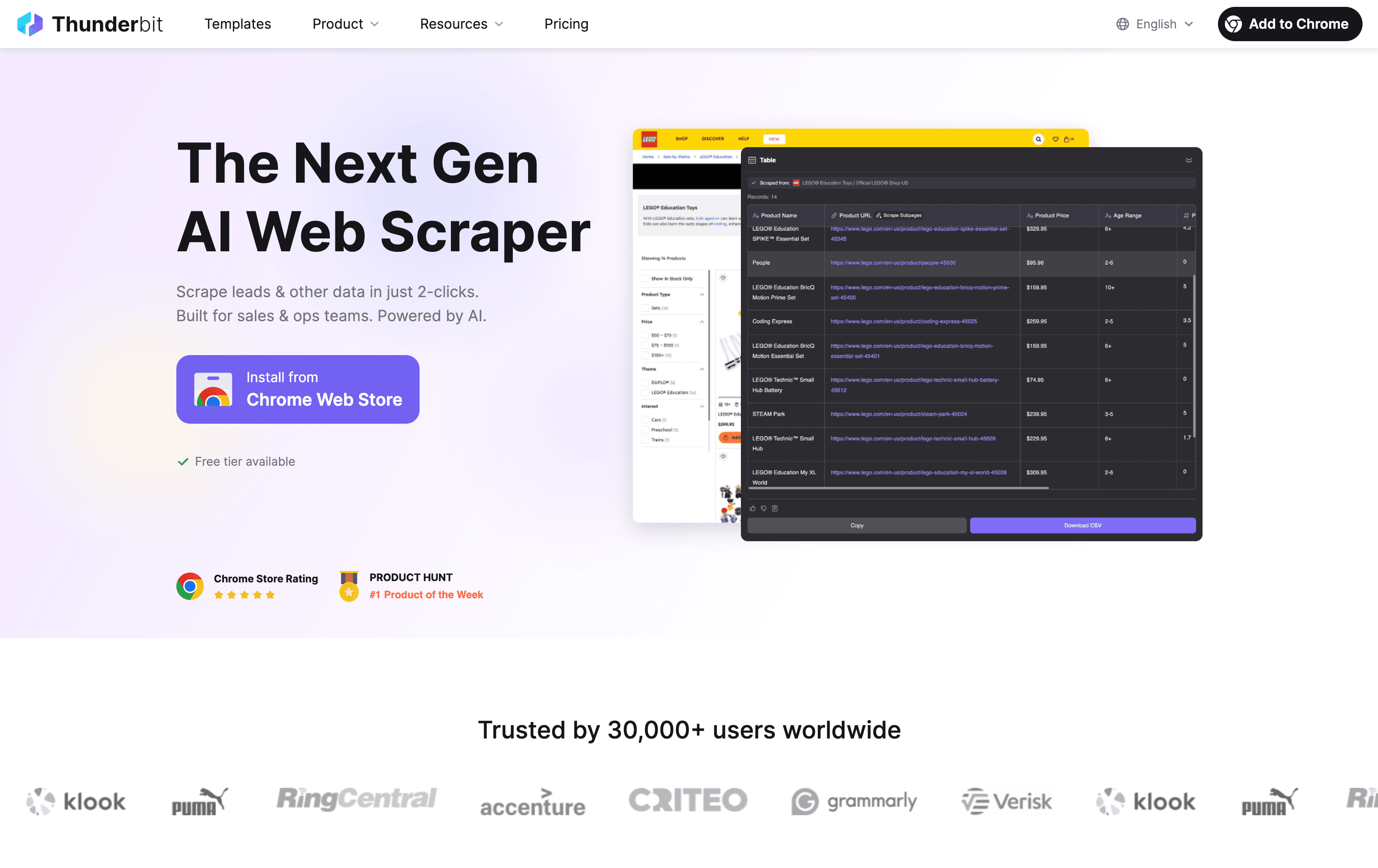

est mon coup de cœur pour ceux qui veulent extraire des données du web en un clin d’œil. En tant que cofondateur, je ne suis pas 100 % neutre, mais laisse-moi t’expliquer : Thunderbit, c’est une extension Chrome d’extracteur web IA qui transforme n’importe quel site, PDF ou image en données structurées en quelques clics. Pas de code, pas de modèles à bidouiller, pas de prise de tête.

Pourquoi Thunderbit sort du lot :

- Suggestion IA de champs : Clique sur « Suggestion IA de champs » et Thunderbit analyse la page, propose les colonnes utiles et structure les données tout seul.

- Extraction de sous-pages & pagination : Besoin de récupérer des infos sur plusieurs pages ou de suivre des liens ? L’IA de Thunderbit s’en occupe.

- Export instantané : Balance tes données direct dans Excel, Google Sheets, Airtable ou Notion, sans étape en plus.

- Export gratuit & Auto-remplissage IA : L’export est toujours gratuit, et l’Auto-remplissage IA gère même les formulaires en ligne à ta place.

- Extraction cloud ou navigateur : Choisis la méthode la plus rapide selon ton besoin, que ce soit sur des sites publics ou des pages avec login.

Thunderbit, c’est l’allié parfait pour les commerciaux à la recherche de leads, les e-commerçants qui surveillent la concurrence, ou tous ceux qui en ont marre du copier-coller. Ce n’est pas une suite analytique complète (pour l’analyse, passe par Excel ou un outil BI), mais c’est la solution la plus simple pour transformer des données web en tableaux exploitables.

Curieux de voir comment ça marche ? et teste l’extraction d’un site en moins d’une minute.

2. RapidMiner

est une plateforme visuelle de data mining et de machine learning très appréciée des analystes et data scientists. Son interface drag-and-drop permet de préparer les données, construire des modèles et les déployer sans écrire une ligne de code.

Points forts :

- Bibliothèque ML complète : Régression, clustering, text mining, deep learning… tout y est.

- Auto Model : Modélisation prédictive automatisée pour les non-experts.

- Intégration : Connexion aux bases de données, tableurs, cloud, et même scripts R/Python.

- Communauté & Marketplace : De nombreux modules complémentaires et une communauté active.

RapidMiner est idéal pour les équipes qui veulent de la puissance analytique sans se plonger dans le code. Version gratuite (limitée à 10 000 lignes), plans pro à partir de 2 500 $/an/utilisateur.

3. KNIME

est le couteau suisse open source de l’analytique. Son éditeur visuel modulaire permet de connecter des « nœuds » pour tout faire, de l’ETL au machine learning avancé, sans coder.

Pourquoi les utilisateurs l’adorent :

- Open source & gratuit : Plateforme de base gratuite, options payantes pour la collaboration serveur.

- Extensible : Intégration avec R, Python, Weka, et bibliothèques de deep learning.

- Community Hub : Des milliers de workflows et extensions partagés.

- Collaboration : KNIME Server pour le travail en équipe, la planification et les dashboards web.

KNIME est parfait pour les organisations cherchant flexibilité, transparence et coût d’entrée nul. Utilisé dans la finance, la pharma, le secteur public…

4. Orange

est le logiciel de data mining le plus accessible pour les débutants. Son interface visuelle permet de créer des workflows en assemblant des widgets, façon « Lego de l’analytique ».

Atouts principaux :

- Visualisation puissante : Nuages de points, cartes de chaleur, graphiques interactifs… explorer les données devient ludique.

- Widgets de machine learning : Classification, clustering, régression, etc.

- Add-ons : Text mining, bioinformatique, analyse de réseaux.

- Open source : 100 % gratuit, prise en main rapide.

Idéal pour l’enseignement, le prototypage ou l’exploration visuelle de données.

5. Weka

est un classique du machine learning, particulièrement apprécié pour l’éducation et les petits projets business. Son interface Java permet de charger des données, appliquer des algorithmes et visualiser les résultats très simplement.

Forces :

- Large choix d’algorithmes : Arbres de décision, SVM, clustering, règles d’association…

- Experimenter : Tester plusieurs algorithmes en lot et comparer les résultats.

- Sans code : Menus et onglets guident chaque étape.

- Open source : Gratuit et personnalisable.

Parfait pour l’apprentissage, le prototypage et l’analyse rapide de jeux de données moyens.

6. IBM SPSS Modeler

est la référence en analytique prédictive et data mining pour les grandes entreprises, notamment dans la finance, le retail et le secteur public.

Ce qui le distingue :

- Workflows visuels drag-and-drop : Construisez des analyses complexes sans coder.

- Algorithmes robustes : Arbres, réseaux de neurones, clustering, séries temporelles, text mining…

- Intégration : Compatible avec l’écosystème IBM, bases de données et outils BI.

- Niveau entreprise : Sécurisé, évolutif, avec des fonctions de gouvernance avancées.

Idéal pour les grandes structures recherchant puissance, fiabilité et simplicité d’utilisation. Tarifs à partir de 5 000–12 000 $/an/utilisateur.

7. SAS Enterprise Miner

est l’outil de prédilection des data scientists en entreprise. Son concepteur de flux visuels et son intégration poussée à l’écosystème SAS en font un incontournable des secteurs réglementés.

Points clés :

- Analytique avancée : Gère de très gros volumes, modélisation complexe, code SAS personnalisé.

- Gouvernance des modèles : Gestion des versions, traçabilité, outils de déploiement.

- Scalabilité : Conçu pour l’analyse à grande échelle et les applications critiques.

Indispensable si votre équipe utilise déjà SAS et doit déployer des modèles prédictifs à grande échelle.

8. Microsoft Azure Machine Learning

démocratise le data mining et le ML dans le cloud. Son Designer (drag-and-drop) et l’AutoML le rendent accessible aussi bien aux analystes métiers qu’aux data scientists.

Pourquoi le choisir :

- Cloud natif : S’adapte à vos besoins, facturation à l’usage.

- Intégration : Connexion profonde à Azure, Power BI, Office 365.

- AutoML : Sélection et optimisation de modèles automatisées pour les non-experts.

- MLOps : Déploiement, suivi et réentraînement des modèles sur une seule plateforme.

Un choix évident pour les organisations déjà investies dans l’écosystème Microsoft.

9. Alteryx

est le « super-Excel » de la préparation, du croisement et de l’automatisation analytique des données. Son interface drag-and-drop permet aux analystes de réaliser en quelques clics ce qui prenait des jours sous Excel ou SQL.

Fonctionnalités phares :

- Préparation de données en self-service : Nettoyez, fusionnez et transformez des données de toutes sources.

- Analytique prédictive : Outils intégrés pour la régression, le clustering, la prévision…

- Automatisation : Planification de workflows, création d’apps analytiques, export vers Tableau/Power BI.

- Intégration : Connexion aux bases, applications cloud, données géospatiales.

Alteryx n’est pas donné (licence Designer à partir de 5 000 $/an), mais le gain de productivité est considérable pour les équipes orientées data.

10. TIBCO Statistica

est une plateforme analytique évolutive axée sur l’analytique guidée et la collaboration. Particulièrement populaire dans l’industrie, la finance et la santé.

Pourquoi l’envisager :

- Analytique complète : Statistiques de base, machine learning, analytique IoT/edge…

- Workflows visuels : Construction et partage de flux analytiques en drag-and-drop.

- Collaboration : Fonctions d’équipe, gestion des versions, gouvernance.

- Intégration : Compatible avec la suite TIBCO, plateformes ML cloud, outils open source.

Idéal pour les grandes entreprises souhaitant démocratiser l’analytique à grande échelle.

11. Teradata

est le mastodonte de l’entreposage et du data mining d’entreprise. Pour analyser des pétaoctets de données à l’échelle de l’entreprise, son traitement massivement parallèle et son analytique in-database sont inégalés.

Pour qui ?

- Big data mining : Exécutez des requêtes et modèles complexes sur d’énormes volumes sans déplacer les données.

- Intégration : Fonctionne avec SAS, R, Python, et tous les grands outils BI.

- Fiabilité : Plébiscité par les plus grandes banques, enseignes et opérateurs télécoms.

Surdimensionné pour les PME, mais incontournable pour l’analytique à l’échelle Fortune 500.

12. Rattle

est une interface graphique open source pour le data mining sous R. Très apprécié dans l’éducation et le secteur public pour rendre la puissance de R accessible aux non-codeurs.

Ce qu’on aime :

- Workflow par onglets : Chargement, exploration, modélisation et évaluation des données au même endroit.

- Variété de modèles : Arbres, forêts, SVM, réseaux de neurones, clustering…

- Outil pédagogique : Affiche le code R généré à chaque étape, idéal pour apprendre ou automatiser.

- Gratuit & open source : Installez R et c’est parti.

Parfait pour les analystes et étudiants souhaitant exploiter R sans la courbe d’apprentissage.

13. Dataiku

est une plateforme collaborative de data science pensée pour le travail en équipe. Elle combine recettes visuelles no-code et notebooks pour les codeurs, rassemblant analystes métiers et data scientists.

Pourquoi c’est un leader :

- Workflows visuels & code : Préparation des données en drag-and-drop, AutoML pour la modélisation, code pour les tâches avancées.

- Collaboration : Espaces projets, wikis, gestion de versions, dashboards.

- Intégration : Connexion à tout : bases, cloud, Hadoop, Spark…

- MLOps : Déploiement, suivi et automatisation des modèles.

Idéal pour les organisations qui veulent casser les silos et industrialiser la data science.

14. H2O.ai

est la référence open source pour le machine learning à grande échelle. Sa librairie H2O-3 séduit les data scientists, tandis que Driverless AI démocratise l’AutoML auprès des métiers.

Fonctionnalités clés :

- ML distribué : Entraînez des modèles sur d’énormes jeux de données, en cluster.

- AutoML : Sélection, optimisation et ingénierie de features automatisées.

- Intégration : Compatible avec R, Python, Spark…

- IA explicable : Outils d’interprétabilité pour la confiance métier.

Parfait pour les organisations cherchant rapidité, scalabilité et innovation ML sans dépendance éditeur.

15. Google Cloud Dataflow

est l’épine dorsale du traitement de données temps réel et massif dans le cloud. Ce n’est pas un outil de modélisation à proprement parler, mais il est essentiel pour extraire des insights de flux ou de gros volumes batch.

Ce qu’il propose :

- Traitement unifié batch & streaming : Créez des pipelines pour ETL, analytique temps réel, feature engineering…

- Autoscaling : Gère des millions d’événements/seconde, sans gestion d’infrastructure.

- Intégration : Connecté à l’IA Google Cloud, BigQuery, stockage…

- Templates & flexibilité : Pipelines préconçus ou personnalisés avec Apache Beam.

Indispensable pour exploiter en temps réel les données IoT, logs massifs ou flux web.

Tableau comparatif rapide : panorama des logiciels de data mining

| Outil | Facilité d’utilisation | Puissance analytique | Visualisation | Intégration | Modèle tarifaire | Utilisateurs cibles |

|---|---|---|---|---|---|---|

| Thunderbit | Très élevée | Extraction web | Tableau (export) | Excel, Sheets, Notion, Airtable | Freemium (crédits) | Commerciaux, ops, marketing, non-tech |

| RapidMiner | Élevée | Suite ML complète, AutoML | Graphiques intégrés | BDD, fichiers, R/Python | Gratuit/Pro/Entreprise | Analystes, data scientists |

| KNIME | Élevée | Analytique complète, extensible | Interactif, web | BDD, cloud, R/Python | Gratuit/Serveur | Équipes open source, analystes |

| Orange | Très élevée | ML basique, visuel | Widgets puissants | Fichiers, add-ons | Gratuit | Débutants, enseignants |

| Weka | Élevée | ML basique, pas de deep learning | Graphiques simples | Fichiers, ODBC | Gratuit | Étudiants, petites entreprises |

| SPSS Modeler | Élevée | Analytique prédictive | Graphiques interactifs | IBM, BDD, BI | Entreprise | Grandes entreprises, analystes |

| SAS EM | Moyenne | Avancé, scalable | Sorties statistiques | SAS, BDD, Hadoop | Entreprise | Data scientists, secteurs régulés |

| Azure ML | Élevée | ML, AutoML, MLOps | Basique, Power BI | Azure, Office, REST | Paiement à l’usage | Équipes mixtes, clients cloud MS |

| Alteryx | Très élevée | Préparation, analytique | Rapports, Tableau | BDD, Excel, APIs | 5K$/an+ | Analystes, directions métiers |

| Statistica | Élevée | Analytique complète, IoT | Interactif, web | TIBCO, ML cloud | Entreprise | Grandes entreprises, analytique collab. |

| Teradata | Faible (utilisateur final) | Analytique in-DB, big data | Limité (via BI) | SAS, R, Python, BI | Entreprise | Grandes entreprises, data engineers |

| Rattle | Élevée | ML R via GUI | Graphiques simples | Fichiers, ODBC, R | Gratuit | Étudiants, apprenants R |

| Dataiku | Élevée | End-to-end, AutoML | Dashboards | Tout | Gratuit/Entreprise | Équipes data, organisations collaboratives |

| H2O.ai | Moyenne | ML distribué, AutoML | Explication de modèles | R, Python, Spark | Gratuit/Entreprise | Data scientists, équipes ML |

| Dataflow | Faible (non-tech) | Analytique streaming | Sortie vers BI | GCP, BigQuery, IA | Paiement à l’usage | Data engineers, besoins temps réel |

Comment choisir le meilleur logiciel de data mining pour votre entreprise ?

Alors, comment choisir l’outil parfait pour ton équipe ? Voici mon pense-bête :

- Besoin d’extraire des données web vite fait, bien fait, sans config ? Thunderbit est fait pour toi.

- Tu veux des workflows visuels et du ML sans code ? RapidMiner, KNIME, Alteryx et Dataiku sont incontournables.

- Pour l’enseignement ou l’apprentissage de la data science ? Orange, Weka et Rattle sont imbattables (et gratuits).

- Pour l’analytique prédictive à l’échelle entreprise ? SPSS Modeler, SAS Enterprise Miner et Statistica sont des valeurs sûres.

- Cloud natif, évolutif et intégré à ta stack ? Azure ML et Google Dataflow sont au top.

- Big data, temps réel ou analytique streaming ? Teradata et Dataflow sont faits pour ça.

- AutoML de pointe et IA explicable ? H2O.ai et les fonctions AutoML de Dataiku sont leaders.

Quelques conseils pour bien choisir :

- Lance un projet pilote et implique les utilisateurs finaux dans les tests.

- Vérifie l’intégration avec tes sources de données et workflows existants.

- Pense au coût global, y compris la formation et le support.

- N’hésite pas à combiner plusieurs outils selon les besoins.

Conclusion : Libérez la valeur de vos données avec le data mining

En 2025, le data mining n’est plus un « bonus » : c’est le moteur de décisions plus intelligentes, rapides et rentables. Le bon outil permet à toute l’équipe, du pro du tableur au data scientist confirmé, de transformer la donnée brute en valeur business.

Mon conseil ? Pars de tes objectifs, aligne tes besoins avec les points forts de ces solutions, et évite les logiciels qui te donnent l’impression d’avoir besoin d’un doctorat pour démarrer. Avec des solutions comme et les autres de cette liste, tu peux enfin exploiter tes données… sans y laisser ta santé (ni tes week-ends).

Envie de voir ce qui est possible ? ou explore le pour plus de guides, conseils et retours d’expérience sur le data mining.

FAQ

1. Qu’est-ce qu’un logiciel de data mining et pourquoi en ai-je besoin ?

Un logiciel de data mining sert à repérer des tendances, des schémas et des insights exploitables dans de gros volumes de données, pour transformer la donnée brute en décisions qui boostent la croissance, l’efficacité et l’innovation. Dans un monde piloté par la donnée, c’est devenu indispensable pour rester dans la course.

2. Les équipes non techniques peuvent-elles utiliser ces outils, ou sont-ils réservés aux data scientists ?

Les solutions modernes comme Thunderbit, KNIME, Alteryx ou Orange sont pensées pour les utilisateurs métiers, même sans expérience en code. Elles proposent des interfaces visuelles, de l’automatisation IA et des fonctions en langage naturel pour rendre l’analytique accessible à tous.

3. Comment choisir le bon logiciel de data mining pour mon entreprise ?

Commence par évaluer les compétences techniques de ton équipe, tes sources de données et tes objectifs business. Privilégie les outils adaptés à tes besoins en termes de simplicité, puissance analytique, intégration et coût. Teste-en plusieurs avant de te lancer.

4. Quelle est la différence entre les outils open source et commerciaux ?

Les solutions open source comme KNIME, Weka ou Rattle sont gratuites, très personnalisables et soutenues par une communauté active. Les outils commerciaux comme SPSS Modeler, Alteryx ou Dataiku offrent des fonctionnalités avancées, du support et une grande évolutivité, souvent à un tarif plus élevé.

5. Puis-je utiliser plusieurs outils de data mining ensemble ?

Bien sûr ! Beaucoup d’entreprises combinent plusieurs solutions : Thunderbit pour l’extraction web, KNIME pour l’automatisation des workflows, Power BI ou Tableau pour la visualisation, par exemple. L’essentiel, c’est d’assurer une bonne intégration et circulation des données entre tes plateformes.

Prêt à révéler la valeur cachée de tes données ? Lance-toi, expérimente, et laisse parler tes données. Et si besoin, l’équipe Thunderbit est là pour t’accompagner. Bonne exploration !