Tu t’es déjà demandé comment Google arrive à dénicher chaque recoin d’Internet, jusqu’à ce vieux post de blog que tu avais écrit en 2012 et que tu pensais oublié ? Rassure-toi, tu n’es pas le seul à te poser la question. Ce n’est ni de la magie, ni une armée de stagiaires insomniaques qui fouillent le web 24h/24. Ce sont les fameux crawlers : ces robots numériques qui arpentent sans relâche les sites web du monde entier pour les cartographier, les classer et les indexer. Après des années à bidouiller des outils d’automatisation et d’IA (et, soyons honnêtes, à casser quelques sites au passage), j’ai compris à quel point ces robots influencent ce qu’on voit en ligne. Si tu gères un site web, piger comment fonctionnent les crawlers, ce n’est pas juste de la curiosité geek : c’est ce qui fait la différence entre être visible ou rester dans l’ombre.

Viens lever le voile avec moi sur ce que sont vraiment les crawlers, comment ils « lisent » ton site, pourquoi ils sont cruciaux pour le SEO, et comment t’assurer que ton contenu ne se perd pas dans l’immensité du web. Et comme je suis fan d’automatisation intelligente, je te montrerai comment des outils nouvelle génération boostés à l’IA comme changent la donne pour les propriétaires de sites et les équipes data.

Les bases des crawlers : c’est quoi et comment ça marche ?

Imagine un crawler comme un bibliothécaire digital – ou une araignée diplômée en organisation – dont la mission est d’explorer le web, lien après lien. Techniquement, un crawler (aussi appelé spider ou bot) est un logiciel qui parcourt méthodiquement les sites, récupère les pages, suit les liens et collecte des infos sur ce qu’il trouve. C’est comme ça que les moteurs de recherche comme Google ou Bing construisent leurs énormes index de contenus en ligne.

En pratique, ça donne quoi ?

- On commence avec une liste d’URLs connues (genre ta page d’accueil ou quelques sites de référence).

- Le crawler télécharge le contenu HTML de chaque page.

- Il extrait les liens hypertextes et les ajoute à sa liste de pages à visiter.

- Il recommence, passant de lien en lien, cataloguant de nouvelles pages et mettant à jour l’index du moteur de recherche.

Imagine un bibliothécaire qui court dans des rayons infinis pour noter chaque titre de livre et les relier entre eux – mais à la vitesse d’Internet. Sans crawlers, la majorité du web resterait invisible pour les moteurs de recherche, et donc pour nous tous.

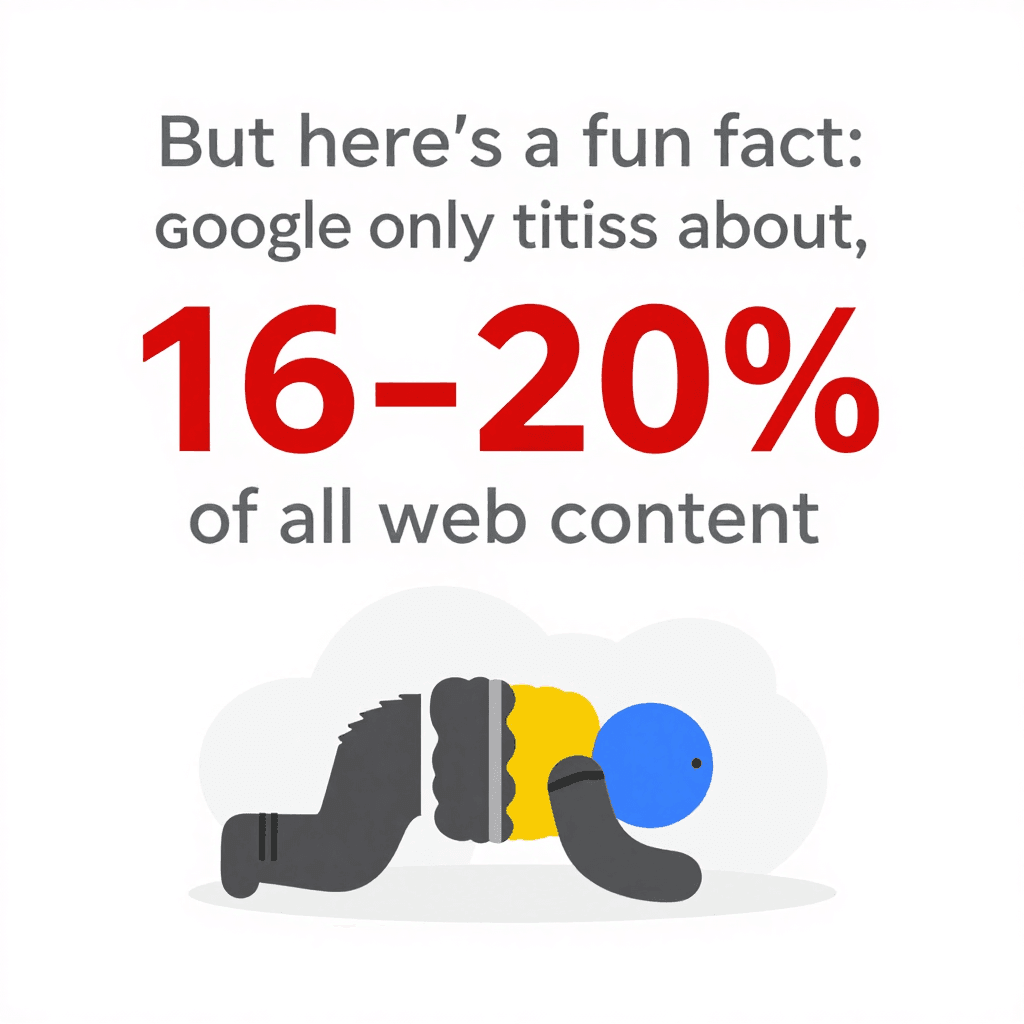

Petite anecdote : malgré toute cette puissance, Google n’indexe qu’environ . Le reste se trouve dans le « deep web », hors de portée de la plupart des bots. Autant dire que la façon dont tu structures ton site – et la manière dont tu accueilles les crawlers – a un impact énorme.

Petite anecdote : malgré toute cette puissance, Google n’indexe qu’environ . Le reste se trouve dans le « deep web », hors de portée de la plupart des bots. Autant dire que la façon dont tu structures ton site – et la manière dont tu accueilles les crawlers – a un impact énorme.

Comment les crawlers voient et comprennent le contenu d’un site web

Les crawlers ne voient pas ton site comme un humain. Ils se fichent de tes polices stylées, de tes images léchées ou de cet effet de scroll que tu as peaufiné pendant des heures. Ils chargent le HTML brut, analysent le texte, lisent les balises et suivent les liens. C’est un peu comme lire le plan d’un immeuble plutôt que de s’y balader.

Ce qui compte vraiment pour eux :

- La structure HTML : Ils repèrent les titres, paragraphes, listes et liens.

- Les liens internes : Ce sont les routes qui guident les crawlers vers les différentes parties de ton site. Une page isolée, c’est quasi invisible pour eux.

- La navigation et les sitemaps : Des menus bien pensés et un sitemap à jour servent de GPS pour que les crawlers trouvent tes contenus clés.

- Les métadonnées et données structurées : Les balises

<title>,<meta description>ou le balisage Schema.org aident les crawlers à piger le sujet d’une page, même si ce n’est pas évident dans le texte principal.

Pour les plus techniques, imagine ton site comme une ville. Les crawlers sont les livreurs, et tes liens internes et sitemaps sont les panneaux et cartes qui leur permettent d’atteindre chaque adresse.

Le rôle des sitemaps et du robots.txt dans le comportement des crawlers

Deux fichiers sont essentiels pour guider les crawlers sur ton site :

-

Le sitemap XML : C’est une liste lisible par machine de tes pages importantes. C’est comme filer au bibliothécaire la liste de tous tes livres et où les trouver. Un bon sitemap garantit que les crawlers ne ratent pas de contenu clé, même si ton maillage interne n’est pas parfait. Pour les gros sites, ajouter un sitemap complet peut .

-

Le robots.txt : Ce simple fichier texte à la racine de ton site indique aux crawlers où ils peuvent (ou non) aller. Tu veux empêcher les bots d’accéder à ton espace admin ou bloquer des pages dupliquées ? C’est ici que ça se passe. Attention : une simple erreur (genre

Disallow: /) peut bloquer tout ton site des moteurs de recherche – le cauchemar classique du SEO. Utilise robots.txt pour .

Petit conseil : indique toujours l’emplacement de ton sitemap dans le robots.txt. C’est comme dire « Commencez la visite ici ! »

Pourquoi les crawlers sont essentiels pour ton site : SEO et impact sur les visiteurs

Soyons clairs : si un crawler ne peut pas accéder à une page, elle est invisible. Pas de crawl = pas d’indexation = pas de trafic depuis la recherche. Tout le boulot sur le contenu, le design, la marque ? Perdu si Googlebot ne le trouve pas.

Pourquoi c’est si important ? Parce que , et . Si ton site n’est pas optimisé pour les crawlers, tu passes à côté de la principale source de visiteurs.

Un site bien crawlé, c’est :

Un site bien crawlé, c’est :

- Plus de pages indexées : Plus de chances d’apparaître dans les résultats de recherche.

- Un meilleur classement : Les moteurs de recherche comprennent mieux la pertinence de ton contenu.

- Des mises à jour plus rapides : Les nouveaux contenus sont indexés et classés rapidement.

- Une meilleure expérience utilisateur : Les internautes trouvent ce qu’ils cherchent, ce qui booste ta crédibilité et ton trafic.

Beaucoup de sites ont vu leur trafic exploser juste en corrigeant des soucis de crawl – liens cassés, balises noindex oubliées… Le classique « caché à la vue de tous ».

L’influence des crawlers sur le classement dans les moteurs de recherche

Les moteurs de recherche s’appuient sur les infos collectées par les crawlers pour décider quelles pages sont les plus pertinentes pour une requête. Ils analysent :

- La qualité du contenu et les mots-clés

- Les liens internes et externes

- La fraîcheur et la fréquence des mises à jour

- L’adaptabilité mobile (Google privilégie maintenant l’indexation mobile-first)

Pour les gros sites, il y a aussi la notion de budget de crawl : le nombre de pages qu’un moteur de recherche va explorer sur une période donnée. Si ton site a 100 000 pages mais que Googlebot n’en visite que 5 000 par jour, il faudra des semaines pour tout indexer. D’où l’intérêt d’une (où la plupart des pages sont à quelques clics de la page d’accueil) : ça facilite et accélère le crawl.

Les limites des crawlers traditionnels : défis des sites web modernes

C’est là que ça se corse. Le web d’aujourd’hui est blindé de JavaScript, de contenus dynamiques et de zones protégées par login. Les crawlers classiques – surtout les plus basiques – peuvent s’y perdre, se bloquer ou abandonner.

Parmi les galères fréquentes :

- Contenus dynamiques et JavaScript : Beaucoup de crawlers ne voient que le HTML initial. Si ton contenu se charge via JavaScript (scroll infini, boutons « voir plus »…), un bot classique risque de ne rien voir du tout. Même le crawler de Google, qui sait exécuter du JavaScript, n’indexe parfois qu’une partie des sites très dynamiques, surtout si le contenu est lent à charger ou demande une interaction ().

- Contenus derrière une connexion : Si une page demande un login, la plupart des crawlers ne peuvent pas y accéder. C’est souvent voulu, mais parfois du contenu public se retrouve bloqué par erreur.

- robots.txt ou balises meta mal configurés : Une simple erreur peut bloquer l’accès à des pans entiers de ton site.

- Mesures anti-bot : CAPTCHAs, limitations de vitesse ou blocage d’agents inconnus peuvent stopper net les crawlers.

Avec , les crawlers ont dû s’adapter. Mais il reste plein de cas où ton contenu peut passer à la trappe.

Quand les outils de crawl classiques atteignent leurs limites : contenu dynamique et JavaScript

Imagine que tu gères un site e-commerce où les produits s’affichent au fur et à mesure qu’on fait défiler la page. Un crawler traditionnel ne verra peut-être que les 20 premiers produits, ignorant tout le reste. Ou alors tes avis clients n’apparaissent qu’après avoir cliqué sur un onglet – là encore, invisibles pour la plupart des bots.

Résultat : du contenu précieux n’est pas indexé, et tu perds du trafic. La solution ? Proposer des alternatives (liens de pagination, HTML généré côté serveur) et tester la visibilité de ton site avec des outils comme l’Inspection d’URL de Google Search Console.

Des crawlers plus malins : comment Thunderbit gère les pages complexes

C’est là que ça devient vraiment intéressant – parce que c’est exactement le genre de défi qu’on a voulu relever avec . Thunderbit n’est pas un crawler comme les autres : c’est un extracteur web boosté à l’IA, capable de « lire » les sites comme un humain, d’extraire des données structurées et de s’adapter à toutes les subtilités du web moderne.

Qu’est-ce qui rend Thunderbit unique ?

- Suggestions de champs par l’IA : Plus besoin de fouiller dans le HTML ou de coder. L’IA de Thunderbit analyse la page et propose direct les colonnes les plus pertinentes à extraire – genre « Nom du produit », « Prix » ou « Email de contact ». Tu peux ajuster, mais l’essentiel est déjà fait.

- Extraction sur les sous-pages : Besoin de détails en plus ? Thunderbit peut visiter chaque sous-page (fiche produit, profil utilisateur…), récupérer les infos et enrichir ta base principale. Fini le copier-coller à la main.

- Gestion du JavaScript et des connexions : Thunderbit fonctionne comme une extension Chrome (ou dans un vrai navigateur dans le cloud), il peut donc exécuter le JavaScript, attendre le chargement dynamique et même extraire des pages derrière une connexion.

- S’adapte aux changements de site : Les extracteurs classiques plantent dès qu’un site change de structure. L’IA de Thunderbit relit la page à chaque fois, donc les petites modifs ne perturbent pas ton workflow.

- Extraction planifiée : Tu veux surveiller les prix ou mettre à jour une liste de prospects chaque matin ? Programme-le en français (« chaque lundi à 9h »), Thunderbit s’occupe du reste.

Thunderbit s’adresse aux pros – commerciaux, marketing, e-commerce, immobilier – qui ont besoin de données, pas de prise de tête technique. Et oui, l’export vers Google Sheets, Notion ou Airtable se fait en un clic (et c’est gratos).

Les fonctionnalités IA de Thunderbit pour booster le crawl de ton site

La vraie force de Thunderbit, c’est sa compréhension du langage naturel. Il ne se contente pas de récupérer du texte brut : il pige le contexte. Par exemple, il fait la différence entre un numéro de téléphone, un email ou un prix, et peut extraire, étiqueter et même traduire les données à la volée.

Les retours utilisateurs sont top. Un client raconte : « Thunderbit est devenu mon outil préféré pour récupérer les contacts d’influenceurs. Avant, je payais des bases de données, maintenant je crée la mienne en quelques minutes. » C’est ce genre de gain de temps qu’on adore voir.

Et si tu as déjà galéré à extraire des données sur un site qui change de mise en page chaque semaine (coucou les plateformes e-commerce), tu vas kiffer l’approche « sans maintenance » de Thunderbit. L’IA s’adapte, plus besoin de réparer des scripts qui plantent.

Optimiser ton site pour les crawlers : structure, stratégie et outils malins

Comment faire de ton site un terrain de jeu idéal pour les crawlers ? Voici quelques stratégies qui marchent à tous les coups :

- Conçois une architecture logique : Garde les pages importantes à quelques clics de la page d’accueil. Une (navigation large, profondeur faible) améliore l’efficacité du crawl et le taux d’indexation.

- Soigne le maillage interne : Relie les pages entre elles avec des liens contextuels. Vérifie et corrige régulièrement les liens cassés.

- Maintiens un sitemap XML à jour : Liste toutes les URLs importantes et soumets-le à Google Search Console et Bing Webmaster Tools.

- Optimise ton robots.txt : Autorise l’accès aux contenus clés, bloque seulement ce qui est nécessaire, et vérifie toujours qu’il n’y a pas de blocage accidentel.

- La vitesse compte : Des pages rapides et sans erreur sont mieux explorées. Optimise tes images, utilise un CDN et corrige les erreurs serveur.

- Gère les contenus dupliqués : Utilise les balises canoniques et évite de gaspiller le budget de crawl sur des pages similaires.

- Exploite les données structurées et les métadonnées : Implémente le balisage Schema.org pour tes produits, articles, événements, etc., et gère intelligemment tes balises meta.

- Surveille l’activité de crawl : Utilise les rapports Index Coverage et Crawl Stats de Google Search Console pour détecter les problèmes rapidement.

- Teste avec des outils intelligents : Utilise Thunderbit ou des outils similaires pour voir comment ton site est perçu par un crawler et pour fluidifier tes pipelines de données.

Aligner l’architecture de ton site sur les besoins des crawlers

Une structure bien pensée, ce n’est pas juste pour les bots, c’est aussi pour tes visiteurs. Des audits réguliers (avec des outils comme Screaming Frog ou Sitebulb) t’aideront à repérer les soucis de crawl, liens cassés et pages orphelines avant que ça ne plombe ton référencement.

Et n’oublie pas le mobile : avec l’indexation mobile-first de Google, ta version mobile doit contenir tous les contenus et liens importants de la version desktop. Sinon, tu risques de laisser des pages précieuses hors de l’index ().

Thunderbit vs. crawlers traditionnels : le comparatif express

Petit tableau récap’ :

| Aspect | Thunderbit (Extracteur Web IA) | Crawler/Extracteur traditionnel |

|---|---|---|

| Facilité d’utilisation | Sans code, suggestions IA, démarrage en 2 clics pour les pros. | Configuration technique, nécessite souvent du code ou des sélecteurs manuels. |

| Adaptabilité | L’IA s’adapte aux changements de mise en page, maintenance minimale. | Se casse si la structure du site change, nécessite des mises à jour manuelles. |

| Contenu dynamique | Gère le JavaScript, les connexions et les éléments interactifs par défaut. | Limité au HTML statique, difficultés avec le JS ou les contenus protégés. |

| Crawl des sous-pages | Crawl intégré des sous-pages et de la pagination, fusion automatique des données. | Configuration manuelle pour la profondeur, crawl récursif plus complexe. |

| Structuration des données | L’IA génère des tableaux prêts à l’emploi avec des colonnes pertinentes, prend en charge de nombreux types de données (texte, chiffres, emails, images, PDF, etc.). | Résultat brut, l’utilisateur doit définir la structure, limité au HTML sauf développement spécifique. |

| Intégration | Export en un clic vers Google Sheets, Notion, Airtable, CSV, etc. | Export/import manuel, peu d’intégrations directes. |

| Gestion des obstacles bots | Gère les proxys, user agents, relances automatiques ; approche « cascade » pour maximiser le succès. | L’utilisateur doit gérer les blocages IP, CAPTCHAs, etc. – souvent complexe et coûteux. |

| Utilisateurs cibles | Professionnels non techniques : commerciaux, marketing, opérations, e-commerce, immobilier. | Développeurs, IT, data engineers. |

| Tarification | Système de crédits, offre gratuite, paiement à l’usage. | Abonnement, licence par utilisateur ou coûts serveurs ; frais cachés pour les proxys ou la maintenance. |

En résumé : Thunderbit met la puissance du crawl avancé à la portée de tous, pas seulement des développeurs. C’est rapide, fiable et taillé pour le web qui change tout le temps.

À retenir : comment profiter à fond des crawlers pour ton site

- Les crawlers sont les gardiens de ta visibilité web. Si ton site n’est pas optimisé pour eux, tu rates du trafic et de nouveaux visiteurs.

- Structure et stratégie sont clés. Navigation logique, liens internes, sitemaps et robots.txt sont tes meilleurs alliés.

- Les sites modernes demandent des crawlers plus malins. JavaScript, contenus dynamiques et connexions peuvent piéger les bots classiques – mais des outils IA comme relèvent le défi.

- La surveillance continue est indispensable. Utilise Search Console, des audits de crawl et des outils d’extraction intelligents pour garder ton site sain et visible.

- Fais évoluer tes outils. Que tu optimises ton SEO ou que tu construises tes propres pipelines de données, des crawlers plus intelligents te feront gagner du temps, amélioreront la précision et soutiendront tes décisions business.

Envie de voir comment Thunderbit peut t’aider à crawler, indexer et extraire des données même sur les sites les plus coriaces ? et teste-la. Pour plus de conseils sur le web scraping, le SEO et l’automatisation, passe sur le .

FAQ

1. C’est quoi un crawler et pourquoi c’est important pour mon site ?

Un crawler est un robot logiciel qui parcourt et indexe le contenu des sites pour les moteurs de recherche. Si ton site n’est pas adapté aux crawlers, tes pages risquent de ne pas apparaître dans les résultats, ce qui complique la tâche des internautes pour te trouver.

2. Quel est l’impact des sitemaps et du robots.txt sur les crawlers ?

Les sitemaps guident les crawlers vers tes pages clés, tandis que le robots.txt leur indique où ils peuvent ou non aller. Les deux sont essentiels pour un crawl et une indexation efficaces.

3. Quels problèmes rencontrent les crawlers traditionnels avec les sites modernes ?

Les crawlers classiques galèrent avec les contenus riches en JavaScript, les éléments dynamiques, les pages qui demandent une connexion et les mesures anti-bot. Résultat : ils peuvent zapper ou n’indexer qu’une partie du contenu important.

4. Comment Thunderbit gère-t-il différemment les sites complexes ?

Thunderbit utilise l’IA pour « lire » les pages comme un humain, gérer le JavaScript et les connexions, et extraire des données structurées – même sur les sous-pages et les contenus dynamiques. Il s’adapte aux changements de site et ne demande aucun code.

5. Quelles sont les bonnes pratiques pour rendre mon site compatible avec les crawlers ?

Garde une structure logique, utilise des liens internes, maintiens ton sitemap et robots.txt à jour, optimise la vitesse et surveille régulièrement l’activité de crawl. Teste et améliore la crawlabilité de ton site avec des outils intelligents comme Thunderbit.

Envie d’aller plus loin ? Découvre d’autres guides sur le ou abonne-toi à notre pour suivre toute l’actu de l’automatisation web et du scraping IA.

Pour aller plus loin