Les données du web, c’est un peu l’or noir de notre époque, et en 2025, elles sont partout : prospection commerciale futée, analyses de marché ultra-ciblées… J’ai vu des équipes – que ce soit dans l’e-commerce, l’immobilier ou le SaaS – se démener pour transformer des pages web en vrac en tableaux bien propres. Si tu lis ces lignes, c’est sûrement que tu veux faire pareil. Bonne nouvelle : Python est le couteau suisse du web scraping, et aujourd’hui, même sans être dev, c’est à la portée de tous.

Dans ce guide, je t’emmène pas à pas dans l’univers du web scraping avec Python, du tout premier script jusqu’à l’automatisation XXL avec des frameworks comme Scrapy. On va aussi voir comment des outils boostés à l’IA comme changent la donne pour les pros, en rendant l’extraction de données plus rapide et plus simple que jamais. Que tu sois débutant curieux ou déjà calé, tu trouveras ici des conseils concrets, des bouts de code et des astuces de terrain pour scraper comme un vrai pro.

C’est quoi le Web Scraping en Python ? Petit tour rapide

Le web scraping, c’est extraire automatiquement des infos de sites web – imagine ton ordi qui fait du copier-coller à ta place, mais à une vitesse folle et sur des centaines de pages. Avec Python, il suffit d’écrire des scripts qui vont chercher les pages, décortiquent le HTML et récupèrent ce qui t’intéresse : prix, contacts, avis, etc.

Pour les pros, le web scraping, c’est une vraie mine d’or. Les commerciaux s’en servent pour choper des prospects, les e-commerçants surveillent les prix des concurrents, les analystes suivent les tendances… Bref, on transforme le bazar du web en données prêtes à l’analyse. Python s’impose parce qu’il est à la fois puissant et super simple à prendre en main, ce qui en fait le langage chouchou pour tous les projets de scraping, petits ou gros ().

Pourquoi Python cartonne pour le Web Scraping ?

Mais pourquoi tout le monde (ou presque) jure par Python pour le scraping ? Trois raisons qui font mouche : c’est simple, il y a un max de bibliothèques, et la communauté est ultra-active.

- Syntaxe limpide : Le code Python, c’est clair et lisible. Pas besoin d’être ingénieur pour s’y mettre.

- Bibliothèques puissantes : Des outils comme BeautifulSoup, Scrapy ou Requests rendent l’extraction et l’analyse du web super faciles.

- Polyvalence : Python ne fait pas que du scraping. C’est aussi la référence pour l’analyse de données et l’automatisation, donc tu passes des données brutes aux analyses sans changer de langage.

- Communauté au taquet : Un souci avec un HTML tordu ? Il y a sûrement déjà une solution sur Stack Overflow.

Regarde comment Python se compare aux autres langages :

| Langage | Avantages | Inconvénients | Idéal pour |

|---|---|---|---|

| Python | Syntaxe simple, bibliothèques riches, communauté | Moins rapide que C++/Java en brut | Tous types de scraping |

| JavaScript | Gère nativement les sites dynamiques JS | Parsing HTML moins mature, gestion asynchrone | Apps monopage, sites dynamiques |

| R | Excellente analyse de données | Peu de frameworks de scraping | Petits projets orientés stats |

| Java/C# | Performant, adapté à l’entreprise | Verbeux, beaucoup de code | Systèmes intégrés de grande taille |

Python reste dans le top des langages pour le web scraping, et en 2023 il a même dépassé SQL pour devenir le troisième langage le plus populaire au monde ().

Les Outils et Bibliothèques Incontournables pour le Web Scraping en Python

Voici ton kit de base pour scraper le web avec Python :

- Requests : L’indispensable pour faire des requêtes HTTP. Récupère les pages web aussi facilement qu’un navigateur.

- BeautifulSoup : Le couteau suisse pour analyser le HTML et XML. Parfait pour fouiller, filtrer et extraire des infos.

- Scrapy : Un framework complet pour le scraping et le crawling à grande échelle.

- Selenium : Automatise un navigateur pour extraire des sites dynamiques ou blindés de JavaScript.

- Autres :

lxmlpour parser vite,pandaspour manipuler les données, etPlaywrightpour automatiser les navigateurs modernes.

Quand utiliser quoi ?

- Requests + BeautifulSoup : Top pour les pages statiques et les petits projets.

- Scrapy : Idéal pour crawler plein de liens, gérer la pagination et exporter des données en masse.

- Selenium/Playwright : À privilégier pour interagir avec du JavaScript ou simuler des actions utilisateur.

Premiers Pas : Préparer son Environnement Python pour le Web Scraping

On prépare le terrain. Même si tu débutes avec Python, c’est super simple.

-

Installer Python : Télécharge Python 3.x sur . Vérifie qu’il est bien dans ton PATH.

-

Créer un environnement virtuel : Pour garder tes dépendances bien rangées.

1python3 -m venv venv 2# Activation : 3# Sous Windows : 4venv\Scripts\activate 5# Sous Mac/Linux : 6source venv/bin/activate -

Installer les bibliothèques :

1pip install requests beautifulsoup4 scrapy selenium -

Organisation du projet : Pour un petit script, un seul fichier

.pysuffit. Pour Scrapy, lancescrapy startproject monprojetpour générer la structure complète. -

Tester ton install :

1import requests, bs4, scrapy, selenium 2print("Toutes les bibliothèques sont importées avec succès !") -

Définir un User-Agent (recommandé) : Certains sites bloquent “Python-requests” par défaut. Imite un navigateur :

1headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

Bravo, tu es prêt à scraper !

Analyser le HTML avec BeautifulSoup : Ton Premier Extracteur Web en Python

On va construire ensemble un extracteur simple. On va récupérer des citations et leurs auteurs sur – un site fait pour s’entraîner.

Étape 1 : Inspecter la Structure du Site

- Ouvre le site dans Chrome.

- Clique droit sur une citation, puis “Inspecter”.

- Chaque citation est dans un

<div class="quote">, le texte dans<span class="text">et l’auteur dans<small class="author">.

Étape 2 : Écrire et Lancer ton Extracteur

Voici un script de base :

1import requests

2from bs4 import BeautifulSoup

3url = "http://quotes.toscrape.com/page/1/"

4headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

5res = requests.get(url, headers=headers)

6if res.status_code != 200:

7 print(f"Échec de la requête : {res.status_code}")

8 exit()

9soup = BeautifulSoup(res.text, "html.parser")

10quote_divs = soup.find_all("div", class_="quote")

11for div in quote_divs:

12 quote_text = div.find("span", class_="text").get_text(strip=True)

13 author = div.find("small", class_="author").get_text(strip=True)

14 print(f"{quote_text} --- {author}")Pièges fréquents :

- Si un élément n’est pas là, vérifie qu’il n’est pas

Noneavant d’appeler.get_text(). - Vérifie toujours tes sélecteurs dans le navigateur.

Passer à l’Échelle : Optimiser le Web Scraping Python avec Scrapy

Quand tu passes de “juste cette page” à “tout le site et ses sous-pages”, c’est le moment de sortir Scrapy.

- Architecture : Scrapy fonctionne avec des “spiders” (classes qui définissent la navigation et l’extraction), des pipelines (pour traiter les données) et des requêtes asynchrones pour aller vite.

- Pourquoi Scrapy ? Il est taillé pour l’échelle : extraire des milliers de pages, gérer les erreurs et exporter les données en CSV/JSON sans prise de tête.

Quand préférer Scrapy à BeautifulSoup

- Tu dois parcourir plein de pages ou suivre des liens automatiquement.

- Tu veux des fonctions intégrées pour gérer les erreurs, limiter la vitesse et traiter les données.

- Tu construis un extracteur à lancer régulièrement ou à partager avec l’équipe.

Scrapy en Pratique : Exemple de Projet

Voici un spider qui récupère toutes les citations sur toutes les pages :

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/page/1/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 "tags": quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)À lancer avec :

1scrapy crawl quotes -O quotes.jsonTu obtiens alors un fichier JSON avec toutes les données – sans te prendre la tête avec des boucles.

Quand ton projet de scraping prend de l’ampleur, l’architecture et la rapidité de Scrapy en font l’outil parfait pour l’extraction de données à grande échelle.

Thunderbit : L’IA qui Dope le Web Scraping Python

Soyons clairs : même avec Python, le scraping peut vite devenir galère – surtout avec des sites dynamiques, des sous-pages ou des structures qui changent tout le temps. C’est là que entre en scène.

Thunderbit, c’est une extension Chrome boostée à l’IA qui te permet de scraper un site en deux clics :

- Suggestion de champs par l’IA : L’IA analyse la page et propose direct les colonnes les plus utiles à extraire (genre “Nom du produit”, “Prix”, etc.).

- Extraction : Un deuxième clic, et Thunderbit récupère toutes les données – il gère la pagination, les sous-pages et même le scroll infini.

Pourquoi j’adore Thunderbit :

- Zéro code : Parfait pour les pros et analystes qui ne veulent pas toucher au code.

- Gère les sites compliqués : Contenu dynamique, sous-pages, changements de structure… l’IA s’adapte.

- Export instantané : Balance tes données direct dans Excel, Google Sheets, Airtable ou Notion.

- Scraping de sous-pages : Besoin de détails sur chaque produit ou profil ? Thunderbit visite chaque sous-page et enrichit ton tableau automatiquement.

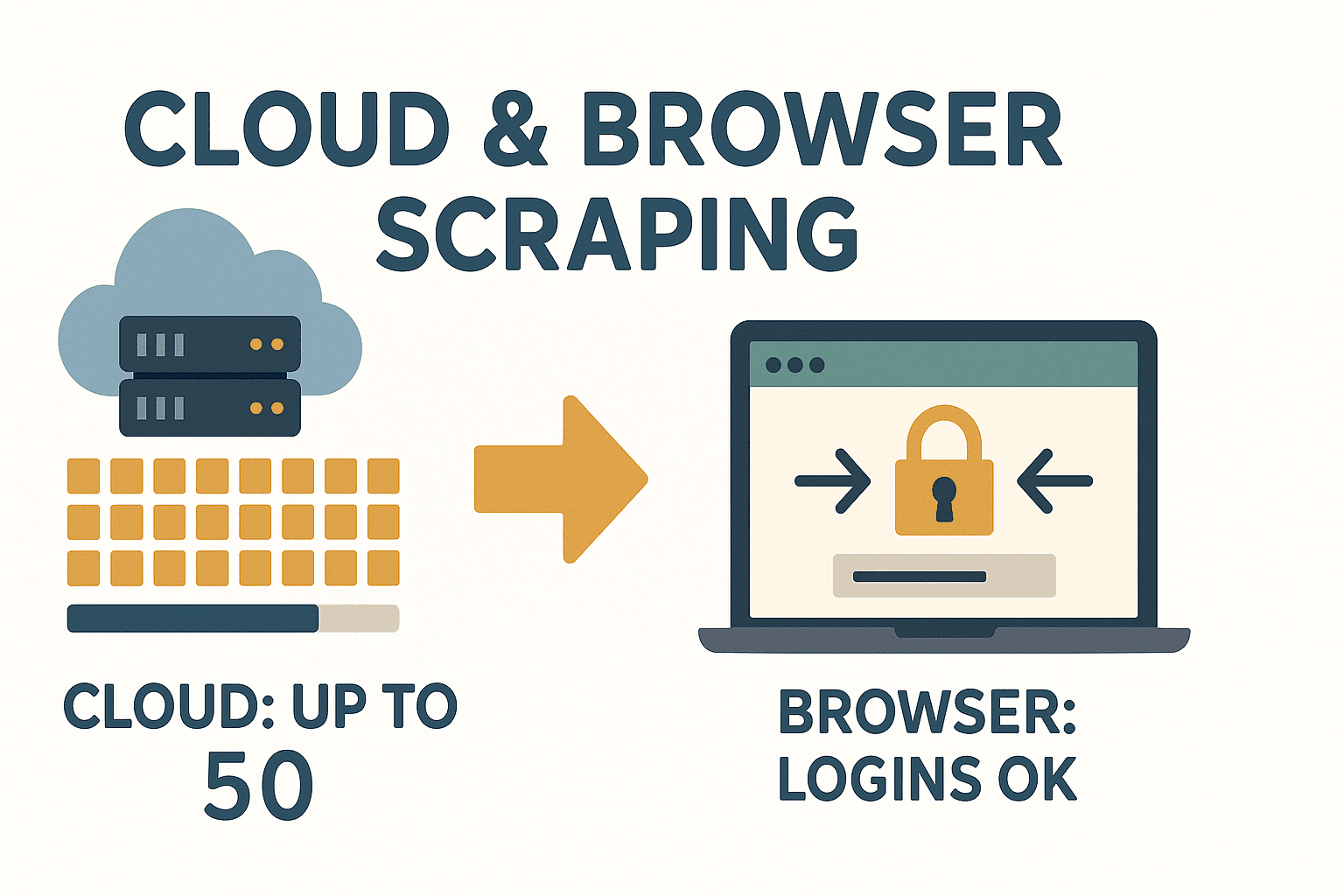

- Mode cloud ou navigateur : Scrape jusqu’à 50 pages d’un coup dans le cloud, ou utilise le navigateur pour les sites qui demandent une connexion.

Thunderbit, c’est le game changer pour tous ceux qui veulent des données vite, sans se battre avec du code à chaque changement de site.

Thunderbit, c’est le game changer pour tous ceux qui veulent des données vite, sans se battre avec du code à chaque changement de site.

Quand utiliser des outils IA comme Thunderbit ?

- Tu as besoin de données tout de suite sans attendre l’IT ou écrire du code.

- Le site est complexe, dynamique ou change souvent.

- Tu veux que toute l’équipe puisse extraire des données, même sans compétences techniques.

- Tu veux enrichir tes données (traduction, catégorisation, etc.) en un clic.

Thunderbit complète parfaitement les workflows Python : utilise-le pour prototyper vite, gérer les sites galères ou éviter la maintenance pénible. Pour aller plus loin, checke .

Gérer le Contenu Dynamique et la Pagination en Web Scraping Python

Les sites modernes raffolent du JavaScript, ce qui peut compliquer le scraping. Voici comment t’en sortir :

- Contenu dynamique : Si les données sont chargées par JS (et pas dans le HTML direct), utilise Selenium ou Playwright pour automatiser un navigateur, attendre le chargement, puis extraire.

- Pagination : Parcours les liens “Suivant” ou incrémente le numéro de page dans l’URL. Scrapy gère ça super bien avec son système de suivi des requêtes.

Exemple : Gérer la pagination avec BeautifulSoup

1page = 1

2while True:

3 url = f"http://quotes.toscrape.com/page/{page}/"

4 res = requests.get(url, headers=headers)

5 if res.status_code == 404:

6 break

7 soup = BeautifulSoup(res.text, 'html.parser')

8 quotes = soup.find_all("div", class_="quote")

9 if not quotes:

10 break

11 # ...extraction des citations...

12 page += 1Pour le scroll infini ou les boutons “Charger plus” : Utilise Selenium pour scroller ou cliquer, ou regarde l’onglet réseau pour repérer les appels API à reproduire avec Requests.

Stocker les Données : Sauvegarder les Résultats du Scraping pour l’Entreprise

Une fois tes données extraites, il faut les sauvegarder dans un format pratique.

- CSV : Universel, parfait pour Excel/Sheets.

1import csv 2with open('data.csv', 'w', newline='') as f: 3 writer = csv.DictWriter(f, fieldnames=['name', 'price']) 4 writer.writeheader() 5 for row in data: 6 writer.writerow(row) - Excel : Utilise pandas pour un export rapide.

1import pandas as pd 2df = pd.DataFrame(data) 3df.to_excel('data.xlsx', index=False) - Base de données : Pour les gros projets ou ceux qui tournent souvent, opte pour SQLite ou PostgreSQL.

1import sqlite3 2conn = sqlite3.connect('scraped_data.db') 3# ...création de table, insertion des données... 4conn.close()

Choisis le format qui colle le mieux à ton organisation. Pour partager avec des collègues pas techniques, Excel ou Google Sheets, c’est souvent le plus simple.

Aspects Légaux et Éthiques du Web Scraping en Python

Le scraping, c’est puissant, mais il faut rester dans les clous. Voici comment faire ça bien :

- Ne scrape que des données publiques : Si un login est nécessaire ou si c’est payant, réfléchis-y à deux fois.

- Vérifie les conditions d’utilisation : Certains sites interdisent clairement le scraping. Les ignorer peut te valoir un blocage, voire pire ().

- Respecte le robots.txt : Ce n’est pas une loi, mais c’est une question de respect.

- Évite les données perso : Le RGPD et la CCPA interdisent de scraper noms, emails ou numéros de téléphone sans consentement.

- N’encombre pas les serveurs : Ajoute des délais, limite la fréquence des requêtes et privilégie les heures creuses.

Checklist rapide :

- Lis les CGU et le robots.txt du site.

- N’extrais pas de données perso ou sensibles.

- Cite tes sources de données.

- Sois respectueux : n’inonde pas le serveur de requêtes.

Pour plus de conseils juridiques, checke .

Dépannage et Bonnes Pratiques pour un Web Scraping Python Béton

Le web scraping, ce n’est pas toujours un long fleuve tranquille. Voici comment gérer les galères :

- Erreurs HTTP (403, 404, 429) : Utilise un User-Agent crédible, ralentis tes requêtes et gère les erreurs proprement.

- Blocage d’IP : Utilise des proxies ou fais tourner ton IP si tu scrapes à grande échelle – mais demande-toi toujours si c’est éthique.

- CAPTCHAs : Si tu tombes sur un CAPTCHA, demande-toi si tu dois continuer. Il existe des services pour les contourner, mais c’est une zone grise.

- Changements de structure du site : Utilise des sélecteurs solides, vérifie la présence des éléments et entoure ton code de try/except.

- Problèmes d’encodage : Travaille toujours en UTF-8 et teste tes exports dans Excel ou Sheets.

Bonnes pratiques :

- Log chaque étape – pour savoir où ça coince.

- Retente les requêtes échouées avec un délai croissant.

- Teste ton extracteur sur quelques pages avant de passer à l’échelle.

- Surveille tes résultats – si le nombre d’éléments chute, c’est qu’il y a eu un changement.

Et si tu en as marre de réparer tes extracteurs à chaque changement de site, sache que utilise l’IA pour s’adapter automatiquement aux nouvelles structures.

L’approche IA de Thunderbit te permet de te concentrer sur l’analyse, pas sur la maintenance.

Conclusion & Points Clés à Retenir

Le web scraping en Python, c’est un vrai super-pouvoir pour les pros : il transforme le chaos du web en données propres et exploitables. À retenir :

- Python est le top pour le scraping, grâce à sa syntaxe claire et ses bibliothèques puissantes.

- Requests + BeautifulSoup sont parfaits pour les petits projets statiques ; Scrapy est l’outil idéal pour l’automatisation à grande échelle.

- Thunderbit amène l’IA dans la boucle, rendant le scraping accessible à tous – sans code, sans prise de tête, juste des données.

- Gère le contenu dynamique et la pagination avec Selenium ou les fonctions natives de Scrapy.

- Stocke tes données en CSV, Excel ou base de données – selon tes besoins.

- Reste dans la légalité et l’éthique : Scrape des données publiques, respecte les règles des sites et évite les infos perso.

- Construis des extracteurs solides : Log, retente, surveille les changements. Ou laisse l’IA de Thunderbit s’en occuper.

Prêt à te lancer ? Essaie de créer ton premier extracteur Python – ou, pour aller plus vite, et découvre à quel point l’extraction de données web peut être simple. Pour plus d’astuces et d’analyses, file sur le .

FAQ

1. Le web scraping en Python est-il légal ?

Le web scraping est légal si tu collectes des données publiques et respectes les conditions d’utilisation du site, le robots.txt et les lois sur la vie privée comme le RGPD. Évite d’extraire des infos perso ou sensibles, et vérifie toujours les règles avant de te lancer ().

2. Quelle est la différence entre BeautifulSoup et Scrapy ?

BeautifulSoup est un parseur HTML léger – parfait pour les petits scripts ou l’analyse de pages uniques. Scrapy est un framework complet pour crawler plein de liens, gérer la pagination et exporter des données à grande échelle. Utilise BeautifulSoup pour les scripts rapides, Scrapy pour les gros projets ().

3. Comment gérer les sites blindés de JavaScript avec Python ?

Utilise Selenium ou Playwright pour automatiser un navigateur, attendre le chargement du JavaScript puis extraire les données. Tu peux aussi inspecter l’onglet réseau pour repérer des appels API à reproduire avec Requests.

4. Qu’est-ce qui différencie Thunderbit des bibliothèques Python de scraping ?

Thunderbit utilise l’IA pour suggérer les champs, gérer les sous-pages et s’adapter aux changements de structure – sans code. C’est parfait pour les pros qui veulent des données vite, sans la maintenance des extracteurs classiques ().

5. Comment stocker et partager les données extraites avec mon équipe ?

Exporte tes données en CSV ou Excel pour un partage facile, ou utilise pandas pour les sauvegarder en base de données sur les gros projets. Thunderbit permet d’exporter direct vers Google Sheets, Airtable, Notion ou de télécharger gratuitement en CSV/Excel.

Bon scraping – que tes données soient toujours propres, structurées et prêtes à l’emploi !