Le web avance à une vitesse folle, et que tu sois entrepreneur, geek ou juste curieux de données comme moi, tu l’as sûrement remarqué : la vraie valeur, c’est la donnée que tu peux récupérer, pas juste celle qui s’affiche devant toi. Aujourd’hui, les boîtes se lancent à fond dans l’automatisation de la collecte de données en ligne, et le marché mondial de l’extraction web devrait atteindre . Un chiffre qui claque : plus de utilisent aujourd’hui des robots d’exploration ou des extracteurs web pour nourrir leurs IA, leurs analyses et leurs process métier.

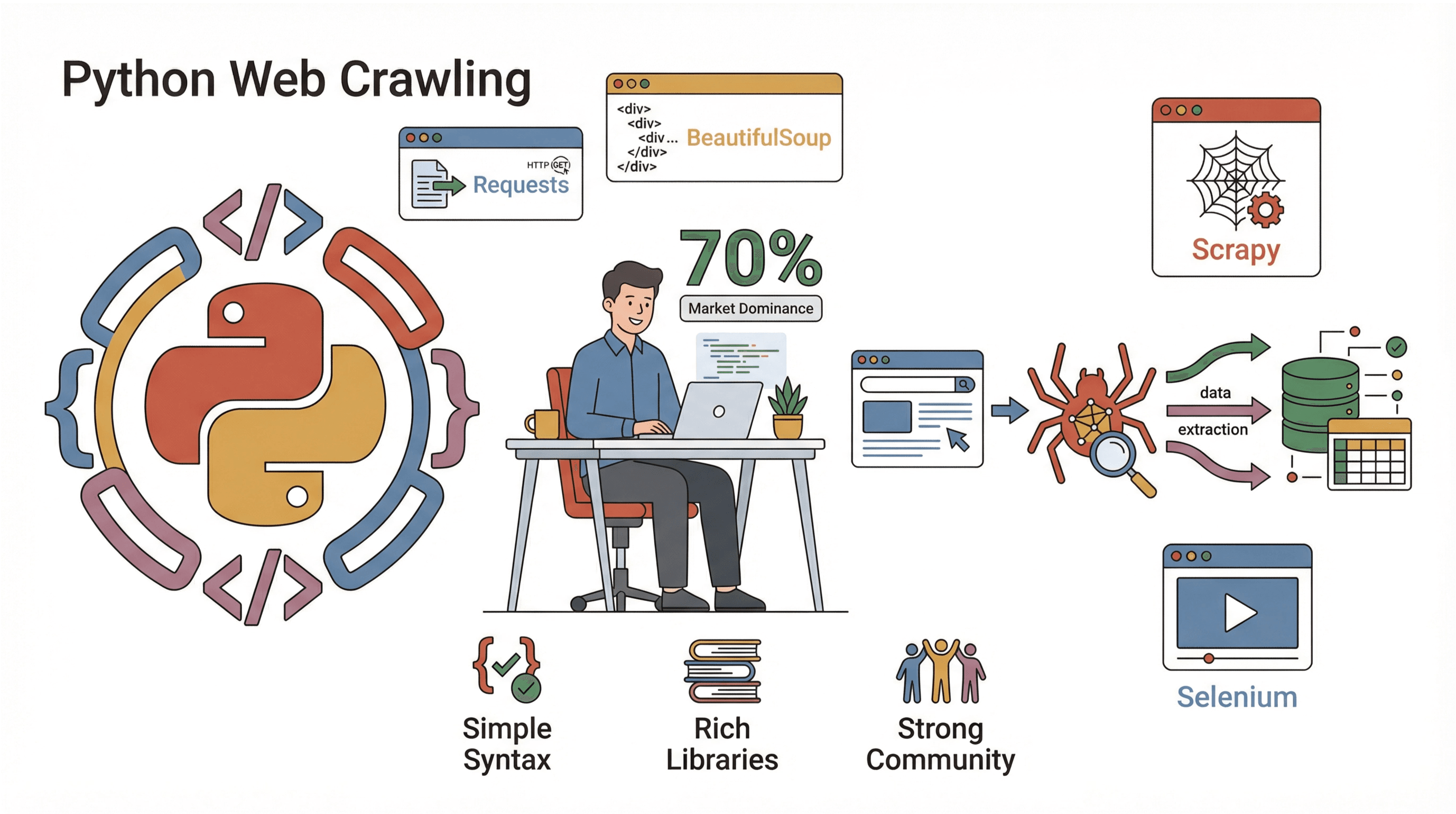

Alors, comment surfer sur cette vague ? Pour beaucoup, la réponse, c’est Python. C’est LE langage pour créer des robots d’exploration de sites web : simple, puissant, et blindé de bibliothèques qui rendent le crawling et l’extraction super accessibles. Dans ce guide, je t’explique ce qu’est un robot d’exploration, pourquoi Python est le top, comment coder ton propre crawler étape par étape, et comment des outils comme peuvent te simplifier la vie (surtout si tu préfères cliquer que coder). Que tu sois dev, marketeur branché data ou juste en quête d’automatisation, tu vas trouver ici de quoi booster ta collecte de données web.

Qu’est-ce qu’un robot d’exploration de site web ? (Et pourquoi ça vaut le coup ?)

Pour faire simple, un robot d’exploration de site web est un programme qui va automatiquement sur le web, visite des pages, suit des liens et (si besoin) récupère des données au passage. Imagine un surfeur du web qui ne dort jamais, ne s’ennuie jamais et ne ferme jamais le mauvais onglet. Les crawlers sont indispensables pour les moteurs de recherche (genre Googlebot), mais aussi pour les entreprises qui veulent surveiller les prix, faire de la veille ou analyser le marché.

Mais alors, c’est quoi la différence entre crawling et scraping ? Le crawling, c’est découvrir et naviguer sur les pages (comme dessiner la carte d’une ville), alors que le scraping, c’est extraire des infos précises de ces pages (genre récupérer tous les menus de restos de la ville). En vrai, la plupart des projets font les deux : on explore pour trouver les pages, puis on extrait ce qui nous intéresse ().

Exemples concrets d’utilisation des crawlers en entreprise :

- Génération de leads : Récupérer automatiquement des contacts depuis des annuaires ou les réseaux sociaux.

- Veille tarifaire : Suivre les prix et stocks des concurrents sur des milliers de produits.

- Surveillance de contenu : Être alerté dès qu’on parle de ta marque dans la presse, les blogs ou les forums.

- Audit SEO : Scanner ton site pour repérer les liens cassés ou les balises manquantes.

- Études de marché : Agréger des annonces immo, offres d’emploi ou avis produits pour analyse.

Si tu as déjà rêvé de te cloner pour faire de la veille sur le web, un crawler, c’est ton meilleur pote.

Pourquoi les robots d’exploration sont incontournables pour l’automatisation en entreprise

Passons au concret. Pourquoi les boîtes misent-elles autant sur les crawlers et extracteurs web ? Parce que le retour sur investissement est énorme. Voilà comment différents services s’en servent, et ce qu’ils y gagnent :

| Cas d’usage | Bénéfice clé | Utilisateurs |

|---|---|---|

| Génération de leads | Automatisation de la prospection, gain de temps | Ventes, Recrutement |

| Veille tarifaire | Suivi en temps réel des concurrents, tarification dynamique | E-commerce, Produits |

| Veille de contenu | Protection de la marque, détection de tendances | Marketing, RP |

| Audit SEO | Santé du site, amélioration du référencement | SEO, Webmasters |

| Études de marché | Données à jour et volumineuses pour l’analyse | Analystes, Recherche |

Une étude de cas a montré qu’automatiser une tâche hebdo de collecte de données (scraping de 5 à 7 sites) a permis à un salarié de gagner plus de 50 heures par an. Multiplie ça par une équipe, et tu piges pourquoi une fois qu’elles ont goûté aux crawlers.

Python : le choix numéro un pour créer un robot d’exploration

Pourquoi Python cartonne pour le crawling web ? Trois raisons qui font la diff :

Pourquoi Python cartonne pour le crawling web ? Trois raisons qui font la diff :

- Simplicité : La syntaxe de Python est limpide, parfaite pour débuter, et tu peux écrire un crawler qui tourne en quelques lignes.

- Écosystème de bibliothèques : Python propose un max de bibliothèques pour chaque étape : récupérer des pages, analyser le HTML, gérer le JavaScript, etc.

- Communauté : Près de tournent sous Python, donc tu trouves toujours de l’aide, des tutos et des réponses à tes galères.

Les bibliothèques Python à connaître pour le crawling :

- Requests : Le plus simple pour récupérer des pages web (HTTP GET/POST).

- BeautifulSoup : L’outil de base pour analyser le HTML et trouver les éléments.

- Scrapy : Un framework complet pour les gros projets de crawling.

- Selenium : Pour automatiser un navigateur et extraire des sites blindés de JavaScript.

Comparé à d’autres langages (Java, C#…), Python te permet de passer de l’idée au crawler qui tourne en un rien de temps. Et si tu bosses la data, tu peux direct exploiter tes résultats dans Pandas pour l’analyse, sans te prendre la tête.

Comparatif des méthodes de parsing : Regex vs. BeautifulSoup vs. Scrapy

Pour extraire des données d’une page web, tu as plusieurs options. Petit tour d’horizon :

| Méthode | Principe | Avantages 🟢 | Inconvénients 🔴 | Idéal pour |

|---|---|---|---|---|

| Regex | Recherche de motifs dans le HTML brut | Rapide pour des motifs simples et connus | Fragile, casse si le HTML change | Hacks rapides, extraction d’URLs |

| BeautifulSoup | Analyse le HTML en arbre, recherche par balises | Simple, flexible, gère le HTML mal formé | Plus lent sur de grosses pages, logique manuelle | Scripts de scraping petits/moyens |

| Scrapy | Framework complet, parsing CSS/XPath | Rapide, évolutif, gère crawling & parsing | Courbe d’apprentissage, configuration | Crawlers à grande échelle |

- Regex : c’est comme utiliser un détecteur de métaux sur la plage – rapide, mais tu passes à côté si le sable bouge.

- BeautifulSoup : c’est comme avoir une carte et une pelle – tu peux creuser partout, mais faut explorer toi-même.

- Scrapy : c’est comme débarquer avec une équipe, des camions et un GPS – trop pour un bac à sable, mais imbattable pour les gros chantiers.

Pour commencer, je te conseille Requests + BeautifulSoup. Tu apprends les bases, et tu passes à Scrapy quand tu veux passer à la vitesse supérieure.

Tutoriel : créer un robot d’exploration simple en Python, étape par étape

Prêt à te lancer ? On va construire un crawler basique qui visite des pages, suit des liens et récupère des données. Je te guide pas à pas, avec du code prêt à copier-coller.

Étape 1 : Préparer ton environnement Python

Vérifie que tu as Python 3.10+ (regarde avec python --version). Je te conseille de créer un environnement virtuel :

1python -m venv venv

2source venv/bin/activate # Sous Windows : venv\Scripts\activateEnsuite, installe les bibliothèques qu’il te faut :

1pip install requests beautifulsoup4C’est tout ! Ouvre ton éditeur de code préféré, on attaque.

Étape 2 : Écrire ton premier script de crawler

On commence par récupérer une page :

1import requests

2def crawl_page(url):

3 response = requests.get(url)

4 response.raise_for_status() # Erreur si le statut n’est pas 200 OK

5 print(response.text[:500]) # Affiche les 500 premiers caractères

6crawl_page("https://www.scrapingcourse.com/ecommerce/")Tu devrais voir un bout de HTML dans ta console : la connexion marche !

Étape 3 : Suivre les liens et explorer plusieurs pages

On va faire en sorte que le crawler suive les liens et visite plusieurs pages. On garde une liste d’URLs à visiter, et un set d’URLs déjà vues (pour éviter les boucles) :

1from bs4 import BeautifulSoup

2start_url = "https://www.scrapingcourse.com/ecommerce/"

3urls_to_visit = [start_url]

4visited_urls = set()

5max_pages = 20 # Limite de sécurité

6while urls_to_visit and len(visited_urls) < max_pages:

7 current_url = urls_to_visit.pop(0)

8 try:

9 resp = requests.get(current_url)

10 resp.raise_for_status()

11 except Exception as e:

12 print(f"Échec de récupération {current_url}: {e}")

13 continue

14 soup = BeautifulSoup(resp.text, "html.parser")

15 print(f"Crawlé : {current_url}")

16 for link_tag in soup.find_all("a", href=True):

17 url = link_tag['href']

18 if not url.startswith("http"):

19 url = requests.compat.urljoin(current_url, url)

20 if url.startswith(start_url) and url not in visited_urls:

21 urls_to_visit.append(url)

22 visited_urls.add(current_url)Ce script va explorer jusqu’à 20 pages, en restant sur le même site. Chaque URL visitée s’affichera.

Étape 4 : Extraire des données des pages

Imaginons que tu veuilles récupérer les noms et prix des produits sur chaque page. Voilà comment faire :

1product_data = []

2while urls_to_visit and len(visited_urls) < max_pages:

3 # ... (identique à plus haut)

4 soup = BeautifulSoup(resp.text, "html.parser")

5 if "/page/" in current_url or current_url == start_url:

6 items = soup.find_all("li", class_="product")

7 for item in items:

8 name = item.find("h2", class_="product-name")

9 price = item.find("span", class_="price")

10 link = item.find("a", class_="woocommerce-LoopProduct-link")

11 if name and price and link:

12 product_data.append({

13 "name": name.get_text(),

14 "price": price.get_text(),

15 "url": link['href']

16 })

17 # ... (suite du crawl)

18# Sauvegarde en CSV

19import csv

20with open("products.csv", "w", newline="") as f:

21 writer = csv.DictWriter(f, fieldnames=["name", "price", "url"])

22 writer.writeheader()

23 writer.writerows(product_data)

24print(f"{len(product_data)} produits extraits.")Tu obtiens un fichier CSV prêt à être analysé, importé ou partagé.

Étape 5 : Déboguer et optimiser ton crawler

Créer un crawler, c’est cool ; le rendre solide, c’est mieux. Quelques astuces de terrain :

- Définir un User-Agent : Certains sites bloquent « Python-requests » par défaut. Fais-toi passer pour un navigateur :

1headers = {"User-Agent": "Mozilla/5.0"} 2requests.get(url, headers=headers) - Gérer les erreurs : Utilise try/except pour zapper les pages inaccessibles ou bloquées.

- Éviter les boucles infinies : Garde la trace des URLs visitées et fixe une limite de pages.

- Limiter la fréquence : Ajoute

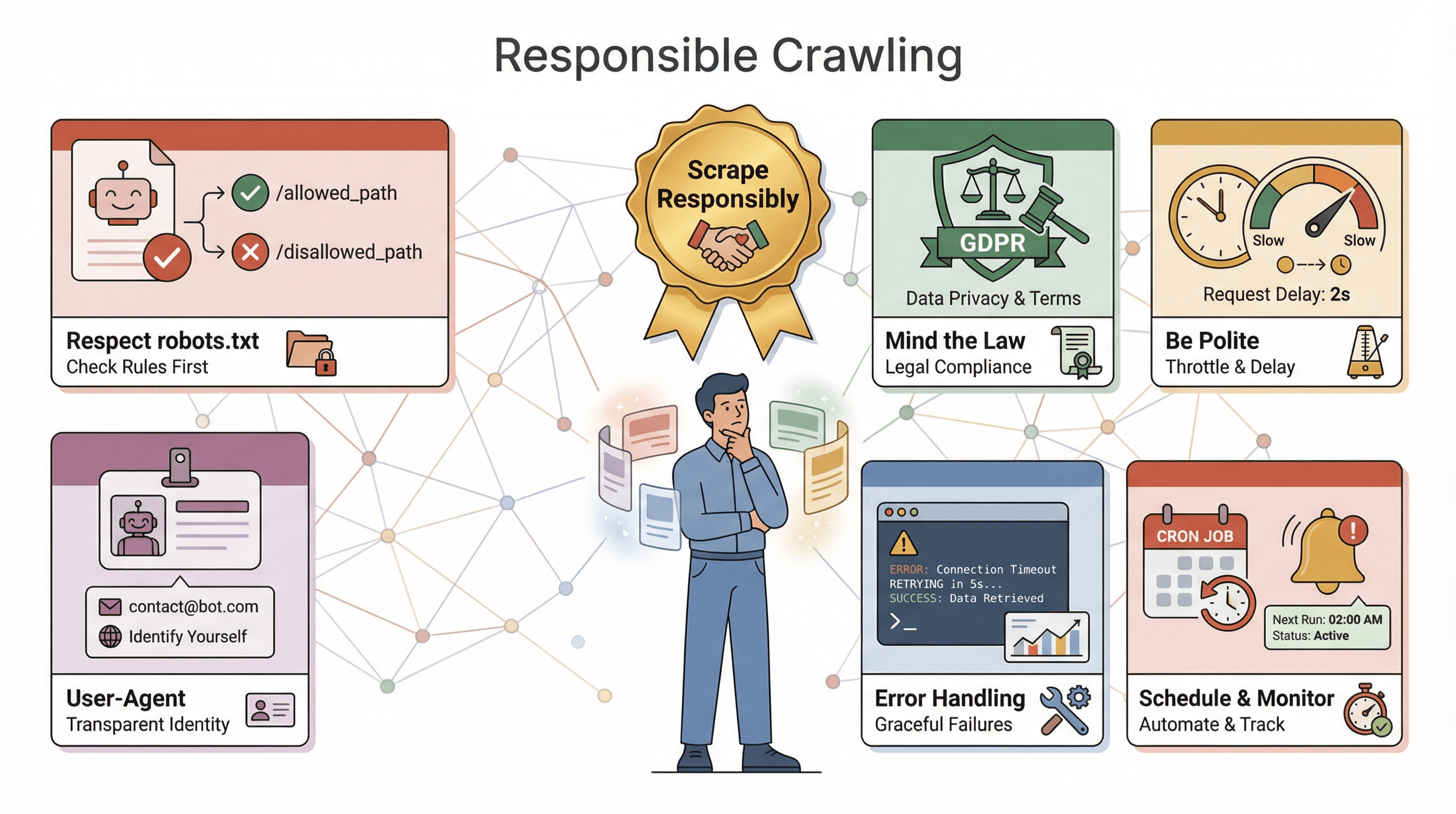

time.sleep(1)entre les requêtes pour éviter d’être bloqué. - Respecter robots.txt : Va toujours checker les règles d’un site ().

- Journaliser ta progression : Affiche ou enregistre chaque URL visitée, c’est super utile pour déboguer.

Si ton crawler se fait bloquer, retourne du contenu bizarre ou rate des données, vérifie tes headers, ralentis le rythme et assure-toi de respecter les protections anti-bot.

Thunderbit : simplifier le crawling web grâce à l’IA

Parlons maintenant de la solution « tranquille » pour le crawling web : . Même si j’adore Python, parfois tu veux juste les données, sans t’embêter avec l’installation, le débogage ou la maintenance. Thunderbit, c’est une extension Chrome d’extracteur web IA qui te permet de collecter des données sur n’importe quel site en quelques clics.

Pourquoi Thunderbit sort du lot ?

- Suggestions IA de champs : L’IA de Thunderbit analyse la page et te propose les données à extraire – plus besoin d’inspecter le HTML ou d’écrire des sélecteurs.

- Sans code, direct dans le navigateur : Ça marche dans ton navigateur, même sur les sites qui demandent une connexion ou blindés de JavaScript.

- Extraction de sous-pages : Besoin de détails ? Thunderbit peut aller automatiquement sur chaque sous-page (ex : fiche produit) et enrichir ton tableau.

- Export instantané : Tu exportes tes données vers Excel, Google Sheets, Airtable ou Notion – sans te prendre la tête avec des CSV.

- Extraction cloud ou locale : Tu choisis entre le cloud (pour les sites publics) ou le mode navigateur (pour les sites connectés ou complexes).

- Planification : Programme tes extractions automatiquement – pas besoin de serveur ni de cron.

Pour les pros, Thunderbit change la donne. Passe de « il me faut ces données » à « voilà mon tableau » en quelques minutes. Et si tu es dev, Thunderbit complète tes scripts : parfait pour les tâches rapides ou quand ton code a besoin d’une pause.

Envie de tester ? et essaie sur ton site préféré. L’offre gratuite permet d’extraire quelques pages, et les abonnements commencent à seulement 15 $/mois pour 500 crédits.

Points clés à retenir pour créer un robot d’exploration Python

Avant de lancer ton crawler, quelques conseils de bon sens :

Avant de lancer ton crawler, quelques conseils de bon sens :

- Respecte robots.txt : La plupart des sites ont un fichier

robots.txtqui dit ce qui est autorisé. L’ignorer peut te valoir un blocage, voire des soucis juridiques. Vérifie et respecte toujours ces règles (). - Attention à la loi : Certains sites interdisent l’extraction dans leurs conditions d’utilisation. Et si tu récupères des données perso, des lois comme le RGPD ou le CCPA peuvent s’appliquer (). En cas de doute, reste sur des données publiques et non sensibles.

- Sois cool : N’inonde pas les sites de requêtes – ralentis, varie les délais, évite les heures de pointe.

- Identifie-toi : Utilise un User-Agent personnalisé, et ajoute un contact si tu scrapes à grande échelle.

- Gère les erreurs et la journalisation : Les sites changent, les pages cassent, les données se salissent. Prévoyez la gestion des erreurs, la journalisation et le monitoring pour réagir vite.

- Planifie et surveille : Pour les crawls réguliers, utilise des outils de planification (cron ou le planificateur intégré de Thunderbit), et mets en place des alertes si ton crawler plante ou ne récupère plus rien.

La règle d’or : scrape de façon responsable. Le web est une ressource partagée – ne sois pas « ce bot » qui pourrit tout pour les autres.

Conseils avancés : faire évoluer et optimiser ton crawler Python

Une fois les bases en main, tu voudras sûrement aller plus loin. Quelques pistes :

- Gérer le JavaScript : Utilise Selenium ou Playwright pour extraire les sites dynamiques.

- Monter en charge : Pour les gros projets, passe à Scrapy ou aux bibliothèques asynchrones (genre

aiohttp) pour des requêtes en parallèle. - Utiliser des proxies : Fais tourner les adresses IP pour éviter les blocages lors de gros crawls.

- Automatiser les pipelines de données : Écris direct dans une base de données ou connecte-toi au cloud pour les gros volumes.

- Surveiller et alerter : Mets en place des logs, des checks de santé et des notifications pour les crawlers longue durée.

Si ton crawler devient critique, pense aux services managés ou aux API pour déléguer la charge. Et si tu scrapes plusieurs sites différents, rends ton code modulaire pour faciliter les mises à jour.

Conclusion & points clés à retenir

Créer un robot d’exploration en Python, c’est l’une des compétences les plus puissantes à avoir dans un monde piloté par la donnée. Pour résumer :

- Les robots d’exploration automatisent la visite et l’extraction de données sur le web – un must pour l’automatisation, la veille et l’intelligence concurrentielle.

- Python est le langage de choix grâce à sa simplicité, ses bibliothèques puissantes et sa communauté énorme.

- Le choix de la méthode de parsing est crucial : regex pour les cas simples, BeautifulSoup pour la majorité des scripts, Scrapy pour les gros volumes.

- Étape par étape, tu peux passer de la récupération d’une page à l’exploration complète d’un site et à la sauvegarde de données structurées – sans être expert.

- Thunderbit va encore plus loin, permettant d’extraire des données avec l’IA, sans code, et avec export instantané – parfait pour les pros ou ceux qui veulent aller vite.

- Le respect des règles est essentiel : suis les consignes des sites, gère les erreurs et garde l’éthique en tête.

- L’évolution est possible avec les bons outils – Selenium pour le JavaScript, Scrapy pour la concurrence, ou Thunderbit pour l’automatisation sans code.

Le meilleur moyen d’apprendre, c’est de te lancer : écris un script, teste Thunderbit, et découvre quelles données tu peux exploiter. Le web, c’est un vrai buffet de données – sers-toi !

Envie d’aller plus loin ? Voici quelques ressources :

- pour plus d’astuces, de guides et de techniques avancées.

Bon crawling – que tes extracteurs soient rapides, tes données propres, et ton café toujours chaud !

FAQ

1. Quelle est la différence entre un robot d’exploration et un extracteur web ?

Un crawler visite et découvre systématiquement les pages web (comme cartographier un site), tandis qu’un extracteur récupère des données précises sur ces pages. La plupart des projets combinent les deux : on explore pour trouver les pages, puis on extrait les données.

2. Pourquoi Python est-il si populaire pour créer des robots d’exploration ?

Python est facile à apprendre, dispose de bibliothèques puissantes (Requests, BeautifulSoup, Scrapy, Selenium) et d’une immense communauté. Près de 70 % des projets d’extraction web utilisent Python, ce qui en fait la norme du secteur.

3. Quand utiliser regex, BeautifulSoup ou Scrapy pour le parsing ?

Utilise regex pour des motifs simples et prévisibles. BeautifulSoup est idéal pour la plupart des scripts – simple et flexible. Scrapy convient aux crawlers à grande échelle ou en production, qui nécessitent rapidité, concurrence et robustesse.

4. Comment Thunderbit se compare-t-il à un crawler codé en Python ?

Thunderbit permet d’extraire des données avec l’IA et sans code – il suffit de cliquer, sélectionner les champs et exporter. Parfait pour les pros ou les tâches rapides. Python offre plus de contrôle et de personnalisation, mais demande du code et de la maintenance.

5. Quelles sont les questions légales ou éthiques à surveiller lors du crawling ?

Vérifie et respecte toujours le robots.txt, suis les conditions d’utilisation du site, évite de collecter des données sensibles ou personnelles sans consentement, et limite la fréquence de tes requêtes pour ne pas surcharger les serveurs. Un scraping responsable préserve l’accès au web pour tous.

Prêt à te lancer ? ou ouvre ton éditeur Python préféré et commence à crawler. Les données t’attendent – à toi de jouer !

En savoir plus