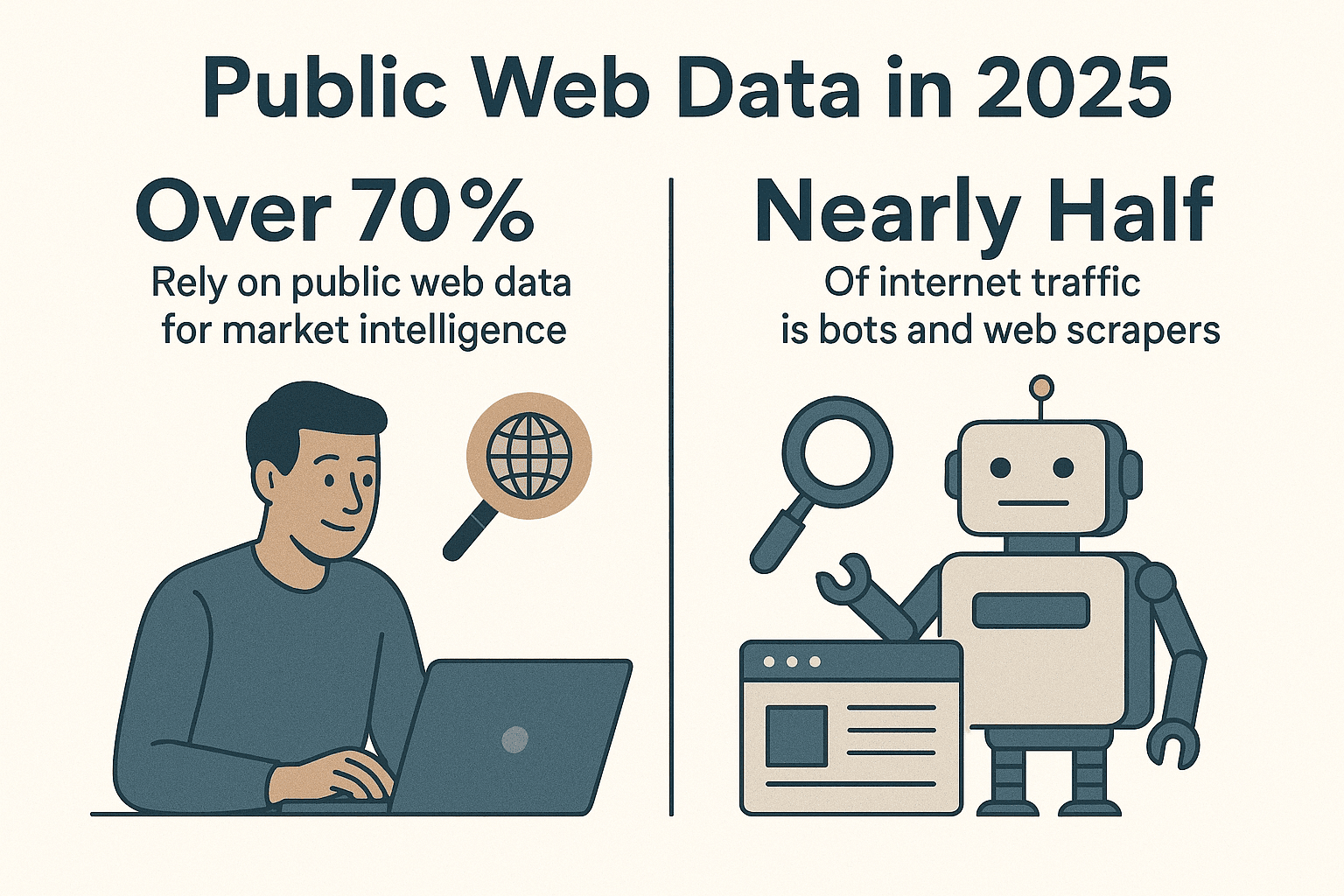

Le web, c’est un vrai terrain de jeu pour les données, et les boîtes rivalisent d’astuces pour transformer ce bazar en infos utiles. Aujourd’hui, plus de , et quasiment la moitié du trafic internet, c’est des bots et des extracteurs web, pas des humains (). Après des années à bidouiller des outils d’automatisation (et quelques spiders qui ont sûrement vu plus de sites que moi !), je peux te le dire franchement : si tu n’utilises pas de spider web Python pour automatiser ta collecte de données, tu rates un sacré gain de temps.

Python, c’est devenu LA référence pour l’extraction web, et ce n’est pas pour rien. Que tu bosses en vente, marketing, ops ou recherche, un spider Python bien ficelé te fera gagner un temps fou et te sortira des infos que tu n’aurais jamais pu choper autrement. Dans ce guide, je t’explique comment monter un spider web Python efficace, je partage mes bibliothèques préférées, mes astuces, et je te montre comment des outils comme peuvent vraiment booster ta productivité—surtout face à ces sites dynamiques qui donnent envie de tout plaquer !

Pourquoi miser sur Python pour créer un spider web ?

Soyons honnêtes : Python écrase tout dans le monde de l’extraction web. D’après les dernières stats, près de , loin devant JavaScript et compagnie. En 2024, Python a même dépassé JavaScript comme langage le plus populaire sur GitHub (), surtout grâce à sa place de choix en data science et automatisation.

Pourquoi Python est-il si parfait pour les spiders web ?

- Lisibilité et simplicité : Sa syntaxe est limpide, les débutants s’y mettent vite et les pros avancent à toute vitesse.

- Écosystème de bibliothèques : Des outils comme , , , et couvrent tous les besoins : récupérer des pages, parser du HTML, automatiser un navigateur…

- Communauté ultra-active : Si tu bloques, il y a toujours un tuto ou un exemple pour t’aider.

- Flexibilité : Python te permet de passer d’un petit script à des spiders capables de crawler des milliers de pages.

Face aux autres langages, Python offre le meilleur compromis entre puissance et accessibilité. JavaScript (Node.js) est top pour le contenu dynamique, mais son côté asynchrone peut dérouter. Java et C# sont costauds mais plus lourds. Python, lui, te laisse te concentrer sur l’essentiel : la data.

Préparer ton environnement Python pour le spider web

Avant de te lancer, il te faut un setup solide. Voici comment je m’y prends à chaque nouveau projet :

1. Installer Python 3

Télécharge la dernière version de Python 3.x sur ou via le gestionnaire de paquets de ton système. Vérifie que python ou python3 marche dans ton terminal.

2. Créer un environnement virtuel

Isole les dépendances de ton projet avec un environnement virtuel :

1python3 -m venv .venv

2# Sur Unix/Mac

3source .venv/bin/activate

4# Sur Windows

5.venv\Scripts\activateÇa permet de garder tes paquets bien rangés et d’éviter les embrouilles.

3. Installer les bibliothèques essentielles

Active ton environnement virtuel, puis installe les bibliothèques clés :

1pip install requests beautifulsoup4 lxml scrapy selenium pandas sqlalchemyÀ quoi servent-elles ?

- Requests : Pour récupérer les pages web en HTTP.

- BeautifulSoup : Pour analyser et naviguer dans le HTML.

- lxml : Pour parser du HTML/XML rapidement (utilisé par BeautifulSoup pour la perf).

- Scrapy : Framework complet pour le crawling à grande échelle.

- Selenium : Pour automatiser le navigateur sur les sites dynamiques.

- pandas : Pour nettoyer et manipuler les données.

- SQLAlchemy : Pour stocker les données en base.

Avec ça, tu peux tout faire, du petit script à l’« armée » de spiders.

Choisir la bonne bibliothèque Python pour ton spider web

Python propose un paquet d’outils pour l’extraction. Voici comment je choisis :

| Bibliothèque/Outil | Facilité d'utilisation | Vitesse & Échelle | Idéal pour |

|---|---|---|---|

| Requests + BeautifulSoup | Très facile | Modérée (une page à la fois) | Débutants, pages statiques, petits besoins |

| Scrapy | Courbe d'apprentissage | Très rapide (asynchrone, concurrent) | Crawling massif, extraction de sites entiers |

| Selenium/Playwright | Moyenne | Plus lent (navigateur) | Sites JS, pages derrière connexion |

| aiohttp + asyncio | Moyenne (async) | Très rapide (beaucoup d’URLs) | Scraping statique à gros volume |

| Thunderbit (No-Code) | Ultra simple (IA) | Rapide (cloud/local) | Non-développeurs, sites dynamiques, résultats rapides |

Ma règle d’or :

- Pour quelques pages statiques, Requests + BeautifulSoup, c’est parfait.

- Pour des centaines ou milliers de pages, ou si tu veux du crawling intégré, Scrapy est top.

- Pour les sites qui ont besoin d’un vrai navigateur (scroll infini, login…), Selenium ou Playwright.

- Pour « je veux la data tout de suite sans coder », est imbattable.

Construire un spider web Python basique : étape par étape

On va se faire un spider simple pour extraire les titres d’articles sur Hacker News. C’est mon « hello world » du scraping !

1. Récupérer la page web

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content2. Analyser le HTML

1soup = BeautifulSoup(html_content, "html.parser")3. Extraire les données

1articles = soup.find_all("tr", class_="athing")

2for article in articles:

3 title_elem = article.find("span", class_="titleline")

4 title = title_elem.get_text()

5 link = title_elem.find("a")["href"]

6 print(title, "->", link)4. Gérer la pagination

Hacker News a un lien « More » en bas de page. Voilà comment le suivre :

1import time

2page_url = url

3while page_url:

4 resp = requests.get(page_url)

5 soup = BeautifulSoup(resp.text, 'html.parser')

6 # (extraction des articles comme ci-dessus)

7 next_link = soup.find("a", class_="morelink")

8 if next_link:

9 page_url = requests.compat.urljoin(resp.url, next_link["href"])

10 time.sleep(1) # On reste cool avec le serveur !

11 else:

12 page_url = None5. Gérer les erreurs et rester fair-play

- Vérifie toujours

response.status_code. - Utilise

time.sleep()pour ne pas bombarder le serveur. - Mets un User-Agent personnalisé :

1headers = {"User-Agent": "MyWebSpider/0.1 (+your_email@example.com)"}

2requests.get(url, headers=headers)Ce spider de base s’adapte à quasi tous les sites statiques. Pour aller plus loin, direction Scrapy.

Booster ton spider avec Scrapy

Quand tu veux passer à la vitesse supérieure, Scrapy est la solution. Voici comment démarrer :

1. Créer un projet Scrapy

1scrapy startproject myspider2. Créer un spider

Dans myspider/spiders/quotes_spider.py :

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get(),

10 'tags': quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)3. Lancer le spider

1scrapy crawl quotes -o quotes.jsonScrapy va tout gérer : parcourir les pages, suivre les liens, exporter tes données en JSON (ou CSV, XML, etc.)—et tout ça avec très peu de code.

Pourquoi j’adore Scrapy :

- Gestion native de la concurrence, des délais et du respect des sites

- robots.txt pris en charge automatiquement

- Export et pipelines de données faciles pour nettoyer ou stocker

- Passe de quelques pages à des millions sans prise de tête

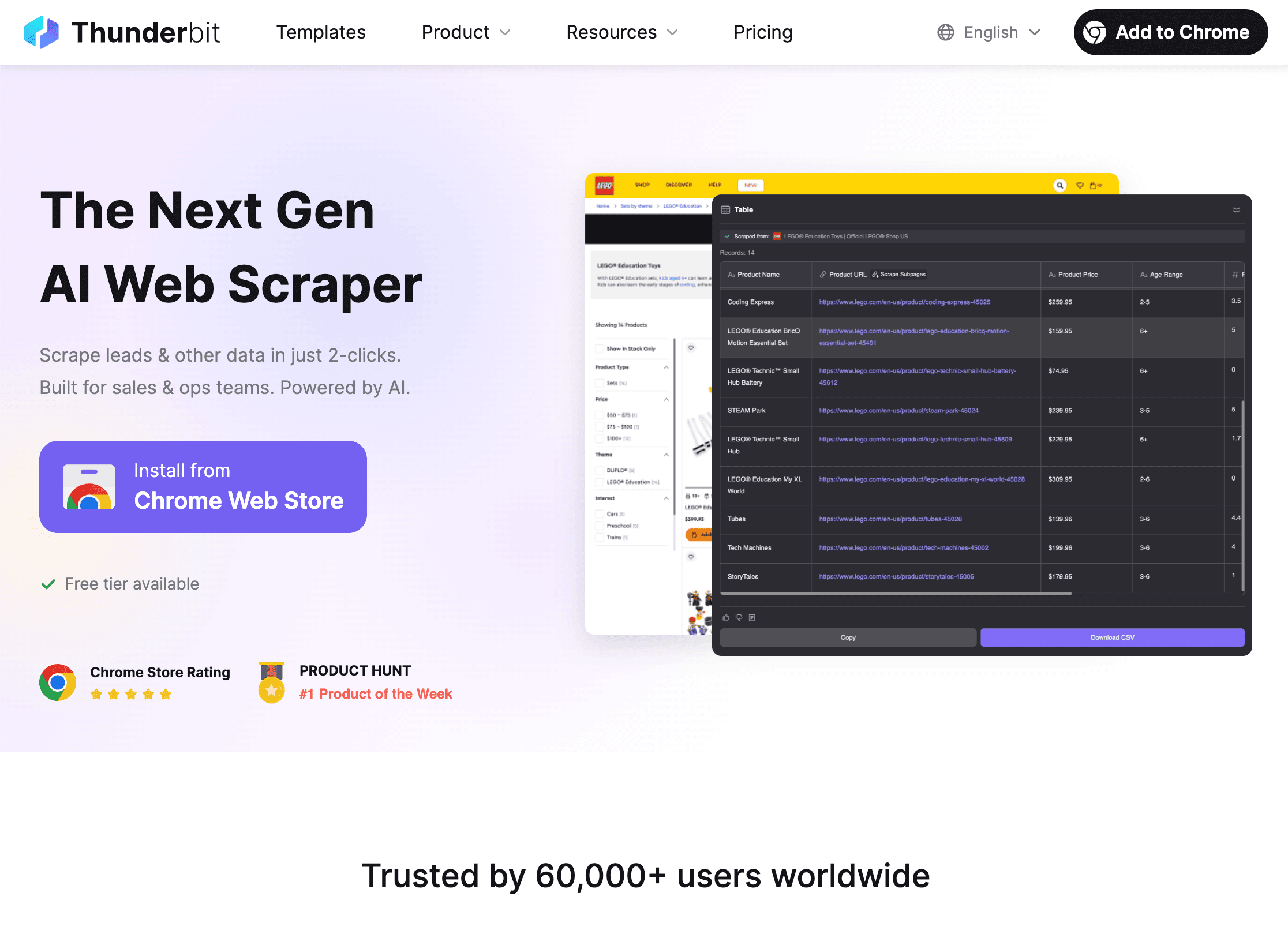

Aller plus loin avec Thunderbit

Parlons du vrai challenge : les sites dynamiques. Même avec Python, certains sites sont un vrai casse-tête—JavaScript partout, protections anti-bot, structure qui change tout le temps. C’est là que fait la différence.

Qu’est-ce qui rend Thunderbit unique ?

- Suggestion de champs par IA : Ouvre l’, clique sur « Suggestion IA », et l’IA de Thunderbit te propose direct les données à extraire—plus besoin de fouiller le HTML ou d’écrire des sélecteurs.

- Extraction sur sous-pages : Thunderbit peut suivre les liens vers des pages de détail (produits, profils…) et fusionner ces infos dans ton tableau principal.

- Gestion du contenu dynamique : Thunderbit bosse dans un vrai navigateur, donc il gère les sites JavaScript, le scroll infini, et même le remplissage de formulaires grâce à l’Auto-remplissage IA.

- No-code, langage naturel : Tu décris ce que tu veux (« Extraire tous les intitulés de poste et localisations de cette page »), Thunderbit s’occupe du reste.

- Export instantané : Balance tes données vers CSV, Excel, Google Sheets, Airtable ou Notion—gratuitement et sans limite.

- Extraction programmée : Planifie des extractions récurrentes (« chaque jour à 9h ») et reçois tes données fraîches automatiquement.

Comment Thunderbit complète Python

Voici mon workflow préféré :

- Utilise Thunderbit pour extraire les sites complexes ou dynamiques—parfait quand il faut aller vite ou éviter de maintenir du code fragile.

- Exporte les données en CSV ou Excel.

- Charge-les dans Python avec pandas pour nettoyage, analyse ou automatisation avancée.

C’est le combo gagnant : Thunderbit gère l’extraction, Python s’occupe du traitement et de l’analyse.

Quand utiliser Thunderbit ou un spider Python ?

- Thunderbit : Idéal pour les non-devs, les sites dynamiques, les besoins ponctuels, ou pour donner de l’autonomie aux équipes métier.

- Python : Parfait pour la logique sur-mesure, les crawls massifs ou planifiés, ou l’intégration avec d’autres systèmes.

- Les deux : Extraction avec Thunderbit, analyse et automatisation avec Python. C’est comme le beurre de cacahuète et la confiture—chacun est bon, ensemble c’est imbattable.

Pour en savoir plus sur les workflows hybrides, va voir .

Rester dans les clous et respecter les règles des sites

L’extraction web, c’est puissant, mais ça vient avec des responsabilités (et parfois des messages pas très sympas des admins !). Voici comment rester clean :

1. Respecter robots.txt

La plupart des sites ont un fichier robots.txt qui dit ce qui est autorisé ou pas. Tu peux le checker en Python :

1import urllib.robotparser

2rp = urllib.robotparser.RobotFileParser()

3rp.set_url("http://www.example.com/robots.txt")

4rp.read()

5if not rp.can_fetch("*", "http://www.example.com/target-page"):

6 print("Extraction interdite par robots.txt")Scrapy respecte robots.txt par défaut (ROBOTSTXT_OBEY=True).

2. Sois cool

- Utilise des délais (

time.sleep()ouDOWNLOAD_DELAYde Scrapy) pour ne pas saturer les serveurs. - Mets un User-Agent explicite avec tes coordonnées.

- N’extrais pas de données perso ou protégées.

- Si un site te bloque ou te demande d’arrêter, respecte sa demande.

3. Gérer les limites et les CAPTCHAs

- Si tu prends des erreurs 429 (« Trop de requêtes »), ralentis ou utilise des proxies.

- N’essaie pas de forcer les CAPTCHAs—si tu en vois un, c’est qu’il faut lever le pied.

Pour plus d’infos sur l’éthique et la conformité, lis .

Organiser et stocker tes données avec Python

Une fois tes données extraites, il faut les nettoyer, transformer et stocker pour l’analyse. Voici ma méthode :

1. Nettoyer et transformer avec pandas

1import pandas as pd

2df = pd.DataFrame(scraped_data)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df = df.dropna()2. Exporter en CSV ou Excel

1df.to_csv('output.csv', index=False)

2df.to_excel('output.xlsx', index=False)3. Stocker en base avec SQLAlchemy

1from sqlalchemy import create_engine

2engine = create_engine('sqlite:///scraped_data.db')

3df.to_sql(name='products', con=engine, if_exists='replace', index=False)Comme ça, tu peux monter toute une chaîne, du spider au dashboard.

Automatiser tes pipelines de données

Pour les tâches récurrentes, tout peut s’automatiser :

- Cron jobs : Planifie tes scripts Python pour tourner régulièrement.

- Apache Airflow : Pour les workflows costauds, Airflow orchestre extraction, nettoyage et reporting.

- Programmation Thunderbit : Laisse Thunderbit extraire à intervalle régulier, puis déclenche ton script Python pour traiter les nouvelles données.

Pour aller plus loin, lis .

Dépanner et optimiser ton spider web Python

Même les meilleurs spiders se prennent des murs. Voici ma checklist rapide :

- Requêtes bloquées (403/429) : Change de User-Agent, ralentis, ou utilise des proxies. Vérifie robots.txt.

- Données manquantes : Revois tes sélecteurs. Le HTML a peut-être changé.

- Contenu dynamique : Passe par Selenium ou Thunderbit pour les sites JS.

- Performance : Utilise l’asynchrone (aiohttp) ou la concurrence de Scrapy. Écris les données au fil de l’eau pour éviter les soucis de mémoire.

- Débogage : Affiche des logs, utilise les outils dev du navigateur, et vérifie toujours tes résultats.

Pour plus d’astuces, va voir .

Conclusion & points clés à retenir

Monter un spider web Python efficace, c’est un vrai super-pouvoir—tu gagnes un temps fou et tu récupères de la meilleure data. On résume :

- Python est le top pour les spiders web, grâce à sa simplicité, ses bibliothèques et sa communauté.

- Prépare ton environnement avec virtualenv et les bonnes bibliothèques (Requests, BeautifulSoup, Scrapy, Selenium, pandas, SQLAlchemy).

- Choisis l’outil adapté : script simple pour les petits besoins, Scrapy pour l’échelle, Selenium pour le dynamique, Thunderbit pour l’IA et le no-code.

- Écris des spiders propres et respectueux des robots.txt et des conditions d’utilisation.

- Stocke et traite tes données avec pandas et SQLAlchemy, et automatise ton pipeline pour les tâches récurrentes.

- Combine Python et Thunderbit pour une flexibilité maximale—laisse l’IA gérer l’extraction, puis analyse et automatise avec Python.

Prêt à passer à la vitesse supérieure ? et découvre à quel point c’est simple d’extraire des données, même sur les sites les plus coriaces. Pour aller plus loin, jette un œil au pour des guides, astuces et exemples concrets.

Bonne extraction—et que tes spiders ramènent toujours la data dont tu as besoin (sans jamais se faire piéger par un CAPTCHA) !

FAQ

1. Pourquoi Python est-il le meilleur langage pour créer des spiders web ?

Grâce à sa syntaxe simple, son écosystème géant (Requests, BeautifulSoup, Scrapy…) et sa communauté active, Python permet de créer, faire évoluer et maintenir des spiders web facilement. Il est accessible aux débutants tout en étant assez costaud pour des projets pros à grande échelle.

2. Quand utiliser Thunderbit plutôt que de coder son propre spider Python ?

Thunderbit est parfait pour les non-devs, les sites dynamiques ou complexes, ou quand il faut obtenir des données vite sans écrire ni maintenir de code. Pour des projets très personnalisés, massifs ou intégrés, les spiders Python restent la référence. Beaucoup d’équipes mixent les deux : Thunderbit pour l’extraction, Python pour l’analyse.

3. Comment s’assurer que mon spider web est légal et éthique ?

Vérifie et respecte toujours le robots.txt du site, adopte un crawling cool (délais, user-agent), et évite d’extraire des données perso ou protégées. Si un site te demande d’arrêter, obéis. Pour plus d’infos, lis .

4. Quelle est la meilleure façon de stocker et traiter les données extraites ?

Utilise pandas pour nettoyer et transformer les données, exporte-les en CSV/Excel pour le partage, et SQLAlchemy pour les stocker en base (SQLite, PostgreSQL…) pour les gros volumes ou les extractions régulières.

5. Comment automatiser mon pipeline d’extraction web ?

Utilise des cron jobs ou Apache Airflow pour planifier tes scripts Python. Thunderbit propose aussi l’extraction programmée, que tu peux combiner avec Python pour une automatisation complète.

Envie de découvrir plus d’astuces concrètes ? Va voir et abonne-toi à la pour des tutos et démos.