Dans le monde B2B d’aujourd’hui, la donnée en temps réel, c’est le nerf de la guerre. Ton CRM, tes modèles de pricing ou tes analyses de marché ne valent pas grand-chose si tu ne les nourris pas avec des infos fraîches et fiables. Et la meilleure source pour ça ? Les sites web publics, évidemment. En 2025, l’extraction web n’est plus réservée aux geeks du code : c’est devenu un réflexe pour toutes les équipes commerciales, marketing ou opérations qui veulent transformer le bazar du web en données propres et prêtes à l’emploi. Avec un bon extracteur web, tu peux dire adieu aux copier-coller interminables et bonjour à la génération de listes de prospects en quelques minutes, café à la main.

Si tu veux rejoindre les équipes qui misent tout sur la data (sans te prendre la tête avec du XPath), t’es au bon endroit. Après des années dans le SaaS, l’automatisation et l’IA — d’abord chez Automation Anywhere, puis , et maintenant comme cofondateur de — j’ai vu les extracteurs web passer de gadgets de nerds à outils business incontournables. Dans ce guide, je te présente les 12 meilleurs extracteurs web pour 2025 : de l’assistant IA aux extensions classiques, pour que tu trouves l’outil parfait, adapté à ton équipe, tes besoins et ton rythme.

Pourquoi les extracteurs web sont devenus incontournables en 2025

Soyons clairs : le web, c’est la plus grosse base de données du monde… et la plus désorganisée. En 2025, les boîtes qui arrivent à transformer ce chaos en infos concrètes prennent une vraie avance. D’après , les entreprises pilotées par la donnée sont 5 % plus productives et 6 % plus rentables que les autres. C’est pas juste un détail, c’est un vrai game changer.

Les extracteurs web (ou extracteurs de page web, ou solutions d’extraction web) sont la clé de cette réussite. Ils permettent aux équipes commerciales de récupérer des listes ciblées de prospects depuis des annuaires, réseaux sociaux ou sites d’entreprises — fini les fichiers obsolètes ou les stagiaires qui craquent en plein copier-coller (). Côté marketing et e-commerce, les extracteurs web servent à surveiller les prix des concurrents, suivre les stocks et comparer les produits en temps réel — John Lewis, par exemple, a vu ses ventes grimper de 4 % grâce à une politique tarifaire plus maligne basée sur le web scraping ().

Mais ce n’est pas qu’une histoire de chiffres. Les extracteurs web font gagner un temps fou (certains parlent de « centaines d’heures » économisées grâce à l’automatisation) et limitent les erreurs humaines (). Les équipes opérations automatisent maintenant des collectes de données qui prenaient des semaines à un stagiaire — libérant des heures entières de tâches répétitives (). Et avec les extracteurs boostés à l’IA, même les non-techs peuvent transformer des sites web en données structurées prêtes à être analysées ().

En clair ? Si tu n’utilises pas d’extracteur web en 2025, tu passes à côté d’opportunités (et de cash).

Comment on a sélectionné les 12 meilleurs extracteurs web ?

Avec tous les outils d’extraction web qui existent, comment faire le tri ? J’en ai testé des dizaines, mais seuls 12 sortent vraiment du lot. Voici mes critères :

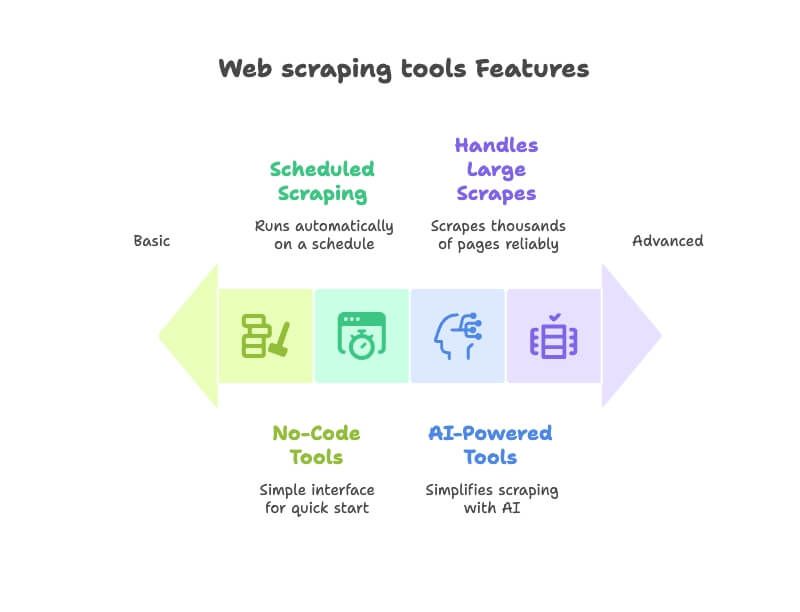

- Simplicité d’utilisation : Est-ce qu’un non-tech peut démarrer sans coder ? J’ai privilégié les solutions no-code ou low-code avec une interface intuitive ().

- Fonctionnalités IA : Les outils nouvelle génération qui utilisent l’IA pour simplifier l’extraction — détection automatique des champs, navigation intelligente, ou description des besoins en langage naturel ().

- Automatisation & planification : Les meilleurs extracteurs tournent en pilote automatique. J’ai gardé ceux qui permettent de planifier des extractions récurrentes ou de surveiller des sites ().

- Export & intégration des données : Peut-on facilement exporter vers Excel, Google Sheets, Airtable ou Notion ? Bonus pour les intégrations dans les workflows ().

- Scalabilité et fiabilité : Que tu extraies une page ou des milliers, ces outils tiennent la route. J’ai aussi pris en compte les retours utilisateurs.

- Cas d’usage business : J’ai mis l’accent sur les outils plébiscités par les équipes commerciales, marketing, e-commerce et opérations — pas juste les devs.

Certains outils sont tout nouveaux et boostés à l’IA, d’autres sont des valeurs sûres. Tous sont pensés pour transformer le web en base de données business — sans prise de tête.

Comparatif express : les extracteurs web en un clin d’œil

Voici un tableau pour comparer d’un coup d’œil les 12 extracteurs web que je vais détailler :

| Outil | Automatisation IA | Facilité d’utilisation | Meilleur cas d’usage |

|---|---|---|---|

| Thunderbit | Oui – l’IA suggère les champs et gère les pages automatiquement | Ultra simple (extension Chrome, sans code) | Extraction rapide de leads, prix, etc. pour les non-techniciens qui veulent des résultats immédiats. |

| Octoparse | Limité (basé sur des modèles, pas d’IA) | Facile pour la plupart (interface glisser-déposer) | Workflows d’extraction personnalisés (avec connexion, pagination) pour analystes sans code. |

| Browse AI | Partiel – robots « pointer-cliquer » | Facile (no-code, cloud) | Surveillance automatisée de données (prix, annonces…) avec alertes et intégrations. |

| WebScraper.io | Non (configuration manuelle) | Moyen (extension navigateur avec sitemaps) | Extraction visuelle de sites complexes pour utilisateurs prêts à configurer les étapes. |

| ScraperAPI | N/A (service API, gère les proxys via API) | Nécessite du code (intégration API) | Extraction web à grande échelle pour équipes techniques — gestion des proxys & CAPTCHAs. |

| Data Miner | Non | Très simple (extension navigateur, modèles 1-clic) | Extraction ponctuelle de données (surtout tableaux/listes) directement en CSV/Excel. |

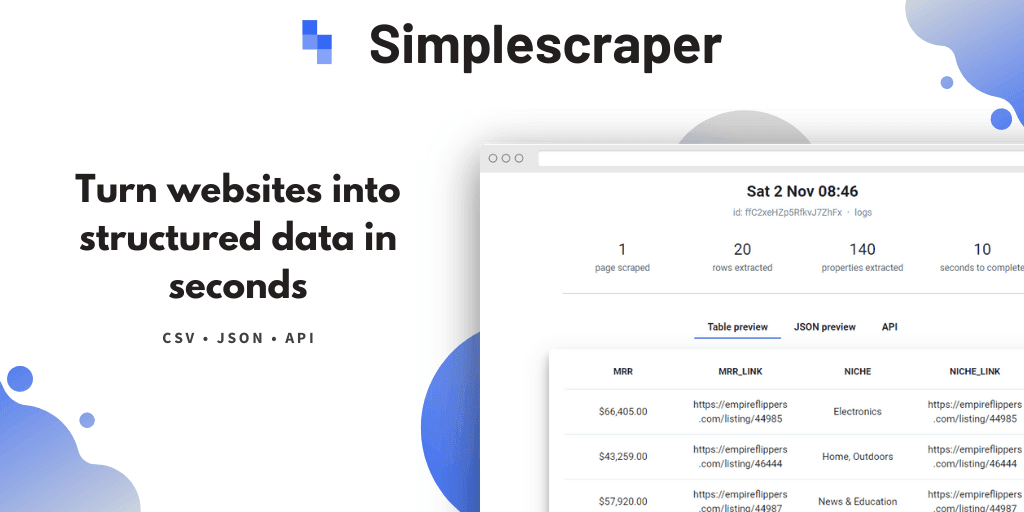

| Simplescraper | Non (quelques fonctions IA) | Facile (créateur de recettes pointer-cliquer) | Extraction no-code avec intégrations — idéal pour envoyer les données vers Google Sheets, Airtable ou API. |

| Instant Data Scraper | Oui – détecte automatiquement les tableaux | Ultra simple (un clic, sans configuration) | Extraction gratuite et instantanée de tableaux/listes HTML pour tous (parfait pour des besoins rapides). |

| ScrapeStorm | Oui – l’IA identifie les éléments | Facile (interface visuelle ; appli multiplateforme) | Projets d’extraction complexes ou volumineux sans code, avec planification. |

| Apify | Partiel – « acteurs » préconstruits disponibles | Moyen (interface web ; code optionnel) | Extraction cloud scalable et automatisation via scripts prêts à l’emploi ou personnalisés. |

| ParseHub | Non (sans script mais configuration manuelle) | Facile pour l’essentiel (éditeur visuel ; appli desktop) | Extraction de sites dynamiques/complexes (contenu AJAX) via une interface no-code. |

| OutWit Hub | Non | Facile (application desktop) | Extraction simple et archivage de contenu hors ligne pour petits projets. |

La plupart des outils proposent une version gratuite ou d’essai, avec des abonnements selon les besoins. Ici, on se concentre sur les fonctionnalités et cas d’usage, pas sur le prix.

Thunderbit : l’extracteur web IA pour tous

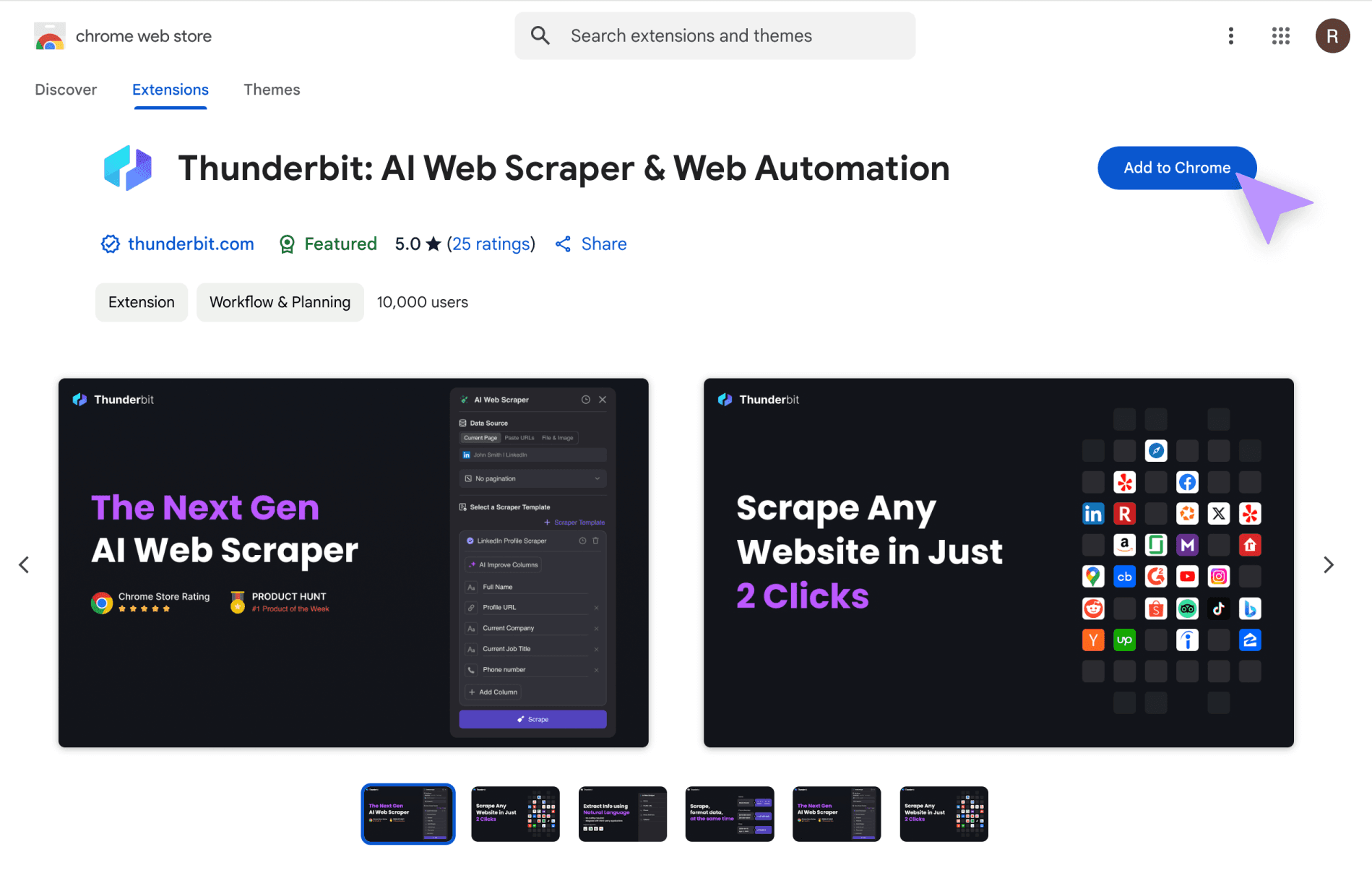

On commence avec Thunderbit — oui, c’est mon bébé, mais laisse-moi t’expliquer pourquoi il change la donne. L’extraction web évolue : on passe du « configure ton propre scraper » au « explique juste à l’IA ce que tu veux ». Thunderbit, c’est le premier outil (et j’y ai bossé !) qui agit vraiment comme un assistant de données IA et pas juste un « crawler ».

Avec , oublie XPath, sélecteurs CSS ou regex. Tu décris simplement ce que tu veux en français — genre « récupère le titre, l’auteur et la date de cette page » — et l’IA de Thunderbit s’occupe de tout (). Clique sur « Suggérer les champs avec l’IA » et Thunderbit lit la page, propose les colonnes, gère les sous-pages et la pagination tout seul ().

Mais Thunderbit ne fait pas que l’extraction brute. Il peut nettoyer, transformer, catégoriser et même traduire les champs à la volée. Besoin d’uniformiser des numéros de téléphone, de résumer des descriptions ou de traduire des noms de produits ? Ajoute une consigne, l’IA s’en charge. À la fin, tu exportes direct vers Excel, Google Sheets, Airtable ou Notion ().

Ce qui fait la vraie différence avec Thunderbit, c’est zéro configuration et aucune courbe d’apprentissage. C’est une extension Chrome : tu es prêt en quelques secondes. Pas de plugins, pas de jargon technique. C’est pour ça qu’il cartonne auprès des équipes commerciales, marketing et opérations qui veulent des résultats immédiats (). La version gratuite permet de tester tout le workflow, et les abonnements sont abordables (souvent moins cher qu’un café par mois pour une équipe !).

Pour tester l’extraction web IA version 2025, et essaie-la. Tu ne verras plus jamais le copier-coller de la même façon.

Octoparse : extracteur web visuel pour workflows sur-mesure

Octoparse, c’est le classique de l’extraction web visuelle. C’est une appli de bureau avec une interface pointer-cliquer : tu interagis avec la page, tu sélectionnes les données à extraire, et Octoparse construit le workflow derrière (). Tu peux gérer les connexions, la pagination, automatiser les formulaires, tout ça sans coder.

Un gros plus d’Octoparse, c’est sa bibliothèque de plus de 500 modèles prêts à l’emploi pour les sites populaires (Amazon, Twitter, LinkedIn, etc.), ce qui permet souvent de démarrer en quelques clics (). Pour les sites plus complexes, tu passes en mode manuel et tu configures chaque étape visuellement. Octoparse gère aussi le contenu qui se charge après clic ou scroll, les proxys et les CAPTCHAs. Une version cloud permet de planifier et d’exécuter des extractions à grande échelle.

Le revers ? Il y a une petite courbe d’apprentissage, surtout pour les scénarios avancés. Mais pour les non-devs et analystes qui veulent un workflow d’extraction sur-mesure sans coder, Octoparse est un super choix ().

Browse AI : extraction web automatisée avec robots pré-entraînés

Browse AI propose une approche fun : tu « entraînes un robot » en cliquant sur les données à extraire, et il apprend à les récupérer sur des pages similaires (). Tout se passe dans le cloud, sans code ni scripts à gérer.

Ce qui fait la force de Browse AI, c’est l’automatisation et la surveillance. Tu peux planifier l’exécution régulière de tes robots et recevoir des alertes en cas de changement (baisse de prix chez un concurrent, nouvelle offre d’emploi, etc.). Une bibliothèque de robots pré-entraînés permet souvent de démarrer avec une solution clé en main, à personnaliser si besoin ().

Browse AI s’intègre à des milliers d’apps via Zapier et Make, et peut exporter direct vers Google Sheets ou via API/webhooks (). C’est top pour la surveillance continue et la collecte récurrente de données, surtout si tu veux des alertes et des intégrations automatiques.

WebScraper.io : extracteur de page web dans le navigateur

WebScraper.io (souvent appelé « Web Scraper ») est une extension navigateur qui permet de créer des « sitemaps » — des plans visuels pour naviguer sur un site et extraire les éléments voulus (). Tu définis les sélecteurs pour les données et les liens à suivre (ex : « cliquer sur suivant pour paginer » ou « visiter chaque fiche produit »).

Il y a une petite courbe d’apprentissage, mais pas besoin de coder : il suffit de sélectionner les éléments et d’indiquer les actions d’extraction. Web Scraper gère la navigation multi-niveaux, la pagination et même le scroll infini (si tu paramètres bien les étapes). Il fonctionne dans le navigateur, donc tu peux extraire des sites derrière un login en te connectant toi-même.

WebScraper.io est parfait pour les « analystes citoyens » à l’aise avec la structure des pages web et qui veulent un outil gratuit et flexible.

ScraperAPI : extracteur web orienté API pour les équipes techniques

Parfois, il faut une solution backend pour injecter les données web direct dans tes apps ou bases de données. ScraperAPI est un extracteur web orienté API : tu lui donnes une URL, il te renvoie le HTML brut ou les données extraites, en gérant pour toi les proxys, la rotation d’IP, les navigateurs headless et les CAPTCHAs ().

ScraperAPI, c’est plus de 40 millions de proxys dans 50+ pays et 36 milliards de requêtes par mois (). C’est l’outil parfait pour l’extraction web à grande échelle et automatisée, où la fiabilité et l’anti-blocage sont essentiels. Il faut quelques bases en dev, mais pour intégrer l’extraction dans tes pipelines ou produits, ScraperAPI est une référence.

Data Miner : extension Chrome pour extractions rapides de pages web

Data Miner est une extension Chrome pensée pour les pros et chercheurs qui veulent extraire des données vite fait. Elle propose une expérience pointer-cliquer et une bibliothèque de recettes d’extraction prêtes à l’emploi pour les tableaux, listes ou sites spécifiques ().

Installe l’extension, va sur la page cible, clique sur l’icône Data Miner. Choisis une recette ou crée la tienne en sélectionnant les éléments. Idéal pour les tâches ponctuelles ou besoins rapides — par exemple, un commercial qui extrait une liste de prospects ou un responsable e-commerce qui copie les prix des concurrents.

Data Miner est simple, intégré au navigateur, parfait pour l’extraction interactive à la demande.

Simplescraper : extracteur web no-code pour résultats instantanés

Simplescraper porte bien son nom. C’est une extension Chrome no-code (et appli web) qui permet de sélectionner visuellement les données sur une page pour créer une « recette » d’extraction (). Tu peux suivre des liens pour extraire des sous-pages, gérer la pagination, et transformer ton extraction en API en un clic.

Là où Simplescraper brille, c’est sur ses options d’intégration : envoie les données direct vers Google Sheets, Airtable ou des outils comme Zapier (). Il propose aussi l’extraction cloud, la planification de tâches récurrentes, et une fonction « AI Enhance » pour nettoyer ou analyser tes données avec GPT.

Pour des résultats rapides et des intégrations faciles, Simplescraper est le couteau suisse de l’extraction web légère.

Instant Data Scraper : extraction express de tableaux et listes

Parfois, tu veux juste récupérer des données tout de suite, sans prise de tête. C’est là qu’Instant Data Scraper (IDS) entre en jeu. C’est une extension Chrome gratuite connue pour son extraction en un clic des données tabulaires (). Active l’extension, IDS détecte automatiquement les tableaux ou listes sur la page. Il gère aussi la pagination et le scroll infini en cliquant sur toutes les pages.

IDS est 100 % gratuit, sans inscription, sans code, sans attente. Parfait pour les besoins ponctuels ou urgents — un commercial qui extrait une liste de leads, un étudiant qui récupère des données de tableaux Wikipédia. Si IDS trouve tes données, tu les obtiens en quelques secondes.

ScrapeStorm : extracteur web cloud avec IA intégrée

ScrapeStorm est un outil d’extraction web boosté à l’IA qui combine une interface visuelle et de puissants algos IA (). Tu saisis une URL, et son IA identifie automatiquement les champs de données — listes, tableaux, boutons « page suivante », etc.

ScrapeStorm fonctionne sur toutes les plateformes (Windows, Mac, Linux) et propose extraction desktop ou cloud. Tu peux planifier des tâches, lancer plusieurs jobs en parallèle, et exporter en Excel, CSV, JSON, ou même vers une base de données (). Très apprécié pour l’e-commerce et les études de marché, il sait aussi extraire des données d’images ou de PDF grâce à l’IA.

Si tu cherches un assistant intelligent pour des projets d’extraction volumineux ou complexes, ScrapeStorm vaut le détour.

Apify : place de marché et plateforme d’automatisation pour l’extraction web

Apify, ce n’est pas juste un extracteur : c’est une plateforme d’extraction et d’automatisation web. Tu peux exécuter des « acteurs », des scripts pour extraire ou automatiser la navigation. Le vrai plus, c’est la place de marché d’acteurs prêts à l’emploi pour les tâches courantes (). Besoin d’extraire tous les avis d’un site e-commerce ? Il y a sûrement un acteur pour ça.

Pour les devs, Apify permet d’écrire ses propres extracteurs en Node.js ou Python et de les déployer dans le cloud. C’est scalable, automatisable, et intégrable via API. Apify est idéal pour les utilisateurs avancés et les boîtes qui font du web data un vrai atout stratégique — extraction continue à grande échelle, ou intégration dans tes pipelines de données.

ParseHub : extracteur visuel pour sites complexes

ParseHub est une appli desktop (avec options cloud) réputée pour gérer les sites dynamiques et complexes. Tu navigues sur le site dans une interface type navigateur, tu cliques sur les données à extraire, et ParseHub construit ton extracteur (). Il gère la logique conditionnelle, l’extraction imbriquée, le contenu AJAX, etc.

ParseHub, c’est souvent l’outil de la dernière chance quand les autres n’arrivent pas à extraire un site. Utilisé par des chercheurs, analystes ou PME pour s’attaquer à des sites coriaces. Il y a une courbe d’apprentissage, mais si tu as un site difficile à extraire sans coder, ParseHub est une valeur sûre.

OutWit Hub : extracteur web desktop pour archiver du contenu

OutWit Hub a un petit côté old school, mais c’est une appli desktop idéale pour récupérer et organiser différents types de contenus (liens, images, emails, etc.) (). Il fonctionne comme un navigateur couplé à un tableur : tu navigues sur une page, OutWit Hub extrait tableaux, listes, images, etc.

Super utile pour l’archivage ou la recherche de contenu — par exemple, extraire tous les posts d’un forum ou télécharger une collection de fichiers. C’est un outil local, donc tes données restent privées. OutWit Hub est parfait pour les petits à moyens projets d’extraction avec une interface desktop simple.

Quel extracteur web choisir selon tes besoins ?

Douze outils, mille usages. Alors, lequel choisir ? Voici mon aide-mémoire :

-

Pour les débutants ou les besoins ponctuels :

Teste Instant Data Scraper pour les tableaux et listes simples (gratuit et instantané). Data Miner est aussi super accessible, avec plein de modèles si tu extraies souvent des pages similaires.

-

Pour les non-techs qui veulent de l’automatisation ou des intégrations :

Thunderbit offre le workflow le plus simple grâce à l’IA — parfait pour les utilisateurs business qui veulent des résultats rapides et réguliers. Browse AI est top pour la surveillance continue et les alertes. Simplescraper est génial si tu veux envoyer les données extraites vers Google Sheets ou une appli interne via API.

-

Pour les sites complexes ou les workflows personnalisés sans code :

Prends un extracteur visuel comme Octoparse ou ParseHub. Octoparse est convivial et propose plein de modèles. ParseHub gère les sites dynamiques complexes et offre un contrôle précis. WebScraper.io est aussi très bien si tu es prêt à configurer tes propres sitemaps.

-

Pour les devs ou data engineers qui veulent passer à l’échelle :

ScraperAPI est fait pour intégrer l’extraction web dans tes logiciels ou projets à grande échelle. Apify est parfait si tu veux une plateforme scalable avec une marketplace de scripts prêts à l’emploi ou personnalisés.

-

Pour l’extraction de contenu en masse ou un usage hors ligne :

OutWit Hub est un bon choix pour collecter et archiver du contenu de façon systématique, surtout si tu préfères un outil desktop pour la confidentialité ou le contrôle.

En vrai, beaucoup d’équipes utilisent plusieurs outils selon la mission. Tu peux commencer avec Instant Data Scraper pour un besoin simple, passer à Thunderbit ou Octoparse pour un projet plus costaud, et utiliser ScraperAPI ou Apify pour industrialiser le process. Bonne nouvelle : la plupart de ces outils proposent une version gratuite ou d’essai, alors teste et vois ce qui te convient.

Conclusion : l’extraction web, l’atout business de 2025

Les extracteurs web ont bien évolué, et 2025 marque leur démocratisation. La grande tendance ? L’extraction web devient plus simple, plus automatisée et mieux intégrée aux workflows quotidiens (). Grâce à l’IA, même les sites dynamiques complexes deviennent accessibles sans compétences techniques. Comme le dit un data engineer : « Depuis l’arrivée des outils d’extraction web IA, je termine mes tâches bien plus vite et à plus grande échelle… avec l’IA, le nettoyage des données est inclus dans mon workflow. »

Autre évolution majeure : la frontière s’efface entre extraction, surveillance et automatisation. Des outils comme Browse AI et Thunderbit extraient les données, les mettent à jour et peuvent même agir (remplir des formulaires, déclencher des alertes). L’adoption explose : une grande plateforme a vu ses utilisateurs actifs mensuels bondir de plus de 140 % en un an (). Toutes les entreprises comprennent que l’accès aux données publiques (de façon éthique et légale) est crucial pour rester dans la course.

Pour les équipes business, le mot d’ordre c’est autonomie. Plus besoin d’attendre des semaines un dev ou de se fier à l’intuition. Les outils de cette liste mettent la puissance de la donnée web à portée de main, avec des interfaces et des fonctions pensées pour les usages concrets en vente, marketing, opérations, etc. Et vu la vitesse à laquelle ça évolue, on peut s’attendre à des interfaces encore plus intuitives, une IA plus futée et une intégration renforcée avec les plateformes BI et analytics.

Petit rappel : respecte les conditions d’utilisation des sites et les règles robots.txt, et assure-toi d’être en règle avec la législation sur la protection des données. L’éthique, c’est la clé pour que ces pratiques durent.

Que tu commences avec une extension gratuite ou que tu déploies une flotte d’extracteurs pro, c’est le moment idéal pour transformer l’info du web en insights concrets. La révolution des extracteurs web est lancée : choisis un outil, teste-le, et révèle la valeur cachée du web. Ton futur piloté par la donnée n’est qu’à un clic.

FAQ

1. C’est quoi un extracteur web et pourquoi c’est important pour les entreprises en 2025 ?

Un extracteur web, c’est un outil qui permet de collecter automatiquement des données structurées depuis des sites internet. En 2025, c’est indispensable car ça aide les entreprises à transformer l’info brute du web en insights exploitables — pour plus de productivité, de rentabilité et sans saisie manuelle.

2. Qui peut utiliser un extracteur web — faut-il être technique ?

Pas besoin d’être un pro du code pour beaucoup d’extracteurs modernes. Des outils comme Thunderbit, Browse AI ou Instant Data Scraper sont pensés pour les non-techs, avec des interfaces intuitives, de l’automatisation IA et des workflows sans code.

3. Quels bénéfices pour les équipes commerciales, marketing et opérations ?

Les commerciaux peuvent constituer des listes de prospects à partir d’annuaires en ligne, les marketeurs surveiller les prix des concurrents, et les opérations automatiser la collecte de données. Ces outils font gagner du temps, réduisent les erreurs et fournissent des infos fraîches et fiables pour la prise de décision.

4. Quels critères pour choisir un extracteur web ?

Les points clés : facilité d’utilisation, fonctions IA, automatisation/planification, intégration avec Google Sheets ou Airtable, capacité à gérer le volume, et adéquation avec ton cas d’usage (prospection, veille tarifaire, archivage de contenu, etc.).

5. Il existe des extracteurs web gratuits ou pas chers ?

Oui, beaucoup d’extracteurs proposent des versions gratuites ou des tarifs accessibles. Instant Data Scraper est totalement gratuit pour les besoins de base, tandis que Thunderbit, Simplescraper et Data Miner offrent des plans gratuits généreux avec des options de montée en gamme.

Envie d’en savoir plus sur l’extraction web, l’IA ou comment transformer les sites en avantage business ? Va voir le pour des guides, astuces et retours d’expérience sur l’automatisation des données.