Le web, c’est un vrai océan de données, et en 2026, la bataille pour transformer ce bazar en valeur business n’a jamais été aussi intense. J’ai vu des équipes commerciales, e-commerce ou opérationnelles complètement changer la donne en automatisant des tâches qui, avant, leur prenaient un temps fou. Franchement, si tu n’utilises pas encore un extracteur web, tu risques non seulement de te faire distancer, mais aussi de rester coincé à remplir des tableurs pendant que tes concurrents savourent déjà leur deuxième café.

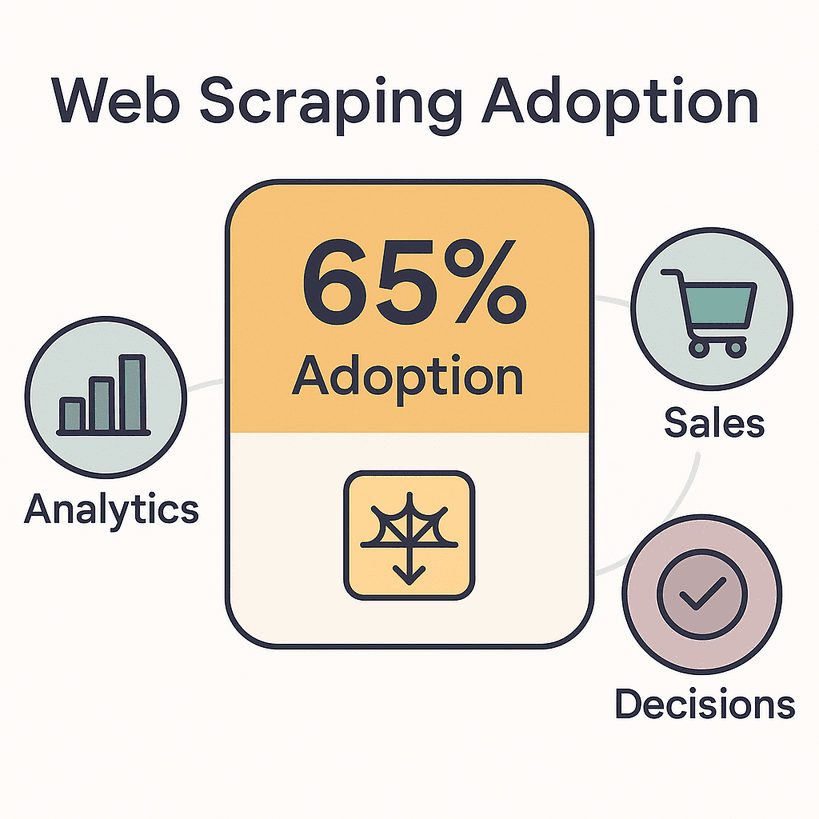

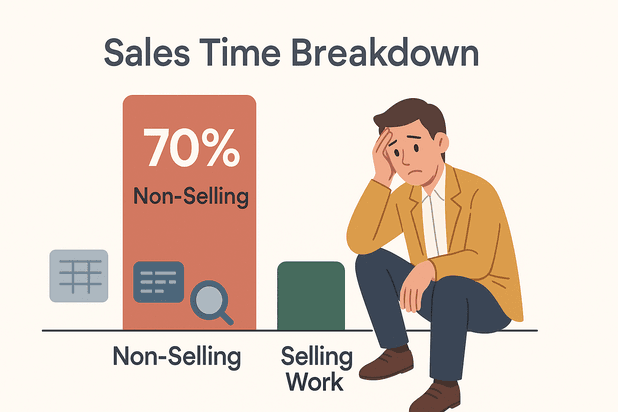

La réalité, c’est que pour booster leurs analyses, leurs ventes et leurs décisions. Le marché mondial de l’extraction de données web a déjà dépassé , et il va doubler d’ici 2030. Les commerciaux, eux, passent jusqu’à sur des tâches administratives comme la saisie ou la recherche de données. Tout ce temps pourrait servir à closer des deals… ou à profiter d’une vraie pause dej’.

Alors, c’est quoi le meilleur extracteur web en 2026 ? J’ai passé au crible cinq outils qui changent la vie, que tu sois débutant ou expert. Que tu cherches une solution sans code ou une plateforme ultra-flexible pour dev, tu vas trouver ton bonheur.

Qu’est-ce qui fait un bon extracteur web ?

Soyons honnêtes : tous les extracteurs web ne se valent pas. Les meilleurs extracteurs web en 2026 se démarquent par leur rapidité, leur fiabilité et leur accessibilité – même pour ceux qui n’ont jamais codé.

Voilà les critères qui comptent vraiment (surtout pour les pros) :

- Facilité d’utilisation : Est-ce qu’un non-tech peut lancer une extraction en quelques minutes ? Les interfaces sans code et boostées à l’IA sont devenues la norme.

- Polyvalence des sources : L’outil gère-t-il les pages web, les PDF, les images, et les contenus dynamiques (scroll infini, AJAX) ? Plus il sait faire, mieux c’est.

- Automatisation & planification : Peut-on programmer des extractions régulières, gérer la pagination et naviguer automatiquement sur les sous-pages ? L’automatisation, c’est la clé pour passer du mode « je surveille tout le temps » à « je lance et j’oublie ».

- Intégration & export : Export direct vers Excel, Google Sheets, Notion, Airtable ou via API ? Moins tu fais de copier-coller, plus ton équipe est efficace.

- Compétences techniques requises : Est-ce vraiment sans code, ou faut-il bidouiller des regex ? Les meilleurs outils conviennent autant aux débutants qu’aux experts.

- Scalabilité : L’outil tient-il la route sur des centaines ou milliers de pages ?

- Support & communauté : Une doc claire, un support réactif et une communauté active, c’est un vrai plus.

Ces critères, ce n’est pas du bonus : c’est ce qui fait la différence entre un outil qui te fait gagner des heures et un autre qui t’en fait perdre. En 2026, alors que , choisir le bon extracteur web, c’est un vrai avantage.

Allez, on passe au top 5.

Les 5 meilleurs extracteurs web en 2026

- pour une extraction multi-source, sans code et boostée par l’IA

- pour des pipelines de données intégrés à l’échelle entreprise

- pour une flexibilité maximale en open source

- pour une extraction visuelle, planifiée et sans code

- pour une extraction accessible à tous, en mode pointer-cliquer

1. Thunderbit : l’extracteur web le plus simple et puissant avec IA

est mon chouchou pour tous ceux qui veulent extraire des données web sans écrire une ligne de code. Oui, j’avoue, je ne suis pas 100 % objectif – j’ai bossé dessus. Mais laisse-moi t’expliquer : Thunderbit a été pensé pour les pros qui veulent des résultats, pas des galères.

Pourquoi Thunderbit sort du lot ?

- Suggestion de champs par IA : Clique sur « Suggestion IA » et l’IA de Thunderbit scanne la page, te propose les données à extraire et configure tout pour toi. Pas de sélecteurs, pas de modèles, pas de prise de tête.

- Extraction multi-source : Récupère des données sur des pages web, mais aussi dans des PDF et des images. Thunderbit extrait textes, liens, emails, numéros de téléphone et images en deux clics.

- Automatisation des sous-pages & pagination : Tu veux les détails de chaque fiche produit ou profil ? Thunderbit suit les liens, récupère les infos complémentaires et les fusionne dans ton tableau. Il gère aussi le scroll infini et la pagination sans effort.

- Extraction en lot & planifiée : Colle une liste d’URLs, programme des tâches récurrentes et laisse Thunderbit bosser pour toi – que ce soit pour surveiller les prix tous les jours ou mettre à jour tes leads chaque semaine.

- Export instantané : Export direct vers Excel, Google Sheets, Airtable, Notion, CSV ou JSON. Fini le copier-coller interminable.

- Prompts IA personnalisés : Tu veux catégoriser, traduire ou annoter tes données à la volée ? Ajoute une instruction personnalisée et l’IA de Thunderbit s’en occupe.

- Mode cloud ou navigateur : Lance tes extractions dans le cloud (jusqu’à 50 pages en même temps) ou en local pour les sites qui demandent une connexion.

Thunderbit, c’est déjà plus de , des équipes commerciales aux agences immo en passant par les e-commerçants indépendants. L’offre gratuite permet d’extraire jusqu’à 6 pages (ou 10 avec un boost d’essai), et tu ne paies que ce que tu consommes – un crédit par ligne de résultat.

Pourquoi je kiffe : Thunderbit, c’est le seul outil où un non-tech peut passer de « j’ai besoin de ces données » à « voilà mon tableau » en moins de cinq minutes. L’interface est vraiment intuitive (on y a mis tout notre cœur), et l’IA s’adapte aux changements de sites pour éviter de devoir tout réparer à chaque fois.

Parfait pour : Les équipes commerciales, e-commerce, opérations, et tous ceux qui veulent extraire des données sans code, avec l’IA et sans se prendre la tête avec la maintenance.

Retrouve plus de guides sur le .

2. Import.io : l’extracteur web pour les entreprises qui veulent tout intégrer

est la référence pour les grosses boîtes qui ont besoin de données web à grande échelle, directement branchées à leurs outils métiers.

Ce qui fait la différence avec Import.io :

- Pipelines prêts pour l’entreprise : Import.io, ce n’est pas juste un extracteur, c’est une vraie plateforme d’intégration de données web. Imagine un « data-as-a-service » avec des flux automatisés et continus.

- IA auto-réparatrice : Si un site change, l’IA d’Import.io essaie de réajuster les champs pour éviter que tes pipelines ne plantent du jour au lendemain.

- Automatisation avancée : Programme des extractions à l’heure, au jour ou comme tu veux. Reçois des alertes en cas de souci ou d’anomalie dans les données.

- Workflows interactifs : Gère les sites avec connexion, formulaires ou navigation complexe. Import.io peut enregistrer et rejouer des séquences avancées.

- Conformité & gouvernance : Détection automatique des données sensibles, masquage et logs d’audit – indispensable pour les secteurs réglementés.

- API & intégration : Alimente directement Google Sheets, Excel, Tableau, Power BI, tes bases de données ou applis via API.

Import.io est utilisé par des marques comme Unilever, Volvo ou RedHat. C’est la solution idéale pour la veille tarifaire sur des milliers de sites e-commerce, l’intelligence de marché ou l’alimentation de modèles IA/ML avec des données fraîches.

Tarifs : Import.io, c’est du premium, à partir de 299 $/mois pour les offres en libre-service. Il y a un essai gratuit, mais pas de formule gratuite sur le long terme. Si la donnée web est stratégique, l’investissement est vite rentabilisé.

Parfait pour : Les grandes entreprises et organisations data-driven qui veulent fiabilité, scalabilité, conformité et intégration avancée.

3. Scrapy : le framework open source pour les développeurs

est la référence open source pour les devs qui veulent une flexibilité et un contrôle total. Si tu codes en Python, Scrapy, c’est le couteau suisse de l’extraction web.

Pourquoi les devs adorent Scrapy :

- Personnalisation totale : Écris tes propres spiders (scripts) pour explorer, parser et traiter les données exactement comme tu veux. Gère les parcours multi-pages, la logique métier et le nettoyage avancé.

- Rapide et asynchrone : L’architecture de Scrapy est faite pour la vitesse et la montée en charge – tu peux extraire des centaines de pages par minute, voire des millions avec des crawlers distribués.

- Extensible : Gros écosystème de plugins et middlewares pour les proxys, navigateurs headless (Splash/Playwright), intégrations, etc.

- Gratuit & open source : Aucun coût de licence. Tu l’exécutes sur tes propres serveurs ou dans le cloud, et tu l’adaptes à tes besoins.

- Communauté active : Plus de 55 000 étoiles sur GitHub et une communauté énorme. Si tu as un souci, il y a de grandes chances que quelqu’un ait déjà trouvé la solution.

À savoir : Scrapy demande de bien maîtriser Python et d’être à l’aise en ligne de commande. Pas d’interface graphique ici – c’est du code pur. Mais pour les projets sur-mesure, la génération de données pour l’IA ou les extractions massives, c’est imbattable.

Parfait pour : Les boîtes avec des devs en interne, des pipelines de données personnalisés ou des besoins d’extraction complexes et à grande échelle.

4. Octoparse : l’extraction visuelle et sans code à portée de clic

est super apprécié des non-techs qui veulent une extraction puissante via une interface visuelle et intuitive.

Pourquoi Octoparse plaît autant :

- Créateur de workflows visuels : Clique sur les éléments dans le navigateur intégré, Octoparse détecte automatiquement les motifs. Pas de code, juste du point-and-click.

- Gestion des contenus dynamiques : Extrayez des sites AJAX, à scroll infini ou protégés par login. Simulez clics, scrolls et soumissions de formulaires.

- Extraction cloud & planification : Exécute tes tâches dans le cloud (plus rapide, en parallèle) et programme des extractions régulières pour des données toujours à jour.

- Modèles préconçus : Des centaines de modèles pour les sites populaires (Amazon, Twitter, Zillow, etc.) pour démarrer en un clic.

- Export & API : Télécharge les résultats en CSV, Excel, JSON ou récupère-les via API. Intégration possible avec Google Sheets ou tes bases de données.

Octoparse est souvent décrit comme « ultra simple, même pour les débutants ». L’offre gratuite est limitée, mais les formules payantes (dès 83 $/mois) débloquent le cloud, la planification et plus de rapidité.

Parfait pour : Les non-techs, marketeurs, chercheurs et petites équipes qui veulent collecter des données régulièrement sans coder.

5. ParseHub : l’extraction simple et intuitive pour le quotidien

est un autre favori sans code, surtout chez les petites boîtes et freelances qui veulent automatiser la collecte de données.

Ce qui fait la force de ParseHub :

- Simplicité pointer-cliquer : Sélectionne les données en cliquant sur les éléments dans la vue navigateur. Construis tes workflows visuellement, sans coder.

- Gestion des sites dynamiques & JS : Extrayez des pages riches en JavaScript, à scroll infini ou à navigation complexe.

- Exécution cloud & locale : Lance tes extractions sur ton ordi ou dans le cloud. Programme des tâches récurrentes et accède aux résultats via API (sur les offres avancées).

- Options d’export : Télécharge les données en CSV, Excel ou JSON. Accès API pour automatiser tes flux.

- Multi-plateforme : Disponible sur Windows, Mac et Linux.

Le plan gratuit de ParseHub est limité (200 pages par extraction), mais les offres payantes (dès 189 $/mois) offrent plus de puissance, de rapidité et l’accès à l’API.

Parfait pour : Les petites boîtes, freelances et équipes avec des besoins d’extraction simples qui veulent un outil fiable et visuel.

Tableau comparatif : les meilleurs extracteurs web en un clin d’œil

| Outil | Facilité d’utilisation | Sources de données | Automatisation & planification | Intégration & export | Compétence technique | Tarification |

|---|---|---|---|---|---|---|

| Thunderbit | Sans code, piloté par IA | Web, PDF, Images | Sous-pages, pagination, planification, batch | Excel, Sheets, Notion, Airtable, CSV, JSON | Aucune | Freemium (paiement par ligne) |

| Import.io | Interface pointer-cliquer | Web (statique/dynamique, login) | Auto-réparation, planification, alertes | API, outils BI, Sheets, Excel, DB | Faible–Moyen | 299 $+/mois |

| Scrapy | Code requis | Web, APIs, (JS via plugins) | Automatisation complète via code | Tout (via code) | Développeurs Python | Gratuit (open source) |

| Octoparse | Visuel, sans code | Web (dynamique, login) | Planification cloud, modèles | CSV, Excel, JSON, API | Aucune | 83 $+/mois |

| ParseHub | Visuel, sans code | Web (JS, dynamique) | Cloud/local, planifié | CSV, Excel, JSON, API | Aucune | 189 $+/mois |

Comment choisir le bon extracteur web pour ta boîte

Tu hésites encore ? Voici mon pense-bête :

- Non-techs, besoin de résultats rapides : Va sur ou . Thunderbit est imbattable pour l’extraction instantanée, boostée par IA et multi-source (web, PDF, images). Octoparse est top pour les extractions visuelles et planifiées.

- Intégration, conformité et scalabilité pour l’entreprise : est fait pour toi. C’est la référence pour des pipelines de données fiables et intégrés.

- Développeurs, projets sur-mesure ou extractions massives : est la solution. Il faut maîtriser Python, mais la flexibilité est totale.

- Petites boîtes, freelances ou tâches quotidiennes : est un choix simple et efficace pour l’extraction visuelle et l’automatisation modérée.

Quelques conseils pour bien choisir :

- Prends un outil adapté aux compétences techniques et aux besoins de ton équipe.

- Évalue la complexité des sites à extraire (contenu dynamique ? login ?).

- Pense à l’utilisation des données – export direct vers Sheets ou intégration API avancée ?

- Teste avec un essai gratuit ou une offre freemium sur des cas concrets.

- Ne néglige pas l’importance d’un bon support et d’une doc claire.

Conclusion : Passe à la vitesse supérieure avec les meilleurs extracteurs web

Les données web, c’est le carburant des décisions stratégiques en 2026. Le bon extracteur web peut te faire gagner un temps fou, réduire les erreurs et donner un vrai coup de boost à ton équipe – que ce soit pour faire des listes de prospects, surveiller la concurrence ou nourrir tes analyses.

En résumé :

- Thunderbit est l’extracteur sans code le plus simple et puissant, boosté par l’IA, pour les pros.

- Import.io est la solution entreprise pour des pipelines de données intégrés et continus.

- Scrapy est l’outil open source pour les devs qui veulent tout personnaliser.

- Octoparse et ParseHub rendent l’extraction visuelle et sans code accessible à tous.

La plupart de ces outils proposent des essais gratuits ou des offres freemium – teste-les ! Automatise les tâches répétitives, découvre de nouveaux insights et concentre-toi sur l’essentiel.

Bonne extraction – que tes données soient toujours fraîches, bien rangées et prêtes à l’emploi.

FAQ

1. À quoi sert un extracteur web ?

Un extracteur web automatise la collecte d’infos sur les sites web, les PDF et les images. Il sert à générer des leads, faire de la veille tarifaire, des études de marché, de l’agrégation de contenus, etc.

2. L’extraction de données web, c’est légal ?

L’extraction de données web est légale si tu restes sur des données publiques et que tu respectes les conditions d’utilisation et la législation sur la vie privée. Vérifie toujours les règles du site et utilise les données de façon responsable.

3. Faut-il savoir coder pour utiliser un extracteur web ?

Pas forcément ! Des outils comme Thunderbit, Octoparse ou ParseHub sont pensés pour les non-codeurs. Pour des projets plus costauds, des solutions pour devs comme Scrapy peuvent être nécessaires.

4. Comment exporter les données extraites vers Excel ou Google Sheets ?

La plupart des extracteurs modernes (Thunderbit, Octoparse, ParseHub) proposent l’export en un clic vers Excel, Google Sheets, CSV, ou même l’intégration directe avec Notion et Airtable.

5. Les extracteurs web gèrent-ils les sites dynamiques ou avec connexion ?

Oui – les meilleurs outils comme Import.io, Octoparse et ParseHub gèrent les contenus dynamiques (AJAX, scroll infini) et les sites protégés par login. Thunderbit prend aussi en charge l’extraction sur des pages dynamiques et des sous-pages.

Tu veux voir à quoi ressemble l’extraction web moderne ? ou va faire un tour sur le pour plus d’astuces, de tutos et de décryptages sur l’extraction de données boostée par l’IA.