En 2025, le web est devenu un vrai terrain de jeu pour les robots : près de n’est même plus généré par des humains. Les systèmes anti-bots se sont donc sérieusement renforcés pour contrer ces flux automatisés. Après des années à bidouiller des outils d’automatisation et des workflows de scraping, je peux te garantir qu’une simple erreur – comme choisir le mauvais user agent – peut faire capoter tout un projet de collecte de données. Pour les équipes commerciales, e-commerce ou opérationnelles, se faire bloquer par un site, ce n’est pas juste un contretemps : ça peut vouloir dire des opportunités ratées, des prix qui ne sont plus à jour ou carrément une perte de chiffre d’affaires.

La bonne nouvelle ? Pas besoin d’être un crack en technique pour contourner ces obstacles. Dans ce guide, je t’explique pourquoi la stratégie de user agent est devenue incontournable pour le scraping, comment éviter les pièges classiques, et comment rend la gestion des user agents tellement simple qu’on n’y pense même plus. Que tu veuilles générer des leads, surveiller des produits ou juste garder tes tableaux à jour, ce guide va t’aider à garder une longueur d’avance.

Pourquoi le Choix du User Agent est Vital pour le Scraping

On commence par la base : c’est quoi un user agent ? C’est un peu la « carte d’identité » de ton navigateur. À chaque fois que tu visites un site – que tu sois humain ou robot – ton navigateur envoie une chaîne User-Agent dans les en-têtes de la requête. C’est une petite présentation du style « Salut, je suis Chrome sur Windows » ou « Je suis Safari sur iPhone » (). Voilà à quoi ressemble un user agent typique de Chrome :

1Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36Les sites web utilisent cette info pour deux raisons principales :

- Adapter le contenu affiché (version mobile ou desktop, par exemple).

- Détecter les bots et extracteurs web.

Si ton user agent affiche « python-requests/2.28.1 » ou « Scrapy/2.9.0 », c’est comme si tu portais un badge « Salut, je suis un robot ! ». Les sites gardent des listes noires de ces identifiants trop évidents et te bloqueront direct. À l’inverse, utiliser un user agent de navigateur courant et à jour te permet de passer sous le radar.

En résumé : ton user agent, c’est ton déguisement. Plus il est crédible, plus tu as de chances de récupérer les données que tu veux.

Le Rôle du User Agent dans la Réussite du Scraping

Pourquoi le choix du user agent est-il si décisif ? Parce que c’est la première barrière pour la plupart des systèmes anti-bots. Voilà ce qui peut mal tourner si tu te plantes :

- Blocage immédiat (erreurs 403/429) : Si tu utilises un user agent par défaut d’une bibliothèque de scraping, tu seras bloqué avant même d’avoir vu la page d’accueil ().

- Données vides ou bidons : Certains sites renvoient des pages blanches ou de fausses infos aux user agents suspects.

- CAPTCHAs ou redirections : Un user agent « robot » déclenche des tests « T’es humain ou pas ? » ou des boucles de connexion sans fin.

- Ralentissements ou bannissements : Si tu envoies trop de requêtes avec le même user agent, tu risques d’être ralenti ou banni par IP.

Regarde comment différents user agents sont traités :

| Chaîne User Agent | Comportement sur la plupart des sites (2025) |

|---|---|

python-requests/2.28.1 | Blocage immédiat, identifié comme bot |

Scrapy/2.9.0 (+https://scrapy.org) | Bloqué ou données factices renvoyées |

Mozilla/5.0 (Windows NT 10.0; Win64; x64)... | Considéré comme un vrai utilisateur, accès autorisé |

AhrefsBot/7.0 (+http://ahrefs.com/robot/) | Bloqué, crawler connu |

| User agent vide ou incohérent | Parfois accepté, souvent suspect |

La leçon à retenir ? Soigne ton déguisement. Et n’oublie pas : les systèmes anti-bots d’aujourd’hui ne se contentent plus de vérifier le user agent. Ils regardent aussi si les autres en-têtes (Accept-Language, Referer, etc.) sont cohérents. Si tu prétends être Chrome mais que tes en-têtes ne suivent pas, tu seras quand même grillé ().

C’est là que Thunderbit fait la différence. J’ai croisé pas mal de pros – commerciaux, e-commerçants, agents immobiliers – qui veulent juste accéder aux données, sans se prendre la tête avec la technique des en-têtes HTTP. Thunderbit a donc été pensé pour rendre la gestion des user agents totalement invisible et automatisée.

Thunderbit : La Gestion des User Agents Sans Prise de Tête

Avec le , tu n’as même pas à te soucier du choix du user agent. Notre moteur IA s’en occupe pour toi, en sélectionnant la signature de navigateur la plus crédible et à jour pour chaque site. Que tu utilises l’ (qui utilise le vrai user agent de Chrome) ou le scraping cloud (où notre IA fait tourner un pool de user agents récents), tu te fonds toujours dans la masse du trafic normal.

Et ce n’est pas qu’une question de user agent. Thunderbit envoie tout un ensemble d’en-têtes cohérents – Accept-Language, Accept-Encoding, Client Hints, etc. – pour que tes requêtes ressemblent à celles d’un vrai navigateur. Fini les en-têtes bizarres ou les signaux d’alerte « bot ».

Le top ? Tu n’as rien à configurer. L’IA de Thunderbit gère tout le côté technique en coulisses, pour que tu puisses te concentrer sur l’essentiel : obtenir des données fiables et de qualité.

Pourquoi la Rotation Dynamique des User Agents est Incontournable

Tu as trouvé le user agent parfait ? Ne l’utilise surtout pas pour toutes tes requêtes ! En 2025, répéter le même user agent, c’est le meilleur moyen de se faire repérer. Les vrais utilisateurs ont des navigateurs, des versions et des appareils différents. Si ton extracteur web envoie 500 requêtes d’affilée avec le même user agent, c’est comme faire défiler une armée de clones – impossible de passer inaperçu.

C’est pour ça que la rotation dynamique des user agents est devenue la règle. Le principe : alterner entre plusieurs user agents crédibles et à jour à chaque requête ou session. Ton extracteur web ressemble alors à un groupe d’utilisateurs réels, pas à un script automatisé ().

La rotation intelligente de Thunderbit va encore plus loin. Pour les extractions multi-pages ou planifiées, Thunderbit alterne automatiquement les user agents et les adresses IP proxy. Si un site devient suspicieux, Thunderbit s’adapte en temps réel : il change de user agent, ajuste les en-têtes ou ralentit le rythme si besoin. Tout ça se fait en arrière-plan, pour un scraping discret et des données qui continuent d’arriver.

User Agent et En-têtes de Requête : La Cohérence Avant Tout

Petit conseil de pro : le user agent n’est qu’un élément de l’« empreinte » de ta requête. Les systèmes anti-bots modernes vérifient la cohérence entre le user agent et d’autres en-têtes comme Accept-Language, Accept-Encoding ou Referer. Si tu prétends être Chrome sur Windows mais que tu envoies un Accept-Language en français depuis une IP new-yorkaise, c’est louche ().

Bonnes pratiques :

- Envoie toujours un ensemble complet d’en-têtes cohérents avec ton user agent.

- Fais correspondre Accept-Language et Accept-Encoding à ton user agent et, si possible, à la géolocalisation de ton IP.

- Utilise les outils développeur du navigateur pour observer les requêtes réelles et reproduire l’ensemble des en-têtes.

Thunderbit s’occupe de tout ça pour toi. Notre IA garantit que chaque requête est parfaitement cohérente – user agent, en-têtes, et même l’empreinte du navigateur. Tu obtiens un profil de requête indiscernable d’un humain, sans effort.

Les Pièges à Éviter : Les Erreurs Classiques avec les User Agents

J’ai vu pas mal de projets de scraping partir en vrille pour les mêmes raisons. Voici les erreurs à éviter absolument :

- Utiliser les user agents par défaut des bibliothèques de scraping : Les chaînes comme

python-requests/2.x,Scrapy/2.9.0ouJava/1.8sont bloquées direct. - Versions de navigateur dépassées : Se faire passer pour Chrome 85 en 2025 ? Très suspect. Utilise toujours des versions récentes.

- En-têtes incohérents : N’envoie pas un user agent Chrome avec des en-têtes Accept-Language ou Accept-Encoding manquants ou bizarres.

- User agents de crawlers connus : Tout ce qui contient « bot », « crawler », « spider » ou le nom d’un outil (genre AhrefsBot) est suspect.

- User agents vides ou incompréhensibles : Parfois acceptés, mais souvent considérés comme suspects et peu fiables.

Checklist pour des user agents au top :

- Utilise des user agents de navigateurs réels et à jour (Chrome, Firefox, Safari).

- Fais tourner un pool de user agents.

- Garde les en-têtes cohérents avec le user agent.

- Mets à jour ta liste de user agents chaque mois (les navigateurs évoluent vite).

- Évite tout ce qui sent l’automatisation.

Thunderbit en Action : Cas d’Usage pour les Équipes Commerciales et Opérationnelles

Passons au concret. Voilà comment la gestion des user agents par Thunderbit aide les équipes au quotidien :

| Cas d’usage | Avant : Scraping manuel | Avec Thunderbit | Résultat |

|---|---|---|---|

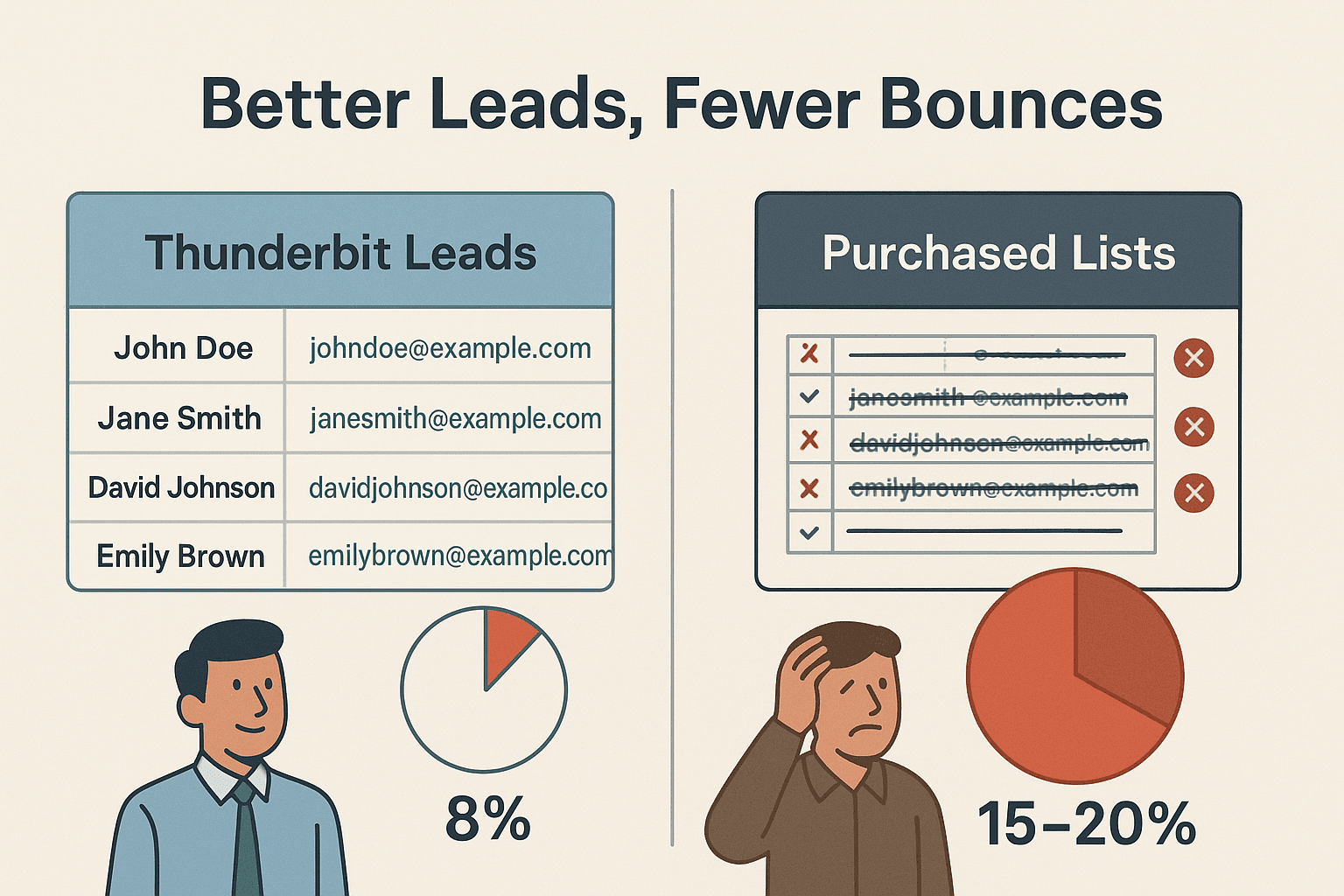

| Génération de leads | Blocages fréquents, données manquantes | L’IA choisit le meilleur user agent, rotation automatique | Plus de leads, meilleure qualité, moins de rebonds |

| Veille e-commerce | Scripts instables, IP bannies | Scraping cloud avec rotation dynamique des user agents & proxys | Suivi fiable des prix et stocks |

| Annonces immobilières | Ajustements fastidieux, blocages | L’IA adapte user agent/en-têtes, gère les sous-pages automatiquement | Listes complètes et à jour |

Une équipe commerciale qui utilise Thunderbit a extrait des leads sur des milliers de sites et n’a eu qu’environ 8 % de taux de rebond email – contre 15 à 20 % avec des listes achetées (). C’est la force d’un scraping frais et indétectable.

Tutoriel : Scraper avec le Meilleur User Agent grâce à Thunderbit

Voilà à quel point c’est simple de démarrer avec Thunderbit – pas besoin d’être un as du code :

- Installe l’.

- Va sur le site cible. Connecte-toi si besoin – Thunderbit fonctionne aussi sur les pages protégées.

- Clique sur « Suggestion IA de champs ». L’IA de Thunderbit analyse la page et propose les colonnes à extraire.

- Ajuste les champs si besoin. Renomme, ajoute ou supprime des colonnes selon tes besoins.

- Clique sur « Extraire ». Thunderbit collecte les données, en faisant tourner user agents et en-têtes en arrière-plan.

- Exporte tes données. Envoie-les direct vers Excel, Google Sheets, Airtable, Notion, ou télécharge-les en CSV/JSON.

Aucune gestion de user agent à prévoir – l’IA de Thunderbit s’occupe de tout, en s’adaptant à chaque site pour maximiser tes chances de succès.

Thunderbit vs Gestion Manuelle des User Agents : Le Duel

Voyons comment Thunderbit se compare à la méthode manuelle classique :

| Fonctionnalité/Tâche | Scraping manuel | Approche Thunderbit |

|---|---|---|

| Configuration du user agent | Recherche & codage | Automatique, IA choisit pour chaque site |

| Mise à jour des user agents | Manuel, facile à oublier | IA met à jour selon les tendances navigateurs |

| Rotation des user agents | Logique de rotation à coder | Rotation intelligente intégrée |

| Cohérence des en-têtes | En-têtes à adapter manuellement | IA garantit un ensemble cohérent |

| Gestion des blocages/CAPTCHAs | Changement manuel, maintenance lourde | IA adapte, réessaie et fait tourner si besoin |

| Compétence technique requise | Élevée (code, HTTP) | Aucune – pensé pour les pros non techniques |

| Temps passé à déboguer | Fréquent, frustrant | Minimal – concentre-toi sur la donnée, pas sur la technique |

Thunderbit est pensé pour tous ceux qui veulent un scraping fiable et évolutif – sans se prendre la tête avec la technique.

À Retenir : Construire une Stratégie User Agent Prête pour Demain

Voici ce que j’ai appris (parfois à mes dépens) sur la gestion des user agents en 2025 :

- N’utilise jamais de user agents par défaut ou dépassés. C’est la première cause de blocage.

- Fais tourner tes user agents dynamiquement. La diversité, c’est la clé – évite l’effet « armée de robots ».

- Garde des en-têtes cohérents et réalistes. Un user agent n’est crédible que si tout le reste suit.

- Reste à jour. Les navigateurs évoluent vite, ta liste de user agents aussi.

- Laisse l’IA gérer la complexité. Des outils comme Thunderbit intègrent les meilleures pratiques, pour que tu puisses te concentrer sur les résultats.

Marre des blocages, des scripts à déboguer ou envie de scraper comme un pro sans prise de tête ? . Notre extracteur web IA est adopté par des milliers d’utilisateurs dans le monde et rend la donnée web accessible à tous – sans migraine technique.

Pour plus d’astuces, de tutos et d’analyses sur le scraping, va jeter un œil au .

FAQ

1. Qu’est-ce qu’un user agent et pourquoi est-il important pour le scraping ?

Un user agent est une chaîne envoyée à chaque requête web qui identifie ton navigateur et système d’exploitation. Les sites s’en servent pour adapter le contenu et repérer les bots. Un bon user agent permet à ton extracteur web de passer inaperçu et d’éviter les blocages.

2. Pourquoi ne pas utiliser le user agent par défaut de ma bibliothèque de scraping ?

Les user agents par défaut comme python-requests/2.x sont des signatures de bots bien connues et sont souvent bloqués direct. Utilise toujours des user agents de navigateurs récents et crédibles.

3. Comment Thunderbit gère-t-il la rotation des user agents ?

L’IA de Thunderbit fait tourner automatiquement un pool de user agents de navigateurs actuels et réalistes à chaque requête ou session. Ton scraping ressemble ainsi à un trafic humain varié.

4. Dois-je configurer manuellement les en-têtes comme Accept-Language ou Referer avec Thunderbit ?

Non ! L’IA de Thunderbit veille à ce que tous les en-têtes soient cohérents et adaptés à ton user agent, pour des requêtes indiscernables de celles d’un vrai navigateur.

5. Que se passe-t-il si un site bloque quand même mes requêtes ?

Thunderbit détecte les blocages ou CAPTCHAs et s’adapte en temps réel : il change de user agent, ajuste les en-têtes ou réessaie si besoin. Tu obtiens des données fiables sans avoir à intervenir.

Prêt à scraper plus intelligemment ? et laisse notre IA gérer le jeu du chat et de la souris des user agents pour toi. Bon scraping !

Pour aller plus loin