Le web, c’est une vraie mine d’or d’infos – et si tu bosses dans la vente, le marketing ou l’opérationnel, tu sais à quel point avoir la bonne donnée au bon moment peut tout changer. Mais franchement, qui a envie de passer ses journées à faire du copier-coller de sites web dans des tableurs ? J’ai vu des équipes perdre des dizaines d’heures chaque mois à « extraire des données » à la main, pour finir avec des listes dépassées et pleines d’erreurs. Heureusement, les outils de screen scraping nouvelle génération ont tout changé : aujourd’hui, tout le monde – pas seulement les développeurs – peut collecter, organiser et exploiter des données web en quelques minutes, au lieu d’y passer des jours entiers.

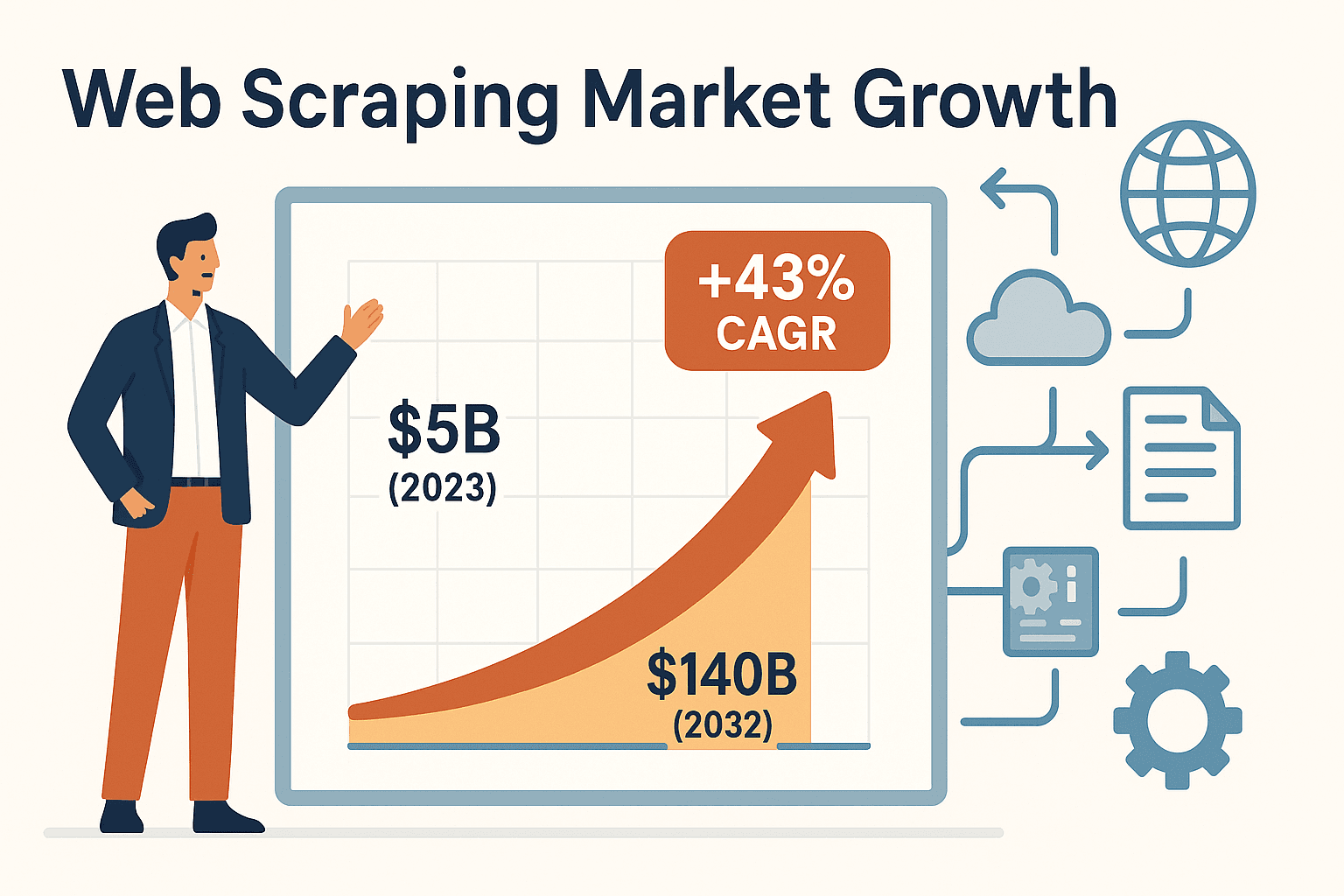

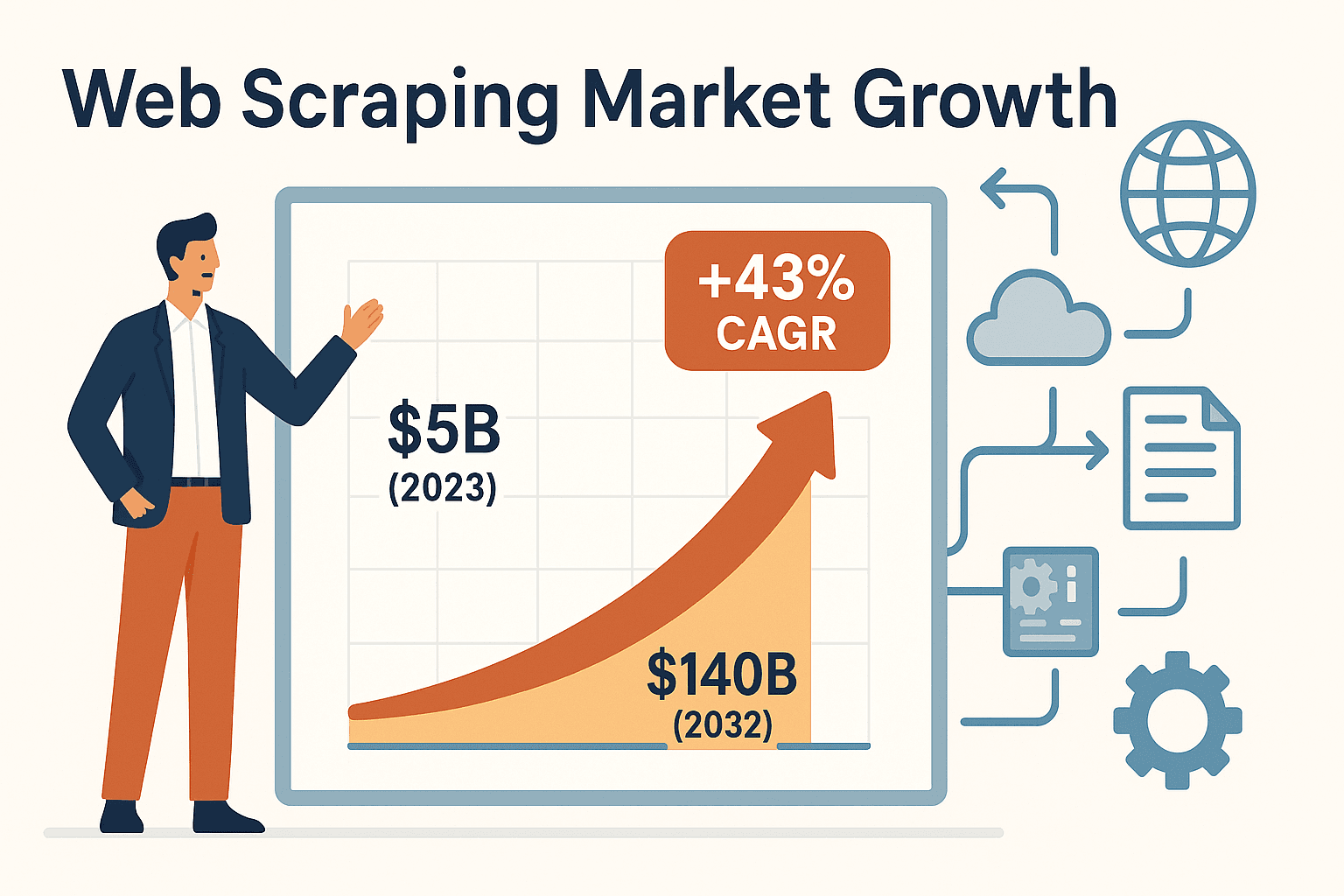

La demande pour les outils de screen scraping explose littéralement. Le marché mondial du web scraping était estimé à , avec une croissance annuelle de 43%. Pourquoi ? Parce que les boîtes ont compris que l’automatisation, ce n’est plus un bonus, c’est vital pour rester dans la course. Que tu veuilles monter des listes de prospects, surveiller tes concurrents ou suivre les annonces immobilières, le bon outil peut te faire gagner 30 à 40% de temps sur la collecte de données et réduire tes coûts d’acquisition jusqu’à 40% ().

On va voir ensemble les six meilleurs outils de screen scraping pour collecter des données efficacement en 2025. Je t’explique ce qui rend chaque solution unique, à qui elle s’adresse, et comment choisir celle qui collera le mieux à ton équipe – que tu sois débutant ou développeur aguerri.

Pourquoi les outils de screen scraping sont devenus incontournables

Si tu as déjà essayé de tenir à jour une liste de prospects ou de surveiller les prix de la concurrence à la main, tu sais à quel point c’est galère. La collecte manuelle de données, c’est lent, pénible et source d’erreurs. Pour les pros non techniques – commerciaux, marketeurs, agents immobiliers, analystes – les outils de screen scraping sont un vrai sauveur. Ils automatisent tout le boulot répétitif de copier-coller, transformant des heures de taf en une simple action.

Voilà comment ces outils changent la donne au quotidien :

- Génération de leads : Récupère en un clin d’œil des centaines de contacts depuis des annuaires ou les réseaux sociaux, pour que tes commerciaux passent plus de temps à vendre et moins à copier.

- Veille concurrentielle : Programme des extractions automatiques sur les sites concurrents pour avoir des listes de prix à jour ou repérer les nouveaux produits. Des enseignes comme John Lewis ont vu leurs ventes grimper de grâce au scraping de prix.

- Collecte de données immobilières : Récupère en quelques secondes les annonces de sites comme Zillow pour garder ton portefeuille et tes prospects à jour.

- Automatisation des workflows : Exporte les données extraites direct dans Excel, Google Sheets, Airtable ou Notion, et automatise même le remplissage de formulaires ou d’autres applis.

En bref ? Les outils de screen scraping permettent aux équipes métier d’accéder aux données web et d’agir sans dépendre de l’IT. Résultat : des décisions plus rapides, des infos toutes fraîches, et un vrai avantage sur la concurrence.

Comment choisir le bon outil de screen scraping

Avec toutes les options qui existent, choisir le bon outil, c’est un peu comme choisir une voiture : tu veux de la performance, de la simplicité ou de la fiabilité ? Voici une petite checklist pour t’aider à faire le bon choix :

- Facilité d’utilisation : Tu préfères un outil sans code, ou tu es à l’aise avec les scripts ?

- Personnalisation : Tu dois gérer des sites complexes, des connexions ou du contenu dynamique (scroll infini) ?

- Types de données pris en charge : Tu veux extraire du texte, des images, des PDF, ou autre chose ?

- Scalabilité : Tu bosses sur quelques pages ou des milliers chaque jour ?

- Options d’export : Tu peux facilement envoyer les données vers Excel, Google Sheets ou ton CRM ?

- Tarification : C’est quoi ton budget ? Tu veux du gratuit ou tu es prêt à investir dans l’automatisation ?

- Support & maintenance : Tu veux un service clé en main ou tu es prêt à gérer la technique ?

Garde ces critères en tête pendant qu’on passe en revue les six outils stars. Et souviens-toi : le meilleur outil, c’est celui que ton équipe va vraiment utiliser.

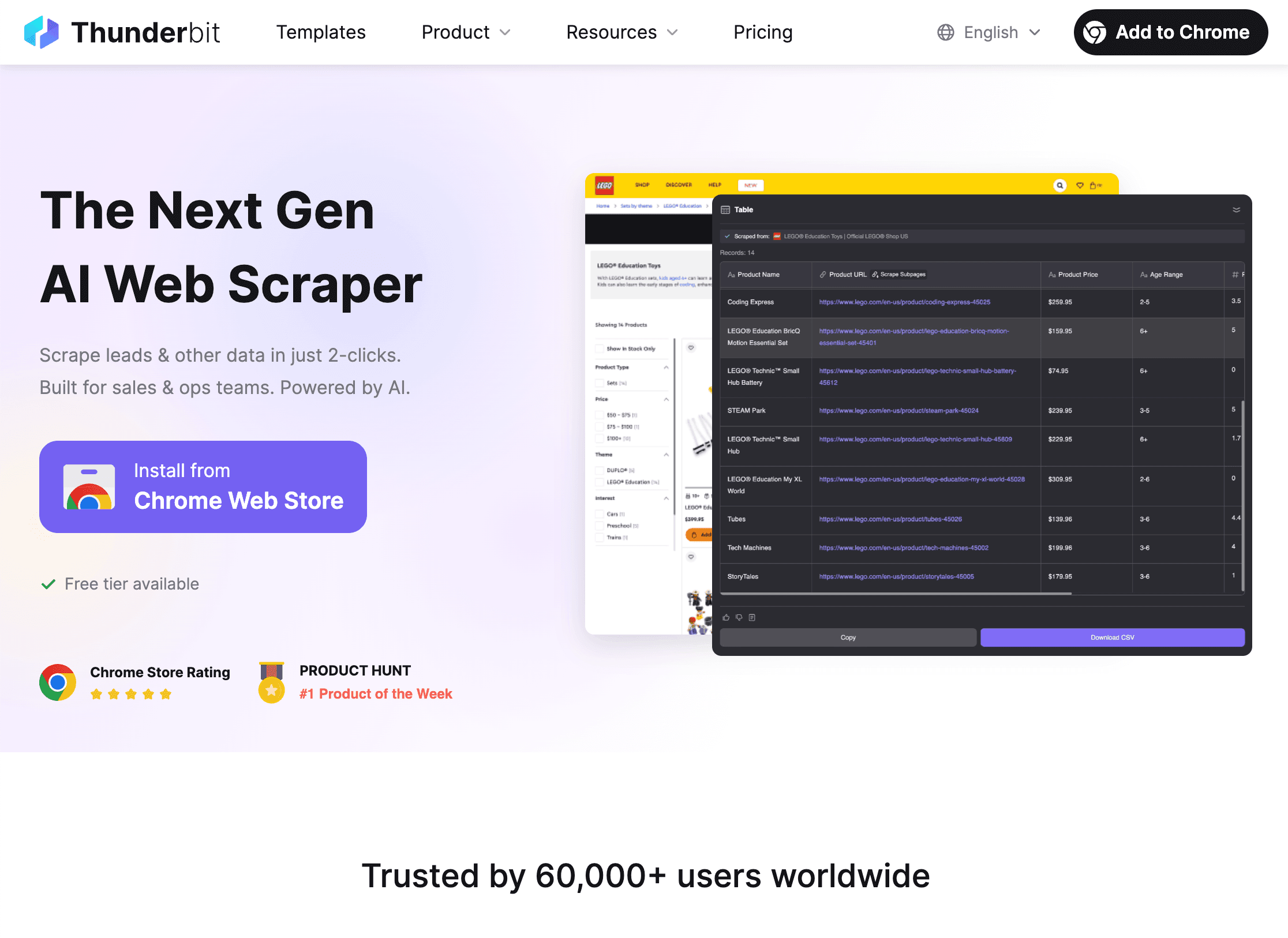

1. Thunderbit

est mon chouchou pour les équipes non techniques qui veulent collecter des données web vite fait – sans code, sans modèles compliqués, sans prise de tête. En tant que cofondateur et CEO, je ne suis peut-être pas objectif, mais j’ai créé Thunderbit pour simplifier la vie des utilisateurs métier face aux outils trop techniques.

Ce qui fait la force de Thunderbit ? Sa simplicité et sa puissance :

- Suggestion de champs par IA : Clique sur « Suggérer des champs IA » et l’IA de Thunderbit analyse la page, propose les meilleures colonnes (noms, prix, emails…) et configure même les types de données.

- Extraction en deux clics : Va sur n’importe quel site, clique sur « Extraire », et Thunderbit fait tout le boulot – pas de configuration, pas de sélecteurs, zéro galère.

- Extraction de sous-pages & pagination : Besoin de récupérer des détails sur des sous-pages (fiches produits, profils LinkedIn…) ? Thunderbit visite chaque sous-page et enrichit ton tableau automatiquement. Il gère aussi la pagination, même le scroll infini.

- Modèles instantanés : Pour les sites populaires comme Amazon, Zillow ou Instagram, Thunderbit propose des modèles prêts à l’emploi – tu entres ta requête et tu exportes les données.

- Export gratuit : Exporte tes résultats vers Excel, Google Sheets, Airtable ou Notion – gratuitement.

- Fonctionnalités avancées : Extrais des données de PDF, d’images, ou même automatise le remplissage de formulaires avec l’Auto-remplissage IA (aussi gratuit). Programme des extractions automatiques avec des instructions en langage naturel.

- Tarification : Thunderbit fonctionne avec un système de crédits – jusqu’à 6 pages gratuites (ou 10 avec le boost d’essai). Les offres payantes commencent à seulement 15 $/mois (ou 9 $/mois en annuel) pour 500 lignes, accessible à toutes les tailles d’équipe.

Thunderbit est déjà adopté par plus de , des équipes commerciales aux agents immobiliers en passant par les e-commerçants. Le retour qui revient le plus ? « Je n’imaginais pas gagner autant de temps – je passais des heures à copier des leads, maintenant c’est fait en quelques minutes. » Pour tester par toi-même, et lance-toi.

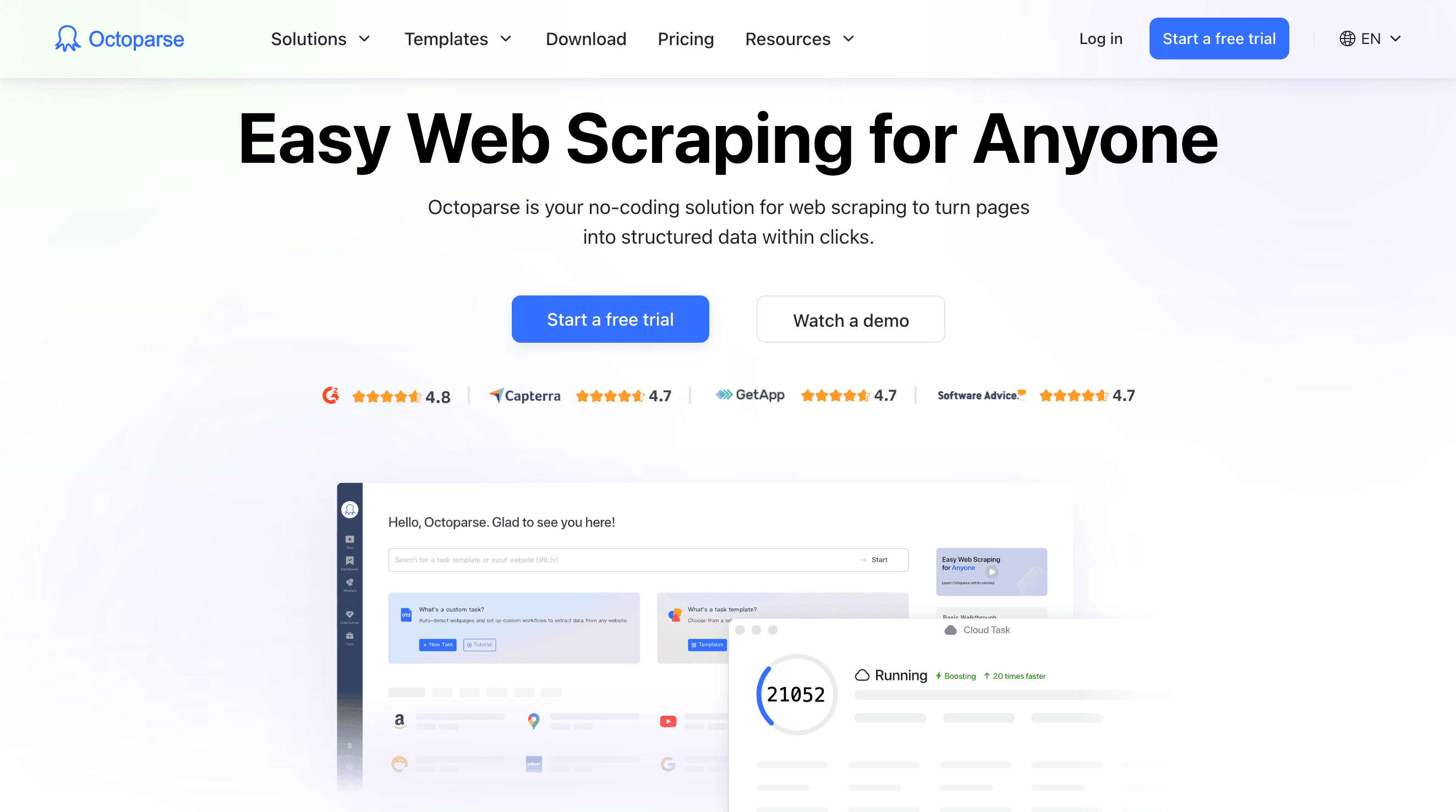

2. Octoparse

est un mastodonte du scraping sans code, avec une interface visuelle en glisser-déposer pour créer des workflows d’extraction sur mesure. Si tu es un utilisateur avancé qui doit gérer des sites complexes – connexions, AJAX, scroll infini, navigation multi-étapes – Octoparse te donne tous les outils, sans écrire une ligne de code.

Les points forts :

- Designer de workflow visuel : Parcours une page exemple, Octoparse détecte les éléments similaires et t’aide à construire ton extraction étape par étape.

- Gestion du contenu dynamique : Prend en charge les sites riches en JavaScript, le scroll infini et les pages protégées par login.

- Scraping cloud : Lance tes tâches dans le cloud (ton ordi peut rester éteint), programme des extractions et traite de gros volumes 24/7.

- Bibliothèque de modèles : Plus de 100 modèles prêts à l’emploi pour des sites comme Amazon, LinkedIn ou Twitter.

- Options d’export : Télécharge les résultats en CSV, Excel ou JSON, ou envoie-les direct dans ta base de données.

- Tarification : Version gratuite limitée ; offres payantes à partir de 75 $/mois pour le plan Standard, avec des options avancées pour plus de puissance.

Octoparse est parfait pour les analystes, chercheurs et PME qui veulent un scraping solide, sans code, à échelle moyenne. Il y a une petite courbe d’apprentissage pour les workflows avancés, mais l’interface visuelle et la doc complète rendent la prise en main assez simple pour ceux qui aiment bidouiller.

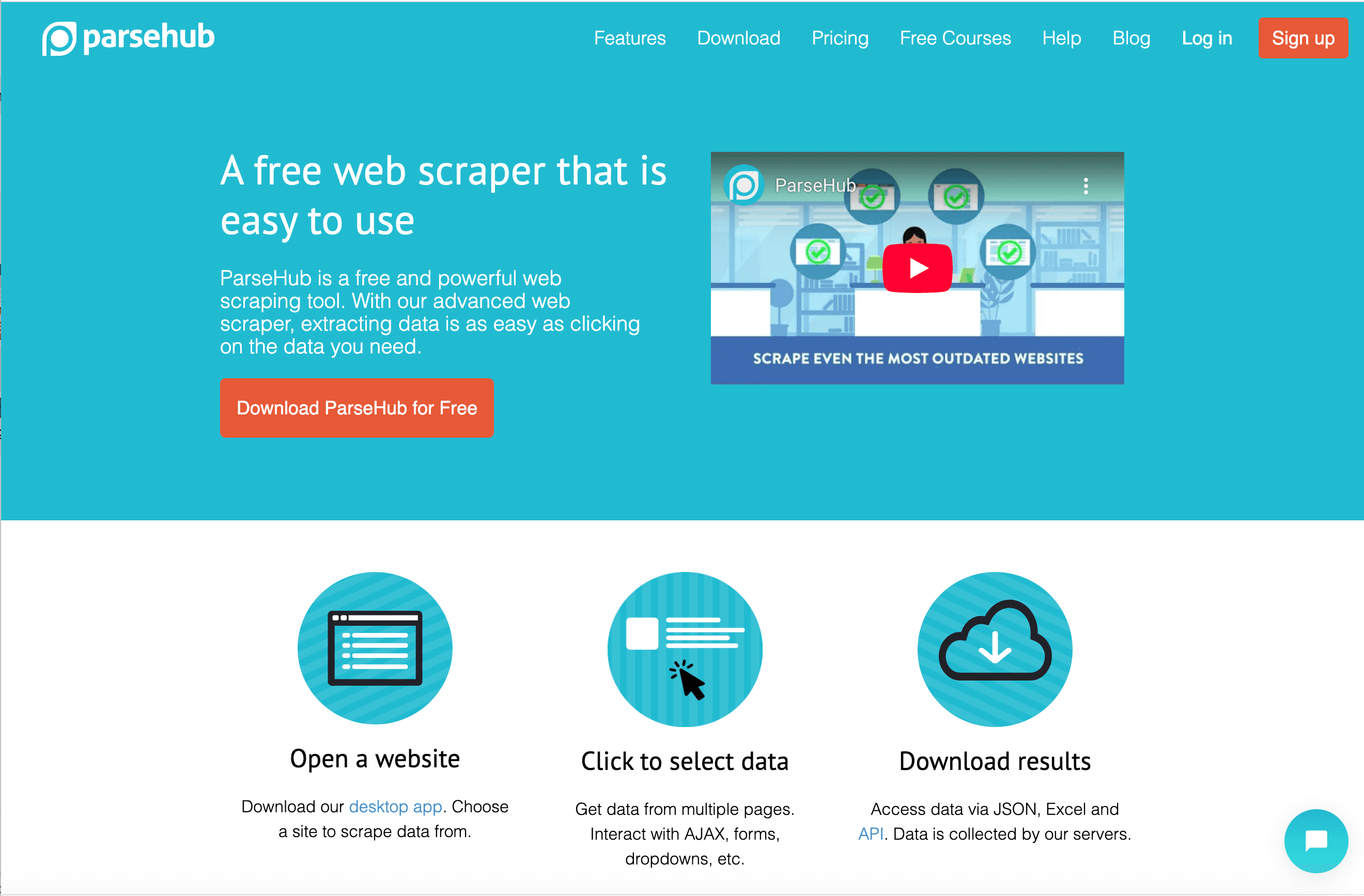

3. ParseHub

est un autre outil visuel, connu pour sa capacité à gérer les sites dynamiques et complexes via une appli de bureau. Si tu dois extraire des données de sites bourrés de JavaScript ou avec des éléments interactifs, l’approche « navigateur simulé » de ParseHub est top.

Ce qui fait la différence avec ParseHub :

- Extracteur visuel sur desktop : Crée tes projets en cliquant sur le site dans le navigateur intégré. ParseHub détecte les motifs et te permet de sélectionner pile ce qu’il te faut.

- Gestion du JavaScript & AJAX : Attend le chargement du contenu, clique sur les boutons, remplit les formulaires et navigue sur les sites interactifs.

- Intégration API : Déclenche des projets et récupère les résultats par programmation.

- Planification cloud : Programme des tâches dans le cloud (sur les offres supérieures).

- Options d’export : Télécharge les données en CSV, Excel ou JSON.

- Tarification : Offre gratuite jusqu’à 200 pages par extraction ; plans payants à partir de 189 $/mois (Standard) et 599 $/mois (Pro).

ParseHub est apprécié des journalistes data, chercheurs et PME qui doivent extraire des sites dynamiques et préfèrent bosser sur desktop. L’onboarding guidé aide les débutants, mais le prix peut vite grimper si tu fais du volume.

4. Scrapy

est la référence pour les développeurs et équipes techniques qui veulent un contrôle total sur leurs projets de scraping. Ce framework open source en Python permet de créer des crawlers sur-mesure – parfait pour les besoins costauds, à grande échelle ou très personnalisés.

Pourquoi Scrapy plaît aux devs :

- Flexibilité totale : Écris du code Python pour définir tes spiders, règles de crawl et pipelines de données. Scrapy gère la concurrence, les relances et l’export.

- Performance : Conçu pour la rapidité et l’échelle – scrape des milliers ou millions de pages efficacement.

- Extensible : Intègre des proxys, bases de données, APIs et middlewares personnalisés.

- Open source : Gratuit ; seuls les coûts d’infrastructure ou d’hébergement cloud (comme Scrapy Cloud de Zyte) sont à prévoir.

- Communauté : Écosystème riche, doc mature, plein de tutos.

Scrapy, ce n’est pas pour les débutants – la courbe d’apprentissage est raide et il faut maintenir son code. Mais si tu as des devs et des besoins de pipeline robuste et scalable, c’est du solide.

5. Diffbot

prend une approche radicalement différente : il utilise l’IA et le machine learning pour analyser et extraire automatiquement des données structurées de n’importe quelle page web. Plutôt que de créer des scrapers, tu envoies une URL à Diffbot (via API) et il te renvoie un JSON propre et structuré – sans rien configurer.

Ce qui rend Diffbot unique :

- Extraction pilotée par l’IA : APIs pré-entraînées pour articles, produits, discussions, etc. Diffbot « lit » la page comme un humain et extrait les champs clés.

- Crawlbot : Explore automatiquement des sites entiers ou des sitemaps.

- Knowledge Graph : Accède à la base de données massive de Diffbot (plus de 1,2 milliard de sites, 246 millions d’organisations, etc.).

- Scalabilité : Taillé pour la collecte de données à grande échelle.

- Tarification : Offre gratuite (10 000 crédits/mois) ; plans payants à partir de 299 $/mois pour 250 000 crédits, avec des options pour plus de volume.

Diffbot vise surtout les grandes entreprises, data scientists et tous ceux qui ont besoin de volumes massifs de données structurées sans gérer de scrapers. Moins personnalisable que les outils code, mais imbattable pour l’extraction automatisée à grande échelle.

6. DataMiner

est une extension de navigateur (Chrome et Edge) qui simplifie l’extraction ponctuelle de données. Si tu es growth hacker, journaliste ou pro qui veut juste récupérer un tableau ou une liste dans Excel, DataMiner est fait pour toi.

Pourquoi DataMiner cartonne :

- Simplicité point-and-click : Clique sur les éléments de la page pour créer une « recette », ou utilise l’une des 60 000+ recettes publiques pour plus de 15 000 sites.

- Extraction en un clic : Applique une recette et exporte instantanément en CSV ou Excel.

- Pagination & extraction en masse : Gère les listes multi-pages et traite même des listes d’URLs en lot.

- Remplissage de formulaires : Automatise la soumission de formulaires à partir d’un CSV.

- Offre gratuite : Jusqu’à 500 pages par mois gratuitement ; plans payants à partir de 19,99 $/mois pour 2 500 pages.

DataMiner est parfait pour les tâches ponctuelles, la recherche rapide et tous ceux qui préfèrent bosser direct dans leur navigateur. Ce n’est pas fait pour les gros volumes, mais pour les projets petits à moyens, c’est super efficace.

Tableau comparatif rapide : les outils de screen scraping en un clin d’œil

| Outil | Facilité d’utilisation | Fonctionnalités clés | Idéal pour | Modèle tarifaire | Atout majeur |

|---|---|---|---|---|---|

| Thunderbit | Très facile (no-code) | Suggestion IA, sous-pages/pagination, modèles, export gratuit | Utilisateurs métier non techniques (vente, ops, immo) | Gratuit/Dès 9–15 $/mois | Mise en route ultra simple, IA, extraction rapide |

| Octoparse | Moyenne (no-code) | Workflow visuel, cloud, sites dynamiques, modèles | Analystes, chercheurs technophiles | Gratuit/Dès 75 $/mois | Constructeur visuel, planification cloud, logique avancée |

| ParseHub | Moyenne (no-code) | App desktop, gestion JS/AJAX, API, cloud | Sites dynamiques, débutants techniques | Gratuit/Dès 189 $/mois | Gère les sites complexes, contrôle desktop |

| Scrapy | Difficile (Python) | Open source, scalable, contrôle total, pipelines | Développeurs, équipes techniques | Gratuit (auto-hébergé) | Flexibilité ultime, scraping personnalisé à grande échelle |

| Diffbot | Facile (pour devs) | Extraction IA, APIs, Knowledge Graph, crawlbot | Entreprises, data scientists | Gratuit/Dès 299 $/mois | Extraction IA sans effort, données web massives |

| DataMiner | Très facile (navigateur) | Extension navigateur, 60k+ recettes, un clic, formulaires | Tâches ponctuelles, journalistes, growth hackers | Gratuit/Dès 19,99 $/mois | Extraction la plus rapide sur navigateur, bibliothèque immense |

Quel outil de screen scraping te correspond le mieux ?

- Tu veux du sans code et des résultats immédiats ? Prends Thunderbit ou DataMiner. Thunderbit est top pour l’extraction structurée, multi-pages ou sous-pages avec l’aide de l’IA ; DataMiner est parfait pour les tâches rapides dans le navigateur.

- Tu cherches des workflows visuels et la puissance du cloud ? Octoparse est ton allié, surtout pour les sites complexes ou les extractions récurrentes.

- Tu scrapes des sites dynamiques bourrés de JavaScript ? L’approche desktop de ParseHub est idéale, surtout pour les débutants techniques.

- Tu as des devs et besoin de contrôle total ? Scrapy est la référence pour le scraping personnalisé à grande échelle.

- Tu veux des données structurées à grande échelle, boostées par l’IA ? Diffbot propose une extraction automatisée et un immense knowledge graph.

Mon conseil ? Commence par une version d’essai gratuite – la plupart de ces outils proposent un test avant engagement. Fais matcher ton niveau technique, le volume de données et tes besoins métier à l’outil qui va bien, et n’hésite pas à tester.

Conclusion : Passe à la vitesse supérieure avec le bon outil de screen scraping

Les outils de screen scraping sont passés de gadgets pour devs à vrais accélérateurs de productivité pour les entreprises. Que tu sois commercial à la chasse aux leads, responsable e-commerce qui surveille les prix, ou agent immobilier qui collecte des annonces, le bon outil peut transformer le web en ta base de données perso. L’essentiel, c’est de choisir une solution adaptée aux compétences de ton équipe et à tes objectifs – car le meilleur outil, c’est celui que tu vas vraiment utiliser.

Prêt à dire adieu au copier-coller et à collecter tes données comme un pro ? ou teste l’un des autres outils de cette liste. Pour plus de conseils, d’analyses et de tutos, file sur le .

FAQ

1. C’est quoi un outil de screen scraping et comment ça marche ?

Un outil de screen scraping automatise l’extraction de données depuis des sites web. Au lieu de copier les infos à la main, ces outils te permettent de sélectionner ce que tu veux et de l’exporter dans un format structuré comme Excel ou CSV. Certains utilisent l’IA ou des interfaces visuelles pour simplifier la config, même pour les non-techniciens.

2. Qui devrait utiliser les outils de screen scraping ?

Toute personne qui a besoin de collecter efficacement des données web : équipes commerciales, marketeurs, agents immobiliers, chercheurs, analystes opérationnels. Que ce soit pour monter des listes de prospects, surveiller la concurrence ou agréger des annonces, ces outils font gagner un temps fou et réduisent les erreurs.

3. Quelle est la différence entre les outils sans code et ceux qui demandent du code ?

Les outils sans code (Thunderbit, Octoparse, ParseHub, DataMiner) proposent des interfaces intuitives et sont pensés pour les non-techniciens. Les outils qui demandent du code (comme Scrapy) nécessitent des compétences en programmation mais offrent plus de flexibilité et d’évolutivité pour les projets costauds.

4. Les outils de screen scraping, c’est légal ?

Le screen scraping est légal pour les données publiques, mais il faut toujours respecter les conditions d’utilisation des sites et la législation sur la vie privée. Évite de collecter des données perso sans consentement et ne surcharge pas les sites de requêtes.

5. Comment choisir le meilleur outil de screen scraping pour mes besoins ?

Prends en compte tes compétences techniques, le volume de données, la complexité des sites ciblés, les besoins d’export et ton budget. Commence par un essai gratuit, teste ton cas d’usage et vois quel outil est le plus intuitif et efficace pour toi.

Prêt à exploiter tout le potentiel des données web ? Essaie l’un de ces outils et booste ta productivité.