En 2026, le monde de l’extraction web, c’est un peu comme le marché de Namdaemun à l’aube : tout le monde se presse pour choper les données les plus fraîches, et seuls ceux qui ont les meilleurs outils repartent avec le jackpot avant la foule. Aujourd’hui, les boîtes misent tout sur les données collectées, que ce soit pour chasser des leads ou surveiller la concurrence. Du coup, choisir la bonne bibliothèque Python pour l’extraction web, ce n’est plus juste une question de code, c’est carrément un choix stratégique. Et franchement, avec toutes les options (et les « guides ultimes ») qui pullulent, on a vite l’impression qu’il faut un master en data pour s’y retrouver.

Après avoir passé des années dans le SaaS et l’automatisation, j’ai vu comment les bons outils Python peuvent transformer une galère d’une semaine en une mission pliée en une matinée. Que tu sois dev à la recherche de pipelines solides ou utilisateur métier qui veut juste des données propres dans un tableur, voici mon top 12 des meilleures bibliothèques Python pour l’extraction web en 2026 — avec en prime une solution IA qui change la donne, que tu sois allergique au code ou expert.

Pourquoi bien choisir sa bibliothèque Python pour l’extraction web, c’est vital

L’extraction web, ce n’est pas juste récupérer des données, c’est surtout choper les bonnes données, vite, sans y laisser ta santé mentale. En 2026, plus de aux US utilisent l’extraction web automatisée pour prospecter, faire de la veille ou optimiser leurs process, et le nombre de pages explorées chaque jour se compte en . L’enjeu est énorme : un mauvais outil, et tu rates des opportunités, tu casses tes scripts ou tu perds des heures à déboguer.

Voilà les critères à checker pour choisir tes outils Python d’extraction web :

- Performance : Est-ce que ça tient la route sur de gros volumes ?

- Facilité d’utilisation : Tu passes plus de temps à coder ou à obtenir des résultats ?

- Compatibilité navigateur & JavaScript : Ça gère les sites modernes et dynamiques ?

- Scalabilité : L’outil suit si tes besoins explosent ?

- Intégration : Facile à brancher à ton pipeline de données ou à tes outils métier ?

Les usages classiques ? Génération de leads, suivi de prix, veille concurrentielle, automatisation des tâches reloues… La bonne bibliothèque, c’est la différence entre une équipe commerciale qui fonce et une autre qui galère dans des tableurs sans fin.

Comment on a évalué les meilleures bibliothèques Python pour l’extraction web

Pour ce classement, j’ai passé chaque bibliothèque au crible selon :

- Performance & Scalabilité : Ça gère les gros volumes et les sites tordus ?

- Facilité d’utilisation : Accessible aux débutants ou réservé aux pros du Python ?

- Gestion du navigateur & JavaScript : Ça gère le contenu dynamique et les applis web modernes ?

- Sécurité & maintenance : C’est bien maintenu et fiable ?

- Communauté & support : Y a de la doc, des tutos, de l’entraide si tu bloques ?

- Potentiel d’intégration : Tu peux la brancher à d’autres outils (ou à une solution IA comme Thunderbit) pour aller plus loin ?

J’ai aussi gardé en tête les vrais besoins des entreprises : au final, ton code ne vaut que par la qualité des données qu’il te ramène.

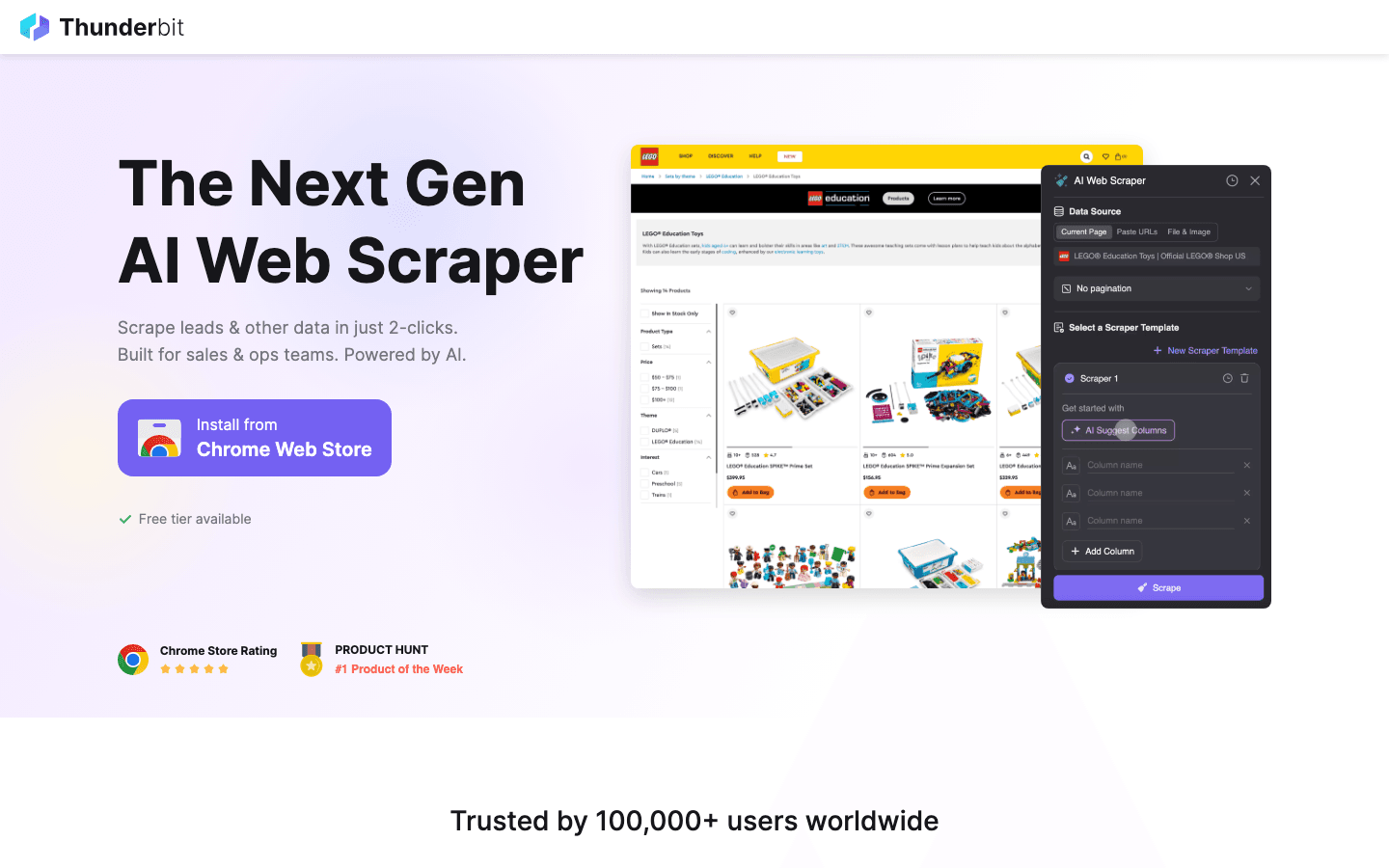

1. Thunderbit

n’est pas une bibliothèque Python classique : c’est une qui change la façon dont pros et devs font de l’extraction web en 2026. Voilà pourquoi elle mérite sa place ici.

n’est pas une bibliothèque Python classique : c’est une qui change la façon dont pros et devs font de l’extraction web en 2026. Voilà pourquoi elle mérite sa place ici.

Fonctionnalités phares :

- Suggestion de champs par IA : Tu expliques ce que tu veux, l’IA de Thunderbit devine les colonnes et types de données.

- Extraction de sous-pages : Va chercher et extrait direct les données des sous-pages (fiches produits, profils LinkedIn, etc.).

- Modèles instantanés : Extraction en un clic pour les sites connus (Amazon, Zillow, Shopify, etc.).

- Exportation gratuite des données : Tu exportes vers Excel, Google Sheets, Airtable, Notion, CSV ou JSON — sans frais cachés.

- Workflow sans code : Parfait pour les non-techs, mais ça s’intègre aussi aux outils Python pour aller plus loin.

Usages idéaux : Prospection commerciale, suivi des prix e-commerce, annonces immo, opérations… partout où tu veux des données structurées, vite.

Points forts :

- Zéro code à écrire : tu pointes, tu cliques, tu décris

- L’IA s’adapte si la structure du site change

- Gère les données web complexes ou mal fichues

- Peut bosser avec des bibliothèques Python (Scrapy, Beautiful Soup…) pour des workflows mixtes

Points faibles :

- Ce n’est pas une bibliothèque Python pure (mais ça s’intègre nickel aux pipelines Python)

- Idéal pour les utilisateurs métier ou en complément d’une extraction codée

Astuce : Utilise Thunderbit pour prototyper vite tes extracteurs ou gérer les tâches ponctuelles galère. Pour l’automatisation massive, exporte les données structurées de Thunderbit et traite-les ensuite avec tes scripts Python.

2. Beautiful Soup

c’est la base pour analyser et naviguer dans le HTML ou XML en Python. Si tu t’es déjà battu avec une page web mal foutue, tu sais pourquoi tout le monde l’adore, débutants comme experts.

c’est la base pour analyser et naviguer dans le HTML ou XML en Python. Si tu t’es déjà battu avec une page web mal foutue, tu sais pourquoi tout le monde l’adore, débutants comme experts.

Fonctionnalités phares :

- Syntaxe intuitive pour chercher, naviguer et modifier du HTML/XML

- Gère sans souci les balises cassées ou mal formées

- S’associe parfaitement avec pour choper les pages

Usages idéaux : Extraction rapide, nettoyage de données, analyse de pages petites à moyennes.

Points forts :

- Ultra simple à prendre en main

- Parfait pour nettoyer du HTML « crade »

- Flexible et tolérant

Points faibles :

- Moins rapide que sur de gros volumes

- Ne gère pas le JavaScript nativement

Astuce : Pour plus de vitesse, utilise Beautiful Soup avec le parseur lxml. Pour les sites dynamiques, combine-le avec Selenium ou Pyppeteer.

3. Selenium

c’est la référence pour piloter les navigateurs. Il contrôle Chrome, Firefox, Edge, etc., donc parfait pour extraire des sites dynamiques blindés de JavaScript.

c’est la référence pour piloter les navigateurs. Il contrôle Chrome, Firefox, Edge, etc., donc parfait pour extraire des sites dynamiques blindés de JavaScript.

Fonctionnalités phares :

- Automatisation de vrais navigateurs (Chrome, Firefox…)

- Mode sans interface graphique (headless) pour aller plus vite

- Peut interagir avec les formulaires, boutons et simuler des actions utilisateur

Usages idéaux : Extraction de sites qui demandent une connexion, des clics ou un rendu JavaScript costaud.

Points forts :

- Gère quasi tous les sites, même les plus dynamiques

- Compatible multi-navigateurs et multi-plateformes

- Parfait pour les tests et l’extraction dans un seul outil

Points faibles :

- Plus lent que les solutions headless pures

- Bouffe plus de ressources

- Les scripts peuvent casser si la structure du site change

Astuce : Utilise Selenium pour les sites coriaces. Pour la vitesse et le passage à l’échelle, préfère Scrapy ou Pyppeteer.

4. Requests

c’est la bibliothèque HTTP incontournable en Python. Elle simplifie l’envoi de requêtes GET/POST et la gestion des réponses, et c’est la base de plein de workflows d’extraction.

c’est la bibliothèque HTTP incontournable en Python. Elle simplifie l’envoi de requêtes GET/POST et la gestion des réponses, et c’est la base de plein de workflows d’extraction.

Fonctionnalités phares :

- API claire et « pythonique » pour les requêtes HTTP

- Gère cookies, sessions et authentification

- Fonctionne nickel avec des parseurs comme Beautiful Soup ou LXML

Usages idéaux : Récupération de pages statiques, d’APIs, ou comme brique de base pour des extracteurs sur mesure.

Points forts :

- Ultra simple à utiliser

- Fiable et bien maintenue

- Parfaite pour les scripts rapides et le prototypage

Points faibles :

- Pas d’analyse HTML intégrée

- Ne gère pas le contenu généré par JavaScript

Astuce : Combine Requests avec Beautiful Soup ou LXML pour une stack d’extraction légère et efficace.

5. LXML

c’est le boss de la vitesse pour analyser HTML/XML en Python. Si tu dois traiter du lourd ou faire des requêtes XPath complexes, c’est l’outil qu’il te faut.

c’est le boss de la vitesse pour analyser HTML/XML en Python. Si tu dois traiter du lourd ou faire des requêtes XPath complexes, c’est l’outil qu’il te faut.

Fonctionnalités phares :

- Analyse ultra-rapide grâce à un backend en C

- Prise en charge complète de XPath et des sélecteurs CSS

- Gère aussi bien le HTML que le XML

Usages idéaux : Analyse à grande échelle, structures de documents complexes, projets où la rapidité est clé.

Points forts :

- Bien plus rapide que Beautiful Soup sur du gros volume

- Sélecteurs puissants

- Gestion robuste des erreurs

Points faibles :

- Moins tolérant avec le HTML mal formé

- Courbe d’apprentissage un peu plus raide

Astuce : Utilise LXML comme parseur pour Beautiful Soup pour allier simplicité et performance.

6. Pyppeteer

c’est le portage Python de Puppeteer, pour contrôler Chrome en mode headless sur des tâches d’extraction avancées. Parfait pour les applis web modernes blindées de JavaScript.

c’est le portage Python de Puppeteer, pour contrôler Chrome en mode headless sur des tâches d’extraction avancées. Parfait pour les applis web modernes blindées de JavaScript.

Fonctionnalités phares :

- Contrôle total de Chrome (ou Chromium) en mode headless

- Rendu JavaScript de haut niveau et simulation d’utilisateur

- Gère navigation complexe, captures d’écran, génération de PDF

Usages idéaux : Extraction de sites modernes, automatisation de parcours utilisateur, contournement des protections anti-bot.

Points forts :

- Gère le JavaScript comme un chef

- Simule le comportement humain pour les sites complexes

- Parfait pour les applications monopage (SPA)

Points faibles :

- Plus lourd et plus lent que Requests ou Scrapy

- Maintenance variable — checke les mises à jour

- Nécessite plus de config

Astuce : Pour les sites qui résistent à Selenium, Pyppeteer est souvent la solution. Pour les workflows métier, utilise l’IA de Thunderbit pour définir les champs, puis laisse Pyppeteer naviguer.

7. Splash

c’est un moteur de rendu léger pour exécuter du JavaScript à grande échelle. Il est souvent utilisé avec Scrapy pour extraire des sites dynamiques.

c’est un moteur de rendu léger pour exécuter du JavaScript à grande échelle. Il est souvent utilisé avec Scrapy pour extraire des sites dynamiques.

Fonctionnalités phares :

- Navigateur headless avec API HTTP

- Rendu JavaScript et retour du HTML, captures d’écran ou fichiers HAR

- S’intègre à Scrapy via un middleware

Usages idéaux : Traitement massif de pages dynamiques, pipelines d’extraction évolutifs, rendu côté serveur.

Points forts :

- Rapide et efficace pour le rendu à grande échelle

- API simple à intégrer

- Moins gourmand en ressources que l’automatisation complète du navigateur

Points faibles :

- Interactivité limitée par rapport à Selenium ou Pyppeteer

- Courbe d’apprentissage pour la config et les scripts

Astuce : Pour l’extraction massive de sites dynamiques, le duo Scrapy + Splash est redoutable.

8. MechanicalSoup

c’est une bibliothèque Python légère pour automatiser les formulaires web et la navigation simple. Elle repose sur Requests et Beautiful Soup.

c’est une bibliothèque Python légère pour automatiser les formulaires web et la navigation simple. Elle repose sur Requests et Beautiful Soup.

Fonctionnalités phares :

- Automatisation de la soumission de formulaires et navigation

- Gestion des sessions et cookies

- API simple, parfaite pour les débutants

Usages idéaux : Connexion à des sites, remplissage de formulaires, extraction de pages statiques ou peu dynamiques.

Points forts :

- Mise en place minimale — parfait pour l’automatisation rapide

- Gère cookies et sessions nativement

- Idéal pour les sites avec formulaires ou recherche simple

Points faibles :

- Pas de gestion du JavaScript

- Pas fait pour l’extraction massive ou très dynamique

Astuce : Utilise MechanicalSoup pour les étapes de connexion, puis passe à Requests + Beautiful Soup pour la suite.

9. Twisted

c’est un moteur réseau asynchrone pour Python. Ce n’est pas un extracteur web à proprement parler, mais c’est la base pour construire des pipelines d’extraction sur-mesure à très haut débit.

c’est un moteur réseau asynchrone pour Python. Ce n’est pas un extracteur web à proprement parler, mais c’est la base pour construire des pipelines d’extraction sur-mesure à très haut débit.

Fonctionnalités phares :

- Réseaux asynchrones pour HTTP, TCP, etc.

- Gère des milliers de connexions en même temps

- Utilisé dans des systèmes d’extraction distribués sur-mesure

Usages idéaux : Création d’extracteurs custom à très haut volume, intégration avec d’autres frameworks asynchrones.

Points forts :

- Ultra puissant et scalable

- Prend en charge plein de protocoles

- Parfait pour les utilisateurs avancés

Points faibles :

- Courbe d’apprentissage raide

- Overkill pour la plupart des besoins classiques

Astuce : Si tu dois extraire des millions de pages, Twisted vaut le détour.

10. Scrapy

c’est le couteau suisse de l’extraction web en Python. Pensé pour les gros projets, il repose sur une architecture asynchrone qui permet de crawler des milliers de pages sans broncher.

c’est le couteau suisse de l’extraction web en Python. Pensé pour les gros projets, il repose sur une architecture asynchrone qui permet de crawler des milliers de pages sans broncher.

Fonctionnalités phares :

- Moteur asynchrone pour un débit élevé

- Prise en charge native des pipelines, middlewares et exports de données (JSON, CSV, XML)

- Gère exploration, analyse et nettoyage des données au même endroit

- Extensible avec des plugins pour les proxys, user agents, etc.

Usages idéaux : Extraction à l’échelle entreprise, extraction de données structurées, projets où rapidité et fiabilité sont clés.

Points forts :

- Ultra rapide sur les gros volumes

- Très personnalisable et extensible

- Communauté active et doc solide

Points faibles :

- Courbe d’apprentissage pour les débutants

- Moins adapté aux sites très dynamiques sans Splash

Astuce : Associe Scrapy à pour le rendu JavaScript, ou à pour la détection intelligente des champs et la structuration des données.

11. PyQuery

apporte la syntaxe des sélecteurs jQuery à Python. Si tu kiffes jQuery, tu vas être à l’aise.

apporte la syntaxe des sélecteurs jQuery à Python. Si tu kiffes jQuery, tu vas être à l’aise.

Fonctionnalités phares :

- API façon jQuery pour sélectionner et manipuler du HTML

- Basé sur lxml pour la rapidité

- Prise en charge des sélecteurs CSS et de la manipulation du DOM

Usages idéaux : Développeurs fans de jQuery, prototypage rapide, projets qui demandent des sélecteurs puissants.

Points forts :

- Rapide et efficace

- Intuitif pour les habitués de jQuery

- Top pour l’analyse et la modif du HTML

Points faibles :

- Communauté plus petite que Beautiful Soup ou LXML

- Moins tolérant avec le HTML mal formé

Astuce : Utilise PyQuery si tu préfères les sélecteurs CSS à XPath, tout en profitant de la puissance de lxml.

12. Parsel

c’est une bibliothèque puissante pour extraire des données de HTML et XML via XPath et sélecteurs CSS. C’est le moteur d’analyse de Scrapy.

c’est une bibliothèque puissante pour extraire des données de HTML et XML via XPath et sélecteurs CSS. C’est le moteur d’analyse de Scrapy.

Fonctionnalités phares :

- Prise en charge avancée de XPath et des sélecteurs CSS

- API claire pour extraire et nettoyer les données

- Utilisable seule ou intégrée à Scrapy

Usages idéaux : Extraction complexe, projets qui demandent une logique de sélection avancée, intégration avec Scrapy.

Points forts :

- Très flexible et puissante

- Parfaite pour les structures de pages complexes

- Bien documentée et maintenue

Points faibles :

- Faut maîtriser les sélecteurs

- Ce n’est pas un framework complet d’extraction — plutôt un composant d’analyse

Astuce : Utilise Parsel pour le traitement avancé dans tes spiders Scrapy ou tes scripts d’analyse custom.

Tableau comparatif : les outils Python d’extraction web en un clin d’œil

| Bibliothèque | Fonctionnalités principales | Performance | Facilité d’utilisation | Support JavaScript | Idéal pour | Options d’intégration |

|---|---|---|---|---|---|---|

| Thunderbit | IA, sans code, sous-pages | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | Oui (navigateur) | Utilisateurs métier, workflows hybrides | Excel, Sheets, Notion, Python |

| Beautiful Soup | Parsing HTML/XML, tolérant | ⭐⭐ | ⭐⭐⭐⭐⭐ | Non | Nettoyage de données, petits jobs | Requests, LXML, Thunderbit |

| Selenium | Automatisation navigateur, dynamique | ⭐⭐ | ⭐⭐ | Oui | Sites dynamiques, interactions utilisateur | Beautiful Soup, PyQuery |

| Requests | Requêtes HTTP, sessions | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | Non | Pages statiques, APIs | Beautiful Soup, LXML |

| LXML | Parsing rapide, XPath, CSS | ⭐⭐⭐⭐ | ⭐⭐⭐ | Non | Gros volumes, parsing complexe | Beautiful Soup, PyQuery |

| Pyppeteer | Chrome headless, JS | ⭐⭐ | ⭐⭐ | Oui | Sites JS modernes, SPA | Thunderbit, Pandas |

| Splash | Rendu JS, API | ⭐⭐⭐ | ⭐⭐ | Oui | Extraction JS en masse, pipelines | Scrapy, Thunderbit |

| MechanicalSoup | Gestion formulaires, navigation | ⭐⭐ | ⭐⭐⭐⭐ | Non | Formulaires simples, connexions | Requests, Beautiful Soup |

| Twisted | Réseau asynchrone, pipelines custom | ⭐⭐⭐⭐⭐ | ⭐ | Non | Gros volumes, extracteurs sur mesure | Scrapy, frameworks custom |

| Scrapy | Haute perf, async, pipelines | ⭐⭐⭐⭐⭐ | ⭐⭐ | Limité (via Splash) | Extraction à l’échelle, données structurées | Splash, Parsel, Thunderbit |

| PyQuery | Sélecteurs jQuery, rapide | ⭐⭐⭐ | ⭐⭐⭐⭐ | Non | Fans de jQuery, prototypage rapide | LXML, Requests |

| Parsel | XPath/CSS, parsing flexible | ⭐⭐⭐⭐ | ⭐⭐⭐ | Non | Extraction complexe, utilisateurs Scrapy | Scrapy, autonome |

Comment choisir la bibliothèque Python d’extraction web qui te correspond

Petit guide express :

-

Tu bosses sur des pages statiques ou des APIs ?

Prends Requests + Beautiful Soup ou LXML. -

Tu dois extraire du lourd, vite ?

Scrapy est ton allié. Pour le réseau asynchrone, pense à Twisted. -

Extraction de sites dynamiques, blindés de JavaScript ?

Tente Selenium, Pyppeteer ou Splash (avec Scrapy). -

Tu kiffes la syntaxe jQuery ?

PyQuery est fait pour toi. -

Automatisation de formulaires ou de connexions ?

MechanicalSoup, simple et efficace. -

Pas codeur ou tu veux gagner du temps sur la config ?

Thunderbit te permet de décrire tes besoins en langage naturel, puis d’exporter des données structurées vers tes outils préférés. -

Approche hybride ?

Utilise Thunderbit pour prototyper et structurer tes données, puis traite-les dans tes scripts Python.

Checklist pour choisir ton outil :

- Le site est statique ou dynamique ?

- Combien de données à extraire ?

- Faut-il interagir avec des formulaires ou des connexions ?

- À l’aise avec Python et les sélecteurs ?

- Besoin d’exporter vers des outils métier (Excel, Sheets, Notion) ?

- La maintenance à long terme, c’est important ?

Conclusion : Passe à la vitesse supérieure avec l’extraction web Python en 2026

L’extraction web avec Python, c’est jamais allé aussi loin — et c’est jamais été aussi accessible. Que tu automatises à grande échelle avec Scrapy, que tu nettoies tes données avec Beautiful Soup, que tu gères le JavaScript avec Selenium ou Pyppeteer, ou que tu veuilles juste remplir un tableur sans taper une ligne de code, il y a forcément un outil pour toi.

Le vrai secret ? N’hésite pas à mixer les outils. Chacune de ces bibliothèques Python a ses points forts, et les combiner (ou ajouter une solution IA comme ) peut te faire gagner un temps fou, limiter les bugs et révéler des insights business insoupçonnés.

En 2026, les gagnants ne sont pas juste les codeurs les plus rapides, mais ceux qui choisissent le bon outil, automatisent à fond et se concentrent sur l’essentiel : transformer les données web en vraie valeur pour l’entreprise.

FAQ

1. Quelle est la meilleure bibliothèque Python pour débuter en extraction web ?

Beautiful Soup est top pour les débutants grâce à sa syntaxe simple et sa tolérance. Pour les non-codeurs, Thunderbit propose une alternative IA sans code.

2. Quel outil Python privilégier pour les sites dynamiques ou blindés de JavaScript ?

Selenium, Pyppeteer et Splash sont les meilleurs pour extraire du contenu dynamique. Pyppeteer est particulièrement efficace avec les applis JavaScript modernes.

3. Peut-on combiner Thunderbit avec des bibliothèques Python comme Scrapy ou Beautiful Soup ?

Carrément ! Thunderbit structure et exporte vite les données, que tu peux ensuite traiter avec tes bibliothèques Python préférées.

4. Quelle est la bibliothèque Python la plus rapide pour analyser de gros documents HTML ?

LXML est généralement la plus rapide pour le parsing massif, surtout avec XPath ou les sélecteurs CSS.

5. Comment choisir entre Scrapy et Selenium ?

Utilise Scrapy pour l’extraction structurée à grande échelle sur des sites surtout statiques. Prends Selenium pour interagir avec des éléments dynamiques, des connexions ou des pages blindées de JavaScript.

Tu veux voir comment Thunderbit peut booster ton workflow d’extraction web ? et découvre d’autres guides sur le . Bonne extraction !

Pour aller plus loin