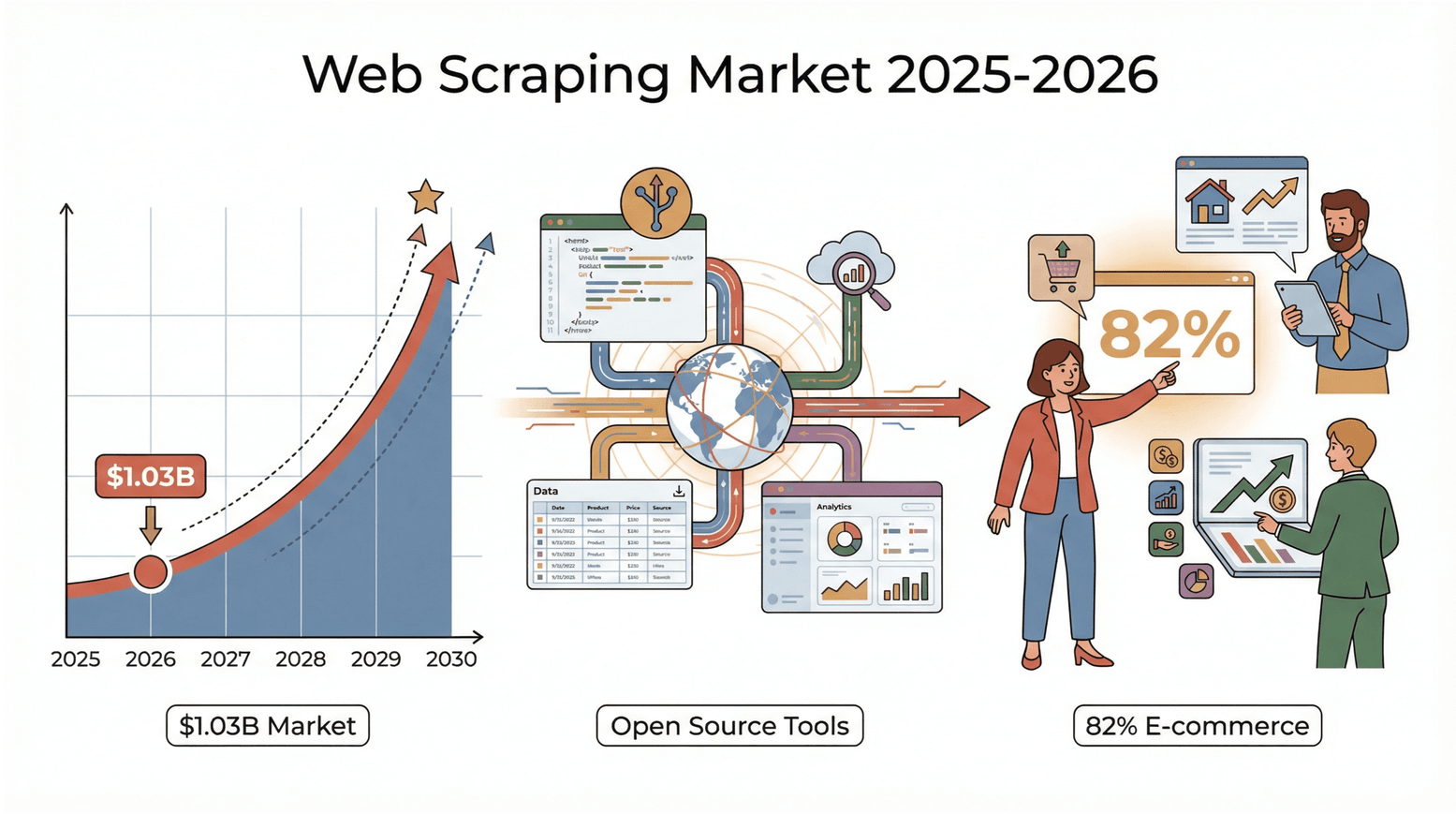

En 2026, le web déborde littéralement de données, et la bataille pour transformer ce grand bazar en infos utiles n’a jamais été aussi féroce. Que tu bosses dans la vente, l’e-commerce, l’immobilier ou que tu sois juste un mordu de data comme moi, tu as sûrement remarqué que le bon vieux « copier-coller » ne fait plus le poids. Un chiffre qui en dit long : le marché mondial de l’extraction web a atteint et devrait doubler d’ici 2030. Et ce ne sont pas que les géants de la tech qui s’y mettent : 82 % des boîtes d’e-commerce et plus d’un tiers des sociétés d’investissement collectent des données en ligne pour dénicher des prospects, surveiller les prix ou faire de la veille (). Bref, si tu n’utilises pas d’extracteur web, tu passes sûrement à côté de belles opportunités… et de données précieuses.

La bonne nouvelle ? Les outils open source d’extraction web sont aujourd’hui plus costauds, plus accessibles et mieux soutenus par la communauté que jamais. Que tu sois un pro du Python, un fan de JavaScript ou juste quelqu’un qui veut récupérer des données sans se prendre la tête, il y a forcément un outil pour toi. Après des années à baigner dans le SaaS et l’automatisation, j’ai vu cet univers exploser. Voici donc mon top 5 des meilleurs extracteurs web open source à tester en 2026 — et mes astuces pour choisir celui qui te conviendra le mieux.

Pourquoi miser sur un extracteur web open source ?

Les extracteurs web open source, c’est un peu le couteau suisse de la data. Ils sont économiques (pas de licence à payer), flexibles (tu peux les bidouiller à ta sauce) et transparents (tu sais exactement ce qu’ils font). Mais leur vrai super-pouvoir, c’est la communauté. Des milliers de devs et d’utilisateurs partagent plugins, tutos et correctifs — tu n’es jamais seul face à un bug ().

Contrairement aux solutions commerciales, les outils open source te laissent les pleins pouvoirs. Pas de dépendance à un éditeur ou à ses prix, et tu peux adapter tes extracteurs au fil des changements des sites. D’ailleurs, beaucoup de services payants tournent sur ces moteurs open source — alors pourquoi ne pas aller direct à la source ?

Comment j’ai sélectionné les meilleurs outils open source d’extraction web ?

Vu la quantité d’options, j’ai gardé quelques critères clés :

- Facilité d’utilisation : Est-ce que même un non-dev peut s’y mettre vite ? Y a-t-il des interfaces visuelles ou de l’IA ?

- Scalabilité : L’outil tient-il la route sur de gros volumes ou juste pour des petits jobs ?

- Langages et plateformes : Python, JavaScript, navigateur, desktop… il en faut pour tous les goûts.

- Communauté et maintenance : L’outil est-il encore vivant ? Y a-t-il des forums, de la doc, des plugins ?

- Fonctionnalités uniques : IA pour détecter les champs, extraction de sous-pages, planification, support cloud, etc.

J’ai aussi écouté les retours d’utilisateurs et regardé des cas concrets — parce que le meilleur outil, c’est celui qui règle vraiment ton problème.

Les 5 meilleurs extracteurs web open source à tester

Voici ma sélection, du plus simple au plus costaud côté dev.

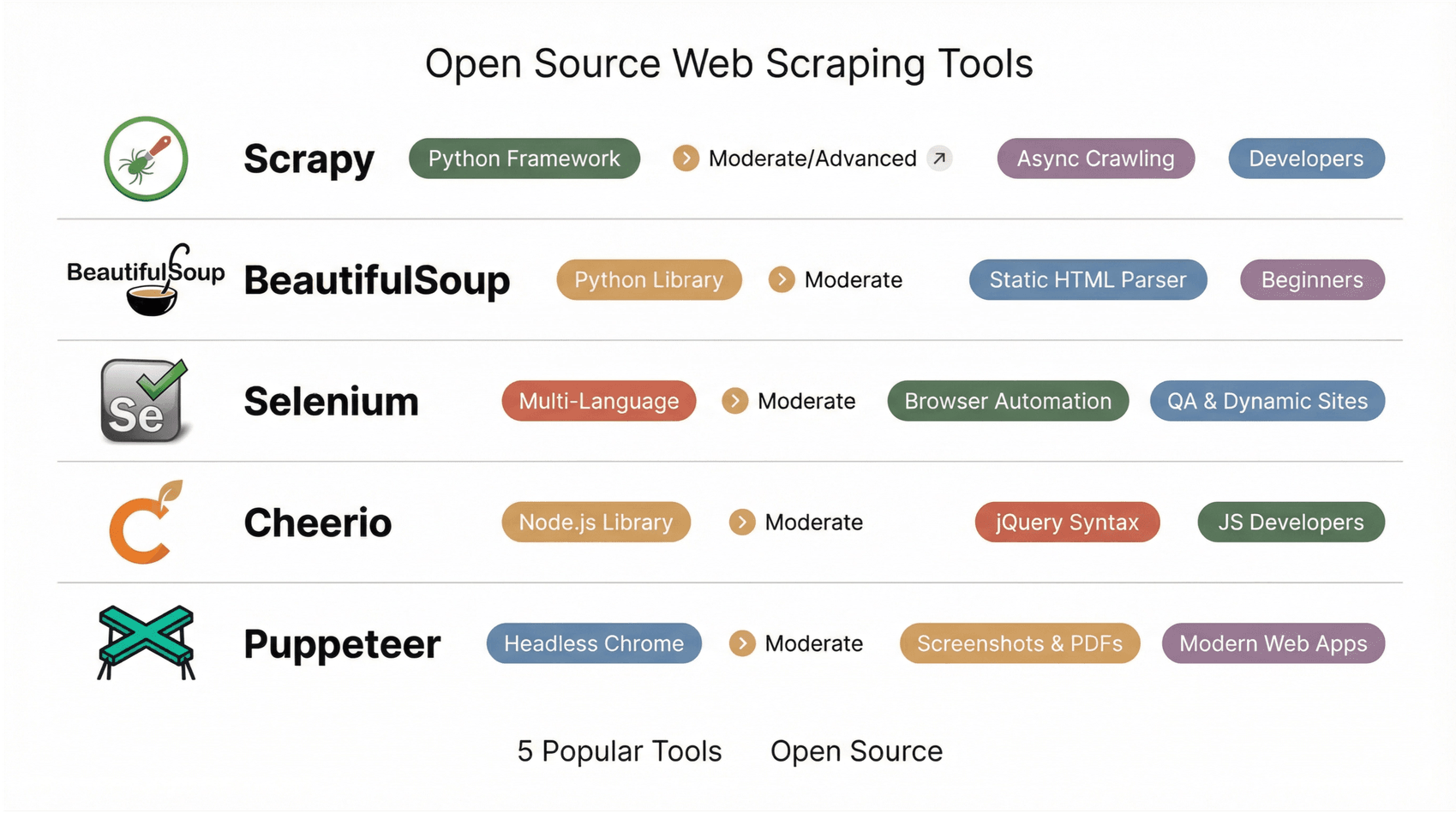

1. Scrapy

est le framework incontournable pour les devs Python. Il permet de créer des robots d’extraction et des pipelines de données solides et scalables. Grâce à son architecture asynchrone, Scrapy peut crawler des milliers, voire des millions de pages sans broncher. Tu codes tes « spiders » en Python, et Scrapy gère la queue, la limitation de vitesse et l’export (JSON, CSV, XML).

Son écosystème de plugins est énorme : gestion des proxys, cookies, intégration de navigateurs headless pour les sites dynamiques… Scrapy est parfait pour les gros projets, comme l’agrégation de catalogues e-commerce ou de news. L’apprentissage est un peu raide pour les non-devs, mais niveau puissance et flexibilité, c’est un must ().

2. Beautiful Soup

est la librairie Python classique pour parser du HTML à la volée. Adorée des débutants comme des pros, elle est super simple à prendre en main et gère même les HTML les plus crades. On récupère la page (souvent avec requests), on la charge dans Beautiful Soup, puis on extrait ce qu’on veut avec des méthodes intuitives.

Idéale pour les petits projets, les protos ou l’apprentissage. Limite : Beautiful Soup ne gère pas le JavaScript, donc uniquement pour les pages statiques. Pour les sites dynamiques, il faudra la coupler à Selenium ou requests_html ().

3. Selenium

est le pionnier de l’automatisation de navigateur. À la base conçu pour les tests, il est devenu un incontournable pour extraire des sites dynamiques bourrés de JavaScript. Selenium lance un vrai navigateur (Chrome, Firefox, etc.) et simule les actions d’un humain : clics, scrolls, connexions… Si tu peux le voir à l’écran, Selenium peut l’extraire.

Il supporte plusieurs langages (Python, Java, JS, C#) et brille pour les extractions derrière login ou les parcours interactifs. Inconvénients : plus lent et plus lourd que les extracteurs HTTP classiques, et la gestion des drivers peut être un peu galère. Mais pour les sites complexes, Selenium reste souvent la meilleure option ().

4. Cheerio

est le jumeau de jQuery côté serveur pour Node.js. Il permet de parser du HTML avec une syntaxe familière et super rapide. Parfait pour les pages statiques : tu récupères le HTML (avec Axios ou Fetch), tu le charges dans Cheerio, puis tu sélectionnes ce que tu veux.

Cheerio n’exécute pas le JavaScript, donc réservé au contenu statique. Mais il s’intègre nickel à l’écosystème Node.js, et les devs JS l’adorent pour sa rapidité ().

5. Puppeteer

est une librairie Node.js pour piloter Chrome ou Chromium en mode headless. On peut le voir comme le cousin moderne et full JS de Selenium. Puppeteer est top pour extraire des applis web récentes, des single-page apps ou tout site qui a besoin d’un vrai rendu navigateur. Il permet aussi de faire des captures d’écran, générer des PDF, intercepter les requêtes réseau… le tout avec une API async/await super propre.

Un peu plus technique, mais pour les sites ultra dynamiques, Puppeteer est un incontournable ().

Tableau comparatif rapide : meilleurs extracteurs web open source

| Outil | Facilité d’utilisation | Plateforme / Langage | Contenu dynamique | Idéal pour | Points forts |

|---|---|---|---|---|---|

| Scrapy | Moyen/Avancé (code) | Framework Python | Partiel | Développeurs, data scientists | Crawling asynchrone, plugins, grande communauté |

| BeautifulSoup | Moyen (code simple) | Librairie Python | Non | Débutants, parsing rapide | Parser tolérant, parfait pour HTML statique |

| Selenium | Moyen (script) | Multi-langage | Oui | QA, extraction sites dynamiques | Automatisation navigateur, gère logins et interactions |

| Cheerio | Moyen (code JS) | Librairie Node.js | Non | Dev JS, pages statiques | Syntaxe jQuery, parsing HTML rapide |

| Puppeteer | Moyen (code JS) | Node.js (Chrome headless) | Oui | Dev, apps web modernes | Screenshots, PDF, SPA, API async/await |

Comment choisir le bon extracteur web open source ?

Voici mon pense-bête pour bien choisir :

- Compétences techniques : Pas envie de coder ? Essaie Thunderbit, Octoparse, ParseHub ou WebHarvy. Plutôt dev ? Scrapy, Cheerio, Puppeteer ou Apify.

- Taille du projet : Petites tâches ponctuelles ? Beautiful Soup, Cheerio, WebHarvy. Gros volumes ou extraction régulière ? Scrapy, Apify, Thunderbit (avec planification).

- Type de données : HTML statique ? Cheerio, Beautiful Soup ou WebHarvy. Sites dynamiques/JavaScript ? Puppeteer, Selenium, Thunderbit, Octoparse.

- Intégration : Besoin d’exporter vers Sheets, Notion ou une base de données ? Thunderbit et Octoparse sont faits pour ça. Besoin d’API ou de pipelines sur-mesure ? Scrapy et Apify sont tes alliés.

- Communauté & support : Privilégie les outils avec des forums actifs, des mises à jour récentes et plein de tutos. Scrapy, Cheerio et Selenium ont de grosses communautés ; Thunderbit et Octoparse voient leur base d’utilisateurs grandir vite.

Teste plusieurs outils sur un petit projet pour voir lequel colle à ta façon de bosser. N’hésite pas à mixer : parfois, un outil visuel pour démarrer, puis un framework code pour aller plus loin, c’est la meilleure recette.

L’importance de la communauté et du support continu dans l’open source

Le vrai plus de l’open source ? Sa communauté. Forums actifs, dépôts GitHub, tags Stack Overflow… tu n’es jamais seul. Si tu bloques, il y a de grandes chances que quelqu’un ait déjà trouvé la solution — ou t’aidera vite. Les outils communautaires évoluent à toute vitesse, avec de nouvelles features, des plugins et des tutos à gogo ().

Pour les outils visuels comme Thunderbit ou Octoparse, les forums utilisateurs et le partage de modèles sont des mines d’or. Pour les outils dev, les issues GitHub et les groupes Discord/Slack sont incontournables. Choisir un outil open source, c’est rejoindre une grande famille de passionnés — et ça, ça n’a pas de prix.

Thunderbit : l’extraction web sans code, pour tout le monde

L’open source, c’est top… mais parfois, on n’a pas envie de passer des heures à configurer et maintenir un extracteur juste pour avoir des données prêtes à l’emploi. Et tous les besoins ne se règlent pas avec du code open source — c’est là que Thunderbit fait la différence. Si tu te dis « Ces outils sont puissants, mais je veux juste les données sans me prendre la tête », Thunderbit est fait pour toi.

est une extension Chrome boostée à l’IA, pensée pour les utilisateurs métier qui veulent des résultats, pas de la technique. Pas besoin d’écrire de sélecteurs ou de scripts : clique sur Suggérer les champs IA, l’IA comprend la page, propose les colonnes, et l’extraction se fait en un clic. Pagination, sous-pages, listes et détails sont gérés automatiquement.

Le gros atout de Thunderbit, c’est de relier ton besoin à la donnée structurée. Décris juste ce que tu veux (« récupérer les noms, prix et notes des produits »), et Thunderbit te sort un tableau prêt à l’emploi. L’extraction de sous-pages va chercher les infos détaillées sans effort. Export vers Excel, Google Sheets, Notion ou Airtable intégré : tes données sont prêtes en un rien de temps.

Thunderbit cartonne auprès des équipes commerciales, marketing, e-commerce et immobilières qui veulent des données fiables sans se prendre la tête avec l’open source. Il gère des dizaines de langues, fonctionne sur les sites dynamiques et propose une version gratuite généreuse pour commencer. Ce n’est pas open source, mais c’est le complément parfait : la solution la plus rapide pour valider une idée ou automatiser des extractions récurrentes sans galère technique.

Conclusion : profite à fond des meilleurs outils open source d’extraction web

L’extraction web n’est plus réservée aux codeurs ou aux grosses boîtes. Avec les outils open source d’aujourd’hui, tout le monde peut transformer le web en données structurées et exploitables — que ce soit pour faire une liste de prospects, surveiller les prix ou nourrir un projet IA. L’essentiel, c’est de choisir l’outil qui colle à ton besoin : IA et interfaces visuelles pour la rapidité et la simplicité, frameworks code pour la puissance et l’échelle.

Alors, c’est quoi la suite ? Choisis un outil dans cette liste, teste-le sur un cas concret, et vois le temps que tu gagnes. Et pour une solution immédiate, et découvre à quel point l’extraction web peut être simple. Le web t’appartient — à toi de récolter ses pépites de données.

Pour plus de guides et de tutos, passe sur le . Bonne extraction !

FAQ

1. Pourquoi choisir un extracteur web open source plutôt qu’une solution commerciale ?

Les outils open source sont économiques, flexibles et portés par des communautés actives. Tu peux les personnaliser, éviter la dépendance à un éditeur et profiter de mises à jour et de partages réguliers.

2. Quel outil open source est le plus adapté aux utilisateurs non techniques ?

Thunderbit, Octoparse, ParseHub et WebHarvy sont parfaits pour ceux qui ne codent pas. Thunderbit se démarque avec son workflow IA en deux clics et ses exports directs.

3. Les outils open source peuvent-ils extraire des sites dynamiques avec beaucoup de JavaScript ?

Oui ! Des outils comme Thunderbit, Selenium, Puppeteer, Octoparse et ParseHub peuvent extraire du contenu dynamique en rendant les pages dans un vrai navigateur (ou headless).

4. Comment savoir si un outil est bien maintenu ?

Regarde l’activité sur GitHub (commits récents, issues ouvertes, contributeurs). Vérifie aussi la présence de forums actifs, de blogs récents et de nombreux plugins ou modèles partagés.

5. Quelle est la meilleure façon de débuter l’extraction web si je suis débutant ?

Commence avec un outil visuel ou IA comme Thunderbit ou Octoparse. Essaie d’extraire un petit jeu de données, exporte-le vers Excel ou Sheets, et expérimente. Une fois à l’aise, explore les outils code pour des projets plus avancés.

Envie de voir Thunderbit en action ? et rejoins plus de 30 000 utilisateurs qui transforment le web en données — sans une ligne de code.

Pour aller plus loin