Gérer un site web en 2025, c’est un peu comme courir un marathon plein de surprises. Un jour, tu répares des liens morts, le lendemain tu prépares une migration de contenu, et entre deux, tu te demandes pourquoi Google a bien pu indexer ta page « test » de 2019. Franchement, je connais bien ce genre de galère. Et si tu es comme moi, il t’est sûrement déjà arrivé de taper « meilleur crawler de site web gratuit » sur Google à 2h du mat, en espérant tomber sur un outil simple à prendre en main (et qui ne demande pas d’être ingénieur en informatique).

Mais attention : tous les crawlers ne se valent pas, et – petit spoiler – beaucoup mélangent « crawler » et « extracteur web » comme si c’était la même chose. Ce n’est pas le cas. Dans ce guide, je vais t’expliquer la différence, pourquoi les crawlers en ligne sont devenus indispensables, et te présenter les 10 meilleurs outils gratuits pour l’exploration de site web en 2025. Et comme je suis co-fondateur de , je te montrerai aussi quand il vaut mieux éviter de se prendre la tête avec la technique et choisir une solution IA qui te livre directement les données dont tu as besoin. Prêt ? C’est parti.

Qu’est-ce qu’un crawler de site web ? Les bases à retenir

Commençons par clarifier les choses : un crawler de site web n’est pas un extracteur web. Je sais, on utilise souvent les deux mots à tort et à travers, mais ils n’ont pas le même job. Imagine le crawler comme le cartographe de ton site : il explore chaque recoin, suit tous les liens, et dresse la carte de toutes tes pages. Sa mission, c’est la découverte : trouver les URLs, cartographier la structure du site, et indexer le contenu. C’est ce que font les moteurs de recherche comme Google avec leurs robots, et ce que les outils SEO utilisent pour vérifier la santé de ton site ().

Un extracteur web, lui, c’est le chercheur d’or. Il ne s’intéresse pas à la carte complète : il veut juste extraire ce qui brille – prix des produits, noms d’entreprises, avis, emails, etc. Les extracteurs récupèrent des infos précises sur les pages découvertes par les crawlers ().

Pour faire simple :

- Crawler : C’est la personne qui parcourt tous les rayons d’un supermarché pour faire l’inventaire de tous les produits.

- Extracteur : C’est celle qui va direct au rayon café pour noter le prix de chaque café bio.

Pourquoi c’est important ? Parce que si tu veux juste lister toutes les pages de ton site (pour un audit SEO, par exemple), il te faut un crawler. Si tu veux extraire tous les prix produits d’un site concurrent, il te faut un extracteur – ou mieux, un outil qui fait les deux.

Pourquoi utiliser un crawler web en ligne ? Les atouts pour ton activité

Alors, pourquoi s’équiper d’un crawler web en ligne en 2025 ? Le web ne cesse de grossir. Plus de pour optimiser leurs sites, et certains outils SEO analysent .

Voici ce que les crawlers peuvent t’apporter :

- Audits SEO : Repérer les liens cassés, titres manquants, contenus dupliqués, pages orphelines, etc. ().

- Vérification des liens & QA : Détecter les erreurs 404 et les boucles de redirection avant que tes visiteurs ne tombent dessus ().

- Génération de sitemap : Créer automatiquement des sitemaps XML pour les moteurs de recherche et la planification ().

- Inventaire de contenu : Lister toutes tes pages, leur hiérarchie et leurs métadonnées.

- Conformité & accessibilité : Vérifier chaque page pour la conformité WCAG, SEO et légale ().

- Performance & sécurité : Signaler les pages lentes, images trop lourdes ou failles de sécurité ().

- Données pour l’IA & l’analyse : Alimenter tes outils d’analyse ou d’IA avec les données crawlées ().

Voici un tableau récapitulatif des usages selon les métiers :

| Cas d’usage | Pour qui ? | Bénéfice / Résultat |

|---|---|---|

| SEO & Audit de site | Marketing, SEO, TPE/PME | Détecter les problèmes techniques, optimiser la structure, améliorer le référencement |

| Inventaire de contenu & QA | Responsables contenu, webmasters | Auditer ou migrer le contenu, repérer liens/images cassés |

| Génération de leads (extraction) | Commerciaux, business dev | Automatiser la prospection, enrichir le CRM |

| Veille concurrentielle | E-commerce, chefs produit | Suivre les prix, nouveautés, stocks des concurrents |

| Clonage de structure & sitemap | Développeurs, DevOps, consultants | Cloner la structure pour refonte ou sauvegarde |

| Agrégation de contenu | Chercheurs, médias, analystes | Collecter des données multi-sites pour analyse ou veille |

| Études de marché | Analystes, équipes IA | Constituer de gros jeux de données pour analyse ou entraînement IA |

()

Comment avons-nous sélectionné les meilleurs crawlers gratuits ?

J’ai passé pas mal de soirées (et bu beaucoup trop de café) à tester des outils de crawling, lire leur doc et lancer des analyses. Voici mes critères :

- Capacités techniques : L’outil gère-t-il les sites modernes (JavaScript, connexion, contenu dynamique) ?

- Facilité d’utilisation : Accessible aux non-techniciens ou réservé aux experts du terminal ?

- Limites du plan gratuit : Gratuit pour de vrai, ou juste une démo ?

- Accessibilité en ligne : Outil cloud, appli de bureau ou bibliothèque de code ?

- Fonctionnalités uniques : Extraction IA, sitemaps visuels, crawling événementiel…

J’ai testé chaque outil, consulté les avis utilisateurs et comparé les fonctionnalités. Si un outil m’a donné envie de balancer mon ordi par la fenêtre, il n’est pas dans la liste !

Tableau comparatif : les 10 meilleurs crawlers gratuits en un clin d’œil

| Outil & Type | Fonctionnalités clés | Cas d’usage idéal | Compétences requises | Détails du plan gratuit |

|---|---|---|---|---|

| BrightData (Cloud/API) | Crawling d’entreprise, proxies, JS, anti-bot | Collecte massive de données | Un peu de technique utile | Essai gratuit : 3 extracteurs, 100 enregistrements chacun (env. 300 au total) |

| Crawlbase (Cloud/API) | API de crawling, anti-bot, proxies, JS | Devs cherchant une infra backend | Intégration API | Gratuit : ~5 000 appels API sur 7 jours, puis 1 000/mois |

| ScraperAPI (Cloud/API) | Rotation de proxy, JS, crawl asynchrone, endpoints préconfigurés | Devs, veille prix, SEO | Mise en place minimale | Gratuit : 5 000 appels API sur 7 jours, puis 1 000/mois |

| Diffbot Crawlbot (Cloud) | Crawl + extraction IA, knowledge graph, JS | Données structurées à grande échelle, IA/ML | Intégration API | Gratuit : 10 000 crédits/mois (env. 10k pages) |

| Screaming Frog (Bureau) | Audit SEO, analyse liens/méta, sitemap, extraction personnalisée | Audits SEO, gestionnaires de site | Application de bureau, interface graphique | Gratuit : 500 URLs par crawl, fonctions de base |

| SiteOne Crawler (Bureau) | SEO, performance, accessibilité, sécurité, export Markdown | Devs, QA, migration, doc | Bureau/CLI, interface graphique | Gratuit & open source, 1 000 URLs par rapport (modifiable) |

| Crawljax (Java, OpenSrc) | Crawl événementiel pour sites JS, export statique | Devs, QA apps dynamiques | Java, CLI/config | Gratuit & open source, sans limite |

| Apache Nutch (Java, OpenSrc) | Distribué, plugins, Hadoop, moteur de recherche | Moteurs de recherche, crawl massif | Java, ligne de commande | Gratuit & open source, coût infra uniquement |

| YaCy (Java, OpenSrc) | Crawl pair-à-pair, confidentialité, indexation web/intranet | Recherche privée, décentralisation | Java, interface web | Gratuit & open source, sans limite |

| PowerMapper (Bureau/SaaS) | Sitemaps visuels, accessibilité, QA, compatibilité navigateurs | Agences, QA, cartographie visuelle | Interface graphique, facile | Essai gratuit : 30 jours, 100 pages (bureau) ou 10 pages (en ligne) par scan |

BrightData : le crawler cloud pour les besoins d’entreprise

BrightData, c’est le géant du crawling web. Plateforme cloud, énorme réseau de proxies, rendu JavaScript, gestion des CAPTCHA, et même un IDE pour des crawls sur-mesure. Si tu dois surveiller des centaines de sites e-commerce pour les prix, l’infrastructure BrightData est difficile à battre ().

Points forts :

- Gère les sites protégés par des anti-bots

- Parfaitement scalable pour les gros volumes

- Modèles prêts à l’emploi pour les sites courants

Limites :

- Pas de version gratuite permanente (juste un essai)

- Surdimensionné pour de simples audits

- Prise en main technique pour les débutants

Pour crawler le web à grande échelle, BrightData c’est la Formule 1 du secteur. Mais après l’essai, ce n’est plus gratuit ().

Crawlbase : le crawler API gratuit pour développeurs

Crawlbase (ex-ProxyCrawl) mise tout sur le crawling programmatique. Tu envoies une URL à leur API, et tu récupères le HTML – proxies, géolocalisation et CAPTCHAs gérés en coulisses ().

Points forts :

- Taux de réussite très élevé (99%+)

- Gère les sites riches en JavaScript

- Idéal pour intégrer dans tes apps ou workflows

Limites :

- Nécessite une intégration API ou SDK

- Plan gratuit : ~5 000 appels API sur 7 jours, puis 1 000/mois

Pour les développeurs qui veulent crawler (et extraire) à grande échelle sans se soucier des proxies, Crawlbase est un choix solide ().

ScraperAPI : le crawling dynamique simplifié

ScraperAPI, c’est l’API « plug and play » : tu donnes une URL, il gère les proxies, les navigateurs headless, les anti-bots, et te renvoie le HTML (ou des données structurées pour certains sites). Parfait pour les pages dynamiques, avec un plan gratuit généreux ().

Points forts :

- Ultra simple pour les devs (un appel API suffit)

- Gère CAPTCHAs, IP bannies, JavaScript

- Gratuit : 5 000 appels API sur 7 jours, puis 1 000/mois

Limites :

- Pas de rapports visuels

- Nécessite de coder la logique de crawl pour suivre les liens

Pour intégrer le crawling web à ton code en quelques minutes, ScraperAPI est incontournable.

Diffbot Crawlbot : la découverte automatisée de la structure d’un site

Diffbot Crawlbot, c’est le crawler intelligent. Il ne se contente pas d’explorer : il utilise l’IA pour classer les pages et extraire des données structurées (articles, produits, événements…) au format JSON. C’est comme avoir un stagiaire robot qui comprend vraiment ce qu’il lit ().

Points forts :

- Extraction IA, pas juste du crawling

- Gère JavaScript et contenu dynamique

- Gratuit : 10 000 crédits/mois (env. 10k pages)

Limites :

- Orienté développeurs (intégration API)

- Pas d’interface SEO visuelle – plutôt pour les projets data

Pour obtenir des données structurées à grande échelle, notamment pour l’IA ou l’analyse, Diffbot est une référence.

Screaming Frog : le crawler SEO gratuit sur ordinateur

Screaming Frog est le classique du crawling SEO sur ordinateur. Il analyse jusqu’à 500 URLs par scan (version gratuite) et fournit tout : liens cassés, balises méta, contenus dupliqués, sitemaps, etc. ().

Points forts :

- Rapide, complet, reconnu dans le SEO

- Aucun code requis : il suffit d’entrer une URL

- Gratuit jusqu’à 500 URLs par crawl

Limites :

- Uniquement sur ordinateur (pas de version cloud)

- Fonctions avancées (rendu JS, planification) payantes

Pour l’audit SEO, Screaming Frog est un indispensable – mais il ne crawl pas gratuitement les très gros sites.

SiteOne Crawler : export statique et documentation

SiteOne Crawler, c’est le couteau suisse de l’audit technique. Open source, multi-plateforme, il peut crawler, auditer et même exporter ton site en Markdown pour la documentation ou l’archivage ().

Points forts :

- Couvre SEO, performance, accessibilité, sécurité

- Exporte les sites pour archivage ou migration

- Gratuit & open source, sans limite d’utilisation

Limites :

- Plus technique que certains outils graphiques

- Rapport GUI limité à 1 000 URLs par défaut (modifiable)

Pour les devs, QA ou consultants qui veulent aller loin (et aiment l’open source), SiteOne est une pépite.

Crawljax : crawler open source Java pour pages dynamiques

Crawljax est un spécialiste : il a été conçu pour crawler les applications web modernes riches en JavaScript, en simulant les interactions utilisateur (clics, formulaires, etc.). Il est événementiel et peut même générer une version statique d’un site dynamique ().

Points forts :

- Inégalé pour crawler les SPAs et sites AJAX

- Open source et extensible

- Sans limite d’utilisation

Limites :

- Nécessite Java et un peu de programmation/config

- Pas adapté aux non-techniciens

Pour crawler une app React ou Angular comme un vrai utilisateur, Crawljax est l’outil idéal.

Apache Nutch : le crawler distribué et scalable

Apache Nutch, c’est le pionnier du crawling open source. Conçu pour des crawls massifs et distribués – idéal pour créer son propre moteur de recherche ou indexer des millions de pages ().

Points forts :

- Passe à l’échelle (Hadoop) pour des milliards de pages

- Très configurable et extensible

- Gratuit & open source

Limites :

- Courbe d’apprentissage raide (Java, ligne de commande, configs)

- Pas adapté aux petits sites ou aux débutants

Pour crawler le web à très grande échelle et si la ligne de commande ne te fait pas peur, Nutch est fait pour toi.

YaCy : crawler pair-à-pair et moteur de recherche décentralisé

YaCy est un crawler et moteur de recherche décentralisé unique. Chaque instance explore et indexe des sites, et tu peux rejoindre un réseau pair-à-pair pour partager les index ().

Points forts :

- Respect de la vie privée, pas de serveur central

- Parfait pour créer un moteur de recherche privé ou intranet

- Gratuit & open source

Limites :

- Résultats dépendant de la couverture du réseau

- Nécessite une installation (Java, interface web)

Pour les fans de décentralisation ou ceux qui veulent leur propre moteur de recherche, YaCy est une option originale.

PowerMapper : générateur de sitemap visuel pour UX et QA

PowerMapper est spécialisé dans la visualisation de la structure d’un site. Il crawl ton site et génère des sitemaps interactifs, tout en vérifiant l’accessibilité, la compatibilité navigateur et les bases SEO ().

Points forts :

- Sitemaps visuels parfaits pour agences et designers

- Vérifie l’accessibilité et la conformité

- Interface graphique simple, aucune compétence technique requise

Limites :

- Essai gratuit uniquement (30 jours, 100 pages bureau/10 pages en ligne par scan)

- Version complète payante

Pour présenter une carte du site à un client ou vérifier la conformité, PowerMapper est très pratique.

Comment choisir le bon crawler gratuit selon tes besoins ?

Avec autant d’options, comment s’y retrouver ? Voici mon guide express :

- Pour les audits SEO : Screaming Frog (petits sites), PowerMapper (visuel), SiteOne (audits poussés)

- Pour les apps web dynamiques : Crawljax

- Pour le crawling massif ou moteur de recherche : Apache Nutch, YaCy

- Pour les devs qui veulent une API : Crawlbase, ScraperAPI, Diffbot

- Pour la documentation ou l’archivage : SiteOne Crawler

- Pour l’entreprise avec essai : BrightData, Diffbot

Points clés à considérer :

- Scalabilité : Quelle est la taille de ton site ou de ton projet ?

- Facilité d’utilisation : À l’aise avec le code ou besoin d’une interface simple ?

- Export de données : Besoin de CSV, JSON, ou d’intégration avec d’autres outils ?

- Support : Communauté ou documentation dispo en cas de galère ?

Quand le crawling rencontre l’extraction : pourquoi Thunderbit est plus malin

Soyons clairs : la plupart des gens ne crawlent pas un site juste pour dessiner une carte. Le but, c’est d’obtenir des données structurées – listings produits, contacts, inventaires de contenu… C’est là que entre en jeu.

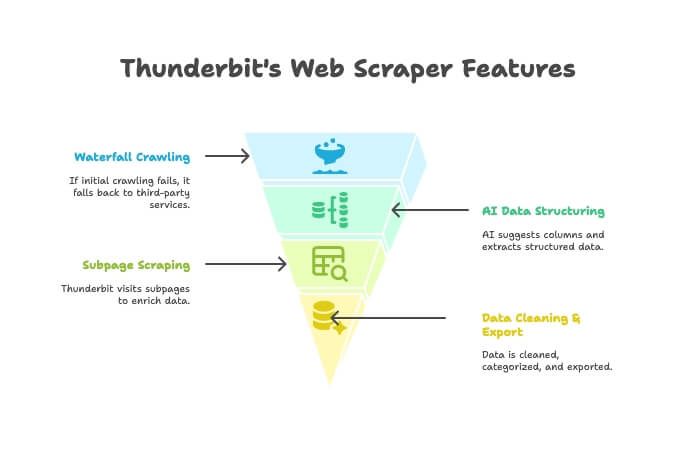

Thunderbit n’est pas juste un crawler ou un extracteur : c’est une extension Chrome boostée à l’IA qui combine les deux. Voici comment ça marche :

- Crawler IA : Thunderbit explore le site comme un crawler classique.

- Crawling en cascade : Si le moteur Thunderbit n’accède pas à une page (anti-bot coriace), il bascule automatiquement sur des services tiers – sans rien à configurer.

- Structuration IA des données : Une fois le HTML récupéré, l’IA de Thunderbit propose les bonnes colonnes et extrait les données structurées (noms, prix, emails…) sans que tu aies à écrire le moindre sélecteur.

- Extraction sur sous-pages : Besoin des détails de chaque fiche produit ? Thunderbit visite automatiquement chaque sous-page et enrichit ton tableau.

- Nettoyage & export des données : Résume, catégorise, traduit et exporte tes données vers Excel, Google Sheets, Airtable ou Notion en un clic.

- Simplicité no-code : Si tu sais utiliser un navigateur, tu sais utiliser Thunderbit. Pas de code, pas de proxy, pas de prise de tête.

Quand privilégier Thunderbit à un crawler classique ?

- Si ton objectif est d’obtenir un tableau propre et exploitable, pas juste une liste d’URLs.

- Si tu veux automatiser tout le processus (crawl, extraction, nettoyage, export) au même endroit.

- Si tu veux gagner du temps et te simplifier la vie.

Tu peux et voir pourquoi tant de pros l’ont adoptée.

Conclusion : exploite la puissance des crawlers gratuits en 2025

Les crawlers de sites web ont bien évolué. Que tu sois marketeur, développeur ou juste soucieux de la santé de ton site, il existe un outil gratuit (ou à tester gratuitement) pour toi. Des plateformes d’entreprise comme BrightData et Diffbot, aux pépites open source comme SiteOne et Crawljax, en passant par les générateurs de sitemaps visuels comme PowerMapper, le choix n’a jamais été aussi large.

Mais si tu veux une solution plus intelligente et tout-en-un pour passer de « j’ai besoin de ces données » à « voici mon tableau », teste Thunderbit. C’est pensé pour les pros qui veulent des résultats, pas juste des rapports.

Prêt à crawler ? Télécharge un outil, lance une analyse et découvre ce que tu ratais. Et si tu veux passer du crawling à la donnée exploitable en deux clics, .

Pour d’autres guides pratiques et analyses, passe sur le .

FAQ

Quelle est la différence entre un crawler de site web et un extracteur web ?

Un crawler découvre et cartographie toutes les pages d’un site (comme une table des matières). Un extracteur récupère des données précises (prix, emails, avis…) sur ces pages. Le crawler explore, l’extracteur extrait ().

Quel crawler gratuit est le plus adapté aux non-techniciens ?

Pour les petits sites et les audits SEO, Screaming Frog est très accessible. Pour une cartographie visuelle, PowerMapper est top (pendant l’essai). Thunderbit est le plus simple si tu veux des données structurées sans coder, directement dans le navigateur.

Certains sites bloquent-ils les crawlers ?

Oui – certains sites utilisent des fichiers robots.txt ou des protections anti-bot (CAPTCHA, blocage IP) pour limiter les crawlers. Des outils comme ScraperAPI, Crawlbase et Thunderbit (avec le crawling en cascade) arrivent souvent à contourner ces obstacles, mais il faut toujours crawler de façon responsable et respecter les règles du site ().

Les crawlers gratuits ont-ils des limites de pages ou de fonctionnalités ?

La plupart oui. Par exemple, la version gratuite de Screaming Frog est limitée à 500 URLs par crawl ; l’essai de PowerMapper à 100 pages. Les outils API ont souvent des quotas mensuels. Les outils open source comme SiteOne ou Crawljax n’ont généralement pas de limite, mais c’est ta machine qui fait la différence.

L’utilisation d’un crawler est-elle légale et conforme à la vie privée ?

En général, crawler des pages publiques est légal, mais vérifie toujours les conditions d’utilisation et le robots.txt du site. N’explore jamais de données privées ou protégées sans autorisation, et respecte la législation sur les données personnelles si tu extrais des infos sensibles ().