Tu t’es déjà retrouvé devant une pile de pages web, de fichiers Excel ou de PDF en te disant : « Franchement, il doit bien y avoir un moyen plus simple de choper toutes ces infos » ? Rassure-toi, tu n’es clairement pas le seul. Après des années à bricoler des outils d’automatisation et à discuter avec des équipes qui en ont ras-le-bol du copier-coller à la chaîne, je peux te le confirmer : en 2025, la masse de données non structurées est juste hallucinante — 80 à 90 % des nouvelles données d’entreprise ne sont pas structurées, et très peu de boîtes savent vraiment les exploiter (). Faire ça à la main, c’est pas juste pénible : ça coûte cher, c’est source d’erreurs, et ça plombe la productivité.

C’est là que les extracteurs de données changent la donne. Que tu bosses dans la vente, l’opérationnel, l’e-commerce ou la recherche, le bon outil peut te faire gagner des heures (voire des jours), fiabiliser tes données et permettre à ton équipe de se concentrer sur ce qui compte vraiment. Mais avec toutes les options qui existent — extensions Chrome boostées à l’IA, plateformes no-code, frameworks pour devs — comment choisir le bon ? J’ai passé au crible les 12 meilleurs extracteurs de données pour 2025, en détaillant leurs atouts, limites et cas d’usage. On y va !

Pourquoi les entreprises ont besoin d’extracteurs de données pour gagner en efficacité

Soyons clairs : 94 % des boîtes perdent un temps fou sur des tâches répétitives et barbantes comme la saisie manuelle de données (). Et ce n’est pas juste une question de temps — la collecte manuelle peut coûter jusqu’à 1 500 $ par employé chaque mois (). Les extracteurs automatisent ces corvées et te permettent de :

- Réduire jusqu’à 77 % le temps passé à collecter des données ().

- Booster l’efficacité opérationnelle de 40 % ().

- Diviser par deux (ou plus) les délais de traitement ().

- Atteindre jusqu’à 99,9 % de précision dans la capture de données documentaires ().

Résultat : des décisions plus rapides, des données fiables et des équipes qui bossent dans de meilleures conditions. Que tu cherches des leads, surveilles les prix de la concurrence ou alimentes tes outils BI, un bon extracteur, c’est comme un assistant digital qui ne se plaint jamais (et qui ne demande pas d’augmentation).

Comment choisir le meilleur extracteur de données : les critères clés

Tous les extracteurs ne se valent pas. Voilà ce que je regarde avant de conseiller un outil :

- Facilité d’utilisation : Est-ce que même les non-techs peuvent s’y mettre vite ? Y a-t-il de l’IA ou du point & click ?

- Personnalisation & flexibilité : Peut-on gérer des sites tordus, des connexions, du contenu dynamique ? Possibilité de coder pour les besoins pointus ?

- Types de données pris en charge : Texte, chiffres, images, emails, numéros, PDF, etc. ?

- Scalabilité & performance : Peut-il gérer des milliers de pages ? Scraping cloud ou multi-thread dispo ?

- Intégration & automatisation : Export direct vers Excel, Google Sheets, Airtable, Notion, ou API ?

- Tarifs & rapport qualité/prix : Y a-t-il une version gratuite ? Les offres payantes sont-elles abordables ?

- Support & communauté : Docs, tutos, support réactif ?

Chaque équipe a ses priorités. Les commerciaux veulent de la simplicité et de l’export rapide, les devs cherchent la personnalisation et l’accès API.

Extracteurs de données pour l’e-commerce et la veille marché

Les équipes e-commerce et études de marché vivent au rythme des données fraîches : suivi des prix, analyse d’avis, veille concurrentielle… Pour ça, il faut des outils capables de gérer le scraping massif, les protections anti-bot et la planification auto.

- : Connu pour son interface no-code solide et ses centaines de modèles prêts à l’emploi pour Amazon, eBay, etc. Parfait pour le suivi de prix et l’analyse d’avis.

- : Spécialiste de l’intégration des données web dans les outils BI, avec planification et détection des changements. Top pour les instituts d’études de marché.

- : Solution entreprise avec automatisation des workflows et transformation des données. Utilisé par de gros distributeurs pour la veille concurrentielle.

Ces outils sont taillés pour l’échelle et savent contourner les protections des géants de l’e-commerce.

Extracteurs de données pour équipes techniques et workflows sur-mesure

Si tu as des devs dans l’équipe (ou que tu aimes coder), vise des outils ultra-flexibles :

- : La référence open-source pour le scraping en Python. Ultra-personnalisable, parfait pour des projets sur-mesure ou l’intégration dans tes applis.

- : Constructeur visuel de workflows, gère les sites dynamiques et JavaScript. Prend en charge la logique conditionnelle, le JS custom et l’API.

- : Plateforme cloud pour exécuter des scripts de scraping personnalisés ("Actors") en JavaScript ou Python. Idéal pour automatiser des chaînes de tâches et passer à l’échelle.

Je recommande ces outils pour les sites complexes, les automatisations multi-étapes ou les besoins impossibles à couvrir avec un simple outil visuel.

Extracteurs de données pour l’intégration et l’automatisation des workflows

Certaines équipes veulent aller plus loin que la simple extraction brute : elles veulent automatiser tout le pipeline, de la collecte à l’analyse.

- : Comme vu plus haut, il excelle dans l’intégration des données web dans les tableaux de bord BI, avec planification et API.

- : Pensé pour l’automatisation de bout en bout, du nettoyage à l’intégration dans les CRM, bases de données, etc.

- : Plateforme d’entreprise avec scripting, gestion des erreurs et intégration avancée. Utilisé pour l’agrégation de données critiques.

Si ton workflow a plusieurs étapes ou que tu veux injecter les données direct dans tes systèmes, ces extracteurs sont à privilégier.

Tableau comparatif : les 12 meilleurs extracteurs de données en un coup d’œil

Voici un aperçu pour t’aider à faire ton choix :

| Nom de l’outil | Facilité d’utilisation | Cas d’usage idéal | Tarification | Personnalisation | Types de données pris en charge |

|---|---|---|---|---|---|

| Thunderbit | ⭐ Très facile | Tous secteurs, non-tech | Gratuit & Payant | Prompts IA low-code | Texte, Nombres, Dates, URLs, Emails, Téléphones, Images, PDFs |

| Octoparse | 🙂 Modérée | E-commerce, études de marché | Gratuit & Payant | Élevée (visuel, regex) | Texte, Nombres, URLs, Images |

| ParseHub | 🙂 Modérée | Sites dynamiques, tech | Payant | Élevée (JS, logique) | Texte, Nombres, URLs, Images |

| Import.io | 😀 Facile | Intégration, BI | Payant (Entreprise) | Moyenne | Texte, Tableaux, Listes |

| Scrapy | 😐 Difficile | Dev sur-mesure, grande échelle | Gratuit (Open-source) | Très élevée (code) | Tout (défini par le dev) |

| Apify | 😐 Difficile | Automatisation, dev | Gratuit & Payant | Très élevée (code) | Tout contenu web |

| Dexi.io | 🙂 Modérée | Entreprise, workflow | Payant (Entreprise) | Élevée (visuel, script) | Texte, Images, Fichiers |

| WebHarvy | 😀 Facile | PME, sites statiques | Licence unique | Faible-Moyenne | Texte, Nombres, URLs, Images |

| Data Miner | 😀 Facile | Web-to-sheet rapide, ventes | Gratuit & Payant | Moyenne (recettes) | Texte, Tableaux, Listes |

| Visual Web Ripper | 🙂 Modérée | Gros sites statiques, logique | Licence unique | Élevée (modèles, API) | Texte, Images, Fichiers |

| Helium Scraper | 🙂 Modérée | Logique personnalisée, relationnel | Licence unique | Élevée (JS, SQL) | Texte, URLs, Images, Fichiers |

| Content Grabber | 🙂 Modérée | Entreprise, automatisation | Payant (Entreprise) | Très élevée (scripting) | Tout contenu, export structuré |

Légende : 😀 Facile (parfait pour les non-tech), 🙂 Modérée (petite prise en main), 😐 Difficile (faut savoir coder)

1. Thunderbit

est mon chouchou pour les non-techs qui veulent être efficaces sans se prendre la tête. Cette est pensée pour les pros — commerciaux, ops, immobilier, e-commerce — qui veulent juste les données, sans galérer.

est mon chouchou pour les non-techs qui veulent être efficaces sans se prendre la tête. Cette est pensée pour les pros — commerciaux, ops, immobilier, e-commerce — qui veulent juste les données, sans galérer.

Fonctionnalités clés :

- Colonnes suggérées par l’IA : Un clic, l’IA de Thunderbit scanne la page et propose les champs à extraire — zéro prise de tête.

- Extraction en 2 clics : Tu valides les champs, tu cliques sur « Extraire » et c’est plié. Même ma mère pourrait s’en servir (et elle m’appelle encore pour le Wi-Fi).

- Extraction sur sous-pages : Besoin de détails ? Thunderbit peut aller automatiquement sur chaque sous-page (produit, profil…) et enrichir ton tableau.

- Export gratuit des données : Balance tes résultats direct dans Excel, Google Sheets, Airtable ou Notion — sans frais cachés.

- Extraction d’emails, téléphones et images en un clic : Parfait pour choper des leads ou des contacts.

- Scraping cloud ou navigateur : Choisis le cloud pour les sites publics ou le mode navigateur pour les pages avec login.

- Disponible en 34 langues : Nickel pour les équipes internationales.

Avantages : Ultra simple, sans code, gère les données non structurées et s’adapte aux changements de site. Version gratuite pour les petits besoins, offres payantes abordables pour les gros volumes.

Inconvénients : Moins personnalisable que les outils pour devs sur les sites très complexes. Tarification à crédit pour les gros volumes.

Idéal pour : Équipes commerciales, e-commerce, agents immobiliers, et tous ceux qui veulent passer de « J’ai besoin de ces données » à « Voilà mon tableau » en moins de cinq minutes. .

2. Octoparse

est une valeur sûre pour les équipes e-commerce et études de marché. C’est une appli desktop no-code (Windows) avec un builder visuel de workflows et des centaines de modèles pour Amazon, eBay, Zillow, etc.

est une valeur sûre pour les équipes e-commerce et études de marché. C’est une appli desktop no-code (Windows) avec un builder visuel de workflows et des centaines de modèles pour Amazon, eBay, Zillow, etc.

Fonctionnalités clés :

- Interface point & click : Crée tes « tâches » en cliquant sur les éléments de la page.

- Scraping cloud & planification : Les offres payantes permettent d’automatiser et de planifier les extractions dans le cloud.

- Rotation d’IP & anti-bot : Gère les sites qui bloquent les extracteurs, avec proxy et captcha intégrés.

- Bibliothèque de modèles : Plus de 500 templates prêts à l’emploi.

- Scraping multi-niveaux & paginé : Gère la navigation complexe et l’extraction sur pages de détail.

Avantages : Parfait pour le suivi de prix massif, l’analyse d’avis et la veille e-commerce. Pas besoin de coder pour la plupart des tâches.

Inconvénients : Uniquement sur desktop, cher pour les gros volumes, courbe d’apprentissage pour les workflows avancés.

Idéal pour : Analystes e-commerce, chercheurs marché, et tous ceux qui surveillent plein de produits ou de concurrents.

3. ParseHub

est un extracteur visuel super flexible, parfait pour les sites dynamiques et blindés de JavaScript. Appli desktop (Windows, Mac, Linux) avec workflow builder, logique conditionnelle, JS custom et accès API.

est un extracteur visuel super flexible, parfait pour les sites dynamiques et blindés de JavaScript. Appli desktop (Windows, Mac, Linux) avec workflow builder, logique conditionnelle, JS custom et accès API.

Fonctionnalités clés :

- Gère le contenu dynamique : Fonctionne avec les applis monopage, AJAX, sites interactifs.

- Workflows & scripting : Automatise des process multi-étapes, injecte du JS, utilise des regex pour affiner.

- Exécution cloud & locale : Lance les jobs sur ta machine ou dans le cloud (payant).

- Accès API : Intègre le scraping à tes applis ou automatise via webhooks.

Avantages : Très personnalisable pour les techs, gère les sites complexes, logique avancée.

Inconvénients : Plus lent sur les gros volumes, courbe d’apprentissage modérée, exécution cloud payante.

Idéal pour : Analystes techniques, devs, ou toute personne qui doit extraire des sites très interactifs.

4. Import.io

est pensé pour intégrer les données web à tes workflows BI. Plateforme web avec interface point & click, planification et API puissantes.

est pensé pour intégrer les données web à tes workflows BI. Plateforme web avec interface point & click, planification et API puissantes.

Fonctionnalités clés :

- Détection auto des tableaux : Colle une URL, Import.io tente d’extraire les données structurées.

- Planification & détection de changements : Programme des extractions régulières et reçois des alertes en cas de modif.

- Intégration API : Récupère les données par API ou pousse-les dans tes outils BI.

- Transformation des données : Nettoie et formate les données direct sur la plateforme.

Avantages : Facile à prendre en main, idéal pour les analystes, intégration forte avec les outils d’analyse.

Inconvénients : Tarifs entreprise, limité pour les sites très interactifs, moins de contrôle pour les experts.

Idéal pour : Équipes études de marché, analystes, ops qui ont besoin de flux de données continus.

5. Scrapy

est le framework Python open-source adoré des devs. Pour un contrôle total, la scalabilité et la création de crawlers sur-mesure, c’est l’outil parfait.

est le framework Python open-source adoré des devs. Pour un contrôle total, la scalabilité et la création de crawlers sur-mesure, c’est l’outil parfait.

Fonctionnalités clés :

- Crawling asynchrone : Rapide, efficace, conçu pour les gros volumes.

- Contrôle total par le code : Écris tes spiders en Python, personnalise chaque étape, intègre à n’importe quel système.

- Middleware & plugins : Rotation de proxy, gestion des connexions, extensions communautaires.

- Sortie structurée : Export vers JSON, CSV, bases de données, ou formats custom.

Avantages : Gratuit, ultra-flexible, grosse communauté.

Inconvénients : Faut savoir coder en Python, pas d’interface graphique, maintenance à ta charge.

Idéal pour : Devs, data engineers, intégration du scraping dans des pipelines ou applis maison.

6. Apify

est une plateforme cloud pour exécuter et partager des scripts de scraping (« Actors ») en JavaScript ou Python. Parfait pour l’automatisation, la chaîne de workflows et le passage à l’échelle.

est une plateforme cloud pour exécuter et partager des scripts de scraping (« Actors ») en JavaScript ou Python. Parfait pour l’automatisation, la chaîne de workflows et le passage à l’échelle.

Fonctionnalités clés :

- Actors & SDK : Écris tes scripts ou utilise des acteurs prêts à l’emploi depuis l’Apify Store.

- Automatisation navigateur headless : Scrape les sites dynamiques, gère les connexions, automatise les tâches web.

- Chaînage de workflows : Déclenche un acteur après l’autre, automatise des process multi-étapes.

- API & intégrations : Connecte-toi à Zapier, Make, Google Drive, AWS, etc.

Avantages : Puissant pour les devs, scalable, idéal pour automatiser des workflows complexes.

Inconvénients : Faut coder pour les tâches custom, tarification à l’usage, courbe d’apprentissage.

Idéal pour : Startups, équipes dev, et tous ceux qui veulent du scraping cloud automatisé à grande échelle.

7. Dexi.io

(ex-CloudScrape) est une plateforme entreprise pour automatiser la collecte et l’intégration de données. Elle permet de construire des workflows complets, de l’extraction à la transformation et la livraison.

(ex-CloudScrape) est une plateforme entreprise pour automatiser la collecte et l’intégration de données. Elle permet de construire des workflows complets, de l’extraction à la transformation et la livraison.

Fonctionnalités clés :

- Designer visuel de robots : Crée des workflows multi-étapes en point & click.

- Exécution cloud & planification : Lance tes robots dans le cloud, planifie des jobs réguliers, gère de gros volumes.

- Traitement & intégration des données : Nettoie, transforme et exporte vers CRM, bases de données ou API.

- Fonctionnalités entreprise : Gestion des utilisateurs, conformité, déploiement sur site.

Avantages : Scalable, puissant pour les workflows complexes, intégration avancée.

Inconvénients : Tarifs entreprise, pas pour les débutants, nécessite une formation pour les usages avancés.

Idéal pour : Grandes boîtes, équipes de veille retail, automatisation de pipelines multi-étapes.

8. WebHarvy

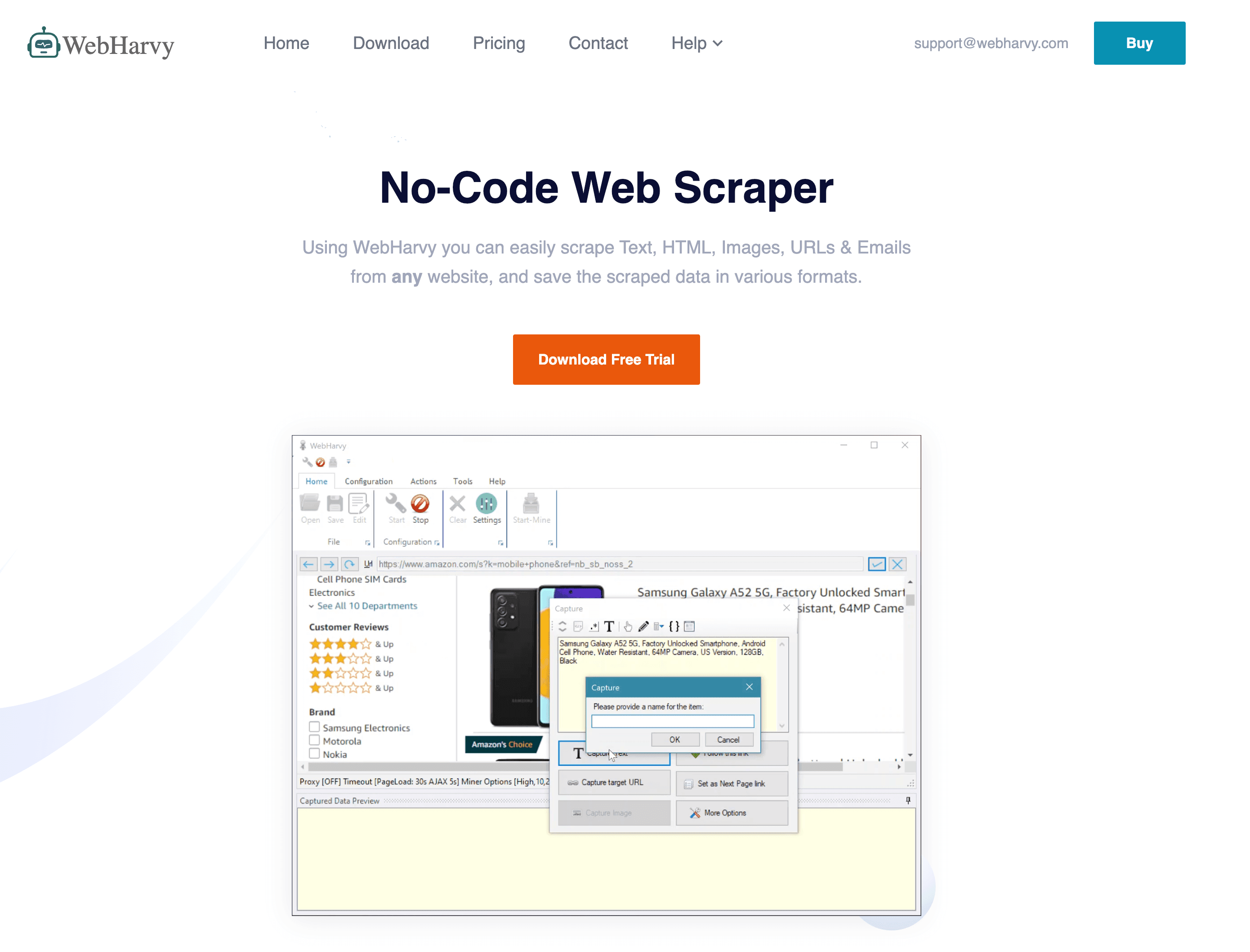

est un extracteur desktop Windows connu pour sa simplicité point & click et sa licence à paiement unique.

est un extracteur desktop Windows connu pour sa simplicité point & click et sa licence à paiement unique.

Fonctionnalités clés :

- Sélection visuelle : Clique sur les éléments dans le navigateur intégré pour définir les champs.

- Détection auto des motifs : Repère automatiquement listes et tableaux.

- Téléchargement d’images & fichiers : Récupère images et documents en plus du texte.

- Planification : Automatise les extractions via le planificateur Windows.

Avantages : Coût unique abordable, facile pour les sites simples, fonctionne hors ligne.

Inconvénients : Limité sur les sites JavaScript ou protégés, uniquement Windows, personnalisation avancée limitée.

Idéal pour : Petites boîtes, chercheurs, et tous ceux qui veulent un extracteur simple et économique pour des sites statiques.

9. Data Miner

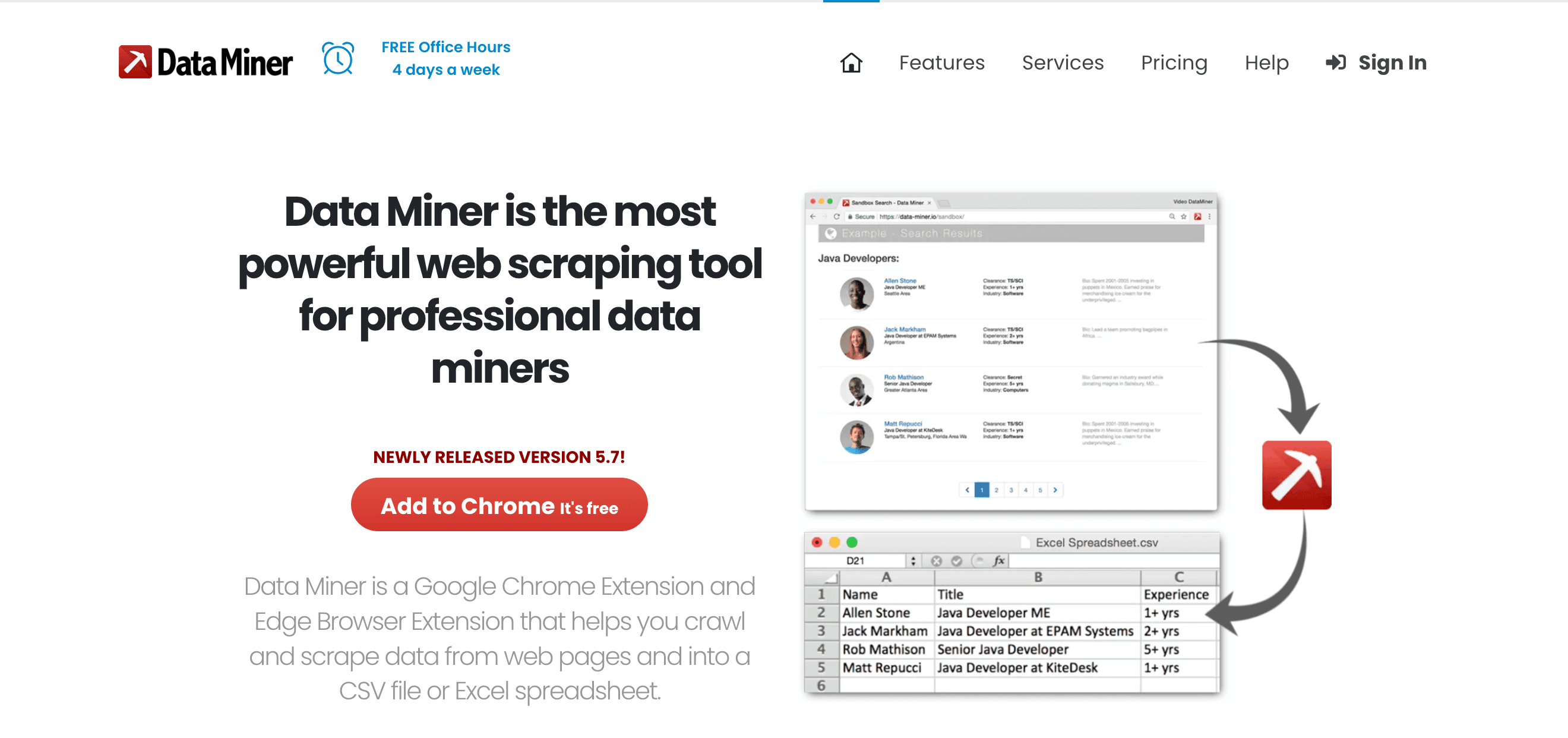

est une extension Chrome/Edge idéale pour extraire vite des données web via des modèles, surtout pour les équipes commerciales et opérationnelles.

est une extension Chrome/Edge idéale pour extraire vite des données web via des modèles, surtout pour les équipes commerciales et opérationnelles.

Fonctionnalités clés :

- 60 000+ recettes publiques : Extraction en un clic sur plein de sites populaires.

- Créateur de recettes point & click : Crée tes propres règles d’extraction.

- Extraction instantanée de tableaux : Récupère tables HTML ou listes en quelques secondes.

- Export direct : Balance les données vers Google Sheets, Excel ou CSV.

Avantages : Rapide, fonctionne dans le navigateur, sans code, parfait pour les sites avec login.

Inconvénients : Limité par la vitesse du navigateur, quotas sur les plans gratuits/payants, pas fait pour les très gros volumes.

Idéal pour : Prospection commerciale, recherches rapides, et tous ceux qui rêvent d’un bouton « Exporter vers Excel » pour le web.

10. Visual Web Ripper

(https://strapi.thunderbit.com/uploads/helium_1d0161c406.png)

est une solution desktop complète pour l’extraction de données à grande échelle, axée sur les projets à base de modèles et l’automatisation.

(https://strapi.thunderbit.com/uploads/helium_1d0161c406.png)

est une solution desktop complète pour l’extraction de données à grande échelle, axée sur les projets à base de modèles et l’automatisation.

Fonctionnalités clés :

- Système de modèles & projets : Conçois des crawls multi-niveaux avec des templates.

- Options avancées : Regex, XPath, outils de debug pour les sites complexes.

- Export vers bases de données : Sortie directe vers SQL, Excel, XML, etc.

- Automatisation : Planification et extraction multi-thread.

Avantages : Puissant pour les sites statiques complexes, licence unique, logique avancée prise en charge.

Inconvénients : Interface vieillotte, uniquement Windows, moins adapté aux sites dynamiques modernes.

Idéal pour : Consultants, agences, utilisateurs avancés qui gèrent de gros projets structurés.

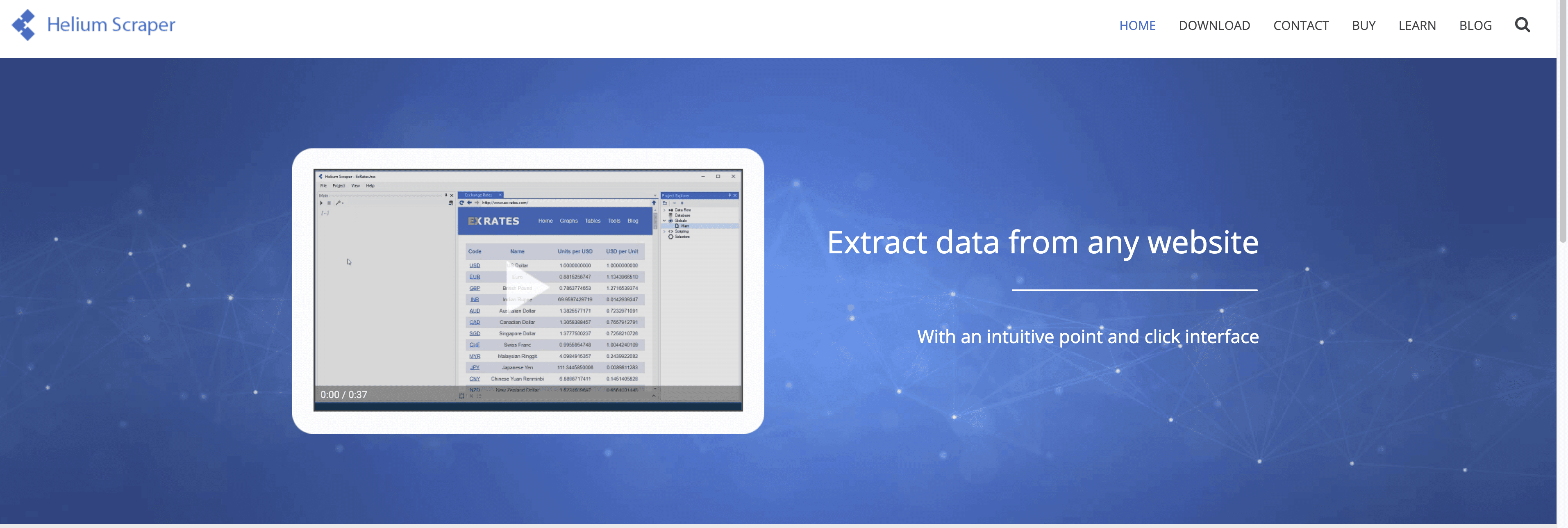

11. Helium Scraper

est une appli Windows qui mixe simplicité drag & drop et personnalisation avancée.

est une appli Windows qui mixe simplicité drag & drop et personnalisation avancée.

Fonctionnalités clés :

- Modèle « Kinds & Actions » : Définis visuellement les motifs de données, puis configure les actions d’extraction.

- Données relationnelles & multi-niveaux : Gère les relations parent-enfant, exécute des requêtes SQL sur les données extraites.

- Scripting personnalisé : Ajoute du JavaScript ou SQL pour la logique avancée.

- Multi-threading : Extraction parallèle pour plus de rapidité.

Avantages : Flexible, gère les structures complexes, licence unique abordable.

Inconvénients : Prise en main pour le concept « Kinds », uniquement Windows, communauté plus restreinte.

Idéal pour : Analystes et passionnés tech qui veulent plus de puissance qu’un simple outil visuel, sans coder de zéro.

12. Content Grabber

est une plateforme entreprise pour l’extraction et l’intégration automatisée de données à grande échelle.

est une plateforme entreprise pour l’extraction et l’intégration automatisée de données à grande échelle.

Fonctionnalités clés :

- Éditeur visuel d’agents : Crée tes agents en point & click, puis ajoute du code C# ou VB.NET pour la logique custom.

- Planification & monitoring entreprise : Contrôle centralisé, gestion des erreurs, notifications.

- Déploiement sur site : Garde tes données en interne pour la conformité.

- API & intégration : Export vers bases de données, API, files de messages.

Avantages : Ultra puissant, scalable, conçu pour les workflows critiques.

Inconvénients : Cher, complexe, réservé aux boîtes avec une équipe IT dédiée.

Idéal pour : Grandes entreprises, fournisseurs de données, et tous ceux pour qui l’extraction web est un process central.

Quel extracteur de données choisir ? Cas d’usage et recommandations

- Génération de leads commerciaux : (IA, export facile), (navigateur, recettes rapides).

- Veille e-commerce : (modèles, planification), (entreprise, intégration).

- Personnalisation technique : (Python, open-source), (cloud, automatisation), (visuel, sites dynamiques).

- Intégration & automatisation : (workflows BI), (entreprise, sur site).

- Tâches rapides et ponctuelles : (point & click, coût unique), (drag & drop, logique personnalisée).

Petit conseil : La plupart des outils proposent des essais gratuits — teste-en quelques-uns sur tes vrais besoins avant de t’engager.

Conclusion : Gagne en efficacité avec le bon extracteur de données

Les jours du traitement manuel des données sont comptés. Avec le bon extracteur, tu peux automatiser des heures de boulot répétitif, fiabiliser tes données et prendre de meilleures décisions — que tu sois solo, en équipe commerciale ou responsable ops d’un grand groupe. L’essentiel, c’est d’adapter l’outil à ton usage, ton niveau technique et ton budget.

Si tu veux la solution la plus rapide pour passer de « J’ai besoin de ces données » à « Elles sont dans mon tableur », est un super point de départ. Mais peu importe ton besoin, il y a un outil dans cette liste pour t’aider à bosser plus malin, pas plus dur.

Prêt à passer à la vitesse supérieure ? Essaie quelques-uns de ces extracteurs et découvre combien de temps (et de stress) tu peux économiser.

FAQ

1. Qu’est-ce qu’un extracteur de données et pourquoi en ai-je besoin ?

Un extracteur de données, c’est un outil qui automatise la collecte d’infos structurées depuis des sites web, documents ou bases de données. Il te fait gagner du temps, limite les erreurs et te permet de te concentrer sur l’analyse plutôt que sur le copier-coller manuel.

2. Quel extracteur de données est le plus adapté aux non-techniciens ?

se démarque avec sa config IA en 2 clics et ses prompts en langage naturel. Il est pensé pour les pros qui veulent des résultats sans coder ni se prendre la tête.

3. Les extracteurs de données peuvent-ils gérer les sites dynamiques ou blindés de JavaScript ?

Oui — des outils comme , et (avec navigateur headless) sont très efficaces pour extraire le contenu dynamique et les sites interactifs.

4. Comment choisir entre un extracteur gratuit et payant ?

Les outils gratuits sont bien pour des besoins ponctuels ou limités. Pour des tâches régulières, à grande échelle ou critiques, les offres payantes offrent plus de fonctionnalités, de volume et de support. Commence toujours par un essai gratuit pour voir si ça colle à ton besoin.

5. Est-il légal d’utiliser un extracteur de données ?

En général, extraire des données publiques est légal, mais vérifie toujours les conditions d’utilisation du site et respecte la législation sur la vie privée. Pour les données sensibles ou perso, assure-toi d’être conforme au RGPD et autres règles.

Envie d’en savoir plus sur le web scraping, l’automatisation et la productivité ? Va jeter un œil au pour des guides, tutos et les dernières nouveautés sur l’extraction de données par l’IA.

Pour aller plus loin