Le web, ce n’est plus juste un terrain de jeu digital : c’est carrément devenu le plus gros entrepôt de données de la planète, et tout le monde – des équipes commerciales aux analystes de marché – veut en tirer le maximum. Mais soyons francs : récupérer des infos à la main sur Internet, c’est un peu comme essayer de monter un meuble IKEA sans la notice (et finir avec une poignée de vis en trop). Aujourd’hui, alors que les boîtes misent tout sur la data en temps réel, la veille concurrentielle et la chasse aux nouveaux clients, avoir un extracteur web fiable et efficace, c’est devenu indispensable. D’ailleurs, près de pour guider leurs choix, et le marché mondial du web scraping devrait carrément .

Si tu en as marre du copier-coller, que tu galères à trouver de nouveaux leads ou que tu veux juste voir ce que l’automatisation peut faire à ta place, tu es au bon endroit. Après des années à bidouiller et tester des extracteurs web (et à piloter l’équipe de ), je peux te dire qu’un bon outil, ça change la vie : ce qui prenait des heures devient un jeu d’enfant. Que tu sois débutant sans bagage technique ou dev’ qui veut tout contrôler, ce top 10 des meilleurs outils de crawling va t’aider à trouver la perle rare.

Pourquoi bien choisir son extracteur web, c’est crucial

Soyons clairs : la différence entre un bon extracteur web et un outil moyen, ce n’est pas juste le confort – c’est un vrai booster pour ton business. Automatiser l’extraction de données, ce n’est pas seulement gagner du temps (un utilisateur G2 a même dit qu’il ), c’est aussi limiter les erreurs, ouvrir de nouvelles portes et garantir à ton équipe des infos fraîches et fiables. La recherche manuelle, c’est lent, ça bug, et souvent c’est déjà dépassé avant d’avoir fini. Avec le bon outil, surveiller la concurrence, suivre les prix ou monter des listes de prospects, ça se fait en quelques minutes, pas en plusieurs jours.

Un exemple concret : un distributeur de cosmétiques a utilisé le web scraping pour surveiller les stocks et prix de ses concurrents, . Impossible d’obtenir ce genre de résultats avec juste des tableurs et de l’huile de coude.

Comment on a sélectionné les meilleurs extracteurs web

Avec toutes les options qui existent, choisir le bon extracteur web, c’est un peu comme faire du speed-dating dans un salon tech. Voilà les critères que j’ai utilisés pour faire le tri :

- Facilité d’utilisation : Est-ce qu’on peut démarrer sans être expert en Python ? Y a-t-il une interface visuelle ou une aide IA pour les non-tech ?

- Automatisation : L’outil gère-t-il la pagination, les sous-pages, le contenu dynamique et la planification ? Peut-il tourner dans le cloud pour les gros volumes ?

- Tarifs et évolutivité : Y a-t-il une version gratuite ou un forfait d’entrée abordable ? Le prix reste-t-il correct si tes besoins explosent ?

- Fonctionnalités et intégrations : Peut-on exporter vers Excel, Google Sheets ou via API ? Y a-t-il des modèles, la planification ou un nettoyage de données intégré ?

- Pour qui ? : L’outil vise-t-il les utilisateurs métiers, les devs, les grosses boîtes ?

Un tableau comparatif t’attend à la fin pour voir tout ça d’un coup d’œil.

Allez, c’est parti pour le top 10 des extracteurs web à ne pas rater en 2025.

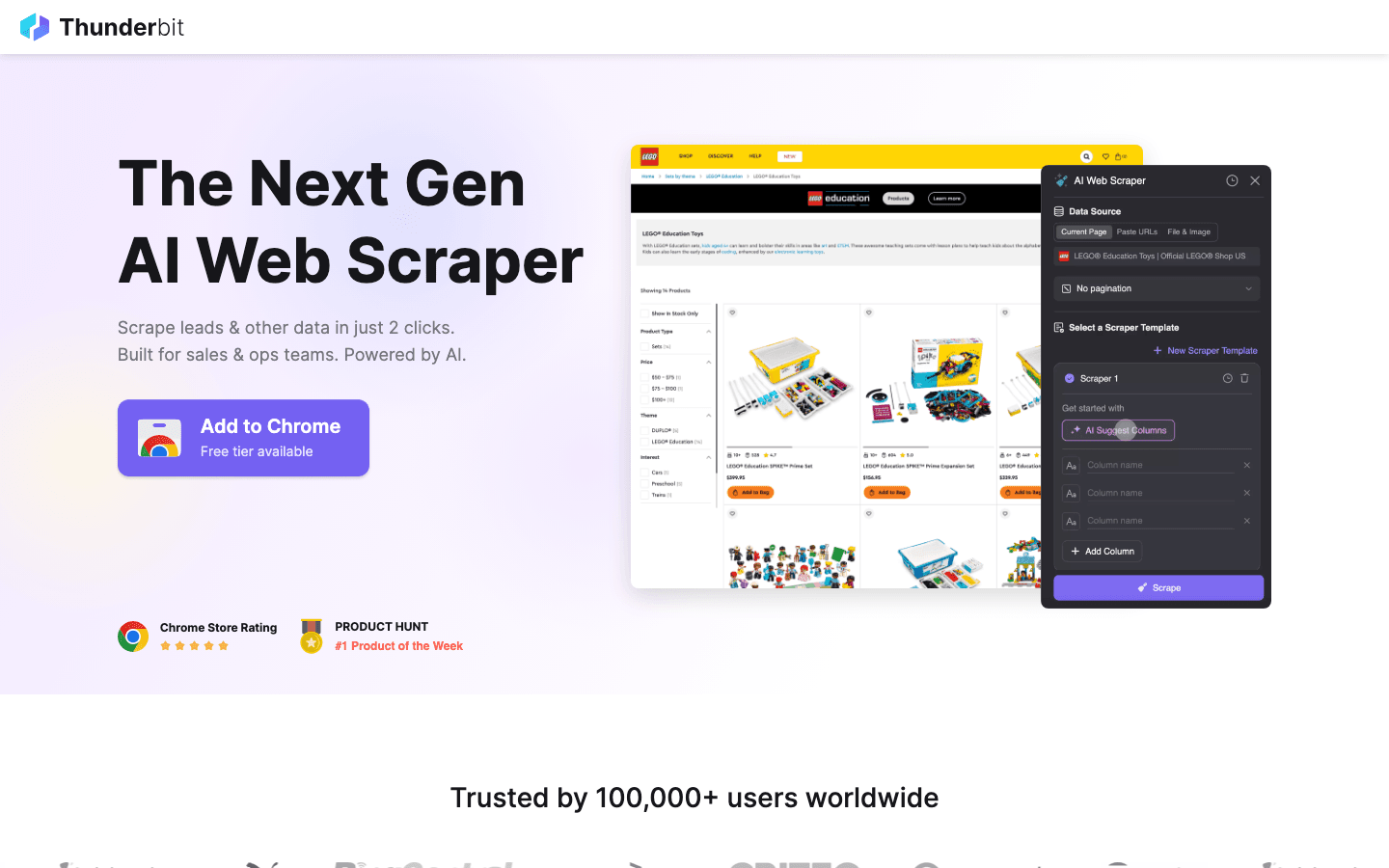

1. Thunderbit

est mon chouchou pour tous ceux qui veulent extraire des données aussi facilement que commander un plat sur une appli. Pensé comme une extension Chrome boostée à l’IA, Thunderbit mise sur la simplicité en 2 clics : tu cliques sur “AI Suggest Fields” pour laisser l’IA repérer les infos importantes, puis sur “Scrape” pour tout récupérer. Pas de code, pas de prise de tête – juste des résultats directs.

est mon chouchou pour tous ceux qui veulent extraire des données aussi facilement que commander un plat sur une appli. Pensé comme une extension Chrome boostée à l’IA, Thunderbit mise sur la simplicité en 2 clics : tu cliques sur “AI Suggest Fields” pour laisser l’IA repérer les infos importantes, puis sur “Scrape” pour tout récupérer. Pas de code, pas de prise de tête – juste des résultats directs.

Pourquoi Thunderbit cartonne auprès des équipes commerciales, marketing et e-commerce ? Parce qu’il répond aux vrais besoins des boîtes :

- AI Suggest Fields : L’IA scanne la page et propose direct les colonnes à extraire – noms, prix, emails, etc.

- Extraction de sous-pages : Besoin de détails en plus ? Thunderbit va tout seul sur chaque sous-page (fiche produit, profil LinkedIn…) pour enrichir ton tableau.

- Export instantané : Balance tes données direct dans Excel, Google Sheets, Airtable ou Notion. Tous les exports sont gratuits.

- Modèles en un clic : Pour les sites connus (Amazon, Zillow, Instagram), tu as des modèles prêts à l’emploi pour aller encore plus vite.

- Export de données gratuit : Pas de paywall pour récupérer tes données.

- Extraction programmée : Planifie des extractions récurrentes en langage naturel (“tous les lundis à 9h”) – parfait pour la veille tarifaire ou la mise à jour de leads.

Thunderbit fonctionne avec un système de crédits (1 crédit = 1 ligne), avec une jusqu’à 6 pages (ou 10 avec l’essai). Les forfaits payants commencent à 15 $/mois pour 500 crédits, ce qui reste accessible pour toutes les équipes.

Pour voir Thunderbit en action, check notre ou . C’est l’outil que j’aurais rêvé d’avoir quand je passais mes journées à faire du copier-coller.

2. Octoparse

est un mastodonte du crawling, adoré par les boîtes qui ont de gros besoins. Il propose une interface visuelle (Windows et Mac) où tu construis tes workflows d’extraction en quelques clics, sans coder. Mais ne te laisse pas tromper par son côté user-friendly : Octoparse gère aussi les connexions, le scroll infini, les proxys rotatifs et même les CAPTCHAs.

est un mastodonte du crawling, adoré par les boîtes qui ont de gros besoins. Il propose une interface visuelle (Windows et Mac) où tu construis tes workflows d’extraction en quelques clics, sans coder. Mais ne te laisse pas tromper par son côté user-friendly : Octoparse gère aussi les connexions, le scroll infini, les proxys rotatifs et même les CAPTCHAs.

- 500+ modèles prêts à l’emploi : Lance-toi direct sur Amazon, Twitter, LinkedIn, etc.

- Extraction cloud : Fais tourner tes tâches sur les serveurs Octoparse, planifie et monte en charge facilement.

- Accès API : Intègre direct les données extraites à tes applis ou bases de données.

- Automatisation avancée : Gère le contenu dynamique, la pagination et les workflows complexes.

Une permet jusqu’à 10 tâches, mais la plupart des pros iront sur le plan Standard (~83 $/mois) ou Pro (~299 $/mois). L’apprentissage est un peu plus long que Thunderbit, mais pour extraire des milliers de pages, Octoparse est une valeur sûre.

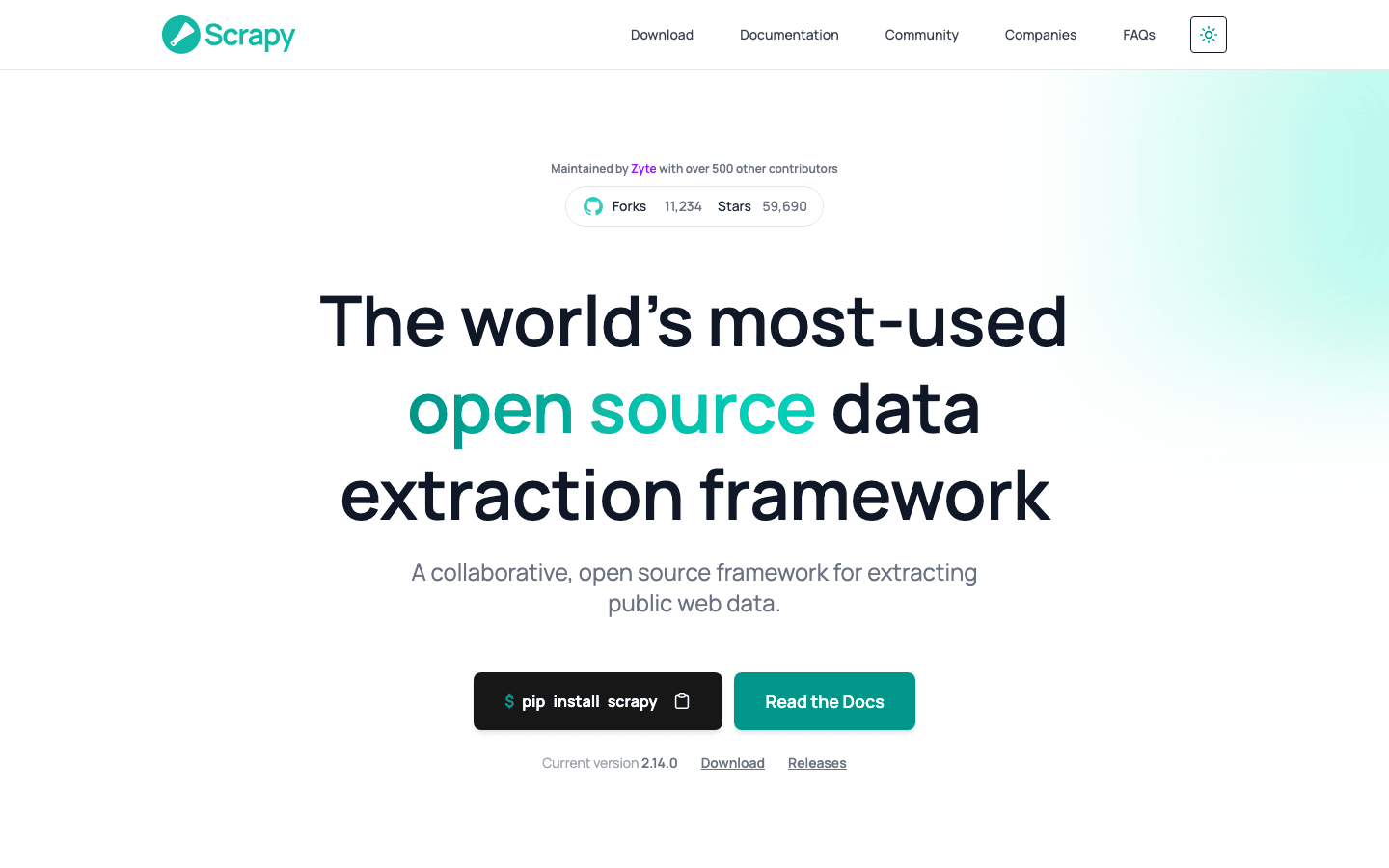

3. Scrapy

est la référence open-source pour les devs qui veulent tout contrôler sur leurs projets de crawling. Ce framework Python permet de coder des spiders (robots d’extraction) sur-mesure pour n’importe quel site. Si tu peux l’imaginer, tu peux le faire avec Scrapy.

est la référence open-source pour les devs qui veulent tout contrôler sur leurs projets de crawling. Ce framework Python permet de coder des spiders (robots d’extraction) sur-mesure pour n’importe quel site. Si tu peux l’imaginer, tu peux le faire avec Scrapy.

- Programmation complète : Définis en Python comment parcourir et analyser chaque site.

- Rapide et asynchrone : Gère des milliers de pages en parallèle pour les gros volumes.

- Extensible : Ajoute des middlewares pour les proxys, navigateurs headless ou logiques custom.

- Communauté active : Plein de tutos, plugins et solutions pour les cas tordus.

Scrapy est gratuit et open-source, mais il faut savoir coder. Parfait pour les équipes techniques ou les pipelines sur-mesure, moins pour les non-développeurs.

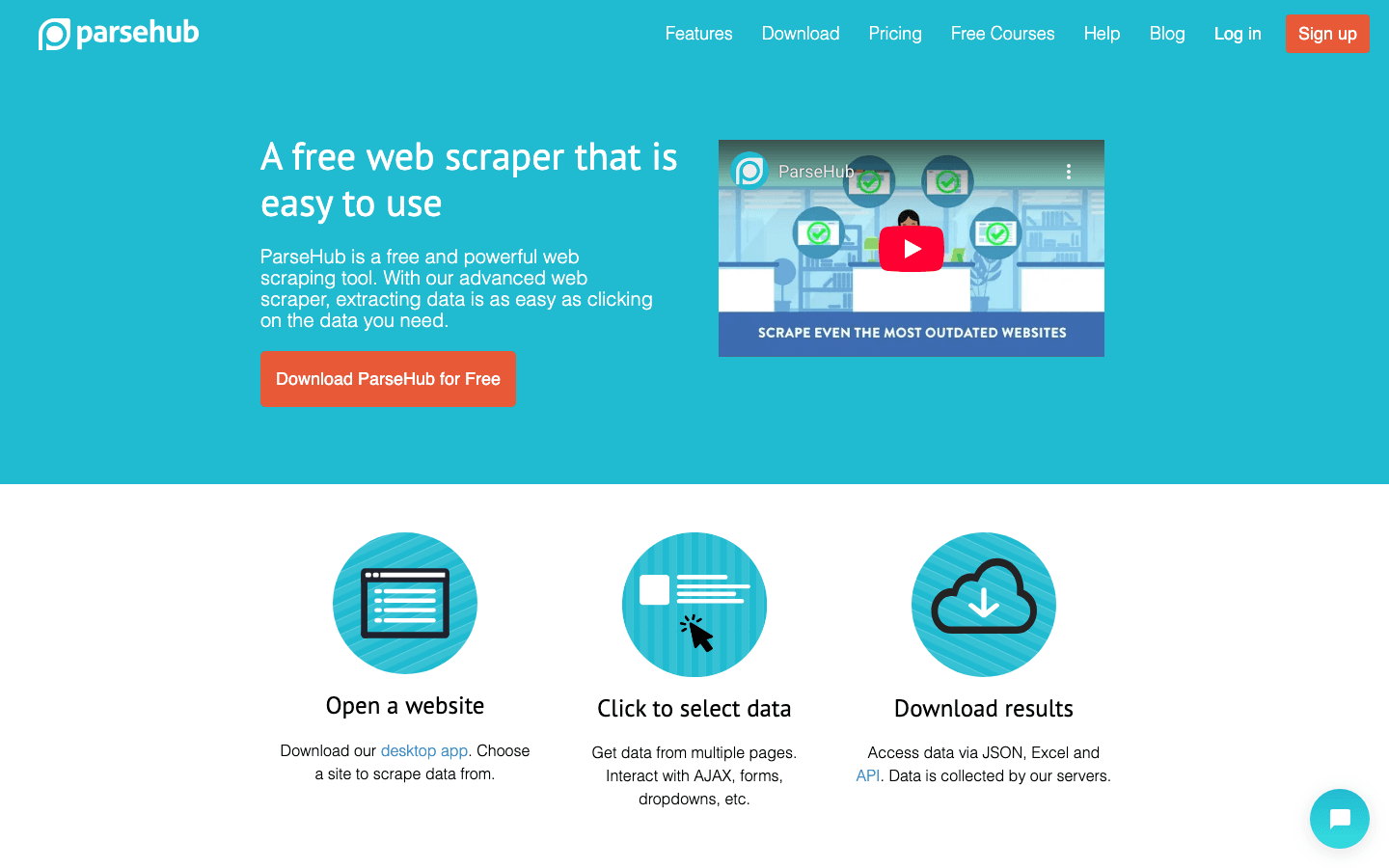

4. ParseHub

est un extracteur web visuel et sans code, parfait pour les non-tech qui doivent gérer des sites compliqués. Son interface point-and-click permet de sélectionner les éléments, définir des actions et construire des workflows, même sur des sites dynamiques ou à navigation galère.

est un extracteur web visuel et sans code, parfait pour les non-tech qui doivent gérer des sites compliqués. Son interface point-and-click permet de sélectionner les éléments, définir des actions et construire des workflows, même sur des sites dynamiques ou à navigation galère.

- Créateur de workflow visuel : Sélectionne les données, gère la pagination, les pop-ups ou menus déroulants.

- Gère le contenu dynamique : Fonctionne sur les sites blindés de JavaScript et pages interactives.

- Exécution cloud et planification : Lance tes extractions dans le cloud et programme-les.

- Export CSV, Excel ou via API : Intégration facile avec tes outils préférés.

ParseHub propose une version gratuite (5 projets), avec des forfaits payants à partir de . Un peu plus cher que certains concurrents, mais son côté visuel plaît aux analystes, marketeurs et chercheurs qui veulent plus qu’une simple extension Chrome.

5. Apify

est à la fois une plateforme et une marketplace pour le crawling web. Tu y trouves une énorme bibliothèque d’“Actors” (extracteurs prêts à l’emploi) pour les sites populaires, mais aussi la possibilité de créer et lancer tes propres robots custom dans le cloud.

est à la fois une plateforme et une marketplace pour le crawling web. Tu y trouves une énorme bibliothèque d’“Actors” (extracteurs prêts à l’emploi) pour les sites populaires, mais aussi la possibilité de créer et lancer tes propres robots custom dans le cloud.

- 5 000+ Actors prêts à l’emploi : Extrais direct Google Maps, Amazon, Twitter, etc.

- Scripts personnalisés : Les devs peuvent utiliser JavaScript ou Python pour des robots avancés.

- Scalabilité cloud : Fais tourner des tâches en parallèle, planifie et gère tes données dans le cloud.

- API & intégration : Connecte les résultats à tes applis, workflows ou pipelines de données.

Apify propose un , avec des plans payants à partir de 29 $/mois (facturation à l’usage). Il faut un peu de temps pour prendre en main, mais si tu veux du prêt-à-l’emploi ET de la personnalisation, Apify est un choix costaud.

6. Data Miner

est une extension Chrome pensée pour l’extraction rapide de données à partir de modèles. Parfait pour les utilisateurs métiers qui veulent récupérer des tableaux ou listes sans se prendre la tête.

est une extension Chrome pensée pour l’extraction rapide de données à partir de modèles. Parfait pour les utilisateurs métiers qui veulent récupérer des tableaux ou listes sans se prendre la tête.

- Grosse bibliothèque de modèles : Plus de mille recettes pour les sites connus (LinkedIn, Yelp, etc.).

- Extraction en un clic : Choisis un modèle, prévisualise les données et exporte direct.

- Fonctionne dans le navigateur : Idéal pour extraire derrière des connexions.

- Export CSV ou Excel : Tes données prêtes à l’emploi en quelques secondes.

Le couvre 500 pages/mois, les plans payants commencent à 20 $/mois. Idéal pour les extractions ponctuelles ou petits volumes – pas fait pour les gros projets ou l’automatisation avancée.

7. Import.io

est une plateforme taillée pour les entreprises qui ont besoin d’intégrer en continu des données web fiables. Plus qu’un simple extracteur, c’est un service géré qui livre des données propres et structurées direct dans tes systèmes métiers.

est une plateforme taillée pour les entreprises qui ont besoin d’intégrer en continu des données web fiables. Plus qu’un simple extracteur, c’est un service géré qui livre des données propres et structurées direct dans tes systèmes métiers.

- Extraction sans code : Configuration visuelle pour définir les données à extraire.

- Flux de données en temps réel : Alimente dashboards, outils d’analyse ou bases de données.

- Conformité & fiabilité : Gère la rotation d’IP, les protections anti-bot et la conformité légale.

- Services gérés : L’équipe Import.io peut configurer et maintenir tes extracteurs.

La tarification est , avec un essai gratuit de 14 jours. Si ton activité dépend de données web toujours à jour (retail, finance, études de marché…), Import.io vaut le détour.

8. WebHarvy

est un extracteur desktop pour Windows, parfait pour ceux qui veulent une solution simple sans abonnement. Très apprécié des petites boîtes et indépendants qui préfèrent payer une fois pour toutes.

est un extracteur desktop pour Windows, parfait pour ceux qui veulent une solution simple sans abonnement. Très apprécié des petites boîtes et indépendants qui préfèrent payer une fois pour toutes.

- Détection visuelle des motifs : Clique sur les éléments, WebHarvy repère direct les motifs récurrents.

- Gère textes, images et plus : Extrait tous types de données, y compris emails et URLs.

- Pagination & planification : Parcours les sites multi-pages et programme tes extractions.

- Export Excel, CSV, XML, JSON, SQL : Sortie flexible pour tous les usages.

La licence individuelle coûte , un choix économique pour un usage régulier – à noter, uniquement sur Windows.

9. Mozenda

est une plateforme cloud de crawling pensée pour les opérations métiers et les besoins récurrents. Elle combine un designer desktop (Windows) à une exécution et une automatisation puissantes dans le cloud.

est une plateforme cloud de crawling pensée pour les opérations métiers et les besoins récurrents. Elle combine un designer desktop (Windows) à une exécution et une automatisation puissantes dans le cloud.

- Créateur d’agents visuel : Conçois tes routines d’extraction en point-and-click.

- Scalabilité cloud : Fais tourner plusieurs agents en parallèle, planifie et centralise tes données.

- Console de gestion des données : Combine, filtre et nettoie tes jeux de données après extraction.

- Support entreprise : Gestionnaires de compte dédiés et services gérés pour les grosses équipes.

Les forfaits commencent à , avec des options pour plus d’utilisateurs et de puissance. Mozenda est top pour les boîtes qui ont besoin de données web fiables et répétables au quotidien.

10. BeautifulSoup

est la bibliothèque Python incontournable pour analyser HTML et XML. Ce n’est pas un extracteur web complet, mais elle est adorée des devs pour les petits projets sur-mesure.

est la bibliothèque Python incontournable pour analyser HTML et XML. Ce n’est pas un extracteur web complet, mais elle est adorée des devs pour les petits projets sur-mesure.

- Analyse HTML simple : Extrais facilement des données de pages statiques.

- Fonctionne avec Python Requests : À combiner avec d’autres bibliothèques pour le crawling.

- Flexible et léger : Parfait pour des scripts rapides ou l’apprentissage.

- Grande communauté : Plein de tutos et d’astuces sur Stack Overflow.

BeautifulSoup est , mais il faut coder et gérer soi-même la logique de crawling. Idéal pour les devs ou étudiants qui veulent comprendre les bases du web scraping.

Tableau comparatif : les extracteurs web en un clin d’œil

| Outil | Facilité d’utilisation | Niveau d’automatisation | Tarification | Options d’export | Idéal pour |

|---|---|---|---|---|---|

| Thunderbit | Ultra simple, sans code | Élevé (IA, sous-pages) | Essai gratuit, dès 15 $/mois | Excel, Sheets, Airtable, Notion, CSV | Commercial, marketing, e-commerce, non-tech |

| Octoparse | Moyenne, interface visuelle | Très élevé, cloud | Gratuit, 83–299 $/mois | CSV, Excel, JSON, API | Entreprises, data teams, sites dynamiques |

| Scrapy | Faible (Python requis) | Élevé (personnalisable) | Gratuit, open-source | Tout (via code) | Développeurs, projets personnalisés à grande échelle |

| ParseHub | Élevée, visuelle | Élevé (sites dynamiques) | Gratuit, dès 189 $/mois | CSV, Excel, JSON, API | Non-tech, structures web complexes |

| Apify | Moyenne, flexible | Très élevé, cloud | Gratuit, 29–999 $/mois | CSV, JSON, API, stockage cloud | Développeurs, entreprises, acteurs prêts à l’emploi ou sur-mesure |

| Data Miner | Ultra simple, navigateur | Faible (manuel) | Gratuit, 20–99 $/mois | CSV, Excel | Extractions rapides, petits volumes |

| Import.io | Moyenne, service géré | Très élevé, entreprise | Sur mesure, selon volume | CSV, JSON, API, intégration directe | Entreprises, intégration continue de données |

| WebHarvy | Élevée, desktop | Moyen (planification) | 129 $ paiement unique | Excel, CSV, XML, JSON, SQL | PME, utilisateurs Windows, extraction régulière |

| Mozenda | Moyenne, visuelle | Très élevé, cloud | 250–450+ $/mois | CSV, Excel, JSON, cloud, DB | Opérations métiers à grande échelle |

| BeautifulSoup | Faible (Python requis) | Faible (codage manuel) | Gratuit, open-source | Tout (via code) | Développeurs, étudiants, scripts personnalisés |

Comment choisir le bon extracteur web pour ton équipe

Le meilleur extracteur web, ce n’est pas forcément le plus puissant, mais celui qui colle à tes compétences, tes besoins et ton budget. Voilà mes conseils :

- Non-tech ou utilisateurs métiers : Thunderbit, ParseHub ou Data Miner pour des résultats immédiats et une prise en main facile.

- Besoins d’entreprise ou gros volumes : Octoparse, Mozenda ou Import.io pour l’automatisation, la planification et le support.

- Développeurs ou projets sur-mesure : Scrapy, Apify ou BeautifulSoup pour un contrôle total et la flexibilité.

- Petits budgets ou besoins ponctuels : WebHarvy (Windows) ou Data Miner (navigateur) sont économiques et simples.

Teste toujours tes outils préférés sur tes vrais sites cibles avec la version gratuite – ce qui marche sur un site peut ne pas marcher sur un autre. Pense aussi à l’intégration : si tu veux tes données dans Sheets, Notion ou une base, vérifie que l’outil le permet direct.

Conclusion : Passe à la vitesse supérieure avec les meilleurs extracteurs web

Les données web, c’est le nouveau pétrole – à condition d’avoir les bons outils pour les extraire et les exploiter. Grâce aux extracteurs web modernes, tu peux transformer des heures de recherche manuelle en quelques minutes d’analyse automatisée – pour booster tes ventes, affiner ton marketing et rendre tes opérations plus agiles. Que tu montes des listes de prospects, surveilles la concurrence ou en aies marre du copier-coller, il y a forcément un outil dans cette liste qui va te simplifier la vie.

Évalue les besoins de ton équipe, teste quelques outils et découvre tout ce que tu peux accomplir en laissant l’automatisation bosser pour toi. Et si tu veux voir à quoi ressemble une extraction IA en 2 clics, . Bonne extraction – et que tes données soient toujours fraîches, bien rangées et prêtes à l’emploi !

FAQ

1. C’est quoi un extracteur web et pourquoi j’en aurais besoin ?

Un extracteur web automatise la récupération d’infos sur les sites web. Ça fait gagner un temps fou, ça limite les erreurs et ça te donne des données à jour pour la vente, le marketing, la recherche ou les opérations – bien plus efficace que le copier-coller à la main.

2. Quel extracteur web est le plus adapté aux non-tech ?

Thunderbit, ParseHub et Data Miner sont les meilleurs choix pour les non-développeurs. Thunderbit se démarque avec son workflow IA en 2 clics, tandis que ParseHub propose une approche visuelle pour les sites plus complexes.

3. Comment varient les prix des extracteurs web ?

Les tarifs sont très variés : certains outils (Thunderbit, Data Miner) offrent des versions gratuites et des forfaits abordables, alors que les plateformes pour entreprises (Import.io, Mozenda) fonctionnent sur devis ou selon le volume. Vérifie toujours que le prix colle à tes vrais besoins.

4. Je peux programmer des extractions récurrentes avec ces outils ?

Oui – Thunderbit, Octoparse, Apify, Mozenda et Import.io permettent de planifier des extractions régulières, parfait pour la veille tarifaire, la génération de leads ou les études de marché.

5. Quels critères regarder avant de choisir un extracteur web ?

Regarde les compétences techniques de ton équipe, la complexité des sites à extraire, le volume de données, les besoins d’intégration et ton budget. Teste plusieurs outils sur tes cas concrets avant de te lancer.

Pour plus de guides pratiques, va voir le .

Pour aller plus loin