Imagine un peu la scène : tu te retrouves devant un site qui affiche des milliers de produits, et ton boss (ou ta passion pour la data) veut que tu rassembles tous les prix, noms et avis dans un tableau… pour hier. Tu pourrais passer des heures à faire du copier-coller, ou alors… laisser Python bosser à ta place. C’est là que l’extraction de données web entre en jeu, et crois-moi, ce n’est plus réservé aux geeks en hoodie ou aux ingénieurs de la Silicon Valley. Aujourd’hui, le web scraping est devenu une compétence clé, que tu sois commercial, agent immo ou analyste marché. Le marché mondial des logiciels d’extraction web pèse déjà plus de et devrait plus que doubler d’ici 2032. Autant dire que les opportunités sont énormes.

En tant que cofondateur de , j’ai accompagné pas mal d’entreprises dans l’automatisation de la collecte de données. Avant que des extracteurs IA comme ne rendent l’extraction web accessible en deux clics, j’ai moi-même galéré avec la stack Python classique : beautifulsoup, requests, et pas mal de tâtonnements. Dans ce guide, je vais te présenter beautifulsoup, comment l’installer et t’en servir, et pourquoi il reste une valeur sûre. Ensuite, je te montrerai comment des solutions IA comme Thunderbit révolutionnent la collecte de données (et t’évitent bien des prises de tête). Que tu sois débutant en Python, utilisateur métier ou juste curieux, suis le guide !

C’est quoi beautifulsoup ? Introduction à l’extraction web avec Python

On commence par la base. (souvent appelé BS4) est une librairie Python faite pour extraire des données de fichiers HTML et XML. Imagine un détective du HTML : tu lui files un code web en vrac, il te le range et te permet de fouiller dedans facilement. Extraire un nom de produit, un prix ou un avis devient alors super simple, il suffit de viser le bon tag ou la bonne classe.

beautifulsoup ne va pas chercher les pages web tout seul (c’est le job de bibliothèques comme requests), mais une fois le HTML récupéré, il te permet de fouiller, filtrer et extraire pile ce qu’il te faut. Pas étonnant que, d’après une étude récente, aient choisi beautifulsoup comme outil d’extraction préféré—devant toutes les autres bibliothèques.

On retrouve beautifulsoup dans des scripts pour la recherche académique, l’analyse e-commerce ou la génération de leads. J’ai vu des équipes marketing s’en servir pour lister des influenceurs, des recruteurs extraire des offres d’emploi, et même des journalistes automatiser leurs enquêtes. Flexible, tolérant aux erreurs et accessible dès qu’on a un peu de bases Python, il séduit un public très large.

Pourquoi choisir beautifulsoup ? Atouts et exemples concrets

Pourquoi autant d’entreprises et de passionnés de data se tournent vers beautifulsoup ? Voilà ce qui fait sa force :

- Automatisation des tâches répétitives : Pourquoi perdre ton temps à copier-coller quand un script peut tout faire ? beautifulsoup collecte des milliers de données en quelques minutes, te libérant pour des tâches plus intéressantes.

- Veille en temps réel : Programme des scripts pour surveiller les prix des concurrents, les stocks ou les news. Plus besoin de surveiller à la main : si un concurrent baisse ses prix, tu le sauras avant même ton café.

- Extraction sur mesure : Tu veux le top 10 des produits tendance, avec notes et avis ? beautifulsoup te donne un contrôle total sur ce que tu récupères et comment tu le traites.

- Gestion du HTML en vrac : Même si le code d’un site est un vrai puzzle, beautifulsoup arrive généralement à s’en sortir.

Quelques exemples d’utilisation concrets :

| Cas d’usage | Description | Résultat attendu |

|---|---|---|

| Génération de leads | Extraire emails et numéros depuis des annuaires ou LinkedIn | Constituer des listes de prospection ciblées |

| Veille tarifaire | Suivre les prix des concurrents sur les sites e-commerce | Ajuster vos propres tarifs en temps réel |

| Études de marché | Collecter avis, notes ou détails produits sur les boutiques en ligne | Détecter les tendances et orienter le développement produit |

| Données immobilières | Agréger les annonces de sites comme Zillow ou Realtor.com | Analyser les tendances de prix ou les opportunités d’investissement |

| Agrégation de contenus | Rassembler articles, posts de blog ou mentions sur les réseaux sociaux | Alimenter des newsletters ou des analyses de sentiment |

Et côté retour sur investissement ? Un distributeur britannique a utilisé le web scraping pour surveiller ses concurrents et . ASOS a doublé ses ventes à l’international en adaptant son marketing grâce aux prix locaux extraits. Bref : la donnée extraite influence directement les décisions business.

Premiers pas : Installer beautifulsoup en Python

Prêt à te lancer ? Voilà comment installer beautifulsoup :

Étape 1 : Installer beautifulsoup (la bonne version)

Vérifie bien d’installer la dernière version—beautifulsoup4 (bs4). Ne te trompe pas de nom de package !

1pip install beautifulsoup4Sur macOS ou Linux, il faudra peut-être utiliser pip3 ou ajouter sudo :

1sudo pip3 install beautifulsoup4Petit conseil : Si tu tapes pip install beautifulsoup (sans le « 4 »), tu auras l’ancienne version, pas compatible. Ça sent le vécu !

Étape 2 : Installer un parseur (optionnel mais recommandé)

beautifulsoup peut utiliser le parseur HTML de base de Python, mais pour plus de rapidité et de fiabilité, installe lxml et html5lib :

1pip install lxml html5libÉtape 3 : Installer Requests (pour récupérer les pages web)

beautifulsoup analyse le HTML, mais il faut d’abord le télécharger. La bibliothèque est la référence :

1pip install requestsÉtape 4 : Vérifier ton environnement Python

Assure-toi d’utiliser Python 3. Si tu bosses dans un IDE (PyCharm, VS Code), vérifie bien l’interpréteur. Si tu as une erreur d’import, c’est peut-être que les packages sont installés dans le mauvais environnement. Sous Windows, py -m pip install beautifulsoup4 permet de viser la bonne version de Python.

Étape 5 : Tester ton installation

Fais ce test rapide :

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("http://example.com").text

4soup = BeautifulSoup(html, "html.parser")

5print(soup.title)Si la balise <title> s’affiche, c’est tout bon !

Les bases de beautifulsoup : concepts clés et syntaxe

Voici les objets et notions à connaître avec beautifulsoup :

- Objet BeautifulSoup : Racine de l’arbre HTML analysé. Créé avec

BeautifulSoup(html, parser). - Tag : Représente une balise HTML ou XML (genre

<div>,<p>,<span>). Tu peux accéder à ses attributs, enfants et texte. - NavigableString : C’est le texte contenu dans une balise.

Comprendre l’arbre d’analyse

Imagine ton HTML comme un arbre généalogique : la balise <html> est l’ancêtre, <head> et <body> sont ses enfants, etc. beautifulsoup permet de naviguer dans cet arbre avec une syntaxe très « Python ».

Exemple :

1html = """

2<html>

3 <head><title>Ma page de test</title></head>

4 <body>

5 <p class="story">Il était une fois <b>trois petites sœurs</b>...</p>

6 </body>

7</html>

8"""

9soup = BeautifulSoup(html, "html.parser")

10# Accéder à la balise title

11print(soup.title) # <title>Ma page de test</title>

12print(soup.title.string) # Ma page de test

13# Accéder à la première balise <p> et à son attribut de classe

14p_tag = soup.find('p', class_='story')

15print(p_tag['class']) # ['story']

16# Récupérer tout le texte de la balise <p>

17print(p_tag.get_text()) # Il était une fois trois petites sœurs...Navigation et recherche

- Accesseurs d’éléments :

soup.head,soup.body,tag.parent,tag.children - find() / find_all() : Recherche de balises par nom ou attributs.

- select() : Utilisation de sélecteurs CSS pour des requêtes plus complexes.

Exemple :

1# Trouver tous les liens

2for link in soup.find_all('a'):

3 print(link.get('href'))

4# Exemple avec un sélecteur CSS

5for item in soup.select('div.product > span.price'):

6 print(item.get_text())Pratique : crée ton premier extracteur web avec beautifulsoup

Passons à la pratique. Imaginons que tu veuilles extraire les titres et prix de produits sur une page de résultats e-commerce (prenons Etsy comme exemple). Voilà comment faire :

Étape 1 : Récupérer la page web

1import requests

2from bs4 import BeautifulSoup

3url = "https://www.etsy.com/search?q=clothes"

4headers = {"User-Agent": "Mozilla/5.0"} # Certains sites exigent un user-agent

5resp = requests.get(url, headers=headers)

6soup = BeautifulSoup(resp.text, 'html.parser')Étape 2 : Analyser et extraire les données

Imaginons que chaque produit soit dans un bloc <li class="wt-list-unstyled">, avec le titre dans <h3 class="v2-listing-card__title"> et le prix dans <span class="currency-value">.

1items = []

2for item in soup.find_all('li', class_='wt-list-unstyled'):

3 title_tag = item.find('h3', class_='v2-listing-card__title')

4 price_tag = item.find('span', class_='currency-value')

5 if title_tag and price_tag:

6 title = title_tag.get_text(strip=True)

7 price = price_tag.get_text(strip=True)

8 items.append((title, price))Étape 3 : Sauvegarder en CSV ou Excel

Avec le module csv de Python :

1import csv

2with open("etsy_products.csv", "w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Titre du produit", "Prix"])

5 writer.writerows(items)Ou avec :

1import pandas as pd

2df = pd.DataFrame(items, columns=["Titre du produit", "Prix"])

3df.to_csv("etsy_products.csv", index=False)Et voilà, tu as un tableau prêt à être analysé, partagé ou exploité.

Les limites de beautifulsoup : maintenance, anti-bot et autres galères

Soyons clairs : aussi pratique soit-il, beautifulsoup a ses limites, surtout pour des extractions à grande échelle ou sur la durée.

1. Fragilité face aux changements de site

Les sites web changent souvent de structure, de noms de classes ou d’ordre des éléments. Ton script beautifulsoup ? Il dépend entièrement des sélecteurs que tu as écrits. Si le HTML bouge, ton script peut casser—parfois sans prévenir. Si tu scrapes des dizaines (ou centaines) de sites, maintenir tous ces scripts devient vite un vrai casse-tête.

2. Mesures anti-scraping

Les sites modernes mettent en place plein d’obstacles : CAPTCHAs, blocages d’IP, limitations de fréquence, contenus dynamiques chargés en JavaScript, etc. beautifulsoup ne gère pas ça tout seul. Il faut ajouter des proxys, des navigateurs sans interface graphique, voire des solveurs de CAPTCHA externes. C’est un vrai jeu du chat et de la souris avec les admins de sites.

3. Passage à l’échelle et performance

beautifulsoup est top pour des scripts ponctuels ou des extractions modérées. Mais pour traiter des millions de pages ou bosser en parallèle, il faut ajouter du code pour la gestion des erreurs, la concurrence, l’infra… C’est faisable, mais ça demande du boulot.

4. Barrière technique

Soyons honnêtes : si tu n’es pas à l’aise avec Python, le HTML et le débogage, beautifulsoup peut faire peur. Même pour les devs expérimentés, l’extraction web, c’est souvent un cycle d’inspection, de code, de test, d’ajustement…

5. Aspects légaux et éthiques

L’extraction de données peut parfois flirter avec la zone grise juridique, surtout si on ignore le robots.txt ou les conditions d’utilisation. Avec le code, c’est à toi de respecter les règles : limiter la fréquence, suivre les politiques des sites et traiter les données de façon responsable.

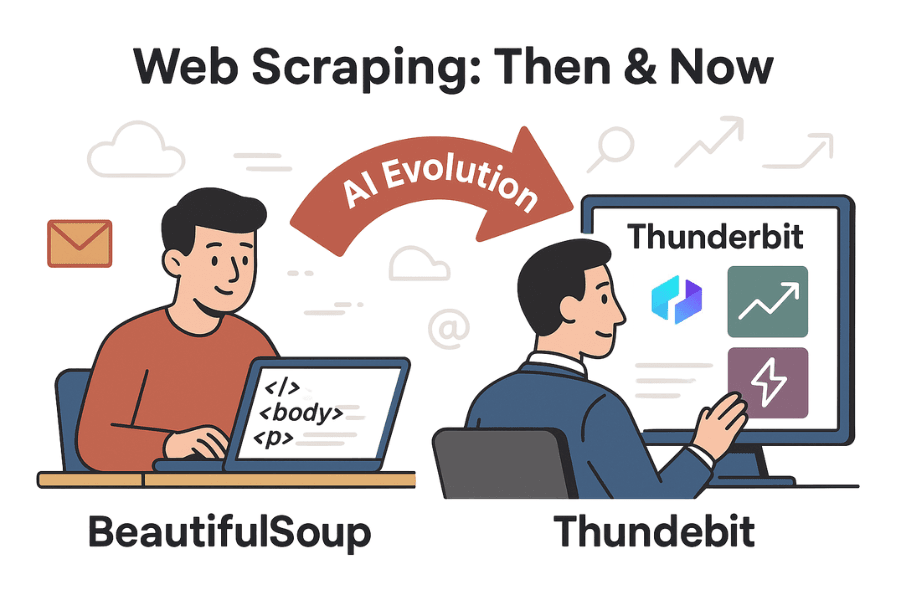

Au-delà de beautifulsoup : comment l’IA avec Thunderbit simplifie l’extraction web

C’est là que ça devient vraiment intéressant. Grâce à l’IA, des outils comme rendent l’extraction web accessible à tous—plus besoin d’être codeur.

Thunderbit, c’est une extension Chrome boostée à l’IA qui te permet d’extraire des données de n’importe quel site en deux clics. Pas de Python, pas de sélecteurs, pas de maintenance. Tu ouvres la page, tu cliques sur « Suggérer les champs IA », et l’IA de Thunderbit repère automatiquement les données utiles (noms de produits, prix, avis, emails, numéros de téléphone, etc.). Ensuite, tu cliques sur « Extraire » et c’est dans la poche.

Thunderbit vs. beautifulsoup : le match

| Fonctionnalité | BeautifulSoup (avec code) | Thunderbit (IA sans code) |

|---|---|---|

| Difficulté de mise en place | Nécessite de coder en Python, connaître le HTML et déboguer | Aucun code—l’IA détecte les champs, interface intuitive |

| Vitesse d’obtention des données | Plusieurs heures (écriture et tests du code) | Quelques minutes (2–3 clics) |

| Adaptabilité aux changements | Casse si le HTML du site change ; mise à jour manuelle requise | L’IA s’adapte à de nombreux changements ; modèles maintenus pour les sites populaires |

| Pagination / sous-pages | Boucles et requêtes manuelles pour chaque page | Pagination et sous-pages intégrées—un simple bouton à activer |

| Gestion des anti-bots | Nécessite d’ajouter des proxys, gérer les CAPTCHAs, simuler un navigateur | De nombreux obstacles gérés en interne ; le contexte navigateur limite les blocages |

| Traitement des données | Contrôle total via le code, mais à écrire soi-même | IA intégrée pour résumer, catégoriser, traduire et nettoyer les données |

| Exportation | Code personnalisé pour CSV, Excel, base de données, etc. | Export en un clic vers CSV, Excel, Google Sheets, Airtable, Notion |

| Scalabilité | Illimitée si tu gères l’infra ; à toi de gérer erreurs, reprises et montée en charge | Élevée—cloud/extension gère la charge, la planification et les gros volumes (selon l’abonnement) |

| Coût | Gratuit (open source), mais coûte du temps et de la maintenance | Freemium (gratuit pour petits volumes, payant pour l’échelle), mais fait gagner énormément de temps |

| Flexibilité | Maximum—le code permet tout, si tu es prêt à le développer | Couvre la majorité des besoins standards ; certains cas spécifiques nécessitent du code |

Pour aller plus loin, jette un œil au et à la .

Pas à pas : extraire des données avec Thunderbit vs. beautifulsoup

Comparons les étapes pour extraire des données produits sur un site e-commerce.

Avec beautifulsoup

- Inspecter la structure HTML du site avec les outils développeur du navigateur.

- Écrire du code Python pour télécharger la page (

requests), l’analyser (beautifulsoup) et extraire les champs voulus. - Ajuster les sélecteurs (noms de classes, chemins de balises) jusqu’à obtenir les bonnes données.

- Gérer la pagination en codant des boucles pour suivre les liens « Suivant ».

- Exporter les données en CSV ou Excel avec du code en plus.

- Si le site change, rebelote : on recommence les étapes 1 à 5.

Temps estimé : 1 à 2 heures pour un nouveau site (plus si tu tombes sur des blocages anti-bot).

Avec Thunderbit

- Ouvre le site cible dans Chrome.

- Clique sur l’extension Thunderbit.

- Clique sur « Suggérer les champs IA »—l’IA propose des colonnes comme Nom du produit, Prix, etc.

- Ajuste les colonnes si besoin, puis clique sur « Extraire ».

- Active la pagination ou l’extraction de sous-pages si nécessaire.

- Prévisualise les données dans un tableau, puis exporte au format voulu.

Temps estimé : 2 à 5 minutes. Aucun code, pas de débogage, pas de maintenance.

Bonus : Thunderbit peut aussi extraire emails, numéros de téléphone, images, et même remplir automatiquement des formulaires. C’est comme avoir un assistant turbo qui ne râle jamais sur les tâches répétitives.

Conclusion & points clés à retenir

L’extraction web est passée d’un truc de geek à un outil business incontournable, aussi bien pour la prospection que pour la veille marché. reste une super porte d’entrée pour qui maîtrise un peu Python, offrant flexibilité et contrôle pour des projets sur mesure. Mais à mesure que les sites se complexifient—et que les utilisateurs métiers veulent des résultats rapides et simples—des outils IA comme changent la donne.

Si tu aimes coder et veux un projet 100 % sur-mesure, beautifulsoup reste la référence. Mais si tu veux aller droit au but, éviter la maintenance et obtenir des résultats en quelques minutes, Thunderbit est la solution parfaite. Pourquoi passer des heures à développer alors que l’IA peut régler le problème en un clin d’œil ?

Envie de tester ? Télécharge l’, ou découvre d’autres tutos sur le . Et si tu veux continuer à explorer Python, amuse-toi avec beautifulsoup—mais pense à ménager tes poignets après toutes ces lignes de code !

Bonne extraction !

Pour aller plus loin :

Des questions, des anecdotes ou envie de partager tes galères d’extraction ? Laisse un commentaire ou contacte-nous. Je parie que j’ai déjà cassé plus de scripts que la plupart n’en ont écrit !