La web está llena de datos, y si llevas un negocio en 2025, ya sabes que quien consigue primero la mejor información suele tomar la delantera. Ya sea en ventas, e-commerce, operaciones o investigación de mercado, la capacidad de extraer datos de sitios web —a gran escala y cuando los necesitas— se ha convertido en una ventaja competitiva silenciosa pero poderosa. Python se ha ganado el puesto de favorito para esta tarea, con casi eligiéndolo para el raspado web, gracias a su ecosistema de librerías y su fama de ser potente y fácil de usar.

Pero ojo, aunque Python es la navaja suiza del raspado web, no es la única alternativa. Herramientas sin código como están abriendo la puerta para que cualquiera —sí, incluso si no sabes programar— pueda raspar, limpiar y organizar datos web en minutos. En esta guía te voy a mostrar ambos caminos: el clásico con Python (Requests, Beautiful Soup, Selenium, Scrapy, Pandas) y cómo Thunderbit puede llevar tu productividad al siguiente nivel. Te compartiré ejemplos prácticos, casos reales y algunos trucos que he aprendido. ¡Vamos al lío!

¿Qué significa "Python pull data from website"?

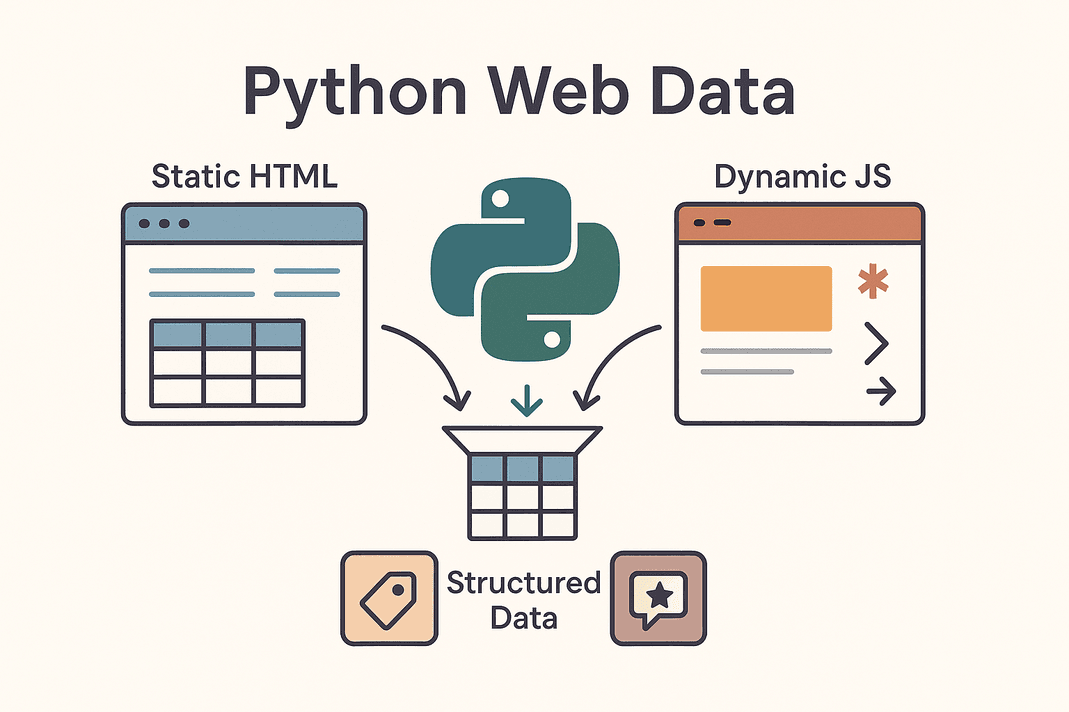

En pocas palabras, “python pull data from website” es usar scripts en Python para conseguir y extraer automáticamente información de páginas web—transformando HTML caótico en datos ordenados y útiles. A esto se le llama raspado web. En vez de copiar y pegar precios, contactos o reseñas a mano, dejas que Python haga el trabajo duro.

En pocas palabras, “python pull data from website” es usar scripts en Python para conseguir y extraer automáticamente información de páginas web—transformando HTML caótico en datos ordenados y útiles. A esto se le llama raspado web. En vez de copiar y pegar precios, contactos o reseñas a mano, dejas que Python haga el trabajo duro.

Te vas a topar con dos tipos de sitios web:

- Sitios estáticos: Todo el contenido viene en el HTML inicial. Lo que ves en “Ver código fuente” es lo que hay. Raspado fácil: solo descargas el HTML y lo analizas.

- Sitios dinámicos: Usan JavaScript para cargar datos después de que la página aparece. Piensa en scroll infinito, precios en tiempo real o contenido que sale tras hacer clic. Aquí necesitas herramientas más avanzadas—simular un navegador con Selenium o buscar las APIs ocultas que alimentan el sitio ().

Los objetivos más comunes del raspado web son tablas de productos, listas de prospectos, precios, reseñas, imágenes y más. Ya sea para armar una base de leads, monitorear precios de la competencia o analizar opiniones del mercado, Python te ayuda a convertir la web en tu propio lago de datos.

¿Por qué las empresas usan Python para extraer datos de sitios web?

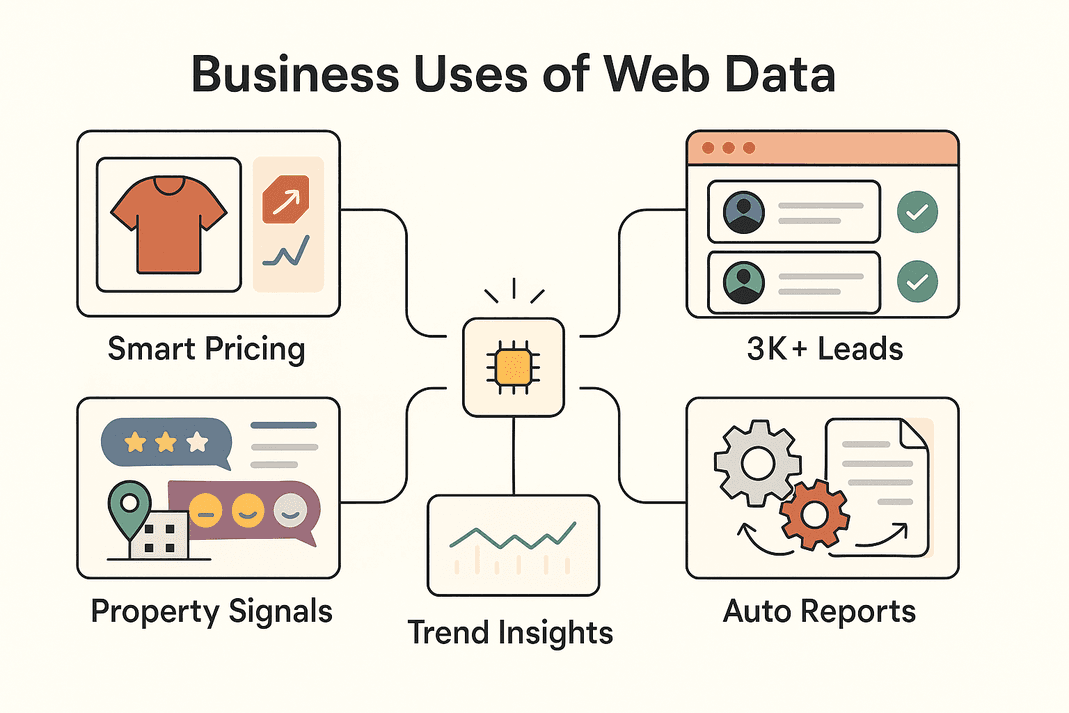

Vamos a lo que importa. ¿Por qué tantas empresas apuestan por el raspado web? Aquí tienes algunos de los principales usos—y el valor que aportan:

| Caso de negocio | Datos extraídos | ROI / Beneficio |

|---|---|---|

| Generación de leads (Ventas) | Información de contacto de directorios, redes sociales | 3,000+ leads/mes, ~8 horas/semana ahorradas por representante (Thunderbit)) |

| Monitoreo de precios (E-commerce) | Precios de productos, niveles de stock | ~4% aumento en ventas, 30% menos tiempo de análisis (blog.apify.com) |

| Investigación de mercado | Reseñas, publicaciones sociales, comentarios en foros | Mejor segmentación; 26% de los raspadores buscan datos sociales (Thunderbit) |

| Listados inmobiliarios | Datos de propiedades, comparables, estadísticas de ubicación | Descubrimiento de oportunidades más rápido, comparables actualizados |

| Automatización de operaciones | Inventario, reportes, datos repetitivos | 10–50% de ahorro de tiempo en tareas manuales |

En resumen: raspar datos web con Python (o Thunderbit) ayuda a los equipos a moverse más rápido, tomar mejores decisiones y automatizar tareas repetitivas que antes se llevaban horas. No es raro que y siga creciendo a toda máquina.

Herramientas esenciales de Python para extraer datos de sitios web

La fama de Python en el raspado web viene de su ecosistema. Aquí tienes un resumen de las herramientas más populares y cuándo usarlas:

| Herramienta | Ideal para | Ventajas | Desventajas |

|---|---|---|---|

| Requests | Obtener HTML estático o APIs | Simple, rápido, ideal para principiantes | No maneja JavaScript |

| Beautiful Soup | Analizar HTML/XML y estructurar datos | Fácil de usar, flexible | Necesita HTML, no sirve para sitios JS |

| Selenium | Sitios dinámicos/con JS, logins, clics | Puede con todo lo que ve un navegador | Más lento, requiere configuración, más pesado |

| Scrapy | Raspados a gran escala, múltiples páginas | Rápido, asíncrono, robusto, escalable | Curva de aprendizaje, no maneja JS por defecto |

| Thunderbit | Sin código/bajo código, usuarios de negocio | Potenciado por IA, maneja JS, exporta fácil | Menos personalizable para lógica avanzada |

En la práctica, los proyectos suelen mezclar varias: Requests + Beautiful Soup para lo sencillo, Selenium para sitios dinámicos, Scrapy para grandes volúmenes y Thunderbit cuando buscas rapidez y facilidad.

Paso 1: Usar Python Requests para extraer datos de sitios web

Vamos con lo básico. Requests es la herramienta principal para conseguir páginas web en Python. Así se usa:

-

Instala Requests:

1pip install requests -

Consigue una página:

1import requests 2url = "https://example.com/products" 3response = requests.get(url) 4if response.status_code == 200: 5 html_content = response.text 6else: 7 print(f"No se pudo obtener la información: {response.status_code}")()

-

Tips para solucionar problemas:

- Añade headers para simular un navegador:

1headers = {"User-Agent": "Mozilla/5.0"} 2response = requests.get(url, headers=headers) - Maneja errores con

response.raise_for_status() - Para APIs que devuelven JSON:

data = response.json()

- Añade headers para simular un navegador:

Requests es ideal para páginas estáticas o APIs. Si te falta información, probablemente se carga con JavaScript—es momento de usar Selenium.

Paso 2: Analizar el contenido web con Beautiful Soup

Ya tienes el HTML, ahora Beautiful Soup te ayuda a sacar lo que importa. Así va:

-

Instala Beautiful Soup:

1pip install beautifulsoup4 -

Analiza el HTML:

1from bs4 import BeautifulSoup 2soup = BeautifulSoup(html_content, 'html.parser') -

Extrae datos:

- Encuentra todas las tarjetas de producto:

1for product in soup.select('div.product-card'): 2 name = product.select_one('.product-name').text.strip() 3 price = product.select_one('.product-price').text.strip() 4 print(name, price) - Para tablas:

1for row in soup.find_all('tr'): 2 cells = row.find_all('td') 3 # Extrae los datos de cada celda según lo necesites

- Encuentra todas las tarjetas de producto:

Tips:

- Usa las herramientas de desarrollador del navegador para inspeccionar el HTML y encontrar los selectores correctos.

- Usa

.get_text()o.textpara sacar el texto. - Maneja datos faltantes con comprobaciones (

if price_elem else "N/A").

Requests + Beautiful Soup es la dupla clásica del raspado web—simple, confiable y perfecta para la mayoría de sitios estáticos.

Paso 3: Gestionar contenido dinámico con Selenium

Cuando un sitio carga datos con JavaScript, necesitas una herramienta que actúe como un usuario real. Aquí entra Selenium.

-

Instala Selenium:

1pip install seleniumDescarga el driver del navegador que uses (por ejemplo, ChromeDriver) y ponlo en tu PATH.

-

Automatiza el navegador:

1from selenium import webdriver 2driver = webdriver.Chrome() 3driver.get("https://example.com/products") 4products = driver.find_elements_by_class_name("product-card") 5for prod in products: 6 print(prod.text) 7driver.quit() -

Gestiona logins y clics:

1driver.get("https://site.com/login") 2driver.find_element_by_name("username").send_keys("myuser") 3driver.find_element_by_name("password").send_keys("mypassword") 4driver.find_element_by_id("login-button").click() -

Espera por contenido dinámico:

1from selenium.webdriver.common.by import By 2from selenium.webdriver.support.ui import WebDriverWait 3from selenium.webdriver.support import expected_conditions as EC 4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CLASS_NAME, "data-row"))) -

Modo headless (sin ventana):

1options = webdriver.ChromeOptions() 2options.add_argument("--headless") 3driver = webdriver.Chrome(options=options)

Selenium es potente pero más pesado—perfecto para sitios que requieren automatización de navegador.

Paso 4: Escalar con Scrapy para extracciones masivas

Cuando tienes que recorrer cientos o miles de páginas, Scrapy es tu mejor amigo.

-

Instala Scrapy:

1pip install scrapy 2scrapy startproject myproject -

Crea un spider:

1import scrapy 2class ProductsSpider(scrapy.Spider): 3 name = "products" 4 start_urls = ["https://example.com/category?page=1"] 5 def parse(self, response): 6 for product in response.css("div.product-card"): 7 yield { 8 'name': product.css(".product-title::text").get().strip(), 9 'price': product.css(".price::text").get().strip(), 10 } 11 next_page = response.css("a.next-page::attr(href)").get() 12 if next_page: 13 yield response.follow(next_page, self.parse) -

Ejecuta el spider:

1scrapy crawl products -o products.csv

Scrapy es asíncrono, rápido y pensado para escalar. Es ideal para recorrer sitios completos o manejar paginación compleja.

Paso 5: Potencia la extracción de datos con Thunderbit

Ahora hablemos de —el Raspador Web IA sin código que está cambiando la forma en que los equipos de negocio acceden a los datos.

- Sugerencia de campos por IA: Thunderbit analiza la página y te sugiere las mejores columnas para extraer—sin que tengas que buscar en el HTML.

- Maneja páginas dinámicas: Ve la página igual que tú, así que JavaScript, scroll infinito y logins no son problema.

- Raspado de subpáginas: Thunderbit puede entrar en cada detalle y enriquecer tu base de datos automáticamente.

- Plantillas predefinidas: Para sitios populares como Amazon, Zillow o Shopify, usa plantillas listas para usar—sin configurar nada.

- Extractores de un clic: ¿Necesitas todos los emails o teléfonos de una página? Thunderbit lo hace en segundos.

- Programación y raspado en la nube: Configura extracciones recurrentes con lenguaje natural (“cada lunes a las 9am”) y deja que la nube de Thunderbit procese hasta 50 páginas a la vez.

- Exporta a cualquier parte: Manda tus datos a Excel, Google Sheets, Airtable, Notion o descárgalos como CSV/JSON—gratis y sin límites.

Thunderbit es ideal para equipos que necesitan datos rápido, sin escribir código. Incluso puedes usar Thunderbit para extraer datos y luego analizarlos en Python—lo mejor de los dos mundos.

Paso 6: Limpieza y análisis de datos extraídos con Pandas

Ya tienes tus datos (sea con Python o Thunderbit), ahora toca limpiarlos y analizarlos con Pandas.

-

Carga tus datos:

1import pandas as pd 2df = pd.read_csv("products.csv") 3print(df.head()) -

Limpia tus datos:

- Elimina duplicados:

1df = df.drop_duplicates() - Gestiona valores faltantes:

1df = df.fillna("N/A") - Estandariza formatos (por ejemplo, precios):

1df['price'] = df['price'].str.replace('$','').str.replace(',','').astype(float)

- Elimina duplicados:

-

Analiza:

- Saca estadísticas:

1print(df.describe()) - Agrupa por categoría:

1avg_price = df.groupby('category')['price'].mean() 2print(avg_price)

- Saca estadísticas:

Pandas es tu navaja suiza para convertir datos web en información útil para el negocio.

Paso 7: Organiza y almacena los datos extraídos para tu empresa

Ya tienes los datos limpios—ahora hazlos útiles para tu equipo.

- CSV/Excel: Usa

df.to_csv("out.csv", index=False)odf.to_excel("out.xlsx")para compartir fácil. - Google Sheets: Usa la exportación de o la librería

gspreadde Python. - Bases de datos: Para grandes volúmenes, usa

df.to_sql()para guardar en bases de datos SQL. - Automatización: Configura scripts o programaciones en Thunderbit para mantener los datos frescos.

- Buenas prácticas: Añade siempre fecha/hora a tus datos, documenta las columnas y controla el acceso si hay información sensible.

La clave es adaptar el almacenamiento a cómo trabaja tu equipo—hojas de cálculo para resultados rápidos, bases de datos para escalar.

Thunderbit vs. Programación en Python: ¿Qué opción le conviene a tu equipo?

Vamos a comparar:

| Factor | Thunderbit (IA sin código) | Librerías Python (Código) |

|---|---|---|

| Habilidades requeridas | Ninguna (interfaz web) | Se necesita programar en Python |

| Tiempo de configuración | Minutos (sugerencias IA, extracción instantánea) | Horas o días (código, depuración, configuración) |

| Maneja JS/Interactividad | Sí, integrado (modos navegador/nube) | Sí, pero requiere Selenium/Playwright |

| Mantenimiento | Bajo—la IA se adapta a muchos cambios de sitio | Manual—actualizar código si el sitio cambia |

| Escalabilidad | Moderada (rápido para decenas o cientos de páginas en la nube) | Alta (Scrapy escala a miles+) |

| Personalización | Opciones en la interfaz y prompts de IA | Ilimitada (cualquier lógica, cualquier integración) |

| Anti-bot/Proxies | Gestionado internamente | Debes implementarlo manualmente |

| Exportación de datos | 1 clic a Sheets, Excel, Notion, Airtable | Se requiere código personalizado |

| Ideal para | Usuarios no técnicos, resultados rápidos, mínimo mantenimiento | Desarrolladores, proyectos complejos o grandes |

Tip: Usa Thunderbit para resultados rápidos y dale poder a tu equipo de negocio. Usa Python cuando necesites personalización avanzada o escalar a lo grande. Muchos equipos combinan ambos: Thunderbit para validar y conseguir datos rápido, Python para automatizar o escalar después.

Aplicaciones empresariales reales de la extracción de datos web

Así aplican estas herramientas los equipos en la vida real:

Así aplican estas herramientas los equipos en la vida real:

- E-commerce: John Lewis al raspar precios de la competencia y ajustar los suyos en tiempo real.

- Ventas: Los equipos extraen más de 3,000 leads al mes, ahorrando 8 horas semanales por representante ())—adiós a la investigación manual.

- Investigación de mercado: Los equipos de marketing recopilan miles de reseñas o publicaciones sociales para análisis de sentimiento y detectar tendencias antes que los dashboards.

- Inmobiliaria: Los agentes extraen listados para detectar propiedades infravaloradas u oportunidades de mercado—más rápido que esperar actualizaciones del MLS.

- Automatización de procesos: Los equipos de operaciones automatizan revisiones de inventario, generación de reportes o incluso FAQs de soporte extrayendo datos de sitios internos o de socios.

Muchas veces, el flujo de trabajo es mixto: Thunderbit para conseguir los datos, Python para limpiar y analizar, y luego exportar a Sheets o una base de datos para el equipo.

Conclusión y puntos clave

Extraer datos de sitios web con Python (y Thunderbit) es una habilidad clave para los equipos modernos. Aquí va el resumen:

- Requests + Beautiful Soup: Perfectos para sitios estáticos, rápidos y sencillos.

- Selenium: Para sitios dinámicos, con JavaScript o que requieren login.

- Scrapy: Para extracciones a gran escala y múltiples páginas.

- Thunderbit: Para raspado sin código, potenciado por IA—rápido, fácil e ideal para usuarios de negocio.

- Pandas: Para limpiar, analizar y sacar valor a tus datos.

- Exporta inteligentemente: Usa CSV, Sheets o bases de datos—lo que mejor se adapte a tu flujo de trabajo.

¿El mejor camino? Empieza con la herramienta que se ajuste a tu nivel técnico y necesidades de negocio. Combina y adapta según vayas creciendo. Y si quieres ver lo fácil que puede ser el raspado web, o visita el para más guías.

¡Feliz raspado! Que tus datos siempre estén limpios, ordenados y listos para la acción.

Preguntas frecuentes

1. ¿Cuál es la forma más sencilla de extraer datos de un sitio web usando Python?

Para sitios estáticos, usa Requests para conseguir el HTML y Beautiful Soup para analizar y extraer los datos que necesitas. Para sitios dinámicos, seguramente necesitarás Selenium.

2. ¿Cuándo debería usar Thunderbit en vez de código Python?

Thunderbit es ideal cuando necesitas datos rápido, no quieres programar o necesitas manejar páginas dinámicas, subpáginas o exportaciones instantáneas a Sheets/Excel. Es perfecto para usuarios de negocio o proyectos urgentes.

3. ¿Cómo gestiono sitios que cargan datos con JavaScript?

Usa Selenium (o Playwright) para automatizar un navegador, o prueba el modo navegador/nube de Thunderbit, que maneja JS automáticamente.

4. ¿Cuál es la mejor forma de limpiar y analizar los datos extraídos?

Importa tus datos en Pandas, elimina duplicados, gestiona valores faltantes, estandariza formatos y usa groupby o describe para obtener insights rápidos.

5. ¿Es legal y seguro el raspado web para uso empresarial?

En general, extraer datos públicos es legal, pero revisa siempre los términos de uso y el robots.txt del sitio. Evita raspar datos personales sin consentimiento y sé respetuoso con los recursos del sitio. Tanto Thunderbit como Python permiten prácticas de raspado ético.

¿Listo para llevar tus datos al siguiente nivel? o ponte manos a la obra con Python—de cualquier forma, tendrás datos valiosos en poco tiempo.

Más información