Voy a serte completamente sincero: la primera vez que armé un raspador web sentí que había desbloqueado un superpoder secreto. De pronto, todas esas horas copiando y pegando datos de páginas para buscar leads o comparar precios quedaron atrás. Y es que, crear tu propio raspador web con Python es casi como un bautizo para cualquiera que quiera automatizar tareas repetitivas en internet. Si trabajas en una empresa, puede ser la diferencia entre quedarte el viernes peleando con hojas de cálculo o salir a tiempo a tomar algo con los amigos.

En este tutorial te voy a mostrar paso a paso cómo crear un raspador web con Python, con ejemplos de código reales que podés usar ya mismo. Y después, te voy a contar por qué, para la mayoría de los equipos de negocio, hay una alternativa mucho más simple: usar un que hace todo en dos clics, sin que tengas que programar nada. Seas fan de Python o solo quieras los datos sin vueltas, acá vas a encontrar la mejor opción para vos.

¿Qué es el Web Scraping con Python? Una explicación fácil

Arranquemos por lo básico. Web scraping es simplemente el proceso de recolectar información de páginas web de manera automática. Imaginá que tenés un robot haciendo todo el trabajo de copiar y pegar—solo que este robot nunca se cansa ni te pide aumento.

Un raspador web es un script o programa que:

- Entra a una página web (como lo haría tu navegador)

- Saca datos específicos (como nombres de productos, precios o contactos)

- Guarda esa info en un formato ordenado (por ejemplo, una hoja de cálculo o un archivo JSON)

Python es el lenguaje preferido para esto porque es fácil de leer, tiene un montón de librerías útiles y es como la navaja suiza de la programación. De hecho, .

El paso a paso básico es:

- Conseguir la página web (descargar el HTML)

- Analizar el HTML para encontrar los datos que te interesan

- Guardar los resultados en algún lugar útil

Es como hacer una torta: conseguís los ingredientes (HTML), elegís lo que te sirve (datos) y lo servís (exportás).

¿Por qué el Web Scraping es clave para los equipos de negocio?

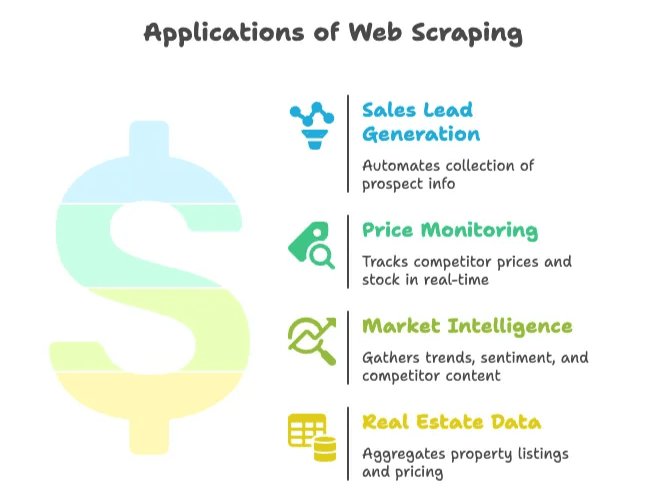

El web scraping no es solo para programadores o fanáticos de los datos. Hoy es fundamental para ventas, marketing, ecommerce, inmobiliarias y cualquier área que necesite datos frescos y confiables para tomar decisiones. El , y crece un 28% cada año. Eso es muchísimo dato… y un montón de oportunidades.

Mirá algunos casos reales en empresas:

| Caso de uso | Beneficio | Ejemplo de resultado |

|---|---|---|

| Generación de leads de ventas | Automatiza la recolección de prospectos desde directorios o redes sociales | Ahorro de ~8 horas/semana por comercial; 3.000 leads/mes extraídos, crecimiento de ventas 10× en 3 meses |

| Monitoreo de precios | Seguimiento en tiempo real de precios y stock de la competencia | Reducción del 30% en tiempo de recolección; aumento del 4% en ventas gracias a precios más inteligentes |

| Inteligencia de mercado | Recopila tendencias, opiniones y contenido de competidores para análisis | Más del 70% de las empresas dependen de datos extraídos de la web para inteligencia de mercado |

| Datos inmobiliarios | Agrupa anuncios y precios de propiedades de varios portales | Empresas extraen datos de Zillow/Trulia para anticiparse a cambios en el mercado local |

En resumen: el web scraping te ahorra tiempo, reduce el trabajo manual y te da ventaja competitiva. Si seguís copiando y pegando, probablemente tu competencia ya te sacó varios cuerpos de ventaja.

Antes de empezar: Herramientas y conocimientos para crear un raspador web

Antes de meterte de lleno a programar, veamos qué necesitás tener a mano.

Lo básico

- Python instalado: Bajate la última versión () y asegurate de poder correr

pythonen tu terminal. - Editor de código: VS Code, PyCharm o hasta Notepad++ sirven. Yo prefiero VS Code porque tiene muy buen soporte para Python.

- Entorno virtual: No es obligatorio, pero sí recomendable para tener tus dependencias ordenadas. Lo creás con

python -m venv venv.

Librerías clave de Python

- Requests: Para descargar páginas web ().

- BeautifulSoup: Para analizar HTML y buscar elementos ().

- Selenium: Para páginas que cargan contenido con JavaScript ().

Instalalas con:

1pip install requests beautifulsoup4 lxml seleniumEntender el HTML

No hace falta que seas desarrollador web, pero sí que sepas inspeccionar el HTML de una página. Hacé clic derecho, elegí “Inspeccionar” y vas a ver la estructura del DOM. Ahí están las etiquetas y clases que tu raspador tiene que buscar ().

Paso a paso: cómo crear un raspador web con Python

Vamos a ponernos manos a la obra y armar un raspador sencillo desde cero. Te muestro con un ejemplo real: extraer titulares de noticias o listados de productos. Después lo podés adaptar a lo que necesites.

Configurá tu entorno de Python

Primero, creá una carpeta para el proyecto y un entorno virtual:

1mkdir mi-raspador

2cd mi-raspador

3python -m venv venv

4# Activá el entorno virtual:

5# En Windows:

6venv\Scripts\activate

7# En macOS/Linux:

8source venv/bin/activateInstalá las librerías:

1pip install requests beautifulsoup4 lxmlCreá un archivo llamado scraper.py y abrilo en tu editor.

Descargar y analizar páginas web

Vamos a descargar el HTML de un sitio de ejemplo. Uso (un clásico para demos de scraping).

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content

7else:

8 print(f"Request failed with status {response.status_code}")

9 exit()Ahora, analizá el HTML con BeautifulSoup:

1soup = BeautifulSoup(html_content, "html.parser")

2print(soup.title.string) # Debería mostrar "Hacker News"Extraer los datos que necesitás

Supongamos que querés sacar todos los títulos de las noticias y sus enlaces. Si inspeccionás la página, vas a ver que cada título está en una etiqueta <a class="storylink">.

1stories = soup.find_all('a', class_='storylink')

2data = []

3for story in stories:

4 title = story.get_text()

5 link = story['href']

6 data.append({"title": title, "url": link})

7 print(title, "->", link)Si estuvieras extrayendo productos, buscarías algo como <div class="product-item"> y sacarías los campos internos. Un patrón genérico sería:

1products = soup.find_all('div', class_='product-item')

2for prod in products:

3 name = prod.find('h2').get_text()

4 price = prod.find('span', class_='price').get_text()

5 url = prod.find('a')['href']

6 data.append({"name": name, "price": price, "url": url})Guardar los datos extraídos en CSV o JSON

Ahora, guardá los datos para poder usarlos fácil.

En CSV:

1import csv

2with open("output.csv", mode="w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "URL"])

5 for item in data:

6 writer.writerow([item["title"], item["url"]])En JSON:

1import json

2with open("output.json", mode="w", encoding="utf-8") as f:

3 json.dump(data, f, indent=2)Abrí tu CSV en Excel o el JSON en cualquier editor de texto—y listo, acabás de automatizar horas de trabajo manual.

Nivel avanzado: paginación y contenido dinámico

La mayoría de los sitios reales no entran en una sola página. Así podés encarar escenarios más complejos.

Paginación

Si el sitio usa paginación en la URL (por ejemplo, ?page=2), podés recorrer los números de página:

1base_url = "https://example.com/products?page="

2for page_num in range(1, 6):

3 url = base_url + str(page_num)

4 resp = requests.get(url)

5 if resp.status_code != 200:

6 break

7 soup = BeautifulSoup(resp.content, "html.parser")

8 # Extraé los datos como antes()

Si el sitio tiene un botón “Siguiente”, buscá el enlace y seguílo:

1url = "https://example.com/products"

2while url:

3 resp = requests.get(url)

4 soup = BeautifulSoup(resp.content, "html.parser")

5 # Extraé los datos

6 next_link = soup.find('a', class_='next-page')

7 if next_link and 'href' in next_link.attrs:

8 url = "https://example.com" + next_link['href']

9 else:

10 url = NoneContenido dinámico (cargado por JavaScript)

Si los datos no están en el HTML (por ejemplo, se cargan con JavaScript), vas a necesitar Selenium:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/complex-page")

4driver.implicitly_wait(5)

5page_html = driver.page_source

6soup = BeautifulSoup(page_html, "html.parser")

7# Ahora extraé los datos como antes()

Selenium también puede hacer clic en botones “Cargar más” o scrollear la página. Eso sí: es más lento y consume más recursos que Requests.

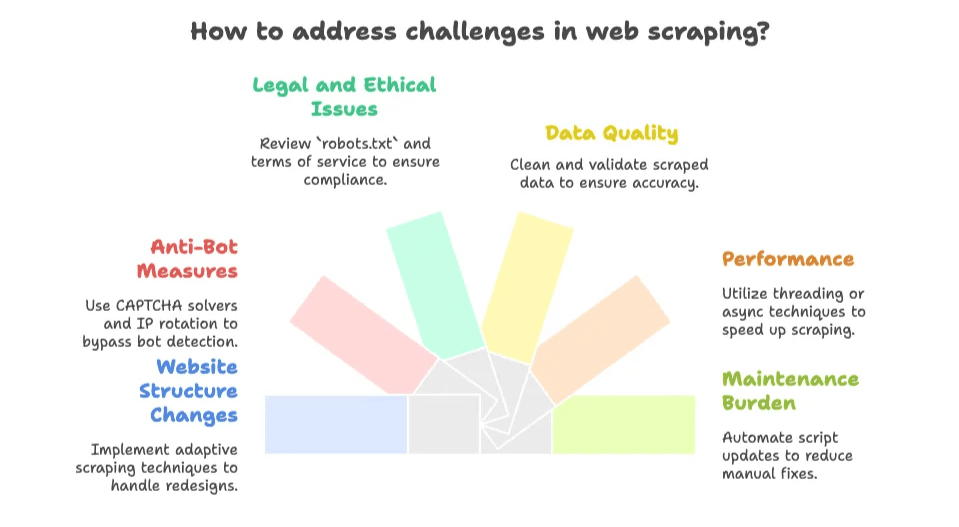

Problemas y desafíos comunes al crear tu propio raspador web

Acá es donde la cosa se pone picante. Programar un raspador web es divertido… hasta que la web cambia y tu script se rompe a las 2 de la mañana antes de una entrega. Estos son los problemas más comunes:

- Cambios en la estructura del sitio: Si la web se rediseña o cambian las clases, tu raspador puede dejar de andar. El mantenimiento es constante ().

- Medidas anti-bots: CAPTCHAs, límites de velocidad y bloqueos de IP son moneda corriente. .

- Aspectos legales y éticos: Revisá siempre el

robots.txty los términos de uso del sitio. Los datos públicos suelen estar permitidos, pero no extraigas contenido privado o protegido (). - Calidad de los datos: Los datos extraídos pueden venir desordenados. A veces hay que limpiar etiquetas HTML, espacios o texto roto.

- Rendimiento: Extraer muchas páginas es lento si no usás hilos o asincronía.

- Carga de mantenimiento: Cada nuevo sitio o cambio implica más scripts que arreglar. Es un juego sin fin de “arreglá y volvé a empezar”.

Si sos desarrollador y te gustan los desafíos, esto puede ser entretenido. Pero si solo querés los datos, puede volverse tedioso rapidísimo.

La alternativa inteligente: Herramientas de Raspador Web IA como Thunderbit

Acá es donde me pongo la gorra de Thunderbit (en mi cabeza, tiene forma de rayo). La mayoría de los usuarios de negocio no quieren programar ni mantener scripts—solo quieren los datos, ya.

Por eso creamos , una que te permite extraer datos de cualquier web, PDF o imagen en dos clics. Sin código, sin configuraciones, sin saber HTML.

¿Qué hace diferente a Thunderbit?

- Configuración en 2 clics: Abrí la web, hacé clic en “Sugerir campos IA” y después en “Extraer”. ¡Listo!

- Sugerencias inteligentes de campos: La IA de Thunderbit analiza la página y te recomienda las mejores columnas (nombre de producto, precio, valoración, etc.).

- Extracción en subpáginas y paginación: Sigue automáticamente enlaces “Siguiente” o entra en páginas de detalle para enriquecer tus datos.

- Exportación instantánea: Exportá a Excel, Google Sheets, Airtable, Notion, CSV o JSON—gratis y sin vueltas.

- Tipos de datos avanzados: Extraé emails, teléfonos, imágenes e incluso texto de PDFs o imágenes (gracias a OCR integrado).

- Raspado en la nube o en el navegador: Extraé hasta 50 páginas a la vez en la nube, o usá el navegador para webs que requieren login.

- Sin dolores de mantenimiento: La IA se adapta sola a los cambios de diseño, así que olvidate de arreglar scripts rotos.

Comparativa: Python vs. Thunderbit

| Aspecto | Raspador en Python | Thunderbit (Raspador Web IA) |

|---|---|---|

| Tiempo de configuración | Horas para programar y depurar | Minutos—instalá la extensión y listo |

| Nivel técnico | Alto (Python, HTML, CSS, depuración) | Bajo (solo apuntar y hacer clic) |

| Mantenimiento | Tenés que arreglarlo cada vez que la web cambia | La IA de Thunderbit se adapta sola |

| Paginación/Subpáginas | Hay que programar bucles y lógica | Integrado, solo activá la opción |

| Tipos de datos | Básico por defecto; más código para imágenes, PDFs, emails, etc. | Extracción en un clic de texto, imágenes, emails, teléfonos, PDFs y más |

| Escalabilidad y velocidad | Limitado por tu código y recursos | Raspado en la nube de hasta 50 páginas; modo navegador para sitios con login |

| Coste | Python es gratis, pero tu tiempo no; infraestructura y proxies pueden sumar | Hay plan gratuito; los pagos empiezan desde ~$16.5/mes por 30.000 créditos/año (precios) |

| Flexibilidad y control | Máximo control para lógica personalizada | Máxima comodidad para casos estándar |

Para la mayoría de los usuarios de negocio, Thunderbit es el atajo para conseguir datos estructurados sin complicaciones.

¿Cuándo programar tu propio raspador web y cuándo usar un Raspador Web IA?

Entonces, ¿qué te conviene más? Acá va mi opinión honesta:

Programá tu propio raspador si:

- Necesitás lógica muy personalizada (por ejemplo, login con 2FA, flujos complejos o integración profunda con tu backend).

- Tenés buenas habilidades de programación y te gusta experimentar.

- El sitio es estable y no te molesta mantener los scripts.

- Querés integrar el scraping en un sistema de software más grande.

- Vas a extraer datos detrás de un login o que no soportan las herramientas IA.

Usá un Raspador Web IA (Thunderbit) si:

- No querés programar ni mantener scripts.

- Necesitás los datos ya (para una tarea puntual o recurrente).

- El sitio cambia seguido o tiene medidas anti-bots (Thunderbit se encarga de eso).

- Querés funciones integradas como OCR, extracción de emails/teléfonos o exportación directa a tus herramientas favoritas.

- Valorás tu tiempo y preferís analizar datos en vez de depurar código.

Acá tenés una lista rápida para decidir:

- ¿Los datos son públicos y no requieren login complicado? → Thunderbit es tu mejor opción.

- ¿Es una necesidad puntual o ad-hoc? → Thunderbit.

- ¿Necesitás personalización o integración profunda? → Script en Python.

- ¿Tenés un desarrollador disponible y te gusta programar? → Script en Python.

- ¿Querés evitar dolores de cabeza de mantenimiento? → Thunderbit.

Acordate, siempre podés empezar con Thunderbit para resultados rápidos y después invertir en scripts personalizados si tus necesidades se vuelven más complejas.

Si querés saber más sobre cómo funcionan los raspadores web IA y cuándo usarlos, revisá nuestra .

Resumen: cómo aprovechar el web scraping en tu empresa

Para cerrar:

- El web scraping con Python es potente y flexible, pero requiere aprendizaje y mantenimiento constante.

- Los raspadores web IA como Thunderbit hacen que la extracción de datos sea accesible para todos—sin código, sin configuraciones, solo resultados.

- Para la mayoría de las empresas, la vía más rápida y eficiente es usar una herramienta IA, salvo que tengas necesidades muy específicas.

- La web es una mina de oro de datos, y elegir el enfoque correcto puede ahorrarte horas (o días) de trabajo manual.

Preguntas frecuentes

1. ¿Qué es el web scraping y por qué se usa Python para eso?

El web scraping es el proceso automatizado de recolectar datos de páginas web. Python es popular para esto por su facilidad de uso, su sintaxis clara y la gran cantidad de librerías disponibles (como requests, BeautifulSoup y Selenium).

2. ¿Cuáles son los usos más comunes del web scraping en empresas?

Las empresas lo usan para generar leads de ventas, monitorear precios, inteligencia de mercado y recopilar datos inmobiliarios. Permite automatizar tareas repetitivas y obtener información actualizada para tomar mejores decisiones.

3. ¿Cuáles son los principales desafíos al programar tu propio raspador web?

Los desafíos más comunes son: cambios en la estructura de las webs, protecciones anti-bots como CAPTCHAs, cuestiones legales y éticas, calidad de los datos y el mantenimiento constante para que los scripts sigan funcionando.

4. ¿En qué se diferencia el Raspador Web IA de Thunderbit de los scripts tradicionales en Python?

Thunderbit ofrece una solución sin código, con sugerencias inteligentes de campos, paginación automática y opciones de exportación. Requiere mínima configuración, se adapta solo a los cambios de la web y es accesible para cualquier usuario, a diferencia de los scripts en Python que exigen conocimientos técnicos y mantenimiento manual.

5. ¿Cuándo conviene usar un raspador IA como Thunderbit en vez de programar uno propio?

Usá Thunderbit si necesitás extraer datos rápido y sin programar, especialmente para datos públicos o tareas puntuales. Elegí un script en Python si necesitás control total, integración profunda o vas a extraer datos complejos o protegidos por login.

Lecturas recomendadas:

Si querés profundizar en el web scraping, revisá estas guías:

Y si querés probar la forma más fácil de extraer datos de la web, y comprobalo vos mismo. Tus viernes (y tus datos) te lo van a agradecer.