Hand aufs Herz: Das Internet ist ein echtes Abenteuer – jeden Tag prasselt ein endloser Strom an Daten auf mich ein. Nachrichten, Produktbewertungen, Schnäppchen, Tweets, Immobilienanzeigen – alles fließt wild und ungeordnet durchs Netz. Und wenn du ein Unternehmen führst, fühlt sich das Sortieren dieses Durcheinanders oft an wie die Suche nach der Nadel im Heuhaufen… während der Heuhaufen lichterloh brennt. (Glaub mir, ich kenn das nur zu gut.)

Doch mitten in diesem Online-Chaos steckt pures Gold – Erkenntnisse, die deinen Umsatz pushen, dich der Konkurrenz voraus sein lassen und langweilige Aufgaben automatisieren, auf die sonst keiner Lust hat. Genau hier kommt Web-Scraping ins Spiel. Mit den richtigen Tools verwandelst du diesen Berg an unstrukturierten Webdaten in übersichtliche, nutzbare Tabellen – bereit für deinen nächsten großen Schritt. Und als jemand, der seit Jahren in SaaS und Automatisierung unterwegs ist, kann ich dir sagen: Web-Scraping ist längst nicht mehr nur was für IT-Nerds. Es ist für alle, die cleverer und schneller arbeiten wollen.

Was bedeutet Web-Scraping? So wird Online-Chaos zu nutzbaren Daten

Was steckt eigentlich hinter Web-Scraping? Ohne großes Technik-Blabla: Web-Scraping heißt, mit Software gezielt Infos von Webseiten zu sammeln und sie in ein strukturiertes Format zu bringen – zum Beispiel in Excel, Google Sheets oder eine Datenbank. Stell dir vor, du hast einen digitalen Assistenten, der rund um die Uhr genau die Infos von tausenden Webseiten für dich kopiert und sortiert. Das ist Web-Scraping in Kurzfassung.

Oft hört man auch den Begriff „Data Scraping“. Der Unterschied: Data Scraping ist der Oberbegriff für das Extrahieren von Daten aus allen möglichen Quellen (Webseiten, PDFs, Bilder usw.). Web-Scraping meint speziell das Sammeln von Daten aus Webseiten. Anders gesagt: Jedes Web-Scraping ist Data Scraping, aber nicht jedes Data Scraping ist Web-Scraping. (So wie jedes Quadrat ein Rechteck ist, aber nicht jedes Rechteck ein Quadrat.)

Für die ganz Genauen: Web-Scraping ist „Data Scraping, das speziell für das Extrahieren von Daten aus Webseiten genutzt wird“ (). In der Praxis heißt das: Automatisierung für Online-Recherche – Schluss mit endlosem Copy-Paste.

Warum Web-Scraping für Unternehmen heute unverzichtbar ist

Warum ist Web-Scraping gerade jetzt so ein großes Thema? Weil das Internet von unstrukturierten Daten überschwemmt wird – , von Social-Media-Posts bis zu Produktlisten. IDC schätzt, dass das weltweite Datenvolumen bis 2025 auf anwächst – das sind Zahlen mit so vielen Nullen, dass einem schwindlig wird.

Das Problem: , nicht fürs Analysieren. Das ist, als würdest du einen Sternekoch nur Kartoffeln schälen lassen. Michael Shulman, Head of Machine Learning bei Kensho, bringt es auf den Punkt: „Da der Großteil der Daten unstrukturiert ist, bietet die Fähigkeit, diese auszuwerten und zu nutzen, enorme Chancen.“

Web-Scraping dreht den Spieß um. Statt Webseiten mühsam von Hand zu durchforsten, automatisierst du den Prozess – und sammelst aktuelle Daten in Echtzeit, von überall im Netz. Kein Wunder, dass und bereits Web-Scraping für externe Daten nutzen. Daten sind nicht nur das neue Öl – sie sind die neue Währung. Und Web-Scraping ist der Weg, sie zu nutzen.

Hier ein Überblick, wie Web-Scraping in verschiedenen Unternehmensbereichen echten Mehrwert bringt:

| Bereich | Beispiel-Anwendung | Nutzen / ROI |

|---|---|---|

| Vertrieb & Marketing | Verzeichnisse und Social Media für Lead-Generierung scrapen | Mehr und bessere Leads – 40 % mehr qualifizierte Kontakte und kürzere Vertriebszyklen |

| E-Commerce | Preise, Lagerbestände und Bewertungen der Konkurrenz überwachen | Mehr Umsatz & Kundenbindung – dynamische Preise steigern Verkäufe und halten Kunden |

| Operations | Automatisierte Datensammlung von Lieferanten- oder Behördenseiten | Effizienz & Genauigkeit – hunderte Arbeitsstunden gespart, weniger Fehler, schnellere Entscheidungen |

Typische Web-Scraping-Anwendungen in verschiedenen Branchen

Web-Scraping ist ein echter Allrounder und kommt in vielen Bereichen zum Einsatz – vom Vertrieb bis zur Immobilienanalyse. Hier ein paar Beispiele aus der Praxis:

- Lead-Generierung & B2B-Akquise: Jobbörsen oder Firmenverzeichnisse scrapen, um gezielte, aktuelle Lead-Listen zu erstellen. Ein SaaS-Unternehmen konnte so die Zahl qualifizierter Leads um steigern.

- Preis- und Produktüberwachung im E-Commerce: Händler scrapen Wettbewerberseiten für Preise und Lagerbestände und passen ihre eigenen Angebote fast in Echtzeit an. Das Ergebnis: .

- Immobilienanzeigen: Plattformen und Investoren scrapen Immobilienportale für Angebote, Preise und Trends – so erkennen sie günstige Objekte und gefragte Lagen ().

- Reise & Tourismus: Flug- und Hotelportale scrapen für Preise, Verfügbarkeiten und Bewertungen – Grundlage für Preisvergleichsseiten und Stimmungsanalysen.

- Finanzen & Investments: Hedgefonds scrapen alles von SEC-Meldungen bis Produktbewertungen, um alternative Datensignale zu finden. setzen bereits auf Web-Scraping.

Fazit: Überall, wo im Web wertvolle Daten schlummern, gibt es auch einen Weg, sie per Scraping in echten Geschäftswert zu verwandeln.

Wie funktioniert Web-Scraping? Von der Webseite zur Tabelle

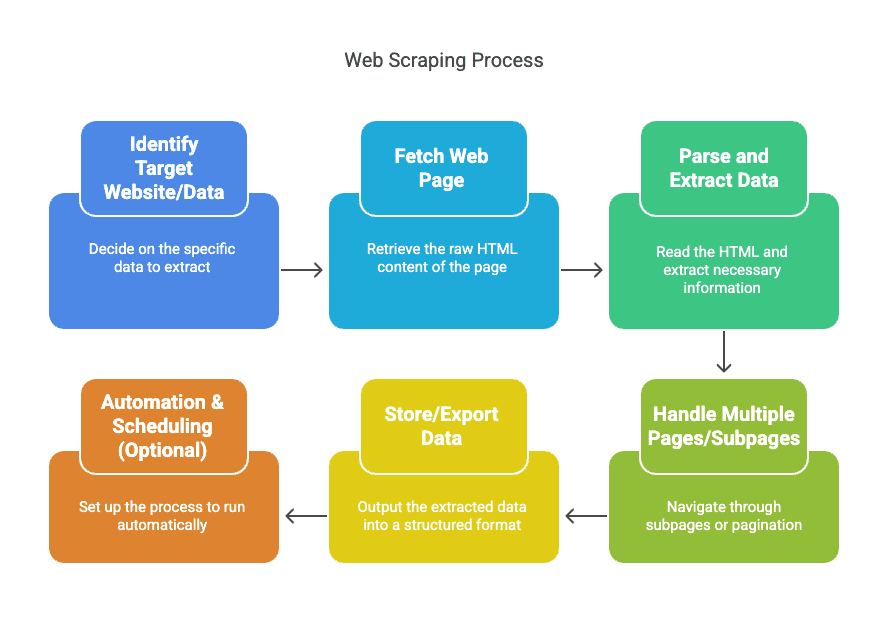

Lass uns den Ablauf mal ganz entspannt anschauen. Web-Scraping ist kein Hexenwerk, sondern läuft in klaren Schritten ab:

- Zielseite/Daten festlegen: Was willst du sammeln? (z. B. Produktnamen und Preise von xyz)

- Webseite abrufen: Der Scraper lädt den HTML-Code, wie dein Browser.

- Daten auslesen: Das Tool liest den HTML-Code und extrahiert die gewünschten Infos (Preise, Namen, Bewertungen).

- Mehrere Seiten abdecken: Scraper folgen automatisch Links zu Unterseiten oder blättern durch Listen.

- Daten speichern/exportieren: Alles wird in ein strukturiertes Format ausgegeben – CSV, Excel, Google Sheets oder Datenbank.

- Automatisierung & Zeitplanung (optional): Du kannst den Scraper regelmäßig laufen lassen, damit deine Daten immer aktuell sind.

Per Hand würde das ewig dauern (und viel Kaffee kosten). Mit Web-Scraping automatisierst du alles – und sparst dir stundenlanges Copy-Paste.

Welche Tools und Services gibt es fürs Web-Scraping?

Die Auswahl ist riesig – von Browser-Add-ons über Cloud-Plattformen bis hin zu Desktop-Programmen. Hier ein kurzer Überblick:

- Browser-Erweiterungen: Leichte, einfach zu bedienende Tools direkt im Browser. Perfekt für schnelle, kleine Aufgaben.

- Desktop-Software: Umfangreiche Programme mit visueller Oberfläche – meistern auch Logins, endloses Scrollen und mehr.

- Cloud-Plattformen: Scraper laufen auf entfernten Servern – ideal für große, dauerhafte Projekte.

- Eigener Code: Für Technik-Fans – eigene Skripte bieten maximale Kontrolle (und manchmal auch Kopfschmerzen).

Warum diese Tools statt Copy-Paste? Drei Gründe: Tempo, Skalierbarkeit und Zuverlässigkeit. Ein guter Scraper verarbeitet tausende Seiten, während du gerade dein Mittagessen aufwärmst. Und du bekommst saubere, strukturierte Daten – ohne Tippfehler oder fehlende Infos.

Strukturierte vs. unstrukturierte Daten: Warum Web-Scraping so wichtig ist

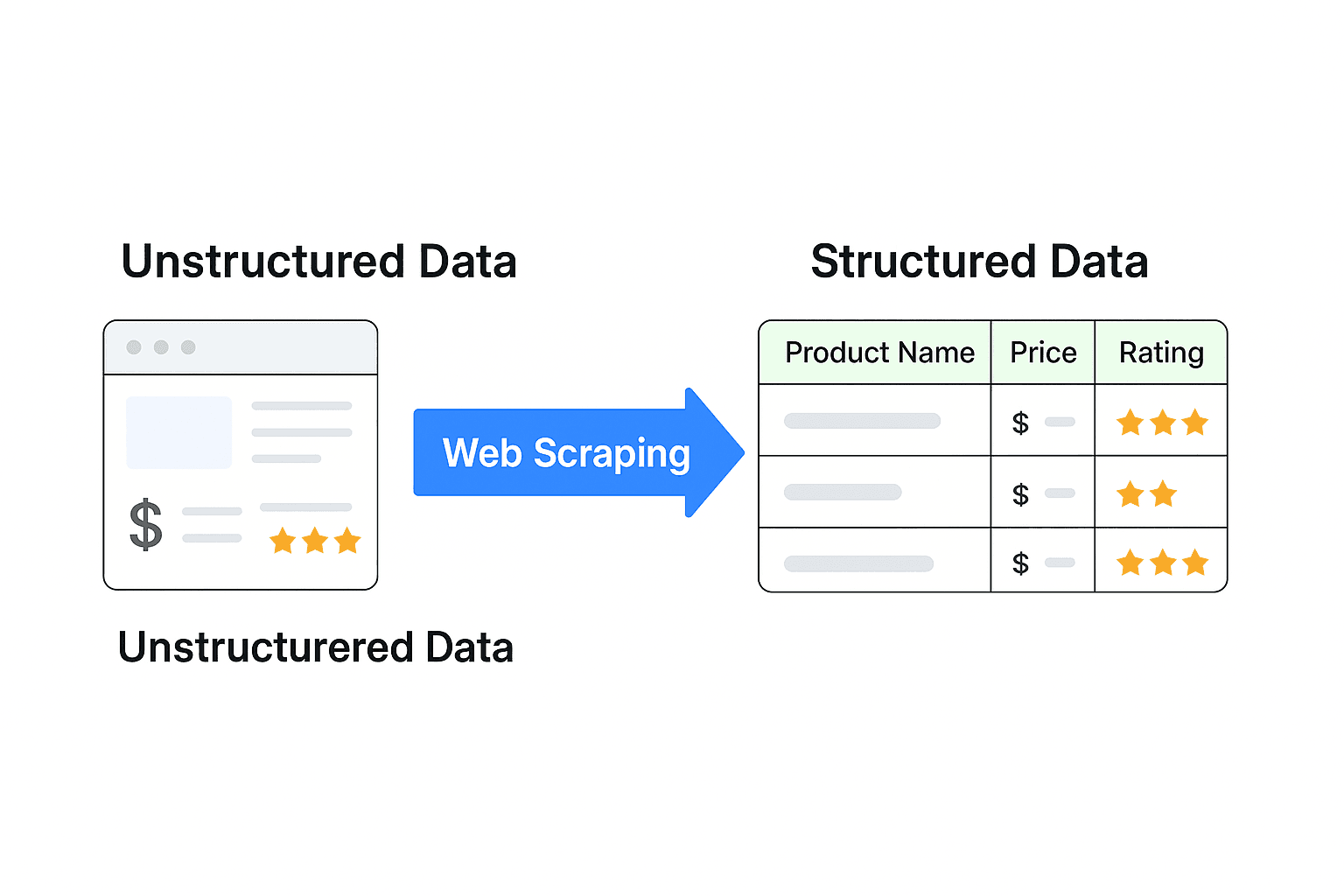

Das Hauptproblem: Die meisten Webdaten sind unstrukturiert – sie sind für Menschen gemacht, nicht für Maschinen. Eine Produktseite mit Bildern, Bewertungen und Preisen ist ein Datenchaos. Das kannst du nicht einfach in Excel einfügen und loslegen.

Strukturierte Daten – also Tabellen mit Spalten wie „Produktname“, „Preis“ und „Bewertung“ – sind die Grundlage für Analysen, Dashboards und smarte Entscheidungen. Web-Scraping ist die Brücke, die aus chaotischem Web-Content verwertbare Infos macht.

Und hier eine erstaunliche Zahl: . Der Rest? Ungehobene Schätze. Web-Scraping hilft, dieses Potenzial zu heben.

Welche Arten von Web-Scraping-Lösungen gibt es? Code, No-Code und KI-Tools

Hier die wichtigsten Optionen:

- Code-basierte Lösungen: Skripte in Python (z. B. mit BeautifulSoup oder Scrapy), JavaScript oder R. Maximale Flexibilität, aber du brauchst Programmierkenntnisse – und Geduld, wenn sich Webseiten ändern.

- No-Code-Lösungen: Visuelle Tools (Browser-Erweiterungen, Desktop-Apps, Cloud-Plattformen), mit denen du Scrapes per Klick statt per Code einrichtest. Ideal für Business-User, die einfach Ergebnisse wollen.

- KI-basierte Scraper: Die neueste Generation. Diese Tools nutzen KI, um automatisch zu erkennen, was gescrapt werden soll, passen sich an Webseitenänderungen an und extrahieren sogar Daten aus PDFs oder Bildern. Thunderbit ist hier ein Paradebeispiel.

Ich kenne beide Seiten – selbst Code schreiben und No-Code-Tools nutzen. Für die meisten Unternehmen sind No-Code- oder KI-Scraper die beste Wahl. Warum sich mit Code abmühen, wenn es auch mit zwei Klicks geht?

Worauf sollte man bei einem Web-Scraping-Tool achten?

Nicht alle Scraper sind gleich. Das sind die wichtigsten Kriterien (und meine Empfehlungen für jedes Business-Team):

- Einfache Bedienung: Kannst du direkt loslegen, ohne ein Handbuch zu wälzen?

- KI-Felderkennung: Schlägt das Tool automatisch vor, was gescrapt werden soll?

- Unterseiten & Paginierung: Kommt das Tool mit mehrseitigen Listen und Detailseiten klar?

- Exportmöglichkeiten: Kannst du Daten direkt nach Excel, Google Sheets, Airtable oder Notion schicken?

- Zeitplanung: Lässt sich das Scraping automatisieren und regelmäßig ausführen?

- Datentyp-Erkennung: Erkennt das Tool E-Mails, Telefonnummern, Bilder usw. automatisch?

- Vorlagen für bekannte Seiten: 1-Klick-Scraping für Amazon, Zillow, Instagram und Co.

Für Teams in Vertrieb, E-Commerce und Operations bedeuten diese Features: weniger Handarbeit, weniger Fehler und mehr Zeit fürs Wesentliche.

Thunderbit: Der einfachste KI-Web-Scraper für alle

Jetzt kommt ein kleiner Werbeblock – aber nur, weil ich wirklich an das glaube, was wir bei entwickeln.

Thunderbit ist ein KI-gestützter Web-Scraper als Chrome-Erweiterung, entwickelt für Business-Anwender – nicht nur für Entwickler. Das macht Thunderbit besonders:

- KI-Feldvorschläge: Einfach auf „AI Suggest Fields“ klicken – Thunderbit liest die Seite, schlägt passende Spalten vor und richtet alles ein. Kein Rätselraten mehr.

- 2-Klick-Scraping: Seite öffnen, Felder vorschlagen lassen, auf „Scrape“ klicken. Fertig.

- Unterseiten & Paginierung: Thunderbits KI erkennt und scrapt automatisch Unterseiten und paginierte Listen – ohne Zusatzaufwand.

- Geplantes Scraping: Preise oder Leads täglich überwachen? Einfach den Zeitplan beschreiben („jeden Morgen um 9 Uhr“), URLs eintragen, und Thunderbit erledigt den Rest.

- Sofort-Export: Daten direkt nach Excel, Google Sheets, Airtable oder Notion senden – ohne versteckte Kosten oder Umwege.

- Spezialisierte Extraktoren: 1-Klick-Extraktion für E-Mails, Telefonnummern und Bilder – komplett kostenlos.

- KI-Autofill: Mit KI Online-Formulare ausfüllen und Workflows automatisieren – nicht nur Daten extrahieren.

- Dokumenten- & Bildanalyse: PDFs, Word-, Excel-Dateien oder Bilder hochladen – Thunderbits KI extrahiert Tabellen und strukturiert die Daten für dich.

Und ja, es gibt eine (bis zu 6 Seiten scrapen), du kannst also risikofrei testen. Wer mehr braucht, bekommt ab 15 $/Monat 500 Zeilen – deutlich günstiger als viele Enterprise-Tools.

Aber glaub nicht nur mir. Nutzer sagen Dinge wie: „Thunderbit ist mit Abstand der einfachste Web-Scraper, den ich je genutzt habe. Früher habe ich stundenlang Skripte geschrieben – jetzt scrape ich ganze Webseiten in Minuten, mit nur wenigen Klicks.“ Genau dieses Feedback macht die langen Nächte beim Programmieren lohnenswert.

Du willst Thunderbit in Aktion sehen? Schau auf unserem vorbei oder lies mehr im .

Web-Scraping: Best Practices für Nicht-Techniker

Web-Scraping ist mächtig, aber ein bisschen Vorsicht schadet nie. Hier meine wichtigsten Tipps für den Einstieg:

- Website-Regeln beachten: Immer die Nutzungsbedingungen und robots.txt der Seite prüfen. Nur öffentliche Daten scrapen und verantwortungsvoll nutzen.

- Server nicht überlasten: Sei fair – keine Flut an Anfragen schicken. Die meisten Tools erlauben das Einstellen von Pausen.

- Klein anfangen: Teste deinen Scraper erst auf ein paar Seiten. So stellst du sicher, dass du die richtigen Daten bekommst.

- Paginierung beachten: Nicht nur die erste Seite scrapen, sondern alle Seiten erfassen.

- Daten prüfen: Ergebnisse bereinigen – Duplikate entfernen, Formatierungen anpassen, Vollständigkeit checken.

- Organisiert bleiben: Dokumentiere, was du wann und wo gescrapt hast. Das spart später Ärger.

- Nach APIs suchen: Manchmal gibt es eine offizielle API, die Daten einfacher und zuverlässiger liefert als HTML-Scraping.

- Auf Änderungen achten: Webseiten ändern sich. Wenn dein Scraper nicht mehr läuft, musst du ihn ggf. anpassen (oder die KI machen lassen).

- Das richtige Tool wählen: Wenn ein Tool nicht passt, probiere ein anderes. Sei offen für Experimente.

- Ethik beachten: Nur weil du etwas scrapen kannst, heißt das nicht, dass du es solltest. Datenschutz und Eigentumsrechte respektieren.

Mehr dazu findest du in unserem Guide: .

Fazit: Mit Web-Scraping echten Mehrwert schaffen

Kurz gesagt: Das Web ist voll mit wertvollen Daten, aber die meisten davon sind unstrukturiert und schwer zugänglich. Web-Scraping ist der Schlüssel, der diese Daten nutzbar macht – aus Chaos wird Klarheit, aus Fleißarbeit wird Wachstum.

Egal ob Vertrieb, E-Commerce, Immobilien oder Operations – Web-Scraping hilft dir dabei:

- Frischere, hochwertigere Leads zu generieren

- Wettbewerber und Märkte in Echtzeit zu beobachten

- Zeitfressende Aufgaben zu automatisieren und jede Woche Stunden zu sparen

- Schnellere, datenbasierte Entscheidungen zu treffen

Und dank moderner Tools – vor allem KI-gestützter Lösungen wie – brauchst du heute weder Programmierer noch Data Scientist zu sein. Such dir ein Projekt, probiere ein Tool aus (unsere ist ein super Einstieg) und erlebe, wie viel mehr du mit Automatisierung erreichen kannst.

In einer Welt, in der „Daten das neue Öl“ sind, ist Web-Scraping deine Förderpumpe. Also: Mach aus dem Datenfeuerwerk im Netz einen stetigen Strom an Erkenntnissen – und sieh zu, wie dein Business wächst.

Viel Spaß beim Scrapen! Und falls du mal nicht weiterkommst, weißt du ja, wo du mich (oder zumindest Thunderbit) findest.

Häufige Fragen

1. Was ist Web-Scraping – einfach erklärt?

Web-Scraping heißt, mit Software gezielt Daten von Webseiten zu sammeln – etwa Preise, Bewertungen oder Stellenanzeigen – und sie in ein nützliches Format wie eine Tabelle zu bringen. Stell es dir vor wie einen Roboter-Praktikanten, der rund um die Uhr das lästige Copy-Paste für dich übernimmt.

2. Muss ich programmieren können?

Nicht mehr. Dank No-Code- und KI-Tools wie kannst du Webseiten mit wenigen Klicks scrapen – ganz ohne Python, Debugging oder Technik-Frust. Wer surfen kann, kann auch scrapen.

3. Welche Daten kann ich scrapen?

Fast alles, was öffentlich im Netz steht:

- Produktlisten und Preise

- Immobilienangebote

- Stellenanzeigen

- Firmenverzeichnisse

- Social-Media-Profile

- Tabellen und Bilder aus PDFs (ja, auch das)

Wenn es online sichtbar ist, gibt es einen Weg, es zu scrapen.

4. Ist Web-Scraping legal?

Im Allgemeinen ja – solange du öffentliche Daten verantwortungsvoll sammelst. Keine Server überlasten, Nutzungsbedingungen beachten und keine geschützten oder persönlichen Daten scrapen. Im Zweifel: fair bleiben und sauber arbeiten.