Stell dir vor, du bist auf der Jagd nach dem perfekten Paar Sneaker im Netz. Du klickst dich durch Seite um Seite, immer wieder auf „Weiter“ oder „Mehr laden“, und spätestens auf Seite 12 fragst du dich: Wie viele Seiten gibt’s hier eigentlich noch? Jetzt stell dir vor, du willst nicht nur shoppen, sondern alle Angebote für einen Preisvergleich sammeln. Oder du bist im Vertrieb und suchst nach neuen Leads in einem riesigen Online-Verzeichnis. Genau dann wird Pagination von einer kleinen Bequemlichkeit (oder einem Nervfaktor) zu einer echten technischen Challenge.

Aus meiner Erfahrung mit SaaS, Automatisierung und KI weiß ich: Pagination kann ein Datenprojekt zum Erfolg führen – oder komplett ausbremsen. Mit dem Aufkommen von KI-Web-Scraper wie verändert sich die Art, wie wir mit Pagination umgehen, gerade rasant. In diesem Guide zeige ich dir, was Web-Pagination eigentlich ist, warum sie fürs Scraping so wichtig ist und wie moderne Tools – vor allem KI-gestützte – es heute so einfach wie nie machen, komplette Datensätze zu extrahieren, egal wie tief die Infos versteckt sind.

Was ist Web-Pagination? Einfach erklärt für Business-Anwender

Fangen wir ganz basic an. Web-Pagination heißt einfach, dass eine lange Liste von Inhalten in kleinere, übersichtliche Seiten aufgeteilt wird. Hat eine Website zum Beispiel 500 Produkte, werden die nicht alle auf einmal geladen (außer du willst deinen Browser grillen). Stattdessen zeigt die Seite vielleicht 20 Produkte pro Seite an, mit Navigationselementen wie Seitenzahlen, „Weiter“- oder „Mehr laden“-Buttons, damit du dich Stück für Stück durchklicken kannst.

Warum machen Websites das? Drei Hauptgründe:

- Bessere Nutzererfahrung: Niemand will durch eine endlose Seite mit 1.000 Einträgen scrollen. Pagination hilft, den Überblick zu behalten, sich zu orientieren („Das Angebot war auf Seite 3!“) und nicht im Daten-Dschungel verloren zu gehen.

- Performance: Kleinere Datenmengen laden schneller und schonen sowohl deinen Browser als auch die Server der Website. Besonders bei vielen Bildern spart das Bandbreite.

- Struktur & Navigation: Pagination sorgt für Ordnung. Du kannst zum Anfang, zum Ende oder zu einem bestimmten Abschnitt springen – wie ein Inhaltsverzeichnis im Buch statt einer einzigen, endlosen Seite.

Ohne Pagination wären viele Websites kaum nutzbar. Stell dir einen Online-Shop vor, der alle 10.000 Produkte auf einer Seite anzeigt – dein Laptop würde abheben wie ein Düsenjet.

Warum ist Pagination für Web-Scraper-Pagination so wichtig?

Jetzt wird’s spannend für alle, die Web-Scraper nutzen. Wenn du nur die erste Seite ausliest, verpasst du den Großteil der Daten. Und unvollständige Daten sind im Business so nützlich wie eine leere Pizzaschachtel.

Hier ein paar typische Anwendungsfälle:

| Anwendungsfall | Warum das Scrapen über Seite 1 hinaus entscheidend ist |

|---|---|

| Lead-Generierung (z.B. Kontakte aus Verzeichnissen oder LinkedIn extrahieren) | Die meisten Kontakte sind nicht auf der ersten Seite. Ohne Pagination erfasst du nur einen Bruchteil der verfügbaren Leads. |

| Preisüberwachung (Konkurrenzprodukte in Online-Shops) | Angebote und Preise der Konkurrenz verteilen sich oft über viele Seiten. Wer nur Seite 1 ausliest, verpasst günstige Produkte oder spezielle Artikelnummern. |

| Marktforschung/SEO (Suchergebnisse, Rankings) | Die Präsenz einer Marke kann auf Seite 2, 3 oder noch weiter hinten liegen. Für eine vollständige Analyse müssen alle Ergebnisse erfasst werden. |

| Listings-Aggregation (Immobilien, Jobbörsen etc.) | Wichtige Einträge können irgendwo in einer 100+ Seiten langen Liste stehen. Unvollständiges Scraping bedeutet verpasste Chancen. |

Wie ein es auf den Punkt bringt: „Ohne Pagination ist dein Datensatz unvollständig. Und unvollständige Daten sind wertlos.“

Die häufigsten Pagination-Beispiele im Web

Websites sind bei der Pagination oft ziemlich kreativ (manchmal zu kreativ). Hier die gängigsten Varianten:

Nummerierte Pagination

Das klassische Modell: Am Ende der Liste findest du Seitenzahlen (1, 2, 3, …, 10, Weiter >). Zu sehen bei Google, Amazon, eBay, Walmart. Du kannst direkt zu einer Seite springen oder dich mit „Weiter“ durchklicken.

![]()

Vorteile:

- Einfach zu verstehen.

- Flexibles Springen zwischen Seiten.

- Die Seitenzahl steht meist direkt in der URL (z.B.

?page=2), was das Scraping erleichtert.

Nachteile:

- Viele Seiten durchzuklicken ist mühsam.

- Manche Seiten verstecken die Seitenzahlen oder zeigen nur wenige auf einmal an.

Für Web-Scraper ist nummerierte Pagination meist am einfachsten – einfach die Seitenzahl in der URL hochzählen oder dem „Weiter“-Link folgen ().

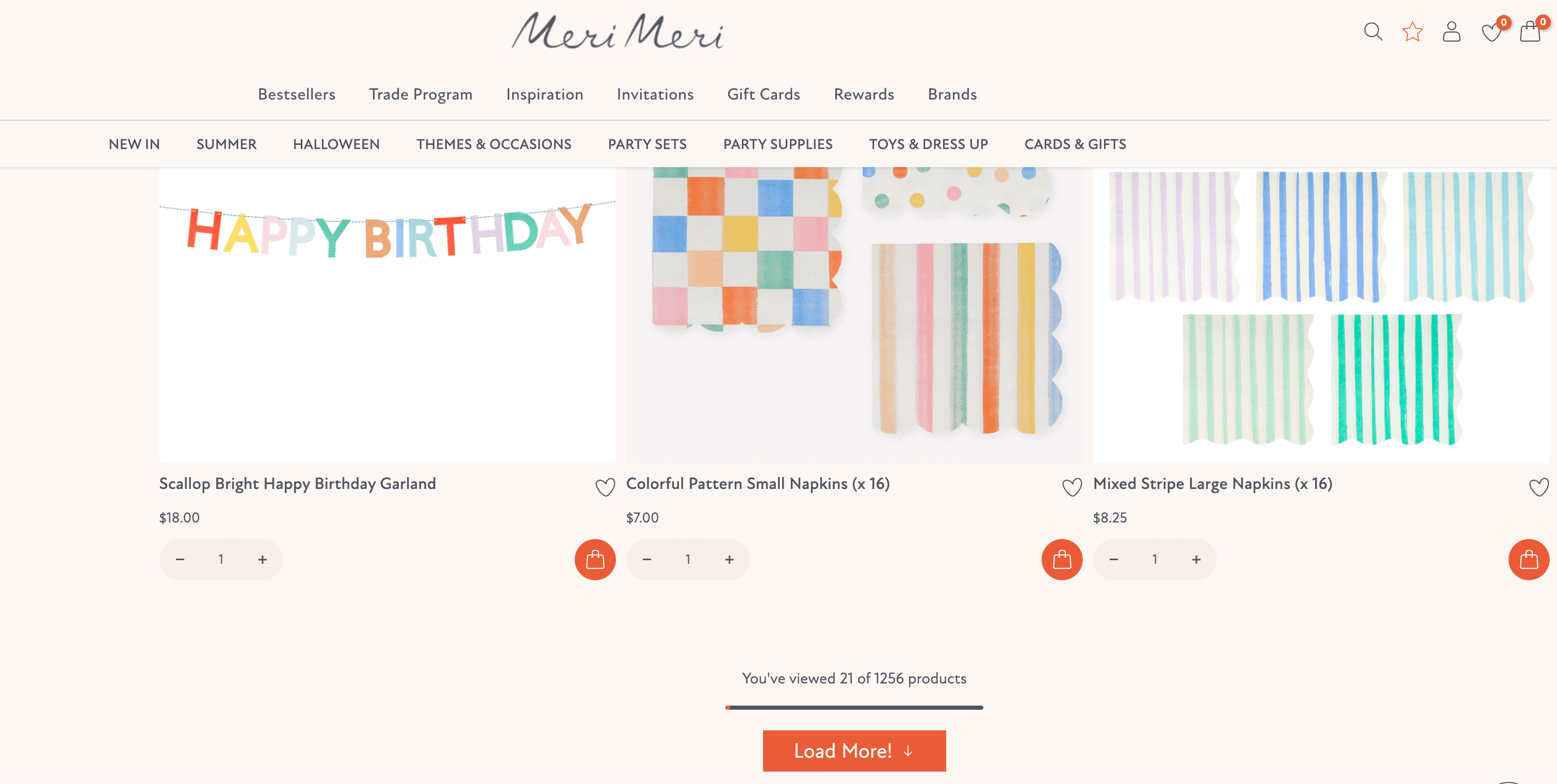

„Mehr laden“-Button

Statt Seiten gibt’s bei manchen Seiten einen großen „Mehr laden“-Button am Ende. Ein Klick, und weitere Einträge erscheinen – ohne Neuladen der Seite. Häufig bei mobil-optimierten Seiten und Social Feeds.

Vorteile:

- Fließendes Nutzererlebnis.

- Alles bleibt auf einer Seite.

Nachteile:

- Scraper müssen den Button simulieren (nicht nur die URL ändern).

- Oft steckt dahinter ein versteckter API-Call, den man nachbauen muss.

Web-Scraper müssen entweder den Button-Klick nachahmen oder die dahinterliegende Netzwerk-Anfrage kopieren ().

Unendliches Scrollen (Infinite Scroll)

Das „Nur noch ein Beitrag mehr“-Prinzip, perfektioniert von Social Media. Beim Scrollen wird automatisch neuer Inhalt geladen. Instagram, Twitter, Facebook, TikTok und sogar manche Shops wie Nike nutzen dieses Muster.

Vorteile:

- Sehr fesselnd für Nutzer (manchmal zu sehr).

- Optimal für mobile Geräte.

Nachteile:

- Es ist schwer, einen bestimmten Eintrag wiederzufinden (keine Seitenzahlen).

- Für Scraper am schwierigsten – es gibt keinen „Weiter“-Button, man muss das Scrollen simulieren und auf neue Inhalte warten.

Unendliches Scrollen erfordert meist Browser-Automatisierung oder KI-Web-Scraper, die echtes Nutzerverhalten nachahmen ().

Navigation mit „Weiter“/„Zurück“

Manche Seiten sind ganz schlicht: Nur „Weiter >“ und „< Zurück“-Links, ohne Seitenzahlen. Man muss sich Seite für Seite durchklicken, wie beim Blättern in einem Fotoalbum.

Vorteile:

- Sehr übersichtlich für Nutzer.

Nachteile:

- Kein direkter Sprung zu einer bestimmten Seite möglich.

- Scraper müssen so lange „Weiter“ klicken, bis der Link verschwindet.

Dieses Muster findet man oft bei minimalistischen Blogs, Foren und älteren Webanwendungen.

Wie funktioniert Pagination beim Web-Scraping? Die Basics

Wie gehen Web-Scraper also mit Pagination um? Hier der typische Ablauf:

- Start auf Seite 1: Der Scraper lädt die erste Seite und sammelt die Daten.

- Pagination erkennen: Er sucht nach Hinweisen – Seitenzahlen, „Weiter“-Buttons, „Mehr laden“ oder Anzeichen für Infinite Scroll.

- Wiederholen: Je nach Typ:

- Erhöht er die Seitenzahl in der URL,

- Klickt auf „Weiter“ oder „Mehr laden“,

- Oder scrollt nach unten, um mehr Inhalte zu laden.

- Schleife: Das Ganze wiederholt sich – scrapen, klicken, scrollen – bis keine neuen Seiten oder Einträge mehr erscheinen.

- Abschluss: Am Ende werden alle Daten zusammengeführt, Duplikate entfernt und das Ergebnis ausgegeben.

Hier ein einfaches Flussdiagramm für alle, die es visuell mögen:

1[Seite 1] → [Daten scrapen] → [Gibt es eine nächste Seite?] → Ja → [Zur nächsten Seite] → [Daten scrapen] → ... → Nein → [Fertig!]Das Entscheidende: „Nächste Seite“ kann ein Link, ein Button oder eine Scroll-Aktion sein. Moderne Web-Scraper (vor allem KI-gestützte) erkennen das automatisch – aber es hilft, zu wissen, was im Hintergrund passiert.

Thunderbits Ansatz: KI-gestützte Web-Scraper-Pagination

Jetzt zum spannenden Teil: Wie das Thema Pagination beim Web-Scraping auf ein neues Level hebt.

Als Mitgründer von Thunderbit habe ich gesehen, wie Nutzer an allen möglichen Pagination-Problemen verzweifeln. Deshalb haben wir Thunderbits KI so entwickelt, dass sie Pagination automatisch erkennt und steuert – ganz ohne Schleifen, Selektoren oder Programmieraufwand.

So geht Thunderbit mit Pagination um:

- Automatische Erkennung: Die KI von Thunderbit scannt die Seite und erkennt, ob Pagination vorhanden ist – egal ob Seitenzahlen, „Weiter“-Button, „Mehr laden“ oder Infinite Scroll. Wird Pagination gefunden, weiß Thunderbit, wie damit umzugehen ist.

- Scraping im Browser-Modus: Thunderbit läuft direkt in Chrome und sieht alles, was auch ein echter Nutzer sieht – inklusive dynamisch nachgeladener Inhalte. Das ist besonders bei Infinite Scroll und „Mehr laden“-Buttons entscheidend.

- Cloud-Scraping für Geschwindigkeit: Müssen viele Seiten gescrapt werden, kann Thunderbit im Cloud-Modus bis zu 50 Seiten gleichzeitig abarbeiten. Das ist, als hättest du 50 Assistenten, die für dich „Weiter“ klicken – nur ohne Kaffeepausen.

- Kein manuelles Scripting: Einfach auf „KI-Felder vorschlagen“ klicken, Thunderbit erkennt die Spalten, dann auf „Scrapen“ – fertig. Gibt es Pagination, arbeitet Thunderbit automatisch alle Seiten ab. Kein Code, kein XPath, keine Kopfschmerzen.

- Klick- und Scroll-Pagination: Egal ob die Seite klickbare Pagination oder Infinite Scroll nutzt – Thunderbit kann beides. Du kannst die KI entscheiden lassen oder den Modus selbst wählen.

- Subpage-Scraping: Nach dem Scrapen einer Liste kann Thunderbit sogar jede Detailseite besuchen, um weitere Infos zu holen – ideal für E-Commerce oder Immobilienportale.

Kurz gesagt: Thunderbits KI behandelt Pagination wie einen ganz normalen Teil der Seite. Sie weiß, wie man „umblättert“ – egal ob durch Klicken, Scrollen oder beides. (Und im Gegensatz zu mir wird sie dabei nie müde.)

Thunderbit vs. klassische Web-Scraper-Pagination

Vergleichen wir Thunderbit mit der herkömmlichen Methode:

| Funktion | Klassischer Scraper | Thunderbit (KI-gestützt) |

|---|---|---|

| Einrichtungszeit | Manuell: „Weiter“-Button auswählen, Schleifen schreiben, Selektoren anpassen | Automatisch: „KI-Felder vorschlagen“, „Scrapen“ klicken |

| Infinite Scroll | Erfordert Browser-Automatisierung, eigenen Code | Eingebaute KI, einfach umschalten |

| Anpassung bei Änderungen | Bricht bei Layout- oder Button-Änderungen | KI analysiert die Seite jedes Mal neu |

| Geschwindigkeit | Nacheinander (eine Seite nach der anderen) | Cloud-Modus: bis zu 50 Seiten parallel |

| Wartung | Hoch – Skripte müssen bei Änderungen angepasst werden | Gering – KI passt sich an, Team aktualisiert Modelle |

| Anti-Bot-Umgehung | Manuell: Delays, Proxies einbauen | Integriert: menschliches Timing, Cloud-IPs |

| Subpage-Scraping | Für jede Ebene manuell einrichten | Ein Klick: „Subpages scrapen“ |

Thunderbit ist wie ein smarter Assistent, der jede Seite findet, jeden Button klickt und sich nie verirrt – selbst wenn die Website den Weg versteckt.

Best Practices für Web-Scraper-Pagination

Egal ob du Thunderbit oder ein anderes Tool nutzt – hier ein paar Tipps, damit du alle Daten bekommst (und keine Kopfschmerzen):

- Pagination-Muster erkennen: Schau dir vorher an, wie die Seite paginiert. Seitenzahlen? „Mehr laden“? Infinite Scroll? Das hilft bei der Tool-Auswahl.

- Das richtige Tool wählen: Für einfache Pagination reichen Basis-Scraper. Für Infinite Scroll oder dynamische Seiten nutze browserbasierte oder KI-gestützte Tools wie Thunderbit.

- Keine Seiten auslassen: Kontrolliere, ob wirklich alle Daten erfasst wurden. Wenn die Seite „500 Ergebnisse“ anzeigt, solltest du auch so viele erhalten.

- Duplikate vermeiden: Manche Seiten zeigen Einträge auf mehreren Seiten. Nutze eindeutige IDs (z.B. Produkt-URLs), um doppelte Ergebnisse zu entfernen.

- Anfragen drosseln: Zu viele Anfragen in kurzer Zeit führen zu Sperren. Thunderbit imitiert menschliches Verhalten, aber beim eigenen Code solltest du Pausen einbauen.

- Proxies für große Jobs: Wer hunderte Seiten scrapt, sollte IPs rotieren. Thunderbits Cloud-Modus übernimmt das automatisch.

- Fehler einplanen: Manchmal lädt eine Seite nicht. Fehler protokollieren, fehlende Seiten nachholen und Ergebnisse prüfen.

- KI-Funktionen nutzen: Bei komplexer Pagination (z.B. AJAX oder Cursor-basiert) helfen KI-Web-Scraper, die Komplexität zu meistern.

- Richtlinien beachten: Prüfe immer, ob Scraping erlaubt ist. Server nicht überlasten und Datenschutz respektieren.

Praxisbeispiele für Web-Scraper-Pagination

So sieht das Scraping auf echten Websites aus:

1. Amazon (nummerierte Pagination, Anti-Bot)

Amazon nutzt klassische Seitenzahlen, ist aber sehr streng beim Blockieren von Bots. Thunderbit erkennt „Weiter“-Buttons oder Seitenlinks und klickt sich im Browser-Modus durch, um wie ein echter Nutzer zu wirken. Im Cloud-Modus können mehrere Seiten gleichzeitig geladen werden. Bei Captchas hilft das menschliche Timing von Thunderbit, Sperren zu vermeiden.

2. Zillow (nummeriert, Seitenlimit)

Zillow zeigt Immobilienangebote paginiert, aber maximal 20 Seiten (ca. 800 Einträge). Thunderbit klickt automatisch durch Seiten 1–20 und stoppt, wenn es kein „Weiter“ mehr gibt. Für mehr Ergebnisse muss die Suche eingegrenzt werden (Thunderbit hilft beim Filtern und Scrapen in mehreren Durchgängen).

3. LinkedIn (Infinite Scroll Hybrid)

Die Jobsuche bei LinkedIn (ohne Login) nutzt Infinite Scroll – mehr Jobs erscheinen beim Scrollen. Thunderbit schaltet in den Infinite-Scroll-Modus und sammelt alle Einträge, bis keine neuen mehr erscheinen. Mit Login und Seitenzahlen passt sich Thunderbit an und klickt durch.

4. Yelp (Offset-Pagination)

Yelp verwendet Offset-Pagination (z.B. start=10 in der URL). Thunderbit klickt „Weiter“ oder erhöht den Offset automatisch. Wenn Yelp nach deinem Standort fragt, kann Thunderbit das im Browser-Modus handhaben.

5. AliExpress (Hybrid: Scroll + Seiten)

AliExpress lädt beim Scrollen mehr Produkte nach und zeigt manchmal zusätzlich einen „Weiter“-Button. Thunderbit scrollt, um möglichst viele Produkte zu laden, und klickt dann weiter, falls nötig. Ein echtes Schweizer Taschenmesser für Pagination.

Fehlerbehebung bei Web-Scraper-Pagination

Auch mit den besten Tools kann mal was schiefgehen. Darauf solltest du achten – und so hilft Thunderbit:

- Nur die erste Seite erhalten: Prüfe, ob Pagination im Tool aktiviert ist. In Thunderbit den „Paginieren“-Schalter kontrollieren. Bei Bedarf manuell „Nächste Seite scrapen“ klicken.

- Fehlende Daten: Vergleiche die Anzahl der Ergebnisse mit der Angabe auf der Website. Fehlen Daten, Scraping wiederholen oder gezielt die fehlenden Seiten ansteuern.

- Scraper bleibt hängen: Bei Infinite Scroll kann es zu Hängern kommen, wenn Inhalte langsam laden. In Thunderbit hilft der Browser-Modus oder das Setzen einer maximalen Scrollzeit.

- Duplikate oder falsche Reihenfolge: Nach eindeutigen IDs deduplizieren. Thunderbit hält meist die Reihenfolge, ansonsten kannst du in Excel sortieren.

- Wiederholte oder leere Seiten: Der Scraper sollte am Ende stoppen. Thunderbits KI erkennt das automatisch, beim eigenen Code sollte die Schleife enden, wenn keine neuen Daten mehr erscheinen.

Thunderbits KI ist darauf ausgelegt, die meisten dieser Probleme automatisch zu lösen – Pagination erkennen, menschliche Pausen einbauen, fehlgeschlagene Seiten erneut versuchen. Und falls du auf ein neues Muster stößt, wird die KI von Thunderbit laufend weiterentwickelt.

Fazit: So holst du das Maximum aus Web-Scraper-Pagination heraus

Hier die wichtigsten Punkte für das Scraping paginierter Seiten:

- Pagination-Typ erkennen: Nummeriert, „Mehr laden“, Infinite Scroll oder Weiter/Zurück? Wissen, womit du es zu tun hast.

- Das richtige Tool wählen: Für komplexe oder dynamische Seiten KI-Web-Scraper wie nutzen.

- Alle Seiten scrapen: Nicht bei Seite 1 aufhören – den kompletten Datensatz erfassen.

- Auf Fehler achten: Fehlende Daten, Duplikate oder Sperren erkennen.

- Anfragen drosseln und rotieren: Sperren vermeiden durch langsames Vorgehen und ggf. Proxies.

- Zeitplanung nutzen: Für wiederkehrende Aufgaben einen Scheduler verwenden (Thunderbits Sprach-Scheduler macht das besonders einfach).

- KI für Datenbereinigung: Thunderbits Field AI hilft beim Labeln, Deduplizieren und Organisieren der Daten schon beim Scraping.

- Von echten Beispielen lernen: Typische Website-Muster erkennen und die Strategie anpassen.

- Vorlagen nutzen: Thunderbit bietet Ein-Klick-Vorlagen für viele bekannte Seiten – das spart Zeit.

- Ethik beachten: Immer die Richtlinien und Datenschutzregeln der Website respektieren.

Pagination im Web kann eine Hürde sein – mit dem richtigen Wissen und den passenden Tools wird sie aber zum Kinderspiel. Dank Thunderbits KI-Ansatz verbringst du weniger Zeit mit dem Kampf gegen Pagination und mehr Zeit damit, deine Daten sinnvoll zu nutzen.

FAQs

1. Was ist Web-Pagination und warum nutzen Websites sie?

Web-Pagination bedeutet, lange Listen (wie Produktangebote oder Suchergebnisse) in mehrere kleinere Seiten zu unterteilen. Das verbessert die Nutzerfreundlichkeit, die Ladezeiten und die Übersichtlichkeit – Nutzer finden sich leichter zurecht, Inhalte laden schneller und sind besser strukturiert.

2. Warum ist Pagination beim Web-Scraping wichtig?

Wenn dein Web-Scraper nur die erste Seite einer Website ausliest, verpasst du meist den Großteil der relevanten Daten. Viele Business-Anwendungen – etwa Lead-Generierung, Preisüberwachung oder Marktforschung – erfordern das Scrapen aller Seiten für einen vollständigen Datensatz.

3. Welche Pagination-Typen sind am häufigsten?

Die wichtigsten Varianten sind:

- Nummerierte Pagination: Seiten mit 1, 2, 3 usw.

- „Mehr laden“-Buttons: Weitere Ergebnisse erscheinen ohne Neuladen der Seite.

- Unendliches Scrollen: Neue Inhalte werden beim Scrollen automatisch geladen.

- Weiter/Zurück-Links: Navigation jeweils eine Seite vor oder zurück.

Jeder Typ erfordert eine eigene Scraping-Strategie.

4. Wie geht Thunderbit mit Pagination beim Web-Scraping um?

Thunderbit nutzt KI, um alle gängigen Pagination-Typen automatisch zu erkennen und zu steuern – von Seitenzahlen über „Mehr laden“-Buttons bis zu Infinite Scroll. Im Browser-Modus werden dynamische Seiten unterstützt, im Cloud-Modus können bis zu 50 Seiten parallel verarbeitet werden – ganz ohne Programmierung.

5. Was sind Best Practices beim Scrapen paginierter Websites?

- Vorab den Pagination-Typ bestimmen.

- Tools nutzen, die mit dynamischen Inhalten umgehen können (wie Thunderbit).

- Immer prüfen, ob alle Seiten erfasst wurden (nicht nur die erste).

- Daten mit eindeutigen IDs deduplizieren.

- Anfragen drosseln und für große Jobs Proxies einsetzen.

- Die Nutzungsbedingungen und Datenschutzregeln der Website respektieren.

Mehr erfahren: