Wer kennt es nicht: Man sitzt vor einem Haufen offener Browser-Tabs und verbringt gefühlt eine Ewigkeit damit, Namen, E-Mail-Adressen und Preise per Copy & Paste in eine Tabelle zu übertragen – bis die Finger vom ständigen Strg+C fast streiken. Gerade im Vertrieb, E-Commerce oder in der Organisation ist das Alltag: endlose Copy-Paste-Sessions, die am Ende nur ein schmerzendes Handgelenk und eine fehlerhafte Tabelle hinterlassen. Fakt ist: In vielen Unternehmen gehört die manuelle Datenerfassung immer noch zum Tagesgeschäft. Im Schnitt verbringen Büroangestellte rund und kommen auf über . Rechnet man das auf ein 20-köpfiges Team hoch, sind das über eine Million Copy-Paste-Vorgänge jährlich – ein echter Produktivitätskiller.

Die gute Nachricht: Data Scraping hat sich von diesen mühsamen Anfängen zu einer Ära der KI-gestützten Automatisierung entwickelt. Heute ermöglichen Tools wie , dass wirklich jeder – nicht nur IT-Profis – Webdaten in wenigen Minuten statt Tagen extrahieren kann. Schauen wir uns an, was Data Scraping eigentlich bedeutet, warum es so wichtig ist und wie KI die Spielregeln für Unternehmen verändert.

Data Scraping Bedeutung: Was ist Data Scraping?

Kurz gesagt: Data Scraping ist der Einsatz von Software, um Informationen aus Webseiten oder digitalen Dokumenten zu sammeln und in eine strukturierte Form zu bringen – zum Beispiel in Tabellen, Datenbanken oder Google Sheets. Wenn du dir schon mal gewünscht hast, einen Praktikanten zu klonen, der all das Copy-Paste übernimmt: Data Scraping ist wie ein digitaler Helfer, der nie müde wird, sich nicht ablenken lässt und keine Gehaltserhöhung fordert.

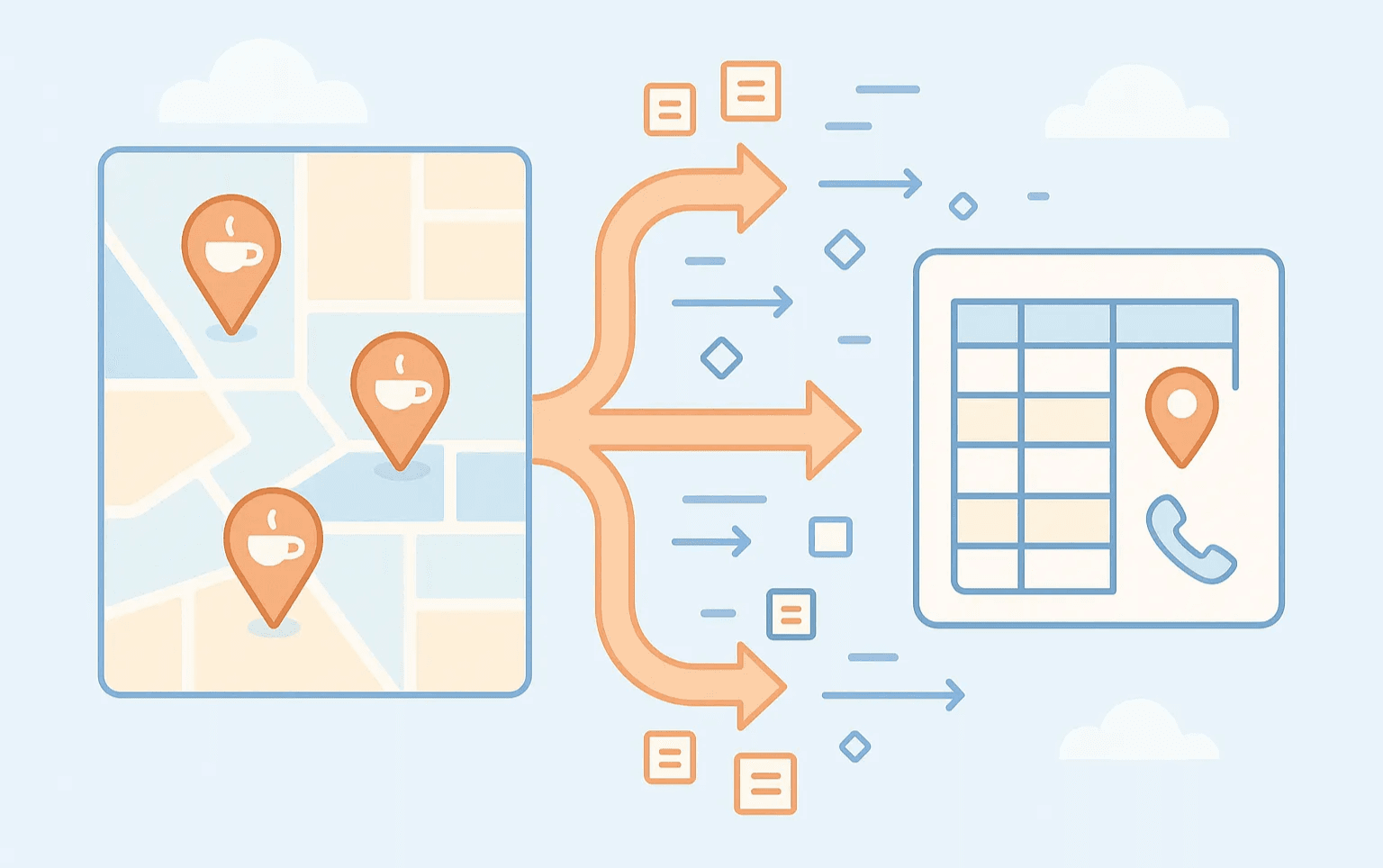

Wie sieht Data Scraping im Alltag aus? Stell dir vor, du möchtest eine Liste aller Cafés in deiner Stadt samt Adresse und Telefonnummer. Statt alles einzeln zu kopieren, besucht ein Data Scraping Tool die Website, sammelt die gewünschten Infos und liefert sie dir als übersichtliche Tabelle. Das Grundprinzip: Daten aus Webseiten oder digitalen Quellen extrahieren und in ein nutzbares Format umwandeln – für Analysen, Akquise oder Automatisierung.

Typische Ergebnisse sind:

- Excel- oder CSV-Dateien

- Google Sheets

- Datenbanken (für die Technikaffinen)

- Direkte Anbindung an Tools wie Airtable oder Notion

Und die Einsatzmöglichkeiten? Die sind überall: Lead-Generierung, Preisbeobachtung, Marktforschung, Immobilienanalysen und vieles mehr.

Warum Data Scraping für moderne Unternehmen unverzichtbar ist

Klar ist: In der digitalen Welt gewinnt, wer die besten Daten hat. Egal ob Vertrieb, E-Commerce, Marketing oder Immobilien – wer schnell relevante Webdaten sammeln, auswerten und nutzen kann, verschafft sich einen klaren Vorsprung. Deshalb ist Data Scraping so wichtig:

- Spart Zeit: Automatisiert wiederkehrende Recherche und Dateneingabe – mehr Zeit für die wirklich wichtigen Aufgaben.

- Erhöht Genauigkeit: Reduziert Fehlerquellen und sorgt für aktuelle Daten.

- Skaliert mühelos: Erlaubt das Sammeln von Daten aus Hunderten oder Tausenden Seiten – per Hand unmöglich.

- Steigert den ROI: Mehr Leads, bessere Preisgestaltung, schnellere Marktanalysen.

Konkret sieht das so aus:

| Unternehmensbereich | Data Scraping Anwendungsfall | Vorteil/ROI |

|---|---|---|

| Vertrieb | Leads und Kontaktdaten extrahieren | 10x mehr Leads, Stunden an Recherche gespart |

| E-Commerce | Wettbewerberpreise und SKUs überwachen | Echtzeit-Preisreaktionen, Margensicherung |

| Immobilien | Immobilienangebote und Preise sammeln | Schnellere Deals, aktuelle Marktdaten |

| Marketing | Kampagnendaten oder Social Insights erfassen | Besseres Targeting, höhere Kampagnenleistung |

| Operations | Routinemäßige Datenerfassung automatisieren | Weniger Personalkosten, weniger Fehler |

Kein Wunder, dass sagen, Automatisierung spare Mitarbeitenden 10–50 % ihrer Zeit bei manuellen Aufgaben. Und fast glauben, sie könnten wöchentlich sechs oder mehr Stunden sparen, wenn wiederkehrende Aufgaben automatisiert wären.

Vom manuellen Copy-Paste zu Data Scraping Tools

Hand aufs Herz: Manuelles Copy-Paste ist der „Urvater“ des Data Scraping. So haben wir alle mal angefangen – langsam, fehleranfällig und ungefähr so spannend wie Farbe beim Trocknen zuzusehen.

Die klassische Methode: Manuelles Copy-Paste

- Einrichtungsaufwand: Keiner (Browser öffnen und loslegen)

- Bedienung: Einfach, aber bei großen Datenmengen zermürbend

- Genauigkeit: Für kleine Mengen okay, bei Müdigkeit schleichen sich Fehler ein

- Skalierbarkeit: Sehr gering – es sei denn, du hast ein Heer an Praktikanten (und viel Pizza)

Die erste Generation: Frühe Data Scraping Tools

Dann kamen die ersten Data Scraping Tools – etwa Excel-Webabfragen, einfache Browser-Erweiterungen oder Point-and-Click-Scraper. Sie automatisierten einen Teil der Arbeit, aber oft musste man:

- Jedes Datenfeld manuell auswählen

- Grundkenntnisse zu HTML-Tags oder XPath mitbringen

- Einstellungen anpassen, sobald sich die Website änderte

Sie waren ein Fortschritt, aber erforderten immer noch technisches Verständnis (und manchmal ein paar YouTube-Tutorials).

Data Scraping Methoden im Vergleich

Hier ein direkter Vergleich:

| Methode | Einrichtungsaufwand | Bedienkomfort | Genauigkeit & Wartung | Skalierbarkeit | Erforderliche Kenntnisse |

|---|---|---|---|---|---|

| Manuelles Copy-Paste | Keiner, aber langsam | Einfach, monoton | Fehleranfällig bei großen Mengen | Sehr gering | Grundkenntnisse PC |

| Klassische Tools | Mittel bis hoch | Mittel, Lernkurve | Hoch bei richtiger Konfiguration, aber anfällig | Hoch (mit Aufwand) | Web-/Technikkenntnisse nötig |

| KI Data Scraping | Minimal | Sehr einfach – einfach beschreiben, was man will | Sehr anpassungsfähig, passt sich Änderungen an | Mittel bis hoch | Keine – Browser reicht |

Das Fazit: Manuelles Scraping reicht für kleine Datenmengen, klassische Tools skalieren, erfordern aber Know-how und Pflege. KI-gestütztes Scraping vereint das Beste aus beiden Welten: einfach für Einsteiger, leistungsstark für Unternehmen.

Die Ära des KI Data Scraping: Ein Quantensprung

Jetzt wird’s spannend: Die neueste Entwicklung ist KI Data Scraping – Tools, die mit künstlicher Intelligenz Webseiten „verstehen“, die richtigen Daten extrahieren und sie sogar direkt aufbereiten.

Statt Extraktionsregeln zu konfigurieren oder CSS-Selektoren zu lernen, sagst du der KI einfach, was du brauchst („Gib mir alle Produktnamen und Preise von dieser Seite“) – und der Rest läuft automatisch. Keine komplizierten Oberflächen mehr, keine Panik bei Website-Änderungen.

Dieser Wandel von regelbasierten zu KI-gesteuerten Tools ist ein echter Sprung nach vorn. Das bedeutet:

- Kein technisches Setup: Du brauchst kein HTML, keine Scripte, kein Hintergrundwissen.

- Schnellere Ergebnisse: Was früher Stunden an Konfiguration kostete, dauert jetzt Minuten – manchmal sogar Sekunden.

- Robuster: KI passt sich an moderate Änderungen im Seitenaufbau an, sodass dein Scraper nicht bei jedem Redesign ausfällt.

Thunderbit: KI Data Scraping für alle zugänglich machen

Hier kommt mein Lieblingsthema: . Wir haben Thunderbit entwickelt, weil wir gesehen haben, dass klassische Data Scraping Tools – selbst die „No-Code“-Lösungen – für Nicht-Techniker oft zu kompliziert waren. Die Lernkurve war zu steil, die Einrichtung zu aufwendig, die Frustration zu groß.

Thunderbit dreht den Spieß um. So funktioniert’s:

- KI-Feldvorschläge: Ein Klick, und Thunderbits KI liest die Seite, schlägt die wichtigsten Datenfelder vor und benennt die Spalten. Kein Suchen nach CSS-Selektoren mehr.

- Subpage Scraping: Du brauchst Details von verlinkten Unterseiten (z. B. Produktspezifikationen oder Immobilieninfos)? Thunderbit besucht automatisch jede Unterseite und ergänzt deine Daten.

- Sofort-Vorlagen: Für bekannte Seiten (Amazon, Zillow, Google Maps usw.) einfach eine Vorlage auswählen und mit einem Klick Daten extrahieren.

- Kostenloser Datenexport: Exportiere nach Excel, Google Sheets, Airtable oder Notion – ohne Zusatzkosten, ohne Stress.

- Null Technik-Hürde: Wer einen Browser bedienen kann, kann Thunderbit nutzen. Kein Code, keine Einrichtung, nur Ergebnisse.

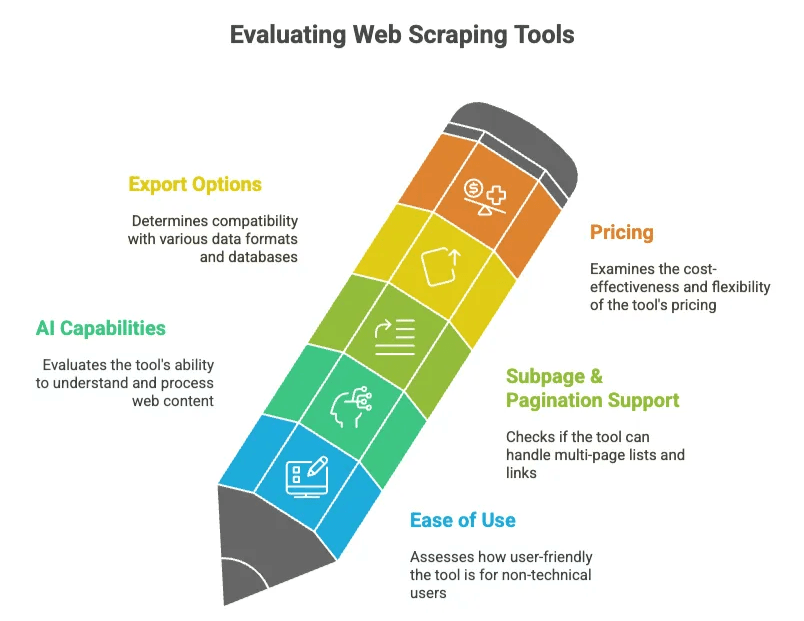

Data Scraping Tools: Worauf sollte man achten?

- Benutzerfreundlichkeit: Kommt auch ein nicht-technischer Kollege ohne Schulung ans Ziel?

- KI-Funktionen: Versteht das Tool die Seite selbstständig oder muss man ständig nachjustieren?

- Unterseiten & Paginierung: Kann es mehrseitige Listen und Links zu Detailseiten abarbeiten?

- Exportmöglichkeiten: Funktioniert der Export in deine bevorzugte Tabelle oder Datenbank?

- Preisgestaltung: Zahlst du für Funktionen, die du nie nutzt, oder ist das Angebot flexibel?

Vergleichen wir Thunderbit mit anderen bekannten Tools:

| Tool | Plattform | Hauptfunktionen | Bedienkomfort | Preis (ab) | Ideal für |

|---|---|---|---|---|---|

| Thunderbit | Chrome-Erweiterung | KI-gestützt, Subpage Scraping, Sofort-Export | Sehr hoch | ca. 9 €/Monat | Nicht-technische Anwender |

| Octoparse | Desktop/Cloud | Visueller Workflow, dynamische Inhalte, Vorlagen | Mittel, Lernkurve | ca. 119 €/Monat | Datenanalysten, Power-User |

| ParseHub | Desktop/Cloud | Point-and-Click, dynamische Seiten, Zeitplanung | Mittel | ca. 189 €/Monat | Komplexe Scraping-Projekte |

| Apify | Cloud | Actor-Marktplatz, API, Zeitplanung | Unterschiedlich (einfach mit Vorlagen, technisch bei Eigenbau) | ca. 49 €/Monat | Entwickler, Großprojekte |

| Browse.ai | Cloud/Erweiterung | No-Code-Recorder, Monitoring, Integrationen | Hoch für Basics | ca. 39 €/Monat | Website-Monitoring |

| Bardeen | Erweiterung/Cloud | Workflow-Automatisierung, KI-Playbooks | Mittel | ca. 10 €/Monat | Workflow-Automatisierung |

Thunderbit richtet sich an Business-Anwender, die schnell und zuverlässig Daten extrahieren wollen – ohne Technik-Frust. Ob Vertrieb, E-Commerce, Immobilien oder Marketing: Wer Ergebnisse statt Konfiguration will, ist bei Thunderbit richtig.

Was moderne Data Scraping Tools auszeichnet

Das macht moderne (vor allem KI-gestützte) Data Scraping Tools besonders:

- KI-Feldvorschläge: Kein mühsames Anklicken jedes Felds – die KI erkennt relevante Daten und schlägt Spalten vor.

- Subpage Scraping: Automatisches Folgen von Links für tiefere Infos (z. B. Produktspezifikationen oder Eigentümerdaten).

- Dynamische Inhalte: Funktioniert auch bei Infinite Scroll, AJAX und JavaScript-lastigen Seiten – ohne manuelle Einstellungen.

- Cloud- vs. Browser-Scraping: Wähle zwischen Ausführung im Browser (ideal für eingeloggte Seiten) oder in der Cloud (schneller für öffentliche Daten).

- Geplantes Scraping: Einmal einrichten, regelmäßig frische Daten erhalten – täglich, wöchentlich oder nach Bedarf.

- Integrierte Datenbereinigung: Die KI kann Formate vereinheitlichen, übersetzen oder Daten direkt kategorisieren.

- Vorlagen: Ein-Klick-Setups für bekannte Seiten – kein Rad neu erfinden.

All diese Funktionen haben ein Ziel: Dich so schnell und einfach wie möglich von „Ich brauche diese Daten“ zu „Hier ist meine Tabelle“ zu bringen.

Praxisbeispiele: Data Scraping im Unternehmenseinsatz

Konkret – so nutzen Unternehmen KI Data Scraping Tools wie Thunderbit:

Vertrieb: Leads und Kontaktdaten extrahieren

Ein Vertriebsteam möchte eine Liste lokaler Unternehmen für die Akquise erstellen. Statt tagelang Namen und E-Mails aus Verzeichnissen zu kopieren, nutzt es Thunderbit und hat die Daten in Minuten. Eine Agentur bei der Recherche und erzielte einen .

E-Commerce: Wettbewerberpreise und SKUs überwachen

Ein E-Commerce-Manager will die Preise der Konkurrenz im Blick behalten. Statt jedes Produkt einzeln zu prüfen, lässt er Thunderbit täglich Preise scrapen und wird bei Preisänderungen benachrichtigt. So bleiben Margen geschützt und das Unternehmen kann schnell auf Marktveränderungen reagieren.

Immobilien: Immobilienangebote und Preise sammeln

Ein Immobilienmakler möchte keine neuen Angebote verpassen. Thunderbit durchsucht Zillow oder nach aktuellen Objekten samt Preis, Lage und Beschreibung. Der Makler erhält täglich eine aktuelle Tabelle mit neuen Chancen – kein FOMO mehr.

Marketing: Kampagnendaten oder Social Media Insights sammeln

Ein Marketingteam extrahiert mit Thunderbit alle Friseursalons einer Stadt aus Google Maps – inklusive Bewertungen – um eine lokale Kampagne zu planen. Oder es sammelt Social-Media-Erwähnungen, um die Markenwahrnehmung zu analysieren – ohne tausende Posts manuell zu lesen.

Typische Herausforderungen beim Data Scraping meistern

- Website-Änderungen: Klassische Scraper scheitern oft bei Layout-Updates. KI-Scraper wie Thunderbit erkennen relevante Daten auch bei geänderten HTML-Strukturen.

- Anti-Scraping-Maßnahmen: Viele Seiten versuchen Bots zu blockieren. Browserbasierte KI-Scraper verhalten sich wie echte Nutzer und werden seltener gesperrt.

- Unsaubere Daten: KI kann Daten schon beim Extrahieren bereinigen und formatieren – weniger Nacharbeit in der Tabelle.

- Skalierbarkeit: Für die meisten Business-Anwendungen reichen browserbasierte Tools, für große Projekte gibt es Cloud-Optionen.

- Rechtliche Aspekte: Prüfe immer die Nutzungsbedingungen und robots.txt einer Seite, vermeide das Scrapen personenbezogener Daten und halte dich an Limits. ist nachhaltiges Scraping.

Best Practice: Wenn du nicht offen sagen würdest, wie du an die Daten gekommen bist, solltest du das Scraping überdenken.

Die Zukunft von Data Scraping: KI-Automatisierung für alle

Die Zeiten mühsamer Copy-Paste-Arbeit sind vorbei. Data Scraping ist vom Technik-Nischenthema zum unverzichtbaren Business-Tool geworden – und dank KI jetzt für jeden zugänglich.

Was kommt als Nächstes? Noch intelligentere KI-„Datenagenten“, die komplexe Aufgaben per natürlicher Sprache erledigen („Zeig mir alle neuen Angebote unter 500.000 € in Berlin diese Woche“). Echtzeit-Datenfeeds, tiefere Integration in Geschäftsprozesse und bessere Compliance-Lösungen stehen bevor.

Unsere Mission bei Thunderbit: Data Scraping demokratisieren – so einfach machen, dass jeder im Unternehmen Webdaten nutzen kann. Keine Technikbarrieren, keine verschwendeten Stunden. Einfach beschreiben, was du brauchst – die KI erledigt den Rest.

Also: Wenn du das nächste Mal zum „Kopieren“-Button greifst, denk dran – es gibt einen besseren Weg. Die Zukunft des Data Scraping ist da, und sie heißt KI. Du willst es ausprobieren? und erlebe den Wandel von Handarbeit zu Automatisierung (okay, ich verspreche keine „Magie“, aber manchmal fühlt es sich wirklich so an).

Häufige Fragen:

1. Was ist Data Scraping?

Data Scraping bezeichnet den Einsatz von Software, um Informationen aus Webseiten oder digitalen Dokumenten zu sammeln und in strukturierte Formate wie Tabellen, Datenbanken oder Google Sheets zu überführen.

Statt mühsam zu kopieren und einzufügen, „besucht“ ein Scraper die Seiten, erkennt relevante Elemente (z. B. Produktnamen, Preise, Kontaktdaten) und exportiert sie in Tabellen. So wird die Datensammlung für Analyse, Akquise oder Reporting beschleunigt und Fehler werden minimiert.

2. Warum ist Data Scraping für moderne Unternehmen wichtig?

Im heutigen, schnelllebigen Markt sind aktuelle und präzise Daten entscheidend für bessere Entscheidungen. Automatisiertes Scraping spart Teams viele Stunden, erhöht die Genauigkeit und ermöglicht das Sammeln von Daten aus Hunderten oder Tausenden Seiten.

Ob Preisbeobachtung, Lead-Generierung oder Marktforschung – Unternehmen gewinnen an Agilität und erhalten wertvolle Einblicke, indem sie Rohdaten in verwertbare Informationen verwandeln.

3. Wie vereinfacht Thunderbit die KI-gestützte Webdatenerfassung?

Die Chrome-Erweiterung von Thunderbit nutzt KI, um Felder vorzuschlagen, automatisch Links zu Unterseiten zu folgen und Spaltennamen zu generieren – ganz ohne Programmier- oder CSS-Kenntnisse. Mit Ein-Klick-Vorlagen für Seiten wie Amazon oder Zillow kannst du Preise, Kontaktdaten, Bewertungen und mehr in Minuten extrahieren. Exportiere direkt nach Google Sheets, Airtable oder Excel und plane wiederkehrende Scrapes, um deine Daten aktuell zu halten.

Mehr erfahren? Hier findest du weitere Ressourcen: