Ich erinnere mich noch genau an meinen allerersten Versuch, Webdaten für ein Nebenprojekt zu sammeln – nur mit einem einfachen Python-Skript, einer großen Tasse Kaffee und viel zu viel Optimismus. Kaum hatte die Website ein neues Design, war mein Code komplett nutzlos und der Koffeinschub wich schnell Kopfschmerzen. Spulen wir ins Jahr 2025 vor: Heute verwandeln KI-Web-Scraper selbst die chaotischsten Webseiten in wenigen Minuten in saubere Tabellen – und das ganz ohne Programmierkenntnisse. Es fühlt sich an, als hätte man einen Super-Praktikanten, der nie nach einer Gehaltserhöhung fragt oder montags verschläft.

Egal ob du im Vertrieb, Marketing, E-Commerce unterwegs bist oder einfach ein Datenfan bist – eines steht fest: Das Web ist die größte Datenbank der Welt. Doch an die Daten zu kommen – schnell, zuverlässig und ohne Nervenverlust – war früher eine echte Herausforderung. Das hat sich geändert. KI-Web-Scraper machen die datenextraktion für alle zugänglich, nicht nur für Entwickler. In diesem Guide zeige ich dir die 15 besten KI-Web-Scraping-Tools für 2025, inklusive Features, Vor- und Nachteilen sowie den besten Anwendungsfällen. Egal, ob du automatisiert Leads sammeln, Preise überwachen oder endlich das Copy-Paste hinter dir lassen willst – hier findest du das passende Tool.

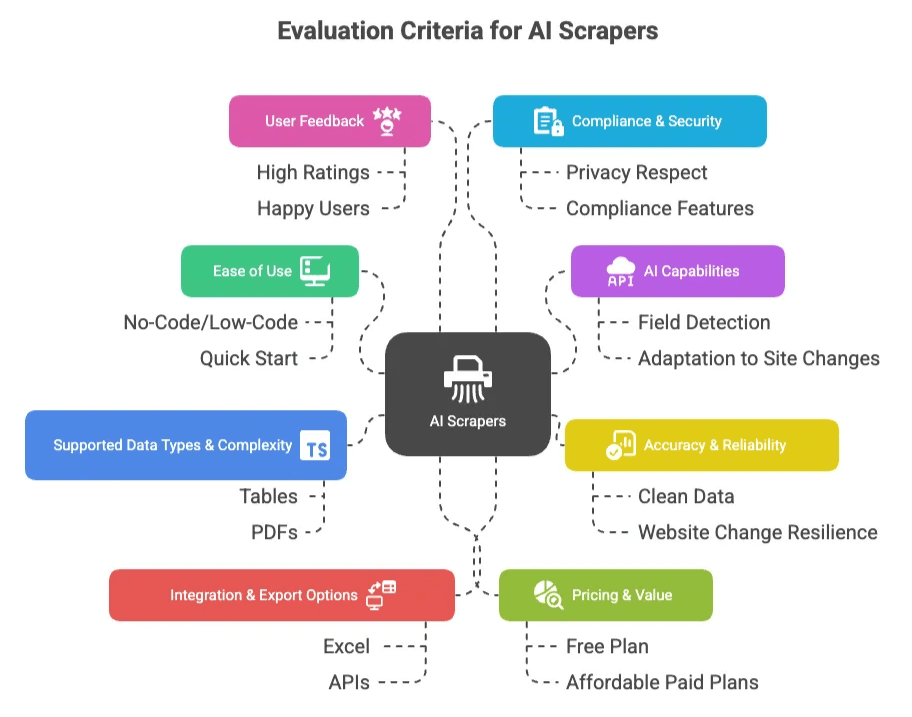

So haben wir die besten KI-Web-Scraper für die Datenextraktion bewertet

Bevor wir zur Liste kommen, ein kurzer Blick auf die Auswahlkriterien. Nach Jahren in der SaaS- und Automatisierungswelt kenne ich die typischen Stolpersteine – deshalb habe ich nach Tools gesucht, die diese wirklich lösen. Das war mir wichtig:

- Benutzerfreundlichkeit: Ist das Tool wirklich ohne oder mit wenig Code nutzbar? Kommen auch Nicht-Techniker schnell zurecht oder braucht man einen Doktortitel in XPath?

- KI-Funktionen: Nutzt der Web-Scraper KI, um Felder zu erkennen, sich an Webseitenänderungen anzupassen oder unstrukturierte Daten zu verstehen? Je mehr die KI übernimmt, desto besser.

- Genauigkeit & Zuverlässigkeit: Wie sauber und strukturiert sind die Ergebnisse? Funktioniert das Tool auch nach Website-Updates oder bricht es sofort ab?

- Unterstützte Datentypen & Komplexität: Kommt das Tool mit Tabellen, Listen, Bildern, PDFs, Logins, Endlos-Scroll und mehrstufigen Workflows klar? Und wie sieht es mit der Skalierbarkeit aus – lassen sich auch tausende Seiten extrahieren?

- Integration & Export: Lässt sich das Tool mit Excel, Google Sheets, Airtable, Notion, APIs oder anderen Business-Tools verbinden? Je weniger Handarbeit, desto besser.

- Preis-Leistungs-Verhältnis: Gibt es einen kostenlosen Plan oder eine Testphase? Sind die Preise fair für die gebotenen Funktionen? Gibt es versteckte Kosten?

- Nutzerfeedback: Ich habe Bewertungen auf G2, Capterra, Trustpilot und im Chrome Store gecheckt. Tools mit Top-Bewertungen und zufriedenen Nutzern bekamen Pluspunkte, bei häufigen Beschwerden habe ich genauer hingeschaut.

- Datenschutz & Sicherheit: Achtet das Tool auf Privatsphäre, geht es verantwortungsvoll mit sensiblen Daten um und gibt es Compliance-Features für Unternehmen?

Mit all diesen Faktoren – und nach dem Lesen unzähliger Nutzerbewertungen – habe ich die 15 besten KI-Web-Scraper ausgewählt. Jedes Tool hat seine eigenen Stärken, egal ob du als Business-Anwender ohne Technikkenntnisse startest oder als Entwickler das nächste große Projekt baust.

Schnellvergleich: Die 15 besten KI-Web-Scraper im Überblick

Hier findest du einen direkten Vergleich der Top-Tools. Für Details zu jedem einzelnen Tool einfach weiterlesen!

| Tool | Wichtige Funktionen (KI & Automatisierung) | Ideal für | Vorteile | Nachteile | Kostenloser Plan? |

|---|---|---|---|---|---|

| Thunderbit | Chrome-Erweiterung, KI-Feldvorschläge, Unterseiten & Paginierung, Sofort-Export, KI-Datenbereinigung | Nicht-technische Teams, Vertrieb, E-Commerce, Immobilien | Extrem einfach, schneller Einstieg, kostenlose Exporte | Kostenloses Kontingent begrenzt, weniger flexibel für Coder | Ja |

| Octoparse | Visueller Workflow, KI-Vorlagen, Cloud/Lokal, Logins, Zeitplanung | Analysten, Forscher, semi-technische Nutzer | Leistungsstark, komplexe Seiten, große Vorlagenbibliothek | Lernkurve, Cloud kostet extra | Ja |

| Browse AI | Point-and-Click-Roboter, KI passt sich an, Zeitplanung, Monitoring, Integrationen | Business-Anwender, wiederkehrende Daten/Monitoring | Einfache Einrichtung, Google Sheets-Integration, Benachrichtigungen | Verbrauchsbasierte Preise, weniger granular für Entwickler | Ja |

| Bardeen | Chrome-Erweiterung, KI-Playbooks, Workflow-Automatisierung, GPT-4, Tabellenintegration | Power-User, Marketer, mehrstufige Automatisierung | Automatisiert Scraping + Aktionen, kostenloser Plan | Komplexe Flows erfordern Einarbeitung | Ja |

| ScrapeStorm | KI-Smart/Flowchart-Modus, plattformübergreifend, Proxys, Zeitplanung, visuelle Oberfläche | Einsteiger & Profis, E-Commerce, Forschung | Visuell, integrierte Proxys, flexibel | Fortgeschrittene Funktionen weniger einsteigerfreundlich | Ja |

| ScrapingBee | API-first, KI-Extraktion, Proxy-Handling, Headless-Browser | Entwickler, Data Engineers, große Projekte | Entwicklerfreundlich, skalierbar, KI-Parsing | Nicht für No-Code-User | Limitierte Testphase |

| Import.io | ML-Extraktoren, Screenshot, Verkettung, Zeitplanung, Compliance | Unternehmen, hohe Volumen, Compliance-Teams | Skalierbar, Managed Services, Compliance | Teuer, überdimensioniert für kleine Jobs | Nein |

| ParseHub | Visuelle Desktop-App, dynamische Inhalte, Bedingungen, Zeitplanung (bezahlt) | Semi-technische Nutzer, Forscher, komplexe Seiten | Komplexe Seiten, kostenloser Plan | Umständliche UI, Lernkurve, keine integrierten Proxys | Ja |

| Kadoa | No-Code-KI, selbstheilend, Echtzeit-Monitoring, Datenbereinigung | Finanzen, E-Commerce, Jobdaten, Monitoring | Selbstheilend, schnelle Benachrichtigungen, Daten-Normalisierung | Teuer, Features im Wandel | Testphase |

| Scrapy | Python-Framework, eigene Spider, skalierbar, Open Source | Entwickler, Ingenieure, individuelle Projekte | Kostenlos, flexibel, große Community | Programmierkenntnisse nötig, Wartung selbst | Ja |

| Webscraper.io | Browser-Erweiterung, Point-and-Click, Community-Sitemaps, Cloud-Option | Einsteiger, einfache Datenerfassung | Kostenlos, einfach, Community-Support | Keine KI, limitiert bei komplexen Seiten | Ja |

| Diffbot | KI/NLP/Computer Vision, Knowledge Graph, strukturierte APIs | Unternehmen, Forschung, Medienmonitoring | Kein Setup, breite Abdeckung, Knowledge Graph | Teuer, weniger Kontrolle bei Feldern | Testphase |

| AIScraper | Chrome-Erweiterung, natürliche Sprache, Presets, Unterseiten, schneller Export | Vertrieb, Lead-Gen, schnelle Datenaufgaben | Sehr schnell, Pay-as-you-go, einfach für Nicht-Techniker | Nicht für große Jobs, browserbasiert | Nein (Credits) |

| Gumloop | Visueller KI-Workflow-Builder, Chrome-Recorder, Integrationen, KI-Nodes | Technikaffine Teams, individuelle Automatisierung | Hochflexibel, mehrstufige Automatisierung | Teuer, Lernkurve | Testphase |

| scrapeless | KI-Scraping-API, Browser-Rendering, Anti-Bot, Datenbereinigung, Pay-per-Success | Entwickler, skalierbare Projekte, Unternehmen | Einfache API, robustes Anti-Blocking, Erfolgspreis | Kleine Community, manche Features nur für Unternehmen | Testphase |

| Oxylabs | API, 100M+ Proxys, KI-Copilot, Anti-Bot, Analytics-Dashboard | Unternehmen, technische Teams, große Skalierung | Enterprise-Qualität, KI-Copilot, 24/7 Support | Teuer, nicht für kleine Jobs | Testphase |

Hinweis: Für Details zu Preisen, Nutzerbewertungen und Anwendungsfällen einfach weiterlesen.

Was ist ein KI-Web-Scraper und wie funktioniert er?

Kurz gesagt: Ein KI-Web-Scraper nutzt künstliche Intelligenz, um Daten automatisiert von Webseiten zu extrahieren – oft mit minimalem Setup. Im Gegensatz zu klassischen Web-Scrapern, bei denen du genau angeben musst, was extrahiert werden soll (z.B. „Finde den Preis in diesem HTML-Tag“), setzen KI-Web-Scraper auf maschinelles Lernen, Computer Vision und NLP, um relevante Inhalte selbstständig zu erkennen.

Einfach ausgedrückt: Du sagst dem KI-Web-Scraper, was du brauchst (oft sogar in natürlicher Sprache), und er findet die Daten – selbst wenn sich das Layout der Seite ändert oder Inhalte dynamisch geladen werden. Weniger Zeit mit Selektoren, mehr Zeit für die eigentliche Arbeit.

Typische Anwendungsfälle:

- Datensammlung: Produktinfos, Preise, Bewertungen oder Nachrichtenartikel in Tabellen oder Datenbanken ziehen.

- Lead-Generierung: Kontaktdaten (E-Mails, Telefonnummern) aus Verzeichnissen oder sozialen Netzwerken extrahieren.

- Marktforschung: Wettbewerber beobachten, Trends verfolgen oder Stellenanzeigen aggregieren.

- Echtzeit-Monitoring: Preisänderungen, neue Angebote oder Breaking News automatisch überwachen.

KI-Web-Scraper kommen auch mit Endlos-Scroll, Unterseiten und dynamischen Inhalten klar – Dinge, an denen klassische Tools oft scheitern. Und weil sie intelligenter sind, können auch Nicht-Entwickler sie nutzen.

Wichtige Funktionen, auf die du bei einem KI-Web-Scraper achten solltest

Wenn du einen KI-Web-Scraper auswählst, solltest du auf Folgendes achten:

- No-Code- oder Low-Code-Oberfläche: Du willst Daten sammeln, nicht programmieren lernen. Tools mit Point-and-Click, Browser-Erweiterungen oder natürlicher Sprache sind ideal – so kann das ganze Team mitmachen.

- KI-gestützte Felderkennung & Strukturierung: Die besten Tools erkennen automatisch Tabellen, Listen, Preise, Namen und mehr. Das spart viel Zeit und funktioniert auch bei Website-Änderungen.

- Unterseiten- & Paginierungs-Support: Daten liegen selten nur auf einer Seite. Gute Web-Scraper folgen „Weiter“-Buttons, klicken in Detailseiten und holen Infos aus allen Ebenen.

- Export & Integration: Kannst du nach Excel, Google Sheets, Airtable, Notion oder ins CRM exportieren? Je mehr Integrationen, desto weniger Handarbeit.

- Zeitplanung & Automatisierung: Brauchst du täglich frische Daten? Dann ist ein integrierter Zeitplaner Gold wert.

- Dynamische Inhalte & Anti-Bot: Moderne Seiten nutzen JavaScript, Endlos-Scroll und Anti-Bot-Maßnahmen. Die besten Tools kommen damit klar – dank Headless-Browser, Proxys und intelligentem Warten.

- Datenbereinigung & Nachbearbeitung: Manche Tools können Daten direkt beim Scraping bereinigen, formatieren oder sogar übersetzen – so sind die Ergebnisse sofort auswertbar.

- Compliance & Sicherheit: Für Unternehmen sind Audit-Logs, PII-Masking und Datenschutz-Features wichtig.

- Skalierbarkeit & Support: Kann das Tool tausende Seiten verarbeiten? Gibt es guten Support oder eine aktive Community?

Welche Mischung du brauchst, hängt von deinem Projekt ab – für kleine Einmal-Jobs reicht oft ein einfaches Tool, für Datenpipelines im Unternehmen lohnen sich die Profi-Features.

Thunderbit: Der einfachste KI-Web-Scraper für Business-Anwender

Starten wir mit – ja, ich bin ein bisschen voreingenommen, aber es lohnt sich wirklich. Thunderbit richtet sich an alle, die Webseiten mit wenigen Klicks in Tabellen verwandeln wollen. Die Chrome-Erweiterung punktet mit Schnelligkeit, Einfachheit und KI-Intelligenz.

Was Thunderbit besonders macht:

- KI-Feldvorschläge: Einfach Webseite öffnen, „KI-Feldvorschläge“ klicken und Thunderbits KI erkennt sofort die wichtigsten Daten – Titel, Preise, Bilder, E-Mails und mehr. Die vorgeschlagene Tabelle kann angepasst werden, meist passt sie aber direkt.

- Unterseiten- & Paginierungs-Scraping: Listen mit Detailseiten? Thunderbit klickt automatisch alle Links durch und holt Zusatzinfos – so wird die Tabelle mit nur einem Klick angereichert. Auch Paginierung und Endlos-Scroll werden unterstützt, damit wirklich alle Daten erfasst werden.

- KI-Datenbereinigung & Transformation: Daten direkt beim Scraping übersetzen, kategorisieren oder zusammenfassen? Mit KI-Prompts kannst du die Daten on-the-fly formatieren oder verändern.

- Sofort-Export: Ein Klick genügt für den Export nach Excel, CSV, JSON, Google Sheets, Airtable und Notion – sogar im kostenlosen Plan.

- Kostenloses KI-Autofill: Thunderbit kann auch Online-Formulare per KI ausfüllen – praktisch für automatisierte Workflows.

- Vorlagen für beliebte Seiten: Amazon, Zillow, Instagram oder Shopify scrapen? Thunderbit bietet fertige Templates – kein Setup nötig.

Preise: Großzügiger Gratis-Plan (bis zu 6 Seiten/Monat, mit Testphase 10). Bezahlpläne ab 9 $/Monat für mehr Seiten, Cloud-Scraping und Zeitplanung. Alle Exportoptionen sind kostenlos.

Ideal für: Vertrieb, Marketing, E-Commerce, Immobilien und alle, die ohne Programmieren sofort Daten brauchen.

Vorteile:

- Sehr einfache Bedienung – jeder kann es nutzen

- Unterstützt Unterseiten, Paginierung und dynamische Inhalte

- Kostenlose Exporte und KI-Datenbereinigung

- Aktiver Support und regelmäßige Updates

Nachteile:

- Kostenloses Kontingent für große Projekte begrenzt

- Weniger flexibel für Entwickler, die alles skripten wollen

- Bei stark geschützten Seiten ggf. Cloud-Modus oder Proxys nötig

Thunderbit wird von über 30.000 Nutzern geschätzt, darunter Teams von Accenture, Puma und Grammarly. Wer in unter einer Minute von „Ich brauche diese Daten“ zu „Hier ist die Tabelle“ kommen will, ist mit der bestens beraten. (Und ja, ich bin stolz auf unser Team – im gibt’s weitere Tipps und Anleitungen.)

Octoparse: No-Code KI-Web-Scraper mit Vorlagen

Octoparse ist seit Jahren beliebt bei Analysten und Forschern, die komplexe Webseiten ohne Programmierung scrapen wollen. Es bietet einen visuellen Workflow-Builder (Desktop-App für Windows/Mac, Cloud-Service für zahlende Nutzer).

Wichtige Funktionen:

- Riesige Vorlagenbibliothek für bekannte Seiten (Amazon, Twitter, Jobbörsen etc.)

- Visueller Workflow-Builder – Felder auswählen, Paginierung, Logins und AJAX einrichten

- Cloud-Scraping für Zeitplanung und schnellere Durchläufe (bezahlt)

- Unterstützt dynamische Inhalte, Endlos-Scroll und mehrstufige Workflows

Preise: Kostenloser Plan für bis zu 10 Aufgaben und 50.000 Datensätze/Monat (nur Desktop). Bezahlpläne ab ca. 75 $/Monat für Cloud-Scraping, mehr Aufgaben und Profi-Features.

Ideal für: Analysten, Forscher und semi-technische Nutzer, die Power und Flexibilität suchen.

Vorteile:

- Komplexe Seiten und Interaktionen möglich

- Große Vorlagenbibliothek spart Zeit

- Aktive Community und viele Tutorials

Nachteile:

- Lernkurve bei komplexen Workflows

- Cloud-Features kosten extra

- Nur Desktop-App (Win/Mac), kein Linux

Wer bereit ist, sich einzuarbeiten, bekommt mit Octoparse ein Schwergewicht im No-Code-Scraping.

Browse AI: Flexibles KI-Web-Scraping & Monitoring

Browse AI macht Web-Scraping und Monitoring so einfach wie möglich. Du richtest „Roboter“ per Point-and-Click ein, und die KI erkennt die Muster – ganz ohne Code.

Wichtige Funktionen:

- Point-and-Click-Roboter-Aufzeichnung

- KI passt sich Webseitenänderungen an

- Zeitplanung und Monitoring (Inhaltsänderungen erkennen, Benachrichtigungen)

- Direkte Integration mit Google Sheets, Airtable, Zapier

Preise: Kostenloser Plan mit 50 Credits/Monat. Bezahlpläne ab 19 $/Monat (ca. 2.000 Credits). Verbrauchsbasiert – du zahlst, was du nutzt.

Ideal für: Business-Anwender, die regelmäßig Daten extrahieren oder überwachen wollen – z.B. Preisüberwachung, neue Angebote, tägliche Reports.

Vorteile:

- Sehr einfache Einrichtung, auch für Nicht-Techniker

- Google Sheets-Integration ist ein Automatisierungs-Highlight

- Schneller Support

Nachteile:

- Verbrauchsbasierte Preise können bei Vielnutzung teuer werden

- Weniger granular für Entwickler

Browse AI ist ideal, um wiederkehrende Checks zu automatisieren oder den Markt im Blick zu behalten – ohne eine Zeile Code.

Bardeen: Datensammlung automatisieren mit KI-Playbooks

Bardeen ist mehr als ein Web-Scraper – es ist eine Chrome-Erweiterung zur Automatisierung kompletter Workflows, wobei Scraping nur ein Schritt ist. Stell es dir als persönlichen Assistenten für deinen Browser vor.

Wichtige Funktionen:

- KI-gestützte Playbooks (Automatisierungsrezepte) für Scraping und Folgeaktionen

- Integration mit Google Sheets, Notion, Slack, Trello und mehr

- GPT-4-Integration für Content-Generierung

- Kann Formulare ausfüllen, mehrstufige Aufgaben ausführen und Aktionen automatisch auslösen

Preise: Großzügiger Gratis-Plan; Bezahlpläne für Cloud-Ausführung und Profi-Features.

Ideal für: Power-User, Marketer und alle, die mehrstufige Workflows automatisieren wollen (z.B. Leads scrapen, ins CRM eintragen und E-Mail senden).

Vorteile:

- Automatisiert Scraping plus Folgeaktionen

- Für die meisten Anwendungsfälle kostenlos

- Flexibel und leistungsstark

Nachteile:

- Lernkurve bei komplexen Playbooks

- Scraping-Ergebnisse sollten geprüft werden

- Browserbasiert, große Jobs benötigen Cloud-Ausführung

Wer in „Wenn X, dann Y“-Logik denkt, wird Bardeen lieben.

ScrapeStorm: KI-gestützte Datenextraktion für alle Erfahrungsstufen

ScrapeStorm ist eine Desktop-App (Win/Mac/Linux) für Einsteiger und Profis – mit Smart Mode (KI-Autoerkennung) und Flowchart Mode (individuelle Workflows).

Wichtige Funktionen:

- Smart Mode: URL eingeben, KI erkennt Daten und Paginierung automatisch

- Flowchart Mode: Visueller Workflow-Builder für komplexe Aufgaben

- Integrierte rotierende Proxys und Anti-Blocking

- Zeitplanung, Cloud-Ausführung, Multi-Format-Export

Preise: Kostenloser Plan (100 Zeilen/Tag, 10 Aufgaben); Bezahlpläne ab ca. 50 $/Monat.

Ideal für: E-Commerce, Forschung und alle, die schnelle und individuelle Scrapes brauchen.

Vorteile:

- Visuelle Oberfläche ist einsteigerfreundlich

- Unterstützt dynamische Seiten, Bilder und Dateien

- Integrierte Proxys sparen Aufwand

Nachteile:

- Fortgeschrittene Funktionen können Einsteiger überfordern

- Kostenloses Kontingent für Vielnutzer begrenzt

ScrapeStorm ist ideal, wenn du ein Tool suchst, das mit deinen Anforderungen wächst.

ScrapingBee: API-basierte KI-Web-Scraping-Lösung für Entwickler

ScrapingBee ist ein Traum für Entwickler: Eine API, die Headless-Browser, Proxys und jetzt auch KI-gestützte Datenextraktion übernimmt.

Wichtige Funktionen:

- API-first: Seiten abrufen, JavaScript, Proxys, CAPTCHAs

- KI-Extraktion: Datenwünsche in natürlicher Sprache oder JSON-Schema angeben, strukturierte Daten erhalten

- Skalierbar für große Projekte

Preise: Bezahlpläne ab 49 $/Monat für 100.000 API-Calls; KI-Extraktion kostet extra pro Anfrage. Kostenlose Testphase verfügbar.

Ideal für: Entwickler, Data Engineers und technische Teams, die eigene Pipelines bauen.

Vorteile:

- Entwicklerfreundlich, schnell und zuverlässig

- KI-Parsing spart Programmierzeit

- Hervorragende Dokumentation

Nachteile:

- Nicht für No-Code-User

- Verbrauchsbasierte Preise bei großen Jobs

Wer Scraping in eigene Apps oder Workflows integrieren will, ist mit ScrapingBee bestens bedient.

Import.io: Enterprise-KI für Datenextraktion

Import.io ist das Luxusmodell unter den Web-Scraping-Plattformen – funktionsreich, skalierbar und für Unternehmen gebaut.

Wichtige Funktionen:

- Machine-Learning-Extraktoren (Felder werden automatisch erkannt)

- Mehrseitige Workflows, Formularausfüllung, Screenshot für Compliance

- Verkettung von Extraktoren für Unterseiten

- Zeitplanung, API und Managed Services

Preise: Enterprise-Preise, individuell (mehrere Hundert bis Tausende pro Monat). Kein kostenloser Plan.

Ideal für: Große Unternehmen mit hohem Datenbedarf und Compliance-Anforderungen.

Vorteile:

- Skalierbar und robust

- Compliance- und Audit-Features

- Managed Services verfügbar

Nachteile:

- Teuer, nicht für kleine Teams

- Lernkurve für DIY-Nutzer

Wenn Daten geschäftskritisch sind und Support, Compliance und Skalierung gefragt sind, ist Import.io eine Top-Wahl.

ParseHub: Visueller KI-Web-Scraper für komplexe Seiten

ParseHub ist eine kostenlose Desktop-App (Win/Mac/Linux), die für komplexe, dynamische Seiten bekannt ist.

Wichtige Funktionen:

- Visuelle Oberfläche zum Auswählen von Elementen und Aktionen

- Unterstützt JavaScript-lastige Seiten, Endlos-Scroll, Bedingungen

- Zeitplanung und Cloud-Ausführung (bezahlt)

- Regex und Scripting für Profis

Preise: Kostenloser Plan (5 Projekte, 200 Seiten/Lauf); Bezahlpläne ab 149 $/Monat.

Ideal für: Semi-technische Nutzer, Forscher und alle, die schwierige Seiten scrapen müssen.

Vorteile:

- Leistungsstark für komplexe Workflows

- Großzügiger Gratis-Plan

- Plattformübergreifend

Nachteile:

- Umständliche UI, Lernkurve

- Keine integrierten Proxys

- Manuelle Wartung bei Seitenänderungen

ParseHub ist ideal für Seiten, an denen einfache Tools scheitern – aber man sollte Zeit zum Einarbeiten einplanen.

Kadoa: KI-Web-Scraper mit Datenbereinigung & Monitoring

Kadoa ist eine No-Code-KI-Plattform für End-to-End-Datenextraktion, -bereinigung und Echtzeit-Monitoring.

Wichtige Funktionen:

- Selbstheilende Web-Scraper (KI passt sich Webseitenänderungen an)

- Echtzeit-Monitoring und Sofort-Benachrichtigungen

- Datenbereinigung und -normalisierung (z.B. Datumsformate, Preise, Einheiten)

- Skalierbar für Millionen Datenpunkte täglich

Preise: Fokus auf Unternehmen, individuelle Preise. Kostenlose Testphase verfügbar.

Ideal für: Finanzen, E-Commerce, Jobdaten und Teams, die kontinuierlich saubere Daten brauchen.

Vorteile:

- Selbstheilung reduziert Wartungsaufwand

- Schnelle Benachrichtigungen für Monitoring

- Daten-Normalisierung integriert

Nachteile:

- Teuer, auf Unternehmen ausgerichtet

- Neue Plattform, Features im Wandel

Wer aktuelle, saubere Daten braucht und weniger Zeit mit kaputten Scrapern verbringen will, sollte Kadoa testen.

Scrapy: Open-Source-Web-Scraper für Entwickler

Scrapy ist das Open-Source-Python-Framework, das seit über einem Jahrzehnt unzählige Scraping-Projekte antreibt.

Wichtige Funktionen:

- Eigene Spider für volle Kontrolle

- Skalierbar, schnell und speichereffizient

- Riesiges Plugin-Ökosystem

- Kostenlos und Open Source

Preise: Kostenlos (eigene Infrastruktur nötig).

Ideal für: Entwickler, Data Engineers und alle, die maximale Kontrolle wollen.

Vorteile:

- Unbegrenzte Flexibilität

- Große Community und Support

- Integration in Python-Datenpipelines

Nachteile:

- Programmierkenntnisse erforderlich

- Wartung liegt beim Nutzer

- Keine integrierte KI (aber eigene Integration möglich)

Wer Python kann und individuelle Web-Scraper bauen will, ist mit Scrapy bestens beraten.

Webscraper.io: Browserbasierter Web-Scraper für Einsteiger

Webscraper.io ist eine kostenlose Chrome/Firefox-Erweiterung, ideal für Einsteiger.

Wichtige Funktionen:

- Point-and-Click-Sitemap-Builder

- Unterstützt Listen, Paginierung, Unterseiten

- Export nach CSV/JSON

- Community-Sitemaps und Tutorials

Preise: Kostenlos für lokale Nutzung; Cloud-Pläne für Zeitplanung und Automatisierung kostenpflichtig.

Ideal für: Nicht-technische Nutzer, Studierende und alle mit einfachen Scraping-Anforderungen.

Vorteile:

- Kostenlos und einfach zu bedienen

- Community-Support

- Gut für kleine, statische Seiten

Nachteile:

- Keine KI- oder Anti-Bot-Funktionen

- Limitiert bei dynamischen/komplexen Seiten

- Läuft im Browser (manuell bei großen Jobs)

Wer gerade startet oder schnell Daten braucht, findet mit Webscraper.io einen guten Einstieg.

Diffbot: KI-gestützte strukturierte Datenextraktion

Diffbot ist ein einzigartiger, KI-basierter Service, der das Web in eine strukturierte Datenbank verwandelt – ganz ohne Setup.

Wichtige Funktionen:

- KI/NLP/Computer Vision-Extraktoren für Artikel, Produkte, Foren etc.

- Knowledge Graph mit Milliarden von Entitäten

- API für strukturierte Daten aus jeder URL

- Unterstützt Bilder, natürliche Sprache und mehr

Preise: Enterprise-Preise, ab 299 $/Monat für festes Kontingent. Kostenlose Testphase verfügbar.

Ideal für: Unternehmen, Forschung, Medienmonitoring und alle, die breite, automatisierte Abdeckung brauchen.

Vorteile:

- Kein Setup – einfach URLs senden, strukturierte Daten erhalten

- Sehr breite Abdeckung

- Knowledge Graph für komplexe Abfragen

Nachteile:

- Teuer

- Weniger Kontrolle bei individuellen Feldern

- Gelegentliche Fehlklassifizierung bei ungewöhnlichen Seiten

Wer das Web zur Datenbank machen will und das Budget hat, findet mit Diffbot eine einzigartige Lösung.

AIScraper: Schnelles KI-Web-Scraping für Lead-Generierung

AIScraper ist eine Chrome-Erweiterung für schnelles, KI-gestütztes Scraping – besonders für Lead-Generierung.

Wichtige Funktionen:

- Natürliche Sprachbefehle („alle Jobtitel und Firmen auf dieser Seite extrahieren“)

- Presets für Jobbörsen, Immobilien, Marktplätze

- Unterseiten-Scraping, Sofort-Export nach CSV/JSON/Sheets

- Pay-as-you-go Credits

Preise: Credits ab 6 $ für 200; kein Abo nötig.

Ideal für: Vertrieb, Recruiter, Gründer und alle, die schnell und bedarfsgerecht Daten brauchen.

Vorteile:

- Sehr schnelle Einrichtung (~8 Sekunden pro Seite)

- Günstig, nur zahlen was man nutzt

- Einfach für Nicht-Techniker

Nachteile:

- Nicht für große Jobs oder ganze Websites

- Browserbasiert, daher manuell bei großen Listen

Wer keine Lust mehr auf Copy-Paste hat, wird AIScraper lieben.

Gumloop: KI-Web-Scraping für individuelle Daten-Workflows

Gumloop ist eine visuelle Automatisierungsplattform für individuelle, KI-gestützte Workflows – inklusive Scraping, Datenverarbeitung und Integrationen.

Wichtige Funktionen:

- Visueller Workflow-Builder mit Drag-and-Drop-Nodes

- KI-gestützte Datenextraktion, Chrome-Recorder

- Integration mit Gmail, Slack, Sheets, HubSpot und mehr

- Bedingungen, Schleifen und mehrstufige Automatisierung

Preise: Starter 97 $/Monat; Pro 297 $/Monat. Kostenlose Testphase verfügbar.

Ideal für: Technikaffine Teams, Growth Ops und alle, die mehrstufige Prozesse automatisieren wollen.

Vorteile:

- Sehr flexibel, auch für komplexe Workflows

- KI-Nodes für unstrukturierte Daten

- Chrome-Recorder für Aktionen

Nachteile:

- Teuer für kleine Teams

- Lernkurve bei fortgeschrittener Automatisierung

Wer mehr als nur Scraping automatisieren will – z.B. ganze Geschäftsprozesse – findet in Gumloop ein starkes Tool.

scrapeless: KI-Web-Scraper mit Fokus auf Einfachheit

scrapeless ist ein Toolkit und eine API, die Webdatenextraktion so einfach wie möglich machen will – ohne Scraping-Frust.

Wichtige Funktionen:

- KI-gestützte Scraping-API (ein Call = strukturierte Daten)

- Echtes Browser-Rendering, Anti-Bot, Proxy-Pool

- Datenbereinigung, Echtzeit-Feeds, Pay-per-Success

- Entwicklerfreundlich, skalierbar für große Projekte

Preise: Verbrauchsbasiert, nur erfolgreiche Anfragen werden berechnet. Kostenlose Testphase verfügbar.

Ideal für: Entwickler, Startups und Unternehmen, die eine einfache, skalierbare API suchen.

Vorteile:

- Einfache API, robustes Anti-Blocking

- Skalierbar für große Projekte

- Datenbereinigung und Transformation integriert

Nachteile:

- Kleine Community

- Manche Features nur für Unternehmen

Wer sich auf die Daten konzentrieren will – nicht auf das Wie –, ist mit scrapeless gut beraten.

Oxylabs: KI-Web-Scraper Copilot für API-basierte Datenextraktion

Oxylabs ist ein Enterprise-Anbieter mit riesigem Proxy-Netzwerk und leistungsstarken Scraping-APIs. Der neue OxyCopilot bringt KI ins Spiel.

Wichtige Funktionen:

- Web-Scraper-API mit 100M+ Proxys, Headless-Browser, Anti-Bot

- OxyCopilot KI-Assistent: Scraping-Code oder Extraktionsregeln per natürlicher Sprache generieren

- Analytics-Dashboard, 24/7 Support, Compliance-Features

Preise: Enterprise-Preise, ab ca. 99 $/Monat für Micro-Pläne. Kostenlose Testphase verfügbar.

Ideal für: Unternehmen, technische Teams und alle, die in großem Stil scrapen.

Vorteile:

- Enterprise-Qualität und Support

- KI-Copilot beschleunigt Entwicklung

- Kommt auch mit schwierigen Seiten klar

Nachteile:

- Teuer, nicht für kleine Projekte

- Technisches Know-how für Integration nötig

Wer Millionen Seiten scrapen will und Top-Infrastruktur sucht (plus KI-Unterstützung), ist bei Oxylabs richtig.

Welcher KI-Web-Scraper passt zu deinen Anforderungen?

Wie wählt man bei so vielen guten Optionen? Hier mein Spickzettel:

- Nicht-technische Nutzer / kleine Teams: , Browse AI, AIScraper, Webscraper.io

- Growth Hacker / Marketer: Bardeen, Gumloop

- Entwickler / Technik-Teams: Scrapy, ScrapingBee, scrapeless

- Unternehmen / große Projekte: Import.io, Diffbot, Oxylabs

- E-Commerce / Wettbewerbsbeobachtung: ScrapeStorm, ParseHub

- Immobilien / Jobdaten: AIScraper, scrapeless, Diffbot

Tipp: Teste mehrere Tools mit deinen echten Daten, bevor du dich festlegst. Die meisten bieten kostenlose Testphasen oder Credits. Lies Nutzerbewertungen und kombiniere ruhig verschiedene Tools – viele Teams nutzen z.B. Thunderbit für schnelle Aufgaben und ScrapingBee für Backend-Jobs.

Und ganz wichtig: Nutze diese Tools verantwortungsvoll – beachte die Nutzungsbedingungen, Datenschutz und Ethik.

Fazit: Mit dem richtigen KI-Web-Scraper zur Daten-Power

Wenn du bis hier gelesen hast, bist du bestens gerüstet für den Daten-Goldrausch 2025. KI-Web-Scraper haben die Hürden für Webdaten so weit gesenkt, dass sogar meine Mutter eine Lead-Liste bauen könnte (und sie ruft mich sonst an, wenn das WLAN spinnt). Egal ob Solo-Gründer oder Fortune-500-Team – hier findest du ein Tool, das dir Stunden spart, bessere Einblicke liefert und dich beim nächsten Meeting wie einen Datenzauberer aussehen lässt.

Was jetzt? Wähle einen KI-Web-Scraper, teste ihn an deinem schwierigsten Datenproblem und schau, wie viel Zeit du sparst. Im findest du weitere Deep Dives, oder starte direkt mit der – zwei Klicks genügen.

Denk daran: In der Datenwelt zählen Geschwindigkeit und Genauigkeit. Mit dem richtigen KI-Web-Scraper verbringst du weniger Zeit mit Datenaufbereitung und mehr Zeit mit Entscheidungen, die wirklich etwas bewegen. Und falls du die „guten alten Copy-Paste-Zeiten“ vermisst – dafür gibt’s heute bestimmt auch eine KI.

Viel Spaß beim Scrapen – und auf immer saubere Tabellen!

Häufige Fragen (FAQ)

1. Was ist ein KI-Web-Scraper und wie unterscheidet er sich von klassischen Scraper-Tools?

Ein KI-Web-Scraper nutzt künstliche Intelligenz – etwa maschinelles Lernen, NLP und Computer Vision –, um Daten automatisch von Webseiten zu extrahieren. Im Gegensatz zu klassischen Scraper-Tools, die manuell eingerichtet und programmiert werden müssen, erkennen KI-Web-Scraper relevante Daten auch bei Layout- oder Inhaltsänderungen. Sie sind schneller, flexibler und auch für Nicht-Entwickler geeignet.

2. Für wen eignen sich KI-Web-Scraping-Tools?

KI-Web-Scraping-Tools sind ideal für Vertriebsteams, Marketer, E-Commerce-Unternehmen, Immobilienprofis, Forscher und Datenanalysten – also für alle, die strukturierte Webdaten ohne Programmierung brauchen. Egal ob Lead-Listen, Preisüberwachung oder Wettbewerbsanalyse: KI-Web-Scraper machen den Prozess einfacher und schneller.

3. Worauf sollte man bei einem KI-Web-Scraper achten?

Wichtige Features sind No-Code- oder Low-Code-Oberflächen, KI-Felderkennung, Unterstützung für Unterseiten und Paginierung, dynamische Inhalte, Export- und Integrationsmöglichkeiten (z.B. Google Sheets, Airtable), Zeitplanung, Datenbereinigung und Compliance-Tools. Die richtige Kombination hängt von deinen Zielen und deinem technischen Know-how ab.

4. Welcher KI-Web-Scraper ist am besten für Nicht-Techniker geeignet?

Thunderbit, Browse AI, AIScraper und Webscraper.io sind besonders empfehlenswert für Nicht-Techniker. Thunderbit überzeugt durch die einfache Chrome-Erweiterung, KI-Feldvorschläge, Unterseiten-Support und Sofort-Export – alles auf maximale Benutzerfreundlichkeit ausgelegt.

5. Gibt es bei den meisten KI-Web-Scraping-Tools einen kostenlosen Plan?

Ja, die meisten Tools bieten einen kostenlosen Plan oder eine Testphase – darunter Thunderbit, Octoparse, Browse AI und ParseHub. Die Einschränkungen sind unterschiedlich: Manche begrenzen die Anzahl der Seiten, andere die Exportformate oder Zeitplanung. Am besten testest du mehrere Tools mit deinem eigenen Anwendungsfall, bevor du dich entscheidest.

Mehr erfahren? Hier findest du weitere Guides: