Web Scraping ist heutzutage längst nicht mehr nur ein Thema für IT-Profis oder Datennerds. Dank zahlreicher No-Code-Lösungen kann mittlerweile fast jeder Daten von Webseiten abgreifen – vorausgesetzt, man entscheidet sich für das richtige Tool. ParseHub ist einer der bekanntesten Namen in diesem Bereich und verspricht, Web Scraping für alle zugänglich zu machen. Doch hält das Tool wirklich, was es verspricht, gerade für Einsteiger? Und gibt es vielleicht sogar noch bessere, unkompliziertere Alternativen für alle, die ohne viel Einarbeitung schnell Ergebnisse sehen wollen?

Wenn du ParseHub für dein nächstes Datenprojekt ins Auge gefasst hast oder schon ausprobiert hast und dabei an deine Grenzen gestoßen bist, bist du hier genau richtig. Ich habe zahlreiche Nutzermeinungen ausgewertet, die Funktionen getestet und ParseHub mit moderneren, benutzerfreundlicheren Lösungen verglichen – allen voran mit , der KI-basierten Chrome-Erweiterung, die bei Business-Usern, Marketern und allen, die mit wenigen Klicks Daten extrahieren möchten, immer beliebter wird. In diesem Beitrag erfährst du, was ParseHub kann, für wen es geeignet ist, wo die Schwächen liegen und warum Thunderbit für die meisten Nicht-Techniker 2025 die bessere Wahl sein dürfte.

Was ist ParseHub?

ParseHub ist ein Unternehmen aus Toronto, das seit 2013 am Start ist und sich als leistungsstarkes No-Code-Web-Scraping-Tool einen Namen gemacht hat. Das Prinzip ist simpel: Statt Code zu schreiben, nutzt du eine visuelle Oberfläche, um die gewünschten Daten auf einer Webseite auszuwählen. Die ParseHub-Desktop-App (für Windows, Mac und Linux) erlaubt es dir, eine Seite zu öffnen, die relevanten Elemente anzuklicken und den Rest erledigt das Tool – es extrahiert die Daten und exportiert sie zum Beispiel als CSV oder JSON.

Wichtige Funktionen und Produkte:

- Visuelles Point-and-Click-Scraping: Daten direkt auf der Webseite markieren.

- Unterstützung für dynamische Inhalte: Kommt mit AJAX, Formularen, Logins und Endlos-Scroll klar.

- Cloud-basiertes Scheduling: Scraping-Aufgaben zeitgesteuert auf ParseHubs Servern laufen lassen.

- Automatische IP-Rotation: Verringert das Risiko, von Webseiten geblockt zu werden.

- Erweiterte Selektoren: XPath oder Regex für komplexere Extraktionen.

- REST API & Webhooks: Für die Integration in andere Tools oder zur Automatisierung von Workflows.

- Plattformübergreifend: Funktioniert auf Windows, Mac und Linux.

ParseHub will Web Scraping auch für Nicht-Programmierer zugänglich machen, bietet aber gleichzeitig genug Power für Fortgeschrittene, die komplexe Aufgaben automatisieren möchten.

Für wen ist ParseHub geeignet?

ParseHub sieht sich als No-Code-Lösung für alle, die Webdaten brauchen, aber keine Skripte schreiben wollen. In der Praxis nutzen vor allem diese Gruppen das Tool:

- Marketer, die Preise der Konkurrenz oder Produktlisten beobachten.

- Forscher, die Bewertungen, Nachrichten oder wissenschaftliche Daten sammeln.

- Datenanalysten, die strukturierte Webdaten benötigen.

- Business-Anwender, die wiederkehrende Datensammlungen automatisieren möchten.

Auch Entwickler greifen für schnelle Aufgaben mal zu ParseHub, aber die eigentliche Zielgruppe sind Einsteiger und Fortgeschrittene – also Leute mit Datenbedarf, aber wenig oder keiner Programmiererfahrung. Wer als Marketer, Makler oder Kleinunternehmer einfach Daten in eine Tabelle bringen will, für den soll ParseHub die Lösung sein.

ParseHub Preismodelle

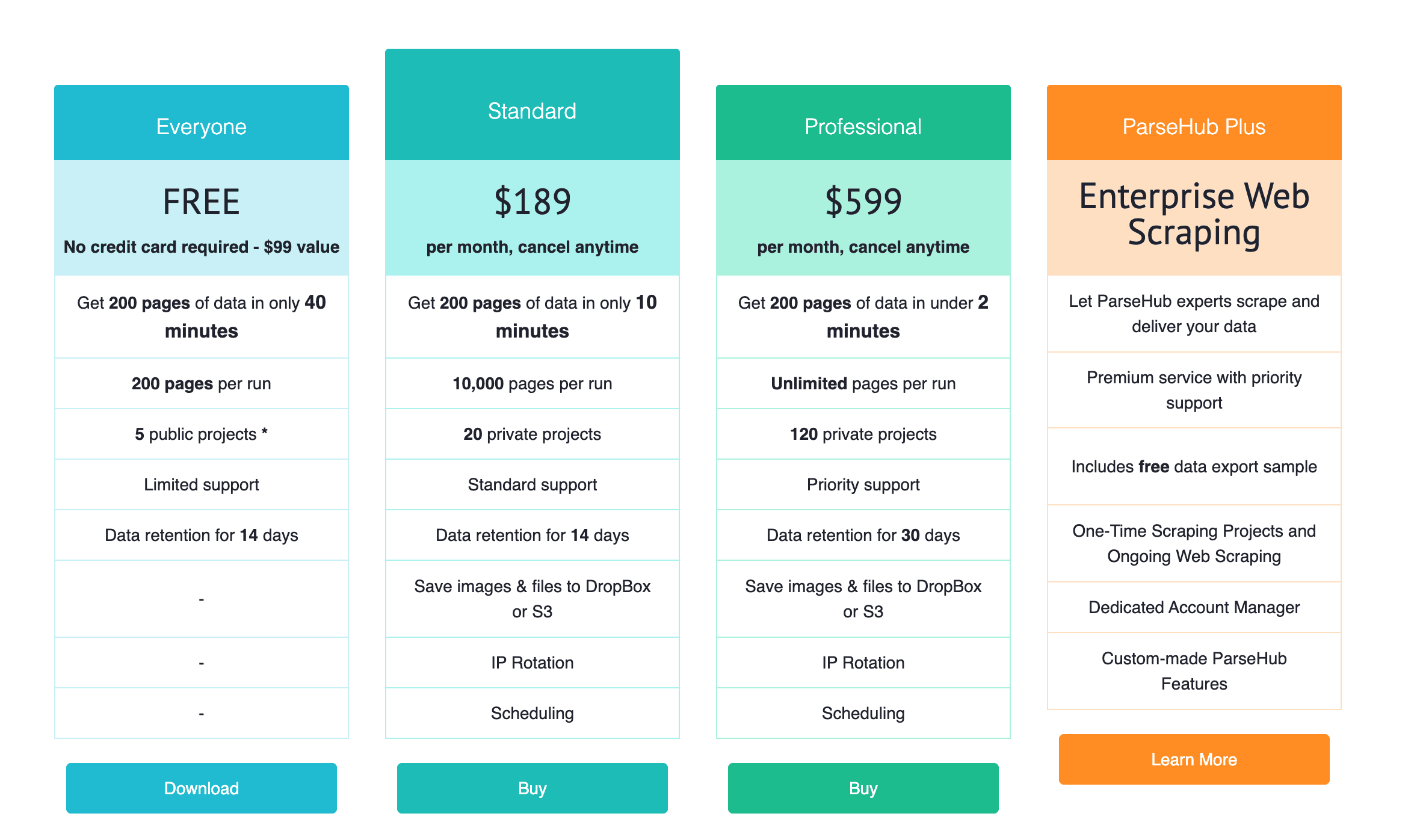

Gerade für Einsteiger oder kleine Teams ist der Preis bei der Wahl eines Web-Scrapers entscheidend. So sehen die Tarife von ParseHub aus:

- Kostenloser Tarif:

- Bis zu 5 öffentliche Projekte (deine Scraper sind für die Community sichtbar)

- Bis zu 200 Seiten pro Durchlauf (ca. 200 Seiten in 40 Minuten)

- Eingeschränkter Support, Daten werden 14 Tage gespeichert

- Ideal für kleine, einmalige Projekte oder zum Ausprobieren

- Standard-Tarif (189 $/Monat):

- 20 private Projekte

- Bis zu 10.000 Seiten pro Durchlauf (200 Seiten in ca. 10 Minuten)

- Zeitplanung, IP-Rotation, Speicherung auf Dropbox/S3

- Standard-Support

- Professional-Tarif (599 $/Monat):

- 120 private Projekte

- Unbegrenzte Seiten pro Durchlauf (200 Seiten in unter 2 Minuten)

- 30 Tage Datenspeicherung, Prioritäts-Support

- Enterprise (ParseHub Plus):

- Individuelle Preisgestaltung

- „Done-for-you“-Scraping durch das ParseHub-Team

- Persönlicher Ansprechpartner, individuelle Features

Der kostenlose Tarif reicht für kleine Projekte, aber wer tausende Seiten oder private Projekte braucht, muss upgraden – und die Preise sind im Vergleich zu anderen Tools ziemlich hoch.

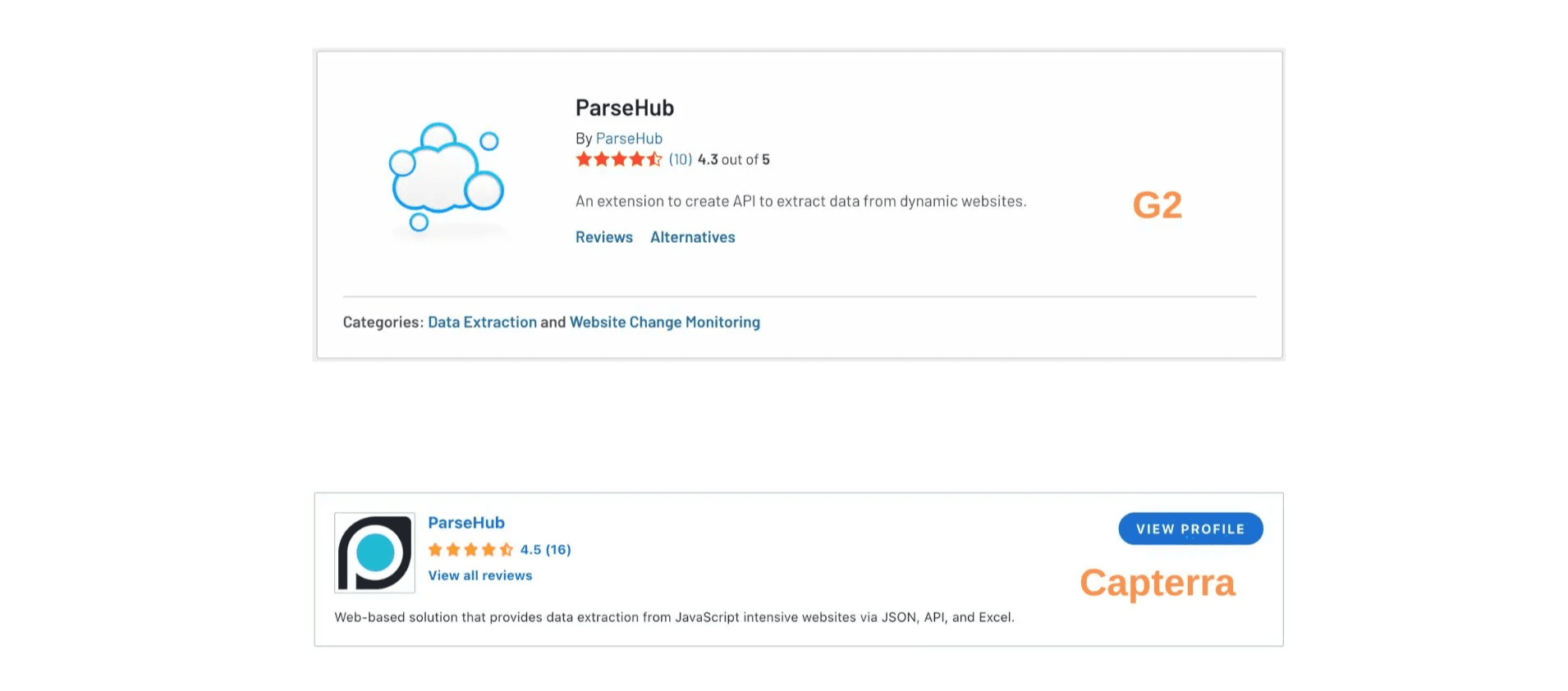

Nutzerfeedback zu ParseHub

Um ein realistisches Bild zu bekommen, habe ich Nutzerbewertungen auf und durchforstet. Die Gesamtbewertungen sind gut – 4,3/5 auf G2 und 4,5/5 auf Capterra – aber die Kommentare zeigen ein differenzierteres Bild.

Was Nutzer an ParseHub schätzen

- Kein Programmieren nötig: Der größte Pluspunkt ist, dass man keinen Code schreiben muss. Viele finden es super, Daten einfach per Klick auszuwählen – das macht Web Scraping auch für Laien zugänglich.

- Stark bei komplexen Aufgaben: Fortgeschrittene loben Features wie Regex, XPath und die Unterstützung dynamischer Inhalte. ParseHub kann auch anspruchsvolle Scraping-Jobs übernehmen, die manuell kaum zu schaffen wären.

- Kostenloser Tarif: Viele sehen die Gratis-Version als guten Einstieg oder für kleine Projekte.

- Plattformübergreifend: Mac- und Linux-Nutzer freuen sich, dass ParseHub nicht nur für Windows verfügbar ist.

- Hilfreicher Support: Einige berichten von einem engagierten Support-Team, das bei Problemen hilft.

- Visuelles Debugging: Screenshots der einzelnen Schritte helfen, Fehlerquellen zu finden.

Wo ParseHub Schwächen hat

1. Hohe Einstiegshürde

Obwohl ParseHub als No-Code-Tool beworben wird, ist es für Einsteiger nicht so intuitiv, wie es scheint. Viele berichten, dass die Einarbeitung schwierig ist – vor allem, wenn es über einfache Aufgaben hinausgeht. Ein Nutzer bringt es auf den Punkt: „Es war schwer zu lernen und umzusetzen. Einen Scraper für eine bestimmte Seite zu bauen, dauert als Neuling 1–3 Stunden.“ Das ist viel Zeit, wenn man nur schnell ein paar Daten braucht.

Gerade bei komplexeren Aufgaben wirkt die Oberfläche oft unübersichtlich. Manche mussten Projekte mehrfach neu starten, um ans Ziel zu kommen, und die Tutorials decken nur die Basics ab. Wer eine anspruchsvolle Seite scrapen will, muss sich mit XPaths oder Navigationslogik beschäftigen – für Nicht-Techniker oft abschreckend.

2. Nicht wirklich einsteigerfreundlich

Selbst Nutzer, die ParseHub irgendwann beherrschen, geben zu, dass die Lernkurve „ziemlich lang“ ist. Für absolute Anfänger kann der Einstieg überfordernd sein. Die Dokumentation reicht für einfache Projekte, aber bei Problemen fehlt oft eine klare Anleitung. Manche wünschen sich eine bessere Wissensdatenbank für fortgeschrittene Techniken, andere mussten sich Tricks vom Support zeigen lassen.

3. Fehlerbehebung und Fehlermeldungen

Web Scraping ist generell fehleranfällig – und wenn bei ParseHub etwas schiefläuft, ist die Ursache oft unklar. Fehlermeldungen sind manchmal wenig hilfreich, sodass Nutzer raten müssen, was zu ändern ist. Dieses Trial-and-Error kostet Zeit und Nerven. Einige beschreiben ParseHub als „größte Zeitverschwendung“, nachdem sie stundenlang an einem Projekt gesessen und letztlich aufgegeben haben.

4. Einschränkungen im Gratis-Tarif

Der kostenlose Tarif wird zwar geschätzt, aber das Limit von 200 Seiten ist für viele zu niedrig. Viele wünschen sich mindestens 500 oder 1.000 Seiten. Außerdem läuft die Gratis-Version langsamer, und wer große Seiten schnell scrapen will, muss zahlen. Kostenlose Nutzer erhalten nur Community-Support, was bei dringenden Problemen schwierig sein kann.

5. Preisgestaltung

Der Sprung vom Gratis- zum Bezahl-Tarif ist enorm. 189 $/Monat für den Standard-Tarif ist eine große Investition – gerade für Einzelpersonen oder kleine Teams. Manche finden, der Preis lohnt sich nur bei sehr großem Datenbedarf.

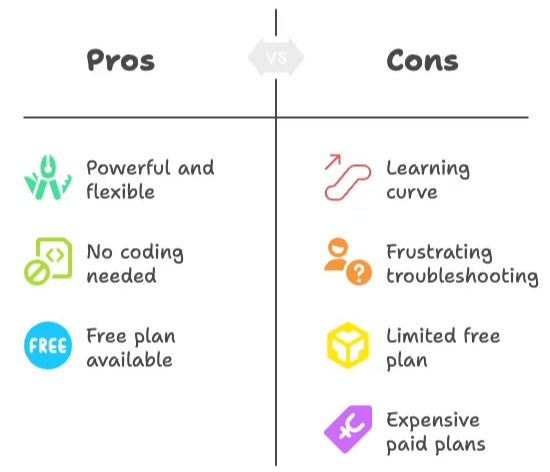

Fazit aus dem ParseHub-Test

- ParseHub ist leistungsstark und flexibel, besonders für komplexe Scraping-Aufgaben.

- Kein Programmieren nötig, aber die Lernkurve ist deutlich spürbar – vor allem für Einsteiger.

- Fehlerbehebung kann frustrierend sein, da Fehlermeldungen oft wenig hilfreich sind und es an Anleitungen für Fortgeschrittene fehlt.

- Der Gratis-Tarif eignet sich für kleine Projekte, aber die Limits sind schnell erreicht.

- Bezahl-Tarife sind teuer und positionieren ParseHub im Premium-Segment.

Wer als Nicht-Techniker einfach und schnell Daten sammeln möchte, wird mit ParseHub oft nicht so glücklich wie erhofft. Die Einarbeitung und die Frustration bei Fehlern sind häufige Kritikpunkte.

Thunderbit vorgestellt: Der einfachste KI-Web-Scraper für alle

Thunderbit ist eine , entwickelt für Business-Anwender, Marketer, Immobilienprofis, E-Commerce-Teams und alle, die Webseiten-Daten ohne technischen Aufwand extrahieren möchten. Das macht Thunderbit besonders:

Thunderbit-Funktionen im Überblick

- KI-gestütztes Scraping: Mit „AI Suggest Columns“ erkennt Thunderbits KI automatisch, wie sich Daten am besten extrahieren lassen – ganz ohne Selektoren oder XPaths.

- Datenextraktion mit 2 Klicks: Spalten auswählen, auf „Scrape“ klicken – fertig.

- Subseiten-Scraping: Thunderbits KI besucht automatisch Unterseiten (z. B. Produktdetails oder Profile) und ergänzt die Datentabelle.

- Sofort nutzbare Scraper-Vorlagen: Für beliebte Seiten wie Amazon, Zillow, Instagram oder Shopify kannst du mit einem Klick Daten exportieren.

- Kostenloser Datenexport: Exportiere deine Daten nach Excel, Google Sheets, Airtable oder Notion – ohne Zusatzkosten.

- KI-Autofill (komplett kostenlos): Mit KI Online-Formulare ausfüllen und Workflows automatisieren – einfach Kontext auswählen und Enter drücken.

- Geplantes Scraping: Automatische Datenerfassung zu festgelegten Zeiten – einfach Zeit angeben und URLs eintragen.

- E-Mail-, Telefon- und Bild-Extraktoren: Mit nur einem Klick E-Mails, Telefonnummern oder Bilder von jeder Website extrahieren (alles kostenlos).

- Bild-/Dokumenten-Parser: Tabellen aus PDFs, Word, Excel oder Bildern extrahieren. Dokument hochladen, KI strukturiert die Daten, auf „Scrape“ klicken.

- Kein Programmieren, keine Installation: Alles läuft direkt im Browser – keine Desktop-App, keine komplizierte Einrichtung.

Thunderbit ist auf Schnelligkeit und Einfachheit getrimmt. Wer sich schon mal mit ParseHubs Einrichtung oder Fehlersuche herumgeärgert hat, wird Thunderbits unkomplizierte Bedienung lieben.

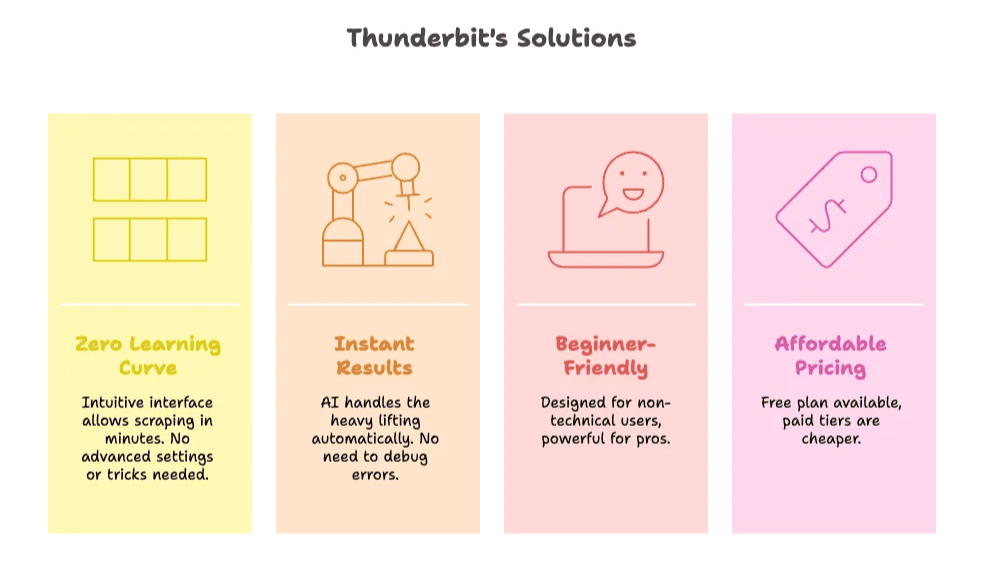

So löst Thunderbit die Schwächen von ParseHub

- Keine Einstiegshürde: Die Oberfläche von Thunderbit ist so intuitiv, dass du in wenigen Minuten loslegen kannst – ganz ohne Tutorials oder versteckte Einstellungen.

- Sofortige Ergebnisse: Die KI übernimmt die Arbeit, du musst dich nicht mit Selektoren oder Fehlersuche beschäftigen.

- Wirklich einsteigerfreundlich: Für Nicht-Techniker entwickelt, aber auch für Profis leistungsstark.

- Attraktive Preisgestaltung: Thunderbit bietet einen kostenlosen Einstieg, und die Bezahl-Tarife sind deutlich günstiger als bei ParseHub.

Thunderbit Preise

Thunderbit setzt auf ein simples Creditsystem: 1 Credit = 1 ausgegebene Datenzeile. So sehen die Tarife aus:

| Tarif | Monatlicher Preis | Jahrespreis (pro Monat) | Credits (monatlich) |

|---|---|---|---|

| Free | Kostenlos | Kostenlos | 6 Seiten |

| Starter | $15 | $9 | 500 |

| Pro 1 | $38 | $16.5 | 3.000 |

| Pro 2 | $75 | $33.8 | 6.000 |

| Pro 3 | $125 | $68.4 | 10.000 |

| Pro 4 | $249 | $137.5 | 20.000 |

. Im Gratis-Tarif kannst du 6 Seiten scrapen (unabhängig von der Zeilenzahl pro Seite), und die Bezahl-Tarife sind deutlich günstiger als der Einstiegspreis von 189 $/Monat bei ParseHub.

Thunderbit vs. ParseHub: Der direkte Vergleich

Hier eine Übersicht, wie Thunderbit und ParseHub bei den wichtigsten Funktionen für Nicht-Techniker abschneiden:

| Funktion | Thunderbit | ParseHub |

|---|---|---|

| No-Code, visuelles Scraping | ✅ – KI schlägt Spalten vor, 2-Klick-Setup | ⚖️ – Visuelle Oberfläche, aber höhere Lernkurve |

| KI-gestützte Extraktion | ✅ – KI übernimmt Selektoren, Subseiten & Struktur | ❌ – Manuelle Auswahl, fortgeschrittene Optionen erfordern XPath/Regex |

| Subseiten-Scraping | ✅ – KI besucht Unterseiten automatisch | ⚙️ – Muss manuell eingerichtet werden |

| Sofort-Vorlagen | ✅ – 1-Klick für Amazon, Zillow, Instagram, Shopify etc. | ❌ – Jedes Projekt muss manuell erstellt werden |

| Kostenloser Datenexport | ✅ – Excel, Google Sheets, Airtable, Notion | ✅ – CSV, JSON, Excel |

| E-Mail/Telefon/Bild-Extraktoren | ✅ – 1-Klick, komplett kostenlos | ❌ |

| Bild-/Dokumenten-Parsing | ✅ – Tabellen aus PDF, Word, Excel, Bildern extrahieren | ❌ |

| Geplantes Scraping | ✅ – Einfache Einrichtung in natürlicher Sprache | 💳 – Nur in Bezahl-Tarifen |

| Plattform | 🌐 – Chrome-Erweiterung (funktioniert auf jedem OS mit Chrome) | 💻 – Desktop-App (Windows, Mac, Linux) |

| Lernkurve | 🟢 – Minimal – Für absolute Einsteiger gemacht | 🔴 – Anspruchsvoll abseits der Basics |

| Support | 💬 – E-Mail, Chat, wachsende Wissensdatenbank | 👫 – Community (gratis), Standard/Priorität (bezahlt) |

| Gratis-Tarif | ✅ – 6 Seiten pro Monat, alle Features inklusive | ✅ – 200 Seiten pro Durchlauf, eingeschränkter Support |

| Einstiegspreis Bezahl-Tarif | $15/Monat ($9/Monat jährlich) | $189/Monat |

Fazit: Thunderbit ist die beste Wahl für Nicht-Techniker

Nach ausführlichem Vergleich von ParseHub und Thunderbit ist das Ergebnis eindeutig: Wer ohne technisches Vorwissen schnell, einfach und günstig Webdaten extrahieren möchte, ist mit am besten beraten.

ParseHub ist zwar leistungsfähig, aber die Einarbeitung ist aufwendig, die Fehlersuche oft frustrierend und die Bezahl-Tarife teuer. Für Einsteiger oder Business-Anwender, die einfach Daten in eine Tabelle bringen wollen, ist Thunderbit die bessere Wahl. Dank KI und 2-Klick-Workflow landen die Daten in wenigen Minuten – nicht erst nach stundenlangem Tüfteln. Mit Features wie Subseiten-Scraping, Sofort-Vorlagen und kostenlosem Export bekommst du alles, was du brauchst – ohne unnötige Komplexität.

Häufige Fragen (FAQ)

1. Was sind die Hauptunterschiede zwischen ParseHub und Thunderbit?

ParseHub ist ein leistungsstarker No-Code-Web-Scraper, hat aber eine steile Lernkurve und teure Bezahl-Tarife. setzt auf KI, um Scraping wirklich einsteigerfreundlich zu machen – mit 2-Klick-Extraktion, Sofort-Vorlagen und deutlich günstigeren Preisen. Für die meisten Nicht-Techniker ist Thunderbit schneller, einfacher und weniger frustrierend.

2. Wie erleichtert Thunderbit Anfängern das Web Scraping?

Die Funktion „AI Suggest Columns“ erkennt automatisch, wie sich Daten am besten extrahieren lassen. Du klickst einfach auf „Scrape“ und die KI übernimmt den Rest – ohne dass du dich mit Selektoren, XPaths oder komplexen Einstellungen beschäftigen musst. Thunderbit ist so konzipiert, dass wirklich jeder damit arbeiten kann.

3. Kann Thunderbit auch komplexe Aufgaben wie Subseiten oder PDFs verarbeiten?

Auf jeden Fall! Thunderbits KI kann automatisch Unterseiten (z. B. Produktdetails oder Profile) besuchen und die Datentabelle anreichern. Außerdem lassen sich Tabellen aus PDFs, Word, Excel und Bildern extrahieren – einfach das Dokument hochladen und die KI erledigt den Rest. Mehr dazu findest du im .

Mehr erfahren