Unter E-Commerce-Insidern macht man sich gern einen Spaß: Wer wissen will, was die Konkurrenz treibt, braucht nur einen starken Kaffee, eine Excel-Tabelle und ein paar Stunden Zeit für Copy & Paste. Aber im Jahr 2025, wo der weltweite Onlinehandel auf zusteuert und E-Commerce schon über ausmacht, ist diese „Handarbeit“ so sinnvoll wie ein Pferdewagen für Expresslieferungen. Die Wahrheit ist: Im E-Commerce entscheidet heute der Zugang zu frischen Daten. Ob Operations, Marketing oder Geschäftsführung – alle brauchen die besten Infos zu Produkten, Preisen und Lagerbeständen, um vorne mitzuspielen.

Das Problem: E-Commerce-Websites werden immer trickreicher. Dynamische Inhalte, CAPTCHAs, IP-Sperren und ständig wechselnde Layouts machen das Scrapen von Produktdaten zu einer echten Detektivarbeit. Deshalb setzen sich moderne E-Commerce-Scraper durch, die mit KI, Headless-Browsern und cleveren Anti-Blockier-Technologien arbeiten. Nach vielen Jahren in SaaS und Automatisierung weiß ich: Mit dem richtigen Scraper wird aus stundenlangem Fleiß ein Job, der mit zwei Klicks erledigt ist.

In diesem Artikel stelle ich die 10 besten E-Commerce Web-Scraper für 2025 vor – inklusive Vergleich der wichtigsten Features, Anwendungsfälle, Preise und Nutzerbewertungen. Egal ob Einzelhändler oder globaler Player: Hier findet jeder das passende Tool – und vielleicht bleibt am Wochenende sogar wieder Zeit für die schönen Dinge.

So haben wir die besten E-Commerce-Scraper ausgewählt

Nicht jeder Web-Scraper taugt für E-Commerce. Bei unserer Auswahl haben wir auf die Kriterien geachtet, die für E-Commerce-Teams wirklich zählen:

- Genauigkeit & Zuverlässigkeit: Holt das Tool auch bei wechselnden Layouts oder dynamischem JavaScript die richtigen Daten raus?

- Benutzerfreundlichkeit: Kommen auch Nicht-Programmierer klar oder braucht man IT-Skills?

- Umgang mit dynamischen Inhalten: Funktioniert es auf modernen, JavaScript-lastigen Seiten mit Endlos-Scroll, Pop-ups und Unterseiten?

- Anti-Blocking & IP-Rotation: Kann das Tool CAPTCHAs und IP-Sperren austricksen oder ist nach ein paar Anfragen Schluss?

- Preis & Skalierbarkeit: Gibt’s faire Tarife für kleine Teams und lässt sich das Tool für große Projekte hochfahren?

- Nutzerbewertungen: Was sagen echte User auf , und im ?

- E-Commerce-Anwendungsfälle: Unterstützt das Tool das Scrapen von SKUs, Preisüberwachung, Bestandskontrolle, Lieferantenrecherche und Bilder-Extraktion?

Wir haben sowohl KI-basierte als auch klassische Tools berücksichtigt – von Browser-Add-ons bis zu API-Plattformen. Unser Ziel: Ein ehrlicher Überblick, was 2025 im E-Commerce wirklich funktioniert – ohne Marketing-Geschwafel.

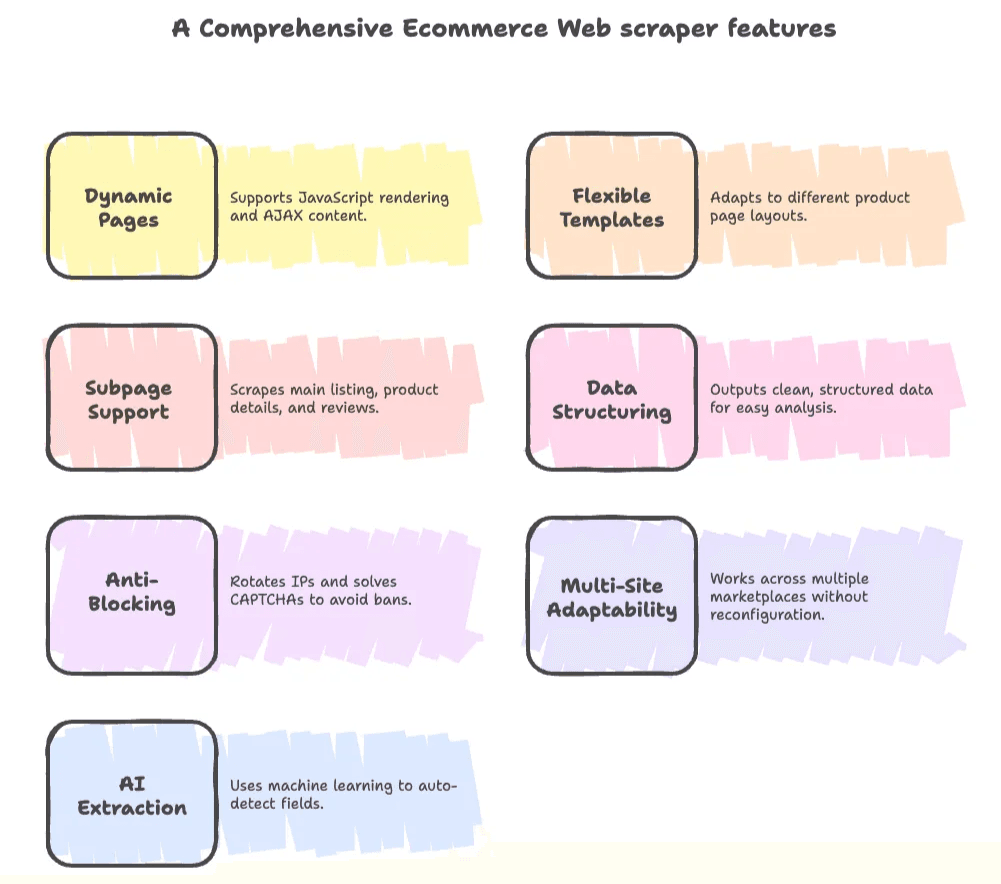

Was macht einen guten E-Commerce-Scraper aus?

Wer im E-Commerce arbeitet, kennt das Problem: Produktseiten mit ständig wechselndem HTML, Preise versteckt hinter JavaScript und Daten, die sich über Unterseiten und Paginierungen verteilen. Ein starker E-Commerce-Scraper sollte daher:

- Dynamische Seiten meistern: JavaScript-Rendering, Endlos-Scroll und AJAX-Inhalte müssen drin sein.

- Flexible Vorlagen: Unterschiedliche Produktseiten-Layouts sollten sich einfach anpassen lassen – auch bei wildem HTML.

- Unterseiten & Paginierung: Nicht nur Hauptlisten, sondern auch Produktdetails, Bewertungen und verwandte Artikel abgreifen.

- Strukturierte Daten & Export: Saubere, strukturierte Daten (CSV, Excel, Google Sheets, Notion, Airtable) für die Weiterverarbeitung bereitstellen.

- Anti-Blocking: IP-Wechsel, CAPTCHA-Lösungen und das Nachahmen von Nutzerverhalten, um Sperren zu umgehen.

- Multi-Site-Fähigkeit: Ohne ständiges Umkonfigurieren auf Amazon, Shopify, eBay, Walmart und Nischen-Marktplätzen laufen.

- KI-gestützte Extraktion: Maschinelles Lernen für automatische Felderkennung, Rauschunterdrückung und Anpassung an neue Layouts – besonders praktisch für Nicht-Techniker.

2025 setzen sich KI-basierte Scraper durch, weil sie Webseiten wie ein Mensch „lesen“, sich an neue Strukturen anpassen und Daten sogar direkt zusammenfassen oder übersetzen können. Klassische, vorlagenbasierte Tools haben aber weiterhin ihre Stärken – vor allem bei großen, wiederkehrenden Aufgaben.

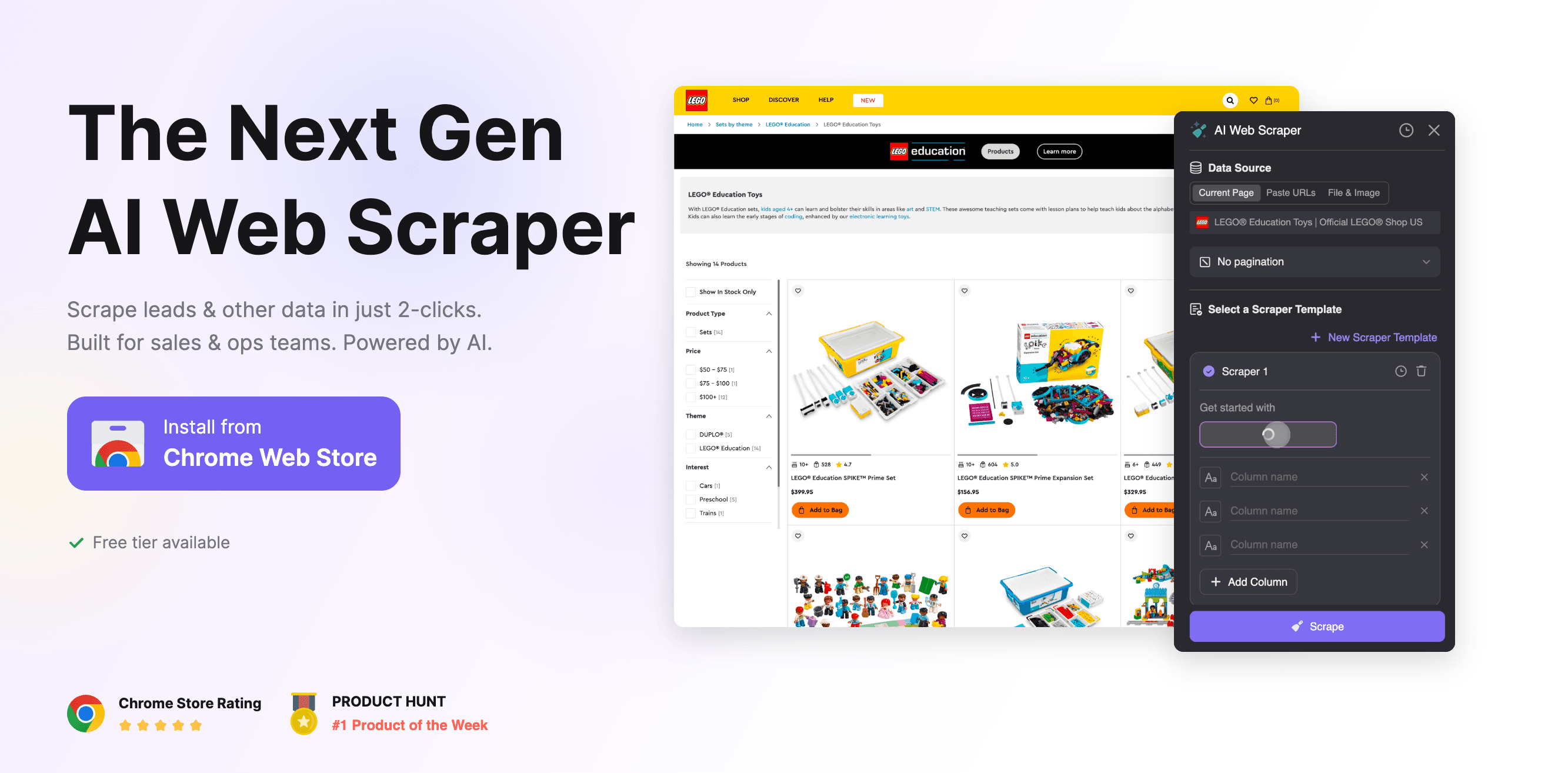

Thunderbit: KI-Web-Scraper für jeden Online-Shop

Los geht’s mit , der KI-basierten Chrome-Erweiterung, in die mein Team und ich viel Herzblut gesteckt haben. (Transparenz: Ich bin Mitgründer und kenne jedes Detail.) Aber keine Sorge, ich bleibe objektiv – Thunderbit ist nicht für jeden, aber für viele E-Commerce-Teams eine echte Erleichterung.

Wichtige Funktionen

- KI-Felderkennung: Mit „KI-Felder vorschlagen“ liest Thunderbit die Seite, schlägt relevante Spalten (z. B. Preis, SKU, Bild, Anbieter) vor und richtet Extraktions-Prompts ein.

- Unterseiten- & Paginierungs-Scraping: Erst Listen scrapen, dann automatisch in Produktdetails klicken und Zusatzinfos (z. B. Bewertungen, Spezifikationen, Lieferdetails) erfassen.

- Sofort-Vorlagen: 1-Klick-Scraper für Amazon, eBay, Shopify, Zillow und mehr – ohne Einrichtung.

- Rauschunterdrückung: KI filtert Werbung, Pop-ups und irrelevante Inhalte heraus – für saubere Daten auch auf unübersichtlichen Seiten.

- Mehrsprachigkeit: Unterstützt 34 Sprachen und kann Inhalte von jedem globalen Shop extrahieren und übersetzen.

- Exportoptionen: Daten direkt nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON exportieren.

- Geplantes Scraping: Wiederkehrende Scrapes für Preisüberwachung, Bestandskontrolle oder Lieferanten-Updates einrichten – ideal für Preisanalysen oder MAP-Compliance.

- Kostenlose Tools: 1-Klick-Extraktion von E-Mails, Telefonnummern und Bildern – praktisch für Lead-Generierung und Produktbilder.

Was macht Thunderbit besonders?

Thunderbits KI kann eine Vorlage flexibel auf unterschiedlichste Produktseiten anwenden – selbst bei chaotischem HTML. Du musst deinen Scraper also nicht jedes Mal neu bauen, wenn ein Anbieter seine Seite umbaut. Auch dynamische Inhalte (Endlos-Scroll, Pop-ups, AJAX-Preise) werden zuverlässig verarbeitet. Das Unterseiten-Scraping spart enorm viel Zeit bei der Anreicherung von Produktdaten.

Typische E-Commerce-Anwendungsfälle

- Preisüberwachung: Wettbewerberpreise auf vielen Seiten automatisch verfolgen.

- SKU-Scraping: Produktkataloge von Lieferanten oder Konkurrenten inklusive Bilder und Spezifikationen erstellen.

- Lieferanten-/Dropshipping-Recherche: Kontaktdaten, Lieferbedingungen und Lagerbestände extrahieren.

- Bewertungen & Lieferinfos: Kundenbewertungen, Ratings und Versanddetails für Analysen oder Marktforschung erfassen.

Preise & Bewertungen

Thunderbit arbeitet mit einem Credit-System: Die erlaubt 6 Seiten pro Monat (bzw. 10 mit Gratis-Test). Bezahlpläne starten ab 9 $/Monat (Starter, 500 Credits), Pro-Tarife für Vielnutzer (bis zu 120.000 Credits/Jahr). Der Datenexport ist immer kostenlos.

- Chrome Web Store: 4,9★ (20.000+ Nutzer)

Einschränkungen

Thunderbit richtet sich an Business-Anwender, nicht an Hardcore-Entwickler. Wer Millionen Seiten pro Tag scrapen oder tiefe API-Integrationen braucht, stößt an Grenzen. Die KI ist sehr anpassungsfähig, aber für Einsteiger gibt es eine kleine Lernkurve (unsere helfen beim Einstieg).

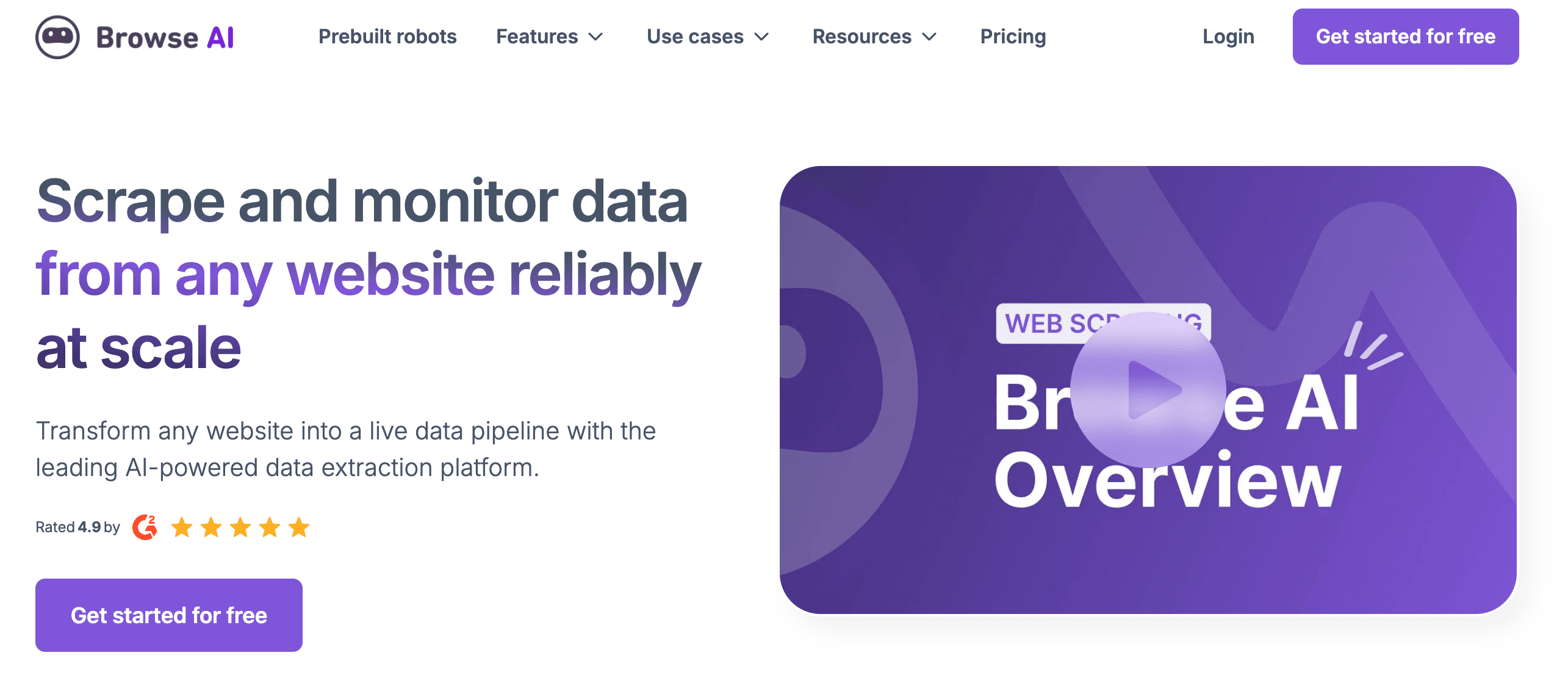

Browse.ai: Visueller E-Commerce-Scraper mit Automatisierung

Browse.ai ist ein No-Code, Cloud-basierter Scraper, bei dem du einfach per Klick dem „Roboter“ zeigst, was extrahiert werden soll. Besonders beliebt bei Teams, die Wettbewerbsbeobachtung automatisieren möchten – ganz ohne Programmierung.

Funktionen

- Visuelles Roboter-Training: Per Klick festlegen, welche Daten extrahiert werden.

- Automatisiertes Monitoring: Roboter regelmäßig Preise oder Lagerbestände prüfen lassen und Benachrichtigungen erhalten.

- Cloud-basiert: Roboter laufen auch, wenn dein Rechner aus ist.

- Integrationen: Anbindung an Google Sheets, Airtable, Slack und über 7.000 Apps via Zapier.

- Vorlagen: Über 150 fertige Roboter für Amazon, eBay, Best Buy und mehr.

E-Commerce-Anwendungsfälle

- Preisüberwachung: Wettbewerberpreise verfolgen und bei Änderungen benachrichtigt werden.

- Verfügbarkeitsprüfung: Lagerbestände auf mehreren Seiten im Blick behalten.

- Content-Aggregation: Produktdetails, Bewertungen und Neuheiten sammeln.

Preise & Bewertungen

- Kostenlos: 50 Credits/Monat (ca. 50 Seiten)

- Bezahlpläne: ab 49 $/Monat (2.000+ Credits)

- G2: 4,8/5

- Capterra: 4,5/5

Stärken & Schwächen

Browse.ai ist super einfach zu bedienen und eignet sich für kleine wie große Aufgaben. Nachteil: Ändert sich das Seitenlayout, muss der Roboter neu trainiert werden. Für stark geschützte Seiten kann die Erfolgsquote schwanken, obwohl Anti-Blocking integriert ist.

Octoparse: No-Code E-Commerce Web-Scraper

Octoparse ist ein etablierter No-Code-Scraper mit Desktop-App und Cloud-Service. Das Tool ist leistungsstark und flexibel – erfordert aber etwas Einarbeitung.

Funktionen

- Visueller Workflow-Builder: Per Klick Scraping-Aufgaben zusammenstellen.

- Smart Mode: Listen und Tabellen werden automatisch erkannt.

- Dynamische Inhalte: AJAX, Endlos-Scroll, Logins und Formulare werden unterstützt.

- Anti-Blocking: IP-Rotation, CAPTCHA-Lösung und Proxy-Integration.

- Cloud-Extraktion: Jobs rund um die Uhr ausführen, Scrapes planen und Daten in Excel, CSV, JSON oder Datenbanken exportieren.

E-Commerce-Anwendungsfälle

- Massenextraktion: Tausende SKUs, Preise und Bewertungen scrapen.

- Wettbewerbsanalyse: Preise und Verfügbarkeit auf Marktplätzen überwachen.

- Review-Mining: Kundenfeedback für Stimmungsanalysen sammeln.

Preise & Bewertungen

- Kostenlos: 10.000 Zeilen/Export, 2 gleichzeitige Jobs

- Standard: 119 $/Monat

- Professional: 299 $/Monat

- G2/Capterra: 4,7/5

Für wen geeignet?

Ideal für Business-Anwender, die ohne Code viel erreichen wollen. Für Technikaffine ein Spielplatz, für Einsteiger empfiehlt sich der Start mit Vorlagen.

Bright Data: Enterprise-Scraping für E-Commerce

Bright Data ist die erste Wahl für Unternehmen, die in großem Stil scrapen wollen. Wer Millionen Seiten erfassen, jede Anti-Bot-Hürde nehmen und Premium-Support möchte, ist hier richtig.

Funktionen

- Riesiges Proxy-Netzwerk: 72 Mio. IPs, Geo-Targeting und mobile Proxies.

- Web-Scraper-API: Headless-Browsing, CAPTCHAs und strukturierte Daten.

- No-Code Data Collector: Vorlagen für Amazon, eBay, AliExpress und mehr.

- Dataset-Marktplatz: Vorgefertigte E-Commerce-Datensätze kaufen.

- Compliance & Support: Rechtsteam, 24/7-Support und persönliche Betreuung.

E-Commerce-Anwendungsfälle

- Preisvergleich in Echtzeit: Preise weltweit überwachen.

- MAP-Compliance: Unautorisierte Rabatte erkennen.

- Marktforschung: Produktlisten und Bewertungen in großem Umfang aggregieren.

Preise & Bewertungen

- Kein kostenloser Tarif: Gratis-Test verfügbar

- Nutzungsbasiert: ca. 2,80 $ pro 1.000 Ergebnisse

- G2/Trustpilot: 4,6/5

Stärken & Schwächen

Bright Data ist unschlagbar in Sachen Skalierbarkeit und Zuverlässigkeit, aber preislich im oberen Segment und eher für große Teams geeignet. Für kleine Shops meist zu aufwendig und teuer.

ScraperAPI: Flexibler E-Commerce-Scraper mit API

ScraperAPI ist das Lieblingswerkzeug vieler Entwickler: Eine einfache API, die Proxies, CAPTCHAs und JavaScript-Rendering übernimmt – du kümmerst dich nur um die Datenverarbeitung.

Funktionen

- API-First: HTML oder JSON jeder Seite mit einem API-Call abrufen.

- Automatische IP-Rotation: Geo-Targeting für über 50 Länder.

- JavaScript-Rendering: Auch moderne, dynamische Shops werden unterstützt.

- Parallele Anfragen: Hohe Geschwindigkeit für große Datenmengen.

- SDKs: Python, Node.js, PHP, Ruby, Java.

E-Commerce-Anwendungsfälle

- Eigene Preis-Aggregation: Produktdaten in eigene Dashboards oder Apps einspeisen.

- Bestandsüberwachung: Lagerstände auf mehreren Seiten verfolgen.

- Review-Scraping: Bewertungen für Stimmungsanalysen sammeln.

Preise & Bewertungen

- Gratis-Test: 5.000 API-Aufrufe

- Bezahlpläne: ab 49 $/Monat (100.000 Anfragen)

- G2: 4,4/5

Für wen geeignet?

Ideal für Entwicklerteams, die eigene Scraper oder Apps bauen. Für Nicht-Techniker weniger geeignet, aber unschlagbar flexibel und günstig.

Zyte: Schneller und anpassbarer E-Commerce-Scraper

Zyte (früher Scrapinghub) ist ein Kraftpaket für Entwickler und Unternehmen, die KI-gestütztes, voll gemanagtes Scraping suchen.

Funktionen

- Zyte API: Einheitlicher Endpunkt für Crawling, Unblocking und Datenextraktion.

- KI-Parsing: Automatische Felderkennung, auch bei sich ändernden Seiten.

- Smart Proxy Manager: Fortschrittliche Anti-Blocking- und IP-Rotation.

- Compliance: Eigenes Rechtsteam und ethische Datenerhebung.

E-Commerce-Anwendungsfälle

- Katalog-Extraktion im großen Stil: Ganze Kategorien oder Marktplätze scrapen.

- Preisfeeds der Konkurrenz: Automatisierte, strukturierte Preis- und Bestandsdaten.

- Markenüberwachung: Unautorisierte Händler oder fehlerhafte Listings erkennen.

Preise & Bewertungen

- Gratis-Credits: ca. 25 $/Monat zum Einstieg

- Bezahlpläne: ab ca. 100 $/Monat

- G2: 4,4/5

Für wen geeignet?

Optimal für Entwicklerteams oder Unternehmen, die Skalierbarkeit, Compliance und KI-Extraktion brauchen. Für Nicht-Techniker weniger geeignet.

Bardeen AI: Automatisierungsfokussierter E-Commerce-Scraper

Bardeen ist ein KI-Automatisierungstool und eine Chrome-Erweiterung, mit der du Webdaten als Teil größerer Workflows extrahierst – quasi das Schweizer Taschenmesser für deinen Browser.

Funktionen

- KI-Playbooks: Mit natürlichen Sprachbefehlen Scraping und Automatisierung einrichten.

- Integrationen: Google Sheets, Notion, Slack, CRMs und mehr.

- Cloud & Lokal: Wiederkehrende Scrapes planen oder spontan ausführen.

- Browser-basiert: Extrahiert, was du siehst – auch dynamische Inhalte.

E-Commerce-Anwendungsfälle

- Lead-Generierung: Lieferanten- oder Anbieterinfos direkt ins CRM scrapen.

- Schnelle Preischecks: Wettbewerberpreise erfassen und Team benachrichtigen.

- Produktlisten-Extraktion: Listen mit SKUs, Preisen und Bildern für Recherchen erstellen.

Preise & Bewertungen

- Kostenlos: 100 Credits/Monat

- Bezahlpläne: ab 99 $/Monat ()

- G2: 4,8/5

Für wen geeignet?

Ideal für Vertriebs- und Operationsteams, die wiederkehrende Aufgaben automatisieren wollen. Nicht für Massenscraping, aber perfekt für tägliche Workflows.

Data Miner: Chrome-Erweiterung für E-Commerce-Produkt-Scraping

Data Miner ist eine bewährte Chrome-Erweiterung für visuelles Scraping – besonders beliebt bei Nicht-Programmierern und Forschern.

Funktionen

- Rezept-Bibliothek: Über 60.000 fertige Extraktionsrezepte für gängige Seiten.

- Eigene Extraktion: Visueller Selektor für eigene Rezepte.

- Paginierungs-Automation: Über mehrere Seiten hinweg scrapen.

- Exportoptionen: CSV, Excel, Google Sheets.

E-Commerce-Anwendungsfälle

- Schnelles Produkt-Scraping: Produktlisten, Preise und Details von fast jeder Seite extrahieren.

- Marktforschung: Wettbewerberkataloge erstellen oder Neuheiten überwachen.

- Kontakt-Extraktion: Anbieter- oder Lieferantendaten aus Verzeichnissen ziehen.

Preise & Bewertungen

- Kostenlos: 500 Seiten/Monat

- Bezahlpläne: ab 19,99 $/Monat

- Chrome Store: 4,0★ (300.000+ Nutzer)

Für wen geeignet?

Ideal für kleine Unternehmen und Nicht-Techniker, die schnell und unkompliziert scrapen wollen. Nicht für große oder häufige Aufgaben gedacht.

Oxylabs: Leistungsstarker E-Commerce-Scraper für jeden Shop

Oxylabs ist ein Premium-Anbieter für Proxies und Scraper-APIs – ideal für große Datenmengen und höchste Ansprüche.

Funktionen

- 100 Mio.+ Proxies: Weltweit Wohn-, Rechenzentrums- und mobile IPs.

- E-Commerce-Scraper-API: Strukturierte Daten für Amazon, Walmart, eBay und mehr.

- KI-Parsing: Anpassungsfähige Extraktion bei sich ändernden Seiten.

- Geo-Targeting: Regionale Preise und Verfügbarkeiten scrapen.

E-Commerce-Anwendungsfälle

- Globale Preisanalysen: Preise und Lagerstände in verschiedenen Ländern überwachen.

- MAP-Überwachung: Unautorisierte Rabatte oder Händler erkennen.

- Datenaggregation: Große Produktdatenbanken für Analysen aufbauen.

Preise & Bewertungen

- Gratis-Test: 7 Tage

- Bezahlpläne: ab 49 $/Monat oder ca. 1,60 $ pro 1.000 Ergebnisse

- G2: 4,7/5

Für wen geeignet?

Optimal für Unternehmen oder Agenturen mit hohem Datenbedarf, die Zuverlässigkeit, Support und globale Reichweite brauchen. Für kleine Teams meist zu umfangreich.

Apify: Anpassbare E-Commerce-Scraper-Plattform

Apify ist das „Schweizer Taschenmesser“ unter den Web-Scraping-Plattformen – mit Marktplatz für fertige Scraper (Actors) und der Möglichkeit, eigene zu entwickeln.

Funktionen

- Actor-Marktplatz: Über 4.500 fertige Scraper für Amazon, eBay, Shopify und mehr.

- Eigene Entwicklung: Eigene Actors in JavaScript/Python erstellen und in der Cloud ausführen.

- Planung & API: Wiederkehrende Scrapes automatisieren und mit eigenen Systemen verbinden.

- Proxy-Integration: Apify-Proxies nutzen oder eigene einbinden.

E-Commerce-Anwendungsfälle

- Produktkataloge aggregieren: Ganze Kategorien oder Marktplätze scrapen.

- Bewertungs- & Sentiment-Analyse: Kundenfeedback sammeln und auswerten.

- Bestandsüberwachung: Lagerstände bei Lieferanten im Blick behalten.

Preise & Bewertungen

- Kostenlos: 5 $/Monat in Credits

- Bezahlpläne: ab 49 $/Monat

- G2: 4,7/5

Für wen geeignet?

Ideal für Entwickler oder Teams, die maximale Flexibilität wollen – oder für alle, die im Actor-Store fündig werden. Für eigene Projekte ist etwas Einarbeitung nötig, aber die Vielseitigkeit ist unschlagbar.

Feature-Vergleich: E-Commerce-Scraper im Überblick

| Tool | Hauptfunktionen | Preise | Unterstützte Seiten | Exportoptionen | Nutzerbewertungen | Ideal für |

|---|---|---|---|---|---|---|

| Thunderbit | KI-Felderkennung, Unterseiten/Paginierung, Vorlagen, Mehrsprachigkeit | Kostenlos, ab 9 $/Monat | Alle (Amazon, eBay, Shopify, etc.) | Excel, Sheets, Notion, Airtable, CSV | 4,9 (Chrome) | Nicht-Programmierer, KMU, Ops-Teams |

| Browse.ai | Visuelle Roboter, Monitoring, Cloud, Integrationen | Kostenlos, ab 49 $/Monat | Alle, 150+ Vorlagen | Sheets, Airtable, CSV | 4,8 (G2) | No-Code-User, Monitoring |

| Octoparse | Visueller Builder, Cloud, Anti-Blocking, Vorlagen | Kostenlos, ab 119 $/Monat | Alle, 100+ Vorlagen | Excel, CSV, JSON, DB | 4,7 (G2) | Power-User, große Jobs |

| Bright Data | Proxy-Netzwerk, APIs, Data Collector, Datasets | Test, 2,80 $/1k | Alle, Vorlagen für Amazon, eBay, etc. | JSON, CSV, DB | 4,6 (G2) | Enterprise, globaler Maßstab |

| ScraperAPI | API, Proxies, JS-Rendering, SDKs | Test, ab 49 $/Monat | Alle | HTML, JSON | 4,4 (G2) | Entwickler, eigene Apps |

| Zyte | KI-Parsing, Smart Proxy, Compliance | 25 $+ Credits, ab 100 $/Monat | Alle, Amazon, eBay, etc. | JSON, CSV | 4,4 (G2) | Unternehmen, Dev-Teams |

| Bardeen | KI-Playbooks, Automatisierung, Integrationen | Kostenlos, ab 99 $/Monat | Alle (browserbasiert) | Sheets, Notion, Slack | 4,8 (G2) | Sales/Ops, Workflow-Automatisierung |

| Data Miner | Chrome-Erweiterung, Rezepte, Paginierung | Kostenlos, ab 19,99 $/Monat | Alle, 60k+ Rezepte | CSV, Excel, Sheets | 4,0 (Chrome) | Nicht-Programmierer, schnelle Scrapes |

| Oxylabs | 100 Mio. Proxies, Scraper-APIs, KI-Parsing | Test, ab 49 $/Monat | Alle, Amazon, Walmart, etc. | JSON, CSV | 4,7 (G2) | Enterprise, globale Ops |

| Apify | Actor-Marktplatz, eigene Skripte, Cloud | Kostenlos, ab 49 $/Monat | Alle, 4.500+ Actors | JSON, CSV, API | 4,7 (G2) | Entwickler, individuelle Workflows |

So findest du den passenden E-Commerce-Scraper

Die Wahl des richtigen E-Commerce-Scrapers ist wie die Entscheidung für ein Auto: Brauchst du einen wendigen City-Flitzer oder einen robusten Transporter? So findest du das passende Modell:

- Für Nicht-Techniker & KMU: Tools wie , Browse.ai und Data Miner sind top. Schnell startklar, kein Coding nötig und decken die meisten E-Commerce-Bedürfnisse ab.

- Für Power-User & große Datenmengen: Octoparse und Apify bieten mehr Flexibilität und Skalierbarkeit, mit Vorlagen und Cloud-Ausführung für große Projekte.

- Für Entwickler & individuelle Integrationen: ScraperAPI und Zyte sind API-basiert und ermöglichen maßgeschneiderte Lösungen und eigene Apps.

- Für Enterprise & globale Anforderungen: Bright Data und Oxylabs sind für riesige, unternehmenskritische Scraping-Projekte gemacht – mit Top-Support und Anti-Blocking.

- Für Workflow-Automatisierung: Bardeen ist perfekt, wenn du Scraping mit automatischer Dateneingabe, Benachrichtigungen oder CRM-Updates kombinieren willst.

Tipp: Starte immer mit einer kostenlosen Testversion. Probiere deine Zielseiten aus, check die Exportmöglichkeiten und lies Nutzerbewertungen, um böse Überraschungen zu vermeiden.

Fazit: Mit dem richtigen Scraper zum E-Commerce-Erfolg

2025 ist E-Commerce ein datengetriebenes Spielfeld. Der passende E-Commerce-Scraper entscheidet, ob du im Blindflug unterwegs bist oder fundierte, schnelle Entscheidungen zu Preisen, Lager und Trends triffst. Ob du SKUs für einen Produktlaunch scrapen, Wettbewerberpreise überwachen oder neue Lieferanten recherchieren willst – in dieser Liste findest du das passende Tool für deine Anforderungen und dein Know-how.

KI-basierte Scraper wie und Zyte machen es möglich, auch ohne Entwicklerkenntnisse strukturierte, zuverlässige Daten selbst von komplexen Seiten zu extrahieren. Gleichzeitig bieten Enterprise-Plattformen wie Bright Data und Oxylabs die nötige Power für große Marken.

Mein Tipp: Lass Copy-Paste und veraltete Tools hinter dir. Probier die besten E-Commerce Web-Scraper aus, automatisiere deine Datenprozesse und verschaff deinem Team den entscheidenden Vorsprung. Mehr Einblicke und Tutorials, wie KI das Web-Scraping revolutioniert, findest du im .

Häufige Fragen (FAQ)

-

Welche Funktionen sollte ein E-Commerce-Scraper 2025 unbedingt bieten?

Achte auf Tools, die JavaScript und Endlos-Scroll verarbeiten, Vorlagen flexibel an neue Layouts anpassen, Unterseiten und Paginierungen scrapen, Daten strukturiert (CSV/JSON/Sheets) exportieren und Anti-Blocking-Maßnahmen wie IP-Rotation und CAPTCHA-Umgehung bieten. Skalierbarkeit, zuverlässige Updates bei Seitenänderungen und flexible Exportoptionen sind für nachhaltige Datenerfassung ein Muss.

-

Worin unterscheiden sich KI-Scraper von klassischen, vorlagenbasierten Tools?

KI-Scraper nutzen maschinelles Lernen, um Felder automatisch zu erkennen, Werbung und Pop-ups herauszufiltern und sich ohne manuelle Anpassung an neue HTML-Strukturen anzupassen. Sie können Inhalte direkt zusammenfassen oder übersetzen und kommen auch mit dynamischen, unübersichtlichen Seiten klar – das spart Zeit und Nerven. Klassische Tools sind bei großen, wiederkehrenden Aufgaben stark, brauchen aber mehr Handarbeit.

-

Wie vereinfacht Thunderbit die E-Commerce-Datenextraktion?

Die Chrome-Erweiterung von Thunderbit liest jede Produktseite aus, schlägt automatisch Spalten (Preis, SKU, Bilder) vor und klickt sich durch Listen, um Spezifikationen, Bewertungen und Versandinfos zu erfassen. Mit 1-Klick-Vorlagen für Amazon, eBay, Shopify, integrierter IP-Rotation und geplantem Scraping bekommst du saubere, strukturierte Daten (CSV, Sheets, Airtable) – ganz ohne Programmierkenntnisse. Perfekt für Teams ohne eigene IT.

Mehr erfahren: