Das Internet wächst in einem Tempo, das einem fast schwindelig werden kann. Im Jahr 2024 gibt es und an Daten, die durchs Netz geistern – und im nächsten Jahr werden es voraussichtlich schon 181 ZB sein. Das ist eine unfassbare Menge an digitalen Inhalten! Aber der Knackpunkt: Nur rund . Der Rest versteckt sich im sogenannten „Deep Web“ und bleibt für normale Suchanfragen unsichtbar. Wie behalten Suchmaschinen und Unternehmen in diesem Datendschungel den Überblick? Genau hier kommen Web-Crawler ins Spiel.

In diesem Guide zeige ich dir, was Web Crawling eigentlich ist, wie es funktioniert und warum es nicht nur für Technik-Nerds spannend ist, sondern für alle, die das Potenzial von Online-Daten ausschöpfen wollen. Wir klären außerdem, worin sich Web Crawling und Web Scraping unterscheiden (Spoiler: Das ist nicht das Gleiche!), schauen uns Praxisbeispiele an und werfen einen Blick auf Lösungen mit und ohne Programmierkenntnisse – inklusive meinem Favoriten . Egal, ob du gerade erst einsteigst oder als Unternehmen mehr aus dem Web herausholen willst – hier bist du goldrichtig.

Was ist ein Web-Crawler? Die Basics des Web Crawling

Ganz einfach erklärt: Ein Web-Crawler (auch Spider, Bot oder Website-Crawler genannt) ist ein automatisiertes Programm, das das Internet systematisch durchstöbert, Webseiten abruft und Links folgt, um immer neue Inhalte zu entdecken. Stell dir einen Roboter-Bibliothekar vor, der mit einer Liste von Büchern (URLs) startet, jedes Buch liest und dann allen Verweisen nachgeht, um noch mehr Bücher zu finden. Genau so arbeitet ein Crawler – nur eben mit Webseiten statt Büchern und im riesigen „Regal“ des Internets.

Das Grundprinzip:

- Start mit einer Liste von URLs (den sogenannten „Seeds“)

- Jede Seite besuchen und deren Inhalte (HTML, Bilder usw.) herunterladen

- Hyperlinks auf den Seiten finden und zur Warteschlange hinzufügen

- Wiederholen – neue Links besuchen, weitere Seiten entdecken usw.

Die Hauptaufgabe eines Web-Crawlers ist es, Seiten zu entdecken und zu katalogisieren. Bei Suchmaschinen werden die Inhalte kopiert und für die Indexierung vorbereitet. In anderen Fällen extrahieren spezialisierte Crawler gezielt bestimmte Datenpunkte (hier kommt Web Scraping ins Spiel – dazu gleich mehr).

Wichtig zu merken:

Web Crawling heißt, das Web zu erkunden und zu kartieren, nicht einfach nur Daten abzugreifen. Es ist die Grundlage dafür, dass Suchmaschinen wie Google und Bing überhaupt wissen, was im Netz alles existiert.

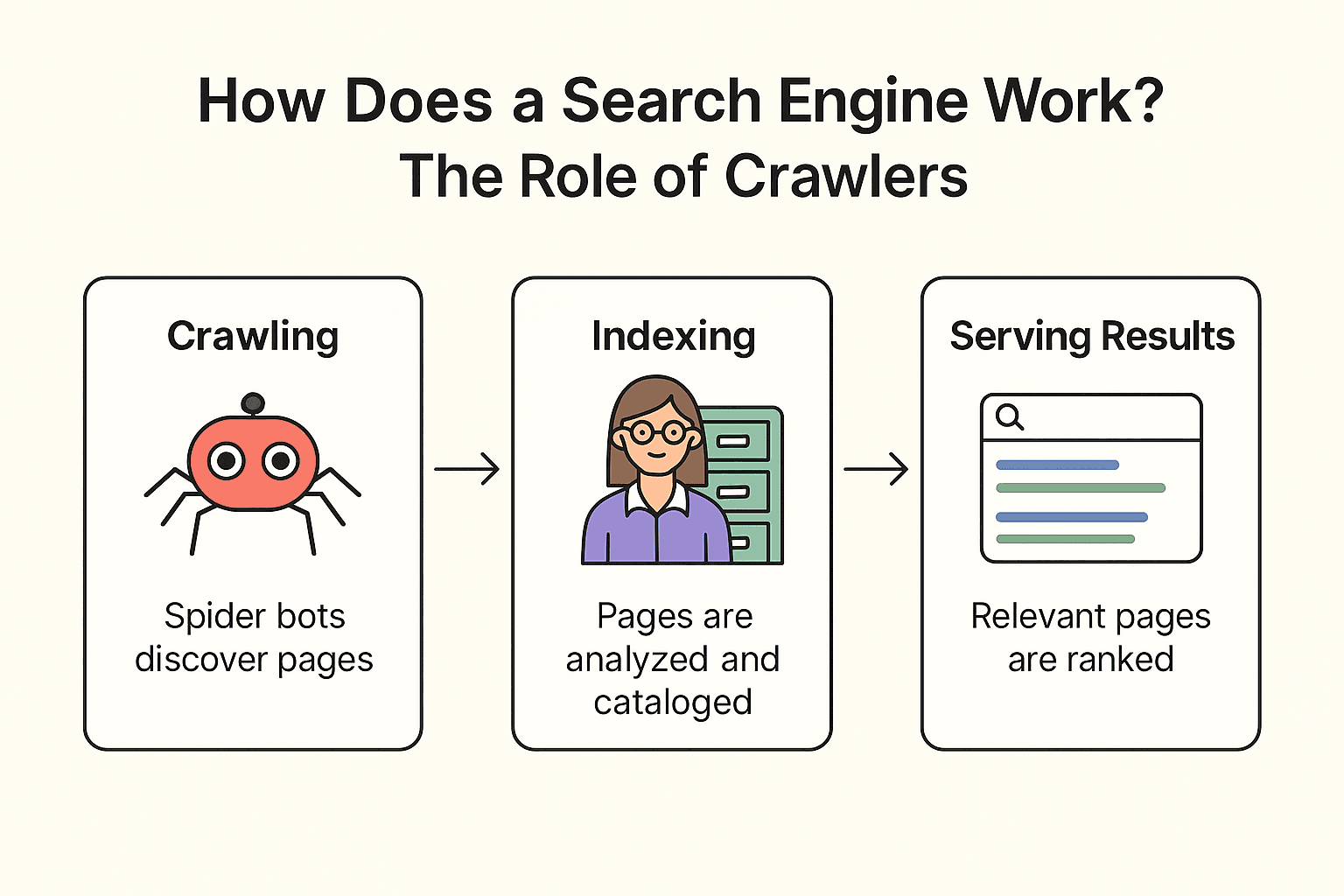

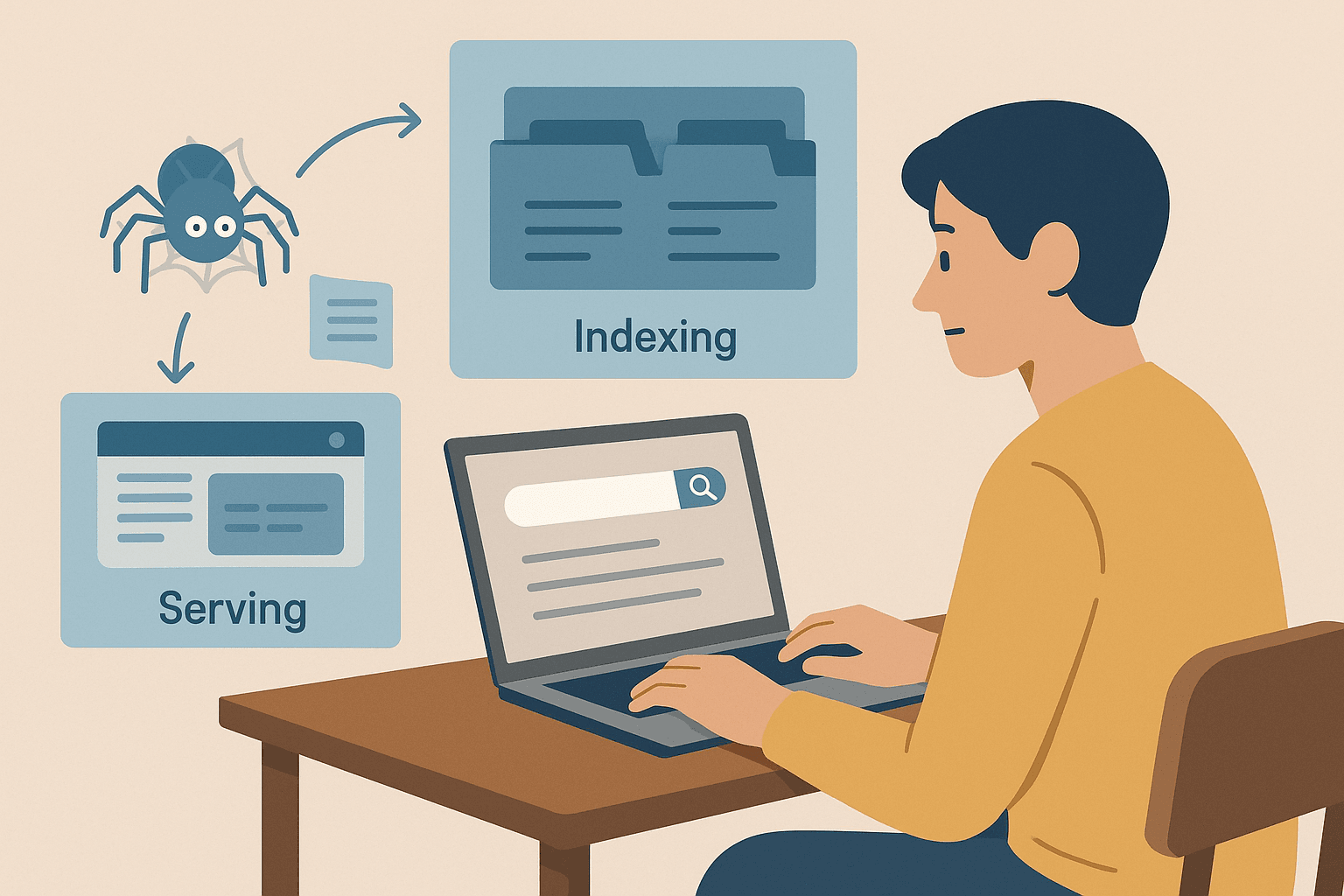

Wie funktioniert eine Suchmaschine? Die Rolle der Crawler

Wie arbeiten eigentlich Google, Bing oder DuckDuckGo? Im Kern läuft alles in drei Schritten ab: Crawling, Indexierung und Ausspielen der Suchergebnisse ().

Nehmen wir wieder das Bibliotheks-Beispiel:

-

Crawling:

Die Suchmaschine schickt ihre „Spider-Bots“ (wie Googlebot) los, um das Web zu erkunden. Sie starten bei bekannten Seiten, holen deren Inhalte und folgen Links zu neuen Seiten – wie ein Bibliothekar, der jedes Regal prüft und allen Fußnoten nachgeht, um weitere Bücher zu finden.

-

Indexierung:

Ist eine Seite gefunden, analysiert die Suchmaschine deren Inhalt, erkennt das Thema und speichert wichtige Infos in einem riesigen digitalen Katalog (dem Index). Nicht jede Seite wird aufgenommen – manche werden übersprungen, wenn sie blockiert, von schlechter Qualität oder doppelt sind.

-

Suchergebnisse anzeigen:

Suchst du z. B. nach „beste Pizza in der Nähe“, durchsucht die Suchmaschine ihren Index nach passenden Seiten und sortiert sie nach Hunderten von Faktoren (wie Keywords, Beliebtheit, Aktualität). Das Ergebnis: Eine übersichtliche Liste von Webseiten, die du durchstöbern kannst.

Fun Fact:

Suchmaschinen crawlen nicht jede Seite im Netz. Seiten hinter Logins, blockiert durch robots.txt oder ohne eingehende Links werden oft nie entdeckt. Deshalb reichen Unternehmen ihre URLs oder Sitemaps manchmal direkt bei Google ein.

Web Crawling vs. Web Scraping: Was ist der Unterschied?

Jetzt wird’s spannend: Viele werfen „Web Crawling“ und „Web Scraping“ in einen Topf, aber das sind zwei verschiedene Paar Schuhe.

| Aspekt | Web Crawling (Spidering) | Web Scraping |

|---|---|---|

| Ziel | Möglichst viele Seiten entdecken und indexieren | Gezielt bestimmte Daten von einer oder mehreren Webseiten extrahieren |

| Vergleich | Bibliothekar, der jedes Buch im Katalog erfasst | Student, der sich gezielt Notizen aus relevanten Büchern macht |

| Ergebnis | Liste von URLs oder Seiteninhalten (für die Indexierung) | Strukturierte Datensätze (CSV, Excel, JSON) mit gezielten Infos |

| Nutzer | Suchmaschinen, SEO-Tools, Web-Archive | Vertrieb, Marketing, Forschung, u. a. |

| Umfang | Riesig (Millionen/Milliarden Seiten) | Fokussiert (Dutzende, Hunderte oder Tausende Seiten) |

.

Kurz gesagt:

- Web Crawling dient dazu, Seiten zu finden (das Web zu kartieren)

- Web Scraping bedeutet, gezielt Daten von diesen Seiten zu extrahieren (z. B. für eine Tabelle)

Gerade für Unternehmen (z. B. im Vertrieb, E-Commerce oder Marketing) ist meist das Scraping spannender – also das strukturierte Sammeln von Daten für Analysen. Crawling ist die Basis für Suchmaschinen und große Datenprojekte, Scraping ist gezielte Datenernte.

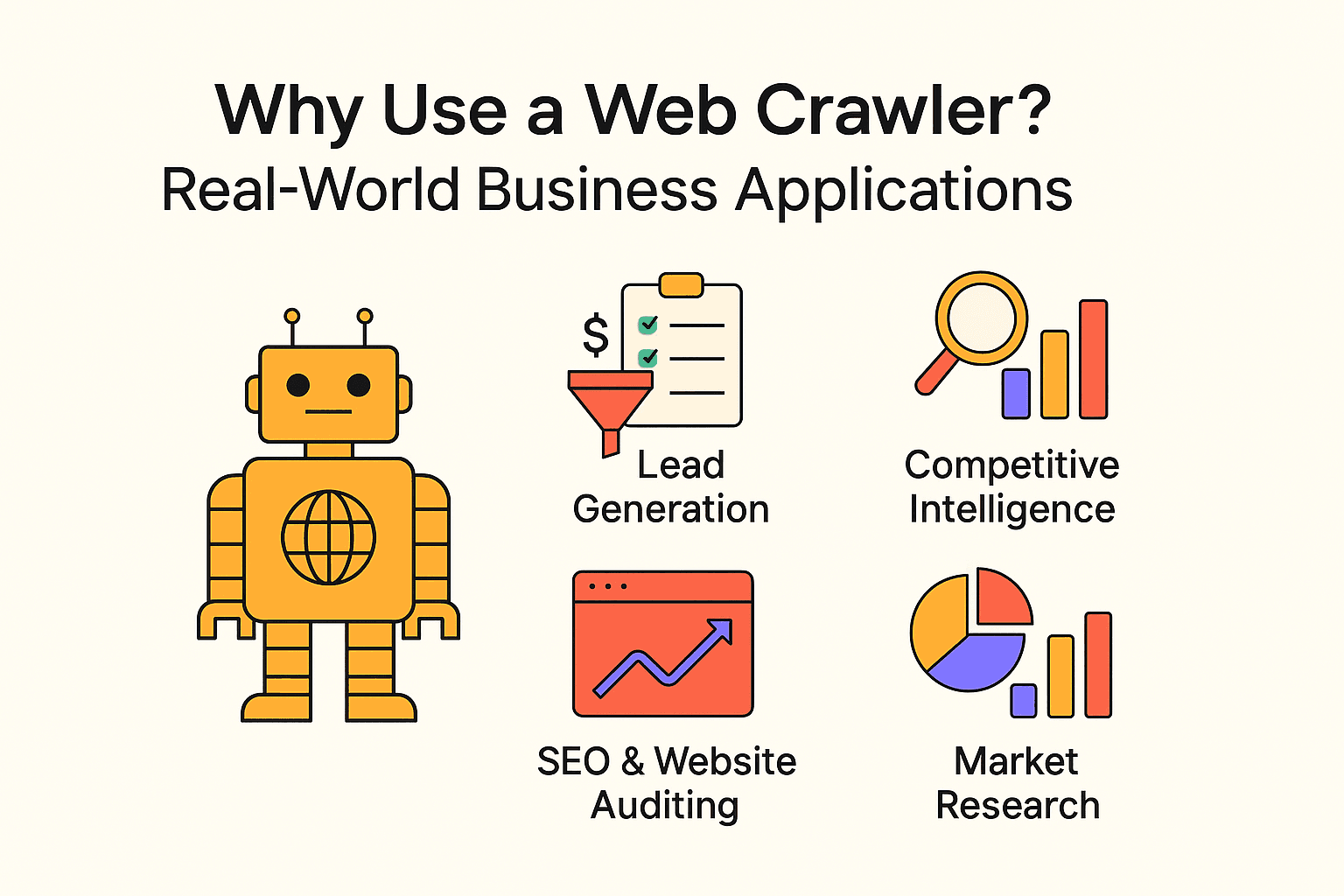

Warum einen Web-Crawler nutzen? Praxisbeispiele für Unternehmen

Web Crawling ist längst nicht nur für Suchmaschinen interessant. Unternehmen jeder Größe setzen Crawler und Scraper ein, um wertvolle Einblicke zu gewinnen und Routineaufgaben zu automatisieren. Hier ein paar typische Anwendungsfälle:

| Anwendungsfall | Zielgruppe | Nutzen |

|---|---|---|

| Lead-Generierung | Vertriebsteams | Automatisierte Akquise, CRM mit frischen Kontakten füllen |

| Wettbewerbsanalyse | Einzelhandel, E-Commerce | Preise, Lagerbestände und Produktänderungen der Konkurrenz überwachen |

| SEO & Website-Audit | Marketing, SEO-Teams | Fehlerhafte Links finden, Seitenstruktur optimieren |

| Content-Aggregation | Medien, Forschung, HR | Nachrichten, Stellenanzeigen oder öffentliche Datensätze sammeln |

| Marktforschung | Analysten, Produktteams | Bewertungen, Trends oder Stimmungen in großem Stil analysieren |

- – dank automatisiertem Web Crawling.

- und setzen auf Web Scraping für ihre Entscheidungen.

- Web Scraping kann und gegenüber manueller Datenerfassung einsparen.

Fazit: Wer Webdaten nicht nutzt, überlässt das Feld der Konkurrenz.

Einen Web-Crawler mit Python programmieren: Das solltest du wissen

Wer sich mit Programmierung auskennt, greift für eigene Crawler meist zu Python. Das Grundrezept:

- Mit requests Webseiten abrufen

- Mit BeautifulSoup HTML parsen und Links/Daten extrahieren

- Mit Schleifen (oder Rekursion) Links folgen und weitere Seiten crawlen

Vorteile:

- Maximale Flexibilität und Kontrolle

- Komplexe Logik, individuelle Datenflüsse und Datenbankanbindung möglich

Nachteile:

- Programmierkenntnisse erforderlich

- Wartungsaufwand: Ändert sich das Webseiten-Layout, muss das Skript angepasst werden

- Anti-Bot-Maßnahmen, Verzögerungen und Fehlerbehandlung müssen selbst umgesetzt werden

Einsteigerfreundliches Python-Beispiel:

Hier ein einfaches Skript, das Zitate und Autoren von abruft:

1import requests

2from bs4 import BeautifulSoup

3url = "<http://quotes.toscrape.com/page/1/>"

4response = requests.get(url)

5soup = BeautifulSoup(response.text, 'html.parser')

6for quote in soup.find_all('div', class_='quote'):

7 text = quote.find('span', class_='text').get_text()

8 author = quote.find('small', class_='author').get_text()

9 print(f"{text} --- {author}")Um mehrere Seiten zu crawlen, ergänzt man eine Logik, die den „Next“-Button erkennt und solange weiterläuft, bis keine Seiten mehr übrig sind.

Typische Stolperfallen:

- robots.txt oder Crawl-Delay ignorieren (bitte nicht!)

- Von Anti-Bot-Systemen blockiert werden

- Endlos-Schleifen crawlen (z. B. Kalenderseiten ohne Ende)

Schritt-für-Schritt-Anleitung: Einen einfachen Web-Crawler mit Python bauen

Wer selbst Hand anlegen will, findet hier eine grobe Schrittfolge für einen Basis-Crawler.

Schritt 1: Python-Umgebung einrichten

Zuerst sicherstellen, dass Python installiert ist. Dann die benötigten Bibliotheken installieren:

1pip install requests beautifulsoup4Falls es hakt: Python-Version checken (python --version) und schauen, ob pip läuft.

Schritt 2: Die Kernlogik des Crawlers schreiben

So sieht ein einfaches Muster aus:

1import requests

2from bs4 import BeautifulSoup

3def crawl(url, depth=1, max_depth=2, visited=None):

4 if visited is None:

5 visited = set()

6 if url in visited or depth > max_depth:

7 return

8 visited.add(url)

9 print(f"Crawling: {url}")

10 response = requests.get(url)

11 soup = BeautifulSoup(response.text, 'html.parser')

12 # Links extrahieren

13 for link in soup.find_all('a', href=True):

14 next_url = link['href']

15 if next_url.startswith('http'):

16 crawl(next_url, depth + 1, max_depth, visited)

17start_url = "<http://quotes.toscrape.com/>"

18crawl(start_url)Tipps:

- Crawl-Tiefe begrenzen, um Endlos-Schleifen zu vermeiden

- Besuchte URLs speichern, um Dopplungen zu verhindern

- robots.txt beachten und Pausen (time.sleep(1)) zwischen Anfragen einbauen

Schritt 3: Daten extrahieren und speichern

Um Daten zu speichern, kann man z. B. eine CSV-Datei schreiben:

1import csv

2with open('quotes.csv', 'w', newline='', encoding='utf-8') as file:

3 writer = csv.writer(file)

4 writer.writerow(['Quote', 'Author'])

5 # Innerhalb der Crawl-Schleife:

6 writer.writerow([text, author])Alternativ kann man das Python-json-Modul für JSON-Ausgaben nutzen.

Wichtige Hinweise und Best Practices beim Web Crawling

Web Crawling ist mächtig, aber mit großer Macht kommt auch Verantwortung (und das Risiko, dass die eigene IP gesperrt wird). So bleibst du auf der sicheren Seite:

- robots.txt respektieren: Immer prüfen und beachten, was eine Website erlaubt oder verbietet.

- Schonend crawlen: Pausen zwischen Anfragen einbauen (mindestens ein paar Sekunden). Server nicht überlasten.

- Umfang begrenzen: Nur das crawlen, was wirklich gebraucht wird. Tiefe und Domain einschränken.

- Sich zu erkennen geben: Einen aussagekräftigen User-Agent verwenden.

- Gesetze beachten: Keine privaten oder sensiblen Daten scrapen. Nur öffentliche Daten nutzen.

- Ethik wahren: Keine kompletten Websites kopieren oder gescrapte Daten für Spam verwenden.

- Langsam testen: Mit kleinen Crawls starten und erst bei Erfolg ausweiten.

Mehr dazu im .

Wann ist Web Scraping die bessere Wahl? Thunderbit für Unternehmen

Mein ehrlicher Tipp: Wenn du nicht gerade eine eigene Suchmaschine baust oder komplette Seitenstrukturen kartieren musst, sind Web Scraping Tools für die meisten Unternehmen die bessere Wahl.

Hier kommt ins Spiel. Als Mitgründer und CEO bin ich vielleicht etwas voreingenommen, aber ich bin überzeugt: Thunderbit ist der einfachste Weg für Nicht-Techniker, Webdaten zu extrahieren.

Warum Thunderbit?

- In zwei Klicks startklar: „KI-Felder vorschlagen“ und dann „Scrapen“ – fertig.

- KI-gestützt: Thunderbit erkennt automatisch die wichtigsten Datenfelder (z. B. Produktnamen, Preise, Bilder).

- Bulk- & PDF-Support: Daten von aktuellen Seiten, mehreren URLs oder sogar PDFs extrahieren.

- Flexible Exporte: Als CSV/JSON herunterladen oder direkt an Google Sheets, Airtable oder Notion senden.

- Kein Code nötig: Wer einen Browser bedienen kann, kann auch Thunderbit nutzen.

- Unterseiten scrapen: Mehr Details nötig? Thunderbit besucht automatisch Unterseiten und reichert die Daten an.

- Zeitplanung: Wiederkehrende Scrapes in Klartext einrichten (z. B. „jeden Montag um 9 Uhr“).

Wann ist ein Crawler sinnvoller?

Wenn du eine komplette Website kartieren willst (z. B. für einen Suchindex oder eine Sitemap), ist ein Crawler das richtige Werkzeug. Geht es aber um strukturierte Daten von bestimmten Seiten (z. B. Produktlisten, Bewertungen oder Kontaktdaten), ist Scraping schneller, einfacher und effizienter.

Fazit & wichtigste Erkenntnisse

Kurz und knapp:

- Web Crawling ist die Methode, mit der Suchmaschinen und große Datenprojekte das Web entdecken und kartieren. Es geht um die Breite – möglichst viele Seiten finden.

- Web Scraping geht in die Tiefe – gezielt die Daten extrahieren, die wirklich gebraucht werden. Für die meisten Unternehmen ist Scraping relevanter als Crawling.

- Eigene Crawler lassen sich programmieren (Python eignet sich super), aber das kostet Zeit, Know-how und Pflegeaufwand.

- No-Code- und KI-Tools wie Thunderbit machen die Webdatenerfassung für alle zugänglich – ganz ohne Programmierung.

- Best Practices sind wichtig: Immer verantwortungsvoll crawlen und scrapen, Website-Regeln respektieren und Daten ethisch nutzen.

Wer gerade erst startet, sollte sich ein kleines Projekt suchen – zum Beispiel Produktpreise scrapen oder Leads aus einem Verzeichnis sammeln. Mit Tools wie Thunderbit gelingt der Einstieg schnell, oder du probierst Python aus, wenn du tiefer einsteigen willst.

Das Web ist eine wahre Schatzkammer an Informationen. Mit dem richtigen Ansatz lassen sich daraus wertvolle Erkenntnisse gewinnen, Zeit sparen und das eigene Unternehmen nach vorne bringen.

FAQ

- Was ist der Unterschied zwischen Web Crawling und Web Scraping?

Crawling findet und kartiert Seiten. Scraping extrahiert gezielt Daten daraus. Crawling = Entdecken; Scraping = Sammeln.

- Ist Web Scraping legal?

Das Extrahieren öffentlicher Daten ist meist erlaubt, solange robots.txt und die Nutzungsbedingungen eingehalten werden. Private oder urheberrechtlich geschützte Inhalte sollten gemieden werden.

- Muss ich programmieren können, um Websites zu scrapen?

Nein. Mit Tools wie geht das per Klick und KI – ganz ohne Code.

- Warum ist nicht das ganze Web bei Google indexiert?

Weil viele Inhalte hinter Logins, Bezahlschranken oder Sperren liegen. Nur etwa 4 % sind tatsächlich indexiert.