In der heutigen B2B-Welt dreht sich alles um frische, verlässliche Daten. Egal ob CRM, Preisstrategie oder Marktanalyse – sie sind nur so gut wie die Daten, die sie füttern. Und woher kommen die besten Infos? Richtig, von öffentlichen Webseiten. Im Jahr 2025 ist Web-Extraktion längst nicht mehr nur ein Thema für IT-Nerds – sie ist Alltag für Sales-, Marketing- und Operations-Teams, die aus dem wilden Internet-Chaos strukturierte, nutzbare Daten machen wollen. Mit dem passenden Web-Extractor wird aus dem nervigen Copy-Paste-Marathon ein entspannter Workflow: Während du gemütlich deinen Kaffee schlürfst, baut das Tool im Hintergrund schon die nächste Lead-Liste.

Du willst datengetrieben arbeiten, aber keine Lust auf Programmieren? Dann bist du hier goldrichtig. Nach vielen Jahren in SaaS, Automatisierung und KI – unter anderem bei Automation Anywhere, Jet.com und jetzt als Mitgründer von Thunderbit – habe ich hautnah erlebt, wie sich Web-Extractor von Nischenlösungen zu echten Gamechangern für Unternehmen entwickelt haben. In diesem Guide stelle ich dir die 12 besten Web-Extractor für 2025 vor – von smarten KI-Tools bis zu bewährten Browser-Erweiterungen. So findest du garantiert das richtige Tool für dein Team und deine Anforderungen.

Warum Web-Extractor 2025 für Unternehmen ein Muss sind

Klar ist: Das Internet ist die größte (und chaotischste) Datenbank der Welt. Und 2025 gewinnen die Unternehmen, die aus diesem Chaos echte Erkenntnisse ziehen. Laut sind datengetriebene Firmen 5 % produktiver und 6 % profitabler als ihre Konkurrenz. Das ist ein echter Vorsprung.

Web-Extractor (auch Web-Page-Extractor oder Web-Extraktionslösungen genannt) sind dabei das Geheimrezept. Sales-Teams können öffentliche Verzeichnisse, Social Media und Firmenwebseiten gezielt durchsuchen und so hochwertige Lead-Listen erstellen – ganz ohne veraltete Adresslisten oder mühsames Copy-Paste (). Marketing- und E-Commerce-Teams nutzen Web-Extractor, um Preise der Konkurrenz zu überwachen, Lagerbestände zu checken und Produkte in Echtzeit zu vergleichen – John Lewis etwa verdankt Web Scraping einen 4 % höheren Umsatz durch clevere Preisgestaltung ().

Aber es geht nicht nur um Zahlen. Web-Extractor sparen richtig viel Zeit (ein Nutzer sprach von „hunderten gesparten Stunden“ durch automatisierte Datenerfassung) und minimieren Fehler (). Operations-Teams nutzen heute Scraper, um Daten zu sammeln, für die früher Praktikanten wochenlang schuften mussten – so bleibt mehr Zeit für die wirklich wichtigen Aufgaben (). Dank KI-gestützter Tools können sogar Nicht-Techniker Webseiten in strukturierte Daten für Analysen verwandeln ().

Kurz gesagt: Wer 2025 keinen Web-Extractor nutzt, lässt wertvolle Insights – und bares Geld – liegen.

So haben wir die 12 besten Web-Extractor ausgewählt

Bei der riesigen Auswahl fragt man sich: Welcher Web-Extractor passt zu mir? Ich habe Dutzende Tools getestet, aber nur 12 haben es in diese Liste geschafft. Das waren meine wichtigsten Kriterien:

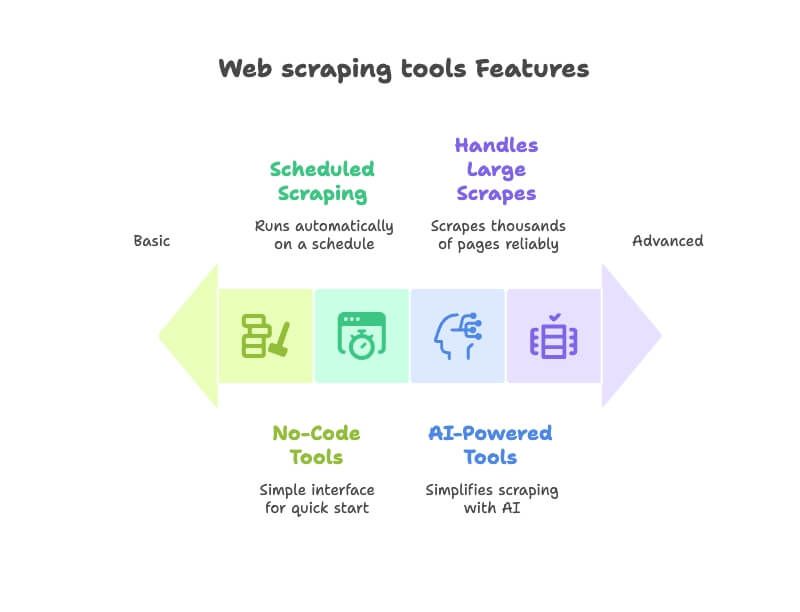

- Benutzerfreundlichkeit: Kann auch jemand ohne Technik-Know-how direkt loslegen? Im Fokus standen No-Code- oder Low-Code-Tools mit intuitiver Bedienung ().

- KI-Funktionen: Moderne Tools, die KI nutzen, um das Extrahieren zu vereinfachen – etwa durch automatische Felderkennung, Navigation oder die Möglichkeit, Anforderungen in Alltagssprache zu formulieren ().

- Automatisierung & Zeitplanung: Die besten Web-Extractor laufen vollautomatisch. Ich habe Tools ausgewählt, die wiederkehrende Extraktionen oder Website-Monitoring unterstützen ().

- Datenexport & Integration: Lässt sich das Ergebnis einfach nach Excel, Google Sheets, Airtable oder Notion exportieren? Pluspunkte gab es für Workflow-Integrationen ().

- Skalierbarkeit & Zuverlässigkeit: Egal ob eine Seite oder tausende – diese Tools sind für jede Größenordnung geeignet. Nutzerbewertungen zur Zuverlässigkeit wurden ebenfalls berücksichtigt.

- Business-Fokus: Im Mittelpunkt standen Tools, die besonders bei Sales-, Marketing-, E-Commerce- und Operations-Teams beliebt sind – nicht nur bei Entwicklern.

Einige der Tools sind brandneue KI-Lösungen, andere seit Jahren bewährte Klassiker. Sie alle helfen dir dabei, das Web in deine persönliche Geschäftsdatenbank zu verwandeln – ganz ohne Kopfschmerzen.

Schneller Vergleich: Die wichtigsten Web-Extractor im Überblick

Hier findest du eine kompakte Übersicht der 12 vorgestellten Web-Extractor – so siehst du auf einen Blick, welches Tool wofür geeignet ist:

| Tool | KI-Automatisierung | Benutzerfreundlichkeit | Bester Anwendungsfall |

|---|---|---|---|

| Thunderbit | Ja – KI schlägt Felder vor und navigiert automatisch | Sehr einfach (Chrome-Erweiterung, kein Code) | Schnelles Extrahieren von Leads, Preisen etc. für Nicht-Techniker, die in Minuten Ergebnisse wollen. |

| Octoparse | Eingeschränkt (Vorlagenbasiert, keine KI) | Einfach (visuelle Drag-and-Drop-Oberfläche) | Individuelle Extraktions-Workflows (mit Logins, Paginierung) für Analysten ohne Programmierkenntnisse. |

| Browse AI | Teilweise – Point-and-Click-„Roboter“ | Einfach (No-Code, Cloud-basiert) | Automatisiertes Monitoring von Daten (Preise, Listings etc.) mit Zeitplan, Benachrichtigungen und Integrationen. |

| WebScraper.io | Nein (manuelle Konfiguration) | Mittel (Browser-Erweiterung mit Sitemap-Erstellung) | Visuelles Extrahieren von mehrstufigen Webseiten für Nutzer, die bereit sind, Schritte zu konfigurieren. |

| ScraperAPI | N/A (API-Service, Proxys via API) | Programmierkenntnisse erforderlich (API-Integration) | Großvolumige Web-Datenextraktion für Tech-Teams – Proxys & CAPTCHAs werden für große Projekte automatisch gehandhabt. |

| Data Miner | Nein | Sehr einfach (Browser-Erweiterung mit 1-Klick-Vorlagen) | Schnelle Einzelextraktion von Seiten (insbesondere Tabellen oder Listen) direkt in CSV/Excel. |

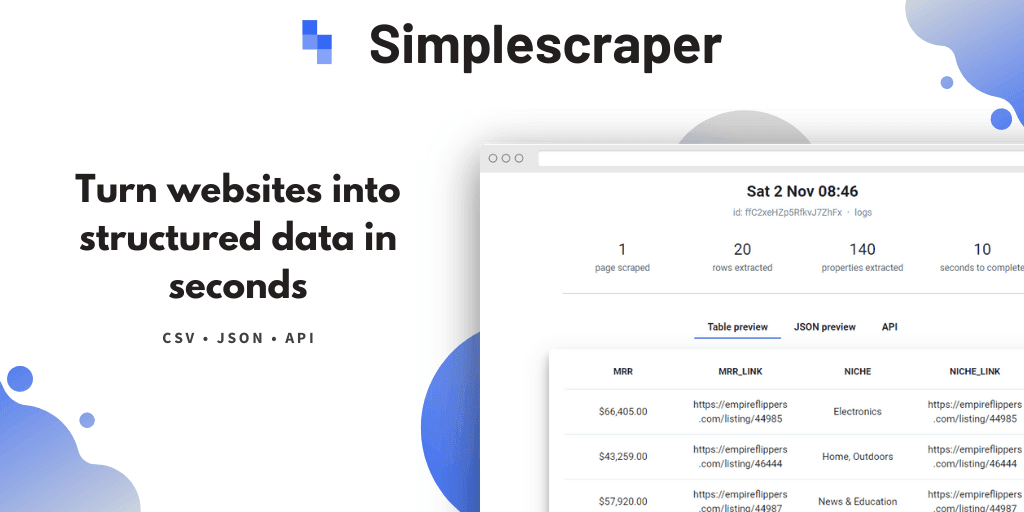

| Simplescraper | Nein (teilweise KI-gestützte Features) | Einfach (Point-and-Click-Rezept-Builder) | No-Code-Extraktion mit Integrationen – ideal für die Übertragung von Webdaten in Google Sheets, Airtable oder per API. |

| Instant Data Scraper | Ja – erkennt Datentabellen automatisch | Sehr einfach (nur klicken, keine Einrichtung) | Sofortige, kostenlose Extraktion von HTML-Tabellen und Listen für jedermann (perfekt für schnelle Datenabfragen). |

| ScrapeStorm | Ja – KI erkennt Seitenelemente | Einfach (visuelle Oberfläche; plattformübergreifende App) | Großvolumige oder komplexe Extraktionsprojekte ohne Programmierung, inkl. geplanter Crawls. |

| Apify | Teilweise – vorgefertigte „Actor“-Bots verfügbar | Mittel (Web-Oberfläche; Programmierung optional) | Skalierbares Cloud-Scraping und Automatisierung via fertigen oder eigenen Skripten. |

| ParseHub | Nein (skriptlos, aber manuelle Einrichtung) | Einfach für Basisanwendungen (visueller Editor; Desktop-App) | Extraktion dynamischer oder komplexer Seiten (AJAX-Inhalte) über eine No-Code-Oberfläche. |

| OutWit Hub | Nein | Einfach (Desktop-GUI-Anwendung) | Einfache, lokale Datenerfassung und Inhaltsarchivierung für kleine Projekte. |

Die meisten Tools bieten eine kostenlose Version oder Testphase sowie gestaffelte Abos. Im Fokus stehen hier die Funktionen und Anwendungsfälle, nicht der Preis.

Thunderbit: Der KI-gestützte Web-Extractor für alle

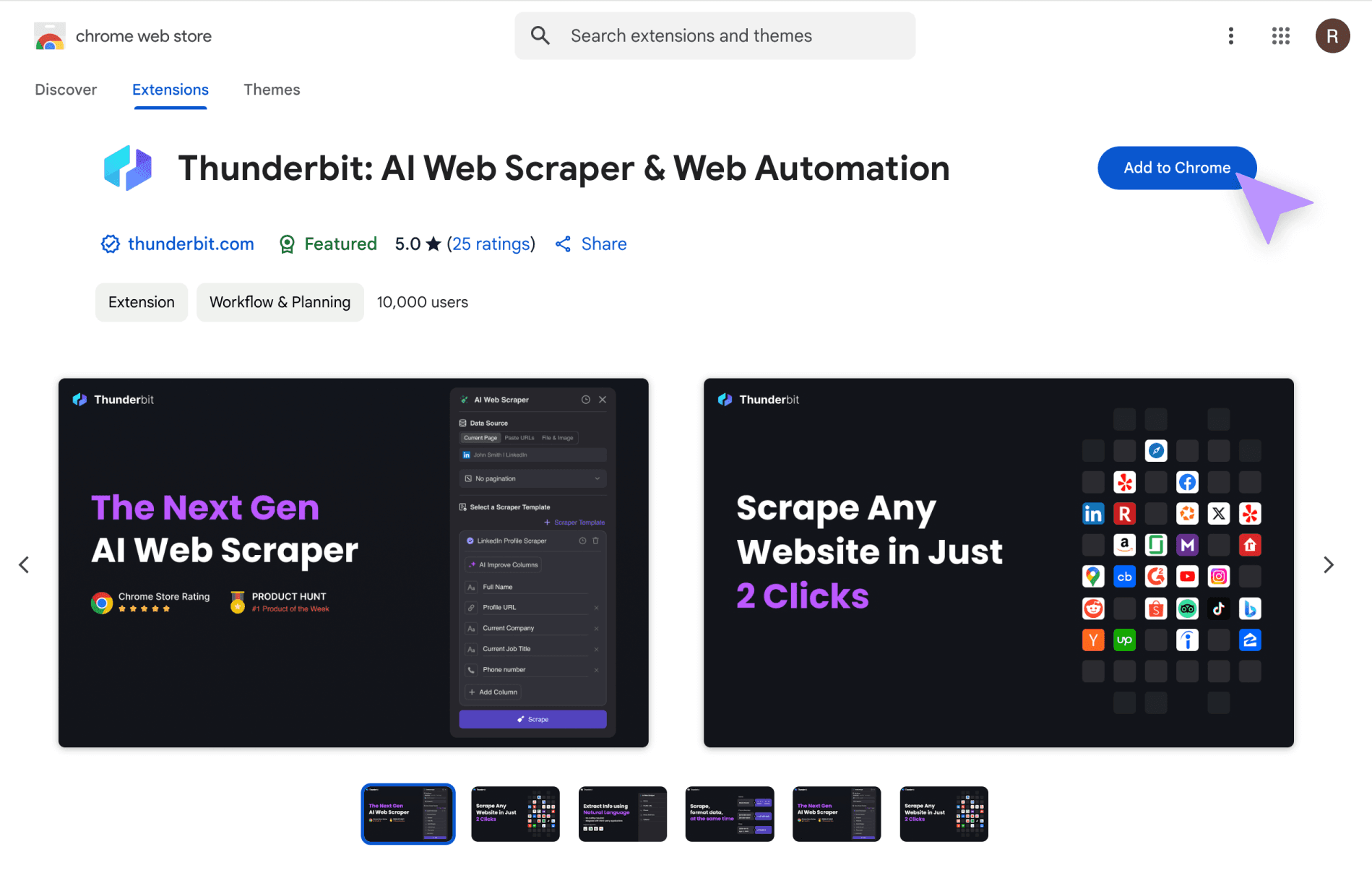

Fangen wir mit Thunderbit an – ja, das ist mein eigenes Baby, aber es lohnt sich wirklich! Die Branche entwickelt sich vom „konfiguriere deinen eigenen Scraper“ hin zu „sag der KI einfach, was du brauchst“. Thunderbit fühlt sich an wie ein KI-Datenassistent – nicht wie ein weiterer „Crawler“.

Mit musst du dich nicht mit XPath, CSS-Selektoren oder Regex rumschlagen. Du beschreibst einfach in Alltagssprache, welche Daten du willst – zum Beispiel „Titel, Autor und Datum dieser Seite extrahieren“ – und die KI macht den Rest (). Ein Klick auf „KI-Felder vorschlagen“ reicht, und Thunderbit liest die Seite, schlägt Spalten vor und übernimmt sogar Unterseiten und Paginierung automatisch ().

Thunderbit kann aber noch mehr: Felder bereinigen, transformieren, kategorisieren und sogar direkt übersetzen. Du willst Telefonnummern vereinheitlichen, Beschreibungen zusammenfassen oder Produktnamen übersetzen? Einfach eine kurze Anweisung dazu – die KI erledigt das. Danach kannst du die Daten direkt nach Excel, Google Sheets, Airtable oder Notion exportieren ().

Das Beste: Thunderbit ist sofort einsatzbereit, ohne Lernaufwand. Als Chrome-Erweiterung ist das Tool in Sekunden startklar – keine Plugins, keine Konfiguration, kein Technik-Kauderwelsch. Deshalb ist Thunderbit besonders bei Sales-, Marketing- und Operations-Teams beliebt, die schnell Ergebnisse brauchen (). Die kostenlose Version bietet den vollen Workflow zum Testen, und die Bezahlpläne sind fair (oft günstiger als der monatliche Kaffeekonsum eines Teams).

Wer erleben will, wie sich KI-gestützte Web-Extraktion 2025 anfühlt, sollte die ausprobieren. Die Zeiten von Copy-Paste sind damit endgültig vorbei.

Octoparse: Visueller Web-Extractor für individuelle Workflows

Octoparse ist ein Klassiker unter den visuellen Web-Scraping-Tools. Die Desktop-App bietet eine Point-and-Click-Oberfläche: Du klickst dich durch die Webseite, wählst die gewünschten Daten aus, und Octoparse baut im Hintergrund den Workflow (). Logins, Paginierung und sogar Formulare lassen sich ohne Programmierung automatisieren.

Ein Highlight ist die Bibliothek mit über 500 Vorlagen für bekannte Seiten (Amazon, Twitter, LinkedIn usw.), sodass du oft direkt loslegen kannst (). Für komplexere Seiten kannst du in den manuellen Modus wechseln und jeden Schritt visuell konfigurieren. Octoparse unterstützt auch das Extrahieren von Inhalten, die erst nach Klicks oder Scrollen geladen werden, und kann Proxys sowie CAPTCHAs für schwierige Fälle handhaben. Es gibt zudem eine Cloud-Option für geplante und großvolumige Extraktionen.

Der Nachteil: Für fortgeschrittene Szenarien ist eine gewisse Einarbeitung nötig. Für Nicht-Programmierer und Datenanalysten, die individuelle Extraktions-Workflows ohne Code suchen, ist Octoparse aber eine sehr gute Wahl ().

Browse AI: Automatisierte Web-Extraktion mit vorgefertigten Robotern

Browse AI setzt auf einen spielerischen Ansatz: Du trainierst einen „Roboter“, indem du die gewünschten Daten auf der Seite anklickst, und das Tool lernt, diese Daten auch auf ähnlichen Seiten zu extrahieren (). Alles läuft cloudbasiert und ohne Code – du musst dich nicht um Skripte oder Server kümmern.

Das Besondere an Browse AI ist die Automatisierung und Überwachung. Du kannst deine Roboter regelmäßig ausführen lassen und bekommst Benachrichtigungen, wenn sich Daten ändern (z. B. wenn ein Konkurrent den Preis senkt oder ein neues Stellenangebot erscheint). Es gibt auch eine Bibliothek mit vorgefertigten Robotern für gängige Aufgaben – oft reicht es, eine Vorlage zu wählen und bei Bedarf anzupassen ().

Browse AI lässt sich mit Tausenden Apps über Zapier und Make verbinden und exportiert Daten direkt nach Google Sheets oder per API/Webhooks (). Ideal für kontinuierliches Monitoring und wiederkehrende Datenerfassung, besonders wenn du Wert auf Benachrichtigungen und Integrationen legst.

WebScraper.io: Browserbasierter Web-Page-Extractor

WebScraper.io (oft einfach „Web Scraper“ genannt) ist eine Browser-Erweiterung, mit der du sogenannte „Sitemaps“ erstellst – also visuelle Pläne, wie eine Website zu navigieren ist und welche Elemente extrahiert werden sollen (). Du definierst Selektoren für die gewünschten Daten und die zu folgenden Links (z. B. „Nächste Seite“-Button oder Produktlinks für Details).

Es gibt eine gewisse Lernkurve, aber du musst keinen Code schreiben – nur Seitenelemente auswählen und Extraktionsaktionen festlegen. Web Scraper unterstützt mehrstufige Navigation, Paginierung und sogar unendliches Scrollen (diese Schritte müssen aber manuell angegeben werden). Das Tool ist flexibel und läuft direkt im Browser, sodass du auch Seiten hinter einem Login extrahieren kannst.

WebScraper.io eignet sich besonders für „Citizen Data Analysts“, die sich mit Webseitenstrukturen auskennen und ein kostenloses, flexibles Tool suchen. Ein zuverlässiger Allrounder, wenn du bereit bist, eigene Sitemaps zu konfigurieren.

ScraperAPI: API-basierter Web-Extractor für Entwickler und Teams

Nicht jedes Team braucht eine Point-and-Click-Oberfläche – manchmal soll Webdaten-Extraktion direkt ins Backend oder in eigene Apps fließen. ScraperAPI ist ein API-first Web-Extractor: Du gibst eine URL an, bekommst das rohe HTML oder extrahierte Daten zurück, und das Tool übernimmt Proxys, Geo-IP-Rotation, Headless-Browser und CAPTCHAs für dich ().

ScraperAPI betreibt ein Netzwerk von über 40 Millionen Proxys in mehr als 50 Ländern und verarbeitet 36 Milliarden Anfragen pro Monat (). Ideal für großvolumige, automatisierte Extraktion, bei der Zuverlässigkeit und Anti-Blocking entscheidend sind. Du brauchst etwas Programmiererfahrung, aber für Datenpipelines oder die Integration in eigene Produkte ist ScraperAPI eine Top-Wahl.

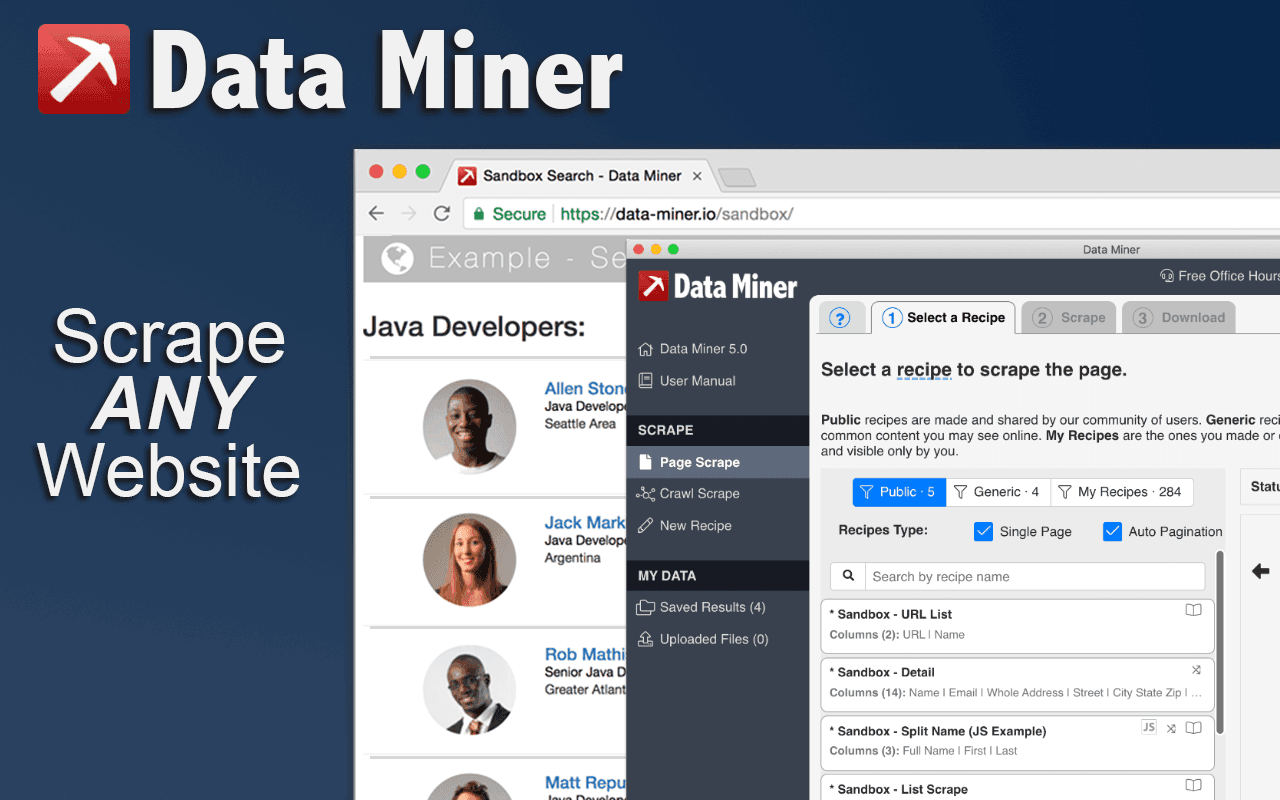

Data Miner: Chrome-Erweiterung für schnelle Web-Extraktion

Data Miner ist eine Chrome-Erweiterung für Business-Anwender und Forscher, die schnell Daten erfassen möchten. Sie bietet eine Point-and-Click-Bedienung und eine Bibliothek mit vorgefertigten „Rezepten“ für gängige Muster wie Tabellen, Listen oder bestimmte Webseiten ().

Einfach die Erweiterung installieren, zur Zielseite gehen und das Data Miner-Icon anklicken. Wähle ein Rezept oder erstelle dein eigenes, indem du Elemente auf der Seite markierst. Perfekt für Einzelaufgaben oder schnelle Datenbedarfe – etwa für Sales, die eine Lead-Liste aus einem Online-Verzeichnis ziehen, oder E-Commerce-Manager, die Preise der Konkurrenz erfassen.

Data Miner ist unkompliziert, läuft direkt im Browser und eignet sich super für interaktive, spontane Extraktionen.

Simplescraper: No-Code Web-Extractor für sofortige Ergebnisse

Simplescraper macht seinem Namen alle Ehre. Es ist eine No-Code Chrome-Erweiterung (und Web-App), mit der du Daten visuell auf einer Seite auswählst und daraus ein „Rezept“ für die Extraktion erstellst (). Du kannst Links zu Unterseiten folgen, Paginierung einrichten und deine Extraktion mit einem Klick in eine API verwandeln.

Die Stärke von Simplescraper liegt in den Integrationsmöglichkeiten – du kannst Daten direkt an Google Sheets, Airtable oder Tools wie Zapier senden (). Es gibt auch Cloud-Scraping und Zeitplanung für wiederkehrende Aufgaben sowie ein „AI Enhance“-Feature, um Daten mit GPT zu bereinigen oder zu analysieren.

Wer schnelle Ergebnisse und einfache Integrationen sucht, findet in Simplescraper das Schweizer Taschenmesser der leichten Web-Extraktion.

Instant Data Scraper: Schnelle Web-Extraktion für Tabellen und Listen

Manchmal braucht man die Daten sofort – ohne Setup. Genau dafür gibt es Instant Data Scraper (IDS). Die kostenlose Chrome-Erweiterung ist bekannt für ihre 1-Klick-Extraktion von Tabellendaten (). Nach Aktivierung erkennt IDS automatisch Tabellen oder Listen auf der Seite. Auch Paginierung und unendliches Scrollen werden durch automatisches Klicken auf alle Seiten unterstützt.

IDS ist 100 % kostenlos, ohne Anmeldung, ohne Programmierung, ohne Wartezeit. Perfekt für spontane oder dringende Extraktionen – etwa für Sales, die schnell eine Lead-Liste brauchen, oder Studierende, die Wikipedia-Tabellen extrahieren möchten. Wenn IDS deine Daten erkennt, hast du sie in Sekunden.

ScrapeStorm: Cloudbasierter Web-Extractor mit KI-Unterstützung

ScrapeStorm ist ein KI-gestütztes Web-Scraping-Tool, das eine visuelle Oberfläche mit starken KI-Algorithmen kombiniert (). Du gibst eine URL ein, und die KI erkennt automatisch Datenfelder – Listen, Tabellen, „Nächste Seite“-Buttons und mehr.

ScrapeStorm läuft plattformübergreifend (Windows, Mac, Linux) und bietet sowohl Desktop- als auch Cloud-Scraping. Du kannst Aufgaben planen, mehrere Jobs parallel ausführen und Daten in Excel, CSV, JSON oder direkt in eine Datenbank exportieren (). Besonders beliebt ist das Tool für E-Commerce und Marktforschung und kann sogar Daten aus Bildern oder PDFs per KI extrahieren.

Wer einen smarten Assistenten für große oder komplexe Extraktionsprojekte sucht, sollte ScrapeStorm testen.

Apify: Web-Extractor-Marktplatz und Automatisierungsplattform

Apify ist mehr als nur ein Scraper – es ist eine Plattform für Web-Scraping und Automatisierung. Du kannst sogenannte „Actors“ ausführen, also Skripte für Extraktion oder Browser-Automatisierung. Das Besondere ist der Marktplatz mit vorgefertigten Actors für gängige Aufgaben (). Du willst alle Bewertungen eines Shops extrahieren? Es gibt wahrscheinlich schon einen Actor dafür.

Für Entwickler bietet Apify die Möglichkeit, eigene Scraper in Node.js oder Python zu schreiben und in der Cloud auszuführen. Die Plattform ist skalierbar, automatisierbar und lässt sich per API integrieren. Apify eignet sich besonders für Power-User und Unternehmen, die Webdaten als strategische Ressource betrachten – etwa für laufende, großvolumige Extraktionen oder die Integration in eigene Datenpipelines.

ParseHub: Visueller Web-Page-Extractor für komplexe Seiten

ParseHub ist eine Desktop-App (mit Cloud-Optionen), die für die Extraktion komplexer, dynamischer Webseiten bekannt ist. Du navigierst durch die Seite in einer browserähnlichen Oberfläche, klickst auf die gewünschten Datenpunkte, und ParseHub erstellt deinen Scraper (). Das Tool unterstützt Bedingungen, verschachtelte Extraktionen, AJAX-Inhalte und mehr.

ParseHub ist oft die Lösung, wenn andere Tools an einer Seite scheitern. Es wird von Forschern, Analysten und kleinen Unternehmen genutzt, die auch schwierige Webseiten ohne Programmierung extrahieren möchten. Die Einarbeitung ist etwas aufwendiger, aber für komplexe Seiten ohne Coding ist ParseHub eine Top-Option.

OutWit Hub: Desktop-Web-Extractor für Content-Archivierung

OutWit Hub ist ein bisschen oldschool, aber als Desktop-Anwendung ideal, um verschiedene Inhalte (Links, Bilder, E-Mail-Adressen usw.) systematisch zu erfassen und zu organisieren (). Es funktioniert wie ein Browser mit Tabellenfunktion – du surfst zur Seite, und OutWit Hub extrahiert Tabellen, Listen, Bilder und mehr.

Besonders praktisch ist das Tool für Content-Archivierung oder Recherche – etwa um alle Beiträge eines Forums zu sichern oder eine Dateisammlung herunterzuladen. Als lokale Desktop-Lösung behältst du die volle Kontrolle über deine Daten. OutWit Hub eignet sich am besten für kleine bis mittlere Extraktionsaufgaben, bei denen du eine einfache Desktop-Oberfläche bevorzugst.

Welcher Web-Extractor passt zu deinen Anforderungen?

Zwölf Tools, tausend Anwendungsfälle – aber welches ist das richtige? Hier ein kleiner Wegweiser:

-

Für absolute Einsteiger oder schnelle Einzelaufgaben:

Instant Data Scraper ist ideal für einfache Tabellen und Listen (kostenlos und sofort einsatzbereit). Data Miner bietet mehr Vorlagen, falls du regelmäßig ähnliche Seiten extrahierst.

-

Für Nicht-Techniker, die regelmäßig extrahieren oder integrieren möchten:

Thunderbit bietet mit seinem KI-Ansatz den einfachsten Workflow – perfekt für Business-Anwender, die schnell und häufig Ergebnisse brauchen. Browse AI eignet sich für kontinuierliches Monitoring und Benachrichtigungen. Simplescraper ist optimal, wenn du Daten direkt in Google Sheets oder per API weiterleiten möchtest.

-

Für komplexe Webseiten oder individuelle Workflows ohne Programmierung:

Setz auf visuelle Tools wie Octoparse oder ParseHub. Octoparse ist besonders einsteigerfreundlich und bietet viele Vorlagen. ParseHub meistert auch sehr komplexe, dynamische Seiten. WebScraper.io ist ebenfalls eine gute Wahl, wenn du eigene Sitemaps konfigurieren möchtest.

-

Für Entwickler oder Dateningenieure mit großem Bedarf:

ScraperAPI ist ideal, um Web-Extraktion in eigene Software einzubinden oder große Projekte umzusetzen. Apify eignet sich, wenn du eine skalierbare Plattform mit Marktplatz für fertige oder eigene Skripte suchst.

-

Für umfangreiche Inhaltsarchivierung oder Offline-Nutzung:

OutWit Hub ist die richtige Wahl, wenn du Inhalte systematisch sammeln und archivieren möchtest – besonders als Desktop-Tool für mehr Datenschutz und Kontrolle.

Viele Teams nutzen übrigens mehrere Tools, je nach Aufgabe. Für einfache Extraktionen eignet sich Instant Data Scraper, für größere Projekte Thunderbit oder Octoparse, und für professionelle Datenpipelines ScraperAPI oder Apify. Das Beste: Fast alle Tools bieten eine kostenlose Version oder Testphase – probier einfach aus, was zu dir passt.

Fazit: Die Zukunft der Web-Extraktion für Business-Teams

Web-Extractor haben sich rasant weiterentwickelt – 2025 sind sie Standard. Der große Trend: Web Scraping wird einfacher, automatisierter und nahtlos in den Arbeitsalltag integriert (). Dank KI-gestützter Tools lassen sich selbst komplexe, dynamische Webseiten ohne Spezialwissen auslesen. Wie ein Dateningenieur es ausdrückte: „Seit es KI-Web-Scraping-Tools gibt, erledige ich Aufgaben viel schneller und in größerem Umfang ... und mit KI ist [die Datenbereinigung] direkt im Workflow enthalten.“

Ein weiterer Wandel: Die Grenzen zwischen Extraktion, Monitoring und Automatisierung verschwimmen. Tools wie Browse AI und Thunderbit extrahieren nicht nur Daten, sondern halten sie auch aktuell und können sogar Aktionen auslösen (z. B. Formulare ausfüllen oder Benachrichtigungen senden). Die Nutzung steigt rasant – eine große Plattform verzeichnete über 140 % mehr aktive Nutzer pro Monat innerhalb eines Jahres (). Unternehmen jeder Größe erkennen, dass der Zugang zu öffentlichen Webdaten (ethisch und rechtlich korrekt) entscheidend für die Wettbewerbsfähigkeit ist.

Für Business-Teams heißt das: Mehr Eigenständigkeit. Du musst nicht mehr auf Entwickler warten oder dich auf dein Bauchgefühl verlassen. Die hier vorgestellten Tools geben dir die Kontrolle über Webdaten – mit Features, die auf echte Anwendungsfälle in Sales, Marketing, Operations und mehr zugeschnitten sind. Und mit der rasanten Entwicklung werden die Tools noch benutzerfreundlicher, die KI noch smarter und die Integration mit BI- und Analyseplattformen noch tiefer.

Wichtig: Beachte die Nutzungsbedingungen und robots.txt der Webseiten und halte dich an Datenschutzgesetze. Nur so bleibt Web-Extraktion nachhaltig und fair.

Ob du mit einer kostenlosen Erweiterung startest oder eine professionelle Lösung einsetzt – es war nie einfacher, das Potenzial des Webs für dein Unternehmen zu nutzen. Die Web-Extractor-Revolution ist da – wähle ein Tool, probier es aus und entdecke die verborgenen Schätze im Netz. Deine datengetriebene Zukunft ist nur einen Klick entfernt.

FAQs

1. Was ist ein Web-Extractor und warum ist er 2025 für Unternehmen wichtig?

Ein Web-Extractor ist ein Tool, das automatisch strukturierte Daten von Webseiten sammelt. 2025 ist das entscheidend, weil Unternehmen so aus unübersichtlichen Online-Infos verwertbare Erkenntnisse gewinnen – das steigert Produktivität, Profitabilität und spart manuelle Datenerfassung.

2. Wer kann Web-Extractor nutzen – brauche ich technisches Know-how?

Für viele moderne Web-Extractor brauchst du keine Technikkenntnisse. Tools wie Thunderbit, Browse AI und Instant Data Scraper sind speziell für Nicht-Techniker gemacht – mit intuitiver Bedienung, KI-Automatisierung und No-Code-Workflows.

3. Wie profitieren Sales-, Marketing- und Operations-Teams von Web-Extractor?

Sales kann Lead-Listen aus Online-Verzeichnissen erstellen, Marketing kann Preise der Konkurrenz überwachen und Operations kann die Datenerfassung automatisieren. Diese Tools sparen Zeit, reduzieren Fehler und liefern aktuelle, zuverlässige Insights für strategische Entscheidungen.

4. Worauf sollte ich bei der Auswahl eines Web-Extractor achten?

Wichtige Kriterien sind Benutzerfreundlichkeit, KI-Funktionen, Automatisierung/Planung, Integration mit Tools wie Google Sheets oder Airtable, Skalierbarkeit und Relevanz für deinen Anwendungsfall (z. B. Leads, Preisüberwachung, Inhaltsarchivierung).

5. Gibt es kostenlose oder günstige Web-Extractor?

Ja, viele Web-Extractor bieten kostenlose Versionen oder günstige Tarife. Instant Data Scraper ist für Basisaufgaben komplett kostenlos, während Tools wie Thunderbit, Simplescraper und Data Miner großzügige Gratispläne mit Upgrade-Optionen bieten.

Du willst mehr über Web-Extraktion, KI-Scraping oder die Nutzung von Webdaten für dein Team erfahren? Im findest du weitere Guides, Tipps und Praxisberichte aus der Welt der Datenautomatisierung.