Springen wir mal kurz zurück ins Jahr 2015: Damals gab’s beim Thema Webdaten-Extraktion eigentlich nur zwei Wege – entweder du hast einen Entwickler angebettelt, dir ein Python-Skript zu schreiben, oder du hast dein Wochenende damit verbracht, XPath zu lernen (nur um’s am Montag wieder zu vergessen). Heute sieht das Ganze komplett anders aus: KI und LLMs haben das Spielfeld auf links gedreht. Web Scraping ist keine technische Hürde mehr, sondern eine Aufgabe, die sogar Kolleg:innen aus Vertrieb oder Marketing mit ein paar Klicks erledigen können.

Ich hab die Entwicklung der Web-Scraping-Branche über Jahre miterlebt – von fehleranfälligen Skripten bis hin zu stabilen, KI-gestützten Tools. Die Nachfrage nach Webdaten explodiert: Über – von Startups bis zu den ganz Großen wie Google – setzen mittlerweile auf Web Scraping, um wertvolle Insights zu gewinnen. Der Markt steuert auf ein Volumen von zu und wird sich bis 2030 vermutlich verdoppeln. Der größte Gamechanger? KI-Web-Crawler, bei denen du einfach in Alltagssprache beschreibst, was du brauchst – und die KI macht den Rest.

Egal ob Entwickler:in, Business-Anwender:in oder einfach jemand, der keine Lust mehr auf Copy & Paste hat: Hier kommen meine Top 15 KI-Web-Crawler für 2025 – inklusive einer ausführlichen Erklärung, warum Thunderbit (ja, das Unternehmen, das ich mitgegründet habe) ganz oben steht.

Warum KI das Web Scraping revolutioniert: Die neue Generation der Web-Scraper-Tools

Mal ehrlich: Klassisches Web Scraping war nie für normale Business-Anwender gedacht. Es drehte sich alles um Code, Selektoren und die Hoffnung, dass das Skript beim nächsten Website-Update nicht abstürzt. KI und LLMs haben das komplett auf den Kopf gestellt.

So läuft’s heute ab:

- Anweisungen in natürlicher Sprache: Statt Code zu schreiben, sagst du der KI einfach, was du willst. Tools wie verstehen deine Beschreibung und richten die Extraktion automatisch ein ().

- Anpassungsfähiges Lernen: KI-Scraper können sich auf Webseiten anpassen und reduzieren so den Wartungsaufwand.

- Dynamische Inhalte meistern: Moderne Websites setzen auf JavaScript und endloses Scrollen. KI-Tools interagieren mit diesen Elementen und holen Daten, die klassische Scraper oft übersehen.

- Strukturierte Ergebnisse dank KI-Parsing: LLM-basierte Scraper und liefern saubere, strukturierte Daten.

- Automatische Anti-Bot-Umgehung: KI-Scraper können und nutzen Proxys oder Headless-Browser, um IP-Sperren zu vermeiden.

- Integrierte Daten-Workflows: Die besten Tools liefern die Daten direkt dorthin, wo du sie brauchst – mit einem Klick in Google Sheets, Airtable, Notion und mehr ().

Das Ergebnis? Web Scraping ist heute so einfach wie Point-and-Click – oder sogar wie ein Chat. Damit können jetzt auch Teams aus Vertrieb, Marketing und Operations direkt auf Webdaten zugreifen, nicht nur Entwickler:innen.

Die 15 besten KI-Web-Crawler für Web Scraping im Jahr 2025

Hier kommen die Top 15 KI-Web-Crawler – los geht’s mit Thunderbit. Zu jedem Tool gibt’s die wichtigsten Features, Zielgruppen, Preise und Besonderheiten. Und ja, ich spreche auch offen über Stärken und Schwächen.

1. Thunderbit: Der KI-Web-Scraper für alle

Klar, ich bin hier ein bisschen voreingenommen, aber Thunderbit ist der KI-Web-Scraper, den ich mir schon vor Jahren gewünscht hätte. Deshalb steht er auf Platz 1:

- Extraktion in natürlicher Sprache: Du „chattest“ mit Thunderbit. Einfach beschreiben, welche Daten du brauchst – zum Beispiel „alle Produktnamen und Preise von dieser Seite extrahieren“ – und die KI macht den Rest (). Kein Code, keine Selektoren, kein Stress.

- Unterseiten & mehrstufiges Crawling: Thunderbit kann . Zum Beispiel eine Produktliste erfassen und dann automatisch Details zu jedem Produkt sammeln.

- Sofort strukturierte Ergebnisse: Die KI , schlägt relevante Felder vor, normalisiert Formate und kann sogar Texte zusammenfassen oder kategorisieren.

- Vielfältige Datenquellen: Thunderbit extrahiert nicht nur aus HTML, sondern auch aus PDFs und Bildern – dank integrierter OCR und Vision-KI ().

- Business-Integrationen: Mit einem Klick exportierst du Daten nach Google Sheets, Airtable, Notion oder Excel (). Du kannst Scrapes planen und die Daten direkt in deine Arbeitsabläufe einbinden.

- Vorlagen für beliebte Seiten: Für Plattformen wie Amazon, LinkedIn, Zillow usw. gibt’s für die Ein-Klick-Extraktion.

- Intuitive Bedienung: Die Oberfläche ist selbsterklärend, mit einem smarten Assistenten. Nutzer:innen berichten, dass sie in wenigen Minuten startklar sind.

Thunderbit wird von eingesetzt – darunter Teams von Accenture, Grammarly und Puma. Vertriebsteams bauen damit auf, Makler:innen sammeln Immobilienangebote, Marketer beobachten Wettbewerber – und das alles ohne eine Zeile Code.

Preise: Es gibt eine (bis zu 100 Schritte/Monat), kostenpflichtige Pakete starten ab 14,99 $/Monat. Auch die Pro-Versionen sind für Einzelpersonen und kleine Teams erschwinglich.

Thunderbit ist das Beste, was ich bisher gesehen habe, um „das Web in eine Datenbank zu verwandeln“ – und das für alle, nicht nur für Entwickler:innen.

2. Crawl4AI

Für wen: Entwickler:innen und technische Teams, die eigene Datenpipelines bauen.

Crawl4AI ist ein Open-Source-Framework auf Python-Basis, das auf Geschwindigkeit und großflächiges Crawling ausgelegt ist – mit im Hinterkopf. Es ist extrem schnell, unterstützt Headless-Browser für dynamische Inhalte und strukturiert die Daten für KI-Workflows.

- Ideal für: Entwickler:innen, die eine leistungsstarke, anpassbare Crawling-Engine brauchen.

- Preise: Kostenlos (MIT-Lizenz). Hosting und Betrieb erfolgen in Eigenregie.

3. ScrapeGraphAI

Für wen: Entwickler:innen und Analyst:innen, die KI-Agenten oder komplexe Datenpipelines bauen.

ScrapeGraphAI ist eine promptbasierte, Open-Source-Python-Bibliothek, die Webseiten mithilfe von LLMs in strukturierte Daten-„Graphen“ verwandelt. Du kannst Prompts wie „Extrahiere alle Produktnamen, Preise und Bewertungen von den ersten 5 Seiten“ schreiben – und das Tool baut den Workflow für dich ().

- Ideal für: Technikaffine Nutzer:innen, die flexible, promptbasierte Extraktion wollen.

- Preise: Open Source kostenlos; Cloud-API ab 20 $/Monat.

4. Firecrawl

Für wen: Entwickler:innen, die KI-Agenten oder große Datenpipelines bauen.

Firecrawl ist eine KI-zentrierte Crawling-Plattform und API, die komplette Websites in „LLM-bereite“ Daten verwandelt (). Sie liefert Markdown oder JSON, verarbeitet dynamische Inhalte und integriert sich in Frameworks wie LangChain und LlamaIndex.

- Ideal für: Entwickler:innen, die Live-Webdaten in KI-Modelle einspeisen möchten.

- Preise: Open-Source-Kern kostenlos; Cloud ab 19 $/Monat.

5. Browse AI

Für wen: Business-Anwender:innen, Growth Hacker und Analyst:innen.

Browse AI ist eine No-Code-Plattform mit . Du „trainierst“ einen Roboter, indem du auf die gewünschten Daten klickst – die KI erkennt das Muster für künftige Scrapes. Logins, endloses Scrollen und Website-Überwachung werden unterstützt.

- Ideal für: Nicht-technische Nutzer:innen, die Datensammlung und Monitoring automatisieren möchten.

- Preise: Kostenloser Plan (50 Credits/Monat); kostenpflichtig ab 19 $/Monat.

6. LLM Scraper

Für wen: Entwickler:innen, die das Parsing der KI überlassen wollen.

LLM Scraper ist eine Open-Source-JavaScript/TypeScript-Bibliothek, mit der du und ein LLM die Daten aus beliebigen Webseiten extrahieren lassen kannst. Es basiert auf Playwright, unterstützt verschiedene LLM-Anbieter und kann wiederverwendbaren Code generieren.

- Ideal für: Entwickler:innen, die jede Webseite per LLM in strukturierte Daten verwandeln möchten.

- Preise: Kostenlos (MIT-Lizenz).

7. Reader (Jina Reader)

Für wen: Entwickler:innen, die LLM-Anwendungen, Chatbots oder Zusammenfassungen bauen.

Jina Reader ist eine API, die extrahiert und als Markdown oder JSON für LLMs bereitstellt. Sie basiert auf einem eigenen KI-Modell und kann sogar Bilder beschriften.

- Ideal für: Saubere, lesbare Inhalte für LLMs oder Q&A-Systeme.

- Preise: Kostenlose API (für Basisnutzung ohne Schlüssel).

8. Bright Data

Für wen: Unternehmen und Profis, die Skalierbarkeit, Compliance und Zuverlässigkeit benötigen.

Bright Data ist ein Schwergewicht im Webdaten-Bereich, mit riesigem Proxy-Netzwerk und . Es gibt fertige Scraper, eine Web-Scraper-API und „LLM-bereite“ Datenfeeds.

- Ideal für: Organisationen, die zuverlässige Webdaten in großem Umfang benötigen.

- Preise: Nutzungsbasiert, Premium. Kostenlose Testphasen verfügbar.

9. Octoparse

Für wen: Von nicht-technischen bis semi-technischen Nutzer:innen.

Octoparse ist ein etabliertes No-Code-Tool mit und KI-gestützter Auto-Erkennung. Logins, endloses Scrollen und verschiedene Exportformate werden unterstützt.

- Ideal für: Analyst:innen, kleine Unternehmen oder Forschende.

- Preise: Kostenlose Version verfügbar; kostenpflichtig ab 59 $/Monat.

10. Apify

Für wen: Entwickler:innen und Tech-Teams, die individuelle Scraping- oder Automatisierungslösungen brauchen.

Apify ist eine Cloud-Plattform für das Ausführen von Scraping-Skripten („Actors“) und bietet einen . Skalierbar, KI-Integration und Proxy-Management inklusive.

- Ideal für: Entwickler:innen, die eigene Skripte in der Cloud ausführen möchten.

- Preise: Kostenloser Einstieg; nutzungsbasierte Tarife ab 49 $/Monat.

11. Zyte (Scrapy Cloud)

Für wen: Entwickler:innen und Unternehmen, die Enterprise-Scraping benötigen.

Zyte ist das Unternehmen hinter Scrapy und bietet eine Cloud-Plattform mit . Zeitplanung, Proxys und große Projekte werden unterstützt.

- Ideal für: Entwicklerteams mit langfristigen Scraping-Projekten.

- Preise: Kostenlose Tests bis hin zu individuellen Enterprise-Tarifen.

12. Webscraper.io

Für wen: Einsteiger:innen, Journalist:innen und Forschende.

ist eine für Point-and-Click-Datenextraktion. Einfach, kostenlos für lokale Nutzung, Cloud-Service für größere Aufgaben.

- Ideal für: Schnelle, einmalige Scraping-Aufgaben.

- Preise: Kostenlose Erweiterung; Cloud ab ca. 50 $/Monat.

13. ParseHub

Für wen: Nicht-technische Nutzer:innen, die mehr Power als bei Basistools brauchen.

ParseHub ist eine Desktop-App mit visuellem Workflow für dynamische Inhalte, inklusive Karten und Formularen. Projekte können in der Cloud laufen, eine API ist verfügbar.

- Ideal für: Digital Marketer, Analyst:innen und Journalist:innen.

- Preise: Kostenlos (200 Seiten/Lauf); kostenpflichtig ab 189 $/Monat.

14. Diffbot

Für wen: Unternehmen und KI-Firmen, die große Mengen strukturierter Webdaten benötigen.

Diffbot nutzt Computer Vision und NLP, um – APIs für Artikel, Produkte und ein riesiger Knowledge Graph inklusive.

- Ideal für: Marktanalysen, Finanzwesen und KI-Trainingsdaten.

- Preise: Premium, ab ca. 299 $/Monat.

15. DataMiner

Für wen: Nicht-technische Nutzer:innen, besonders in Vertrieb, Marketing und Journalismus.

DataMiner ist eine für schnelle, Point-and-Click-Datenextraktion. Es gibt eine Bibliothek mit Vorlagen und direkten Export nach Google Sheets.

- Ideal für: Schnelle Aufgaben wie das Exportieren von Tabellen oder Listen in Tabellenkalkulationen.

- Preise: Kostenlos (bis 500 Seiten/Tag); Pro ab ca. 19 $/Monat.

Vergleich der Top-KI-Web-Scraper: Welches Tool passt zu dir?

Hier ein Überblick, damit du die passende Lösung findest:

| Tool | KI/LLM-Nutzung | Bedienkomfort | Output/Integration | Ideal für | Preise |

|---|---|---|---|---|---|

| Thunderbit | Natürliche Sprache, KI schlägt Felder vor | Am einfachsten (No-Code-Chat) | Export zu Sheets, Airtable, Notion | Nicht-technische Teams | Kostenlos; Pro ca. 30 €/Monat |

| Crawl4AI | KI-bereites Crawling, LLM-Integration | Anspruchsvoll (Python-Code) | Bibliothek/CLI, Integration per Code | Entwickler:innen für schnelle KI-Datenpipelines | Kostenlos |

| ScrapeGraphAI | LLM-Prompt-Pipelines fürs Scraping | Mittel (etwas Code oder API) | API/SDK, JSON-Output | Entwickler:innen/Analyst:innen für KI-Agenten | OSS kostenlos; API ab 20 €/Monat |

| Firecrawl | Crawlt zu LLM-bereitem Markdown/JSON | Mittel (API/SDK-Nutzung) | SDKs (Py, Node, etc.), LangChain-Integration | Entwickler:innen für Live-Webdaten in KI | Kostenlos + Cloud-Tarife |

| Browse AI | KI-gestütztes Point & Click | Einfach (No-Code) | 7000+ App-Integrationen (Zapier) | Nicht-technische Nutzer:innen für Web-Monitoring | 50 Runs gratis; ab 19 €/Monat |

| LLM Scraper | Nutzt LLMs für Schema-Parsing | Anspruchsvoll (TS/JS-Code) | Code-Bibliothek, JSON-Output | Entwickler:innen für KI-Parsing | Kostenlos (eigene LLM-API) |

| Reader (Jina) | KI-Modell extrahiert Text/JSON | Einfach (API-Aufruf) | REST API liefert Markdown/JSON | Entwickler:innen für Websuche/Content in LLMs | Kostenlose API |

| Bright Data | KI-gestützte APIs, großes Proxy-Netz | Anspruchsvoll (API, technisch) | APIs/SDKs, Datenstreams/Datasets | Enterprise-Scale | Nutzungsbasiert |

| Octoparse | KI erkennt Listen automatisch | Mittel (No-Code-App) | CSV/Excel, API für Ergebnisse | Semi-technische Nutzer:innen | Kostenlos limitiert; 59–166 €/Monat |

| Apify | Einige KI-Features (Actors, Tutorials) | Anspruchsvoll (Skripte) | Umfassende API, LangChain-Integration | Entwickler:innen für Custom-Scraping in der Cloud | Kostenlos; Pay-as-you-go |

| Zyte (Scrapy) | ML-basierte Extraktion, Scrapy-Framework | Anspruchsvoll (Python-Code) | API, Scrapy Cloud UI, JSON/CSV | Entwicklerteams, Langzeitprojekte | Individuelle Preise |

| Webscraper.io | Keine KI (manuelle Vorlagen) | Einfach (Browser-Erweiterung) | CSV-Download, Cloud-API | Einsteiger:innen, schnelle Scrapes | Kostenlos; Cloud ca. 50 €/Monat |

| ParseHub | Kein LLM, visueller Builder | Mittel (No-Code-App) | JSON/CSV, API für Cloud-Runs | Nicht-Entwickler:innen für komplexe Seiten | 200 Seiten gratis; ab 189 €/Monat |

| Diffbot | KI-Vision/NLP für jede Seite, Knowledge Graph | Einfach (API-Aufrufe) | APIs (Artikel/Produkt/...) + Knowledge Graph | Enterprise, strukturierte Webdaten | Ab ca. 299 €/Monat |

| DataMiner | Kein LLM, Community-Vorlagen | Am einfachsten (Browser-UI) | Excel/CSV-Export, Google Sheets | Nicht-technische Nutzer:innen für Tabellen | Kostenlos limitiert; Pro ab 19 €/Monat |

Tool-Kategorien: Von Entwickler-Tools bis zu Business-freundlichen Web-Scrapern

Damit du den Überblick behältst, hier die wichtigsten Kategorien:

1. Entwickler- & Open-Source-Power-Tools

- Beispiele: Crawl4AI, LLM Scraper, Apify, Zyte/Scrapy, Firecrawl

- Stärken: Maximale Flexibilität, Skalierbarkeit und Anpassbarkeit. Ideal für eigene Pipelines oder KI-Integration.

- Nachteile: Erfordern Programmierkenntnisse und mehr Konfiguration.

- Einsatz: Eigene Datenpipelines, komplexe Seiten, Integration in interne Systeme.

2. KI-integrierte Scraping-Agenten

- Beispiele: Thunderbit, ScrapeGraphAI, Firecrawl, Reader (Jina), LLM Scraper

- Stärken: Schließen die Lücke zwischen Scraping und Datenverständnis. Natürliche Sprache macht sie zugänglich.

- Nachteile: Teilweise noch in Entwicklung, weniger Detailkontrolle.

- Einsatz: Schnelle Antworten/Datasets, autonome Agenten, Live-Daten für LLMs.

3. No-Code/Low-Code Business-Scraper

- Beispiele: Thunderbit, Browse AI, Octoparse, ParseHub, , DataMiner

- Stärken: Benutzerfreundlich, kaum Programmierkenntnisse nötig, ideal für Business-Aufgaben.

- Nachteile: Komplexe Seiten oder große Datenmengen können herausfordernd sein.

- Einsatz: Lead-Generierung, Wettbewerbsbeobachtung, Recherche, einmalige Datenabfragen.

4. Enterprise-Datenplattformen und -Services

- Beispiele: Bright Data, Diffbot, Zyte

- Stärken: Komplettlösungen, Managed Services, Compliance und Zuverlässigkeit im großen Maßstab.

- Nachteile: Höhere Kosten, mehr Einarbeitung nötig.

- Einsatz: Große, dauerhafte Datenpipelines, Marktanalysen, KI-Trainingsdaten.

Wie finde ich den passenden KI-Web-Crawler für meine Scraping-Bedürfnisse?

Die Auswahl kann echt überwältigend sein – hier mein Fahrplan:

- Ziele und Datenbedarf klären: Welche Seiten und Daten brauchst du? Wie oft? Wie viel? Was machst du damit?

- Technisches Know-how einschätzen: Kein Code? Thunderbit, Browse AI oder Octoparse. Etwas Skripting? LLM Scraper oder DataMiner. Entwickler:in? Crawl4AI, Apify oder Zyte.

- Häufigkeit und Umfang: Einmalig? Kostenlose Tools. Regelmäßig? Auf Planungsfunktionen achten. Großes Volumen? Enterprise- oder Open-Source-Lösungen.

- Budget und Preismodell: Kostenlose Pläne zum Testen. Abo vs. nutzungsbasiert je nach Bedarf.

- Testen und Proof of Concept: Probier mehrere Tools mit deinen echten Daten aus. Die meisten bieten kostenlose Stufen.

- Wartung und Support: Wer kümmert sich, wenn sich die Seite ändert? No-Code-Tools mit KI passen sich oft automatisch an, Open Source erfordert Eigeninitiative.

- Tools auf Szenarien abbilden: Vertriebsteam für Leads? Thunderbit oder Browse AI. Forscher:in für Tweets? DataMiner oder . KI-Modell für News? Jina Reader oder Zyte. Vergleichsportal bauen? Apify oder Zyte.

- Backup einplanen: Manchmal funktioniert ein Tool auf einer bestimmten Seite nicht. Hab eine Alternative parat.

Das „richtige“ Tool ist das, mit dem du deine Daten am einfachsten und effizientesten bekommst – und das zu deinem Budget passt. Oft ist es eine Kombination.

Thunderbit vs. klassische Web-Scraper: Was macht den Unterschied?

Was Thunderbit besonders macht:

- Interface in natürlicher Sprache: Kein Code, kein umständliches Klicken. Einfach beschreiben, was du brauchst ().

- Null Konfiguration & Vorlagensuche: Thunderbit erkennt Paginierung, Unterseiten und schlägt sogar Vorlagen für bekannte Seiten vor ().

- KI-gestützte Datenbereinigung und Anreicherung: Daten beim Scraping zusammenfassen, kategorisieren, übersetzen und anreichern ().

- Weniger Wartungsaufwand: Thunderbits KI ist robust gegenüber kleineren Website-Änderungen.

- Business-Integration: Direkter Export zu Google Sheets, Airtable, Notion – kein CSV-Chaos mehr ().

- Schneller Mehrwert: Von der Idee zu den Daten in Minuten statt Tagen.

- Einfache Lernkurve: Wer surfen und beschreiben kann, kann Thunderbit nutzen.

- Vielseitigkeit: Webseiten, PDFs, Bilder und mehr – alles mit einem Tool.

Thunderbit ist mehr als ein Scraper – es ist dein Datenassistent, der sich nahtlos in deinen Workflow einfügt, egal ob Vertrieb, Marketing, E-Commerce oder Immobilien.

Best Practices für Web Scraping mit KI-Web-Scraper-Tools

So holst du das Maximum aus KI-Web-Scrapern raus:

- Datenbedarf klar definieren: Welche Felder, wie viele Seiten, welches Format?

- KI-Vorschläge nutzen: Lass dir von den Tools Felder und Daten vorschlagen, die du vielleicht übersehen hättest ().

- Klein anfangen und prüfen: Erst mit wenigen Seiten testen, Ergebnisse kontrollieren, dann anpassen.

- Dynamische Inhalte beachten: Das Tool sollte mit Paginierung, endlosem Scrollen etc. umgehen können.

- Website-Richtlinien respektieren: robots.txt prüfen, keine sensiblen Daten scrapen, Rate-Limits einhalten.

- Automatisierung nutzen: Export- und Webhook-Funktionen verwenden, um Daten direkt in Workflows einzubinden.

- Datenqualität sichern: Ergebnisse prüfen, nachbearbeiten und Fehler überwachen.

- Klare Prompts formulieren: Je präziser die Anweisung, desto besser das Ergebnis bei KI-Tools.

- Von der Community lernen: In Foren und Gruppen gibt’s Tipps und Hilfe.

- Up-to-date bleiben: KI-Tools entwickeln sich rasant – neue Features im Blick behalten.

Die Zukunft des Web Scraping: KI, LLMs und die Ära der Web-Scraper-Agenten

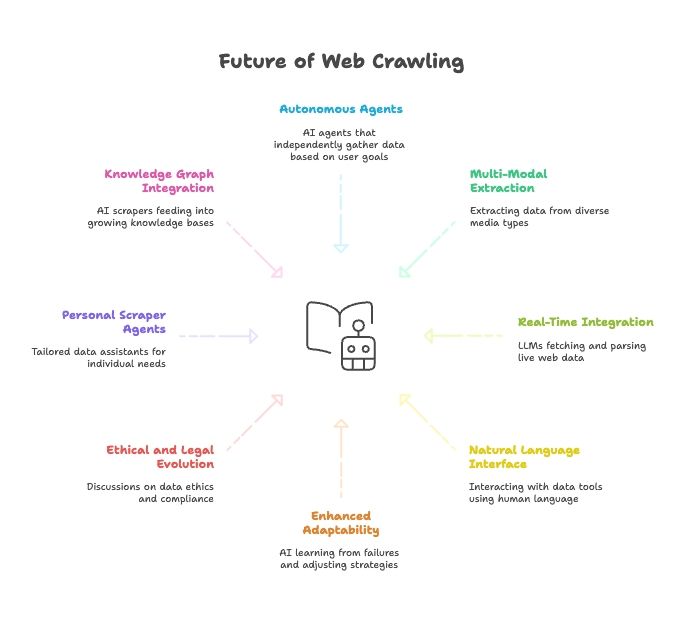

Der Blick nach vorn zeigt: KI und Web Scraping wachsen immer stärker zusammen:

- Vollautonome Scraper-Agenten: Bald reicht ein Ziel – die KI findet selbstständig den Weg zu den Daten.

- Multimodale Datenerfassung: Scraper holen Daten aus Text, Bildern, PDFs und sogar Videos.

- Echtzeit-Integration mit KI-Modellen: LLMs bekommen Module, um Live-Webdaten zu holen und zu verarbeiten.

- Natürliche Sprache überall: Wir sprechen mit unseren Datentools wie mit Menschen – Datensammlung wird für alle zugänglich.

- Mehr Anpassungsfähigkeit: KI-Scraper lernen aus Fehlern und passen ihre Strategien automatisch an.

- Ethik und Recht: Diskussionen zu Datenethik, Compliance und Fair Use nehmen zu.

- Persönliche Scraper-Agenten: Ein persönlicher Datenassistent sammelt News, Jobs und mehr – individuell zugeschnitten.

- Integration in Knowledge Graphs: KI-Scraper speisen kontinuierlich Wissensdatenbanken und machen KI noch smarter.

Fazit: Die Zukunft des Web Scraping ist eng mit der Entwicklung von KI verknüpft. Die Tools werden täglich intelligenter, autonomer und zugänglicher.

Fazit: Mit dem richtigen KI-Web-Crawler echten Mehrwert schaffen

Web Scraping ist dank KI von einer Nischendisziplin zu einer zentralen Business-Fähigkeit geworden. Die 15 vorgestellten Tools zeigen, was 2025 möglich ist – von Entwickler-Tools bis zu benutzerfreundlichen Assistenten.

Das eigentliche Geheimnis? Mit dem passenden Tool holst du das Maximum aus deinen Webdaten heraus. Für nicht-technische Teams ist Thunderbit der einfachste Weg, das Web in eine strukturierte, auswertbare Datenbank zu verwandeln – ohne Code, ohne Aufwand, mit sofortigen Ergebnissen.

Egal ob du Leads generierst, Wettbewerber beobachtest oder dein KI-Modell mit Daten fütterst: Nimm dir Zeit, probiere verschiedene Tools aus und finde deine optimale Lösung. Und wenn du die Zukunft des Web Scraping schon heute erleben willst, . Die gewünschten Einblicke sind nur einen Prompt entfernt.

Neugierig auf mehr? Im findest du Deep Dives, Tutorials und die neuesten Trends rund um KI-gestützte Datenextraktion.

Weiterführende Artikel:

FAQs

1. Was ist ein KI-Web-Crawler und wie unterscheidet er sich von klassischen Web-Scrapern?

Ein KI-Web-Crawler nutzt natürliche Sprachverarbeitung und maschinelles Lernen, um Webdaten zu verstehen, zu extrahieren und zu strukturieren. Im Gegensatz zu klassischen Scrapern, die manuell programmiert und mit XPath-Selektoren gefüttert werden müssen, können KI-Tools dynamische Inhalte verarbeiten, sich an Layout-Änderungen anpassen und Anweisungen in Alltagssprache interpretieren.

2. Für wen eignen sich KI-Web-Scraper wie Thunderbit?

Thunderbit ist für technische und nicht-technische Nutzer:innen gemacht. Perfekt für Vertrieb, Marketing, Operations, Forschung und E-Commerce – überall dort, wo strukturierte Daten aus Webseiten, PDFs oder Bildern gebraucht werden, ohne eine Zeile Code zu schreiben.

3. Was macht Thunderbit im Vergleich zu anderen KI-Web-Crawlern besonders?

Thunderbit bietet eine natürliche Sprachsteuerung, mehrstufiges Crawling, automatische Datenstrukturierung, OCR-Unterstützung und nahtlose Exporte zu Plattformen wie Google Sheets und Airtable. Außerdem gibt’s KI-gestützte Feldvorschläge und Vorlagen für beliebte Seiten.

4. Gibt es 2025 kostenlose Optionen für KI-Web-Scraping?

Ja. Viele Tools wie Thunderbit, Browse AI und DataMiner bieten kostenlose Pläne mit begrenztem Umfang. Für Entwickler:innen gibt’s Open-Source-Optionen wie Crawl4AI und ScrapeGraphAI, die volle Funktionalität bieten, aber technisches Setup erfordern.

5. Wie finde ich den passenden KI-Web-Crawler für meine Anforderungen?

Definiere zuerst deine Datenziele, dein technisches Know-how, dein Budget und den gewünschten Umfang. Wenn du eine No-Code-Lösung suchst, sind Thunderbit oder Browse AI ideal. Für große oder individuelle Projekte eignen sich Tools wie Apify oder Bright Data besser.