Ich verrate dir mal was: Früher dachte ich, Web Scraping wäre nur was für Nerds mit Hoodie oder Datenfreaks, die mehr Bildschirme als gesunden Schlaf haben. Aber heute gehört das Extrahieren von Webdaten zum Büroalltag wie der Kaffee am Morgen – und zum Glück muss man dafür weder Python können noch literweise Espresso kippen. Dank moderner KI-Web-Scraper-Tools können mittlerweile sogar Leute, die „HTML“ für ein neues Sandwich bei Subway halten, strukturierte Daten aus dem Netz ziehen.

Falls du schon mal Produktinfos, Leads oder Preislisten mühsam per Copy & Paste in eine Tabelle übertragen hast, bist du nicht allein. Rund nutzen Web Scraping längst für Marktanalysen und Wettbewerbsbeobachtung. Und weil der Markt für Web-Scraping-Software bis 2032 auf wachsen soll, ist klar: Datenextraktion aus dem Web ist längst Mainstream. Egal ob Vertrieb, Marketing oder einfach, um sich die lästige Dateneingabe zu sparen – dieser Guide ist für dich. Ich erkläre die Basics, vergleiche klassische und KI-basierte Methoden und zeige, wie du direkt loslegen kannst – ganz ohne Hoodie.

Web-Scraper-Grundlagen: Was heißt eigentlich, Daten von einer Website zu holen?

Ganz einfach: Ein Web-Scraper ist ein Tool (oder Skript, oder eine Chrome-Erweiterung), das automatisch Daten von Webseiten einsammelt. Stell dir vor, du hast einen superschnellen Praktikanten, der nie über langweilige Aufgaben meckert. Statt jede Zeile einzeln zu kopieren, macht der Web-Scraper das in Sekunden – und will nicht mal eine Kaffeepause.

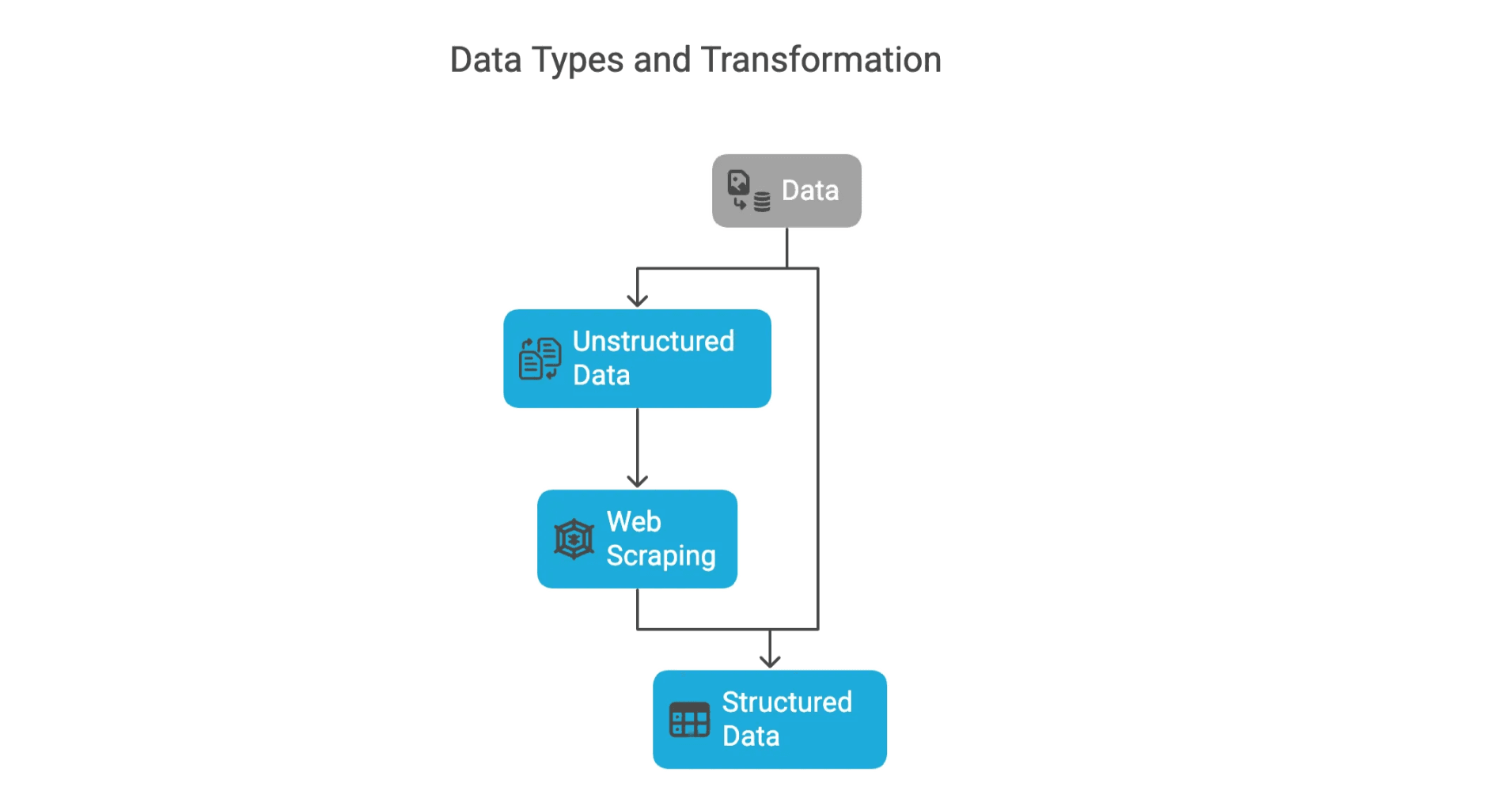

Im Netz findest du zwei Arten von Daten:

- Strukturierte Daten: Das sind ordentlich sortierte Infos, die direkt in eine Tabelle passen – zum Beispiel Produktnamen, Preise oder E-Mail-Adressen. Klar beschriftet, leicht auswertbar.

- Unstrukturierte Daten: Hier wird’s chaotisch – Blogartikel, Bewertungen, Bilder oder alles, was nicht brav in Zeilen und Spalten steckt. Die meisten Scraping-Projekte wollen genau diese wilden Daten in eine strukturierte Form bringen, damit man sie nutzen kann.

Wenn du schon mal eine Tabelle von einer Website nach Excel kopiert hast, hast du Web Scraping per Hand gemacht. Stell dir vor, das für 10.000 Seiten zu machen. (Bitte nicht! Dafür gibt’s Web-Scraper.)

Warum überhaupt Daten von Websites holen? Die wichtigsten Vorteile für Unternehmen

Warum also scrapen? Kurz gesagt: Daten sind der Treibstoff für Unternehmen – und das Web ist die größte Zapfsäule der Welt. Egal ob Vertrieb, Marketing, E-Commerce oder Immobilien: Webdaten verschaffen dir einen echten Vorsprung.

Hier ein paar typische Einsatzgebiete:

| Anwendungsfall | Beschreibung | Beispielhafter Nutzen/ROI |

|---|---|---|

| Lead-Generierung | Kontaktdaten, E-Mails oder Firmenlisten aus Verzeichnissen oder sozialen Netzwerken sammeln | Vertriebsteams sparen Zeit und finden mehr qualifizierte Leads |

| Preisüberwachung | Wettbewerberpreise, Lagerbestände oder Aktionen in Echtzeit verfolgen | Händler passen Preise dynamisch an und steigern den Umsatz um 4 % |

| Marktforschung | Bewertungen, News oder Social-Media-Stimmungen bündeln, um Trends zu erkennen | Marketing passt Kampagnen an aktuelle Kundenbedürfnisse an |

| Wettbewerbsanalyse | Produktkataloge, Markteinführungen oder Inhalte der Konkurrenz beobachten | Unternehmen reagieren schneller auf Marktveränderungen |

| Immobilien-Insights | Immobilienangebote, Preise und Verfügbarkeiten extrahieren | Makler und Investoren erkennen Chancen vor dem Markt |

Tatsächlich setzen in Großbritannien und Europa auf dynamische Preisstrategien, die durch Preis-Scraping der Konkurrenz möglich werden. Unternehmen wie John Lewis und ASOS konnten so nachweislich ihren Umsatz steigern.

Klassische Web-Scraper-Tools: Wie funktionieren die eigentlich?

Schauen wir uns mal die „klassische“ Methode an, bevor KI ins Spiel kam. Traditionelle Web-Scraper sind meist Skripte (oft in Python) oder Browser-Erweiterungen, die nach festen Regeln die gewünschten Daten abgreifen.

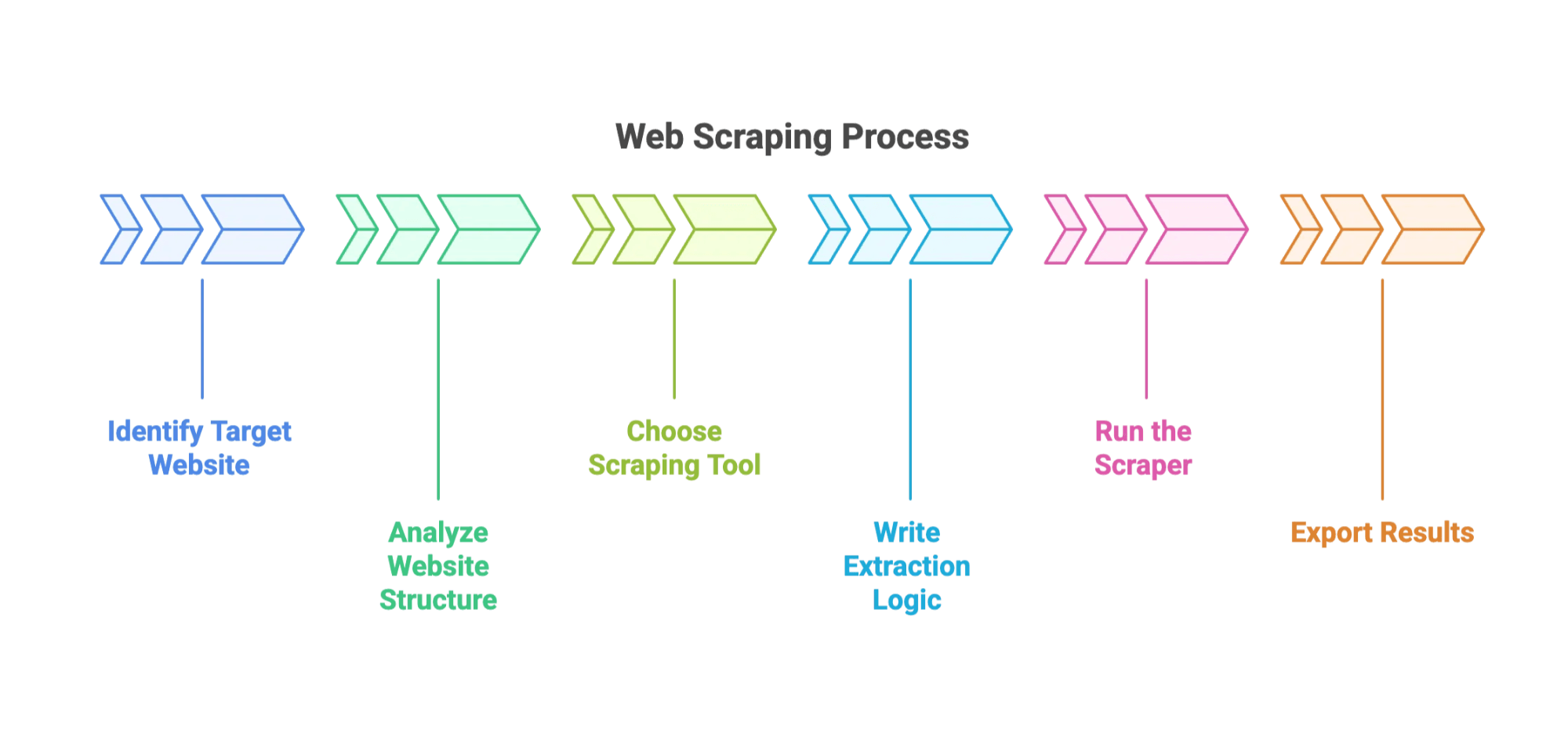

So läuft das Ganze meistens ab:

- Zielseite und Datenfelder festlegen.

- Website-Struktur analysieren. (Mit den Entwicklertools im Browser im HTML wühlen – fast wie digitale Archäologie.)

- Tool auswählen: Beliebte Optionen sind , oder Browser-Plugins.

- Extraktionslogik schreiben: Dem Tool sagen, wie es die Daten findet – meist per CSS-Selektoren oder XPath.

- Scraper ausführen: Das Tool sammelt die Daten seitenweise ein.

- Ergebnisse exportieren: Meist als CSV, JSON oder direkt nach Excel.

Schritt-für-Schritt: Daten mit einem klassischen Web-Scraper holen

Angenommen, du willst Produktlisten von einem Online-Shop extrahieren. So könnte das ablaufen:

- Schritt 1: Python und die BeautifulSoup-Bibliothek installieren.

- Schritt 2: Mit dem Browser die Produktseite inspizieren und die HTML-Tags für Name und Preis finden.

- Schritt 3: Ein kleines Skript schreiben, das die Seite lädt, das HTML parst und die gewünschten Felder extrahiert.

- Schritt 4: Über mehrere Seiten iterieren (Paginierung beachten).

- Schritt 5: Die Daten als CSV exportieren.

Klingt easy, aber glaub mir: Das erste Skript läuft selten fehlerfrei. (Mein erster Versuch hat 500 Zeilen „None“ ausgespuckt, weil ich einen Klassennamen falsch geschrieben hatte. Klassiker.)

Typische Stolperfallen bei klassischen Web-Scraper-Lösungen

Hier wird’s tricky:

- Website-Änderungen: Schon kleine Layout-Updates können den Scraper lahmlegen. gehen jede Woche wegen Änderungen kaputt.

- Anti-Bot-Maßnahmen: CAPTCHAs, IP-Sperren und Rate-Limits können dich ausbremsen. Dann braucht’s Proxys, Pausen und manchmal sogar CAPTCHA-Lösungen.

- Technisches Know-how: Du musst programmieren und HTML/CSS verstehen.

- Wartung: Scraper brauchen ständige Pflege und Updates.

- Unsaubere Daten: Du verbringst Zeit mit dem Aufräumen von Formaten, fehlenden Werten oder komischen Zeichencodierungen.

Gerade für Einsteiger fühlt sich das an, als würde man einen Kuchen backen, während das Rezept ständig geändert wird und der Ofen sich ab und zu selbst verriegelt.

Die neue Generation: KI-Web-Scraper machen Datenextraktion für alle easy

Jetzt wird’s richtig spannend. KI-Web-Scraper krempeln das Thema komplett um. Statt Code zu schreiben oder Selektoren zu basteln, beschreibst du einfach in Alltagssprache, was du brauchst – die KI macht den Rest.

Thunderbit (das sind wir!) ist ein Paradebeispiel für diese neue Generation. Mit kannst du strukturierte Daten von jeder Website per natürlicher Sprache extrahieren – ganz ohne Programmierkenntnisse. Egal ob Vertrieb, Marketing oder E-Commerce: Du bekommst die gewünschten Daten in Minuten statt Tagen.

Thunderbit KI-Web-Scraper: So einfach geht Datenextraktion

So macht Thunderbit dir das Leben leichter:

- KI-Feldvorschläge: Einfach auf „KI-Felder vorschlagen“ klicken – Thunderbit liest die Website, schlägt Spaltennamen vor und erkennt automatisch, wie die Felder extrahiert werden können.

- Unterseiten-Scraping: Du brauchst mehr Details? Thunderbit besucht automatisch jede Unterseite (z. B. einzelne Produktseiten) und ergänzt deine Datentabelle.

- Sofort-Vorlagen: Für bekannte Seiten wie Amazon oder Zillow gibt’s fertige Templates – kein Setup nötig.

- Kostenloser Datenexport: Exportiere deine Daten nach Excel, Google Sheets, Airtable oder Notion. Download als CSV oder JSON – ohne versteckte Kosten.

- Geplantes Scraping: Richte wiederkehrende Extraktionen ein, um deine Daten aktuell zu halten – ideal für Preisüberwachung oder Lead-Updates.

- KI-Autofill: Lass die KI Online-Formulare für dich ausfüllen (ja, sogar das 10-seitige Onboarding-Formular für Lieferanten).

- E-Mail-, Telefon- und Bild-Extraktoren: Kontaktdaten oder Bilder mit nur einem Klick erfassen.

Das Beste: Du brauchst keinerlei Programmierkenntnisse. Die Thunderbit Chrome-Erweiterung findest du , mehr Infos gibt’s auf unserer .

Klassisch vs. KI-Web-Scraper: Der direkte Vergleich

So schlagen sich die beiden Ansätze im Vergleich:

| Kriterium | Klassischer Web-Scraper | KI-Web-Scraper (Thunderbit) |

|---|---|---|

| Bedienung | Programmierkenntnisse oder komplexes Setup nötig | Kein Code, intuitive Bedienung in Alltagssprache |

| Anpassungsfähigkeit | Bricht bei Website-Änderungen schnell | KI passt sich automatisch an neue Layouts an |

| Wartungsaufwand | Hoch – häufige Updates nötig | Gering – KI übernimmt die Anpassungen |

| Technisches Know-how | Programmier- und HTML-Kenntnisse erforderlich | Für Business-Anwender konzipiert |

| Einrichtungsdauer | Stunden bis Tage | Minuten |

| Datenaufbereitung | Manuelle Nachbearbeitung nötig | KI bereinigt und strukturiert die Daten automatisch |

| Kosten | Open Source oft kostenlos, aber hoher Zeitaufwand | Günstige Tarife, kostenloser Export möglich |

Gerade für Einsteiger und Business-Anwender sind KI-Web-Scraper wie Thunderbit die beste Wahl: schnell, einfach und zuverlässig. Klassische Tools haben ihren Platz bei sehr individuellen oder riesigen Projekten – aber für 95 % der Fälle ist KI die bessere Lösung.

Schritt-für-Schritt-Anleitung: So holst du als Einsteiger Daten von einer Website

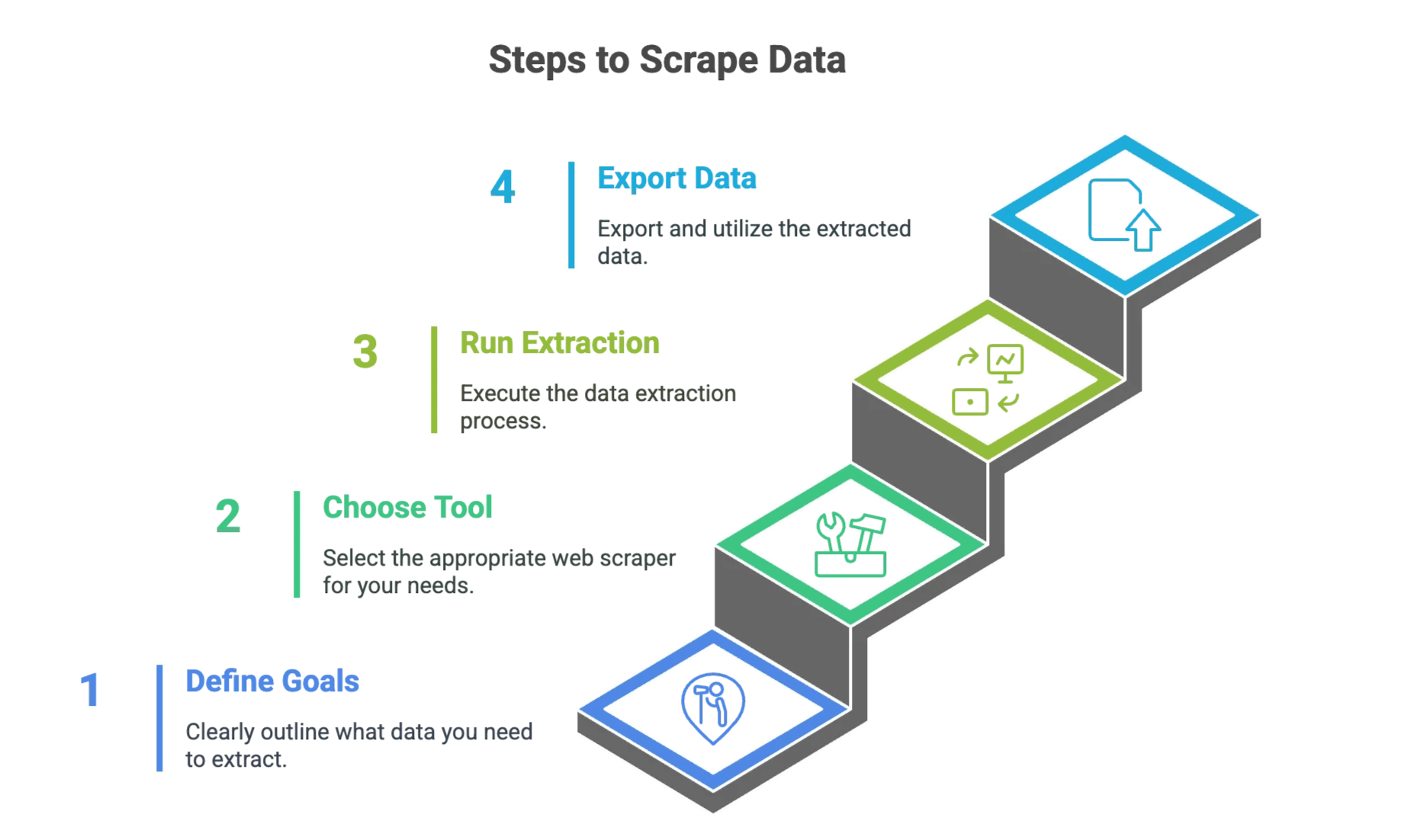

Schritt 1: Ziele für die Datenextraktion festlegen

Überleg dir vorher genau, was du brauchst. Frag dich:

- Welche Website(s) will ich scrapen?

- Welche Datenfelder sind wichtig? (z. B. Produktname, Preis, E-Mail, Telefon)

- Wie oft brauche ich die Daten? (Einmalig oder regelmäßig?)

Mach dir eine Checkliste. Beispiel: „Ich will Produktnamen, Preise und Bewertungen von den ersten 5 Seiten von sammeln.“

Schritt 2: Das passende Web-Scraper-Tool wählen

Kurze Entscheidungshilfe:

- Du bist technisch fit und willst volle Kontrolle? Probier klassische Tools wie BeautifulSoup oder Scrapy.

- Du willst es schnell, einfach und ohne Code? Nimm einen KI-Web-Scraper wie .

Im Zweifel starte mit KI – vertiefen kannst du dich später immer noch.

Schritt 3: Datenextraktion einrichten und starten

Klassische Methode

- Tool installieren: Python und die nötigen Bibliotheken einrichten.

- Website inspizieren: Mit den Entwicklertools die HTML-Struktur analysieren.

- Skript schreiben: Definieren, wie die Datenfelder gefunden und extrahiert werden.

- Testlauf auf einer Seite: Prüfen, ob die richtigen Daten extrahiert werden.

- Skalieren: Paginierung oder Schleifen für mehrere Seiten einbauen.

- Daten exportieren: Als CSV oder JSON speichern.

KI-Methode (Thunderbit)

- Thunderbit Chrome-Erweiterung installieren: .

- Zielseite öffnen: Geh auf die gewünschte Website.

- „KI-Felder vorschlagen“ klicken: Thunderbit liest die Seite und schlägt Spalten vor.

- Vorschau prüfen: Kontrolliere die Daten und passe die Spalten ggf. an.

- „Scrapen“ klicken: Thunderbit sammelt die Daten für dich ein.

- Daten exportieren: Download nach Excel, Google Sheets, Airtable oder Notion.

Eine visuelle Anleitung findest du auf unserem .

Schritt 4: Daten exportieren und nutzen

Sobald du deine Daten hast:

- Exportiere in dein Lieblingstool: Excel, Google Sheets, Airtable, Notion, CSV oder JSON.

- In den Workflow integrieren: Nutze die Daten für Vertrieb, Preisanalysen, Marktforschung oder andere Geschäftsprozesse.

- Daten prüfen: Auch mit KI lohnt sich ein kurzer Check auf Richtigkeit.

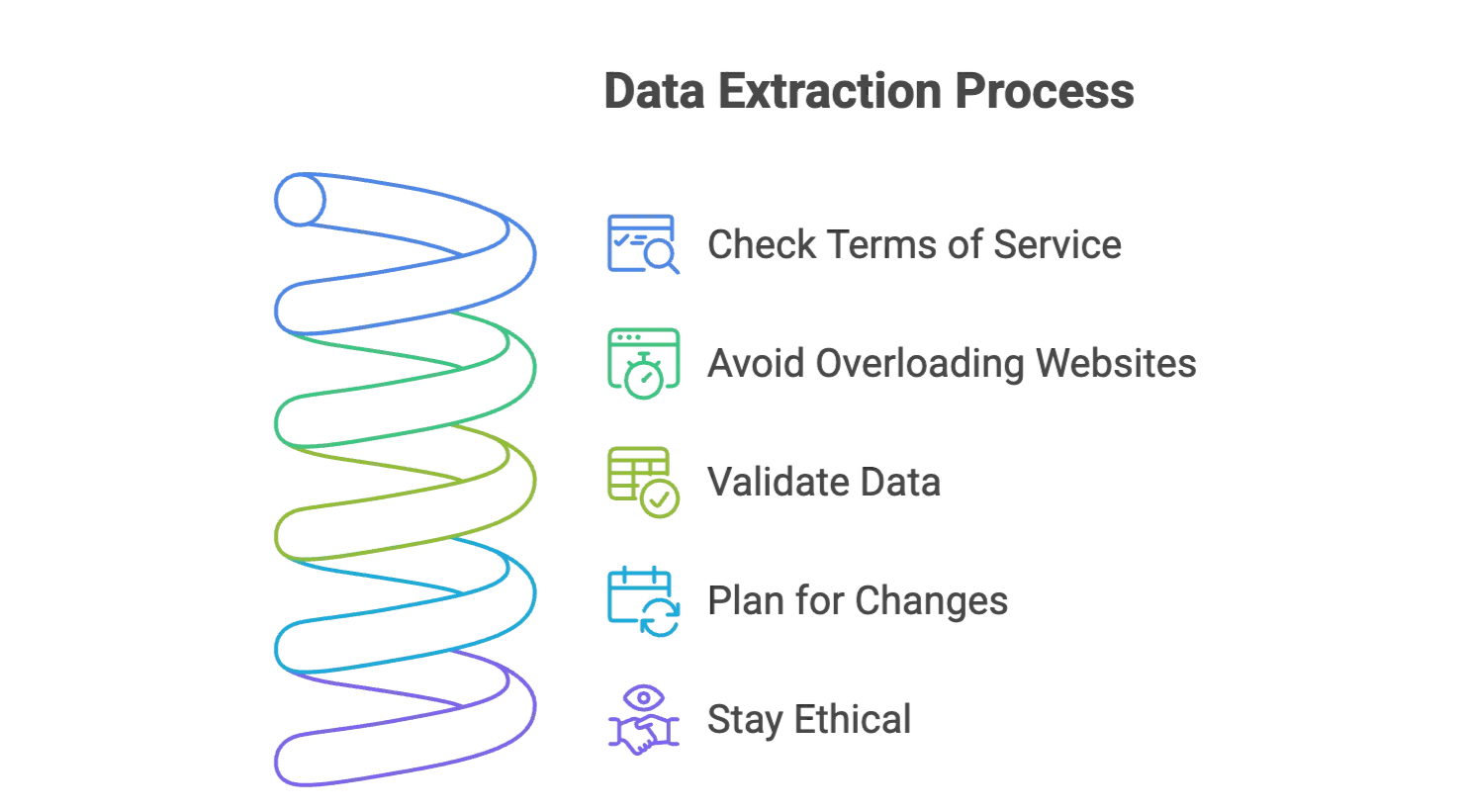

Tipps für erfolgreiche Datenextraktion: So umgehst du die typischen Fehler

- Nutzungsbedingungen checken: Schau, ob das Scraping erlaubt ist. Bleib bei öffentlichen Daten und lass sensible Infos außen vor.

- Websites nicht überlasten: Bei klassischen Tools Pausen einbauen oder das Timing Thunderbit überlassen.

- Daten validieren: Immer eine Stichprobe auf Korrektheit prüfen.

- Auf Änderungen vorbereitet sein: Websites ändern sich ständig. KI-Scraper wie Thunderbit passen sich meist automatisch an, aber ein Auge auf größere Änderungen schadet nicht.

- Ethik beachten: Nur die wirklich nötigen Daten holen und bei Veröffentlichungen die Quelle angeben.

Weitere Tipps findest du in unseren Artikeln und .

Fazit & wichtigste Learnings

Web Scraping hat sich rasant entwickelt – von handgeschriebenen Skripten zu KI-gestützten Tools, die auch Einsteiger sofort nutzen können. Die Unterschiede?

- Klassische Scraper bieten viel Kontrolle, brauchen aber Programmierkenntnisse, Wartung und Geduld.

- KI-Web-Scraper wie machen Datenextraktion für alle zugänglich – mit natürlicher Sprache, Sofort-Vorschau und praktischen Features wie Unterseiten- und geplanten Scrapes.

Lass dich als Einsteiger nicht abschrecken. Die Tools waren nie einfacher und der geschäftliche Nutzen ist riesig. Ob Lead-Generierung, Preisüberwachung oder einfach, um sich das Copy & Paste zu sparen – KI-Web-Scraper sind dein neuer bester Kumpel.

Wenn du das nächste Mal vor einem Berg Webdaten stehst, denk dran: Du brauchst weder ein Informatikstudium noch einen Hoodie. Nur ein klares Ziel, das richtige Tool – und vielleicht einen guten Kaffee.

Bereit, es selbst auszuprobieren? und erlebe, wie einfach Webdaten-Extraktion sein kann.

Neugierig auf mehr? Im findest du ausführliche Anleitungen zu Amazon, Google, PDFs und vielem mehr. Viel Spaß beim Scrapen!

Häufige Fragen (FAQ)

F1: Ist Web Scraping legal? A: Ja, das Extrahieren öffentlicher Daten ist in vielen Ländern grundsätzlich erlaubt. Prüfe aber immer die Nutzungsbedingungen der Website und lass sensible oder personenbezogene Daten außen vor.

F2: Kann ich auch Websites mit Login scrapen? A: Ja, das geht, ist aber technisch aufwendiger und kann gegen die Richtlinien der Seite verstoßen. Du brauchst spezielle Tools für authentifizierte Sessions und solltest die rechtlichen Aspekte checken.

F3: Wie kann ich Daten von JavaScript-lastigen Websites extrahieren? A: Nutze Tools, die dynamisches Rendering unterstützen – zum Beispiel Headless-Browser oder KI-Scraper, die menschliches Verhalten simulieren und JavaScript-Inhalte auslesen können.

F4: Wie verhindere ich, dass ich beim Scraping blockiert werde? A: Arbeite mit Rate-Limiting, zufälligen Pausen, wechselnden User-Agents und vermeide zu aggressives Scraping. KI-Scraper übernehmen viele dieser Maßnahmen automatisch.

Mehr erfahren

-

Überblick zu rechtlichen Rahmenbedingungen, Branchenstatistiken und ethischen Best Practices.

-

Trends, Marktentwicklung und die Rolle von KI bei der Webdaten-Extraktion (2024–2025).

-

Erfahre, wie du robots.txt-Dateien interpretierst und rechtssicher scrapen kannst.