我还记得第一次尝试从网站抓数据做副业的场景,满屏的 HTML 代码让我怀疑自己是不是误进了古埃及象形文字速成班。现在,连我那些完全不懂技术的朋友都能为自己的生意搭建专属数据集——而且全程不用写一行代码。这背后的秘诀不是魔法,而是新一代自定义提取工具和 AI 的强大加持。如果你也曾被“复制-粘贴”困在原始社会,别担心,你绝对不是一个人。好消息是,现在从网页点几下就能变成数据表,比以前任何时候都更简单高效。

这篇文章会带你深入了解什么是真正的自定义提取、它为什么成了现代企业的核心动力,以及像 这样的 AI 网页爬虫如何让每个人都能轻松搞定定制化数据。不管你是做销售、电商、运营,还是厌倦了重复的网页操作,你都能看到合适的工具如何把繁琐的手工劳动变成结构化、可用的数据——而且完全不用写代码。

什么是数据提取中的自定义提取?

先说最基本的:自定义提取就是让你能根据自己的需求,从网页上精准抓取你想要的信息,而不是只能接受爬虫默认给你的那些内容。就像点菜时可以单点喜欢的菜,而不是只能选套餐。普通网页爬虫可能只会抓页面标题、价格或元数据,但如果你想要更特别的内容,比如“产品材质”或者隐藏的“库存状态”标签呢?这时候就得靠自定义提取。

自定义提取让你可以指定要抓的字段、模式,甚至页面的某些区域,灵活适配你的业务需求。就像用金属探测器,不只是找硬币,而是能精准锁定你想要的“宝藏”——不管它藏得多深、多隐蔽()。这种灵活性在面对非标准数据时尤其重要,比如特殊标签、嵌套表格,或者需要用户操作后才显示的内容。

但问题来了:传统的自定义提取通常意味着你得自己写 XPath、CSS 选择器或者正则表达式来定位数据。虽然很强大,但设置和维护都很麻烦(后面会详细说)。真正的突破,是让你不用懂技术也能实现高度定制化的数据提取。

为什么自定义提取对企业至关重要?

那为什么要费心做自定义提取?因为在现在这个数据驱动的时代,拥有“对的”数据,而不是“随便什么”数据,直接决定你的业务能不能跑赢对手。全球网页爬虫软件市场在 ,预计到 2032 年会飙到近 1440 亿美元。这不仅仅是数字的增长,更说明了网页数据已经成了现代企业的基石。

自定义提取到底能给不同团队带来什么实际好处?

| 业务场景 | 自定义提取的数据 | 收益 / 投资回报 |

|---|---|---|

| 销售 – 潜在客户挖掘 | 目录、社交网站上的联系方式 | 潜客名单更大更精准,节省人工查找时间,最高可节省 80% 时间 |

| 电商 – 价格监控 | 竞品价格、库存信息 | 优化定价,直接提升收入(John Lewis 销售增长 4%) |

| 运营 – 数据报告 | 市场行情、合规数据 | 报告自动化,每周节省数小时,决策更快 |

| 房地产 – 市场调研 | 房源、业主联系方式、趋势指标 | 全面市场视角,投资决策更优,网页数据使用增长 50% |

比如说,销售团队可以自己搭建精准的客户名单,不用再花钱买过时的线索。电商经理能实时监控竞品价格,灵活调整策略,销量直接提升。运营团队自动化数据收集,释放大量人力。房产经纪人整合多平台房源和业主信息,市场先机一把抓。

说到底,自定义提取早就不是技术宅的专属,而是每个想用网页数据做出更快、更明智决策的企业必备利器()。

传统自定义提取方式:技术门槛与难题

说到这,传统自定义提取的难点就浮现出来了。它就像自己拼装宜家家具——会的人觉得有成就感,没经验的很容易装歪(或者数据管道直接“塌了”)。

配置流程:手动操作与工具

传统流程大致是这样的:

- 查看 HTML 结构: 打开 Chrome DevTools,右键“检查”页面,定位包裹目标数据的

<div>、class 或 ID。 - 编写提取规则: 写 XPath、CSS 选择器或正则表达式,比如

//div[@class="product-name"]/text()抓产品名。 - 配置工具或脚本: 把规则填进爬虫工具,可能是浏览器插件,也可能是用 BeautifulSoup 或 Scrapy 写的 Python 脚本。

- 测试与调整: 运行爬虫,检查结果,不断微调选择器,反复试错。(有时候这一步能无限循环下去。)

- 处理分页与子页面: 还要手动设置翻页逻辑或跟进详情页链接。

即使是号称“零代码”的工具,往往也要求你理解 HTML 结构和选择器语法。对非技术用户来说,这几乎是“劝退”级别的门槛,最后只能回归“复制-粘贴”大法()。

维护难题:为何传统方式难以为继

搭好爬虫只是第一步,后续维护才是“噩梦”开始:

- 网站结构变动: 网站经常改版,class 名一变、按钮一挪,精心写的选择器就失效了()。

- 动态内容: 越来越多网站用 JavaScript 动态加载内容,传统爬虫常常抓不到,除非加复杂的浏览器自动化。

- 提取规则脆弱: 规则太细容易失效,太宽又抓到一堆杂乱数据。

- 持续维护: 脚本需要不断检查、更新和调试。很多团队不得不请专人维护,或者干脆放弃自动化,回归手工操作。

难怪那么多企业用户觉得自己还困在“复制-粘贴”原始社会()。

AI 网页爬虫崛起:自定义提取的新范式

AI 网页爬虫的出现,直接改变了游戏规则。它不再死板地依赖规则,而是像人一样“理解”网页内容。

AI 网页爬虫通过计算机视觉和自然语言处理,分析页面的视觉布局和语义。它能根据页面的实际呈现方式识别表格、列表、标题和表单,而不是只看 HTML 代码的位置()。

这对自定义提取意味着什么?

- 极简配置: 只要把 AI 指向页面,它就能自动推荐可提取字段,无需写代码、无需折腾选择器。

- 高度适应: 网站布局变了,AI 还能通过上下文找到数据。

- 动态内容无压力: AI 支持渲染后的页面,JavaScript 加载和无限滚动都能搞定。

- 人人可用: 非技术用户也能完成复杂提取,无需开发者协助。

就像有个聪明助手帮你读懂页面,自动整理成干净的数据表,无需手写规则、无需频繁维护()。

Thunderbit 如何用 AI 简化自定义提取

说到这里不得不“自豪”一下——Thunderbit 就是为让每个人都能轻松自定义提取而生。作为 Chrome 扩展, 把 AI 驱动的数据提取带到你的浏览器里。

让网页提取变轻松的核心功能

Thunderbit 有哪些亮点?

- AI 字段推荐: 一键点击,Thunderbit 的 AI 扫描页面,自动推荐可提取的字段(列),包括名称和数据类型。你可以直接用、微调或自定义,无需猜测。

- 子页面抓取: 需要更详细信息?Thunderbit 可自动访问链接的子页面(如商品详情页),为主表补充更多数据。原本复杂的多步操作,现在只需多点一次。

- 即用型爬虫模板: 针对 Amazon、Zillow、Instagram 等热门网站,Thunderbit 提供一键模板,秒级导出数据,无需消耗 AI 点数。

- 动态内容支持: Thunderbit 支持云端和本地浏览器两种模式。云端模式可同时抓取 50 个页面(适合公开数据),浏览器模式适合需要登录或动态内容复杂的网站。

- 定时爬虫: 用自然语言描述抓取计划(如“每周一上午 9 点”),Thunderbit 自动定时运行,无需手动干预。

- 一键提取器: 需要邮箱、电话或图片?Thunderbit 有专用提取器,一键获取。

- 便捷导出: 数据可直接导出到 Excel、Google Sheets、Airtable 或 Notion,图片也能完整保存,数据集一应俱全。

- 多语言支持: Thunderbit 支持 34 种语言,全球团队都能无障碍使用。

- 免费试用与点数机制: 免费试用可抓取 6 个页面(注册后 10 个),导出永远免费。

用 Thunderbit,无需懂 HTML、CSS 或 XPath,AI 自动搞定技术难题,你只需专注于获取所需数据。

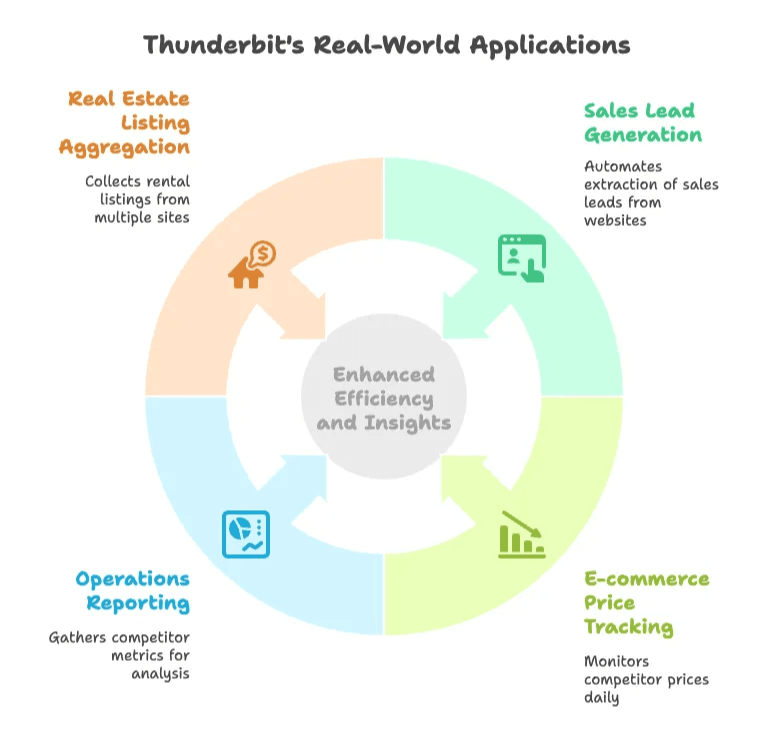

真实场景:Thunderbit 的实际应用

- 销售线索挖掘: 销售人员再也不用手动复制粘贴,只要打开网站,点“AI 字段推荐”,Thunderbit 就能批量提取姓名、公司、职位、邮箱等信息,子页面抓取还能补充更多细节。原本几天的工作,现在几分钟搞定()。

- 电商价格监控: 电商经理用 Thunderbit 每天监控竞品价格,AI 自动推荐字段,定时爬虫每天早上自动抓取并导出到 Google Sheets。网站布局变了,只需重新点“AI 字段推荐”即可,无需 IT 支持。

- 运营数据报告: 分析师需要每周收集多站点竞品数据,Thunderbit 用 AI 提示词抓取新闻、招聘、社交数据(如情感分类),数据直接流入仪表盘,随时分析。

- 房产信息整合: 经纪人整合多平台租赁房源,包括地址、价格、房东联系方式。Thunderbit 的子页面和联系方式提取器能抓取“显示联系方式”按钮背后的信息,市场全貌一览无余。

无论哪种场景,Thunderbit 都能让原本技术门槛高、耗时长的流程变得简单高效,让非技术团队也能自主掌控数据提取。

传统与 AI 驱动自定义提取对比

来看一组对比:

| 对比维度 | 传统自定义提取 | AI 驱动提取(Thunderbit) |

|---|---|---|

| 配置与技术门槛 | 需编程/脚本,手动设置选择器,学习曲线陡峭 | 无需编程,AI 自动识别字段,点选或自然语言配置 |

| 适应网站变动 | 脆弱,网站小改动就失效,需频繁手动维护 | 强韧,AI 依靠上下文和视觉线索,自动适应多数变动 |

| 动态内容处理 | JS 动态页面需额外工具/脚本,配置复杂 | 内置支持动态页面、无限滚动、“加载更多”等 |

| 字段灵活性 | 新增字段需新选择器或代码,难以实时转换 | 新增字段简单,AI 提示词可直接格式化、分类、翻译 |

| 用户可用性 | 主要面向开发者,非技术团队受限 | 人人可用,业务团队可自助提取数据 |

| 扩展性与速度 | 可扩展但需处理代理、并发等 | 云端爬取轻松扩展,最多一次抓取 50 页,扩展只需升级套餐/点数 |

| 维护成本 | 高,需持续检查、更新、调试 | 低,AI 降低失效率,算法由服务方维护,用户干预极少 |

| 准确性与数据质量 | 配置得当准确,但规则变动易出错,需后期清洗 | AI 语境理解,数据更干净相关,内置清洗与格式化 |

结论很明显:AI 驱动的自定义提取在配置、维护、扩展和易用性上全面胜出。对大多数企业来说,选择 AI 已是明智之选。

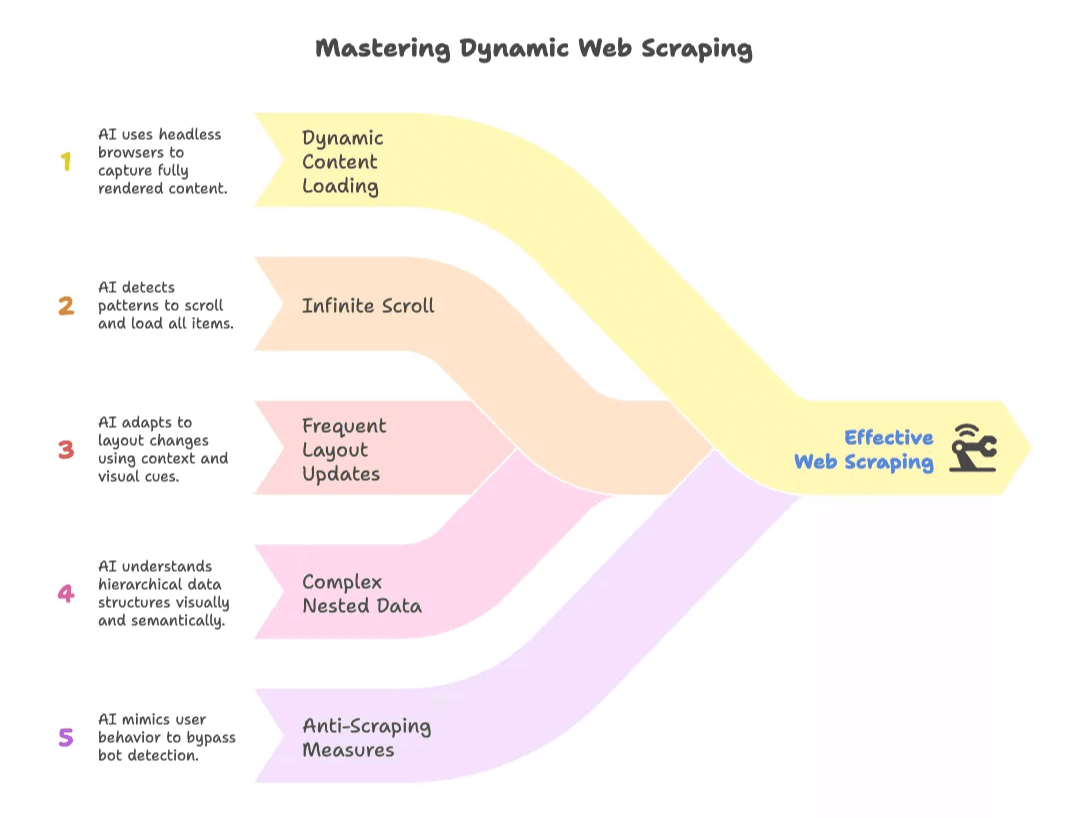

动态与复杂网站的数据提取难题如何破解?

动态网站(比如无限滚动、JS 加载内容、频繁改版)曾经是爬虫的“噩梦”。传统工具要么抓不到数据,要么一改版就崩。

AI 网页爬虫直接改变了局面:

- 动态内容加载: AI 工具用无头浏览器或扩展,能看到完整渲染页面,抓取用户可见的所有数据()。

- 无限滚动: AI 能识别重复模式,自动滚动加载所有内容。

- 频繁布局更新: AI 依靠上下文和视觉线索,不易因 HTML 结构变化而失效。

- 复杂嵌套数据: AI 能理解表格嵌套、可选字段、不规则布局,语义和视觉双重识别。

- 反爬机制应对: AI 模拟真实用户行为,可绕过简单的机器人检测,必要时还能处理验证码或登录。

对企业来说,这意味着即使面对“难搞”或经常变动的网站,也能稳定、可靠地获取数据()。

非技术团队自定义提取的实用建议

即使有 AI 加持,掌握一些实用技巧依然很重要:

- 明确数据需求: 事先规划好要抓什么、从哪里抓、多久抓一次,后期清洗更省心。

- 善用 AI 推荐,但要核查: 总是检查 AI 推荐的字段和样例,信任但要验证。

- 优先用模板: 针对热门网站的模板省时省点数,能用就用。

- 结合行业知识: 用字段提示词实现格式化、分类、翻译等高级操作。

- 小批量测试: 先抓一小部分,确认无误再大规模运行。

- 定时与监控: 自动化定期任务,但要定期抽查结果。

- 管理数据与点数: 根据实际需求设定抓取频率,及时导出数据。

- 合规与道德: 只抓取公开数据,遵守网站规定,避免收集不该获取的个人信息。

- 选对工具: 简单导出或 API 更高效时就用,AI 爬虫适合非结构化或复杂网页。

- 注意安全: 抓取登录内容时保护好账号信息。

目标很简单:让 AI 为你赋能,但数据质量和合规性还需人工把关。

自定义提取的未来趋势

展望未来,自定义提取会变得更智能、更无缝:

- 更深度的 AI 集成: 爬虫会自我学习、主动适应,甚至用多智能体系统处理更复杂流程。

- 实时数据流: 不再只是批量抓取,未来会有持续、流式的数据提取,实时驱动仪表盘。

- 超越网页: 数据提取将扩展到 PDF、图片、App、多媒体等各类数据源。

- 零代码成常态: 语音控制、甚至 AR 操作的提取方式或许很快就会到来。

- 内置合规保障: 工具会自动帮你规避法律和道德风险。

- 集成式工作流: 抓取到的数据将直接流入分析、AI 模型或业务系统,实现即时洞察。

总之,自定义提取会成为企业的“隐形助手”——始终在线、实时更新,人人可用()。

总结:用更智能的自定义提取释放业务价值

我们已经走过了手动复制粘贴和脆弱脚本的时代。自定义提取从高门槛、难维护的技术活,进化为 AI 驱动、人人可用的超级能力。像 这样的工具,让每个人都能轻松掌控网页数据——无需编程、无需折腾,只需专注于洞察和决策。

业务价值一目了然:决策更快、线索更优、定价更聪明、流程更高效。拥抱现代网页提取的企业,将更敏捷、更有洞察力,也更有竞争力。

如果你还困在“复制-粘贴”时代,是时候让 AI 帮你解放双手了。自定义提取的未来已来,从点击到表格,只需一次智能抓取。

想亲自体验?赶快下载 ,访问我们的获取更多技巧,或看看。

如果你还犹豫,不妨想想:比手动录入更糟糕的,只有发现其实一切都能自动化。

常见问题

1. 什么是自定义提取?它和标准网页爬取有何不同?

自定义提取是指根据用户需求,从网页中抓取特定字段(如产品材质、隐藏标签),而不是只抓取标题、价格等通用信息。相比标准爬虫工具只能输出预设内容,自定义提取让你灵活定制数据,更贴合实际需求。

2. 为什么自定义数据提取对现代企业重要?

自定义提取帮助企业精准获取关键数据,助力更优决策。无论是精准获客、竞品价格监控,还是自动化市场调研,定制化数据都能提升投资回报、加快流程、增强行业竞争力。

3. 传统数据提取方式存在哪些挑战?

传统方法通常需要编程能力、手动配置选择器,且网站结构变动后需频繁维护。它们难以处理动态内容,容易失效,且大多需要开发者持续支持,对非技术用户极不友好。

4. AI 工具如 Thunderbit 如何简化自定义提取?

AI 网页爬虫如 Thunderbit 利用计算机视觉和 NLP 理解页面内容,用户只需一键即可抓取数据,哪怕是动态或复杂网页。字段推荐、子页面抓取、定时任务和模板等功能,让整个流程更快、更易扩展,非技术用户也能轻松上手。

5. 团队使用 AI 数据提取工具有哪些最佳实践?

建议团队明确数据目标、核查 AI 推荐、先小批量测试、自动化定期任务。善用模板、合理安排抓取频率、确保合规操作也很重要。定期抽查数据质量,让 AI 做繁重工作,人为把控关键环节。

了解更多: