在 2025 年的互联网时代,数据量大到让人眼花缭乱。只要你在做生意,肯定深有体会:谁能更快、更准地拿到数据,谁就能抢占市场先机。不管你是做销售、电商、运营还是市场调研,能大规模、按需提取网站数据,已经成了企业的核心竞争力。Python 之所以能成为主流工具,靠的就是它丰富的库生态,既强大又容易上手。现在有将近 都用它来搞网页数据抓取。

不过,虽然 Python 是网页数据提取的“万能工具”,但现在已经不是唯一选择。像 这样的零代码工具,让任何人——哪怕完全不会编程——都能轻松搞定网页数据的抓取、清洗和整理。本文就带你了解两种主流方式:经典的 Python 抓取(Requests、Beautiful Soup、Selenium、Scrapy、Pandas),以及 Thunderbit 如何帮你提升效率。我们会结合实用代码、业务场景和实战经验,带你全面入门。

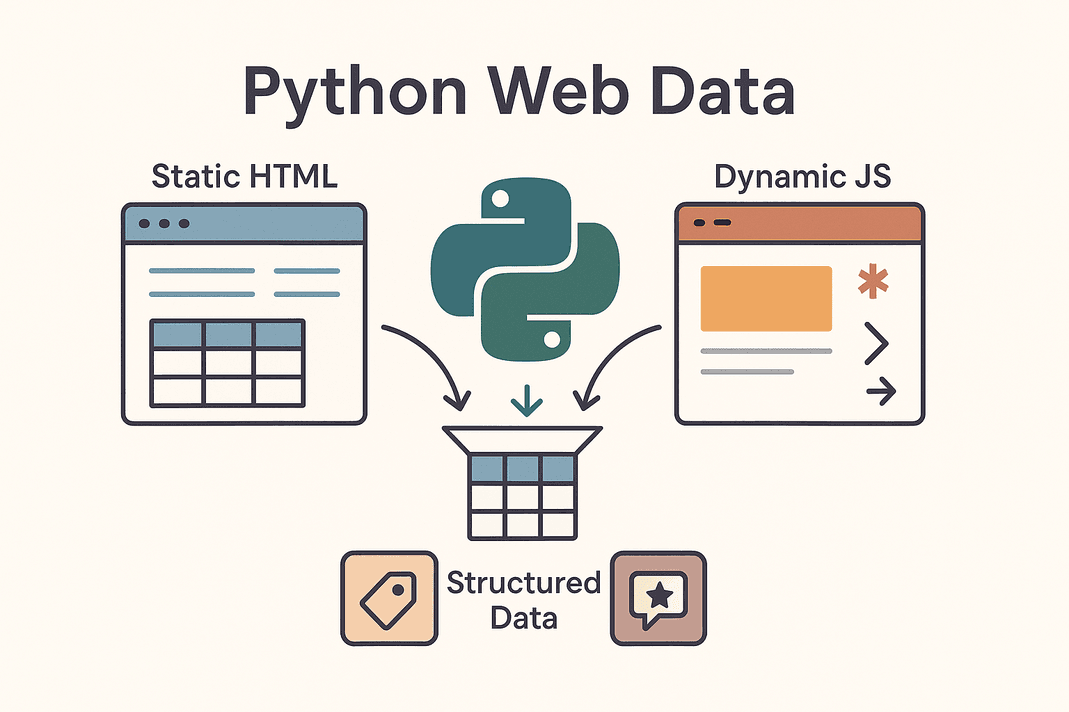

什么是“Python 从网站提取数据”?

简单来说,“python pull data from website” 就是用 Python 脚本自动获取网页信息,把杂乱的 HTML 变成结构化、可用的数据。这其实就是网页爬虫。与其手动复制粘贴产品价格、联系方式或评论,不如让 Python 自动帮你搞定这些繁琐的活儿。

简单来说,“python pull data from website” 就是用 Python 脚本自动获取网页信息,把杂乱的 HTML 变成结构化、可用的数据。这其实就是网页爬虫。与其手动复制粘贴产品价格、联系方式或评论,不如让 Python 自动帮你搞定这些繁琐的活儿。

常见的网站类型主要有两种:

- 静态网站: 所有内容都直接写在 HTML 里,页面源码里能看到全部数据,抓取起来很简单,只要拿到 HTML 再解析就行。

- 动态网站: 通过 JavaScript 动态加载数据,比如无限滚动、实时价格更新、点击后才显示的内容。抓取这类网站就得用更强的工具,比如用 Selenium 模拟浏览器,或者直接找网站背后的 API()。

常见的抓取目标有产品信息表、客户名单、价格、评论、图片等。不管你是做客户名单、监控竞品价格,还是收集市场舆情,Python 都能帮你把互联网变成你的专属数据仓库。

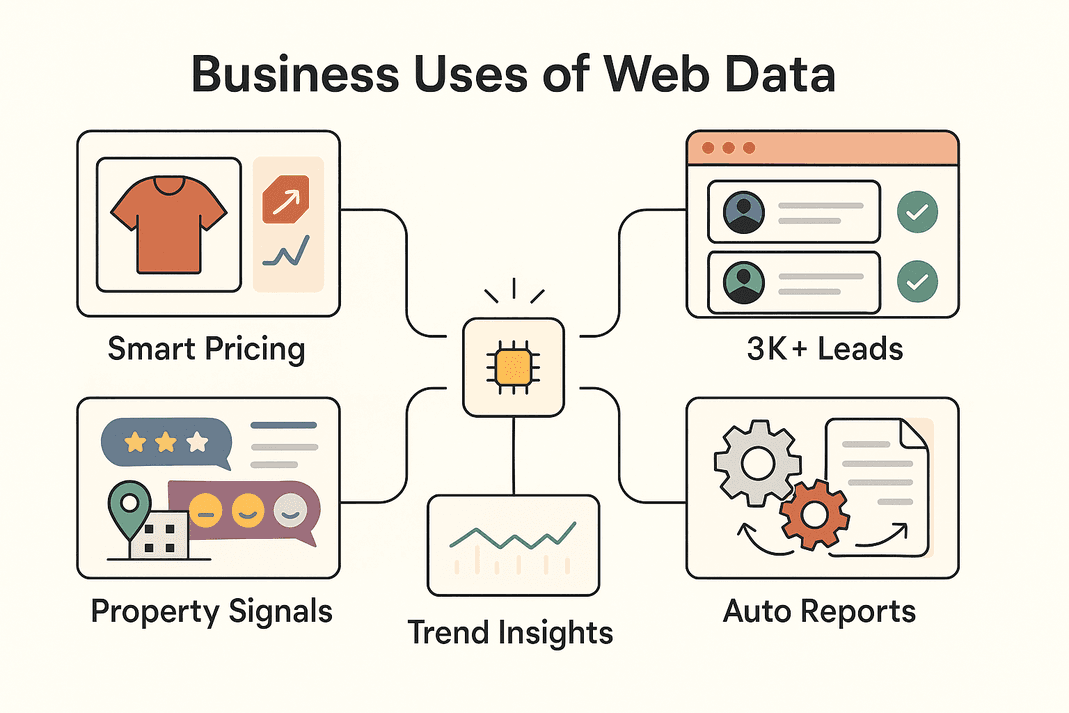

为什么企业喜欢用 Python 抓取网站数据?

说点实际的,为什么这么多企业都爱用网页数据提取?下面是常见的应用场景,以及它们带来的业务价值:

| 业务场景 | 提取数据类型 | ROI / 业务收益 |

|---|---|---|

| 销售线索挖掘 | 目录、社交平台上的联系方式 | 每月 3,000+ 潜在客户,每位销售每周节省约 8 小时 (Thunderbit)) |

| 价格监控(电商) | 产品价格、库存情况 | 销售提升约 4%,分析师工作量减少 30% (blog.apify.com) |

| 市场调研 | 评论、社交帖子、论坛留言 | 精准定位客户,26% 的爬虫用于社交数据 (Thunderbit) |

| 房产信息采集 | 房源数据、对比、地理信息 | 更快发现优质房源,获取最新市场对比 |

| 运营自动化 | 库存、报表、重复性数据 | 手动任务节省 10–50% 时间 |

总结一下:用 Python(或者 Thunderbit)抓取网页数据,能让团队更高效、决策更明智,还能自动化那些原本很耗时的琐碎工作。难怪 ,而且还在持续增长。

Python 网页数据提取的常用工具

Python 之所以受欢迎,离不开它强大的工具生态。下面是最常用的几款工具,以及各自适合的场景:

| 工具 | 最适合场景 | 优点 | 缺点 |

|---|---|---|---|

| Requests | 抓取静态 HTML 或 API | 简单、快速、适合新手 | 无法处理 JavaScript |

| Beautiful Soup | 解析 HTML/XML 结构化数据 | 易用、灵活 | 需先获取 HTML,不适合 JS 动态页面 |

| Selenium | 动态/JS 密集型网站、登录、点击 | 能模拟浏览器操作 | 速度较慢、配置复杂、资源占用高 |

| Scrapy | 大规模、多页面爬取 | 异步高效、健壮、可扩展 | 学习曲线陡峭,默认不支持 JS |

| Thunderbit | 零代码/低代码,面向业务用户 | AI 驱动,支持 JS,导出便捷 | 深度定制能力有限 |

实际项目里,大家经常会组合用:简单任务用 Requests + Beautiful Soup,遇到动态页面用 Selenium,大规模爬取用 Scrapy,追求效率和易用性时就用 Thunderbit。

步骤一:用 Python Requests 获取网页数据

先从最基础的说起。Requests 是 Python 抓取网页的主力工具,使用方法如下:

-

安装 Requests:

1pip install requests -

获取网页内容:

1import requests 2url = "https://example.com/products" 3response = requests.get(url) 4if response.status_code == 200: 5 html_content = response.text 6else: 7 print(f"Failed to retrieve data: {response.status_code}")()

-

常见问题排查:

- 添加 headers 模拟浏览器:

1headers = {"User-Agent": "Mozilla/5.0"} 2response = requests.get(url, headers=headers) - 用

response.raise_for_status()处理异常 - 如果 API 返回 JSON:

data = response.json()

- 添加 headers 模拟浏览器:

Requests 适合抓取静态页面或 API。如果你发现页面上没有你要的数据,说明数据是 JS 动态加载的,这时候就要用 Selenium 了。

步骤二:用 Beautiful Soup 解析网页内容

拿到 HTML 后,Beautiful Soup 可以帮你提取有用信息。具体操作如下:

-

安装 Beautiful Soup:

1pip install beautifulsoup4 -

解析 HTML:

1from bs4 import BeautifulSoup 2soup = BeautifulSoup(html_content, 'html.parser') -

提取数据:

- 查找所有产品卡片:

1for product in soup.select('div.product-card'): 2 name = product.select_one('.product-name').text.strip() 3 price = product.select_one('.product-price').text.strip() 4 print(name, price) - 解析表格:

1for row in soup.find_all('tr'): 2 cells = row.find_all('td') 3 # 按需提取单元格内容

- 查找所有产品卡片:

小技巧:

- 用浏览器开发者工具定位 HTML 结构和选择器。

- 用

.get_text()或.text提取文本内容。 - 用条件判断处理缺失数据(比如

if price_elem else "N/A")。

Requests + Beautiful Soup 是网页爬虫的黄金搭档,简单高效,适合大多数静态网站。

步骤三:用 Selenium 处理动态内容

遇到 JS 动态加载的网站,就得像真人一样操作页面,这时候就要用 Selenium。

-

安装 Selenium:

1pip install selenium下载对应的浏览器驱动(比如 ChromeDriver),并配置到 PATH。

-

自动化浏览器操作:

1from selenium import webdriver 2driver = webdriver.Chrome() 3driver.get("https://example.com/products") 4products = driver.find_elements_by_class_name("product-card") 5for prod in products: 6 print(prod.text) 7driver.quit() -

处理登录和点击:

1driver.get("https://site.com/login") 2driver.find_element_by_name("username").send_keys("myuser") 3driver.find_element_by_name("password").send_keys("mypassword") 4driver.find_element_by_id("login-button").click() -

等待动态内容加载:

1from selenium.webdriver.common.by import By 2from selenium.webdriver.support.ui import WebDriverWait 3from selenium.webdriver.support import expected_conditions as EC 4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CLASS_NAME, "data-row"))) -

无界面模式(Headless):

1options = webdriver.ChromeOptions() 2options.add_argument("--headless") 3driver = webdriver.Chrome(options=options)

Selenium 功能很强,但资源消耗也大,适合必须模拟浏览器操作的场景。

步骤四:用 Scrapy 实现大规模数据抓取

如果你要批量抓取上百、上千页面,Scrapy 就是你的好帮手。

-

安装 Scrapy:

1pip install scrapy 2scrapy startproject myproject -

编写爬虫:

1import scrapy 2class ProductsSpider(scrapy.Spider): 3 name = "products" 4 start_urls = ["https://example.com/category?page=1"] 5 def parse(self, response): 6 for product in response.css("div.product-card"): 7 yield { 8 'name': product.css(".product-title::text").get().strip(), 9 'price': product.css(".price::text").get().strip(), 10 } 11 next_page = response.css("a.next-page::attr(href)").get() 12 if next_page: 13 yield response.follow(next_page, self.parse) -

运行爬虫:

1scrapy crawl products -o products.csv

Scrapy 支持异步高效抓取,适合全站爬取和复杂分页。

步骤五:用 Thunderbit AI 网页爬虫提升效率

接下来聊聊 ,这款零代码 AI 网页爬虫正让业务用户彻底告别繁琐。

- AI 智能字段推荐: Thunderbit 会自动识别页面内容,推荐最佳提取字段,完全不用你手动找 HTML。

- 支持动态页面: 能像你一样“看”页面,JS、无限滚动、登录都能轻松搞定。

- 子页面抓取: 可以自动点击每个条目的详情页,帮你丰富数据集。

- 内置模板: 针对 Amazon、Zillow、Shopify 等热门网站,直接用模板,无需配置。

- 一键提取器: 想要页面上的所有邮箱或手机号?Thunderbit 一键帮你搞定。

- 定时与云端爬取: 支持用自然语言设置定时任务(比如“每周一上午 9 点”),云端可同时抓取 50 个页面。

- 多平台导出: 数据可一键导出到 Excel、Google Sheets、Airtable、Notion,或下载为 CSV/JSON,免费且无限制。

Thunderbit 特别适合追求高效、又不想写代码的团队。你甚至可以用 Thunderbit 抓取数据,再用 Python 进行分析,实现两者结合。

步骤六:用 Pandas 清洗与分析抓取数据

无论你用 Python 还是 Thunderbit 抓取数据,后续都可以用 Pandas 进行清洗和分析。

-

加载数据:

1import pandas as pd 2df = pd.read_csv("products.csv") 3print(df.head()) -

数据清洗:

- 去重:

1df = df.drop_duplicates() - 处理缺失值:

1df = df.fillna("N/A") - 格式标准化(比如价格):

1df['price'] = df['price'].str.replace('$','').str.replace(',','').astype(float)

- 去重:

-

数据分析:

- 查看统计信息:

1print(df.describe()) - 按类别分组:

1avg_price = df.groupby('category')['price'].mean() 2print(avg_price)

- 查看统计信息:

Pandas 是处理和分析网页数据的神器,能帮你快速获得业务洞察。

步骤七:组织与存储抓取数据,便于业务使用

数据清洗好后,怎么让团队用起来?

- CSV/Excel: 用

df.to_csv("out.csv", index=False)或df.to_excel("out.xlsx"),方便分享。 - Google Sheets: 可以用 或 Python 的

gspread库。 - 数据库: 数据量大可以用

df.to_sql()存到 SQL 数据库。 - 自动化: 用脚本或 Thunderbit 定时任务,保持数据实时更新。

- 最佳实践: 记得给数据加时间戳、注释字段、敏感数据要控制权限。

存储方式要看团队需求——小团队用表格,大团队用数据库。

Thunderbit 与 Python 编码:哪种方式更适合你的团队?

来对比一下:

| 对比维度 | Thunderbit(零代码 AI) | Python 库(编程) |

|---|---|---|

| 技能要求 | 无需编程(浏览器界面) | 需懂 Python 编程 |

| 上手速度 | 几分钟(AI 推荐,极速抓取) | 数小时到数天(写代码、调试、配置) |

| 支持 JS/交互 | 内置支持(浏览器/云端模式) | 需用 Selenium/Playwright |

| 维护成本 | 低——AI 能适应大部分网站变动 | 需手动维护代码 |

| 扩展性 | 中等(云端可抓取数十到数百页面) | 高(Scrapy 可扩展到上千页面) |

| 定制化 | UI 选项和 AI 提示 | 无限(可实现任意逻辑和集成) |

| 反爬/代理 | 内部自动处理 | 需手动实现 |

| 数据导出 | 一键导出到 Sheets、Excel、Notion、Airtable | 需自定义代码 |

| 适用对象 | 非技术用户、追求效率、维护简单 | 开发者、复杂/大规模项目 |

实用建议: 快速需求用 Thunderbit,赋能业务团队;需要深度定制或大规模自动化时用 Python。很多团队会两者结合——Thunderbit 快速验证和采集,Python 负责自动化和扩展。

网页数据提取的实际业务应用

看看各行各业怎么用这些工具:

看看各行各业怎么用这些工具:

- 电商: John Lewis 。

- 销售: 团队每月抓取 3,000+ 潜在客户,每人每周节省 8 小时 (),彻底告别手动查找。

- 市场调研: 市场人员批量抓取评论或社交帖子做情感分析,趋势早于数据看板。

- 房产: 经纪人抓取房源,快速发现低价房或新机会,比 MLS 更新更快。

- 流程自动化: 运营团队自动化库存检查、报表生成,甚至抓取合作伙伴或内部网站的 FAQ。

实际流程常常是混合模式:Thunderbit 采集数据,Python 清洗分析,最后导出到表格或数据库。

总结与要点回顾

用 Python(和 Thunderbit)抓取网站数据,已经成了现代企业团队的必备技能。速查表如下:

- Requests + Beautiful Soup: 静态网站首选,简单高效。

- Selenium: 动态、JS 密集或需登录的网站。

- Scrapy: 大规模、多页面爬取。

- Thunderbit: 零代码、AI 驱动,业务用户理想选择。

- Pandas: 数据清洗、分析、洞察。

- 灵活导出: 用 CSV、Sheets 或数据库,按需选择。

最佳实践?选最适合你技术水平和业务需求的工具,灵活组合。想体验网页爬虫的高效,,或者访问 获取更多教程。

祝你抓取顺利,数据始终干净、结构化、可用!

常见问题

1. 用 Python 抓取网站数据最简单的方法是什么?

静态网站推荐用 Requests 获取 HTML,再用 Beautiful Soup 解析提取所需数据。动态网站则建议用 Selenium。

2. 什么时候用 Thunderbit 而不是 Python 代码?

如果你需要快速获取数据、不想写代码,或者要处理动态页面、子页面、数据一键导出到表格,Thunderbit 是最佳选择,特别适合业务用户和短平快项目。

3. 如何应对 JS 动态加载数据的网站?

用 Selenium(或 Playwright)自动化浏览器,或者直接用 Thunderbit 的浏览器/云端模式,自动处理 JS。

4. 抓取到的数据如何清洗和分析?

用 Pandas 导入数据,去重、处理缺失值、格式标准化,再用 groupby 或 describe 快速分析。

5. 网页爬虫是否合法、适合企业使用吗?

一般来说,抓取公开数据是合法的,但要遵守网站的服务条款和 robots.txt。不要抓取个人隐私数据,注意合规和礼貌。Thunderbit 和 Python 都支持合规抓取。

想提升数据能力? 或用 Python 实战,无论哪种方式,都能让你高效获取有价值的网页数据。

延伸阅读