Internet bây giờ không chỉ là “sân chơi số” nữa đâu – nó đã thành kho dữ liệu khổng lồ nhất hành tinh, nơi bất cứ phòng ban nào từ kinh doanh đến phân tích thị trường đều muốn khai thác triệt để. Nhưng nói thật nhé: tự đi thu thập dữ liệu web thủ công chẳng khác gì lắp ráp đồ IKEA mà không có sách hướng dẫn (và lúc nào cũng dư cả đống ốc vít). Khi doanh nghiệp ngày càng phụ thuộc vào thông tin thị trường theo thời gian thực, cập nhật giá đối thủ hay tìm kiếm khách hàng mới, nhu cầu về các công cụ thu thập dữ liệu web hiệu quả, ổn định chưa bao giờ “nóng” như bây giờ. Thực tế, gần để ra quyết định, và thị trường web scraping toàn cầu dự kiến sẽ .

Nếu bạn đã quá mệt với cảnh copy-dán thủ công, bỏ lỡ khách hàng tiềm năng, hoặc chỉ đơn giản muốn trải nghiệm sức mạnh tự động hóa, bạn đã đến đúng chỗ rồi đấy. Mình đã dành nhiều năm xây dựng và thử nghiệm các công cụ trích xuất dữ liệu web (và hiện đang dẫn dắt đội ngũ tại ), nên mình hiểu rõ một công cụ phù hợp có thể biến hàng giờ nhập liệu thành thao tác chỉ với hai cú nhấp chuột. Dù bạn là người không biết code muốn có kết quả ngay, hay là dev cần kiểm soát toàn diện, danh sách 10 công cụ thu thập dữ liệu web tốt nhất dưới đây sẽ giúp bạn tìm ra lựa chọn lý tưởng.

Vì sao chọn đúng công cụ thu thập dữ liệu lại quan trọng?

Thực tế là: sự khác biệt giữa một công cụ thu thập dữ liệu tốt và một công cụ “bình thường” không chỉ ở sự tiện lợi – mà còn ảnh hưởng trực tiếp đến tăng trưởng kinh doanh. Khi bạn tự động hóa việc trích xuất dữ liệu web, bạn không chỉ tiết kiệm thời gian (một người dùng trên G2 từng chia sẻ ), mà còn giảm sai sót, mở ra cơ hội mới và đảm bảo đội nhóm luôn làm việc với dữ liệu mới nhất, chính xác nhất. Nghiên cứu thủ công vừa chậm, dễ lỗi, lại thường lỗi thời khi hoàn thành. Với công cụ phù hợp, bạn có thể theo dõi đối thủ, cập nhật giá, hoặc xây dựng danh sách khách hàng chỉ trong vài phút – thay vì vài ngày.

Ví dụ thực tế: một nhà bán lẻ mỹ phẩm đã dùng web scraping để theo dõi tồn kho và giá của đối thủ, . Đó là kết quả mà bạn không thể đạt được chỉ với bảng tính và công sức thủ công.

Tiêu chí đánh giá các công cụ thu thập dữ liệu web tốt nhất

Với cả “rừng” lựa chọn ngoài kia, chọn đúng công cụ cũng giống như đi “hẹn hò tốc độ” ở hội nghị công nghệ vậy. Đây là các tiêu chí mình dùng để chọn ra những cái tên xuất sắc nhất:

- Dễ sử dụng: Có thể bắt đầu mà không cần biết code không? Giao diện có trực quan, AI có hỗ trợ cho người không chuyên không?

- Khả năng tự động hóa: Công cụ có xử lý được phân trang, subpage, nội dung động và lên lịch không? Có thể chạy trên cloud cho các dự án lớn không?

- Giá cả & khả năng mở rộng: Có gói miễn phí hoặc giá khởi điểm hợp lý không? Khi nhu cầu tăng thì chi phí có “leo thang” không?

- Tính năng & tích hợp: Có xuất dữ liệu ra Excel, Google Sheets, API không? Có template, lên lịch, hoặc làm sạch dữ liệu tích hợp không?

- Phù hợp với ai: Công cụ này dành cho ai – doanh nghiệp, dev hay đội nhóm lớn?

Mình cũng đã tổng hợp bảng so sánh nhanh ở cuối bài để bạn dễ đối chiếu.

Giờ thì cùng mình khám phá top 10 công cụ thu thập dữ liệu web hiệu quả nhất năm 2025 nhé!

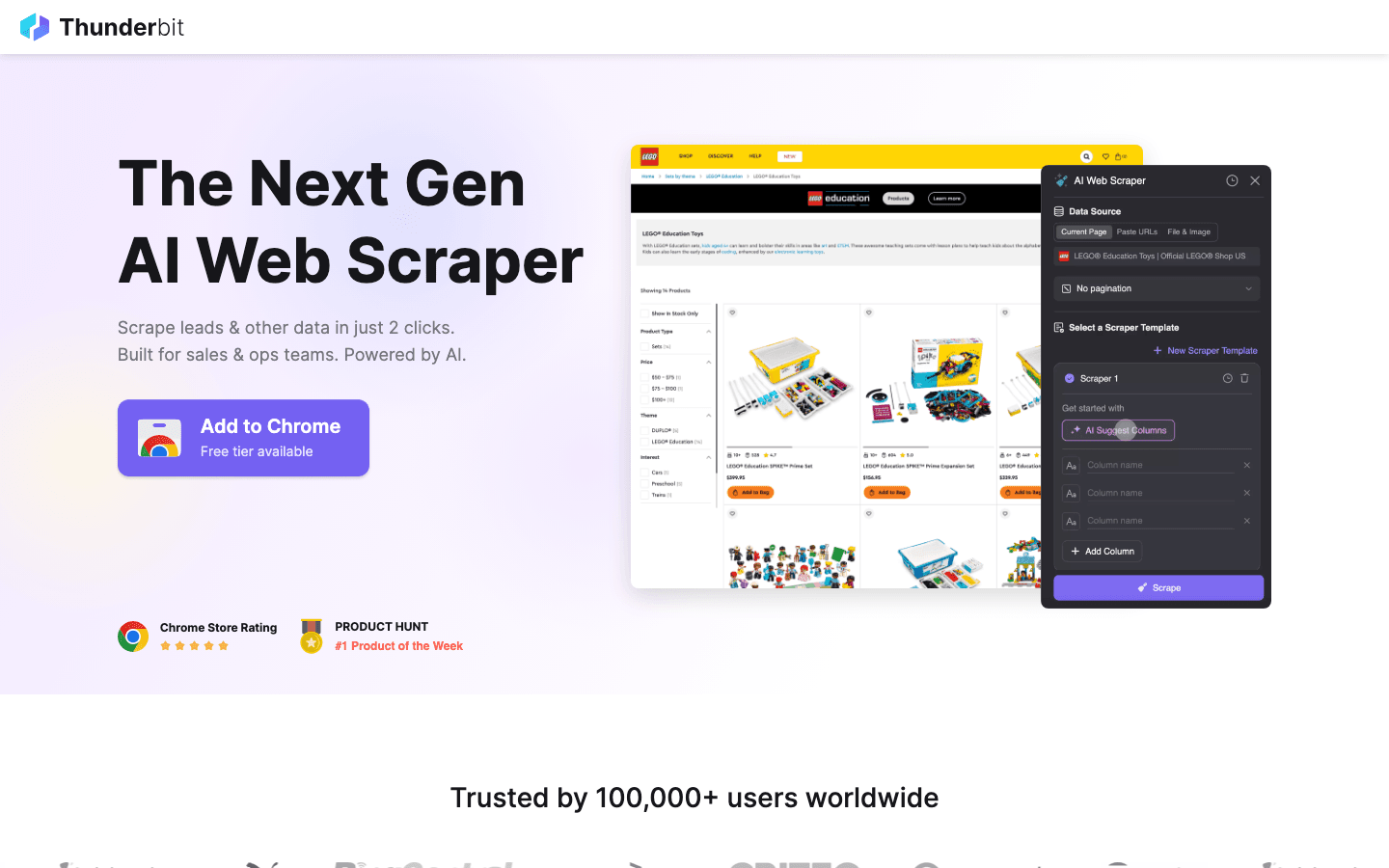

1. Thunderbit

là lựa chọn số 1 của mình cho bất kỳ ai muốn thu thập dữ liệu web dễ như đặt đồ ăn online. Được phát triển dưới dạng tiện ích Chrome tích hợp AI, Thunderbit nổi bật với trích xuất dữ liệu chỉ 2 bước: nhấn “AI Gợi ý trường dữ liệu”, để AI tự động nhận diện thông tin trên trang, rồi nhấn “Trích xuất” để lấy dữ liệu. Không cần code, không phải chỉnh selector – kết quả có ngay lập tức.

là lựa chọn số 1 của mình cho bất kỳ ai muốn thu thập dữ liệu web dễ như đặt đồ ăn online. Được phát triển dưới dạng tiện ích Chrome tích hợp AI, Thunderbit nổi bật với trích xuất dữ liệu chỉ 2 bước: nhấn “AI Gợi ý trường dữ liệu”, để AI tự động nhận diện thông tin trên trang, rồi nhấn “Trích xuất” để lấy dữ liệu. Không cần code, không phải chỉnh selector – kết quả có ngay lập tức.

Điều gì khiến Thunderbit được các đội kinh doanh, marketing và TMĐT cực kỳ ưa chuộng? Công cụ này thiết kế sát với quy trình thực tế:

- AI Gợi ý trường dữ liệu: AI đọc trang và đề xuất các cột phù hợp – tên, giá, email, v.v.

- Trích xuất subpage: Cần thêm chi tiết? Thunderbit tự động truy cập từng subpage (như chi tiết sản phẩm hoặc hồ sơ LinkedIn) và bổ sung vào bảng dữ liệu.

- Xuất dữ liệu tức thì: Đẩy dữ liệu trực tiếp sang Excel, Google Sheets, Airtable hoặc Notion. Tất cả đều miễn phí.

- Template một chạm: Với các trang phổ biến (Amazon, Zillow, Instagram), bạn có thể dùng template có sẵn để tiết kiệm thời gian.

- Xuất dữ liệu miễn phí: Không bị giới hạn khi lấy dữ liệu ra ngoài.

- Lên lịch tự động: Đặt lịch chạy định kỳ bằng tiếng Anh đơn giản (“mỗi thứ Hai lúc 9h sáng”) – lý tưởng để theo dõi giá hoặc cập nhật khách hàng hàng tuần.

Thunderbit sử dụng hệ thống credit (1 credit = 1 dòng), với cho tối đa 6 trang (hoặc 10 trang nếu dùng thử). Gói trả phí bắt đầu từ $15/tháng cho 500 credit, phù hợp cho mọi quy mô đội nhóm.

Muốn xem Thunderbit hoạt động thực tế? Ghé hoặc của tụi mình nhé. Đây là công cụ mà mình ước gì đã có từ hồi còn phải nhập liệu thủ công.

2. Octoparse

là “ông lớn” trong làng thu thập dữ liệu web, đặc biệt phù hợp với doanh nghiệp cần sức mạnh xử lý lớn. Công cụ này có giao diện trực quan trên desktop (Windows và Mac), cho phép bạn xây dựng quy trình trích xuất chỉ bằng thao tác chuột – không cần code. Đừng để giao diện thân thiện đánh lừa: Octoparse xử lý được cả đăng nhập, cuộn vô hạn, proxy xoay vòng và thậm chí vượt qua CAPTCHA.

là “ông lớn” trong làng thu thập dữ liệu web, đặc biệt phù hợp với doanh nghiệp cần sức mạnh xử lý lớn. Công cụ này có giao diện trực quan trên desktop (Windows và Mac), cho phép bạn xây dựng quy trình trích xuất chỉ bằng thao tác chuột – không cần code. Đừng để giao diện thân thiện đánh lừa: Octoparse xử lý được cả đăng nhập, cuộn vô hạn, proxy xoay vòng và thậm chí vượt qua CAPTCHA.

- 500+ Template dựng sẵn: Bắt đầu nhanh với template cho Amazon, Twitter, LinkedIn, v.v.

- Thu thập dữ liệu trên cloud: Chạy tác vụ trên server của Octoparse, lên lịch và mở rộng cho dự án lớn.

- API tích hợp: Đưa dữ liệu trực tiếp vào ứng dụng hoặc cơ sở dữ liệu của bạn.

- Tự động hóa nâng cao: Xử lý nội dung động, phân trang, quy trình nhiều bước.

Có cho tối đa 10 tác vụ, nhưng doanh nghiệp thường chọn gói Standard (~$83/tháng) hoặc Professional (~$299/tháng). Độ khó học cao hơn Thunderbit, nhưng nếu bạn cần thu thập hàng ngàn trang ổn định, Octoparse là ứng viên sáng giá.

3. Scrapy

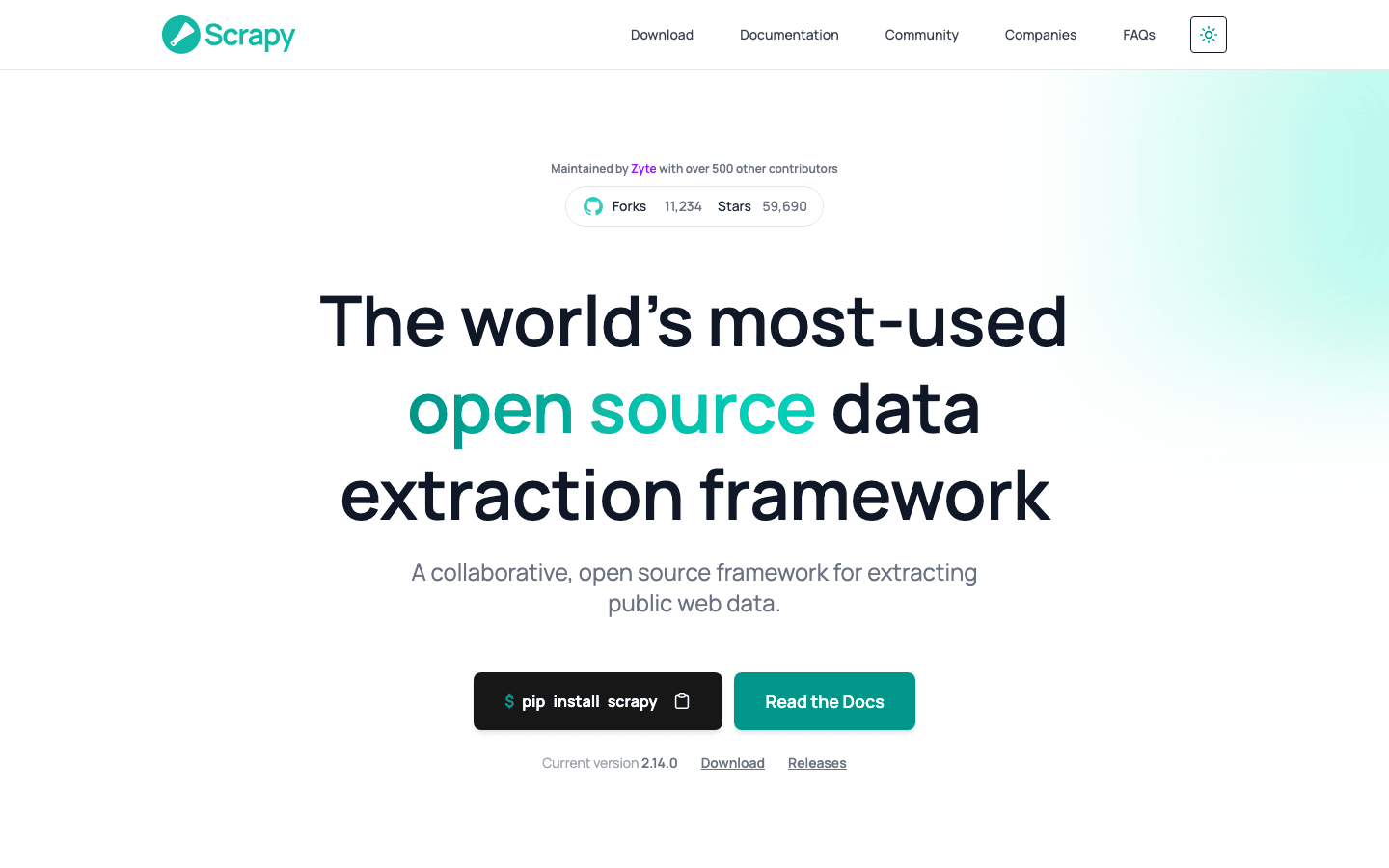

là “chuẩn vàng” cho dev muốn kiểm soát toàn diện dự án thu thập dữ liệu. Đây là framework Python mã nguồn mở, cho phép bạn lập trình spider (trình thu thập) tùy chỉnh cho bất kỳ website nào. Nếu bạn tưởng tượng được, Scrapy đều có thể làm được.

là “chuẩn vàng” cho dev muốn kiểm soát toàn diện dự án thu thập dữ liệu. Đây là framework Python mã nguồn mở, cho phép bạn lập trình spider (trình thu thập) tùy chỉnh cho bất kỳ website nào. Nếu bạn tưởng tượng được, Scrapy đều có thể làm được.

- Lập trình toàn diện: Viết code Python để xác định cách thu thập và phân tích dữ liệu.

- Xử lý song song, tốc độ cao: Thu thập hàng ngàn trang cùng lúc cho dự án lớn.

- Mở rộng linh hoạt: Thêm middleware cho proxy, trình duyệt headless hoặc logic tùy chỉnh.

- Cộng đồng mạnh: Nhiều tài liệu, plugin và hỗ trợ cho các trường hợp phức tạp.

Scrapy miễn phí, mã nguồn mở, nhưng yêu cầu kỹ năng lập trình. Nếu bạn có đội ngũ kỹ thuật hoặc muốn xây dựng pipeline riêng, Scrapy là lựa chọn khó thay thế. Tuy nhiên, với người không biết code, đây là thử thách lớn.

4. ParseHub

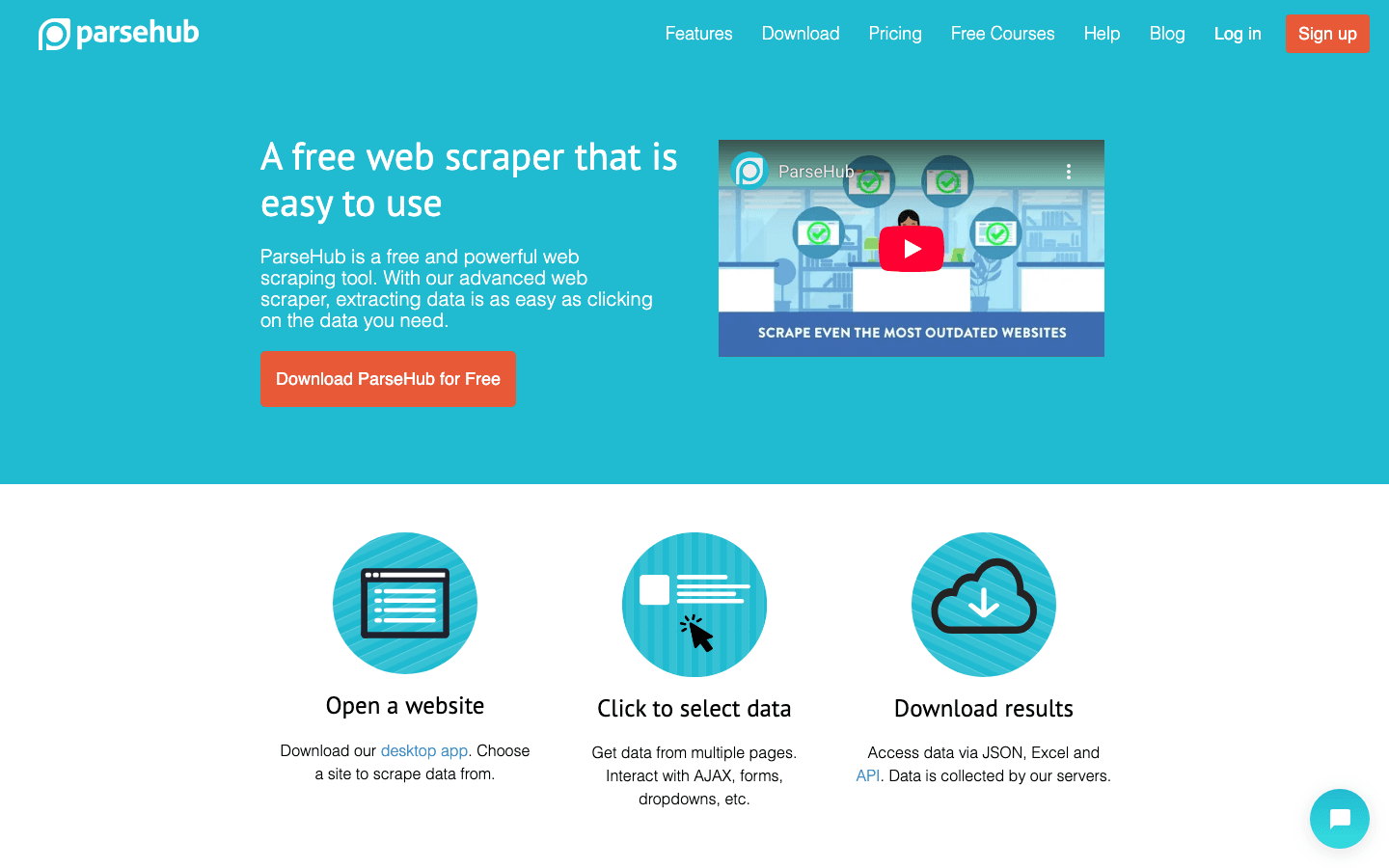

là công cụ trích xuất dữ liệu web trực quan, không cần code, lý tưởng cho người không chuyên khi gặp website phức tạp. Giao diện point-and-click cho phép bạn chọn dữ liệu, thiết lập hành động và xây dựng quy trình thu thập – kể cả với trang động hoặc điều hướng rắc rối.

là công cụ trích xuất dữ liệu web trực quan, không cần code, lý tưởng cho người không chuyên khi gặp website phức tạp. Giao diện point-and-click cho phép bạn chọn dữ liệu, thiết lập hành động và xây dựng quy trình thu thập – kể cả với trang động hoặc điều hướng rắc rối.

- Xây dựng quy trình trực quan: Chọn dữ liệu, thiết lập phân trang, xử lý popup hoặc dropdown dễ dàng.

- Xử lý nội dung động: Làm việc tốt với trang nhiều JavaScript, tương tác cao.

- Chạy trên cloud & lên lịch: Thu thập dữ liệu trên cloud, lên lịch định kỳ.

- Xuất ra CSV, Excel, API: Dễ dàng tích hợp với các công cụ quen thuộc.

ParseHub có gói miễn phí (5 dự án), gói trả phí bắt đầu từ . Giá cao hơn một số đối thủ, nhưng cách tiếp cận trực quan rất phù hợp cho nhà phân tích, marketer, nhà nghiên cứu cần nhiều hơn một tiện ích Chrome cơ bản.

5. Apify

vừa là nền tảng, vừa là chợ ứng dụng cho thu thập dữ liệu web. Apify cung cấp thư viện "Actor" (trình thu thập dựng sẵn) khổng lồ cho các trang phổ biến, đồng thời cho phép bạn xây dựng và chạy crawler tùy chỉnh trên cloud.

vừa là nền tảng, vừa là chợ ứng dụng cho thu thập dữ liệu web. Apify cung cấp thư viện "Actor" (trình thu thập dựng sẵn) khổng lồ cho các trang phổ biến, đồng thời cho phép bạn xây dựng và chạy crawler tùy chỉnh trên cloud.

- 5.000+ Actor dựng sẵn: Thu thập dữ liệu Google Maps, Amazon, Twitter, v.v. chỉ trong tích tắc.

- Lập trình tùy chỉnh: Lập trình viên có thể dùng JavaScript hoặc Python để xây dựng crawler nâng cao.

- Mở rộng trên cloud: Chạy song song, lên lịch, quản lý dữ liệu trên cloud.

- API & tích hợp: Đưa kết quả vào ứng dụng, quy trình hoặc pipeline dữ liệu.

Apify có , gói trả phí từ $29/tháng (tính theo thời gian xử lý). Có chút khó làm quen, nhưng nếu bạn muốn vừa dùng sẵn vừa tùy chỉnh sâu, Apify là lựa chọn mạnh mẽ.

6. Data Miner

là tiện ích Chrome dành cho những ai muốn thu thập dữ liệu nhanh, dựa trên template. Rất phù hợp cho người dùng doanh nghiệp cần lấy dữ liệu từ bảng hoặc danh sách mà không cần thiết lập phức tạp.

là tiện ích Chrome dành cho những ai muốn thu thập dữ liệu nhanh, dựa trên template. Rất phù hợp cho người dùng doanh nghiệp cần lấy dữ liệu từ bảng hoặc danh sách mà không cần thiết lập phức tạp.

- Thư viện template khổng lồ: Hơn 1.000 công thức cho các trang phổ biến (LinkedIn, Yelp, v.v.).

- Trích xuất point-and-click: Chọn template, xem trước dữ liệu, xuất ngay lập tức.

- Chạy trên trình duyệt: Hoạt động với phiên đăng nhập hiện tại – tiện lợi khi cần lấy dữ liệu sau đăng nhập.

- Xuất ra CSV hoặc Excel: Đưa dữ liệu vào bảng tính chỉ trong vài giây.

cho phép thu thập 500 trang/tháng, gói trả phí từ $20/tháng. Phù hợp cho các tác vụ nhỏ, nhanh hoặc khi cần dữ liệu ngay – nhưng không thích hợp cho dự án lớn hoặc tự động hóa phức tạp.

7. Import.io

là nền tảng cấp doanh nghiệp dành cho tổ chức cần tích hợp dữ liệu web liên tục, ổn định. Đây không chỉ là công cụ thu thập – mà còn là dịch vụ quản lý, cung cấp dữ liệu sạch, có cấu trúc trực tiếp vào hệ thống doanh nghiệp.

là nền tảng cấp doanh nghiệp dành cho tổ chức cần tích hợp dữ liệu web liên tục, ổn định. Đây không chỉ là công cụ thu thập – mà còn là dịch vụ quản lý, cung cấp dữ liệu sạch, có cấu trúc trực tiếp vào hệ thống doanh nghiệp.

- Trích xuất không cần code: Thiết lập trực quan để xác định dữ liệu cần lấy.

- Dữ liệu thời gian thực: Đẩy dữ liệu vào dashboard, công cụ phân tích hoặc cơ sở dữ liệu.

- Tuân thủ & ổn định: Xử lý xoay IP, chống bot, tuân thủ pháp lý.

- Dịch vụ quản lý: Đội ngũ Import.io có thể thiết lập và duy trì scraper cho bạn.

Giá , có dùng thử 14 ngày cho nền tảng SaaS. Nếu doanh nghiệp bạn cần dữ liệu web luôn mới (bán lẻ, tài chính, nghiên cứu thị trường), Import.io rất đáng cân nhắc.

8. WebHarvy

là phần mềm desktop cho người dùng Windows muốn giải pháp point-and-click mà không cần đăng ký thuê bao. Được ưa chuộng bởi doanh nghiệp nhỏ và cá nhân thích mua một lần dùng mãi.

là phần mềm desktop cho người dùng Windows muốn giải pháp point-and-click mà không cần đăng ký thuê bao. Được ưa chuộng bởi doanh nghiệp nhỏ và cá nhân thích mua một lần dùng mãi.

- Nhận diện mẫu trực quan: Chọn dữ liệu, WebHarvy tự động phát hiện mẫu lặp lại.

- Xử lý văn bản, hình ảnh, v.v.: Trích xuất mọi loại dữ liệu phổ biến, kể cả email và URL.

- Phân trang & lên lịch: Duyệt nhiều trang và thiết lập thu thập định kỳ.

- Xuất ra Excel, CSV, XML, JSON, SQL: Đáp ứng mọi quy trình làm việc.

Giấy phép cho một người dùng , rất tiết kiệm cho nhu cầu thường xuyên – lưu ý chỉ hỗ trợ Windows.

9. Mozenda

là nền tảng thu thập dữ liệu web trên cloud, phục vụ nhu cầu vận hành doanh nghiệp và dữ liệu liên tục. Kết hợp trình thiết kế trên desktop (Windows) với khả năng tự động hóa mạnh mẽ trên cloud.

là nền tảng thu thập dữ liệu web trên cloud, phục vụ nhu cầu vận hành doanh nghiệp và dữ liệu liên tục. Kết hợp trình thiết kế trên desktop (Windows) với khả năng tự động hóa mạnh mẽ trên cloud.

- Trình xây dựng tác vụ trực quan: Thiết kế quy trình trích xuất bằng thao tác chuột.

- Mở rộng trên cloud: Chạy nhiều tác vụ song song, lên lịch, quản lý dữ liệu tập trung.

- Bảng điều khiển dữ liệu: Kết hợp, lọc, làm sạch dữ liệu sau khi thu thập.

- Hỗ trợ doanh nghiệp: Quản lý tài khoản riêng và dịch vụ hỗ trợ cho đội nhóm lớn.

Gói cơ bản từ , các gói cao hơn cho nhiều người dùng và sức mạnh xử lý lớn. Mozenda lý tưởng cho doanh nghiệp cần dữ liệu web ổn định, lặp lại hàng ngày.

10. BeautifulSoup

là thư viện Python kinh điển để phân tích HTML và XML. Không phải là trình thu thập dữ liệu hoàn chỉnh, nhưng được dev cực kỳ yêu thích cho các dự án nhỏ, tùy chỉnh.

là thư viện Python kinh điển để phân tích HTML và XML. Không phải là trình thu thập dữ liệu hoàn chỉnh, nhưng được dev cực kỳ yêu thích cho các dự án nhỏ, tùy chỉnh.

- Phân tích HTML đơn giản: Dễ dàng lấy dữ liệu từ trang web tĩnh.

- Kết hợp với Python Requests: Dùng cùng thư viện khác để lấy và thu thập dữ liệu.

- Linh hoạt & nhẹ: Lý tưởng cho script nhanh hoặc dự án học tập.

- Cộng đồng lớn: Nhiều tài liệu, hướng dẫn trên Stack Overflow.

BeautifulSoup , nhưng bạn phải tự viết code và xử lý logic thu thập. Phù hợp cho lập trình viên hoặc người học muốn hiểu sâu về web scraping.

Bảng so sánh nhanh: Các công cụ thu thập dữ liệu web nổi bật

| Công cụ | Dễ sử dụng | Tự động hóa | Giá | Tùy chọn xuất dữ liệu | Phù hợp với |

|---|---|---|---|---|---|

| Thunderbit | Rất dễ, không cần code | Cao (AI, subpage) | Dùng thử miễn phí, từ $15/tháng | Excel, Sheets, Airtable, Notion, CSV | Kinh doanh, marketing, TMĐT, người không biết code |

| Octoparse | Trung bình, giao diện trực quan | Rất cao, cloud | Miễn phí, $83–$299/tháng | CSV, Excel, JSON, API | Doanh nghiệp, đội dữ liệu, trang động |

| Scrapy | Thấp (cần Python) | Cao (tùy chỉnh) | Miễn phí, mã nguồn mở | Tùy ý (qua code) | Lập trình viên, dự án lớn, tùy chỉnh |

| ParseHub | Cao, trực quan | Cao (trang động) | Miễn phí, từ $189/tháng | CSV, Excel, JSON, API | Người không biết code, cấu trúc web phức tạp |

| Apify | Trung bình, linh hoạt | Rất cao, cloud | Miễn phí, $29–$999/tháng | CSV, JSON, API, lưu trữ cloud | Dev, doanh nghiệp, actor dựng sẵn/tùy chỉnh |

| Data Miner | Rất dễ, trình duyệt | Thấp (thủ công) | Miễn phí, $20–$99/tháng | CSV, Excel | Tác vụ nhanh, nhỏ, trích xuất tức thì |

| Import.io | Trung bình, dịch vụ | Rất cao, doanh nghiệp | Giá tùy chỉnh theo khối lượng | CSV, JSON, API, tích hợp trực tiếp | Doanh nghiệp, tích hợp dữ liệu liên tục |

| WebHarvy | Cao, desktop | Trung bình (lên lịch) | $129 mua một lần | Excel, CSV, XML, JSON, SQL | Doanh nghiệp nhỏ, người dùng Windows, thường xuyên |

| Mozenda | Trung bình, trực quan | Rất cao, cloud | $250–$450+/tháng | CSV, Excel, JSON, cloud, DB | Vận hành doanh nghiệp, dữ liệu lớn, lặp lại |

| BeautifulSoup | Thấp (cần Python) | Thấp (code thủ công) | Miễn phí, mã nguồn mở | Tùy ý (qua code) | Lập trình viên, người học, script nhỏ |

Cách chọn công cụ thu thập dữ liệu phù hợp cho đội nhóm

Chọn công cụ thu thập dữ liệu tốt nhất không phải là chọn cái “xịn nhất” – mà là chọn cái hợp với kỹ năng, nhu cầu và ngân sách của đội nhóm. Gợi ý nhanh của mình:

- Người không biết code hoặc người dùng doanh nghiệp: Bắt đầu với Thunderbit, ParseHub hoặc Data Miner để có kết quả nhanh, dễ thiết lập.

- Doanh nghiệp hoặc nhu cầu lớn: Xem xét Octoparse, Mozenda hoặc Import.io để tự động hóa, lên lịch và được hỗ trợ.

- Lập trình viên hoặc dự án tùy chỉnh: Scrapy, Apify hoặc BeautifulSoup cho phép kiểm soát và linh hoạt tối đa.

- Ngân sách hạn chế hoặc tác vụ nhỏ: WebHarvy (Windows) hoặc Data Miner (trình duyệt) vừa tiết kiệm vừa đơn giản.

Luôn thử nghiệm các lựa chọn hàng đầu với website mục tiêu thực tế – vì công cụ hoạt động tốt ở trang này có thể không hiệu quả ở trang khác. Đừng quên cân nhắc tích hợp: nếu bạn cần dữ liệu vào Sheets, Notion hoặc database, hãy đảm bảo công cụ hỗ trợ sẵn.

Kết luận: Tối ưu giá trị kinh doanh với công cụ thu thập dữ liệu web

Dữ liệu web là “dầu mỏ mới” – nhưng chỉ khi bạn có công cụ phù hợp để khai thác và tinh lọc. Với các công cụ hiện đại, bạn có thể biến hàng giờ nghiên cứu thủ công thành vài phút phân tích tự động – thúc đẩy bán hàng thông minh, marketing hiệu quả và vận hành linh hoạt hơn. Dù bạn xây dựng danh sách khách hàng, theo dõi đối thủ hay chỉ đơn giản là muốn thoát khỏi cảnh copy-dán, chắc chắn sẽ có công cụ trong danh sách này giúp bạn tiết kiệm thời gian đáng kể.

Hãy xem xét nhu cầu đội nhóm, thử nghiệm một vài công cụ và cảm nhận sự khác biệt khi để tự động hóa “gánh vác” phần việc nặng nhọc. Nếu muốn trải nghiệm trích xuất dữ liệu AI chỉ với 2 cú nhấp chuột, . Chúc bạn thu thập dữ liệu hiệu quả – và luôn có dữ liệu mới, sạch, sẵn sàng sử dụng.

Câu hỏi thường gặp

1. Công cụ thu thập dữ liệu web là gì và tại sao tôi cần nó?

Công cụ thu thập dữ liệu web giúp tự động lấy thông tin từ website. Nó tiết kiệm thời gian, giảm sai sót và giúp đội nhóm có dữ liệu mới nhất cho bán hàng, marketing, nghiên cứu, vận hành – hiệu quả hơn nhiều so với copy-dán thủ công.

2. Công cụ nào phù hợp nhất cho người không biết kỹ thuật?

Thunderbit, ParseHub và Data Miner là lựa chọn hàng đầu cho người không biết code. Thunderbit nổi bật với quy trình AI chỉ 2 bước, còn ParseHub phù hợp với website phức tạp nhờ giao diện trực quan.

3. Các mô hình giá của công cụ thu thập dữ liệu khác nhau thế nào?

Giá rất đa dạng: một số công cụ (như Thunderbit, Data Miner) có gói miễn phí và giá hợp lý hàng tháng, trong khi nền tảng doanh nghiệp (Import.io, Mozenda) tính phí tùy chỉnh hoặc theo khối lượng. Hãy kiểm tra kỹ chi phí có phù hợp nhu cầu dữ liệu của bạn không.

4. Tôi có thể dùng các công cụ này để thu thập dữ liệu định kỳ không?

Có – các công cụ như Thunderbit, Octoparse, Apify, Mozenda và Import.io đều hỗ trợ thu thập dữ liệu theo lịch, rất phù hợp để theo dõi giá, tìm khách hàng hoặc nghiên cứu thị trường liên tục.

5. Tôi nên cân nhắc gì trước khi chọn công cụ thu thập dữ liệu?

Hãy xem xét kỹ năng kỹ thuật của đội nhóm, độ phức tạp của website cần thu thập, khối lượng dữ liệu, nhu cầu tích hợp và ngân sách. Nên thử nghiệm với tác vụ thực tế trước khi mua gói trả phí.

Để tìm hiểu sâu hơn và xem các hướng dẫn thực tế, hãy ghé .

Tìm hiểu thêm