Já parou pra pensar como o Google sabe praticamente tudo sobre todos os sites do planeta, ou como aquele site de comparação de preços consegue mostrar ofertas atualizadas em tempo real? Por trás dessas facilidades, verdadeiros exércitos de “aranhas” digitais estão rodando pela internet 24 horas por dia, mapeando esse labirinto online pra que a gente encontre o que precisa em segundos. Hoje em dia, quase metade do tráfego da internet vem de bots—principalmente crawlers—que trabalham nos bastidores coletando, indexando e organizando informações pra buscadores, modelos de IA e empresas ().

Trabalhando há anos com automação e IA na Thunderbit, vi de perto como entender o que são crawlers pode ser um baita diferencial pra qualquer negócio. Seja em vendas, e-commerce ou operações, saber o que são crawlers—e como soluções modernas com IA, tipo a , funcionam—pode abrir portas pra novos dados, automatizar pesquisas e colocar sua empresa na frente da concorrência. Bora entender como esses robôs digitais funcionam e por que eles são mais importantes do que nunca.

O que são Crawlers? Conceito Básico

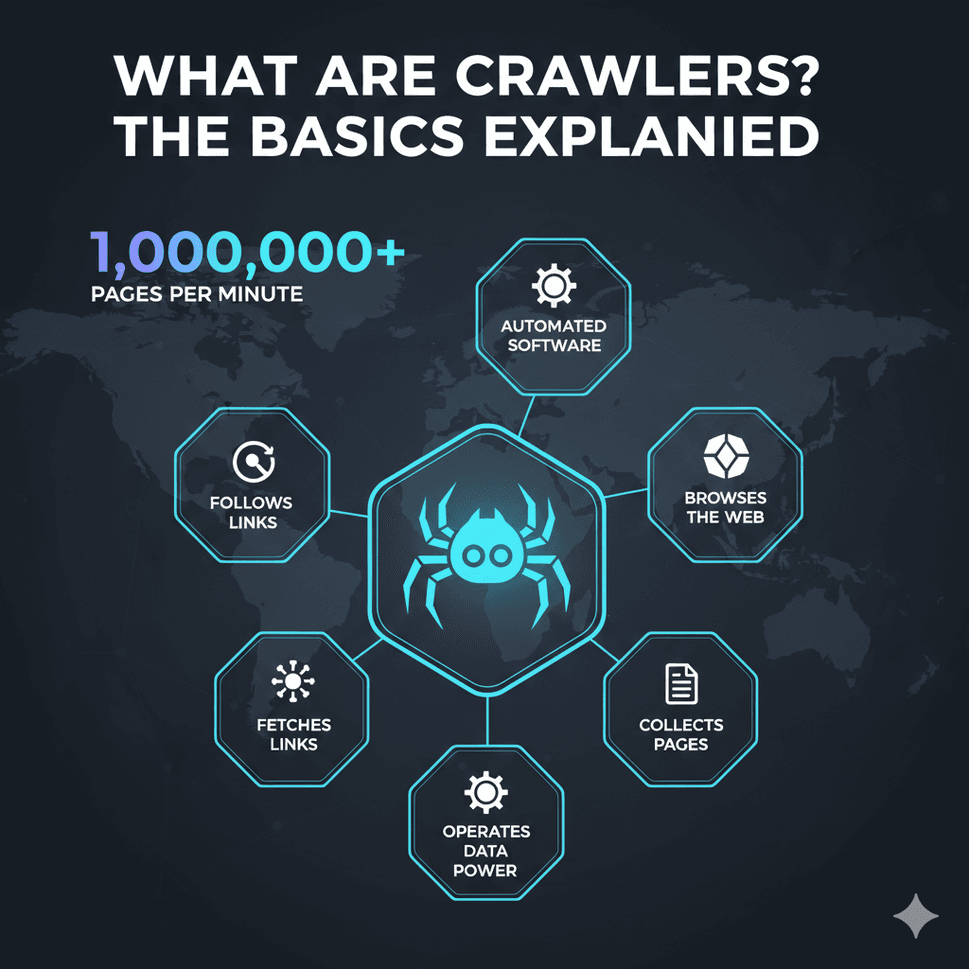

Mas afinal, o que são crawlers? De um jeito simples, um crawler (também chamado de spider ou bot) é um programa que navega automaticamente pela web, acessando páginas, seguindo links e coletando informações. Pensa nos crawlers como bibliotecários incansáveis da internet: eles visitam sites, leem o conteúdo e catalogam tudo pra facilitar buscas futuras (, ).

Pra ilustrar: imagina a web como uma cidade gigante, e os crawlers como mensageiros que começam em um endereço, anotam tudo o que encontram e seguem cada placa (hiperlink) pro próximo lugar. Eles repetem isso sem parar, construindo um mapa gigante e pesquisável da internet.

Entre os crawlers mais famosos estão o Googlebot (do Google), Bingbot (do Bing) e os novos bots de IA como o GPTBot (usado pela OpenAI). Esses robôs são responsáveis por indexar centenas de bilhões de páginas—só o índice do Google já passa de 100 milhões de gigabytes (). Sem crawlers, buscadores, assistentes de IA e várias ferramentas de negócios simplesmente não existiriam.

Por que Crawlers são Importantes: Funções e Aplicações nos Negócios

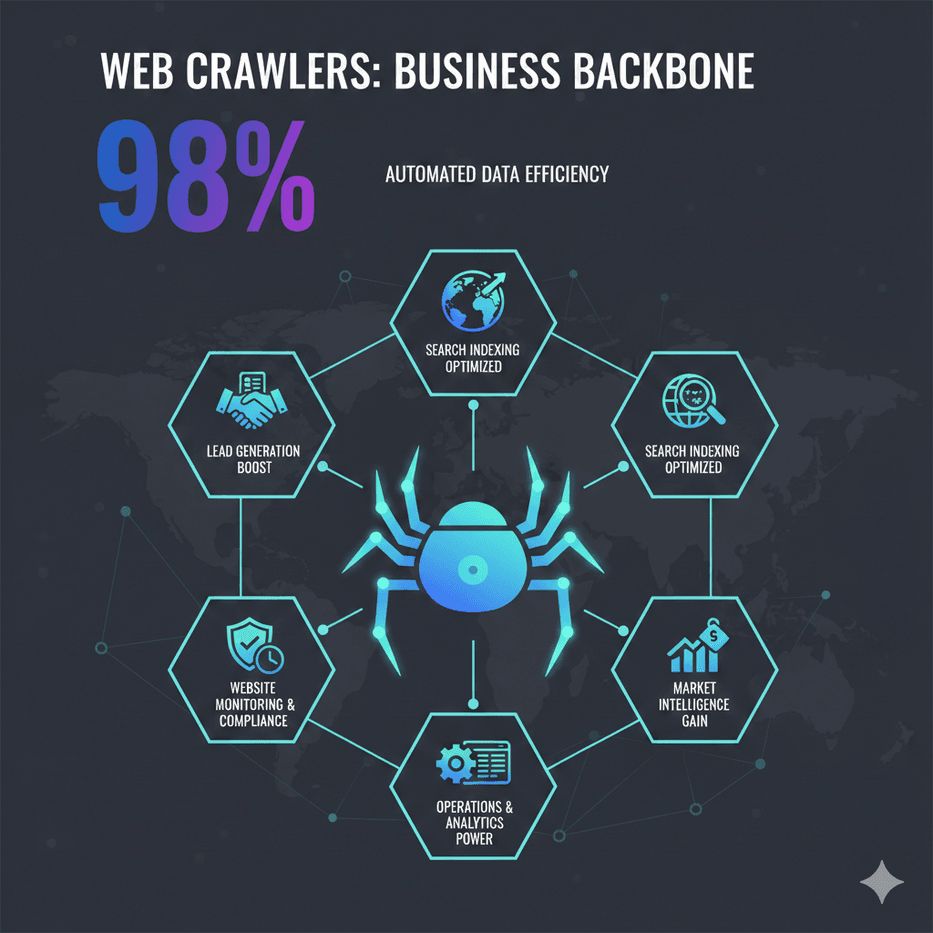

Crawlers não servem só pra buscadores—eles são a base de muitos processos modernos nas empresas. Olha só algumas das principais funções:

- Indexação pra Buscadores: Crawlers vasculham a web pra que buscadores entreguem resultados relevantes em segundos. Se seu site não for rastreado, não aparece no Google ou Bing ().

- Extração de Dados & Inteligência de Mercado: Empresas usam crawlers (e raspadores) pra coletar preços de concorrentes, detalhes de produtos, avaliações e muito mais. Por exemplo, a varejista britânica John Lewis aumentou as vendas em 4% usando crawlers pra monitorar preços da concorrência, enquanto a ASOS dobrou as vendas internacionais aproveitando dados regionais da web ().

- Monitoramento de Sites & Compliance: Crawlers podem monitorar seu próprio site ou o de concorrentes pra detectar mudanças—como lançamentos de produtos, atualizações de preços ou verificações de conformidade.

- Geração de Leads: Equipes de vendas usam crawlers pra coletar contatos em diretórios ou listas de empresas, automatizando tarefas que antes levavam horas.

- Operações & Analytics: Desde o acompanhamento de estoques até a agregação de anúncios imobiliários, crawlers alimentam dashboards e ferramentas analíticas, ajudando a tomar decisões mais inteligentes.

Dá uma olhada nesse resumo dos usos de crawlers em diferentes áreas de negócio:

| Equipe/Função | Uso de Crawler | Benefício Obtido |

|---|---|---|

| Vendas & Geração de Leads | Coletar contatos em sites ou diretórios | Criação automática de listas de leads; crescimento do funil sem digitação manual |

| Marketing/Pesquisa | Monitorar sites de concorrentes e avaliações online | Inteligência de mercado em tempo real; estratégias mais informadas |

| E-commerce & Varejo | Raspagem de preços e monitoramento de produtos em sites concorrentes | Precificação dinâmica; melhores margens e receitas |

| Operações/Produto | Detecção de mudanças em sites para compliance ou atualizações | Controle de qualidade; resposta rápida a mudanças externas |

| Analytics & IA | Coleta de dados em larga escala para análises ou treinamento de IA | Insights baseados em dados; material para machine learning |

()

Como Funcionam os Crawlers? Passo a Passo

Apesar de parecerem super avançados, o funcionamento básico de um crawler é bem direto ():

- URLs de Origem: O crawler começa com uma lista inicial de endereços (os “seeds”). Pode ser a página inicial, um sitemap ou uma lista que você mesmo fornece.

- Acesso às Páginas: O crawler visita cada URL, baixando o HTML da página (igualzinho ao que seu navegador faz).

- Leitura & Extração: Ele lê a página, extrai informações úteis (texto, metadados, links) e anota todos os hiperlinks encontrados.

- Armazenamento & Indexação: Os dados extraídos são salvos em um banco de dados ou índice—organizados pra buscas ou análises.

- Seguindo Links: Todos os novos links são adicionados à fila, e o crawler repete o processo, explorando a web sem parar.

Os crawlers modernos são educados: eles checam o arquivo robots.txt do site pra saber o que podem acessar e controlam a frequência dos acessos pra não sobrecarregar servidores (). Buscadores ainda usam “crawl budgets” pra decidir com que frequência revisitar um site, priorizando páginas importantes ou que mudam bastante.

Crawlers vs. Scrapers: Qual a Diferença?

Muita gente confunde “crawling” com “scraping”, mas tem uma diferença importante ():

- Crawling é sobre descobrir e indexar o máximo de páginas possível (mapear a web).

- Scraping é sobre extrair dados específicos de páginas-alvo (tipo pegar preços de um produto).

Na prática, os dois costumam andar juntos: você pode usar crawling pra encontrar todas as páginas de produtos e scraping pra extrair detalhes como preço e estoque. Entender essa diferença ajuda a escolher a ferramenta certa pra cada situação.

Tipos de Crawlers: De Buscadores a Bots com IA

Nem todo crawler é igual. Olha só os principais tipos que você pode encontrar ():

- Crawlers de Buscadores: Os gigantes como Googlebot, Bingbot, Baidu Spider e Yandex Bot. O objetivo deles é indexar toda a web pra buscas.

- Crawlers Focados: Feitos pra buscar páginas sobre um tema específico (tipo só sites de empregos ou notícias sobre “mudanças climáticas”).

- Crawlers Incrementais: Otimizados pra detectar e buscar só conteúdo novo ou atualizado, economizando tempo e banda.

- Crawlers de Deep Web: Criados pra acessar conteúdos atrás de formulários, logins ou páginas escondidas.

- Crawlers de Auditoria de Sites: Ferramentas como Screaming Frog ou Site Audit do SEMrush, usadas pra rastrear seu próprio site pra SEO ou controle de qualidade.

- Crawlers de Monitoramento/Comparação: Usados por empresas pra acompanhar preços de concorrentes, mudanças em produtos ou compliance em sites específicos.

- Crawlers com IA: Os mais novos—como o GPTBot da OpenAI ou o CCBot do Common Crawl—projetados pra coletar dados pra IA ou usar IA pra decidir o que e como rastrear ().

Os crawlers com IA estão mudando o jogo rapidinho. Em 2025, bots ligados à IA já representam cerca de 30% do tráfego web—e esse número só cresce ().

Desafios dos Crawlers Tradicionais e Soluções Modernas

Com a web cada vez mais complexa, crawlers tradicionais enfrentam vários desafios:

- Defesas Anti-Crawling: CAPTCHAs, bloqueios de IP, limites de acesso e fingerprinting de navegador podem barrar bots antigos. Mais de 95% das falhas em scraping são causadas por medidas anti-bot ().

- Conteúdo Dinâmico: Muitos sites carregam dados via JavaScript ou rolagem infinita, o que crawlers básicos não conseguem lidar. Hoje, browsers headless e IA são essenciais ().

- Mudanças Frequentes nos Sites: Se um site muda o layout, scrapers tradicionais quebram e exigem manutenção manual constante.

- Escala e Velocidade: Rastrear milhões de páginas rápido exige sistemas distribuídos e infraestrutura em nuvem—bem além do que um PC comum aguenta.

- Questões Legais e Éticas: Respeitar o

robots.txt, leis de privacidade e termos de uso é mais importante do que nunca.

Ferramentas modernas—incluindo soluções com IA—estão superando esses obstáculos. Elas usam machine learning pra se adaptar a layouts novos, simulam navegadores reais e até interpretam páginas como um humano faria. Por exemplo, raspadores com IA já conseguem extrair dados de PDFs, imagens ou páginas fora do padrão, ficando muito mais flexíveis e resistentes.

Thunderbit: Crawlers Otimizados pra Web Diversificada de Hoje

É aí que entra a Thunderbit. Na , desenvolvemos um crawler e raspador web com IA, pensado pra web dinâmica e imprevisível de 2025. Nosso objetivo? Tornar dados da web acessíveis pra todo mundo, não só pra quem manja de programação.

O que faz a Thunderbit ser diferente?

- Simplicidade com IA: Só clicar em “Sugerir Campos com IA” e a IA da Thunderbit analisa a página, sugere as melhores colunas (tipo “Nome do Produto”, “Preço”, “Avaliação”) e já configura a extração pra você. Sem códigos, sem mexer em HTML—é só clicar e pronto ().

- Lida com Páginas Complexas e de Nicho: A IA da Thunderbit se adapta a layouts diferentes, conteúdo dinâmico e até páginas fora do padrão. É ótima pra extrair dados de sites de nicho ou páginas que quebram raspadores tradicionais.

- Crawling de Subpáginas e Paginação: Precisa de detalhes de todas as páginas de produtos de uma categoria? A Thunderbit segue links automaticamente, rastreia subpáginas e junta tudo em uma tabela—sem configuração manual ().

- Modos Nuvem & Navegador: Escolha entre raspagem rápida na nuvem pra sites públicos ou modo navegador pra sites que exigem login ou proteção extra.

- Exportação de Dados Gratuita: Exporte seus dados direto pra Excel, Google Sheets, Airtable ou Notion—sem taxas escondidas ().

- Sem Código, Pronto pra Negócios: A Thunderbit foi feita pra usuários de negócios—vendas, marketing, e-commerce e operações—que querem resultado, não aprender programação.

Thunderbit vs. Crawlers Tradicionais: Comparativo de Recursos

Veja como a Thunderbit se sai em relação às ferramentas tradicionais:

| Recurso | Thunderbit (Com IA) | Crawlers/Raspadores Tradicionais |

|---|---|---|

| Tempo de Configuração | Configuração em 2 cliques com IA | Configuração manual, curva de aprendizado |

| Adaptabilidade | IA se ajusta a mudanças no site | Quebra com alterações de layout |

| Lida com Conteúdo Dinâmico | Sim (IA & navegador headless) | Limitado ou exige configuração manual |

| Crawling de Subpáginas/Paginação | Integrado, automático | Requer scripts manuais |

| Exportação de Dados | Grátis para Excel, Sheets, Notion | Muitas vezes pago ou limitado |

| Habilidade Técnica Necessária | Nenhuma (sem código) | Exige programação ou conhecimento técnico |

| Manutenção | Mínima (IA reaprende) | Correções manuais frequentes |

| Modelos para Sites Populares | 1 clique, sempre atualizados | Modelos compartilhados, podem estar desatualizados |

| Preço | Plano gratuito e opções acessíveis | Geralmente caro para recursos completos |

()

Por Dentro da Thunderbit: Recursos Inovadores que Facilitam o Crawling

Olha só alguns diferenciais da Thunderbit:

- Sugerir Campos com IA: Meu recurso favorito. Com um clique, a IA da Thunderbit lê a página, sugere as colunas mais relevantes e até cria prompts de extração. Chega de adivinhar seletores ou nomes de campos.

- Crawling de Subpáginas: Depois de raspar uma página de lista, é só clicar em “Raspar Subpáginas” e a Thunderbit visita cada link (tipo detalhes de produtos), enriquecendo sua tabela automaticamente.

- Modelos Instantâneos: Pra sites populares (Amazon, Zillow, Instagram, Shopify), a Thunderbit oferece modelos prontos—sem configuração, só resultado.

- Extratores Gratuitos de Email, Telefone e Imagem: Precisa pegar todos os emails ou imagens de uma página? A Thunderbit faz isso em um clique, de graça.

- Raspagem Agendada: Programe coletas recorrentes (diárias, semanais, etc.) usando linguagem natural. Perfeito pra monitorar preços ou pesquisas regulares.

- Raspagem em Nuvem ou Navegador: Escolha o modo que mais faz sentido—nuvem pra velocidade, navegador pra sites mais chatos.

A Thunderbit já é usada por mais de 30.000 pessoas no mundo todo, de empreendedores solo a grandes equipes (). E sim, tem um pra você testar sem compromisso.

Gerenciando o Acesso de Crawlers: Boas Práticas pra Empresas

Seja você dono de site ou usuário de crawlers, gerenciar o acesso é fundamental:

Pra Donos de Sites:

- Use o

robots.txtpra definir regras—bloqueie áreas sensíveis, permita bots de busca, bloqueie crawlers indesejados (). - Adicione meta tags (

noindex,nofollow) pra controlar o que será indexado. - Monitore o tráfego de bots e ajuste a frequência de rastreamento se precisar.

- Equilibre SEO (visibilidade) com proteção de conteúdo—não bloqueie os bots que você quer (tipo o Googlebot).

Pra Empresas que Usam Crawlers:

- Sempre respeite o

robots.txte os termos do site—crawling ético é essencial. - Identifique seu bot com um user-agent claro.

- Controle a frequência dos acessos pra não sobrecarregar servidores.

- Use APIs quando disponíveis e só raspe dados públicos.

- Monitore o impacto do seu crawler e ajuste conforme necessário.

Conclusão: O Papel dos Crawlers na Estratégia de Dados das Empresas

Os crawlers evoluíram de simples “aranhas” pra espinha dorsal de buscas, IA e inteligência de negócios. No mundo atual, movido a dados, entender o que são crawlers—e como usar ferramentas modernas com IA como a Thunderbit—pode abrir novas oportunidades pra qualquer equipe. Seja pra impulsionar o SEO, automatizar pesquisas ou criar pipelines de vendas mais inteligentes, crawlers são aliados invisíveis.

E à medida que a web cresce e muda, as empresas que mais se destacam são as que abraçam essas ferramentas—de forma responsável e criativa. Se quiser ver o que o crawling com IA pode fazer pelo seu negócio, e comece a explorar. Pra mais dicas e guias práticos, acesse o .

Perguntas Frequentes

1. O que é um crawler, em linguagem simples?

Crawler é um programa que navega automaticamente pela internet, visitando sites, seguindo links e coletando informações. Pensa nele como um bibliotecário digital que cataloga páginas pra buscadores ou uso empresarial.

2. Qual a diferença entre crawlers e scrapers?

Crawlers focam em descobrir e indexar o máximo de páginas possível (mapear a web), enquanto scrapers extraem dados específicos de páginas-alvo. Na prática, eles costumam trabalhar juntos—crawling pra encontrar páginas, scraping pra pegar os detalhes.

3. Por que empresas usam crawlers?

Empresas usam crawlers pra tudo: garantir que o site seja indexado (SEO), monitorar concorrentes, gerar leads, fazer pesquisas de mercado e automatizar a coleta de dados pra analytics ou IA.

4. Quais desafios crawlers tradicionais enfrentam?

Crawlers tradicionais têm dificuldades com defesas anti-bot (CAPTCHAs, bloqueios de IP), conteúdo dinâmico (JavaScript, rolagem infinita), mudanças frequentes nos sites e questões legais/éticas. Ferramentas modernas com IA, como a Thunderbit, foram criadas pra superar esses obstáculos.

5. Como a Thunderbit facilita o crawling pra empresas?

A Thunderbit usa IA pra reconhecer automaticamente a estrutura das páginas, sugerir campos de dados e lidar com tarefas complexas como crawling de subpáginas e conteúdo dinâmico. É sem código, fácil de configurar e exporta dados direto pras suas ferramentas favoritas—tornando dados web acessíveis pra todo mundo, não só pra desenvolvedores.

Pronto pra colocar crawlers pra trabalhar no seu negócio? e veja como é fácil acessar dados da web.

Saiba Mais