A internet está cheia de dados valiosos — seja para vendas, e-commerce ou pesquisa de mercado, o raspador web é a carta na manga para geração de leads, monitoramento de preços e análise da concorrência. Mas tem um detalhe: quanto mais empresas apostam no scraping, mais os sites se armam para barrar essas tentativas. Hoje, mais de , e já viraram rotina. Se você já viu seu script Python rodar de boa por 20 minutos e, do nada, só receber erro 403, sabe bem o drama.

Com anos de experiência em SaaS e automação, já vi projetos de scraping irem de “isso é tranquilo” para “por que estou sendo bloqueado em todo lugar?” em questão de minutos. Então, bora ao que interessa: vou te mostrar como fazer web scraping sem ser bloqueado em Python, compartilhar as melhores práticas e trechos de código, e indicar quando vale a pena apostar em alternativas com IA, tipo o . Seja você fera em Python ou só curioso, vai sair daqui com um kit de ferramentas para extrair dados de forma confiável e sem dor de cabeça.

O Que É Web Scraping Sem Ser Bloqueado em Python?

No fim das contas, fazer web scraping sem ser bloqueado é extrair dados dos sites sem acionar os sistemas de defesa anti-bot. No universo Python, isso vai muito além de um simples requests.get() em loop — é preciso se camuflar, agir como um usuário de verdade e sempre estar um passo à frente dos sistemas de detecção.

Por que Python? — graças à sua sintaxe simples, ecossistema gigante (pensa em requests, BeautifulSoup, Scrapy, Selenium) e flexibilidade para tudo, de scripts rápidos a crawlers distribuídos. Mas a fama tem seu preço: muitos sistemas anti-bot já reconhecem padrões típicos de scraping em Python.

Se você quer extrair dados sem dor de cabeça, precisa ir além do básico. Isso significa entender como os sites detectam bots — e como você pode driblá-los, sempre respeitando os limites éticos e legais.

Por Que Evitar Bloqueios é Essencial em Projetos de Web Scraping com Python

Ser bloqueado não é só um perrengue técnico — pode travar processos inteiros do seu negócio. Olha só alguns exemplos:

| Caso de Uso | Impacto do Bloqueio |

|---|---|

| Geração de Leads | Listas incompletas ou desatualizadas, perda de vendas |

| Monitoramento de Preços | Mudanças de preço da concorrência passam despercebidas, decisões ruins de precificação |

| Agregação de Conteúdo | Falhas em notícias, reviews ou dados de pesquisa |

| Inteligência de Mercado | Lacunas no acompanhamento de concorrentes ou do setor |

| Listagens Imobiliárias | Dados desatualizados ou imprecisos, oportunidades perdidas |

Quando um raspador é bloqueado, você não só perde dados — desperdiça recursos, pode ter problemas de conformidade e ainda toma decisões ruins baseadas em informações incompletas. Num cenário onde , confiabilidade é tudo.

Como os Sites Detectam e Bloqueiam Raspadores Python

Os sites estão cada vez mais espertos para identificar bots. Veja as principais barreiras anti-scraping que você pode encontrar (, ):

- Blacklist de IP: Muitos acessos do mesmo IP? Bloqueio na certa.

- Verificação de User-Agent e Headers: Headers genéricos ou ausentes (tipo o padrão

python-requests/2.25.1) entregam o bot. - Limite de Taxa (Rate Limiting): Muitos acessos em pouco tempo levam a bloqueios ou lentidão.

- CAPTCHAs: Aqueles desafios “prove que você é humano” que bots não passam fácil.

- Análise Comportamental: Sites monitoram padrões robóticos — tipo clicar sempre no mesmo botão, no mesmo intervalo.

- Honeypots: Campos ou links escondidos que só bots acessam.

- Fingerprinting de Navegador: Coleta de informações do navegador/dispositivo para identificar automação.

- Rastreamento de Cookies e Sessões: Bots que não lidam bem com cookies ou sessões são facilmente pegos.

Pensa na segurança de um aeroporto: se você age e se comporta como todo mundo, passa tranquilo. Se aparece de sobretudo e óculos escuros, vai ser parado na hora.

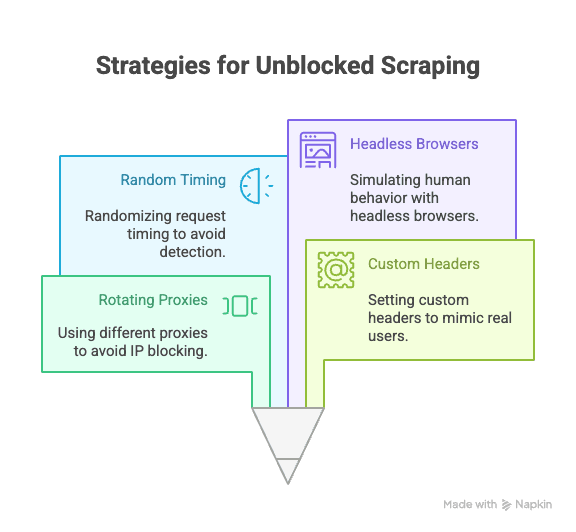

Técnicas Essenciais em Python para Web Scraping Sem Ser Bloqueado

Vamos ao que interessa: como evitar bloqueios ao fazer scraping com Python. Aqui estão as estratégias que não podem faltar:

Rotação de Proxies e IPs

Por que é importante: Se todos os acessos vêm do mesmo IP, fica fácil ser bloqueado. Usar proxies rotativos espalha os acessos, dificultando a detecção.

Como fazer em Python:

1import requests

2proxies = [

3 "<http://proxy1.example.com:8000>",

4 "<http://proxy2.example.com:8000>",

5 # ...mais proxies

6]

7for i, url in enumerate(urls):

8 proxy = {"http": proxies[i % len(proxies)]}

9 response = requests.get(url, proxies=proxy)

10 # processar respostaServiços pagos de proxy (residenciais ou rotativos) aumentam a confiabilidade ().

Definindo User-Agent e Headers Personalizados

Por que é importante: Headers padrão do Python entregam o jogo. Imite navegadores reais ajustando user-agent e outros headers.

Exemplo de código:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/124.0.0.0 Safari/537.36",

3 "Accept-Language": "en-US,en;q=0.9",

4 "Accept-Encoding": "gzip, deflate, br",

5 "Connection": "keep-alive"

6}

7response = requests.get(url, headers=headers)Rotacione user-agents para ficar ainda mais discreto ().

Aleatorizando o Tempo e o Padrão das Requisições

Por que é importante: Bots são rápidos e previsíveis; humanos são mais lentos e aleatórios. Adicione atrasos e varie a navegação.

Dica em Python:

1import time, random

2for url in urls:

3 response = requests.get(url)

4 time.sleep(random.uniform(2, 7)) # Espera entre 2 e 7 segundosSe usar Selenium, também dá para aleatorizar cliques e rolagens.

Gerenciando Cookies e Sessões

Por que é importante: Muitos sites exigem cookies ou tokens de sessão para liberar conteúdo. Ignorar isso é pedir para ser bloqueado.

Como fazer em Python:

1import requests

2session = requests.Session()

3response = session.get(url)

4# a sessão gerencia os cookies automaticamentePara fluxos mais complexos, use Selenium para capturar e reutilizar cookies.

Simulando Comportamento Humano com Navegadores Headless

Por que é importante: Alguns sites usam JavaScript, movimentos do mouse ou rolagem como sinais de usuário real. Ferramentas como Selenium ou Playwright simulam essas ações.

Exemplo com Selenium:

1from selenium import webdriver

2from selenium.webdriver.common.action_chains import ActionChains

3import random, time

4driver = webdriver.Chrome()

5driver.get(url)

6actions = ActionChains(driver)

7actions.move_by_offset(random.randint(0, 100), random.randint(0, 100)).perform()

8time.sleep(random.uniform(2, 5))Isso ajuda a driblar análise comportamental e conteúdo dinâmico ().

Estratégias Avançadas: Contornando CAPTCHAs e Honeypots em Python

CAPTCHAs existem para barrar bots. Algumas bibliotecas Python resolvem CAPTCHAs simples, mas para desafios mais difíceis, a maioria dos raspadores usa serviços externos (como 2Captcha ou Anti-Captcha) mediante pagamento ().

Exemplo de integração:

1# Pseudocódigo para usar a API do 2Captcha

2import requests

3captcha_id = requests.post("<https://2captcha.com/in.php>", data={...}).text

4# Aguarde a solução e envie junto com sua requisiçãoHoneypots são campos ou links escondidos que só bots acessam. Evite clicar ou enviar qualquer coisa que não apareça em um navegador real ().

Como Montar Headers Robustos Usando Bibliotecas Python

Além do user-agent, você pode rotacionar e aleatorizar outros headers (como Referer, Accept, Origin, etc.) para se misturar ainda mais.

Com Scrapy:

1class MySpider(scrapy.Spider):

2 custom_settings = {

3 'DEFAULT_REQUEST_HEADERS': {

4 'User-Agent': '...',

5 'Accept-Language': 'en-US,en;q=0.9',

6 # Outros headers

7 }

8 }Com Selenium: Use perfis de navegador ou extensões para definir headers, ou injete via JavaScript.

Mantenha sua lista de headers atualizada — copie requisições reais do navegador usando o DevTools como referência.

Quando o Scraping Tradicional em Python Não Basta: O Avanço das Tecnologias Anti-Bot

A real é: quanto mais o scraping se populariza, mais avançadas ficam as barreiras anti-bot. . Detecção por IA, limites dinâmicos e fingerprinting de navegador dificultam até para scripts Python avançados ().

Às vezes, não importa o quão bom seja seu código — você vai esbarrar em bloqueios. Nesses casos, é hora de buscar outra abordagem.

Thunderbit: Uma Alternativa com IA ao Scraping em Python

Quando o Python chega ao limite, o entra em cena como um raspador web IA, sem necessidade de código, pensado para quem quer praticidade. Em vez de se preocupar com proxies, headers e CAPTCHAs, o agente de IA do Thunderbit lê o site, sugere os melhores campos para extrair e cuida de tudo — da navegação em subpáginas à exportação dos dados.

O que faz o Thunderbit ser diferente?

- Sugestão de Campos por IA: Clique em “Sugerir Campos com IA” e o Thunderbit analisa a página, recomenda colunas e até gera instruções de extração.

- Raspagem de Subpáginas: O Thunderbit navega por subpáginas (tipo detalhes de produtos ou perfis do LinkedIn) e enriquece sua tabela automaticamente.

- Raspagem em Nuvem ou no Navegador: Escolha a opção mais rápida — nuvem para sites públicos, navegador para páginas protegidas por login.

- Raspador Agendado: Programe e esqueça — o Thunderbit pode raspar periodicamente, mantendo seus dados sempre atualizados.

- Modelos Prontos: Para sites populares (Amazon, Zillow, Shopify, etc.), o Thunderbit oferece modelos prontos — só clicar e usar.

- Exportação Gratuita de Dados: Exporte para Excel, Google Sheets, Airtable ou Notion — sem taxas extras.

O Thunderbit já é usado por mais de , e você não precisa escrever uma linha de código.

Como o Thunderbit Ajuda a Evitar Bloqueios e Automatizar a Extração de Dados

A IA do Thunderbit não só imita o comportamento humano — ela se adapta em tempo real a cada site, reduzindo o risco de bloqueio. Veja como:

- IA se adapta a mudanças de layout: Chega de scripts quebrados quando o site muda o visual.

- Navegação em subpáginas e paginação: O Thunderbit segue links e listas paginadas automaticamente, como um usuário real.

- Raspagem em nuvem em escala: Extraia até 50 páginas de uma vez, com alta velocidade.

- Sem código, sem manutenção: Foque na análise, não em depuração.

Quer saber mais? Veja o artigo .

Comparando Scraping em Python vs. Thunderbit: Qual Escolher?

Olha só um comparativo lado a lado:

| Recurso | Scraping em Python | Thunderbit |

|---|---|---|

| Tempo de Configuração | Médio–Alto (scripts, proxies, etc) | Baixo (2 cliques, IA faz o resto) |

| Habilidade Técnica | Requer programação | Não precisa programar |

| Confiabilidade | Varia (fácil de quebrar) | Alta (IA se adapta a mudanças) |

| Risco de Bloqueio | Moderado–Alto | Baixo (IA imita usuário, adapta) |

| Escalabilidade | Exige código customizado/nuvem | Nuvem e lotes integrados |

| Manutenção | Frequente (mudanças, bloqueios) | Mínima (IA ajusta sozinha) |

| Opções de Exportação | Manual (CSV, banco de dados) | Direto para Sheets, Notion, Airtable, CSV |

| Custo | Gratuito (mas consome tempo) | Plano grátis, pagos para maior escala |

Quando usar Python:

- Você precisa de controle total, lógica customizada ou integração com outros fluxos Python.

- Vai raspar sites com pouca proteção anti-bot.

Quando usar Thunderbit:

- Busca rapidez, confiabilidade e zero configuração.

- Precisa raspar sites complexos ou que mudam com frequência.

- Não quer lidar com proxies, CAPTCHAs ou código.

Passo a Passo: Como Fazer Web Scraping em Python Sem Ser Bloqueado

Vamos a um exemplo prático: extrair dados de produtos de um site de exemplo, aplicando as melhores práticas anti-bloqueio.

1. Instale as Bibliotecas Necessárias

1pip install requests beautifulsoup4 fake-useragent2. Prepare Seu Script

1import requests

2from bs4 import BeautifulSoup

3from fake_useragent import UserAgent

4import time, random

5ua = UserAgent()

6urls = ["<https://example.com/product/1>", "<https://example.com/product/2>"] # Substitua pelos seus URLs

7for url in urls:

8 headers = {

9 "User-Agent": ua.random,

10 "Accept-Language": "en-US,en;q=0.9"

11 }

12 response = requests.get(url, headers=headers)

13 if response.status_code == 200:

14 soup = BeautifulSoup(response.text, "html.parser")

15 # Extraia os dados aqui

16 print(soup.title.text)

17 else:

18 print(f"Bloqueado ou erro em {url}: {response.status_code}")

19 time.sleep(random.uniform(2, 6)) # Atraso aleatório3. Adicione Rotação de Proxies (Opcional)

1proxies = [

2 "<http://proxy1.example.com:8000>",

3 "<http://proxy2.example.com:8000>",

4 # Mais proxies

5]

6for i, url in enumerate(urls):

7 proxy = {"http": proxies[i % len(proxies)]}

8 headers = {"User-Agent": ua.random}

9 response = requests.get(url, headers=headers, proxies=proxy)

10 # ...restante do código4. Gerencie Cookies e Sessões

1session = requests.Session()

2for url in urls:

3 response = session.get(url, headers=headers)

4 # ...restante do código5. Dicas de Solução de Problemas

- Se aparecerem muitos erros 403/429, diminua a velocidade das requisições ou troque de proxy.

- Se encontrar CAPTCHAs, use Selenium ou um serviço de resolução de CAPTCHA.

- Sempre confira o

robots.txte os termos de uso do site.

Conclusão & Principais Lições

Web scraping em Python é poderoso — mas o risco de bloqueio só aumenta com o avanço das tecnologias anti-bot. O segredo para evitar bloqueios? Combine boas práticas técnicas (proxies rotativos, headers inteligentes, atrasos aleatórios, sessões e navegadores headless) com respeito às regras e ética dos sites.

Mas, às vezes, nem as melhores técnicas em Python resolvem. É aí que ferramentas com IA como o brilham — oferecendo uma solução sem código, resistente a bloqueios e pensada para negócios.

Quer ver como pode ser fácil raspar dados? e experimente — ou confira nosso para mais dicas e tutoriais de scraping.

Perguntas Frequentes

1. Por que os sites bloqueiam raspadores Python?

Os sites bloqueiam raspadores para proteger seus dados, evitar sobrecarga nos servidores e impedir abusos de bots. Scripts Python são facilmente detectados se usam headers padrão, não gerenciam cookies ou fazem muitas requisições rapidamente.

2. Quais as melhores formas de evitar bloqueios ao fazer scraping com Python?

Use proxies rotativos, defina user-agent e headers realistas, aleatorize o tempo das requisições, gerencie cookies/sessões e simule comportamento humano com ferramentas como Selenium ou Playwright.

3. Como o Thunderbit ajuda a evitar bloqueios em comparação com scripts Python?

O Thunderbit usa IA para se adaptar ao layout dos sites, imitar a navegação humana e lidar automaticamente com subpáginas e paginação. Assim, reduz o risco de bloqueio ao se misturar e atualizar sua abordagem em tempo real — sem precisar de código ou proxies.

4. Quando devo usar scraping em Python e quando optar por uma ferramenta de IA como o Thunderbit?

Use Python quando precisar de lógica customizada, integração com outros códigos Python ou para sites simples. Use Thunderbit para scraping rápido, confiável e escalável — especialmente em sites complexos, que mudam com frequência ou bloqueiam scripts agressivamente.

5. Web scraping é legal?

Web scraping é permitido para dados públicos, mas é fundamental respeitar os termos de uso, políticas de privacidade e leis aplicáveis de cada site. Nunca raspe dados sensíveis ou privados e sempre atue de forma ética e responsável.

Quer raspar dados de forma mais inteligente? Experimente o Thunderbit e deixe os bloqueios para trás.

Saiba Mais:

- Como Raspar Notícias do Google com Python: Guia Passo a Passo

- Como Criar um Rastreador de Preços da Best Buy Usando Python

- 14 Maneiras de Fazer Web Scraping Sem Ser Bloqueado

- 10 Melhores Dicas para Não Ser Bloqueado ao Fazer Web Scraping