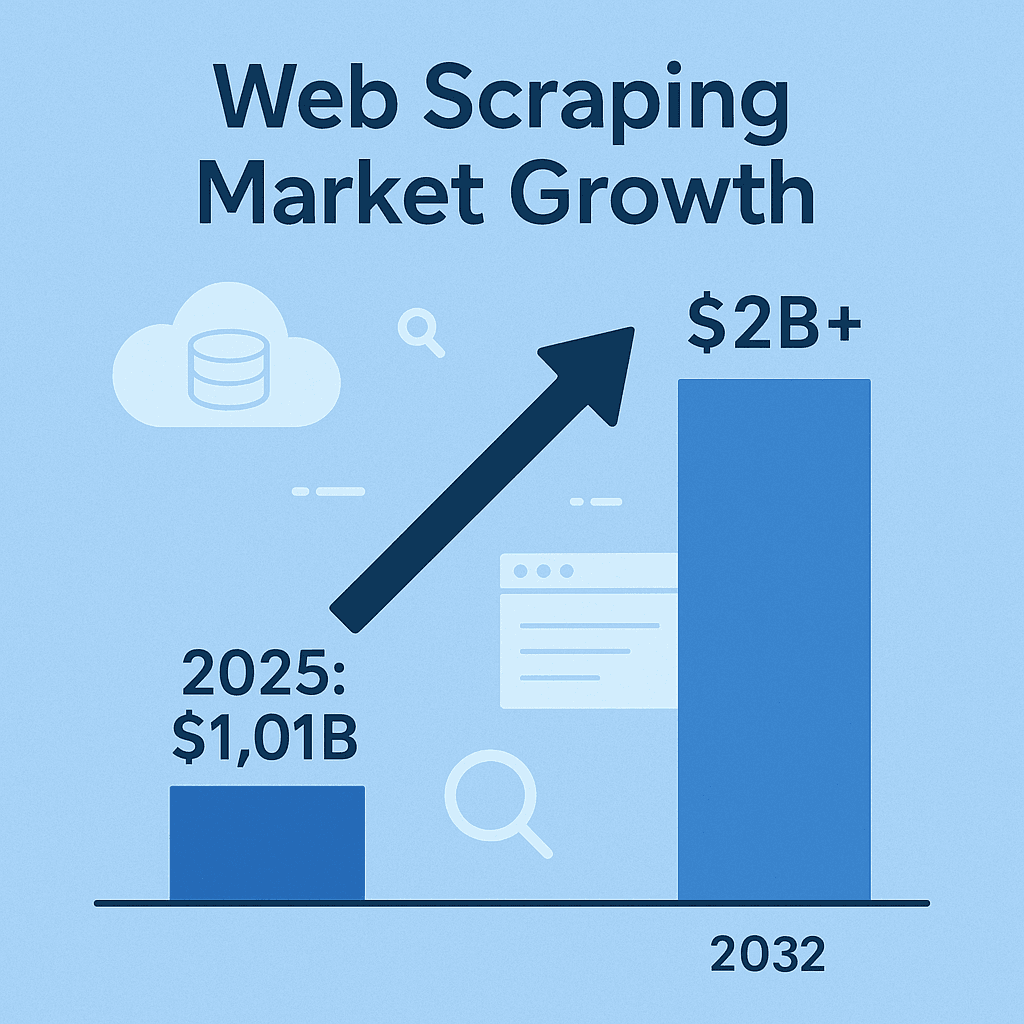

O web scraping virou aquele truque de mestre que está por trás das estratégias de inteligência de negócios, vendas e pesquisa de mercado mais modernas. Hoje, se você não está coletando dados da web — como preços de concorrentes, catálogos de produtos, tendências ou leads — provavelmente está deixando passar informações que seus concorrentes já estão usando a seu favor. Para ter uma noção, o mercado de softwares de raspador web deve chegar a e dobrar até 2032. Não é só modinha — é uma revolução de verdade. E, apesar do hype em cima do Python, Java segue firme como a escolha de quem busca confiabilidade, performance e integração parruda.

Com minha bagagem em SaaS e automação, posso garantir: o web scraping em Java está mais forte do que nunca — principalmente em empresas, onde estabilidade, multithreading e integração com big data são indispensáveis. Mas fica ligado: scraping não é só sair puxando dado. Tem que ser eficiente, organizado e — se não quiser dor de cabeça jurídica — dentro das regras. Bora colocar a mão na massa e ver como dominar o web scraping em Java, seja criando seu próprio raspador web java ou acelerando tudo com ferramentas inteligentes como o .

Descomplicando o Web Scraping em Java: O Que Você Precisa Saber

No fim das contas, web scraping é a arte (e às vezes ciência) de extrair informações de sites de forma automática. O fluxo é direto: seu código faz uma requisição HTTP, recebe o HTML, analisa o conteúdo para achar os dados que você quer (preços, nomes de produtos, avaliações) e exporta tudo para um formato útil — CSV, JSON ou direto para um banco ().

Por que Java? Apesar do Python ser o queridinho para scripts rápidos, Java é o trator para scraping em larga escala, projetos longos e ambientes corporativos. É fortemente tipado, robusto e tem um ecossistema cheio de bibliotecas para rede, parsing de HTML e concorrência. E se seu pipeline já roda em Java, a integração é natural — sem dor de cabeça com várias linguagens ().

Resumindo: raspador web java pode rodar por dias, aguentar grandes volumes de dados e se encaixar fácil na sua infraestrutura. Mas é essencial escolher a ferramenta certa para cada cenário.

Principais Ferramentas e Bibliotecas de Web Scraping em Java

Vamos ao que interessa. Essas são as bibliotecas de raspador web java mais populares, cada uma com seus pontos fortes e limitações:

| Ferramenta | Melhor Para | Pontos Fortes | Limitações |

|---|---|---|---|

| Jsoup | Páginas HTML estáticas, extração rápida | Leve, API simples, rápida, ótima para tarefas simples | Não lida com JavaScript ou conteúdo dinâmico |

| Selenium | Sites dinâmicos e interativos | Automatiza navegadores reais, executa JS, suporta ações do usuário, comunidade ativa | Consome mais recursos, mais lento, sensível a mudanças no layout, requer drivers de navegador |

| HtmlUnit | Navegação headless, JS moderado | 100% Java, executa algum JS, não precisa de navegador externo | Mais lento que Jsoup, suporte limitado a frameworks JS modernos, sem recursos anti-bloqueio nativos |

| Playwright | Sites modernos com muito JS, automação | Rápido, eficiente, suporta múltiplos navegadores, lida com pop-ups e fluxos multi-página, auto-wait | Ecossistema mais novo, ainda requer recursos de navegador, menos nativo em Java que Selenium |

(, )

Jsoup: O Básico para Extração de HTML Estático

é o arroz com feijão do scraping em Java para páginas estáticas. Ele funciona como um jQuery para Java: você busca a página com Jsoup.connect(URL).get() e usa seletores CSS para pegar os dados. Quer todos os <h1>? Moleza. Precisa dos nomes dos produtos em <div class="product-name">? Uma linha resolve.

Exemplo: Extraindo nomes de produtos de uma página de e-commerce

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements products = doc.select("div.product-name");

3for (Element product : products) {

4 System.out.println(product.text());

5}Jsoup é rápido, simples e perfeito para raspar blogs, listas de produtos ou notícias — só não esquece: ele não executa JavaScript. Se o dado não está no HTML, o Jsoup não vai achar.

Selenium e HtmlUnit: Lidando com Conteúdo Dinâmico

Às vezes, os dados que você quer só aparecem depois que o JavaScript carrega ou após alguma interação (tipo clicar em “Carregar mais”). É aí que o brilha. Ele deixa seu código Java abrir um navegador de verdade (Chrome, Firefox etc.), interagir com a página e capturar o conteúdo como se fosse um usuário.

O HtmlUnit é uma alternativa mais leve, 100% Java, que executa parte do JavaScript, mas não acompanha sites modernos cheios de JS. Para páginas simples com um pouco de dinamismo, ele resolve. Mas se o site usa React ou Angular, vai de Selenium ou Playwright.

Quando usar navegador headless: Se precisa logar, clicar em botões ou raspar conteúdo que só aparece depois de scripts rodarem, automação de navegador é o caminho. Só esteja pronto para menor velocidade e mais manutenção — sites mudam o tempo todo.

Playwright: Automação Moderna e Eficiente

é a sensação do momento, criado pela Microsoft e pensado para ser rápido e confiável. Pode ser até 40–50% mais veloz que o Selenium, suporta vários navegadores e encara situações complexas como pop-ups, scroll infinito e fluxos multi-página com menos código. Se você precisa raspar sites modernos renderizados no cliente, vale a pena conhecer.

Como Escolher a Ferramenta de Web Scraping Java Ideal para Seu Projeto

Nem todo projeto precisa de uma solução supercomplexa. Veja como costumo decidir:

- Complexidade do Site: HTML estático? Vai de Jsoup. Muito JS? Selenium ou Playwright. Um pouco de JS? HtmlUnit pode dar conta.

- Volume e Frequência de Dados: Vai raspar só uma vez? Mantenha simples. Grandes volumes e tarefas recorrentes? Prefira ferramentas com suporte a multithreading e tratamento de erros.

- Facilidade vs. Flexibilidade: Jsoup é fácil de aprender. Selenium/Playwright dão mais poder, mas exigem mais configuração e manutenção.

- Requisitos e Orçamento: Bibliotecas open-source são gratuitas, mas você cuida de tudo. APIs pagas ou serviços em nuvem economizam tempo, mas têm custo.

Matriz de Decisão:

| Critério | Jsoup | Selenium | HtmlUnit | Playwright |

|---|---|---|---|---|

| HTML Estático | ✔️ | ✔️ | ||

| JS Dinâmico | ✔️ | (algum) | ✔️ | |

| Velocidade | ✔️ | ✔️ | ||

| Facilidade de Uso | ✔️ | |||

| Lida com Login/Clicks | ✔️ | (básico) | ✔️ | |

| Escala/Paralelismo | ✔️ | (mais difícil) | (ok) | ✔️ |

| Econômico | ✔️ | ✔️ | ✔️ | ✔️ |

Comece simples e só complique se precisar. E não tenha medo de misturar ferramentas — às vezes, a solução perfeita é híbrida.

Thunderbit: Facilitando o Web Scraping para Desenvolvedores Java

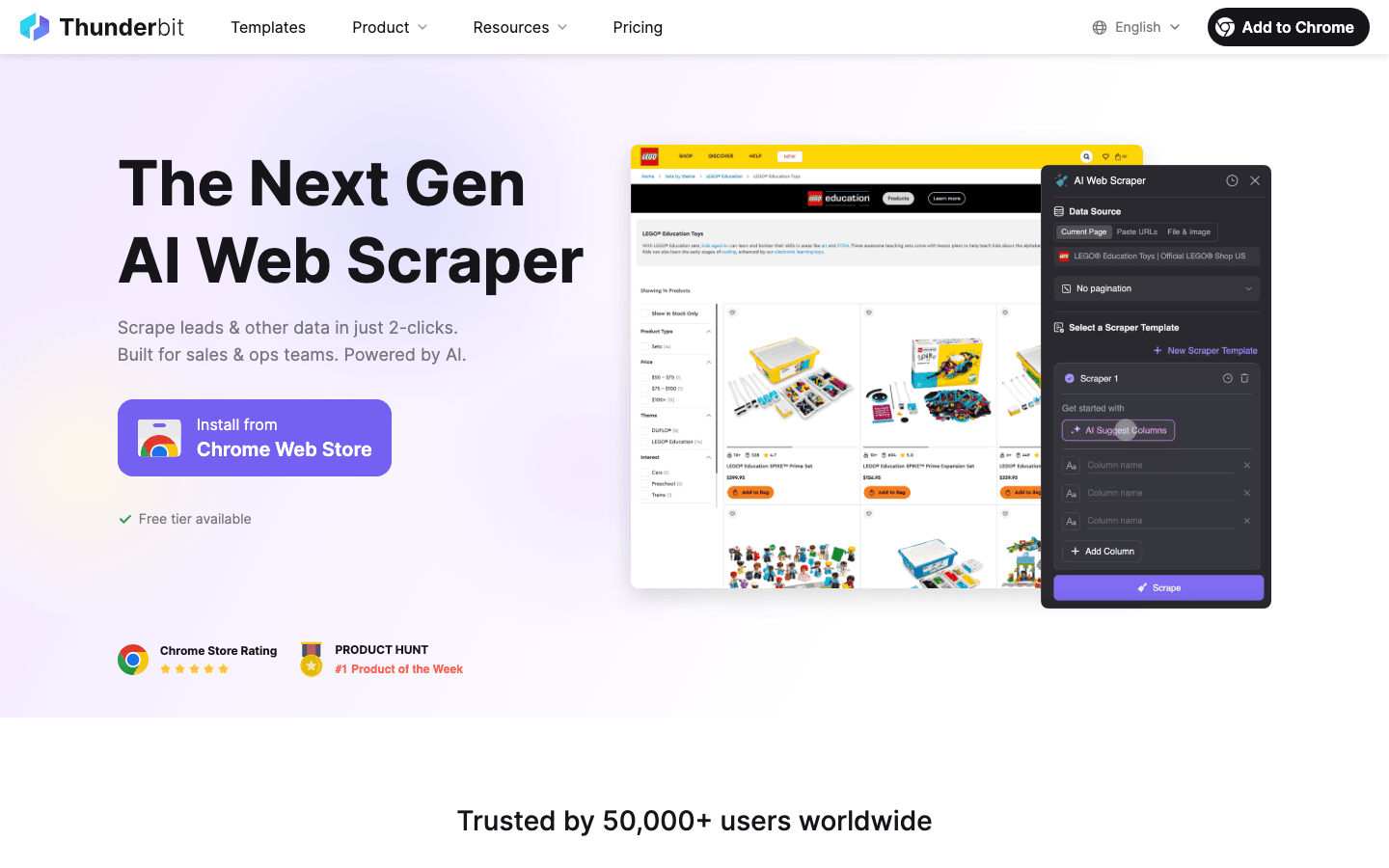

Agora, vamos falar do que mudou o jogo para muita gente: o . O Thunderbit é um Raspador Web IA para Chrome que permite extrair dados estruturados de qualquer site em poucos cliques — sem código, sem templates, sem dor de cabeça.

Como o Thunderbit ajuda devs Java e equipes de negócio:

- Campos sugeridos por IA: A IA do Thunderbit lê a página e já sugere as melhores colunas para extração. Chega de caçar seletor CSS ou escrever código frágil.

- Navegação em subpáginas: Precisa de detalhes em páginas vinculadas? O Thunderbit navega sozinho por subpáginas e enriquece seu dataset — perfeito para listas de produtos com páginas de detalhes.

- Paginação e Scroll Infinito: O Thunderbit rola a página, clica em “Próximo” e segue até capturar tudo.

- Exportação Estruturada: Exporte direto para Excel, Google Sheets, Airtable ou Notion. Ou baixe como CSV/JSON e integre ao seu app Java.

- Raspagem em Nuvem ou Navegador: Execute raspagens na nuvem (até 50 páginas de uma vez — rapidinho!) ou no navegador para sites que exigem login.

- Agendamento: Programe raspagens diárias, semanais ou em horários personalizados. A IA do Thunderbit entende até comandos em linguagem natural (“toda segunda às 9h”).

Para devs Java, o Thunderbit economiza tempo em protótipos, coletas rápidas ou até fluxos de produção — principalmente quando você quer que colegas não técnicos também possam coletar dados.

Como o Thunderbit Aproxima Equipes de Vendas e Operações dos Dados

O Thunderbit não é só para devs. Equipes de vendas, marketing, operações de e-commerce e imobiliárias usam todo dia para:

- Gerar Leads: Extraia contatos de diretórios, LinkedIn ou listas de eventos — sem precisar programar.

- Monitorar Concorrentes: Acompanhe preços, produtos ou estratégias de marketing dos concorrentes com raspagens agendadas.

- Unificar Listagens: Junte produtos, imóveis ou vagas de emprego de vários sites em uma tabela organizada.

Já vi equipes saírem do “queria esses dados” para “tá aqui a planilha” em menos de 10 minutos. E com scraping de subpáginas e detecção inteligente de campos, até site bagunçado vira fonte de dado.

Garantindo Qualidade dos Dados em Projetos de Web Scraping Java

Coletar dado é só metade do caminho. Se os dados estiverem desatualizados, incompletos ou bagunçados, você fica no escuro. Veja como mantenho meus raspadores (e minha sanidade) em ordem:

- Valide e Limpe: Cheque precisão, completude e consistência. Use o forte tipado do Java para identificar valores estranhos (tipo preço “N/A” em vez de número). Normalize formatos — datas, moedas, telefones — para facilitar a análise ().

- Remova Duplicatas: Dados raspados costumam vir com duplicatas. Use chaves únicas (URLs ou IDs) e coleções

Setdo Java para eliminar repetições. - Automatize Checagens de Qualidade: Depois de cada raspagem, faça verificações — a quantidade de itens bate com o esperado? Algum campo ficou vazio? Registre anomalias e configure alertas para problemas.

- Armazene com Inteligência: Para grandes volumes, envie os dados para um banco (Postgres, MongoDB etc.) em vez de manter tudo em memória. Bancos ajudam a impor esquemas e facilitam deduplicação ().

Tratamento de Erros e Resiliência: Como Construir Raspadores Robustos

Web scraping é jogo duro. Sites caem, HTML muda, bloqueios aparecem. Veja como evitar que seu raspador web java pare de funcionar:

- Tratamento Elegante de Erros: Capture erros HTTP (404, 500), timeouts e exceções de parsing. Refaça tentativas com backoff exponencial — não sobrecarregue o servidor ().

- Resiliência a Mudanças: Use seletores robustos, checagens de nulo e lógica de fallback. Se a estrutura da página mudar, registre o HTML bruto para depuração.

- Logs e Alertas: Registre cada requisição, sucesso e falha. Configure alertas para problemas críticos — tipo raspar zero itens quando esperava 100.

- Checkpointing: Em tarefas longas, salve o progresso de tempos em tempos. Se o raspador cair, retome de onde parou.

- Controle de Requisições: Seja educado — pause entre requisições, limite a concorrência e alterne User-Agent para evitar bloqueios.

Exemplo de lógica de retry em Java:

1Document doc = null;

2for (int attempt = 1; attempt <= MAX_RETRIES; attempt++) {

3 try {

4 doc = Jsoup.connect(url).timeout(5000).get();

5 break;

6 } catch (IOException e) {

7 log("Tentativa " + attempt + " falhou: " + e.getMessage());

8 Thread.sleep(1000 * attempt); // Backoff exponencial

9 }

10}()

Cumprindo as Regras: Aspectos Legais e Éticos do Web Scraping

Web scraping não é terra de ninguém. Tem regra — ignorar pode render bloqueio, processo ou coisa pior.

- Respeite a Propriedade dos Dados: Raspar dados públicos e não sensíveis geralmente é ok, mas dados pessoais (nomes, e-mails) são protegidos por leis como GDPR e LGPD. Não colete PII sem base legal ().

- Siga os Termos de Uso e robots.txt: Se o site proíbe scraping, respeite — ou saiba que está assumindo riscos. Sempre obedeça robots.txt e limites de requisição.

- Não Sobrecarregue Servidores: Controle a frequência das requisições, limite a concorrência e nunca raspe de forma a prejudicar o site ().

- Evite Conteúdo Protegido ou com Copyright: Não raspe e republique material protegido, nem acesse dados atrás de login sem permissão.

- Proteja e Anonimize Dados Sensíveis: Se coletar informações sensíveis, armazene com segurança e atenda pedidos de exclusão.

Dicas Práticas para Web Scraping Ético

- Revise os Termos de Uso e robots.txt do site antes de raspar.

- Use um User-Agent descritivo (nada de “Java/1.8.0_201”).

- Limite a taxa e concorrência das requisições.

- Prefira APIs ou datasets públicos quando possível.

- Documente o que foi raspado e por quê.

- Fique de olho nas leis e melhores práticas ().

Otimizando Performance: Escalando Seu Raspador Web em Java

Quando a demanda cresce, performance faz toda a diferença. Veja como escalar sem dor de cabeça (e sem travar seu servidor):

- Paralelize Requisições: Use

ExecutorServiceou pools de threads do Java para buscar várias páginas ao mesmo tempo. Controle a concorrência para não sobrecarregar o site (). - Transmita Dados: Grave resultados em banco ou arquivo conforme coleta — não deixe tudo em memória.

- Parsing Eficiente: Use seletores do Jsoup para parsing direto ao ponto. Para grandes volumes, pense em parsing em streaming ou mais leve.

- Aproveite Recursos em Nuvem: Rode raspadores em servidores cloud para mais banda e confiabilidade. Ou use plataformas de scraping em nuvem (como o modo cloud do Thunderbit) para grandes volumes.

- Otimize o Uso de Rede: Use compressão, execute raspadores próximos dos alvos e faça cache de respostas quando possível.

Exemplo de scraping multithread em Java:

1ExecutorService pool = Executors.newFixedThreadPool(10);

2for (String url : urlList) {

3 pool.submit(() -> scrapePage(url));

4}

5pool.shutdown();()

Conclusão: Dicas Essenciais para o Sucesso no Web Scraping com Java

Vamos recapitular o que é fundamental para mandar bem no web scraping em Java:

- Escolha a Ferramenta Certa: Jsoup para páginas estáticas, Selenium/Playwright para sites dinâmicos, HtmlUnit para scraping headless em Java.

- Aproveite Automação e IA: Use ferramentas como o para acelerar a detecção de campos, scraping de subpáginas e exportação de dados — especialmente para usuários de negócio ou prototipagem rápida.

- Priorize a Qualidade dos Dados: Valide, limpe, remova duplicatas e armazene seus dados com inteligência.

- Siga as Regras: Respeite limites legais e éticos — raspe dados públicos, siga as regras do site e evite informações pessoais sem base legal.

- Otimize para Escala: Use concorrência, armazenamento eficiente e recursos em nuvem para lidar com grandes volumes.

Web scraping não é só uma habilidade técnica — é uma vantagem competitiva. Seja você dev criando raspador web java robusto ou alguém de vendas/ops usando Thunderbit para automatizar a coleta de dados, dominar essas práticas vai turbinar seus resultados.

Quer testar scraping com IA? e veja como é fácil transformar qualquer site em um dataset organizado. E se quiser se aprofundar, dá uma olhada no para mais tutoriais, comparativos e cases reais.

Perguntas Frequentes

1. Por que Java ainda é uma ótima escolha para web scraping?

Java entrega confiabilidade, multithreading robusto e integração fácil com sistemas corporativos. É ideal para scraping em larga escala, projetos longos ou de alta performance — principalmente se seu pipeline já usa Java ().

2. Qual a diferença entre Jsoup, Selenium, HtmlUnit e Playwright?

Jsoup é ótimo para HTML estático; Selenium e Playwright encaram sites dinâmicos e pesados em JS; HtmlUnit é um navegador headless puro Java para JS moderado. Escolha conforme a complexidade do site e o que seu projeto pede ().

3. Como o Thunderbit ajuda devs Java e equipes de negócio?

O Thunderbit usa IA para automatizar a detecção de campos, navegação em subpáginas e estruturação dos dados — sem precisar de código. É perfeito para usuários de negócio ou devs que querem prototipar ou empoderar colegas não técnicos ().

4. Quais as melhores práticas para garantir qualidade dos dados no web scraping?

Valide e limpe os dados, remova duplicatas, automatize checagens de qualidade e armazene resultados em bancos para grandes volumes. Sempre trate dados raspados como matéria-prima a ser processada ().

5. Como manter a conformidade e ética ao raspar dados da web?

Raspe só dados públicos e não sensíveis; respeite robots.txt e termos do site; evite sobrecarregar servidores; e não colete informações pessoais sem base legal. Fique de olho em leis como GDPR e LGPD ().

Pronto para levar seu web scraping a outro nível? Teste o Thunderbit de graça ou crie seu próprio raspador web java seguindo essas dicas. Boas raspagens — e lembre-se: programe com responsabilidade, raspe com ética e sempre revise seus dados antes de tomar decisões importantes.

Saiba Mais