Imagine a situação: são 8h30 da manhã, você com aquele café passado na hora, e o seu chefe (ou até o chefe do seu chefe) pede uma planilha com os preços de todos os produtos dos concorrentes, avaliações dos clientes e—por que não?—até o sabor de pizza favorito do CEO deles. Você pode perder horas copiando e colando, ou deixar o Python fazer esse trabalho pesado. Mas e se você não programa, ou não quer passar a manhã inteira brigando com bugs de HTML? É aí que este guia entra em cena.

Eu sou Shuai Guan, cofundador e CEO da , e há anos ajudo equipes a transformar o caos dos dados da web em informações valiosas usando SaaS, automação e IA. Neste artigo, vou te mostrar as 10 melhores bibliotecas python para raspagem web em 2025—explicando o que cada uma faz, como funcionam, seus pontos fortes e limitações, e onde realmente brilham. E se você está pensando “Legal, mas não sei programar em Python”, relaxa. Também vou mostrar como o Raspador Web IA da Thunderbit entrega o mesmo resultado em dois cliques—sem código, sem dor de cabeça, sem precisar de litros de café.

Por que bibliotecas python para raspagem web são essenciais para equipes de negócios

- Geração de Leads & Vendas: Extraia listas de diretórios, redes sociais ou fóruns para montar listas de prospecção—nomes, e-mails, perfis sociais, o que precisar. Equipes de vendas podem automatizar tarefas que antes tomavam horas ().

- Monitoramento de Preços & Inteligência Competitiva: Times de e-commerce acompanham preços, estoques e promoções dos concorrentes em tempo real, ajustando suas estratégias rapidinho ().

- Pesquisa de Mercado & Análise de Tendências: Raspando avaliações, redes sociais ou sites de notícias, equipes de marketing e produto pegam tendências e percepções dos clientes antes de virarem moda ().

- Dados Imobiliários: Corretores e analistas reúnem anúncios, preços e detalhes de imóveis de várias fontes, facilitando a análise de mercado.

- Operações de E-commerce: Da coleta de dados de fornecedores à auditoria de catálogos, a raspagem garante precisão e evita trabalho manual repetitivo.

Resumindo: . Mas tem um porém: a maioria das bibliotecas python para raspagem web parte do princípio que você já sabe programar. Para quem não é técnico, isso pode ser um baita obstáculo. Por isso, ferramentas sem código e com IA, como a , estão ganhando cada vez mais espaço—e eu vou te mostrar o porquê.

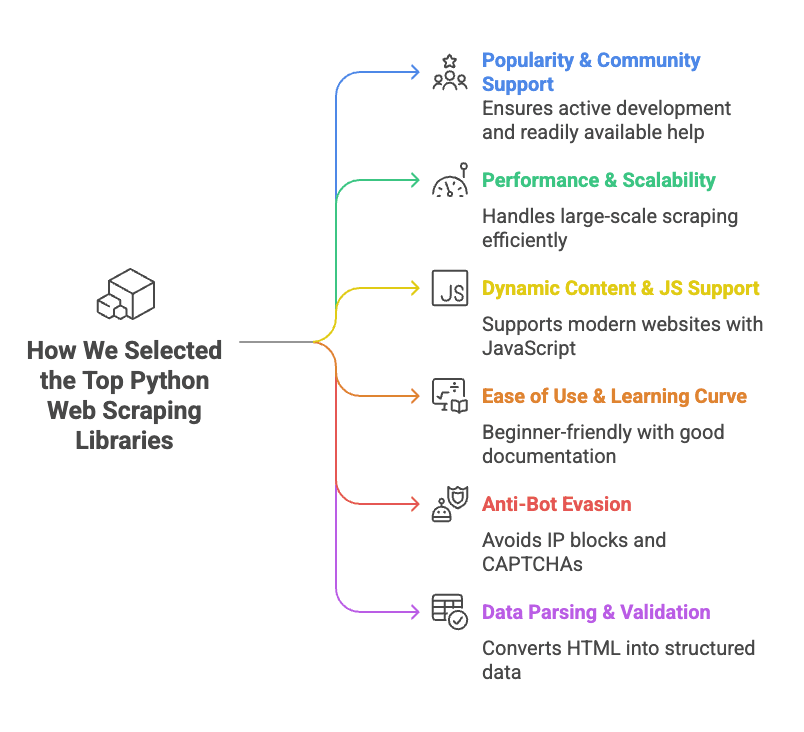

Como escolhemos as melhores bibliotecas python para raspagem web

- Popularidade & Suporte da Comunidade: Bibliotecas com muitos stars no GitHub, desenvolvimento ativo e bastante material de apoio. Se você travar, quer resposta no Stack Overflow, não silêncio.

- Performance & Escalabilidade: O recurso aguenta milhares de páginas? Suporta requisições assíncronas ou concorrentes? É rápido ou faz você desejar ter contratado um estagiário?

- Suporte a Conteúdo Dinâmico & JavaScript: Muitos sites modernos usam JavaScript para carregar dados. Bibliotecas que lidam bem com conteúdo dinâmico (via automação de navegador ou integração com API) ganharam pontos extras.

- Facilidade de Uso & Curva de Aprendizado: Algumas ferramentas são plug-and-play; outras exigem um doutorado em “Por que isso não funciona?”. Priorizamos as mais amigáveis para iniciantes ou bem documentadas.

- Evasão de Anti-bot: O recurso consegue lidar com bloqueios de IP, CAPTCHAs ou limites agressivos? Se não, você pode raspar por cinco minutos e ficar bloqueado por cinco dias.

- Parsing & Validação de Dados: Não basta capturar HTML—é preciso transformar em dados limpos e estruturados. Bibliotecas que ajudam nesse processo ganharam pontos extras.

Para cada biblioteca, explico o que é, como usar, prós e contras, e os cenários ideais.

Tabela Comparativa: Bibliotecas Python para Raspagem Web

Confira um comparativo lado a lado das 10 principais bibliotecas, para você escolher a ideal (e até impressionar o chefe com seu novo vocabulário de raspagem web):

| Biblioteca | Facilidade de Uso | Suporte JS | Requisições HTTP | Parsing HTML | Anti-bot | Validação de Dados | Melhor Uso |

|---|---|---|---|---|---|---|---|

| ZenRows | Muito fácil (API) | ✅ (navegador) | ✅ (API) | ✅ | ✅ (proxies, bypass CAPTCHA) | ❌ | Raspagem em larga escala de sites protegidos |

| Selenium | Moderado | ✅ (navegador) | ✅ (navegador) | Parcial | ❌ | ❌ | Sites dinâmicos e interativos |

| Requests | Muito fácil | ❌ | ✅ | ❌ | ❌ | ❌ | Páginas estáticas, APIs |

| Beautiful Soup | Fácil | ❌ | ❌ | ✅ | ❌ | ❌ | Parsing de HTML de páginas estáticas |

| Playwright | Moderado | ✅ (navegador) | ✅ (navegador) | Acesso DOM | ❌ | ❌ | Web apps modernos, suporte multi-navegador |

| Scrapy | Moderado/Difícil | Parcial (add-ons) | ✅ (assíncrono) | ✅ | ❌ | Limitado | Crawling estruturado em larga escala |

| urllib3 | Fácil (baixo nível) | ❌ | ✅ | ❌ | ❌ | ❌ | HTTP customizado, alta concorrência |

| HTTPX | Fácil/Moderado | ❌ (async IO) | ✅ (assíncrono) | ❌ | ❌ | ❌ | Raspagem assíncrona de alta performance |

| lxml | Moderado | ❌ | ❌ | ✅ (rápido) | ❌ | ❌ | Parsing rápido de HTML/XML complexo |

| Pydantic | Moderado | N/A | N/A | N/A | N/A | ✅ | Validação de dados pós-raspagem |

Obs: “Suporte JS” indica capacidade de lidar com conteúdo renderizado por JavaScript. “Anti-bot” refere-se a recursos nativos, não soluções improvisadas.

ZenRows: Solução Completa de Raspagem Web em Python

O que é?

é uma API de raspagem web que resolve as partes chatas—proxies rotativos, bypass de CAPTCHA, fingerprinting de navegador e renderização JavaScript. Só precisa fazer uma chamada de API e o ZenRows devolve a página pra você.

Como usar:

Cadastre-se para pegar uma chave de API e use a biblioteca requests do Python para chamar o ZenRows:

1import requests

2url = "<https://example.com>"

3apikey = "<YOUR_ZENROWS_API_KEY>"

4params = {

5 "url": url,

6 "apikey": apikey,

7 "js_render": "true",

8 "premium_proxy": "true"

9}

10response = requests.get("<https://api.zenrows.com/v1/>", params=params)

11print(response.text[:500])Vantagens:

- Contorna a maioria das barreiras anti-bot (proxies, CAPTCHAs, etc.)

- Lida com sites pesados em JavaScript

- API simples—sem precisar gerenciar navegadores ou proxies

- Escalável para grandes volumes

Desvantagens:

- Serviço pago (tem teste gratuito, mas uso contínuo é cobrado)

- Fica dependente de API de terceiros

Melhor uso:

Raspagem em larga escala, especialmente em sites que bloqueiam bots ou exigem renderização JavaScript. Se você está cansado de bloqueios e CAPTCHAs, vale a pena conferir ().

Selenium: Automação de Navegador para Raspagem Dinâmica

O que é?

é o clássico da automação de navegadores. Permite controlar Chrome, Firefox ou outros navegadores via Python, simulando cliques, preenchimento de formulários, rolagem e mais. Se um humano faz no navegador, o Selenium também faz.

Como usar:

Instale o pacote Selenium e um driver de navegador (tipo o ChromeDriver), depois:

1from selenium import webdriver

2from selenium.webdriver.chrome.options import Options

3options = Options()

4options.add_argument("--headless=new")

5driver = webdriver.Chrome(options=options)

6driver.get("<https://example.com>")

7html = driver.page_source

8print(html[:200])

9driver.quit()Vantagens:

- Lida com qualquer site que um navegador real acessa (conteúdo dinâmico, logins, pop-ups)

- Simula interações de usuário (cliques, digitação, etc.)

- Suporte multi-navegador

Desvantagens:

- Consome muitos recursos (cada instância usa RAM e CPU)

- Mais lento que raspagem via HTTP

- Curva de aprendizado maior (especialmente para concorrência)

- Pode ser detectado por sistemas anti-bot avançados

Melhor uso:

Raspagem de sites dinâmicos e interativos que exigem ações do usuário—como LinkedIn, dashboards ou áreas restritas ().

Requests: O Cliente HTTP Padrão do Python

O que é?

é a biblioteca “HTTP para Humanos”. É o jeito padrão de buscar páginas web ou APIs em Python—simples, confiável e onipresente.

Como usar:

Busque uma página estática:

1import requests

2response = requests.get("<https://www.example.com>")

3if response.status_code == 200:

4 html_text = response.text

5 print(html_text[:300])Vantagens:

- API extremamente simples

- Rápido e leve

- Lida com cookies, redirecionamentos e necessidades HTTP comuns

- Comunidade enorme, muitos tutoriais

Desvantagens:

- Não executa JavaScript nem lida com conteúdo dinâmico

- Não faz parsing de HTML (combine com Beautiful Soup ou lxml)

- Sem recursos anti-bot nativos (você precisa gerenciar headers, proxies, etc.)

Melhor uso:

Páginas estáticas, APIs ou qualquer site onde os dados estão no HTML inicial. Para iniciantes, Requests + Beautiful Soup é a dupla clássica ().

Beautiful Soup: Parsing HTML Fácil para Python

O que é?

(BS4) é uma biblioteca Python para parsing de HTML e XML. Não busca páginas sozinha—você combina com Requests ou Selenium—mas facilita encontrar e extrair dados do HTML.

Como usar:

Extraia nomes de produtos de uma página:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("<https://example.com/products>").text

4soup = BeautifulSoup(html, "html.parser")

5product_names = [tag.get_text() for tag in soup.find_all("h2", class_="product-name")]

6print(product_names)Vantagens:

- Fácil para iniciantes, tolerante a HTML malformado

- Busca flexível (por tag, classe, seletor CSS, regex)

- Leve e rápido para a maioria dos usos

- Muita documentação e exemplos

Desvantagens:

- Não busca páginas nem lida com JavaScript

- Mais lento que lxml para documentos grandes

- Menos poderoso para queries complexas (use lxml para XPath avançado)

Melhor uso:

Transformar HTML bruto em dados organizados—listas de produtos, tabelas ou links. Se você já tem o HTML, o Beautiful Soup ajuda a organizar ().

Playwright: Automação Moderna de Navegador para Python

O que é?

é a novidade da automação de navegadores, criado pela Microsoft. Assim como o Selenium, controla navegadores, mas é mais rápido, suporta múltiplos motores (Chromium, Firefox, WebKit) e tem uma API moderna.

Como usar:

Busque o conteúdo de uma página:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://example.com>")

6 content = page.content()

7 print(content[:200])

8 browser.close()Vantagens:

- Lida com sites dinâmicos e pesados em JS

- Suporte multi-navegador (Chromium, Firefox, WebKit)

- Espera automática por elementos (menos instável que Selenium)

- Suporta async e paralelismo

Desvantagens:

- Ainda consome muitos recursos (automação de navegador)

- Curva de aprendizado, especialmente para código assíncrono

- Não é imune a detecção anti-bot

Melhor uso:

Web apps modernos, sites que mudam conforme o navegador ou quando você precisa interceptar requisições de rede ().

Scrapy: Framework Escalável de Raspagem Web em Python

O que é?

é um framework completo para raspagem web. Feito para crawling em larga escala, com concorrência nativa, pipelines de itens e opções de exportação. Se você precisa raspar milhares de páginas, o Scrapy é seu aliado.

Como usar:

Defina um spider:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get()

10 }Execute com scrapy crawl quotes dentro de um projeto Scrapy.

Vantagens:

- Alta performance, concorrência nativa

- Estrutura de projeto organizada (spiders, pipelines, middlewares)

- Exportação fácil para CSV, JSON, bancos de dados

- Comunidade grande, muitos plugins

Desvantagens:

- Curva de aprendizado íngreme para iniciantes

- Requer configuração de projeto (não ideal para tarefas rápidas)

- Suporte limitado a JavaScript nativamente (precisa de add-ons)

Melhor uso:

Crawling estruturado em larga escala—como agregar anúncios imobiliários de vários sites ou catálogos inteiros de produtos ().

Urllib3: HTTP Confiável para Raspagem Web em Python

O que é?

é um cliente HTTP de baixo nível que serve de base para bibliotecas como Requests. Se você precisa de controle detalhado sobre conexões, tentativas ou pools, urllib3 é a escolha.

Como usar:

Busque uma página:

1import urllib3

2http = urllib3.PoolManager()

3resp = http.request("GET", "<http://httpbin.org/html>")

4if resp.status == 200:

5 html_text = resp.data.decode('utf-8')

6 print(html_text[:100])Vantagens:

- Pooling de conexões rápido e eficiente

- Thread-safe, ótimo para raspagem concorrente

- Controle detalhado do comportamento HTTP

Desvantagens:

- Mais manual que Requests

- Não faz parsing de HTML nem lida com JS

- Menos documentação para iniciantes

Melhor uso:

Cenários HTTP customizados, raspagem de alta concorrência ou quando você precisa de máxima performance ().

HTTPX: Biblioteca Moderna e Assíncrona para Raspagem Web em Python

O que é?

é o cliente HTTP de nova geração para Python. Parecido com Requests, mas com suporte a async e HTTP/2 nativo. Se você quer raspar milhares de páginas em paralelo, HTTPX é ideal.

Como usar:

Síncrono:

1import httpx

2response = httpx.get("<https://httpbin.org/get>")

3if response.status_code == 200:

4 data = response.json()

5 print(data)Assíncrono:

1import httpx, asyncio

2urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

3async def fetch(url, client):

4 resp = await client.get(url)

5 return resp.status_code

6async def scrape_all(urls):

7 async with httpx.AsyncClient(http2=True) as client:

8 tasks = [fetch(u, client) for u in urls]

9 results = await asyncio.gather(*tasks)

10 print(results)

11asyncio.run(scrape_all(urls))Vantagens:

- Suporte a async para raspagem concorrente

- HTTP/2 nativo (mais rápido para muitos sites)

- API parecida com Requests (migração fácil)

- Melhor tratamento de erros

Desvantagens:

- Mais novo, menos tutoriais que Requests

- Async exige conhecimento de event loop

- Não faz parsing de HTML nativamente

Melhor uso:

Raspagem de alta performance, APIs ou quando você precisa de velocidade para muitas páginas ().

lxml: Parsing Rápido e Poderoso de HTML/XML em Python

O que é?

é uma biblioteca de alta performance para parsing de HTML e XML, com suporte a XPath e seletores CSS. É o motor por trás de várias outras ferramentas (incluindo os seletores do Scrapy).

Como usar:

Extraia citações e autores:

1import requests

2from lxml import html

3page = requests.get("<http://quotes.toscrape.com>").content

4tree = html.fromstring(page)

5quotes = tree.xpath('//div[@class="quote"]/span[@class="text"]/text()')

6authors = tree.xpath('//div[@class="quote"]/small[@class="author"]/text()')

7print(list(zip(quotes, authors)))Vantagens:

- Extremamente rápido, mesmo para documentos grandes

- Suporte poderoso a XPath para queries complexas

- Eficiente em memória

Desvantagens:

- Curva de aprendizado para XPath

- Documentação menos amigável para iniciantes que o BS4

- Instalação pode ser complicada em alguns sistemas

Melhor uso:

Parsing de HTML/XML grande ou complexo, ou quando você precisa de queries avançadas ().

Pydantic: Validação de Dados para Resultados Limpos em Python

O que é?

não é um raspador—é uma biblioteca para validação e modelagem de dados. Depois de raspar, o Pydantic garante que seus dados estejam limpos, tipados e prontos para uso.

Como usar:

Valide dados raspados:

1from pydantic import BaseModel, validator

2from datetime import date

3class ProductItem(BaseModel):

4 name: str

5 price: float

6 listed_date: date

7 @validator('price')

8 def price_must_be_positive(cls, v):

9 if v <= 0:

10 raise ValueError('price must be positive')

11 return v

12raw_data = {"name": "Widget", "price": "19.99", "listed_date": "2025-02-15"}

13item = ProductItem(**raw_data)

14print(item.price, type(item.price))

15print(item.listed_date, type(item.listed_date))Vantagens:

- Validação rigorosa (identifica erros cedo)

- Conversão automática de tipos (string para número, datas, etc.)

- Modelos declarativos (código claro e fácil de manter)

- Lida com dados complexos e aninhados

Desvantagens:

- Curva de aprendizado para sintaxe dos modelos

- Adiciona um pouco de overhead ao pipeline

Melhor uso:

Garantir que os dados raspados estejam limpos, consistentes e prontos para análise ou importação ().

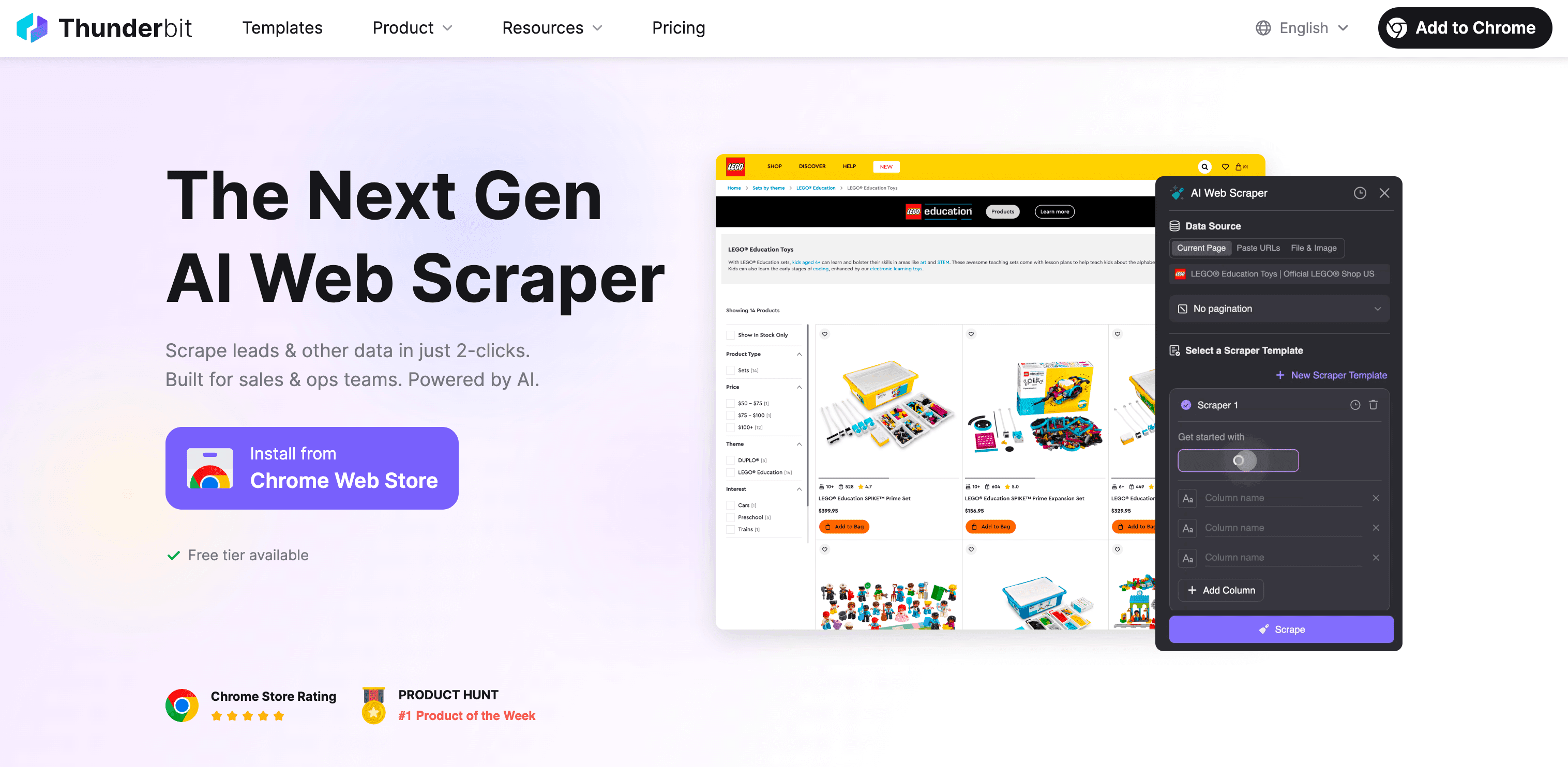

Alternativa Sem Código: Thunderbit Raspador Web IA para Usuários de Negócios

Vamos ser sinceros. Se você chegou até aqui e ainda pensa “Python é poderoso, mas não quero passar o fim de semana aprendendo XPath”, você não está sozinho. Foi exatamente por isso que criamos a .

O que é a Thunderbit?

Thunderbit é uma extensão Chrome de raspagem web com IA e sem código. Feita para profissionais de vendas, operações de e-commerce, marketing, corretores de imóveis—qualquer um que precise de dados da web sem se preocupar com código, proxies ou dores de cabeça anti-bot.

Por que a Thunderbit supera as bibliotecas python para quem não programa:

- Sem programação: Só clicar em “Sugerir Campos com IA”, deixar a IA da Thunderbit ler a página e clicar em “Raspar”. Pronto. Você pode raspar qualquer site, PDF ou imagem em dois cliques.

- Lida com conteúdo dinâmico: Como a Thunderbit funciona no seu navegador (ou na nuvem), ela captura dados de sites com JavaScript, rolagem infinita ou até conteúdo atrás de login.

- Raspagem de subpáginas: Precisa coletar detalhes de cada produto ou perfil? A Thunderbit visita cada subpágina e preenche sua tabela automaticamente.

- Estruturação de dados com IA: A Thunderbit sugere nomes de campos, tipos de dados e até prompts personalizados. Você pode rotular, formatar, traduzir e organizar os dados em tempo real.

- Resistência anti-bot: Sem precisar configurar proxies ou se preocupar com bloqueios—a Thunderbit usa sessões reais de navegador e IA para evitar a maioria das barreiras.

- Exportação flexível: Baixe seus dados para Excel, Google Sheets, Airtable, Notion, CSV ou JSON—de forma gratuita e ilimitada.

- Modelos prontos: Para sites populares (Amazon, Zillow, Instagram, Shopify, etc.), basta escolher um modelo e começar. Sem configuração, sem complicação.

- Recursos gratuitos: Extratores de e-mail, telefone e imagem são totalmente gratuitos. O preenchimento automático com IA para formulários online também.

Como ela se compara às bibliotecas python?

| Recurso | Bibliotecas Python | Thunderbit |

|---|---|---|

| Programação necessária | Sim | Não |

| Conteúdo dinâmico | Às vezes (navegador) | Sim (navegador/nuvem) |

| Anti-bot | Manual (proxies, headers) | Embutido (sessão navegador, IA) |

| Estruturação de dados | Manual (código, parsing) | IA, automático |

| Raspagem de subpáginas | Código customizado | 1 clique |

| Exportação | CSV/JSON (código) | Excel, Google Sheets, Airtable, Notion, etc. |

| Modelos prontos | DIY ou comunidade | Embutidos para sites populares |

| Manutenção | Você (atualiza scripts) | Equipe Thunderbit cuida das atualizações |

Para quem é a Thunderbit?

Se você trabalha com vendas, operações de e-commerce, marketing ou imóveis e precisa de dados da web—leads, preços, informações de produtos, anúncios—mas não tem perfil técnico, a Thunderbit foi feita pra você. É o jeito mais rápido de sair do “Preciso desses dados” para “Aqui está sua planilha”, sem precisar de Python.

Quer ver funcionando? e experimente grátis. Ou confira mais dicas no .

Conclusão: Como escolher a biblioteca python (ou ferramenta sem código) certa para raspagem web

Resumindo: as bibliotecas python para raspagem web são poderosas, flexíveis e podem lidar com praticamente qualquer cenário—se você domina código e está disposto a investir tempo. Veja um resumo rápido:

- ZenRows: Ideal para raspagem em larga escala de sites protegidos, com recursos anti-bot nativos.

- Selenium & Playwright: Ótimos para sites dinâmicos e interativos, mas mais pesados e complexos.

- Requests & HTTPX: Perfeitos para páginas estáticas e APIs; HTTPX brilha em raspagem assíncrona e rápida.

- Beautiful Soup & lxml: Os clássicos para parsing de HTML—BS4 para iniciantes, lxml para velocidade e queries avançadas.

- Scrapy: O framework para crawling estruturado em grande escala.

- urllib3: Para necessidades HTTP customizadas e alta concorrência.

- Pydantic: Garante que seus dados raspados estejam limpos e prontos para uso.

Mas se você não é programador—ou só quer o resultado rápido— é o atalho. Sem código, sem manutenção, só resultado.

Minha dica:

- Se você curte Python e quer controle total, escolha a biblioteca que se encaixa no seu caso e nível de habilidade.

- Se só quer os dados (e talvez dormir melhor), deixa a IA da Thunderbit fazer o trabalho pesado.

De qualquer forma, a web está cheia de dados esperando para virar insights. Seja você um expert em Python ou um profissional de negócios que prefere não mexer com código, existe uma solução para você em 2025. E se quiser conversar sobre raspagem, automação ou o melhor sabor de pizza para CEOs, já sabe onde me encontrar.

Boas raspagens!

Perguntas Frequentes

1. Quais são as bibliotecas python mais populares para raspagem web?

Algumas das bibliotecas python mais usadas para raspagem web são Requests para páginas estáticas, Selenium para sites dinâmicos com JavaScript e Scrapy para crawling em larga escala. A escolha depende da complexidade dos dados, necessidade de concorrência e do quão dinâmico é o conteúdo.

2. Como lidar com sites pesados em JavaScript durante a raspagem?

Para sites com muito JavaScript, Selenium e Playwright são ótimas opções. Elas simulam ações de navegador e carregam conteúdo dinâmico como um usuário real. ZenRows também é uma alternativa, oferecendo uma API simples que lida com JavaScript e bypass anti-bot sem configuração extra.

3. Como a Thunderbit pode ajudar meu negócio com raspagem web?

A Thunderbit é um raspador web IA sem código que permite a qualquer profissional coletar dados da web sem programação. Seja para preços de concorrentes, geração de leads ou dados de produtos, a Thunderbit facilita a raspagem com automação IA, lida com conteúdo dinâmico, recursos anti-bot e exportação em apenas dois cliques.

Saiba mais: