Imagine a situação: são 14h de uma terça-feira, o teu chefe pede uma lista de preços dos concorrentes e tu estás diante de um site cheio de dados valiosos — todos presos atrás de um muro de HTML. Vais arregaçar as mangas e começar a programar um raspador em Python? Ou preferias um botão mágico que resolvesse tudo num instante?

Hoje em dia, raspagem de dados na web já não é coisa só de hackers ou cientistas de dados com três ecrãs. Virou uma competência essencial para equipas de negócios, marketing, investigadores e qualquer pessoa que queira transformar páginas web em folhas de cálculo. O mercado de raspagem de dados está em alta — movimentou e continua a crescer. Mas, com tantas opções, escolher a ferramenta certa pode parecer como decidir entre um canivete suíço e um bisturi. Neste artigo, vamos comparar os dois gigantes do Python — Scrapy e Beautiful Soup — e mostrar onde entram soluções sem código como o para quem não quer programar.

Scrapy vs. Beautiful Soup: O Essencial do Web Scraping em Python

Se já pesquisaste por "Python scraper", de certeza que encontraste Scrapy e Beautiful Soup. Ambos são referências no universo Python, mas servem propósitos bem diferentes.

- Scrapy é um framework. Imagina um conjunto completo de eletrodomésticos: faz tudo, desde buscar páginas, seguir links, processar dados até exportar resultados. É feito para grandes volumes — rastreia centenas ou milhares de páginas, gere pedidos e mantém o fluxo de dados a funcionar.

- Beautiful Soup é uma biblioteca. Funciona como uma faca de chef afiada: perfeita para cortar e manipular HTML, mas tens de trazer os ingredientes (o HTML) e fazer o resto do trabalho (buscar, navegar, guardar) por tua conta.

Ambos servem para criar "raspadores em Python" — scripts ou programas que extraem dados de sites. Mas a escolha entre eles vai além das funções: depende do teu projeto e do teu à-vontade com programação.

Quando Usar Scrapy: Potência e Escalabilidade para Projetos de Raspagem de Dados

Se a missão é raspar um site de e-commerce inteiro — milhares de páginas de produtos, atualizações frequentes e até contornar bloqueios anti-bot — o Scrapy é a escolha certa.

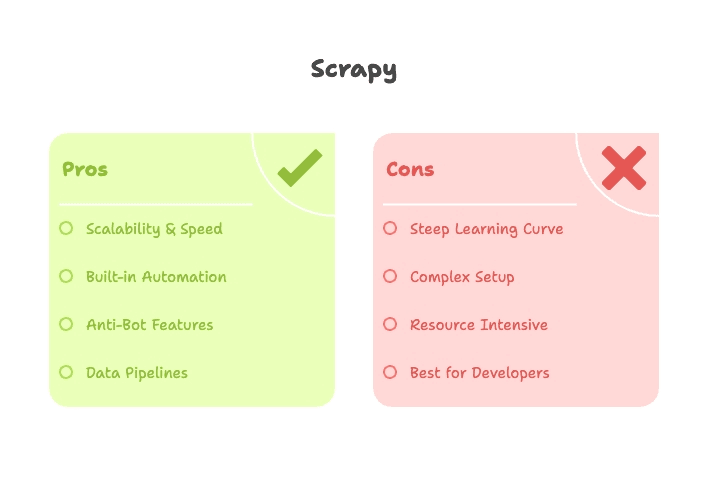

O Scrapy foi criado para raspagem de dados em grande escala e automatizada. Oferece:

- Pedidos assíncronos: Busca várias páginas ao mesmo tempo, acelerando o processo.

- Crawling integrado: Segue links automaticamente, lida com paginação e gere filas de URLs.

- Pipelines: Limpa, valida e exporta dados para CSV, JSON ou bases de dados — sem código extra.

- Rotação de proxy e user-agent: Ajuda a contornar bloqueios simples com funcionalidades nativas.

- Agendamento: Permite correr spiders em horários definidos para monitorização contínua ou atualização de dados.

Se precisas de algo que corra todos os dias, trate erros e cresça conforme a procura, o Scrapy é como ter uma equipa profissional na cozinha.

Pontos Fortes do Scrapy para Projetos em Python

- Escalabilidade: Capaz de rastrear milhares (ou milhões) de páginas, gerindo concorrência e memória de forma eficiente ().

- Velocidade: O motor assíncrono garante alto desempenho em grandes tarefas ().

- Extensibilidade: Precisas resolver CAPTCHAs, renderizar JavaScript ou exportar para S3? Existem plugins e middlewares para isso.

- Automação: Feito para raspagens recorrentes e robustas — basta configurar e deixar a correr.

Limitações e Curva de Aprendizagem do Scrapy

O senão: Scrapy não é tão amigável para quem está a começar. É preciso perceber spiders, pipelines, middlewares e a estrutura do projeto. A instalação pode ser trabalhosa (olá, dependências do Twisted) e depurar seletores sem interface visual exige paciência.

- Curva de aprendizagem acentuada: Vais gastar algumas horas (ou dias) até ter o teu primeiro spider a funcionar ().

- Exagerado para tarefas pequenas: Se só queres raspar uma página, o Scrapy pode ser mais do que precisas.

- Sites com JavaScript: O Scrapy puro não executa JavaScript — é preciso integrar com ferramentas como Splash ou Selenium para lidar com conteúdo dinâmico.

Beautiful Soup: Rápido, Flexível e Perfeito para Quem Está a Começar

Agora, se só queres apanhar as manchetes de um site de notícias ou extrair uma tabela da Wikipédia para uma análise pontual, o Beautiful Soup é ideal.

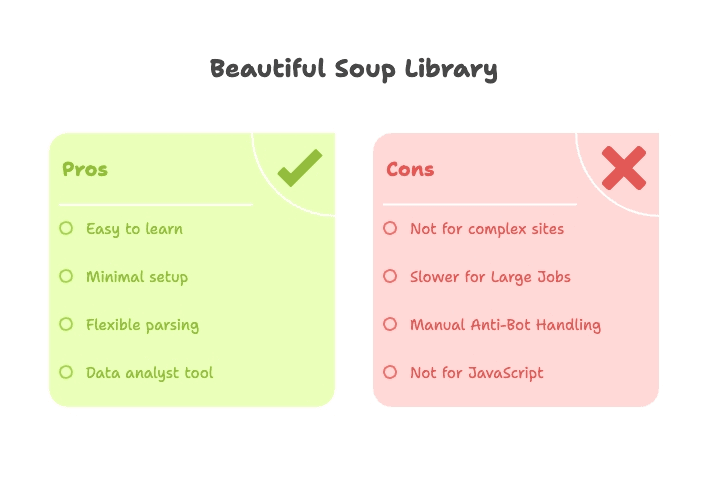

O Beautiful Soup é uma biblioteca leve para análise de HTML/XML. Não faz o download das páginas — normalmente, usas em conjunto com a biblioteca requests para descarregar o HTML e, depois, o Beautiful Soup para navegar e extrair os dados.

- Configuração mínima: Instala com pip, importa e começa a usar.

- Curva de aprendizagem suave: Mesmo quem está a começar em Python consegue resultados rapidamente ().

- Análise flexível: Pesquisa por tag, classe, ID ou texto — ótimo para HTML desorganizado.

Vantagens do Beautiful Soup para Iniciantes em Python

- Fácil para quem está a começar: Não exige aprender um framework — só o básico de Python e HTML.

- Resultados rápidos: Ideal para prototipagem, trabalhos académicos ou extrações pontuais.

- Flexível: Integra facilmente com outras bibliotecas Python (requests, pandas, etc.).

- Lida bem com HTML "sujo": O Beautiful Soup é tolerante até com marcação mal feita.

Onde o Beautiful Soup Não Chega

Mas o Beautiful Soup não é uma solução completa:

- Sem crawling integrado: Tens de criar ciclos para navegar entre páginas.

- Mais lento em grandes volumes: Funciona de forma sequencial; para centenas de páginas, pode ser demorado.

- Recursos anti-bot limitados: Tens de configurar headers ou proxies manualmente e lidar com bloqueios por tua conta.

- Não lida com conteúdo dinâmico: Se o site depende de JavaScript, vais precisar de Selenium ou Playwright.

Scrapy vs. Beautiful Soup: Comparação de Funcionalidades

Vamos pôr lado a lado:

| Recurso | Scrapy | Beautiful Soup |

|---|---|---|

| Tipo | Framework (completo) | Biblioteca (apenas parser) |

| Configuração | Estrutura de projeto, CLI, ficheiros de config | Script simples, pip install |

| Melhor para | Raspar em larga escala, tarefas recorrentes e automação | Tarefas pequenas, prototipagem, extrações pontuais |

| Velocidade | Rápido em escala (assíncrono, concorrente) | Rápido para poucas páginas, lento em escala |

| Crawling | Integrado (segue links, paginação) | Manual (tu crias os ciclos) |

| Anti-bot | Proxies, rotação de user-agent, retries, plugins | Manual (headers, proxies no requests) |

| Extensibilidade | Plugins, middlewares, pipelines | Combina com outras libs Python |

| Curva de aprendizagem | Íngreme (spiders, pipelines, async) | Suave (Python básico + HTML) |

| Conteúdo dinâmico | Precisa de plugins (Splash, Selenium) | Precisa de Selenium/Playwright |

| Exportação de dados | CSV, JSON, bases de dados (nativo) | Manual (escrever em ficheiro ou usar pandas) |

| Perfil ideal | Devs, engenheiros de dados, projetos contínuos | Iniciantes, analistas, scripts rápidos |

Resumindo: Scrapy é indicado para tarefas grandes, complexas ou recorrentes — se dominas Python e frameworks. Beautiful Soup é ótimo para tarefas pequenas, pontuais ou para quem está a começar.

Curva de Aprendizagem: Qual Python Scraper é Mais Simples para Iniciantes?

Vamos ser sinceros — ninguém quer passar uma semana a aprender uma ferramenta só para extrair uma tabela de um site.

- Beautiful Soup: Dá para sair do zero e raspar dados numa tarde. Só precisas de Python básico e um pouco de HTML. Existem muitos tutoriais e o resultado aparece rápido ().

- Scrapy: É preciso perceber spiders, pipelines, fluxo assíncrono e ferramentas de linha de comandos. Não é nenhum bicho de sete cabeças, mas exige mais do que um simples "hello world" ().

Se não és técnico ou queres resolver rápido, o Beautiful Soup é uma porta de entrada mais simpática. Mas, se queres criar um raspador que corra todos os dias, trate erros e escale, vale a pena investir tempo no Scrapy.

Performance e Recursos Anti-Bot: Scrapy vs. Beautiful Soup na Prática

Performance:

- Scrapy: Gere concorrência nativamente. Dá para raspar 16, 32 ou mais páginas em paralelo, acelerando grandes tarefas ().

- Beautiful Soup: Funciona de forma sequencial, a não ser que adiciones lógica de threads ou async. Ótimo para poucas páginas, mas lento para grandes volumes.

Anti-bot:

- Scrapy: Tem middlewares para proxies, rotação de user-agent, retries e até plugins para resolver CAPTCHA ou renderizar JavaScript ().

- Beautiful Soup: Fazes tudo manualmente. Podes configurar headers ou proxies, mas não há proteção nativa. Se fores bloqueado, tens de ajustar o script por tua conta ().

Casos de Uso: Qual Python Scraper Combina com o Teu Projeto?

Um guia rápido para escolheres a ferramenta certa:

| Caso de Uso | Melhor Ferramenta | Porquê? |

|---|---|---|

| Geração de leads (pequeno volume) | Beautiful Soup | Extração rápida e pontual de poucas páginas |

| Geração de leads (grande volume/contínuo) | Scrapy ou Thunderbit | Scrapy para devs, Thunderbit para não técnicos — ambos lidam com escala e automação |

| Monitorização de preços em e-commerce | Scrapy ou Thunderbit | Scrapy para crawls customizados e recorrentes; Thunderbit para raspagem instantânea sem código |

| Monitorização de conteúdo/notícias | Scrapy ou Thunderbit | Scrapy para crawls agendados em vários sites; Thunderbit para utilizadores de negócios, configuração rápida |

| Auditoria SEO (poucas páginas) | Beautiful Soup | Fácil de programar, resultados rápidos |

| Auditoria SEO (site inteiro) | Scrapy | Rastreia centenas de páginas, exporta dados estruturados |

| Raspagem de redes sociais | Thunderbit | Modelos prontos, lida com conteúdo dinâmico, sem necessidade de código |

| Pesquisa académica (pontual) | Beautiful Soup | Prototipagem rápida, configuração mínima |

| Enriquecimento/agregação de dados | Thunderbit | Enriquecimento com IA, exportação fácil para Sheets/Airtable |

Para a maioria dos profissionais de negócios, se não és programador, ferramentas como o são um verdadeiro salva-vidas (ou melhor, um grande poupador de tempo).

Para Além do Python: Conhece o Thunderbit para Raspagem de Dados Sem Código

Agora, vamos ao que interessa: nem toda a gente quer programar. E, sinceramente, não devia ser preciso — principalmente se o objetivo é transformar uma página numa folha de cálculo, não lançar um foguetão.

É aqui que entra o . O Thunderbit é um raspador web IA sem código — uma extensão do Chrome que permite extrair dados de qualquer site em poucos cliques. Vê como muda o jogo:

- Sem Python, sem complicações: Instala a extensão, abre a página e já está.

- Sugestão de campos por IA: Clica em “Sugerir Campos com IA” e o Thunderbit lê a página, recomenda colunas e monta a tua tabela automaticamente ().

- Raspagem de subpáginas: Precisas de extrair detalhes de páginas ligadas? O Thunderbit segue os links e enriquece os teus dados — sem ciclos ou spiders complicados ().

- Paginação e scroll infinito: Lida com listas de várias páginas ou rolagem infinita com um simples ajuste.

- Exportação instantânea: Envia os dados diretamente para Google Sheets, Airtable, Notion ou descarrega como CSV/Excel ().

- Pré-visualização em tempo real: Vê os resultados enquanto raspa — chega de "correr e rezar" no código.

- Enriquecimento com IA: Resume, categoriza ou traduz dados automaticamente ().

E sim, o Thunderbit ainda oferece modelos prontos para sites populares como Amazon, LinkedIn, Google Maps e outros. Para a maioria das necessidades de raspagem de dados em negócios, é o mais próximo de "carregar num botão" que vais encontrar.

Por Que Optar pelo Thunderbit em Vez de Ferramentas Python?

- Curva de aprendizagem zero: Não precisas de saber Python, HTML ou como resolver erro 403. Se usas navegador, consegues usar o Thunderbit.

- Rapidez: Do “preciso destes dados” ao “aqui está a tua folha de cálculo” em minutos — não horas ou dias.

- Sem manutenção: A IA do Thunderbit adapta-se a muitas mudanças nos sites e os modelos são atualizados pela equipa. Chega de scripts a falhar de madrugada.

- Anti-bloqueio: Funciona no teu navegador (parece um utilizador real) ou na nuvem, com estratégias integradas para evitar bloqueios.

- Colaboração: Partilha modelos e resultados com a tua equipa, sem repositórios de código ou controlo de versões.

- Custo-benefício: Plano gratuito para tarefas pequenas e opções acessíveis para projetos maiores ().

Para vendas, marketing, operações ou qualquer um que precise de dados para ontem, o Thunderbit é um verdadeiro descanso. (E, como alguém que já perdeu noites a depurar scripts Python, posso garantir que faz diferença!)

Como Escolher a Ferramenta de Raspagem de Dados Ideal: Guia Prático

Então, qual ferramenta escolher? Vê este passo a passo rápido:

- Sentes-te confortável a programar em Python?

- Sim: Vai para o passo 2.

- Não: Usa o ou outra solução sem código.

- O teu projeto é pequeno (uma página, pontual ou protótipo)?

- Sim: Usa Beautiful Soup (com requests).

- Não: Usa Scrapy para tarefas grandes, recorrentes ou complexas.

- Precisas de lidar com bloqueios, concorrência ou automação?

- Sim: Scrapy é a melhor opção.

- Não: Beautiful Soup resolve tarefas simples e de baixo risco.

- Queres resultados instantâneos, exportação fácil ou colaboração em equipa?

- Sim: Thunderbit é o caminho — sem código, sem complicação.

Confere este checklist:

| A Tua Necessidade | Melhor Ferramenta |

|---|---|

| Sem código, resultado instantâneo | Thunderbit |

| Tarefa pequena, pontual e programável | Beautiful Soup |

| Raspagem grande, automatizada e complexa | Scrapy |

| Coleta de dados recorrente para negócios | Thunderbit ou Scrapy |

| Prototipagem académica | Beautiful Soup |

Conclusão: Scrapy, Beautiful Soup ou Thunderbit — Qual é o Melhor para Ti?

A raspagem de dados está mais acessível — e mais importante — do que nunca. Sejas tu um programador a montar um pipeline robusto ou um profissional de negócios a querer transformar uma página numa folha de cálculo, existe uma ferramenta ideal para o que precisas.

- Scrapy: Melhor para programadores, projetos grandes, recorrentes ou complexos. Potente, mas exige aprendizagem.

- Beautiful Soup: Perfeito para iniciantes, analistas ou quem precisa de extrair dados de poucas páginas. Simples, flexível e ótimo para prototipagem.

- Thunderbit: A solução sem código, com IA, para todos os outros. Se queres evitar programação, depuração e manutenção, o Thunderbit permite raspar, enriquecer e exportar dados em minutos — diretamente do navegador.

Se queres experimentar a raspagem sem código, e testa. Ou espreita o nosso para mais dicas, tutoriais e exemplos de uso.

No fim do dia, a melhor ferramenta é aquela que te entrega os dados que precisas — sem transformar a tua tarde de terça numa maratona de depuração em Python. E, se quiseres trocar ideias sobre raspagem de dados, já sabes onde me encontrar.

Perguntas Frequentes

1. Qual é melhor para iniciantes: Scrapy ou Beautiful Soup?

Beautiful Soup é muito mais amigável para quem está a começar. É fácil de instalar, simples de perceber e ideal para tarefas pequenas. Scrapy é poderoso, mas tem uma curva de aprendizagem maior — indicado para programadores que precisam de raspadores grandes ou recorrentes.

2. Posso usar Scrapy ou Beautiful Soup sem programar?

Na prática, não. Ambos exigem conhecimentos de Python e um pouco de HTML. Se não queres escrever scripts, uma ferramenta sem código como o é a melhor escolha — permite raspar dados usando linguagem natural, diretamente no navegador.

3. Preciso usar Scrapy e Beautiful Soup juntos?

Na maioria dos casos, não. O Scrapy tem o seu próprio motor de parsing e funciona de forma independente. Beautiful Soup costuma ser usado sozinho em tarefas menores. Utilizadores avançados às vezes combinam os dois, mas raramente é necessário — especialmente se procuras resultados rápidos e práticos.

4. E se o site usa JavaScript ou scroll infinito?

Nem Scrapy nem Beautiful Soup lidam com JavaScript nativamente — é preciso integrar ferramentas como Selenium. O lida automaticamente com muitos sites modernos, incluindo scroll infinito ou conteúdo dinâmico.

5. Só preciso transformar uma página em folha de cálculo. Preciso mesmo de aprender Python?

Não. Se o objetivo é obter dados estruturados rapidamente — como importar uma lista de preços ou diretório para o Excel — aprender Scrapy ou Beautiful Soup pode ser exagerado. O faz isso em dois cliques, sem escrever uma linha de código.

Queres saber mais? Espreita , , ou explora outros conteúdos no .