Deixa eu te contar como foi minha primeira tentativa de extrair dados de produtos de um site de ecommerce. Eu estava com o Python aberto, café do lado e aquela ideia de criar um rastreador de preços para a Amazon. Algumas horas depois, o tal “projetinho rápido” virou um nó de seletores XPath, dor de cabeça com paginação e mais tempo depurando código do que eu gostaria de admitir. Se você já tentou coletar dados da web programando, sabe bem como é essa mistura de empolgação e frustração: “por que isso é tão complicado?”

A real é que a raspagem web não é mais só para cientista de dados ou engenheiro. Hoje, virou habilidade básica para quem trabalha com vendas, ecommerce, marketing ou qualquer um que queira transformar o caos da internet em informação útil para o negócio. Só para ter uma noção, o mercado de softwares de raspagem web bateu , e só vai crescer. Apesar do Python e frameworks como o Scrapy seguirem como referência para projetos robustos e sob medida, eles não são nada amigáveis para quem está começando. Por isso, neste tutorial, vou te mostrar o passo a passo do Scrapy com um exemplo real na Amazon — e apresentar uma alternativa muito mais simples, com IA, para quem não programa: o .

O que é Scrapy Python? Sua Ferramenta Potente de Raspagem Web

Vamos do começo. Scrapy é um framework open-source em Python feito especialmente para rastrear e raspar dados da web. Imagina um kit completo para criar spiders (é assim que o Scrapy chama seus robôs) que navegam em sites, seguem links, lidam com paginação e extraem dados estruturados em grande escala.

Qual a diferença do Scrapy para usar só requests e BeautifulSoup? Essas bibliotecas são ótimas para tarefas simples, mas o Scrapy foi feito para projetos grandes e complexos, quando você precisa:

- Rastrear milhares de páginas (tipo todo o catálogo de uma loja)

- Seguir links e lidar com paginação automaticamente

- Processar dados de forma assíncrona para ganhar velocidade

- Estruturar, limpar e exportar dados de forma repetida

Resumindo: o Scrapy é tipo um canivete suíço da raspagem web — poderoso, flexível e (para quem está começando) um pouco assustador.

Por que Usar Scrapy Python para Raspagem Web?

Mas afinal, por que tanta gente de dados e dev escolhe o Scrapy? Olha só:

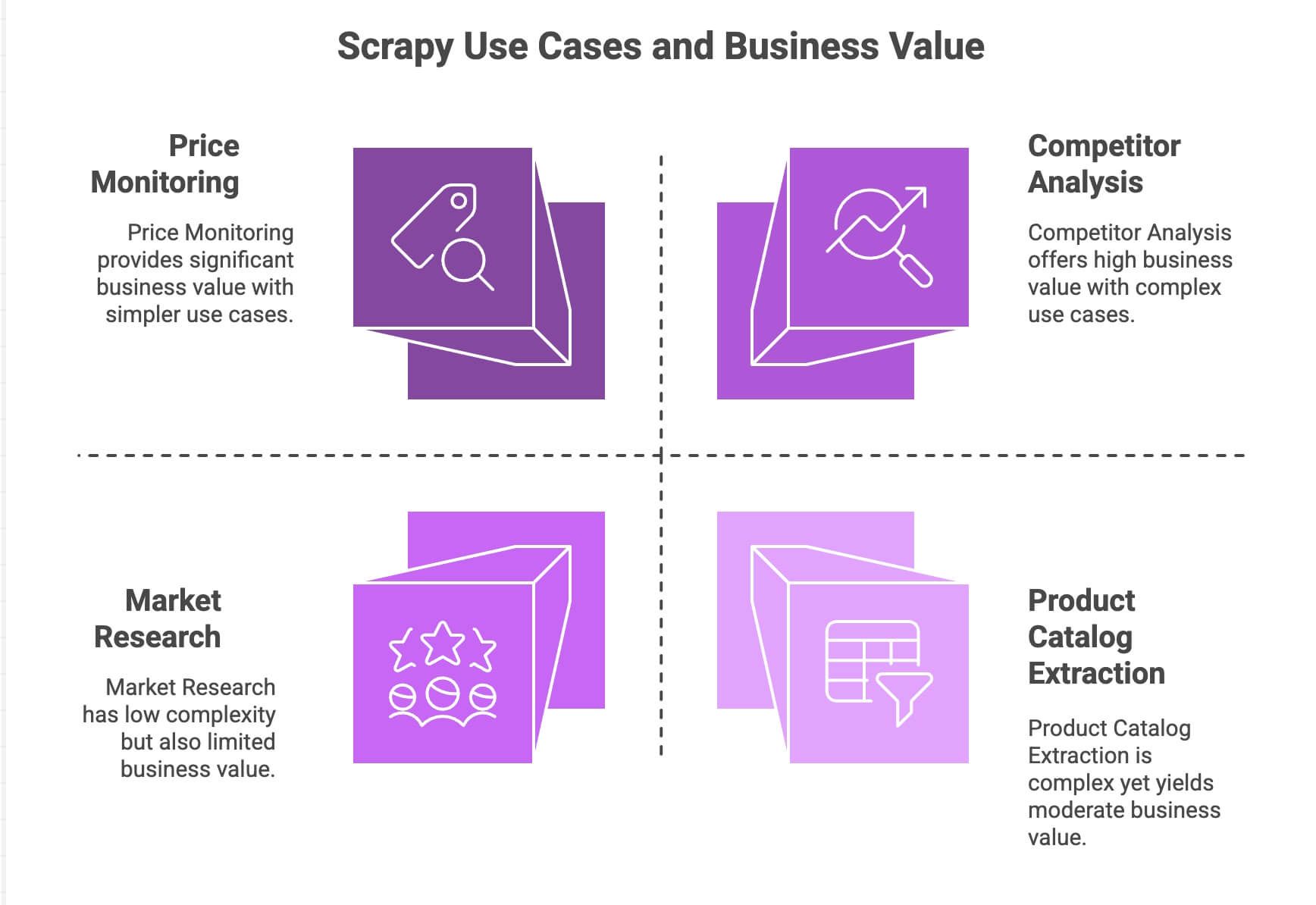

| Caso de Uso | Pontos Fortes do Scrapy | Valor para o Negócio |

|---|---|---|

| Monitoramento de Preços | Lida com paginação, requisições assíncronas, agendamento | Fique à frente da concorrência, ajuste preços dinamicamente |

| Extração de Catálogo de Produtos | Segue links, extrai dados estruturados | Monte bancos de dados, alimente análises |

| Análise de Concorrentes | Escalável, resistente a mudanças no site | Acompanhe tendências, lançamentos, estoque |

| Pesquisa de Mercado | Pipelines modulares para limpar/transformar dados | Agregue avaliações, faça análise de sentimento |

O motor assíncrono do Scrapy (baseado no Twisted) permite buscar várias páginas ao mesmo tempo, deixando tudo mais rápido e escalável. Sua arquitetura modular facilita adicionar lógicas personalizadas (tipo proxies, user-agents ou etapas de limpeza de dados). E com os pipelines, você pode processar, validar e exportar os dados do jeito que quiser — CSV, JSON, banco de dados, etc.

Para quem já manja de Python, o Scrapy é uma máquina. Mas sejamos sinceros: para o usuário comum, não é nada “plug and play”.

Como Configurar o Ambiente Scrapy Python

Bora colocar a mão na massa? Veja como começar do zero:

1. Instale o Scrapy

Primeiro, garanta que você tem Python 3.9+ instalado. Depois, abre o terminal e digita:

1pip install scrapyConfere se deu certo com:

1scrapy versionSe estiver no Windows ou usando Anaconda, vale criar um ambiente virtual para evitar dor de cabeça. O Scrapy roda em Windows, macOS e Linux.

2. Crie um Novo Projeto Scrapy

Vamos criar um projeto chamado amazonscraper:

1scrapy startproject amazonscraperVocê vai ver uma estrutura de pastas assim:

1amazonscraper/

2├── scrapy.cfg

3├── amazonscraper/

4│ ├── __init__.py

5│ ├── items.py

6│ ├── pipelines.py

7│ ├── middlewares.py

8│ ├── settings.py

9│ └── spiders/Para que serve cada arquivo?

scrapy.cfg: Configuração do projeto (quase nunca mexe)items.py: Define os modelos de dados (ex: Produto com nome, preço, etc.)pipelines.py: Onde você limpa, valida e exporta os dadosmiddlewares.py: Recursos avançados (proxies, headers customizados)settings.py: Ajusta o comportamento do Scrapy (concorrência, delays, etc.)spiders/: Onde fica o código de raspagem mesmo

Se já bateu aquele frio na barriga, relaxa — é normal. Muita gente trava aqui.

Construindo um Raspador Python: Extraindo Dados de Produtos da Amazon com Scrapy

Vamos para um exemplo prático: extrair dados de produtos dos resultados de busca da Amazon. (Atenção: a Amazon proíbe raspagem nos termos de uso e tem barreiras anti-bot. Use só para fins educativos!)

1. Crie um Spider

Dentro da pasta spiders/, crie o arquivo amazon_spider.py:

1import scrapy

2class AmazonSpider(scrapy.Spider):

3 name = "amazon_example"

4 allowed_domains = ["amazon.com"]

5 start_urls = ["https://www.amazon.com/s?k=smartphones"]

6 def parse(self, response):

7 products = response.xpath("//div[@data-component-type='s-search-result']")

8 for product in products:

9 yield {

10 'name': product.xpath(".//span[@class='a-size-medium a-color-base a-text-normal']/text()").get(),

11 'price': product.xpath(".//span[@class='a-price-whole']/text()").get(),

12 'rating': product.xpath(".//span[@aria-label]/text()").get()

13 }

14 next_page = response.xpath("//li[@class='a-last']/a/@href").get()

15 if next_page:

16 yield scrapy.Request(url=response.urljoin(next_page), callback=self.parse)O que está rolando aqui?

- Começamos numa página de resultados da Amazon para “smartphones”

- Para cada produto, extraímos nome, preço e avaliação usando seletores XPath

- Procuramos o link da próxima página e pedimos para o Scrapy seguir, coletando mais produtos

2. Execute seu Spider

No diretório do projeto, rode:

1scrapy crawl amazon_example -o products.jsonPronto — o Scrapy vai percorrer os resultados, seguir a paginação e salvar os dados num arquivo JSON.

Lidando com Paginação e Conteúdo Dinâmico

O suporte nativo do Scrapy para seguir links e lidar com paginação é um dos seus grandes diferenciais. Mas e quando a página carrega dados via JavaScript? Por padrão, o Scrapy só vê o HTML estático. Se precisar extrair conteúdo dinâmico (tipo scroll infinito ou pop-ups), vai ter que integrar com ferramentas como Selenium ou Splash. Aí complica um pouco mais.

Processando e Exportando Dados com Scrapy Python

Depois de coletar os dados, provavelmente você vai querer limpá-los e exportar para algum lugar útil.

- Pipelines: No

pipelines.py, você pode criar classes Python para limpar, validar ou enriquecer os dados (ex: converter preços para número, remover linhas incompletas ou até traduzir textos via API) - Exportação: O Scrapy exporta direto para CSV, JSON ou XML usando o parâmetro

-o. Para exportações mais avançadas (tipo enviar para Google Sheets), vai precisar programar ou usar bibliotecas de terceiros.

Quer fazer análise de sentimento ou traduzir descrições? Vai precisar integrar APIs externas ou bibliotecas Python — não é nativo.

Os Desafios Ocultos: Limitações do Scrapy Python para Usuários de Negócios

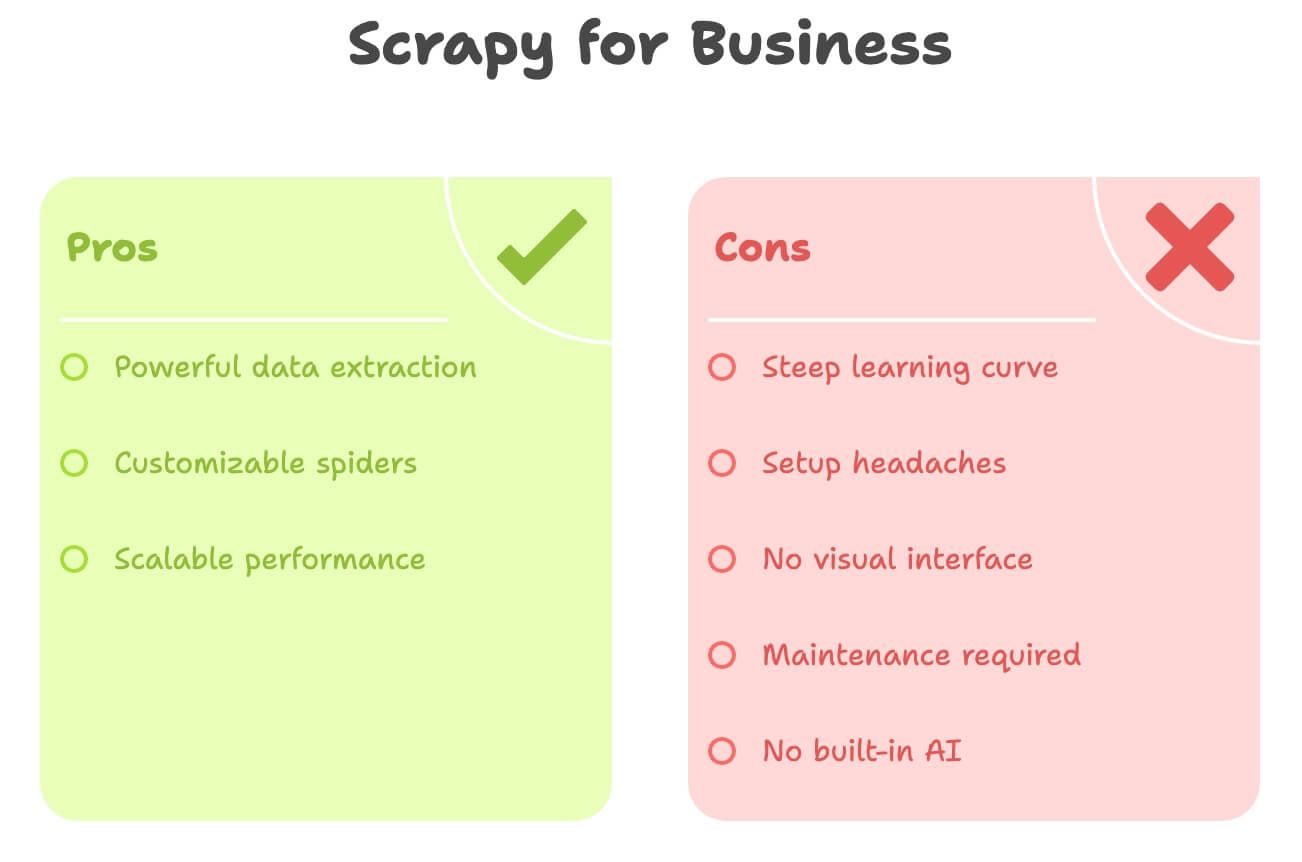

Vamos ser sinceros: o Scrapy é potente, mas está longe de ser amigável para quem não é dev. Olha os principais obstáculos:

- Curva de Aprendizado Íngreme: Precisa saber Python, HTML, seletores XPath/CSS e a estrutura do Scrapy. Leva dias ou semanas para pegar o jeito.

- Dores na Instalação: Instalar Python, gerenciar dependências e resolver erro é chato — principalmente no Windows.

- Sem Interface Visual: Tudo é feito por código. Não dá para só clicar e selecionar os dados.

- Manutenção: Se o site muda, seu spider quebra. E você tem que arrumar.

- Sem IA Embutida: Quer traduzir, resumir ou analisar sentimento? Tem que programar à parte.

Olha um comparativo rápido:

| Desafio | Scrapy (Python) | Necessidades do Usuário de Negócios |

|---|---|---|

| Precisa Programar | Sim | Preferem sem código |

| Tempo de Configuração | Horas (ou dias) | Minutos |

| Manutenção | Constante (mudanças no site) | Mínima |

| Exportação de Dados | CSV/JSON (integração manual) | Direto para Excel/Sheets/Notion |

| Recursos de IA | Nenhum (integração manual) | Tradução/sentimento embutidos |

Se você é do marketing, vendas ou operações, usar Scrapy pode ser como usar um canhão para matar uma formiga.

Conheça o Thunderbit: A Alternativa Sem Código ao Scrapy Python

É aí que entra o . Depois de anos criando ferramentas de automação, posso dizer: a maioria dos profissionais de negócios não quer programar — só quer os dados, rápido.

O Thunderbit é um raspador web com IA em formato de extensão para Chrome. Ele foi feito para quem não é técnico e quer:

- Extrair dados de qualquer site em poucos cliques

- Usar linguagem natural para descrever o que precisa (“Nome do Produto, Preço, Avaliação”)

- Lidar com paginação e subpáginas automaticamente

- Exportar direto para Excel, Google Sheets, Airtable ou Notion

- Traduzir, resumir ou analisar sentimento na hora

Sem Python. Sem seletores. Sem dor de cabeça com manutenção.

O Thunderbit foi pensado para quem precisa agilidade e quer deixar o trabalho pesado para a IA.

Thunderbit vs. Scrapy Python: Comparativo Lado a Lado

Olha como eles se comparam:

| Aspecto | Scrapy (Python) | Thunderbit (Ferramenta de IA) |

|---|---|---|

| Habilidade Necessária | Python, HTML, seletores | Nenhuma — só clicar e descrever |

| Tempo de Configuração | Horas (instalar, codar, depurar) | Minutos (instalar extensão, fazer login) |

| Estruturação de Dados | Manual (definir itens, pipelines) | IA detecta colunas e sugere campos |

| Paginação/Subpáginas | Precisa programar | 1 clique (IA faz tudo) |

| Tradução | Código próprio ou API | Embutido — só ativar “Traduzir” |

| Análise de Sentimento | Biblioteca/API externa | Embutido — adicione coluna “Sentimento” |

| Exportação | CSV/JSON (importação manual) | 1 clique para Excel, Google Sheets, Airtable, Notion |

| Manutenção | Manual (atualizar código se o site mudar) | IA se adapta a pequenas mudanças automaticamente |

| Escala | Melhor para grandes projetos contínuos | Ideal para tarefas rápidas, escala moderada (centenas/milhares de linhas) |

| Custo | Gratuito (mas consome tempo/recursos de dev) | Plano grátis + pagos (a partir de R$ 9/mês, economiza tempo e dor de cabeça) |

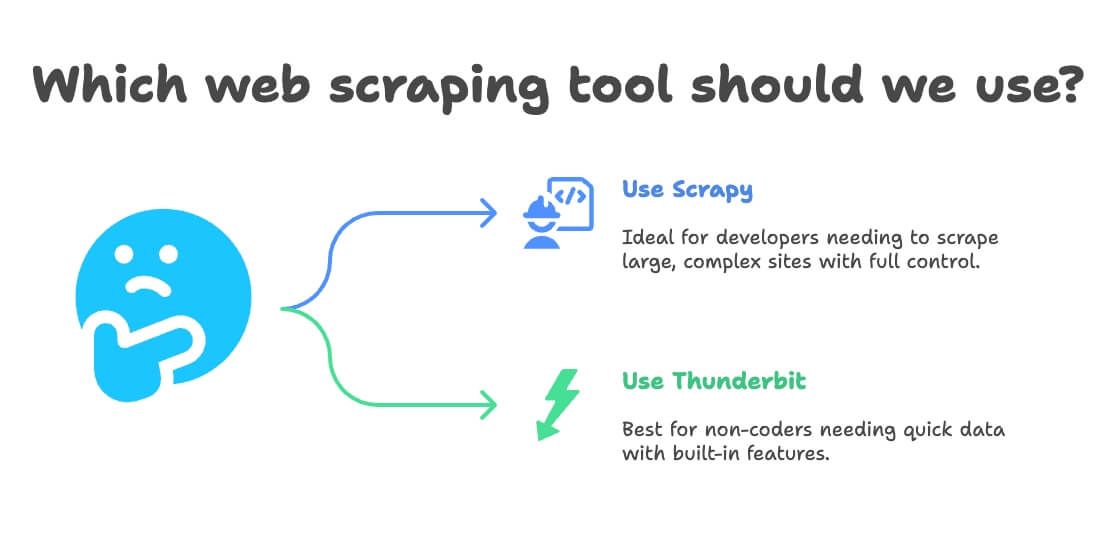

Quando Escolher Scrapy Python ou Thunderbit para Raspagem Web

Minha dica:

- Use Scrapy se:

- Você é dev ou tem um na equipe

- Precisa extrair dezenas de milhares de páginas ou criar pipelines personalizados e contínuos

- O site é muito complexo ou exige lógica avançada

- Quer controle total (e não se importa com manutenção)

- Use Thunderbit se:

- Não programa (ou não quer programar)

- Precisa dos dados rápido, para tarefas pontuais ou recorrentes

- Quer tradução, sentimento ou enriquecimento de dados embutidos

- Valoriza agilidade e flexibilidade mais do que customização extrema

Olha um fluxograma rápido:

- Você sabe programar em Python?

- Sim → Scrapy ou Thunderbit (para tarefas rápidas)

- Não → Thunderbit

- Seu projeto é grande e contínuo?

- Sim → Scrapy

- Não → Thunderbit

- Precisa de tradução ou análise de sentimento?

- Sim → Thunderbit

- Não → Qualquer um

Passo a Passo: Extraindo Dados de Produtos da Amazon com Thunderbit (Sem Código)

Vamos refazer o exemplo da Amazon — agora, do jeito fácil.

1. Instale o Thunderbit

- Cadastre-se (tem plano gratuito)

2. Acesse a Amazon e Pesquise seu Produto

- Abra e pesquise por “laptops” (ou qualquer produto)

3. Abra o Thunderbit na Página

- Clique no ícone do Thunderbit no navegador

- O painel lateral vai abrir, reconhecendo a página da Amazon

4. Use o AI Suggest Fields

- Clique em “AI Suggest Fields”

- A IA do Thunderbit analisa a página e sugere colunas como “Nome do Produto”, “Preço”, “Avaliação”, “Número de Avaliações”

- Adicione ou remova colunas conforme quiser (quer “URL do Produto” ou “Prime”? Só digitar)

5. Ative Paginação e Raspagem de Subpáginas

- Ative Paginação: o Thunderbit vai clicar em “Próxima” e coletar todas as páginas

- Ative Raspagem de Subpáginas: o Thunderbit visita a página de cada produto e coleta mais informações (tipo descrição ou ASIN)

6. Inicie a Raspagem

- Clique em Scrape

- Veja o Thunderbit coletando os dados em tempo real, página por página

7. Traduza e Analise Sentimento (Opcional)

- Quer traduzir descrições? Ative “Traduzir” para a coluna desejada

- Quer analisar sentimento das avaliações? Adicione a coluna “Sentimento” — a IA do Thunderbit preenche para você

8. Exporte seus Dados

- Clique em Exportar

- Escolha Excel, Google Sheets, Airtable ou Notion

- Pronto! Dados prontos para uso — sem importar manualmente, sem dor de cabeça com CSV

9. Agende Raspagens Recorrentes (Opcional)

- Programe um horário (ex: diariamente às 8h)

- O Thunderbit executa a raspagem automaticamente e atualiza o destino escolhido

Simples assim. Sem código, sem seletores, sem manutenção. Só dados prontos para o negócio.

Dicas Extras: Como Potencializar seus Projetos de Raspagem Web

Seja usando Scrapy, Thunderbit ou qualquer outra ferramenta, aqui vão algumas dicas que aprendi na prática:

- Valide seus Dados: Sempre confira se tem valor faltando ou estranho (tipo preço zerado ou nome em branco)

- Respeite as Regras: Veja os termos de uso do site, respeite o

robots.txte não sobrecarregue servidores - Automatize com Consciência: Use agendamento para manter os dados atualizados, mas não raspe mais do que precisa

- Aproveite Ferramentas Gratuitas: O Thunderbit inclui extratores gratuitos de e-mail, telefone e imagens — ótimo para geração de leads ou curadoria de conteúdo

- Organize para Análise: Exporte direto para Sheets/Excel para filtrar, cruzar e visualizar rapidinho

Para mais dicas, dá uma olhada no ou no .

Para mais dicas, dá uma olhada no ou no .

Conclusão: Raspagem Web Descomplicada — Escolha a Ferramenta Certa para sua Equipe

Resumindo: Scrapy é uma potência para devs, mas é exagero para a maioria dos profissionais de negócios. Se você domina Python e precisa de um raspador personalizado e robusto, o Scrapy é excelente. Mas se quer agilidade, sem código, e dados prontos (com tradução e análise de sentimento inclusas), o é a melhor escolha.

Já vi de perto o quanto o Thunderbit economiza tempo e evita dor de cabeça para equipes não técnicas. Você sai do “queria ter esses dados” para “já está na minha planilha” em minutos — não em horas ou dias. E com recursos como AI Suggest Fields, raspagem de subpáginas e exportação em um clique, nunca foi tão fácil transformar a web em inteligência para o negócio.

Então, da próxima vez que precisar extrair dados de produtos, monitorar preços ou montar uma lista de leads, pergunte-se: você quer programar em Python ou quer resultado? Teste o plano gratuito do Thunderbit e veja como a raspagem web pode ser muito mais simples.

Quer saber mais? Acesse o , ou aprofunde-se nas melhores práticas de raspagem web no .

Leituras recomendadas:

Aviso legal: Sempre garanta que suas atividades de raspagem web estejam de acordo com os termos do site e as leis locais. Em caso de dúvida, consulte um advogado — ninguém quer receber uma notificação judicial por causa de uma planilha.

Escrito por Shuai Guan, Co-fundador & CEO da Thunderbit. Anos de experiência em SaaS, automação e IA — para você não precisar passar por isso.