Se você já ficou encarando um site e pensou “será que dá pra puxar todas essas informações direto pra uma planilha, sem perder horas no copia e cola?”, pode ter certeza: você não está sozinho. Em 2025, extrair dados da web virou rotina, não só pra quem programa, mas pra qualquer empresa que quer se manter competitiva. Seja o pessoal de vendas montando lista de leads, ou quem cuida de e-commerce de olho nos preços dos concorrentes, todo mundo quer dados da web — e quer pra ontem. A boa notícia? Python deixou o processo de raspagem de dados super acessível, até pra quem só mexeu com código na época de personalizar o Orkut.

Neste passo a passo, vou te mostrar como extrair dados da web usando Python, do básico ao avançado. Vamos ver como lidar com sites estáticos e dinâmicos, e ainda como turbinar seu fluxo de trabalho juntando Python com o , nosso Raspador Web IA. Seja você iniciante ou já tenha alguma experiência com dados, aqui tem dica prática, código de verdade e aprendizados de quem já rodou muito SaaS e automação por aí.

O que é Web Scraping e Por Que Usar Python?

Pra começar do começo: web scraping é o jeito automatizado de coletar informações de sites. É como ensinar seu computador a “ler” uma página e pegar só o que interessa — tipo preço de produto, manchete de notícia ou contato de empresa — sem precisar fazer tudo na mão (). Empresas usam web scraping pra tudo: monitorar concorrente em tempo real, fazer pesquisa de mercado, gerar leads e até treinar IA ().

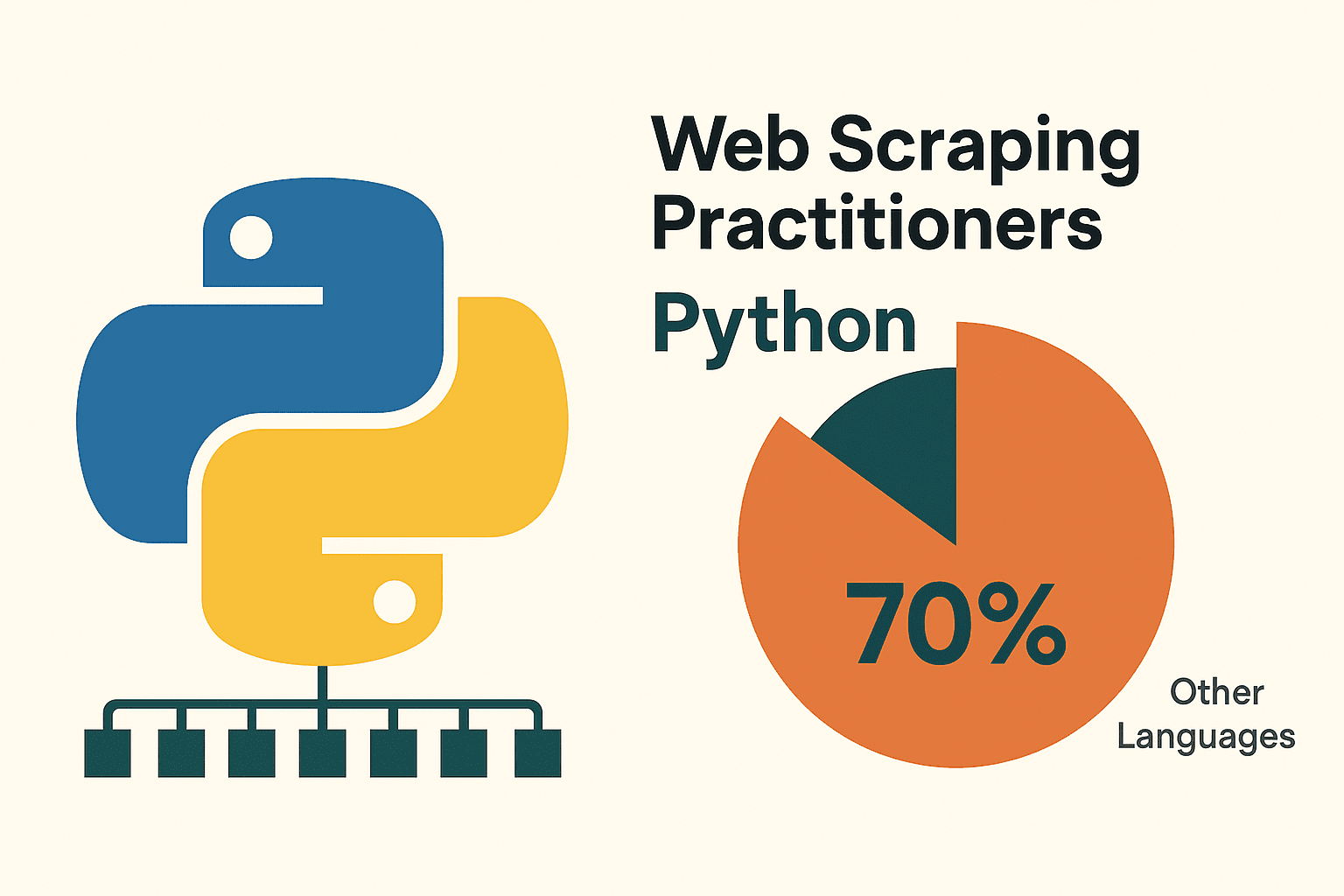

E por que Python é a linguagem queridinha pra raspagem? Primeiro, porque é fácil de aprender — a sintaxe parece inglês, então quem tá começando não se assusta. Mas o diferencial mesmo é o ecossistema: bibliotecas como requests, BeautifulSoup, Scrapy, Selenium e pandas fazem tudo, desde buscar páginas até analisar HTML e exportar dados limpos. Não é à toa que , disparado na frente das outras linguagens.

Por Que Escolher Python para Raspagem de Dados?

Já testei várias linguagens nesses anos, mas Python sempre leva vantagem pra web scraping — principalmente pra quem tá começando. Olha só:

- Simplicidade e Clareza: O código em Python é limpo, fácil de ler e de ajustar, o que ajuda muito na hora de escrever e corrigir scripts ().

- Bibliotecas Poderosas: Ferramentas como requests (requisições HTTP), BeautifulSoup (análise de HTML), Scrapy (raspagem em larga escala), Selenium (automação de navegador) e pandas (análise de dados) cobrem tudo que você precisa ().

- Comunidade e Recursos: Python tem uma galera gigante e ativa. Se pintar um problema, alguém já passou por isso e deixou a solução na internet.

Quer comparar Python com outras opções? Dá uma olhada:

| Abordagem | Vantagens | Desvantagens |

|---|---|---|

| Python | Fácil de aprender, ecossistema robusto, ótimo para análise de dados, versátil | Exige algum conhecimento de código, precisa de ferramentas extras para sites com muito JavaScript |

| JavaScript/Node | Lida nativamente com conteúdo dinâmico, suporte a assíncrono, mesma linguagem do front-end | Curva de aprendizado maior, menos bibliotecas específicas para scraping, mais verboso para iniciantes |

| R (rvest) | Bom para extração rápida em pesquisas, integra com análise do R | Ecossistema menor, menos robusto para sites dinâmicos |

| Ferramentas No-Code | Não exige programação, configuração rápida, IA/recursos visuais (como Thunderbit) | Flexibilidade limitada para lógica personalizada, limites de uso, menos controle |

(, )

Pra maioria do pessoal de negócios e quem curte dados, Python é o equilíbrio perfeito: potente, flexível e nada assustador.

Como Preparar o Ambiente Python para Raspagem de Dados

Antes de sair extraindo tudo, bora preparar o ambiente Python. Relaxa, é mais fácil que montar móvel da Tok&Stok — e com menos peça sobrando.

1. Instale o Python:

Baixe a versão mais nova do Python 3 em . No Windows, marca a opção “Add Python to PATH” na instalação. No Mac, usa o Homebrew (brew install python3). No Linux, normalmente já vem, mas apt install python3 python3-pip resolve ().

2. (Recomendado) Crie um Ambiente Virtual:

Assim, as bibliotecas do seu projeto ficam separadas. No diretório do projeto:

1python -m venv venv

2# Ative o ambiente:

3# Windows:

4venv\Scripts\activate

5# Mac/Linux:

6source venv/bin/activate3. Instale as Bibliotecas Essenciais:

Abre o terminal e manda ver:

1pip install requests beautifulsoup4 pandas selenium lxmlrequests: Pra fazer requisições HTTPbeautifulsoup4: Pra analisar HTMLpandas: Pra manipular/exportar dadosselenium: Pra sites dinâmicos (opcional)lxml: Análise rápida de HTML/XML

4. Escolha um Editor de Código:

- (com extensão Python): Leve, popular e ótimo pra quem tá começando.

- : Completo e focado em Python.

- : Interativo, perfeito pra testar e analisar dados ().

5. (Para Selenium) Instale um WebDriver:

O Selenium precisa de um driver de navegador (tipo ChromeDriver). O jeito mais fácil é usar o webdriver_manager:

1pip install webdriver-managerNo seu script:

1from selenium import webdriver

2from selenium.webdriver.chrome.service import Service

3from webdriver_manager.chrome import ChromeDriverManager

4driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))Dica: Se o pip não funcionar, confere se o Python tá no PATH e se o ambiente virtual tá ativado.

Extraindo Dados de Sites Estáticos com Python: Passo a Passo

Sites estáticos são o melhor ponto de partida pra quem tá começando. Se você vê os dados no “Ver código-fonte” do navegador, dá pra puxar com Python.

Vamos praticar com o , um clássico pra treinar.

Passo 1: Buscar a Página

1import requests

2url = "http://quotes.toscrape.com/page/1/"

3response = requests.get(url)

4html = response.text

5print(response.status_code) # 200 significa OKPasso 2: Analisar o HTML

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, 'html.parser')

3quotes = soup.find_all("div", class_="quote")Passo 3: Extrair os Dados

1for q in quotes:

2 text = q.find("span", class_="text").get_text()

3 author = q.find("small", class_="author").get_text()

4 print(f"{text} --- {author}")Passo 4: Lidar com Paginação

1import pandas as pd

2all_data = []

3page = 1

4while True:

5 url = f"http://quotes.toscrape.com/page/{page}/"

6 resp = requests.get(url)

7 if resp.status_code != 200:

8 break

9 soup = BeautifulSoup(resp.text, 'html.parser')

10 quotes = soup.find_all("div", class_="quote")

11 if not quotes:

12 break

13 for q in quotes:

14 text = q.find("span", class_="text").get_text()

15 author = q.find("small", class_="author").get_text()

16 all_data.append({"quote": text, "author": author})

17 page += 1

18df = pd.DataFrame(all_data)

19df.to_csv("quotes.csv", index=False)Pronto! Você puxou várias páginas e salvou tudo num CSV. Nada mal pra poucas linhas de código, né? ()

Dica de ouro: Sempre dá uma olhada no robots.txt e nos termos de uso do site antes de raspar. E seja gente boa — não sobrecarregue o servidor mandando requisição sem parar. Um time.sleep(1) entre as requisições já ajuda.

Extraindo Dados de Sites Dinâmicos: Usando Selenium com Python

Tem site que é mais casca. Se os dados só aparecem depois que o JavaScript roda (tipo rolagem infinita, pop-up ou dashboard dinâmico), aí precisa de uma ferramenta que simule um navegador de verdade. É aí que entra o Selenium.

Passo 1: Abrir o Navegador

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.chrome.service import Service

4from webdriver_manager.chrome import ChromeDriverManager

5driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))

6driver.get("https://example.com/dynamic-products")Passo 2: Esperar o Conteúdo Carregar

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(

4 EC.presence_of_element_located((By.ID, "product-list"))

5)Passo 3: Rolar ou Clicar para Carregar Mais

1import time

2last_height = driver.execute_script("return document.body.scrollHeight")

3while True:

4 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

5 time.sleep(2)

6 new_height = driver.execute_script("return document.body.scrollHeight")

7 if new_height == last_height:

8 break

9 last_height = new_heightPasso 4: Extrair os Dados

1products = driver.find_elements(By.CLASS_NAME, "product-item")

2data = []

3for prod in products:

4 name = prod.find_element(By.CSS_SELECTOR, "h2.product-name").text

5 price = prod.find_element(By.CSS_SELECTOR, "span.price").text

6 data.append({"name": name, "price": price})Passo 5: Salvar e Finalizar

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4driver.quit()Dicas:

- Use esperas explícitas (

WebDriverWait) pra evitar erro quando o elemento ainda não carregou (). - Pra rodar sem abrir janela, coloca

options.headless = Truenas opções do Chrome. - Se achar um endpoint de API JSON no tráfego do site, tenta usar

requestsem vez de Selenium — é bem mais rápido!

Combinando Thunderbit e Python para Fluxos de Dados Poderosos

Agora o jogo fica ainda mais interessante. Às vezes, mesmo com as bibliotecas do Python, raspar um site complicado parece briga de foice. É aí que o entra em cena.

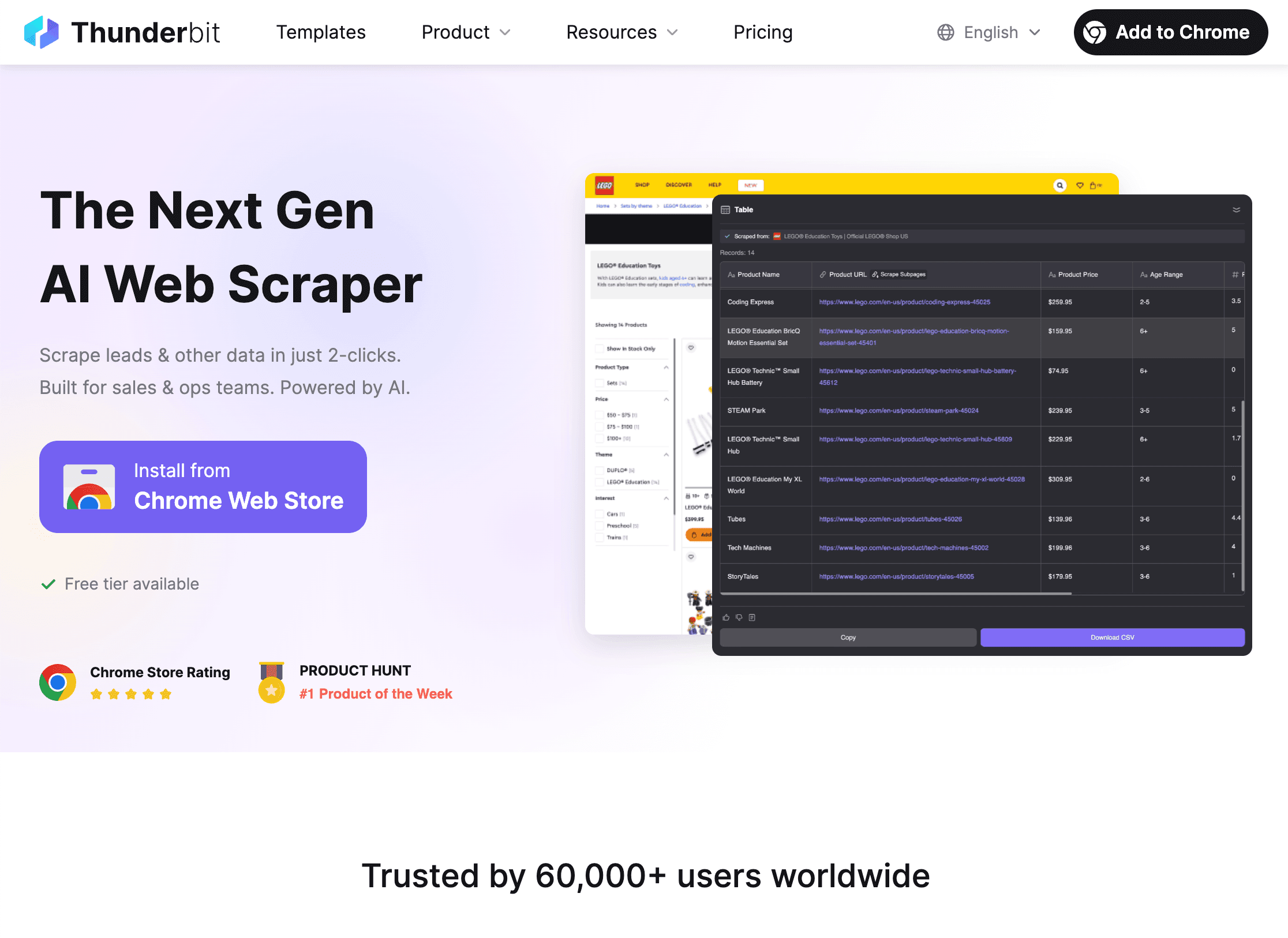

Thunderbit é uma extensão Chrome de Raspador Web IA que permite extrair dados de qualquer site em poucos cliques — sem precisar programar. É perfeito pra quem precisa de dados pra ontem, mas também se integra fácil ao Python pra fluxos mais avançados.

Como Thunderbit + Python Turbinam Seu Fluxo de Trabalho:

Como Thunderbit + Python Turbinam Seu Fluxo de Trabalho:

-

Use o Thunderbit para Extrair Dados:

- Abra a .

- Clique em “IA Sugere Campos” e deixe a IA do Thunderbit mostrar o que extrair.

- Lide com paginação, subpáginas e até imagens ou PDFs com um clique.

- Exporte os dados direto pra CSV, Excel, Google Sheets, Notion ou Airtable.

-

Analise e Limpe os Dados no Python:

- Carregue o arquivo exportado no Python com pandas:

1import pandas as pd 2df = pd.read_csv("thunderbit_output.csv") - Agora é só filtrar, limpar, juntar, visualizar ou rodar análise avançada — o que seu projeto pedir.

- Carregue o arquivo exportado no Python com pandas:

-

Automatize o Processo:

- O Thunderbit permite agendar extrações, então você pode receber dados atualizados todo dia.

- Junte com scripts Python pra relatórios automáticos, alertas ou processamento extra.

Por que usar os dois juntos? O Thunderbit economiza horas de programação e debug, principalmente em site difícil ou projeto pontual. Python te dá o poder de analisar, limpar e integrar esses dados no seu fluxo. É tipo arroz com feijão — cada um é bom, mas juntos são imbatíveis ().

Como Lidar com Desafios Comuns em Web Scraping com Python

Raspar dados nem sempre é moleza. Olha alguns perrengues comuns — e como sair deles:

1. Bloqueios (Erros 403/429, CAPTCHAs):

- Troque o User-Agent pra simular navegador real.

- Use proxies pra variar o IP ().

- Coloque intervalos entre as requisições (

time.sleep()). - Respeite o robots.txt e as regras de crawl-delay.

- Pra CAPTCHAs, use Selenium pra resolver manualmente ou serviços próprios.

2. Conteúdo Dinâmico Não Carrega:

- Use Selenium pra renderizar páginas cheias de JavaScript.

- Procure chamadas de API internas no navegador — às vezes dá pra puxar os dados direto em JSON.

3. Problemas de Login ou Sessão:

- Use

requests.Session()pra manter cookies. - Automatize o login com Selenium se precisar.

4. Mudanças na Estrutura do Site:

- Escreva seletores robustos (prefira IDs a classes).

- Fique de olho em mudanças e atualize o script quando necessário.

- A IA do Thunderbit se adapta sozinha a mudanças de layout, poupando manutenção.

5. Grandes Volumes de Dados:

- Use concorrência (

concurrent.futuresouasyncio) pra acelerar a raspagem. - Salve dados aos poucos no disco ou banco de dados pra não estourar a memória.

(, )

Solução de Problemas: Como Depurar e Otimizar Seus Scripts

Quando der ruim (e vai acontecer), segue esse checklist:

- HTTP 404/403/429: Confere URL, cabeçalhos e frequência das requisições.

- Timeouts/Erros de Conexão: Implemente tentativas com backoff exponencial.

- AttributeError/NoneType: Adicione checagens antes de acessar elementos; confira o HTML retornado.

- Problemas de Codificação: Defina

response.encoding = 'utf-8'ou especifique ao salvar arquivos. - Elemento Não Encontrado no Selenium: Use esperas explícitas; revise seus seletores.

- Erros de Memória: Salve dados em lotes, use geradores ou banco de dados pra grandes volumes.

- Depuração: Use prints, logging ou salve o HTML pra inspecionar.

Pra performance, pense em requisições assíncronas (aiohttp), threads ou frameworks como Scrapy pra projetos grandes. Mas não complica demais em tarefa pequena — clareza é mais importante que “gambiarra” quando se está aprendendo.

Boas Práticas para Web Scraping Ético e Legal

Com grande poder de raspagem vem grande responsabilidade. Fique ligado:

- Respeite robots.txt e Termos de Uso: Se o site proíbe scraping, não faça.

- Evite Dados Pessoais ou Sensíveis: Foque em informação pública; não colete nada que você não gostaria que coletassem sobre você.

- Seja Educado: Limite a frequência das requisições, evite horários de pico e não sobrecarregue servidores.

- Identifique-se: Use um User-Agent personalizado com contato, se for o caso.

- Cheque a Legislação: Nos EUA, raspar dados públicos geralmente é permitido, mas violar termos ou coletar dados privados pode dar problema ().

- Prefira APIs Quando Existirem: Se o site tem API, use — é mais seguro e estável.

(, )

Conclusão & Principais Dicas

Aprender a extrair dados com Python é uma das skills mais valiosas no mundo dos dados hoje. Resumindo:

- Python é a melhor escolha pra web scraping por causa da simplicidade, bibliotecas e comunidade ().

- Comece por sites estáticos usando requests e BeautifulSoup; use Selenium pra conteúdo dinâmico.

- Thunderbit pode economizar horas em tarefas complexas ou pontuais — depois, use Python pra análise e automação.

- Supere desafios alternando cabeçalhos, usando proxies, delays e tratamento de erros.

- Raspe com ética: Respeite os sites, evite dados sensíveis e siga a lei.

Meu conselho? Comece pequeno — escolha um site simples, escreva seu primeiro script e veja o que consegue extrair. Quando pegar confiança, junte Thunderbit e Python pra fluxos ainda mais poderosos. E lembre: todo erro é só um desafio esperando pra ser resolvido (às vezes com uma ajudinha do Stack Overflow).

Quer ver o Thunderbit em ação ou aprender mais sobre scraping? Dá uma olhada no ou se inscreve no nosso pra tutoriais e dicas.

Boas raspagens — que seus dados sejam sempre limpos, seus scripts sem bug e seu IP nunca bloqueado.

Perguntas Frequentes

1. O que é web scraping e é legal?

Web scraping é a extração automatizada de dados de sites. Extrair dados públicos geralmente é permitido nos EUA e em muitos países, mas é preciso respeitar os termos do site, evitar dados sensíveis e seguir as leis de privacidade ().

2. Por que a maioria usa Python para web scraping?

Python é fácil pra quem tá começando, tem bibliotecas poderosas pra cada etapa (requests, BeautifulSoup, Selenium, pandas) e uma comunidade gigante pra ajudar ().

3. Quando usar Selenium em vez de requests/BeautifulSoup?

Use Selenium quando os dados são carregados dinamicamente por JavaScript e não aparecem no HTML inicial da página. Selenium simula um navegador real, então “vê” o que o usuário vê.

4. Como o Thunderbit funciona com Python?

Thunderbit permite extrair dados complexos ou desestruturados com IA em poucos cliques, exportando pra CSV/Excel/Sheets. Depois, você pode carregar esses dados no Python pra limpeza, análise ou automação — economizando horas de programação.

5. Dicas pra evitar bloqueios ao raspar dados?

Troque o User-Agent, use proxies, adicione intervalos, respeite o robots.txt e evite dados sensíveis ou privados. Pra raspagens pesadas, pense em ferramentas anti-bot ou serviços especializados.

Quer testar na prática? Baixe a e veja como é fácil unir IA e Python no seu próximo projeto de dados. E se travar, lembra: todo grande raspador começou com uma linha de código.

Saiba Mais