Lembro perfeitamente da primeira vez que tentei extrair dados de um site. Estava sentado na minha mesa, café do lado, decidido a automatizar aquela tarefa chata de copiar e colar preços de produtos por horas a fio. Abri o Python, instalei o BeautifulSoup e fui com tudo—só para me perder num mar de HTML bagunçado e um monte de erros. Se você já tentou fazer web scraping python, sabe bem como é: mistura de empolgação, frustração e, às vezes, vontade de jogar o notebook pela janela.

Mas a real é que os dados da web nunca foram tão valiosos. Empresas querem insights em tempo real—seja para monitorar preços de concorrentes, montar listas de leads ou ficar de olho nas tendências do mercado. O python web scraping sempre foi o caminho clássico, mas com sites cada vez mais complexos e cheios de bloqueios anti-raspagem, aquele método tradicional, cheio de código, já ficou meio ultrapassado. Por isso, hoje vou te mostrar os dois lados: o kit clássico de web scraping python e a nova geração de raspador web ia, como o , que está mudando o jogo para times de vendas, e-commerce e operações.

O que é Web Scraping com Python?

Vamos ao básico: web scraping é simplesmente coletar dados automaticamente de sites. Em vez de copiar e colar na mão, você cria um script para fazer isso por você. Python é a linguagem queridinha de quem está começando porque é fácil de entender, tem uma comunidade gigante e várias bibliotecas que facilitam a vida—mesmo para quem não é programador de carreira.

Por que Python?

- Fácil de aprender: A sintaxe do Python é super amigável para quem está começando.

- Bibliotecas poderosas: Ferramentas como Requests, BeautifulSoup, Selenium e Scrapy resolvem desde páginas simples até sites cheios de JavaScript.

- Comunidade ativa: Se você travar, alguém já passou pelo mesmo e deixou a solução no Stack Overflow.

Principais Aplicações

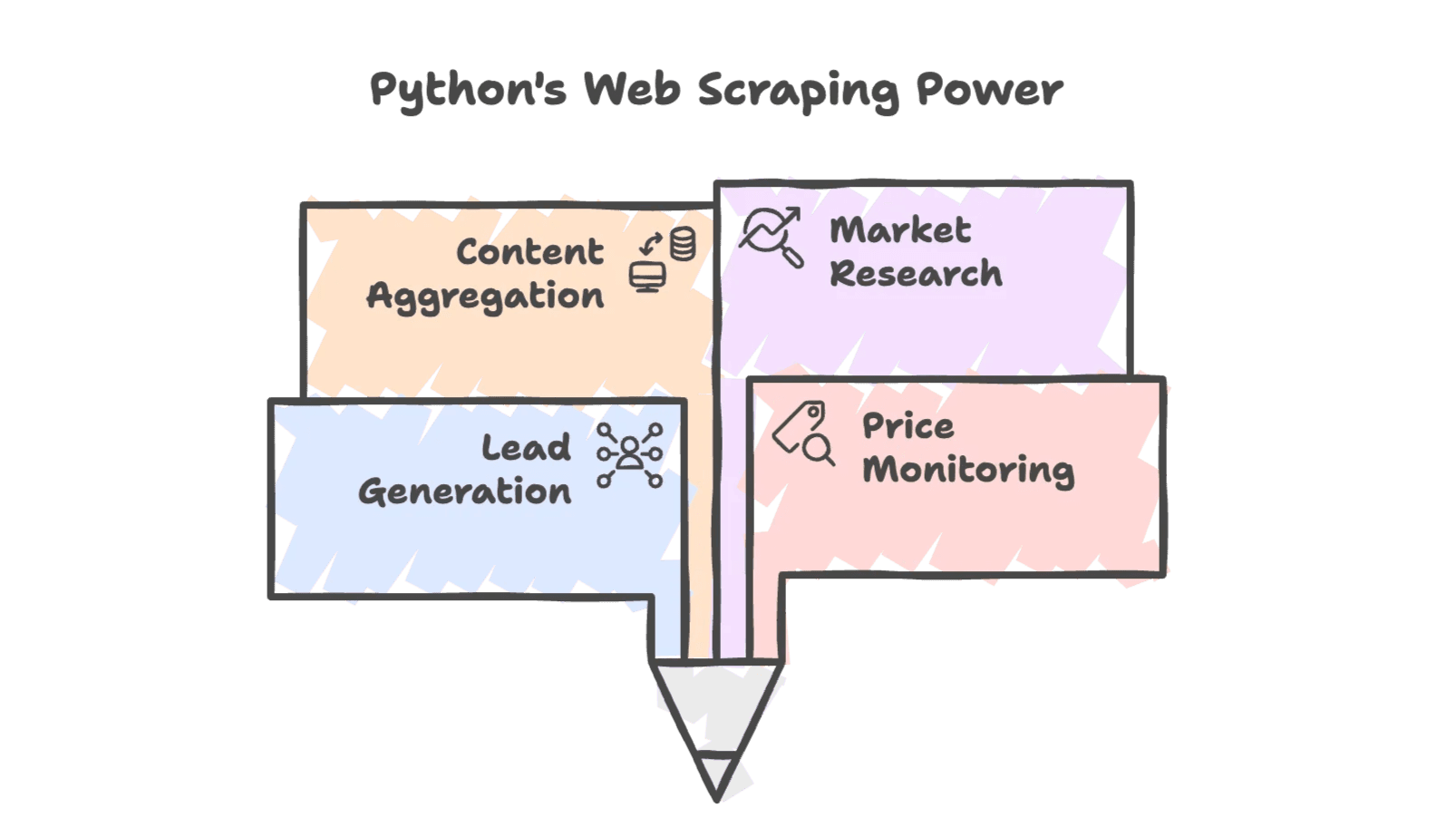

O python web scraping aparece em várias áreas de negócio:

- Geração de leads: Buscar contatos em diretórios ou redes sociais.

- Monitoramento de preços: Acompanhar valores dos concorrentes para ajustar sua estratégia.

- Agregação de conteúdo: Juntar notícias, avaliações ou listas de produtos.

- Pesquisa de mercado: Captar tendências em fóruns, redes sociais ou resultados de busca.

E não é só para quem é de TI—times de vendas, e-commerce e até imobiliárias usam dados extraídos para sair na frente. Na real, já usam web scraping para montar bases de dados personalizadas e qualificar leads.

Por que Empresas Usam Python para Web Scraping?

A flexibilidade do Python e suas bibliotecas robustas fazem dele a escolha natural para raspagem de dados. Olha só alguns exemplos reais:

| Cenário | Como o Python Ajuda | Benefício (ROI) |

|---|---|---|

| Geração de Leads | Extrai nomes, e-mails e telefones de diretórios | Monta uma lista de 500 prospects em uma noite, contra 50 manualmente |

| Monitoramento de Preços | Busca preços de produtos concorrentes regularmente | Permite precificação dinâmica—um varejista aumentou as vendas em 4% usando dados extraídos |

| Acompanhamento de Estoque | Verifica disponibilidade de produtos em concorrentes | Aborda clientes quando rivais estão sem estoque, economizando horas de checagem manual |

| Pesquisa de Concorrentes | Coleta detalhes de produtos e avaliações | Analisa mais de 1.000 reviews para orientar marketing e desenvolvimento de produto |

| Pesquisa de Mercado | Agrega dados de fóruns, redes sociais e buscas | Direciona campanhas com tendências atualizadas, alinhando estratégia ao interesse real do consumidor |

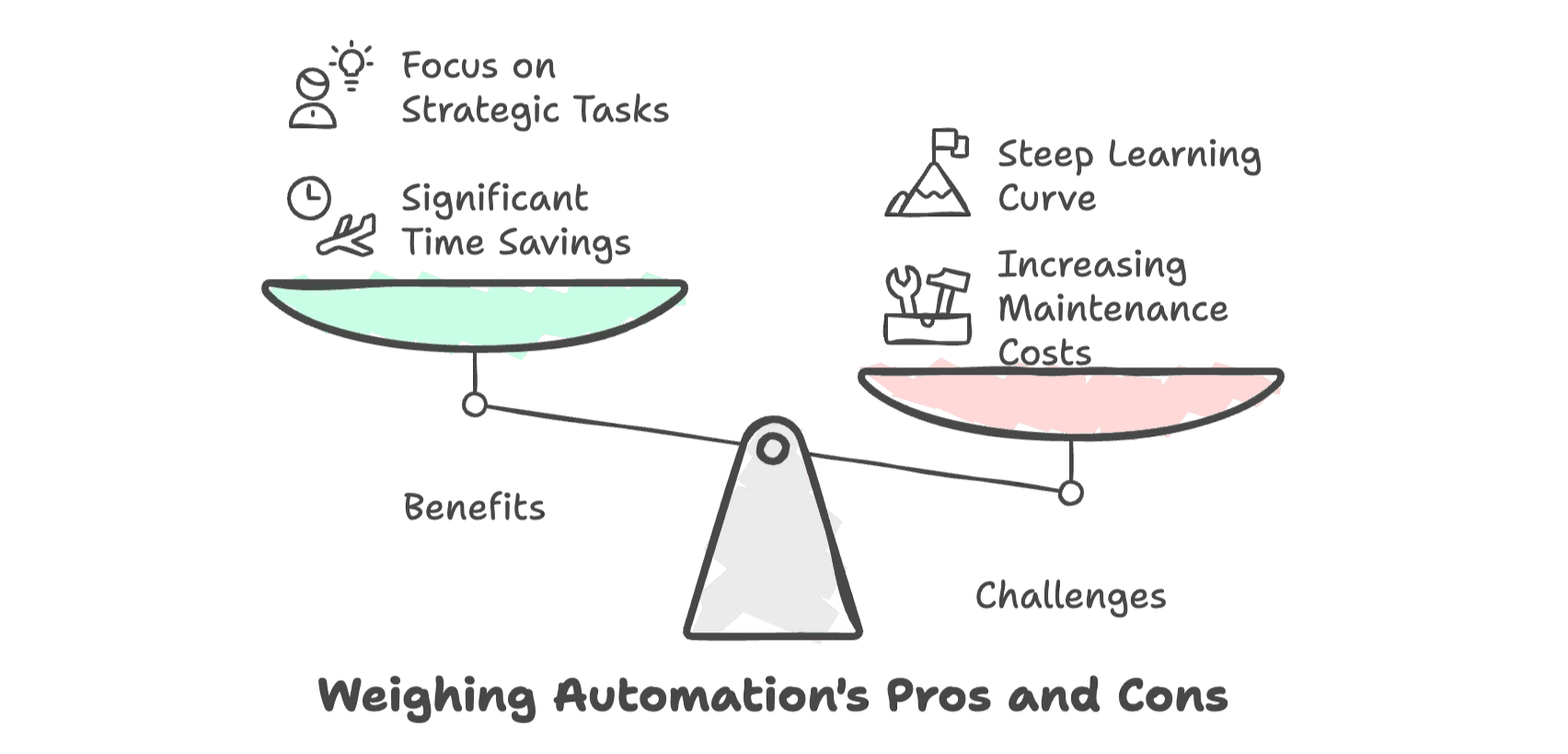

O retorno é claro: automatizar a coleta de dados com Python pode gerar economia de até 80% do tempo comparado ao trabalho manual (). Ou seja, sua equipe gasta menos tempo em tarefas repetitivas e mais tempo fechando negócios ou analisando tendências.

Mas—e é um “mas” grande—conforme os sites evoluem, o custo (em tempo, dor de cabeça e manutenção) para manter esses scripts funcionando só aumenta. Para quem não é técnico, a curva de aprendizado pode ser puxada e a frustração, real.

Ferramentas Essenciais para Web Scraping com Python

Se você está começando, o universo Python oferece algumas ferramentas de destaque. Dá uma olhada:

| Ferramenta | Ideal Para | Suporta JavaScript? | Nível de Dificuldade | Velocidade & Escala |

|---|---|---|---|---|

| Requests + BeautifulSoup | Páginas estáticas e simples | Não | Baixo | Rápido para poucas páginas |

| Selenium | Sites dinâmicos, com JS e interações | Sim | Médio | Mais lento por página |

| Scrapy | Raspagem em larga escala e estruturada | Parcial (com plugins) | Alto | Alta performance, escalável |

Requests + BeautifulSoup

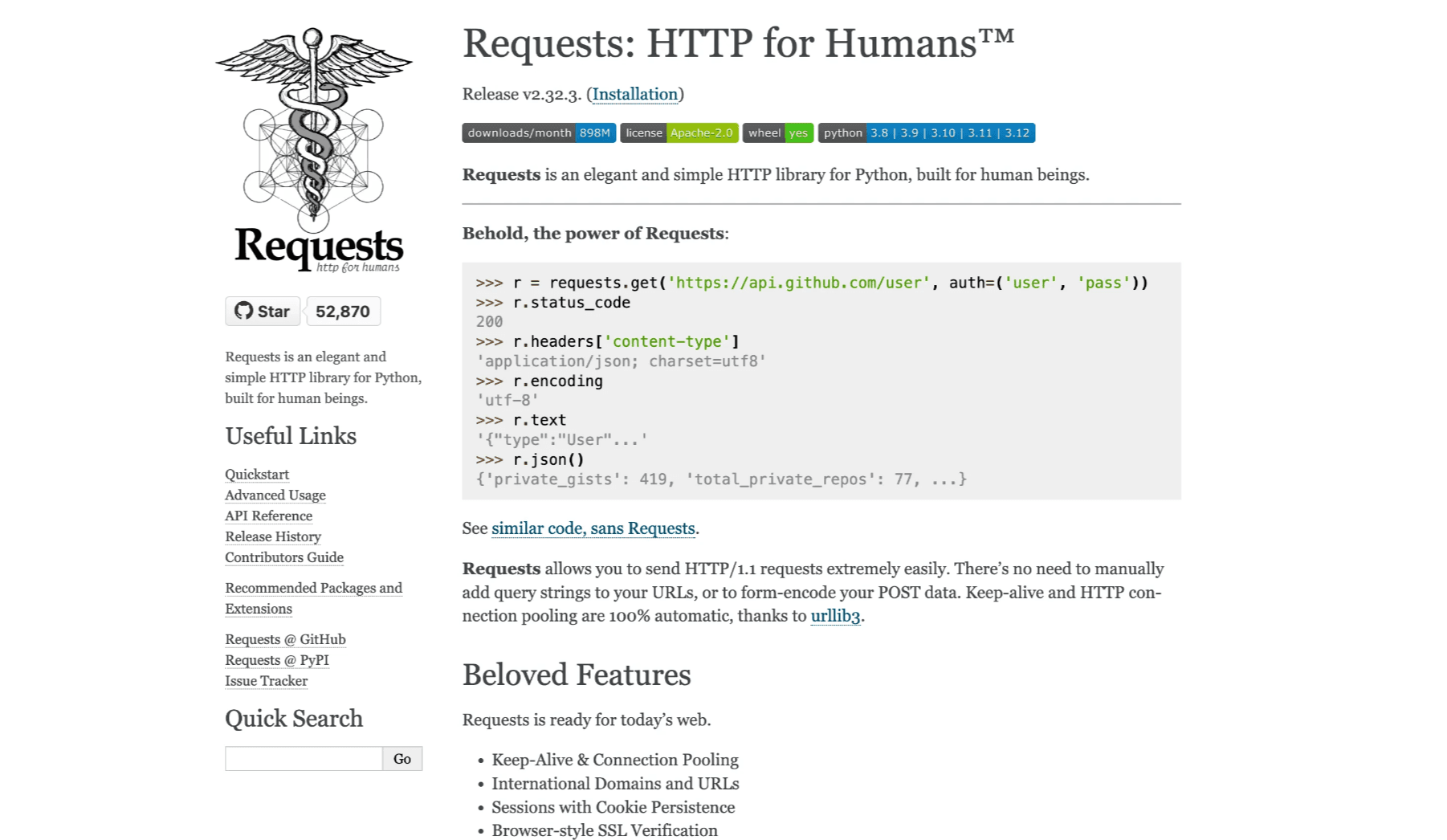

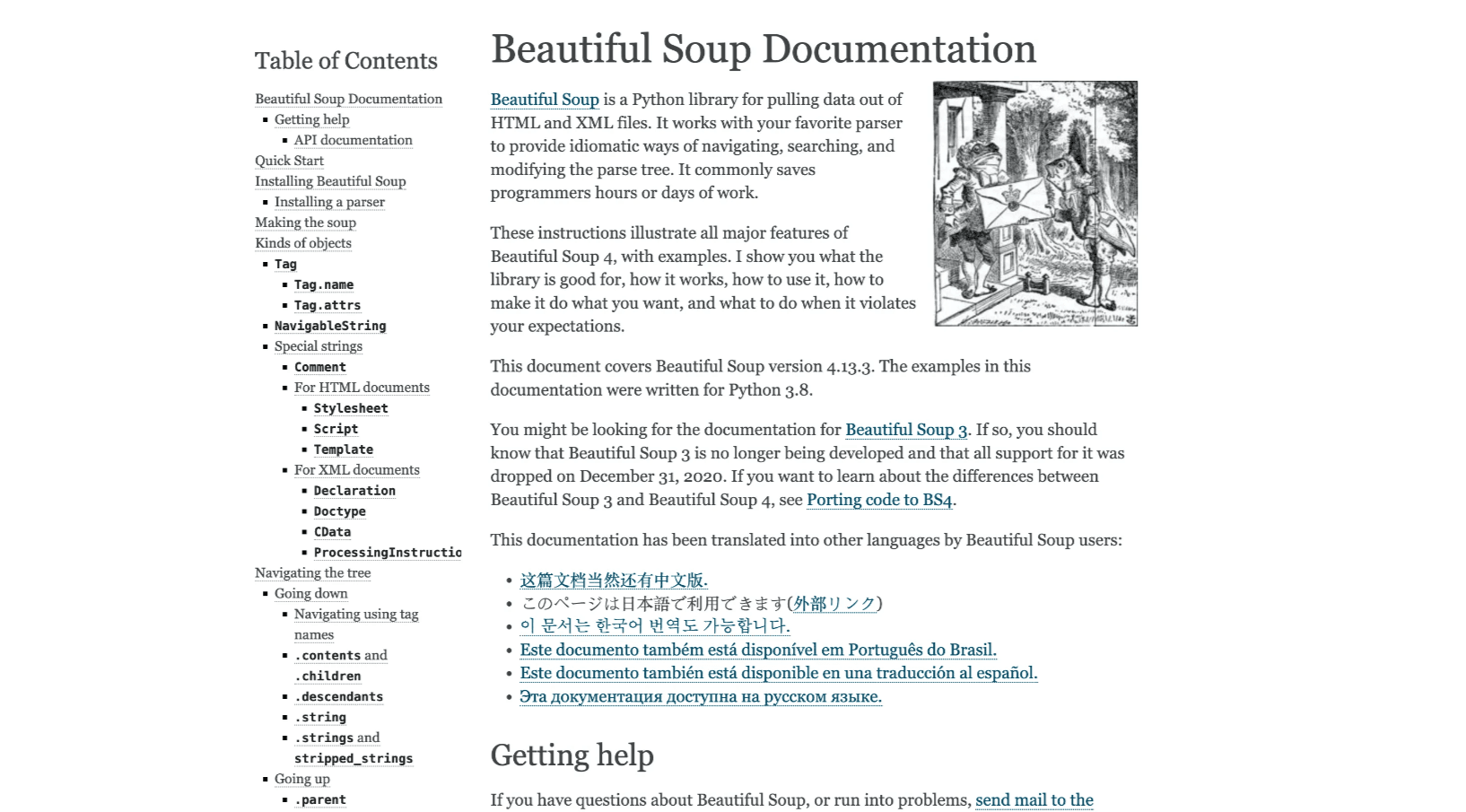

A dupla clássica para sites estáticos. Requests busca o HTML, e o BeautifulSoup faz a leitura e extração dos dados. É leve, fácil de aprender e perfeito para projetos pequenos (, ).

Selenium

Quando você precisa extrair dados que só aparecem depois do carregamento do JavaScript, o Selenium é o parceiro ideal. Ele automatiza um navegador de verdade, permitindo lidar com logins, cliques e rolagem de página (). O lado ruim? É mais lento e exige uma configuração mais detalhada.

Scrapy

Para projetos grandes—como rastrear milhares de páginas ou criar pipelines recorrentes de dados—Scrapy é o peso-pesado. É um framework completo para criar spiders robustos, lidar com concorrência e organizar seu código (). A curva de aprendizado é maior, mas compensa para projetos de grande porte.

Passo a Passo: Seu Primeiro Raspador Web com Python

Vamos colocar a mão na massa com um exemplo prático. Vamos extrair títulos e preços de livros do —um site de demonstração feito para treinar web scraping python.

Preparando o Ambiente Python

Primeiro, garanta que o Python está instalado. Depois, abra o terminal e rode:

1pip install requests beautifulsoup4Recomendo usar um editor de código bacana, tipo VS Code ou PyCharm. Faz diferença na hora de visualizar o código.

Escrevendo Seu Primeiro Script de Web Scraping

Veja um exemplo simples para buscar a página inicial e extrair os dados dos livros:

1import requests

2from bs4 import BeautifulSoup

3url = "http://books.toscrape.com/"

4response = requests.get(url)

5html_content = response.text

6soup = BeautifulSoup(html_content, 'html.parser')

7book_elements = soup.find_all('article', class_='product_pod')

8books_data = []

9for book in book_elements:

10 title = book.find('h3').find('a')['title']

11 price = book.find('p', class_='price_color').text

12 books_data.append([title, price])

13print(books_data)O que está rolando aqui?

- Buscamos o HTML com Requests.

- Fazemos o parsing com BeautifulSoup.

- Encontramos todos os livros listados.

- Extraímos o título e o preço de cada um.

Exportando os Dados Extraídos

Para aproveitar melhor os dados, vamos salvar em um arquivo CSV:

1import csv

2with open('books.csv', 'w', newline='', encoding='utf-8') as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "Price"])

5 writer.writerows(books_data)Agora é só abrir o books.csv no Excel ou Google Sheets e conferir o resultado.

Dicas de Ouro:

- Sempre confira a saída para ver se não tem erro ou dado faltando.

- Se aparecerem caracteres estranhos, veja se está usando codificação UTF-8.

- Se o script parar de funcionar, pode ser que a estrutura do site mudou.

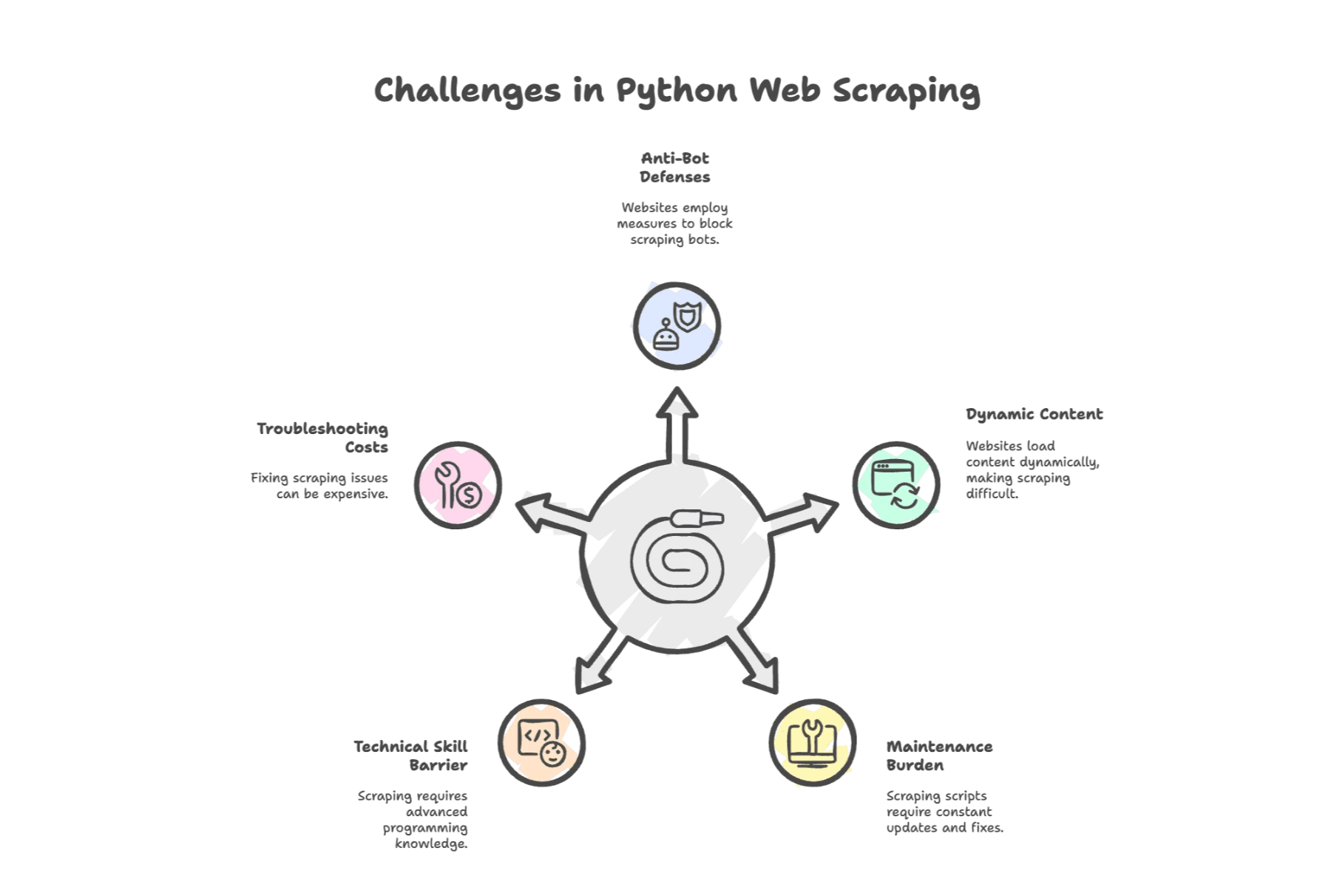

Principais Desafios do Web Scraping com Python

Aqui começam as dores de cabeça. O python web scraping é poderoso, mas não é só alegria. Veja os obstáculos mais comuns:

1. Barreiras Anti-Bot

Os sites estão cada vez mais espertos. Em uma pesquisa recente, citaram bloqueios (banimento de IP, CAPTCHAs) como principal desafio. Os sites detectam scripts e impõem barreiras—às vezes literalmente, como um CAPTCHA.

2. Conteúdo Dinâmico

Sites modernos usam muito JavaScript. Se os dados que você precisa só aparecem depois do carregamento, Requests + BeautifulSoup não vão resolver. Vai precisar usar Selenium ou tentar decifrar uma API.

3. Manutenção Constante

Sites mudam. E mudam muito. Uma pequena alteração no HTML pode quebrar seu script. Um estudo mostrou que desenvolvedores gastam só corrigindo raspadores, e empresas podem gastar US$ 15.000 por ano só em manutenção.

4. Barreiras Técnicas

Mesmo sendo simples, o Python exige conhecimento de HTML, seletores CSS e, às vezes, protocolos HTTP. Para quem não é desenvolvedor, pode parecer aprender um novo idioma—e, de fato, é.

5. Custos de Suporte

Quando algo dá errado (e vai acontecer), talvez seja necessário investir em proxies, navegadores headless ou serviços de terceiros. Cada hora de depuração é uma hora a menos no seu trabalho principal.

Ferramenta Automatizada de Web Scraping: O Próximo Nível

E aí, o que fazer se você é do time de negócios (ou está atolado de tarefas)? É aí que entram as ferramentas automatizadas de web scraping—e, mais recentemente, o raspador web ia.

Essas ferramentas tiram o peso do processo. Nada de escrever código para cada site, nem noites em claro depurando scripts. Só apontar, clicar e receber os dados.

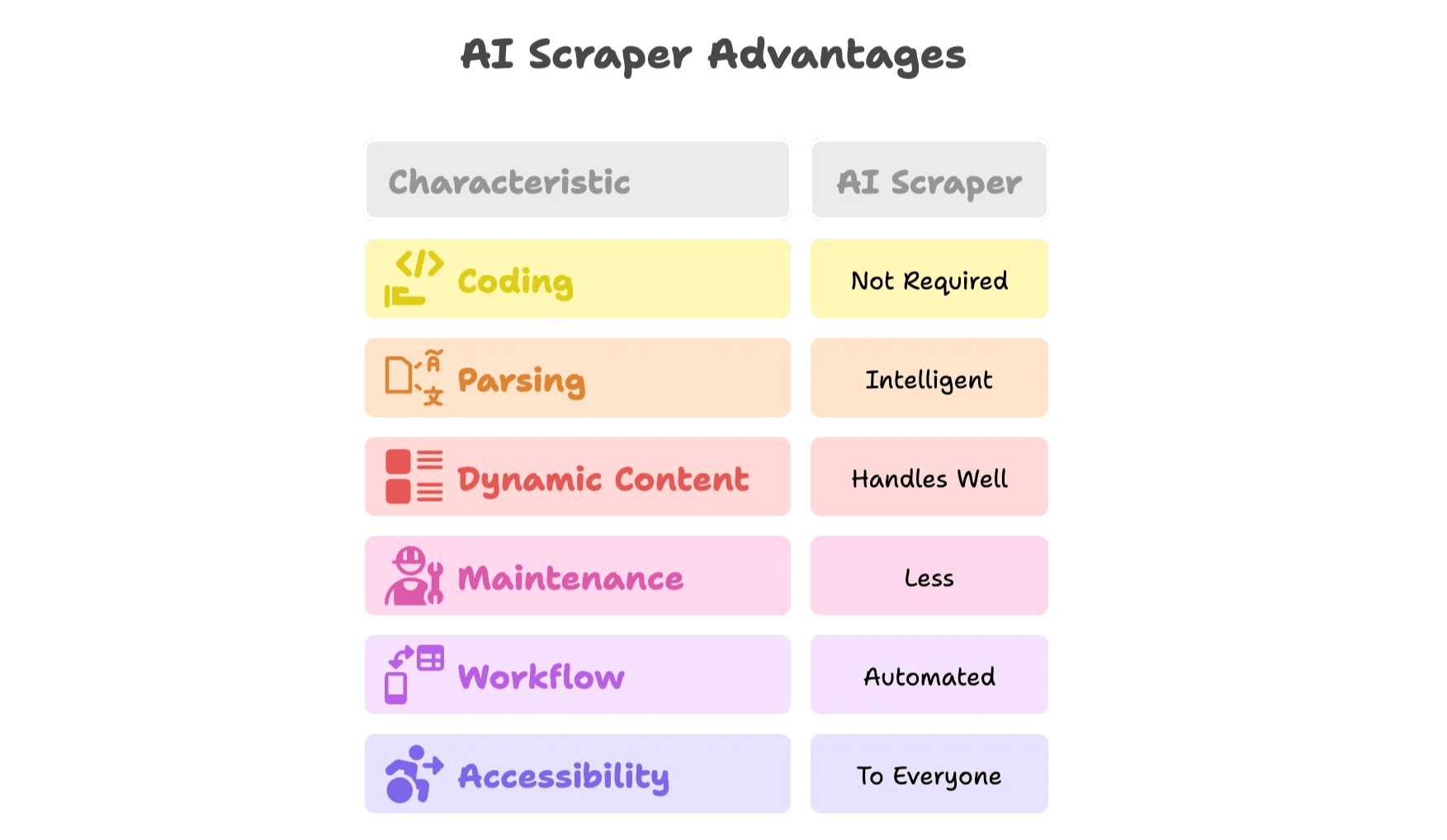

O que Torna um Raspador IA Diferente?

O raspador web ia é um salto à frente. Olha só por quê:

- Sem código: Interfaces visuais ou extensões de navegador permitem selecionar os dados na página, e a IA faz o resto.

- Leitura inteligente: Modelos de IA identificam automaticamente campos como nomes, preços e e-mails—sem precisar inspecionar o HTML.

- Lida com conteúdo dinâmico: O raspador web ia funciona em navegadores reais, lidando com JavaScript, rolagem e cliques.

- Menos manutenção: Se o site muda, a IA se adapta—ou a equipe da ferramenta atualiza tudo para você.

- Automação de fluxos: Agende raspagens, exporte direto para Google Sheets, Airtable, Notion ou Excel.

- Acessível para todos: Chega de depender do “pessoa do Python” no time.

Veja como isso funciona na prática com o .

Thunderbit: A Alternativa Inteligente ao Web Scraping com Python

Co-fundei o Thunderbit porque vi de perto quanto tempo e energia as equipes perdiam com raspagem manual. Nosso objetivo? Democratizar o acesso aos dados da web—sem código, sem dor de cabeça, só resultado.

Principais Recursos do Raspador Web IA do Thunderbit

- Raspador Web IA em 2 Cliques: Só abrir o site, clicar em “IA Sugerir Campos” e deixar a IA do Thunderbit indicar as melhores colunas para extrair. Clique em “Raspar” e pronto.

- Modelos Prontos: Para sites populares (Amazon, Zillow, LinkedIn, etc.), use templates prontos—sem configuração.

- Raspagem de Subpáginas e Paginação: O Thunderbit navega automaticamente em subpáginas (como detalhes de produtos) e lida com paginação ou rolagem infinita.

- Exportação Gratuita de Dados: Exporte para Excel, Google Sheets, Airtable ou Notion—sem bloqueio, sem pegadinha.

- Extrator de E-mails e Telefones: Extraia contatos de qualquer página, perfeito para vendas e prospecção.

- Transformação de Dados com IA: Resuma, categorize, traduza ou formate dados em tempo real.

- Raspagem Agendada: Programe raspagens recorrentes com linguagem natural.

- Opções em Nuvem e Navegador: Escolha entre raspagem rápida na nuvem ou via navegador para sites que exigem login.

- Suporte a 34 Idiomas: O Thunderbit é feito para equipes globais.

Quer ver na prática? Confira nossa e o para tutoriais e exemplos reais.

Quando Migrar do Python para um Raspador IA?

Veja um checklist rápido para ajudar na decisão:

| Situação | Script Python | Raspador IA (Thunderbit) |

|---|---|---|

| Página estática simples, uso pontual | ✔️ | ✔️ |

| Conteúdo dinâmico (JS, login, rolagem infinita) | ⚠️ | ✔️ |

| Mudanças frequentes no site, alta manutenção | ⚠️ | ✔️ |

| Equipe não técnica, necessidade de agilidade | ⚠️ | ✔️ |

| Integração com várias plataformas (Sheets, CRM) | ⚠️ | ✔️ |

| Raspagem recorrente e em grande escala | ⚠️ | ✔️ |

| Precisa de agendamento, enriquecimento ou automação | ⚠️ | ✔️ |

Se você está vendo muitos ⚠️ no seu fluxo atual, talvez seja hora de experimentar um raspador web ia.

Bônus: Dicas para Coleta de Dados Web Eficiente e Sustentável

Seja usando python web scraping ou uma ferramenta automatizada de web scraping, algumas boas práticas fazem toda a diferença:

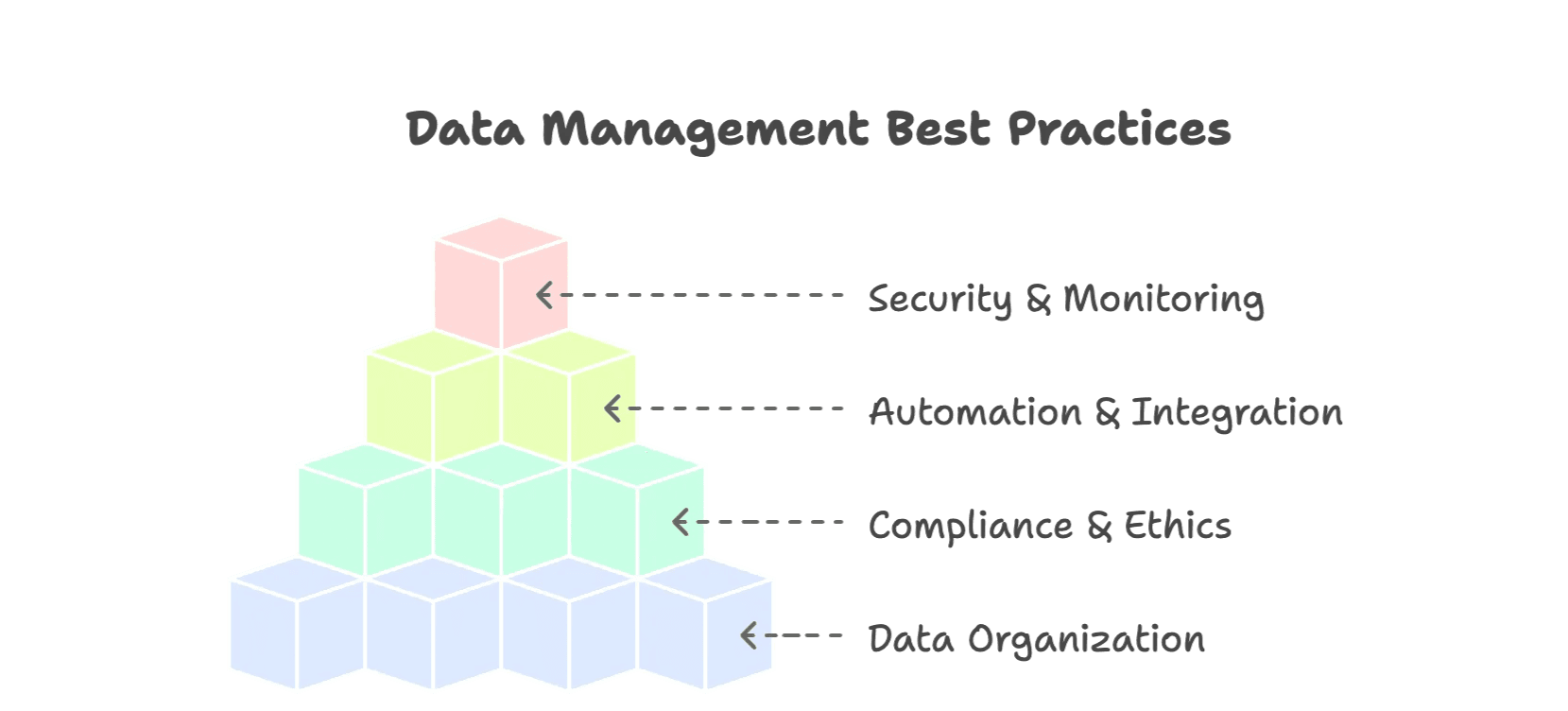

1. Organize Seus Dados

- Use formatos estruturados (CSV, Excel, bancos de dados).

- Normalize campos (datas, moedas, categorias).

- Adicione metadados (fonte, data da raspagem) para contexto.

- Remova duplicidades e valide os dados.

2. Siga as Regras e Seja Ético

- Respeite o robots.txt e os termos de uso dos sites ().

- Não sobrecarregue os sites—use intervalos razoáveis.

- Evite coletar dados pessoais ou sensíveis.

- Prefira APIs públicas quando disponíveis.

3. Automatize e Integre

- Programe raspagens recorrentes para manter os dados atualizados.

- Exporte direto para suas ferramentas de trabalho (Sheets, Airtable, Notion).

- Use alertas ou monitoramento para identificar erros rapidamente.

4. Segurança e Monitoramento

- Registre execuções e erros das raspagens.

- Faça backup dos seus dados.

- Restrinja o acesso a informações sensíveis.

Para mais dicas, confira .

Conclusão: O Futuro do Web Scraping é Mais Inteligente

Já evoluímos muito desde os tempos dos scripts Python feitos à mão e horas ajustando seletores quebrados. Os dados da web viraram um ativo estratégico— são destinados a dados públicos, e o mercado de ferramentas de raspagem com IA deve chegar a .

O Python ainda é ótimo para aprender o básico e resolver tarefas menores. Mas, com sites cada vez mais complexos, precisamos de ferramentas à altura. O raspador web ia como o Thunderbit oferece uma abordagem mais inteligente e eficiente para coletar e usar dados da web—do jeito que as equipes trabalham hoje.

Se você está gastando mais tempo corrigindo erros do que obtendo resultados, ou quer conhecer o que há de mais moderno em raspagem, experimente o Thunderbit: . Seu time de vendas, e-commerce ou operações vai sentir a diferença.