Deixa eu te contar como foi minha primeira tentativa de extrair dados de um site para uso comercial. Eu estava na mesa da cozinha, café numa mão e um script Python improvisado na outra, tentando puxar preços de produtos do site de um concorrente. Pensei: “Isso não deve ser tão complicado, né?” Resultado: acabei com um arquivo CSV cheio de células vazias e um respeito renovado por quem diz que é só “automatizar com Python”. Pulando para 2025, a raspagem de dados virou peça-chave para empresas que querem ser guiadas por dados — abastecendo times de vendas, e-commerce, marketing e operações com informações fresquinhas que seriam impossíveis de coletar manualmente.

Mas aqui vai a real: mesmo com o Python mais afiado do que nunca para raspagem de dados, o cenário está mudando rápido. O mercado de raspagem web está bombando — avaliado em . Quase para tomar decisões mais inteligentes. Só que o verdadeiro desafio não é só programar — é escolher a ferramenta certa, escalar o processo e não enlouquecer cuidando de dezenas de scripts. Neste guia, vou te mostrar as principais bibliotecas Python para raspador web (com exemplos de código), casos reais de uso nos negócios e por que, apesar de curtir Python, acredito que soluções sem código como o são a melhor pedida para a maioria das empresas em 2025.

O que é Web Scraping com Python? Explicação Direta ao Ponto

Resumindo: web scraping é automatizar o famoso “copiar e colar”. Em vez de contratar uma equipe para coletar preços, contatos ou avaliações, você usa um software para visitar páginas, puxar os dados que precisa e jogar tudo numa planilha ou banco de dados. Raspador web com Python significa usar scripts em Python para fazer isso — acessar páginas, analisar o HTML e capturar as informações que interessam.

Pensa como se fosse um assistente digital navegando nos sites pra você, 24 horas por dia, sem pedir pausa pro café. O que as empresas mais buscam? Preços, detalhes de produtos, contatos, avaliações, imagens, notícias e até anúncios de imóveis. E mesmo que alguns sites tenham APIs, a maioria não tem — ou limita bastante o acesso. É aí que entra o raspador web: permite acessar dados públicos em grande escala, mesmo quando não existe um botão de “baixar”.

Por que Web Scraping com Python é Essencial para Empresas

Vamos ser sinceros: em 2025, se tua empresa não usa raspador web, está perdendo espaço. Olha só:

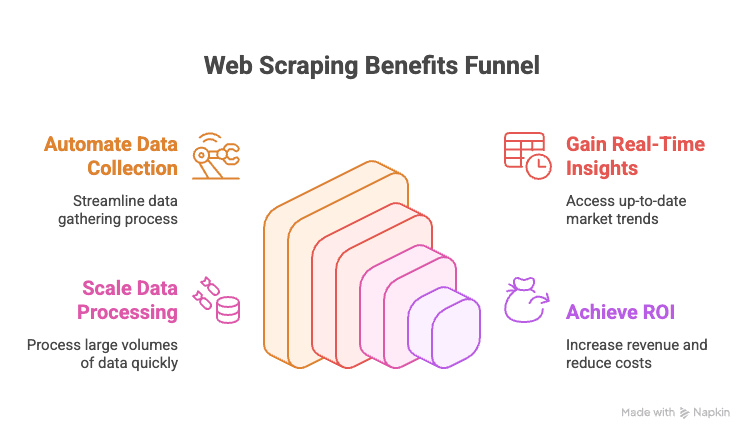

- Automatize a Coleta Manual de Dados: Chega de copiar e colar linha por linha de sites de concorrentes ou diretórios online.

- Informação em Tempo Real: Tenha acesso a preços, estoques ou tendências de mercado atualizados na hora.

- Escalabilidade: Extraia dados de milhares de páginas no tempo em que seu almoço esquenta no micro-ondas.

- Retorno sobre o Investimento: Empresas guiadas por dados relatam .

Veja alguns exemplos de uso que fazem diferença:

| Departamento | Exemplo de Uso | Valor Gerado |

|---|---|---|

| Vendas | Capturar leads de diretórios, enriquecer com e-mails | Listas de leads maiores e mais qualificadas |

| Marketing | Monitorar preços, promoções e avaliações de concorrentes | Campanhas mais inteligentes, respostas rápidas |

| E-commerce | Acompanhar preços, estoque e avaliações de produtos | Precificação dinâmica, alertas de estoque |

| Operações | Agregar dados de fornecedores, automatizar relatórios | Economia de tempo, menos erros manuais |

| Imobiliário | Coletar anúncios de imóveis em vários sites | Mais opções, resposta mais ágil ao cliente |

Resumindo: raspador web é o tempero secreto para decisões de negócio mais rápidas, inteligentes e competitivas.

Visão Geral: Principais Bibliotecas Python para Web Scraping (Com Exemplos)

Prometi um tour completo, então bora lá. O universo Python para raspador web é gigante — tem biblioteca pra tudo, desde baixar páginas simples até automação completa de navegação. Veja as principais opções, com exemplos de código:

urllib e urllib3: O Básico das Requisições HTTP

Essas são as ferramentas nativas do Python para fazer requisições HTTP. São mais simples, um pouco trabalhosas, mas confiáveis para tarefas básicas.

1import urllib3, urllib3.util

2http = urllib3.PoolManager()

3headers = urllib3.util.make_headers(user_agent="MyBot/1.0")

4response = http.request('GET', "<https://httpbin.org/json>", headers=headers)

5print(response.status) # Código de status HTTP

6print(response.data[:100]) # primeiros 100 bytes do conteúdoUse se quiser evitar instalar pacotes extras ou precisar de controle total. Mas, na maioria dos casos, requests é mais prático.

requests: A Biblioteca de Web Scraping Mais Querida do Python

Se raspador web em Python tivesse um mascote, seria a biblioteca requests. Simples, poderosa e resolve toda a parte chata do HTTP.

1import requests

2r = requests.get("<https://httpbin.org/json>", headers={"User-Agent": "MyBot/1.0"})

3print(r.status_code) # 200

4print(r.json()) # conteúdo JSON já processadoPor que todo mundo usa? Gerencia cookies, sessões, redirecionamentos e mais — você só se preocupa em extrair os dados. Só lembre: requests só baixa o HTML. Para extrair informações, use um parser como o BeautifulSoup.

BeautifulSoup: Extração de Dados e Parsing HTML Sem Dor de Cabeça

BeautifulSoup é a escolha clássica para analisar HTML no Python. É tolerante a erros, fácil para quem está começando e funciona muito bem junto com o requests.

1from bs4 import BeautifulSoup

2html = "<div class='product'><h2>Widget</h2><span class='price'>$19.99</span></div>"

3soup = BeautifulSoup(html, 'html.parser')

4title = soup.find('h2').text # "Widget"

5price = soup.find('span', class_='price').text # "$19.99"Ideal para projetos pequenos e médios ou para quem está começando. Para grandes volumes ou consultas mais complexas, vale conhecer o lxml.

lxml e XPath: Parsing HTML/XML Rápido e Preciso

Se você precisa de velocidade ou quer usar XPath (uma linguagem de consulta para XML/HTML), o lxml é a melhor pedida.

1from lxml import html

2doc = html.fromstring(page_content)

3prices = doc.xpath("//span[@class='price']/text()")Com XPath, você extrai dados com precisão cirúrgica. O lxml é rápido e eficiente, mas tem uma curva de aprendizado um pouco maior que o BeautifulSoup.

Scrapy: O Framework para Raspagem em Grande Escala

Scrapy é o peso-pesado para projetos grandes. É um framework completo — pense nele como o Django do raspador web.

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com/>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 }O Scrapy faz requisições assíncronas, segue links, gerencia pipelines e exporta dados em vários formatos. É robusto para grandes volumes, mas pode ser demais para scripts simples.

Selenium, Playwright e Pyppeteer: Raspando Sites Dinâmicos

Quando o site carrega dados via JavaScript, é preciso automação de navegador. Selenium e Playwright são os nomes mais conhecidos.

Exemplo com Selenium:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("<https://example.com/login>")

5driver.find_element(By.NAME, "username").send_keys("user123")

6driver.find_element(By.NAME, "password").send_keys("secret")

7driver.find_element(By.ID, "submit-btn").click()

8titles = [el.text for el in driver.find_elements(By.CLASS_NAME, "product-title")]Exemplo com Playwright:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://website.com>")

6 page.wait_for_selector(".item")

7 data = page.eval_on_selector(".item", "el => el.textContent")Essas ferramentas conseguem lidar com qualquer site que um humano acessaria, mas são mais lentas e pesadas que o scraping via HTTP puro. Use só quando realmente não tiver outro jeito.

MechanicalSoup, RoboBrowser, PyQuery, Requests-HTML: Outras Ferramentas Úteis

-

MechanicalSoup: Automatiza envio de formulários e navegação, baseado em Requests e BeautifulSoup.

1import mechanicalsoup 2browser = mechanicalsoup.StatefulBrowser() 3browser.open("<http://example.com/login>") 4browser.select_form('form#loginForm') 5browser["username"] = "user123" 6browser["password"] = "secret" 7browser.submit_selected() 8page = browser.get_current_page() 9print(page.title.text) -

RoboBrowser: Parecido com o MechanicalSoup, mas menos atualizado.

-

PyQuery: Parsing HTML no estilo jQuery.

1from pyquery import PyQuery as pq 2doc = pq("<div><p class='title'>Hello</p><p>World</p></div>") 3print(doc("p.title").text()) # "Hello" 4print(doc("p").eq(1).text()) # "World" -

Requests-HTML: Junta requisições HTTP, parsing e até renderização de JavaScript.

1from requests_html import HTMLSession 2session = HTMLSession() 3r = session.get("<https://example.com>") 4r.html.render(timeout=20) 5links = [a.text for a in r.html.find("a.story-link")]

Use quando quiser facilitar o trabalho com formulários, seletores CSS ou renderização leve de JS.

Asyncio e Aiohttp: Acelerando o Web Scraping em Python

Para raspar centenas ou milhares de páginas, requisições síncronas são lentas demais. aiohttp e asyncio permitem scraping concorrente.

1import aiohttp, asyncio

2async def fetch_page(session, url):

3 async with session.get(url) as resp:

4 return await resp.text()

5async def fetch_all(urls):

6 async with aiohttp.ClientSession() as session:

7 tasks = [fetch_page(session, url) for url in urls]

8 return await asyncio.gather(*tasks)

9urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

10html_pages = asyncio.run(fetch_all(urls))Assim, você pode baixar várias páginas ao mesmo tempo, acelerando muito o processo.

Bibliotecas Específicas: PRAW (Reddit), PyPDF2 e Outras

-

PRAW: Para extrair dados do Reddit via API.

1import praw 2reddit = praw.Reddit(client_id='XXX', client_secret='YYY', user_agent='myapp') 3for submission in reddit.subreddit("learnpython").hot(limit=5): 4 print(submission.title, submission.score) -

PyPDF2: Para extrair texto de arquivos PDF.

1from PyPDF2 import PdfReader 2reader = PdfReader("sample.pdf") 3num_pages = len(reader.pages) 4text = reader.pages[0].extract_text() -

Outras: Existem bibliotecas para Instagram, Twitter, OCR (Tesseract) e muito mais. Se a fonte de dados for diferente, provavelmente já existe uma biblioteca Python pra ela.

Tabela Comparativa: Bibliotecas Python para Scraping

| Ferramenta / Biblioteca | Facilidade de Uso | Velocidade & Escala | Melhor Para |

|---|---|---|---|

| Requests + BeautifulSoup | Fácil | Moderada | Iniciantes, sites estáticos, scripts rápidos |

| lxml (com XPath) | Média | Rápida | Grandes volumes, parsing complexo |

| Scrapy | Difícil | Muito Rápida | Empresas, grandes crawls, pipelines |

| Selenium / Playwright | Média | Lenta | Sites dinâmicos, interativos |

| aiohttp + asyncio | Média | Muito Rápida | Alto volume, páginas estáticas |

| MechanicalSoup | Fácil | Moderada | Login, formulários, sessões |

| PyQuery | Média | Rápida | Fãs de seletores CSS, manipulação DOM |

| Requests-HTML | Fácil | Variável | Pequenos projetos, JS leve |

Passo a Passo: Como Criar um Raspador Web em Python (Com Exemplos)

Vamos ver um exemplo prático: extrair listagens de produtos de um site de e-commerce (hipotético), lidando com paginação e exportando para CSV.

1import requests

2from bs4 import BeautifulSoup

3import csv

4base_url = "<https://example.com/products>"

5page_num = 1

6all_products = []

7while True:

8 url = base_url if page_num == 1 else f"{base_url}/page/{page_num}"

9 print(f"Scraping page: {url}")

10 response = requests.get(url, timeout=10)

11 if response.status_code != 200:

12 print(f"Page {page_num} returned status {response.status_code}, stopping.")

13 break

14 soup = BeautifulSoup(response.text, 'html.parser')

15 products = soup.find_all('div', class_='product-item')

16 if not products:

17 print("No more products found, stopping.")

18 break

19 for prod in products:

20 name_tag = prod.find('h2', class_='product-title')

21 price_tag = prod.find('span', class_='price')

22 name = name_tag.get_text(strip=True) if name_tag else "N/A"

23 price = price_tag.get_text(strip=True) if price_tag else "N/A"

24 all_products.append((name, price))

25 page_num += 1

26print(f"Collected {len(all_products)} products. Saving to CSV...")

27with open('products_data.csv', 'w', newline='', encoding='utf-8') as f:

28 writer = csv.writer(f)

29 writer.writerow(["Product Name", "Price"])

30 writer.writerows(all_products)

31print("Data saved to products_data.csv")O que está rolando aqui?

- Percorre as páginas, busca o HTML, extrai os produtos, coleta nome e preço e para quando não há mais produtos.

- Exporta os resultados para CSV para análise fácil.

Quer exportar para Excel? Use pandas:

1import pandas as pd

2df = pd.DataFrame(all_products, columns=["Product Name", "Price"])

3df.to_excel("products_data.xlsx", index=False)Lidando com Formulários, Logins e Sessões em Web Scraping Python

Muitos sites exigem login ou envio de formulário. Veja como lidar com isso:

Usando requests com sessão:

1session = requests.Session()

2login_data = {"username": "user123", "password": "secret"}

3session.post("<https://targetsite.com/login>", data=login_data)

4resp = session.get("<https://targetsite.com/account/orders>")Usando MechanicalSoup:

1import mechanicalsoup

2browser = mechanicalsoup.StatefulBrowser()

3browser.open("<http://example.com/login>")

4browser.select_form('form#login')

5browser["user"] = "user123"

6browser["pass"] = "secret"

7browser.submit_selected()Sessões ajudam a manter cookies e permanecer logado ao navegar por várias páginas.

Raspando Conteúdo Dinâmico e Páginas Renderizadas em JavaScript

Se os dados não aparecem no HTML (visualizar código-fonte mostra divs vazias), é preciso automação de navegador.

Exemplo com Selenium:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3driver.get("<http://examplesite.com/dashboard>")

4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, 'stats-table')))

5html = driver.page_sourceOu, se encontrar o endpoint da API que o JavaScript usa, basta usar requests para buscar o JSON direto — é muito mais rápido.

Exportando Dados Raspados: CSV, Excel, Bancos de Dados e Mais

-

CSV: Use o módulo

csvdo Python (veja acima). -

Excel: Use pandas ou openpyxl.

-

Google Sheets: Use a biblioteca

gspread.1import gspread 2gc = gspread.service_account(filename="credentials.json") 3sh = gc.open("My Data Sheet") 4worksheet = sh.sheet1 5worksheet.clear() 6worksheet.append_row(["Name", "Price"]) 7for name, price in all_products: 8 worksheet.append_row([name, price]) -

Bancos de Dados: Use

sqlite3,pymysql,psycopg2ou SQLAlchemy para bancos SQL. Para NoSQL, usepymongopara MongoDB.

Comparando Web Scraping em Python com Soluções No-Code: Por que Thunderbit é Destaque em 2025

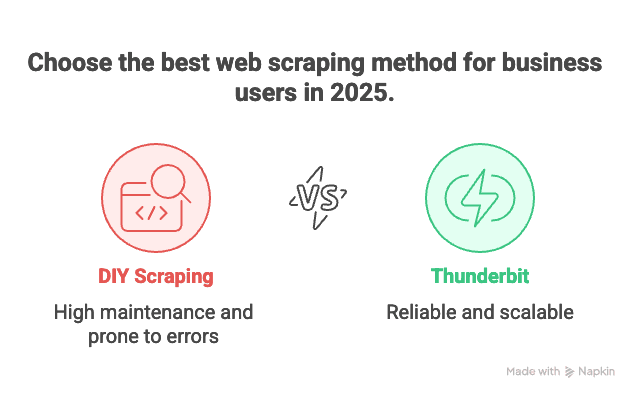

Agora, vamos falar do grande desafio: manutenção. Programar seus próprios raspadores é ótimo — até você precisar extrair dados de 100 sites diferentes, cada um com suas manias, e todos quebrarem na véspera do relatório. Já passei por isso.

Por isso sou fã do . Veja por que ele é minha principal dica para empresas em 2025:

- Sem Programação: O Thunderbit tem uma interface visual. Clique em “IA Sugere Campos”, ajuste as colunas, clique em “Raspar” e pronto. Sem Python, sem dor de cabeça, sem maratonas no Stack Overflow.

- Escala para Milhares de Páginas: Precisa extrair 10.000 produtos? O motor em nuvem do Thunderbit faz isso, sem você precisar ficar de olho em script.

- Zero Manutenção: Se você acompanha 100 sites de concorrentes, manter 100 scripts Python é um pesadelo. Com Thunderbit, basta escolher ou ajustar um template e a IA se adapta automaticamente a mudanças no layout.

- Suporte a Subpáginas e Paginação: O Thunderbit segue links para subpáginas, lida com paginação e até enriquece os dados visitando páginas de detalhes dos produtos.

- Templates Prontos: Para sites populares (Amazon, Zillow, LinkedIn, etc.), o Thunderbit já tem templates prontos. Um clique e os dados estão com você.

- Exportação Gratuita de Dados: Exporte para Excel, Google Sheets, Airtable ou Notion — sem custo extra.

Resumindo: se você só quer os dados, o Thunderbit é como ter um mordomo digital. Se você é dev e curte programar, Python ainda é um playground — mas às vezes, o que importa é resolver rápido.

Boas Práticas Éticas e Legais para Web Scraping com Python

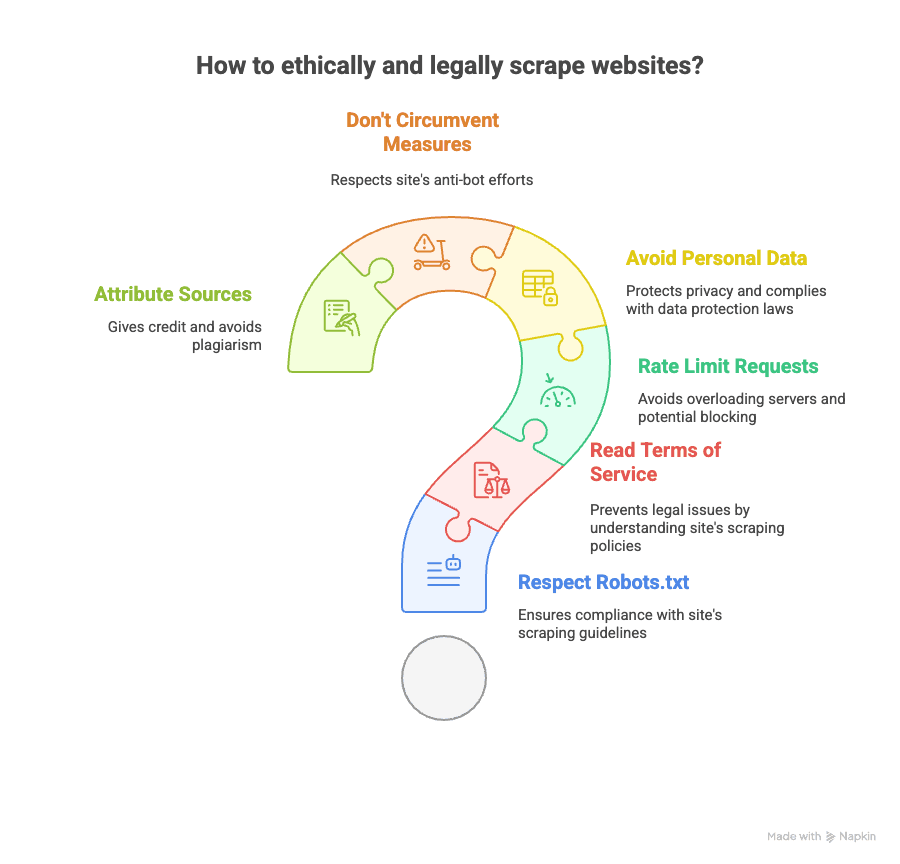

Raspador web é poderoso, mas exige responsabilidade. Veja como agir de forma ética e dentro da lei:

- Verifique o robots.txt: Respeite as regras do site sobre o que pode ser raspado.

- Leia os Termos de Uso: Alguns sites proíbem explicitamente a raspagem. Ignorar isso pode dar bloqueio ou até processo.

- Limite a Taxa de Acesso: Não sobrecarregue os servidores — coloque intervalos entre as requisições.

- Evite Dados Pessoais: Tenha cuidado ao coletar e-mails, telefones ou qualquer dado protegido por leis como GDPR ou LGPD.

- Não Burle Medidas Anti-Bot: Se o site usa CAPTCHA ou bloqueios pesados, pense duas vezes.

- Dê Crédito às Fontes: Se publicar análises, cite de onde vieram os dados.

Quer saber mais? Veja esta e as .

Onde Aprender Mais Sobre Web Scraping com Python (Cursos, Documentação, Comunidades)

Quer se aprofundar? Olha minha seleção de recursos:

- Documentação Oficial:

- Livros:

- “Web Scraping with Python” de Ryan Mitchell

- “Automate the Boring Stuff with Python” de Al Sweigart

- Guias Online:

- Vídeo Aulas:

- Canal do Corey Schafer no YouTube

- Comunidades:

E claro, se quiser ver como funciona raspagem sem código, dá uma olhada no ou no .

Conclusão & Principais Lições: Como Escolher a Solução de Web Scraping em 2025

- Web scraping com Python é super poderoso e flexível. Se você gosta de programar, quer controle total e não se importa com manutenção, é uma ótima escolha.

- Tem biblioteca Python pra tudo — páginas estáticas, conteúdo dinâmico, formulários, APIs, PDFs, o que você imaginar.

- Mas para a maioria das empresas, manter dezenas de scripts é um desafio. Se o objetivo é obter dados rápido, em escala e sem precisar ser expert em TI, é o caminho.

- A interface sem código e com IA do Thunderbit permite raspar qualquer site em poucos cliques, lidar com subpáginas e paginação, e exportar dados para onde quiser — sem precisar de Python.

- Ética e legalidade importam: Sempre confira as políticas do site, respeite a privacidade e faça scraping de forma responsável.

Ou seja, seja você fera em Python ou só quer os dados sem dor de cabeça, as ferramentas nunca estiveram tão boas em 2025. Meu conselho? Teste os dois caminhos, veja o que encaixa melhor no seu dia a dia e não tenha medo de deixar os robôs cuidarem do trabalho repetitivo — só garanta que eles sejam educados.

E se cansou de script quebrando, experimenta a . Seu eu do futuro (e seu estoque de café) vão agradecer.

Quer mais? Veja ou para tutoriais práticos e as estratégias mais atuais.