A web em 2025 virou um verdadeiro faroeste digital, mudando o tempo todo—num instante você está de olho nos preços dos concorrentes, no outro já está batendo de frente com JavaScript dinâmico e barreiras anti-bot que parecem coisa de filme de ação. Depois de anos criando ferramentas de automação para times de vendas e operações, posso dizer sem medo: web scraping não é mais um diferencial, virou habilidade básica para qualquer negócio. Com tomando decisões estratégicas baseadas em dados e o volume de informação online crescendo quase , transformar o caos da web em insights práticos é o que separa quem lidera de quem só corre atrás.

Mas sejamos realistas: fazer scraping não é mais como antigamente. Aquela fase de pegar HTML estático com meia dúzia de linhas de Python ficou no passado. Hoje, a gente encara conteúdo dinâmico, rolagem infinita e sistemas anti-bot cada vez mais espertos. Seja você iniciante ou já querendo turbinar sua stack de scraping, este guia traz as melhores práticas, ferramentas e jeitos de trabalhar para dominar scraping com Python em 2025—e ainda mostra como dar um gás nos seus projetos usando IA com ferramentas como o .

Do Básico ao Avançado: Fundamentos do Scraping com Python

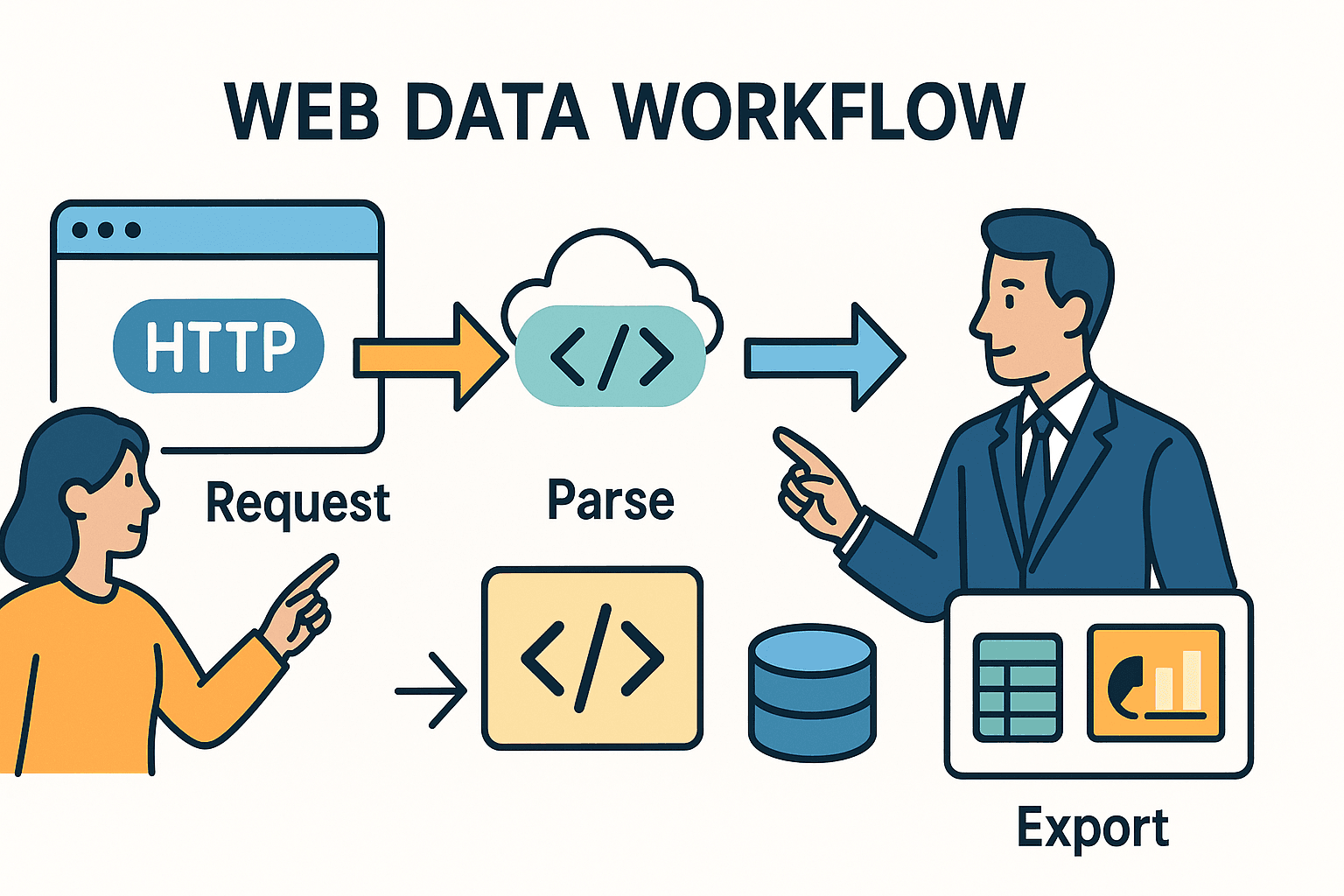

Vamos do começo. Raspador Web, no fim das contas, é automatizar o que você faria manualmente no navegador: acessar uma página, achar as informações que precisa e guardar para usar depois. Em Python, normalmente o caminho é:

- Fazer uma requisição HTTP (igualzinho ao que seu navegador faz).

- Analisar o HTML para encontrar os dados que interessam.

- Exportar ou processar esses dados—pode ser para uma planilha, banco de dados ou dashboard.

O segredo está nas ferramentas que você escolhe (e nos perrengues que enfrenta), que mudam conforme a complexidade do site e o que você quer alcançar.

Scraping com Python: Como Funciona

Pensa no scraping como pedir para um bibliotecário buscar um jornal e depois usar uma tesoura para recortar só as matérias que você quer. A biblioteca requests do Python é o bibliotecário—ela pega o HTML. O BeautifulSoup é a tesoura—te ajuda a recortar e extrair só o que interessa.

Agora, se o jornal estiver escrito com tinta invisível (alô, JavaScript!) ou as matérias estiverem espalhadas em várias páginas? Aí entram ferramentas mais avançadas—ou um toque de IA.

Comparando as Principais Ferramentas

Aqui vai um resumo das principais ferramentas de scraping em Python e quando usar cada uma:

| Ferramenta/Biblioteca | Quando Usar... | Vantagens | Desvantagens |

|---|---|---|---|

| Requests + BeautifulSoup | Páginas estáticas ou tarefas pequenas | Simples, rápido, ótimo para iniciantes. Controle total. | Não lida com JavaScript ou grandes volumes de dados. |

| Scrapy | Projetos grandes, muitos sites/páginas | Alta performance, crawling embutido, assíncrono, pipelines, tratamento robusto de erros. | Curva de aprendizado maior, configuração inicial. |

| Selenium/Playwright | Páginas com JavaScript, login ou ações do usuário | Permite extrair tudo que o navegador exibe. Lida com conteúdo dinâmico, logins, rolagem. | Mais lento, consome mais recursos, implantação mais complexa. |

| Thunderbit (IA) | Dados não estruturados, PDFs, imagens, ou sem código | IA detecta campos automaticamente, lida com subpáginas, exporta para Excel/Sheets, sem programação. | Menos personalizável para casos específicos, uso por créditos. |

Para a maioria dos negócios, começar com requests e BeautifulSoup é perfeito para sites simples e estáticos. Se a tarefa for maior ou mais complicada, Scrapy é o caminho. E quando aparecem obstáculos—conteúdo dinâmico, anti-bot ou dados bagunçados—ferramentas de IA como o salvam o dia.

Mapeando o Terreno: Passo a Passo para Scraping Complexo

Como sair do “quero esses dados” para um raspador robusto e que aguenta o tranco? Olha meu passo a passo testado na prática:

1. Inspecione e Entenda o Site-Alvo

Antes de sair programando, abre as Ferramentas do Desenvolvedor do navegador (F12 ou botão direito > Inspecionar). Ache os dados no HTML. Estão numa tabela? Em <div>s? Tem uma chamada de API trazendo JSON? Às vezes, o caminho mais fácil está ali na sua cara.

Dica: Se ao clicar em “próxima página” ou “carregar mais” aparece uma requisição de rede trazendo JSON, muitas vezes dá pra ignorar o HTML e ir direto nessa API com Python.

2. Faça um Protótipo em Uma Página

Comece pequeno. Use requests para buscar uma página e BeautifulSoup para extrair alguns campos. Imprima os resultados. Se for bloqueado ou faltar dados, tente adicionar headers (tipo User-Agent de navegador) ou veja se o conteúdo é carregado via JavaScript (aí, vá para o passo 3).

3. Lide com Conteúdo Dinâmico e Paginação

Se os dados não estão no HTML, provavelmente são carregados por JavaScript. O que fazer:

- Automação de Navegador: Use ou para abrir a página, esperar carregar e capturar o HTML renderizado.

- Chamada de API: Procure por requisições XHR na aba de rede. Se achar um endpoint retornando JSON, replique essa chamada com

requests. - Paginação: Para dados em várias páginas, faça um loop pelos números de página ou siga os links “Próximo”. Para rolagem infinita, use Selenium para rolar a página ou simule as chamadas de API disparadas pela rolagem.

4. Tratamento de Erros e Boas Práticas

Sites nem sempre gostam de raspadores. Para evitar bloqueios:

- Respeite o

robots.txt: Sempre confiraexample.com/robots.txtpara caminhos proibidos ou delays. - Limite de Taxa: Use

time.sleep()entre requisições. Se orobots.txtpedirCrawl-delay: 5, espere pelo menos 5 segundos. - User-Agent Personalizado: Identifique seu raspador de forma educada (ex:

"MeuRaspador/1.0 (seu@email.com)"). - Lógica de Retentativa: Envolva requisições em try/except. Tente de novo se falhar e diminua a frequência se receber HTTP 429 (Muitas Requisições).

5. Extraia e Limpe os Dados

Use BeautifulSoup ou seletores do Scrapy para extrair os campos. Tire espaços em branco, converta preços para número, ajuste datas e valide tudo. Para grandes volumes, use pandas para limpeza e deduplicação.

6. Scraping de Subpáginas

Muitas vezes, o ouro está nas páginas de detalhes. Extraia uma lista de links e visite cada um para pegar mais dados. Em Python, é só iterar pelas URLs e buscar cada página. No , basta usar o recurso “Raspar Subpáginas”—a IA visita cada subpágina e turbina seu dataset.

7. Exporte e Automatize

Exporte os dados limpos para CSV, Excel, Google Sheets ou banco de dados. Para tarefas recorrentes, agende seu script com cron, Airflow ou (se usar Thunderbit) configure uma raspagem agendada na nuvem com linguagem natural (“toda segunda-feira às 9h”).

Thunderbit: Quando a IA Potencializa seu Scraping com Python

Vamos direto ao ponto: tem hora que nem o melhor código Python resolve dados desestruturados ou protegidos. É aí que entra o .

Como o Thunderbit Complementa o Python

Thunderbit é uma extensão do Chrome com IA que lê páginas web (ou PDFs, imagens etc.) e gera dados estruturados—sem precisar programar. Veja como uso junto com Python:

- Para Dados Não Estruturados: Se pego um PDF, imagem ou site com HTML bagunçado, deixo a IA do Thunderbit analisar. Ele extrai tabelas de PDFs, textos de imagens e até sugere campos automaticamente.

- Para Subpáginas e Etapas Múltiplas: O recurso “Raspar Subpáginas” do Thunderbit economiza muito tempo. Extraio uma página de lista, deixo a IA visitar cada detalhe e juntar os resultados—sem precisar criar loops aninhados ou gerenciar estados.

- Para Exportação: O Thunderbit exporta direto para Excel, Google Sheets, Notion ou Airtable. Depois, posso importar esses dados para meu pipeline Python para análises ou relatórios.

Exemplo Prático: Python + Thunderbit em Ação

Imagina que estou monitorando anúncios imobiliários. Uso Python e Scrapy para coletar URLs de anúncios em vários sites. Mas um deles só libera detalhes em PDFs para download. Em vez de criar um parser de PDF, mando os arquivos para o Thunderbit, deixo a IA extrair as tabelas e exporto para CSV. Depois, junto tudo no Python para uma análise de mercado completa.

Ou, se estou montando uma lista de leads para vendas. Uso Python para raspar URLs de empresas e o Thunderbit para extrair e-mails e telefones (recursos gratuitos!) de cada site—sem precisar de regex.

Construindo um Fluxo de Scraping Sustentável: Do Código ao Pipeline

Um script pontual resolve problemas rápidos, mas a maioria das demandas de scraping nos negócios é recorrente. Veja como estruturo um fluxo sustentável e escalável:

O Framework CCCD: Rastrear, Coletar, Limpar, Depurar

- Rastrear: Junte todas as URLs-alvo (de sitemaps, páginas de busca ou listas).

- Coletar: Extraia dados de cada URL (com Python, Thunderbit ou ambos).

- Limpar: Normalize, deduplicate e valide os dados.

- Depurar/Monitorar: Registre cada execução, trate erros e configure alertas para falhas ou anomalias.

Pensa como um pipeline:

URLs → [Rastreador] → [Raspador] → [Limpador] → [Exportador] → [Plataforma de Negócios]

Agendamento e Monitoramento

- Com Python: Use cron, Airflow ou agendadores em nuvem para rodar scripts periodicamente. Registre saídas, envie alertas por e-mail ou Slack em caso de erro.

- Com Thunderbit: Use o agendador integrado—basta digitar “toda segunda-feira às 9h” e o Thunderbit executa a raspagem na nuvem e exporta os dados para onde você quiser.

Documentação e Repasse

Mantenha o código sob controle de versão (Git), documente o fluxo e garanta que pelo menos outra pessoa saiba rodar ou atualizar o pipeline. Em fluxos mistos Python/Thunderbit, registre qual ferramenta lida com cada site e onde os dados são entregues (ex: “Thunderbit raspa o Site C para o Google Sheets, Python une tudo semanalmente”).

Ética e Conformidade: Scraping Responsável em 2025

Com grande poder de scraping vem grande responsabilidade. Veja como agir de forma ética e legal:

Robots.txt e Limite de Taxa

- Verifique o robots.txt: Sempre confira o robots.txt do site para caminhos proibidos e delays. Use o

robotparserdo Python para automatizar. - Scraping Educado: Adicione intervalos entre requisições, especialmente se houver

Crawl-delay. Nunca sobrecarregue o site com acessos rápidos. - User-Agent: Identifique seu raspador de forma honesta. Não finja ser o Googlebot ou outro navegador.

Privacidade de Dados e Conformidade

- GDPR/CCPA: Se coletar dados pessoais (nomes, e-mails, telefones), siga as leis de privacidade. Extraia só o necessário, proteja os dados e esteja pronto para removê-los se pedirem.

- Termos de Uso: Não raspe áreas protegidas por login sem permissão. Muitos ToS proíbem acesso automatizado—violar pode dar ban ou até problema jurídico.

- Apenas Dados Públicos: Fique só nas informações públicas. Não tente acessar dados privados, protegidos por direitos autorais ou sensíveis.

Checklist de Conformidade

- [ ] Conferiu o robots.txt para regras e delays

- [ ] Adicionou limite de taxa e User-Agent personalizado

- [ ] Raspa só dados públicos e não sensíveis

- [ ] Trata dados pessoais conforme a lei

- [ ] Não viola ToS ou direitos autorais

Erros Comuns e Dicas de Depuração: Tornando seu Scraping Robusto

Mesmo os melhores raspadores encaram problemas. Veja os mais comuns—e como costumo resolver:

| Tipo de Erro | Sintoma/Mensagem | Dica de Depuração |

|---|---|---|

| HTTP 403/429/500 | Bloqueio, limite de taxa ou erro do servidor | Verifique headers, reduza a velocidade, alterne IPs ou use proxies. Respeite delays de crawling. |

| Dados Ausentes/NoneType | Dados não encontrados no HTML | Imprima e inspecione o HTML. Pode ter mudado a estrutura ou ser página de bloqueio. |

| Dados Renderizados em JS | Dados ausentes no HTML estático | Use Selenium/Playwright ou encontre a chamada de API subjacente. |

| Problemas de Parsing/Codificação | Erros de unicode, caracteres estranhos | Defina a codificação correta, use .text ou html.unescape(). |

| Duplicatas/Inconsistências | Dados repetidos ou desencontrados | Deduplicate por ID único ou URL. Valide a integridade dos campos. |

| Anti-Bot/CAPTCHA | Página de CAPTCHA ou login obrigatório | Reduza a velocidade, use automação de navegador ou recorra ao Thunderbit/IA para casos difíceis. |

Fluxo de Depuração:

- Imprima o HTML bruto quando algo der errado.

- Use as DevTools do navegador para comparar o que o script vê com o navegador.

- Registre cada etapa—URLs, códigos de status, número de itens extraídos.

- Teste em um pequeno conjunto antes de escalar.

Projetos Avançados: Coloque o Scraping em Prática

Pronto para colocar a mão na massa? Olha só ideias de projetos reais:

1. Painel de Monitoramento de Preços para E-commerce

Extraia preços e estoque da Amazon, eBay e Walmart. Lide com anti-bot, conteúdo dinâmico e exporte diariamente para o Google Sheets para análise de tendências. Use para resultados rápidos.

2. Agregador de Vagas de Emprego

Junte anúncios do Indeed e sites de nicho. Extraia títulos, empresas, localizações e datas. Lide com paginação e remova duplicatas por ID da vaga. Agende execuções diárias e exporte para o Airtable.

3. Extrator de Contatos para Geração de Leads

Com uma lista de URLs de empresas, extraia e-mails e telefones das páginas iniciais e de contato. Use regex no Python ou os extratores gratuitos do Thunderbit para resultados instantâneos. Exporte para Excel para o time de vendas.

4. Comparador de Anúncios Imobiliários

Extraia anúncios do Zillow e Realtor.com para uma região específica. Normalize endereços e preços, compare tendências e visualize no Google Sheets.

5. Monitor de Menções em Redes Sociais

Acompanhe menções de marcas no Reddit usando a API JSON. Agregue contagem de posts, analise sentimento e exporte séries temporais para insights de marketing.

Conclusão: O Essencial do Scraping com Python em 2025

Recapitulando os pontos-chave:

- Raspador Web é mais importante do que nunca para inteligência de negócios, vendas e operações. A web é um baú de tesouros—se você souber minerar.

- Python é seu canivete suíço: Comece simples com

requestseBeautifulSoup, escale com Scrapy e use automação de navegador para sites dinâmicos. - Ferramentas de IA como Thunderbit são seu trunfo para scraping sem código, dados complexos ou desestruturados. Misture Python e IA para máxima eficiência.

- Boas práticas fazem diferença: Inspecione antes, escreva código modular, trate erros, limpe os dados e automatize o fluxo.

- Conformidade não é opcional: Sempre confira o robots.txt, respeite leis de privacidade e raspe de forma ética.

- Seja adaptável: A web muda—monitore seus raspadores, depure com frequência e esteja pronto para ajustar sua abordagem.

O futuro do raspador web é híbrido, ético e voltado para negócios. Seja você iniciante ou veterano, continue aprendendo, seja curioso e deixe os dados impulsionarem seu próximo grande resultado.

Apêndice: Recursos e Ferramentas para Scraping com Python

Aqui está minha lista de referência para aprender e resolver perrengues:

- – HTTP para humanos, com tudo que você precisa.

- – Aprenda a destrinchar HTML como um ninja.

- – Para scraping em larga escala e produção.

- / – Para automação de navegador e conteúdo dinâmico.

- – O Raspador Web IA mais fácil para negócios.

- – Tutoriais, estudos de caso e melhores práticas de scraping com IA.

- – Fique por dentro de conformidade e ética.

- / ** – Comunidade para tirar dúvidas e achar soluções.

E se quiser ver como o Thunderbit pode facilitar sua vida no scraping, dá uma olhada no nosso para ver demonstrações e tutoriais.

Perguntas Frequentes

1. Qual a melhor biblioteca Python para raspador web em 2025?

Para páginas estáticas e tarefas pequenas, requests + BeautifulSoup ainda é a dupla campeã. Para scraping em larga escala ou multi-páginas, é o ideal. Para conteúdo dinâmico, use ou . Para dados desestruturados ou difíceis, ferramentas de IA como o são indispensáveis.

2. Como lidar com sites dinâmicos ou pesados em JavaScript?

Use ferramentas de automação de navegador como Selenium ou Playwright para renderizar a página e extrair os dados. Ou então, inspecione a aba de rede para achar chamadas de API que retornam JSON—geralmente é mais fácil e confiável raspar assim.

3. Raspador web é legal?

Raspar dados públicos geralmente é permitido nos EUA, mas sempre confira o , respeite os termos do site e siga leis de privacidade como GDPR/CCPA. Nunca raspe informações privadas, protegidas por direitos autorais ou sensíveis.

4. Como automatizar e agendar fluxos de scraping?

Para scripts Python, use cron, Airflow ou agendadores em nuvem. Para automação sem código, o tem agendamento integrado—basta descrever o cronograma em português e deixar rodar na nuvem.

5. O que fazer se meu raspador parar de funcionar?

Primeiro, veja se a estrutura do site mudou ou se você foi bloqueado (HTTP 403/429). Inspecione o HTML, atualize os seletores, diminua a frequência das requisições e confira medidas anti-bot. Se continuar com problema, experimente os recursos de IA do Thunderbit ou mude para automação de navegador.

Boas raspagens—que seus dados estejam sempre limpos, em conformidade e prontos para uso. Se quiser ver como o Thunderbit pode entrar no seu fluxo, e experimente. E para mais dicas, o está sempre aberto para você.