Vamos falar a real: ninguém acorda empolgado para copiar e colar centenas de linhas de preços de produtos numa folha de cálculo. (Se esse é o teu caso, parabéns pela disposição — e já recomendo uma boa munhequeira!) Seja no comercial, operações ou só tentando manter o teu negócio na frente da concorrência, aposto que já sentiste na pele o desafio de extrair dados de sites. Hoje em dia, tudo gira em torno de dados online, e a procura por automação só aumenta — .

Depois de anos a trabalhar com SaaS e automação, já vi de tudo: desde macros épicas no Excel até scripts Python feitos à pressa de madrugada. Neste guia, vou mostrar-te como usar um parser HTML em Python para extrair dados reais (sim, vamos buscar as avaliações de filmes do IMDb juntos) — e também porque, em 2025, há um caminho bem mais prático: ferramentas com IA como o , que eliminam o código e entregam os insights diretos para ti.

O que é um Parser HTML e Por Que Usar em Python?

Vamos ao básico: para que serve um parser HTML? Imagina um bibliotecário digital. Ele lê aquele HTML todo desarrumado de uma página e organiza tudo numa estrutura de árvore, facilitando encontrar só o que interessa — títulos, preços, links — sem te perderes no meio de tags e divs.

Python é a linguagem de eleição para esta tarefa, e não é por acaso. É fácil de ler, acessível para quem está a começar e tem uma enorme variedade de bibliotecas para raspagem e análise de dados. Na verdade, , graças à sua curva de aprendizagem suave e comunidade ativa.

Principais Bibliotecas de Parser HTML em Python

Aqui estão os nomes mais conhecidos quando o assunto é parser HTML em Python:

- BeautifulSoup: O clássico, perfeito para quem está a começar.

- lxml: Super rápido e potente, com recursos avançados de pesquisa.

- html5lib: Aguenta HTML desorganizado, como um browser.

- PyQuery: Permite usar seletores ao estilo jQuery dentro do Python.

- HTMLParser: O parser nativo do Python — sempre disponível, mas mais básico.

Cada uma tem as suas particularidades, mas todas ajudam a transformar HTML cru em dados organizados.

Principais Aplicações: Como Empresas se Beneficiam de Parsers HTML em Python

Extrair dados da web não é só para programadores ou cientistas de dados. Hoje, é uma atividade essencial para negócios, especialmente em vendas e operações. Vê alguns exemplos:

| Caso de Uso (Setor) | Dados Extraídos | Benefício para o Negócio |

|---|---|---|

| Monitorização de Preços (Retalho) | Preços de concorrentes, stock | Preços dinâmicos, margens melhores (fonte) |

| Inteligência de Produtos da Concorrência | Listagens, avaliações, disponibilidade | Identificar oportunidades, gerar leads (fonte) |

| Geração de Leads (Vendas B2B) | Nome de empresas, e-mails, contactos | Prospecção automática, crescimento do funil (fonte) |

| Análise de Sentimento (Marketing) | Publicações, avaliações, notas | Feedback em tempo real, identificar tendências (fonte) |

| Agregação Imobiliária | Listagens, preços, agentes | Análise de mercado, estratégia de preços (fonte) |

| Inteligência em Recrutamento | Perfis, salários | Busca de talentos, comparação salarial (fonte) |

Resumindo: se ainda estás a copiar dados à mão, estás a perder tempo e dinheiro.

Conhece as Principais Bibliotecas de Parser HTML em Python

Vamos pôr as mãos na massa. Aqui tens uma comparação rápida das bibliotecas mais populares de parser HTML em Python, para te ajudar a escolher a melhor para o teu projeto:

| Biblioteca | Facilidade de Uso | Velocidade | Flexibilidade | Manutenção | Indicado Para |

|---|---|---|---|---|---|

| BeautifulSoup | ⭐⭐⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ | Moderada | Iniciantes, HTML desorganizado |

| lxml | ⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | Moderada | Velocidade, XPath, grandes volumes |

| html5lib | ⭐⭐⭐ | ⭐ | ⭐⭐⭐⭐⭐ | Baixa | Parsing tipo browser, HTML partido |

| PyQuery | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | Moderada | Fãs de jQuery, seletores CSS |

| HTMLParser | ⭐⭐⭐ | ⭐⭐⭐ | ⭐ | Baixa | Tarefas simples, embutido |

BeautifulSoup: O Querido dos Iniciantes

BeautifulSoup é o “olá mundo” dos parsers HTML. Tem uma sintaxe simples, documentação clara e lida bem com HTML malformado (). O lado menos bom? Não é o mais rápido, especialmente em páginas grandes ou complexas, e não suporta seletores avançados como XPath de forma nativa.

lxml: Rápido e Potente

Se precisas de desempenho ou queres usar consultas XPath, lxml é a escolha certa (). É construído sobre bibliotecas C, por isso é muito rápido, mas pode ser mais chato de instalar e tem uma curva de aprendizagem maior.

Outras Opções: html5lib, PyQuery e HTMLParser

- html5lib: Faz parsing como um browser — ótimo para HTML partido, mas é lento ().

- PyQuery: Permite usar seletores ao estilo jQuery no Python, ideal para quem vem do front-end ().

- HTMLParser: Opção nativa do Python — rápida e sempre disponível, mas com menos funcionalidades.

Passo 1: Preparar o Ambiente para o Parser HTML em Python

Antes de começares a extrair dados, é preciso preparar o ambiente Python. Vê como fazer:

-

Instala o Python: Vai a se ainda não tens.

-

Instala o pip: Normalmente já vem com Python 3.4+, mas confirma com

pip --versionno terminal. -

Instala as bibliotecas (vamos usar BeautifulSoup e requests neste tutorial):

1pip install beautifulsoup4 requests lxmlbeautifulsoup4é o parser.requestsserve para ir buscar páginas web.lxmlé um parser rápido que pode ser usado pelo BeautifulSoup.

-

Confirma a instalação:

1python -c "import bs4, requests, lxml; print('Tudo certo!')"

Dicas para resolver problemas:

- Se aparecer erro de permissão, tenta

pip install --user ... - No Mac/Linux, pode ser preciso usar

python3epip3. - Se aparecer “ModuleNotFoundError”, confirma a grafia e o ambiente Python.

Passo 2: Extrair Dados de uma Página Web com Python

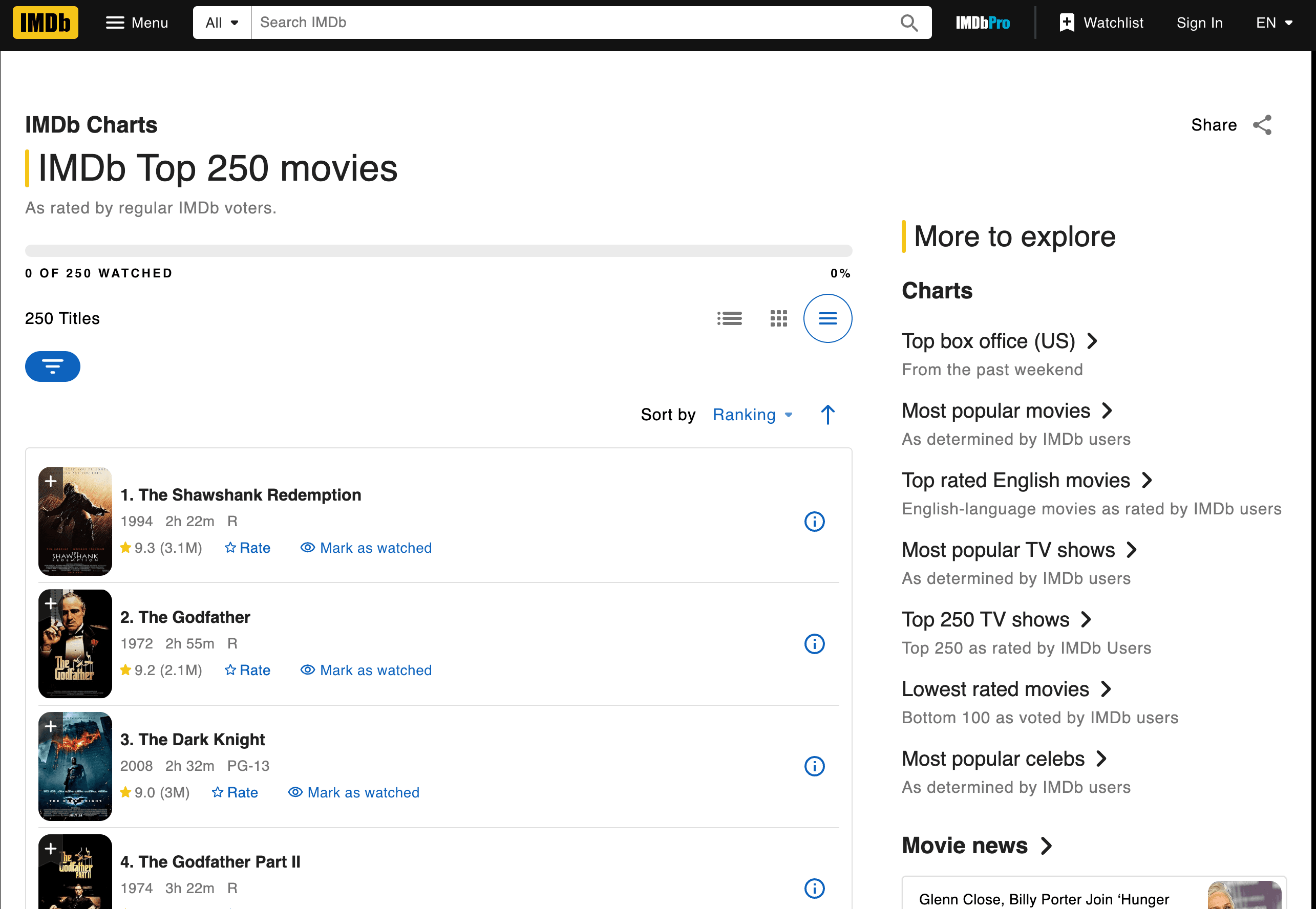

Vamos pôr a mão na massa e raspar a lista dos 250 melhores filmes do IMDb. Vamos buscar títulos, anos e avaliações.

Buscar e Interpretar a Página

Aqui tens um exemplo de script passo a passo:

1import requests

2from bs4 import BeautifulSoup

3url = "<https://www.imdb.com/chart/top/>"

4resp = requests.get(url)

5soup = BeautifulSoup(resp.text, 'html.parser')

6# Encontrar todas as células de título e avaliação

7title_cells = soup.find_all('td', class_='titleColumn')

8rating_cells = soup.find_all('td', class_='ratingColumn imdbRating')

9# Iterar pelos 3 primeiros filmes como exemplo

10for i in range(3):

11 title_cell = title_cells[i]

12 rating_cell = rating_cells[i]

13 title = title_cell.a.text

14 year = title_cell.span.text.strip("()")

15 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

16 print(f"{i+1}. {title} ({year}) -- Avaliação: {rating}")O que está a acontecer aqui?

- Usamos

requests.get()para ir buscar a página. - O

BeautifulSoupfaz o parsing do HTML. - Encontramos os elementos

<td>relevantes pelas classes. - Extraímos o texto de título, ano e avaliação.

Saída:

11. Um Sonho de Liberdade (1994) -- Avaliação: 9.3

22. O Padrinho (1972) -- Avaliação: 9.2

33. O Cavaleiro das Trevas (2008) -- Avaliação: 9.0Extrair Dados: Encontrar Títulos, Avaliações e Mais

Como saber que tags e classes usar? Basta inspecionar o HTML da página do IMDb (botão direito > Inspecionar Elemento no browser). Procura padrões — aqui, cada filme está num <td class="titleColumn"> e as avaliações em <td class="ratingColumn imdbRating"> ().

Dica de ouro: Ao raspar outro site, começa sempre por inspecionar a estrutura do HTML e identificar classes ou tags únicas.

Guardar e Exportar os Resultados

Vamos guardar os dados num ficheiro CSV:

1import csv

2movies = []

3for i in range(len(title_cells)):

4 title_cell = title_cells[i]

5 rating_cell = rating_cells[i]

6 title = title_cell.a.text

7 year = title_cell.span.text.strip("()")

8 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

9 movies.append([title, year, rating])

10with open('imdb_top250.csv', 'w', newline='', encoding='utf-8') as f:

11 writer = csv.writer(f)

12 writer.writerow(['Título', 'Ano', 'Avaliação'])

13 writer.writerows(movies)Dicas de limpeza:

- Usa

.strip()para tirar espaços. - Trata dados em falta com verificações

if. - Para exportar para Excel, abre o CSV no Excel ou usa

pandaspara gerar ficheiros.xlsx.

Passo 3: Lidar com Mudanças no HTML e Desafios de Manutenção

Aqui começa o verdadeiro desafio. Os sites mudam de layout constantemente — às vezes só para dificultar a vida de quem raspa dados. Se o IMDb trocar class="titleColumn" por class="movieTitle", o teu script vai devolver resultados vazios. Já passei por isso.

Quando os Scripts Deixam de Funcionar: Problemas do Mundo Real

Problemas comuns:

- Seletores não encontrados: O código não encontra a tag/classe indicada.

- Resultados vazios: A estrutura da página mudou ou o conteúdo agora é carregado por JavaScript.

- Erros HTTP: O site implementou barreiras contra bots.

Como resolver:

- Confirma se o HTML que estás a analisar é igual ao que aparece no browser.

- Atualiza os seletores para refletir a nova estrutura.

- Se o conteúdo for dinâmico, pode ser preciso usar automação de browser (como Selenium) ou procurar um endpoint de API.

O maior desafio? Se raspas 10, 50 ou 500 sites diferentes, podes acabar a gastar mais tempo a corrigir scripts do que a analisar dados ().

Passo 4: Escalar — Os Custos Escondidos da Raspagem Manual com Python

Imagina que queres raspar não só o IMDb, mas também Amazon, Zillow, LinkedIn e outros sites. Cada um precisa do seu próprio script. E sempre que um site muda, lá vais tu mexer no código.

Os custos invisíveis:

- Manutenção: .

- Infraestrutura: Vais precisar de proxies, tratamento de erros e monitorização.

- Desempenho: Escalar implica lidar com concorrência, limites de acesso e mais.

- Qualidade: Mais scripts = mais pontos de falha.

Para equipas não técnicas, isto torna-se rapidamente impossível. É como contratar um batalhão de estagiários para copiar dados o dia todo — só que, neste caso, os estagiários são scripts Python que “adoecem” sempre que um site muda.

Para Além dos Parsers HTML em Python: Conhece o Thunderbit, a Alternativa com IA

Agora vem a parte interessante. E se pudesses saltar o código, esquecer a manutenção e simplesmente obter os dados que precisas — mesmo que o site mude?

É exatamente isso que o faz. É uma extensão Chrome de Raspador Web IA que permite extrair dados estruturados de qualquer site em dois cliques. Sem Python, sem scripts, sem dores de cabeça.

Parsers HTML em Python vs. Thunderbit: Comparativo

| Aspeto | Parsers HTML em Python | Thunderbit (vê preços) |

|---|---|---|

| Tempo de Configuração | Alto (instalar, programar, depurar) | Baixo (instalar extensão, clicar) |

| Facilidade de Uso | Exige programação | Sem código — só apontar e clicar |

| Manutenção | Alta (scripts quebram com frequência) | Baixa (IA adapta-se automaticamente) |

| Escalabilidade | Complexa (scripts, proxies, infra) | Nativa (raspagem em nuvem, lotes) |

| Enriquecimento de Dados | Manual (mais código) | Nativo (rotulagem, limpeza, tradução, subpáginas) |

Porquê construir do zero se a IA já resolve o problema?

Por Que Optar por IA na Extração de Dados da Web?

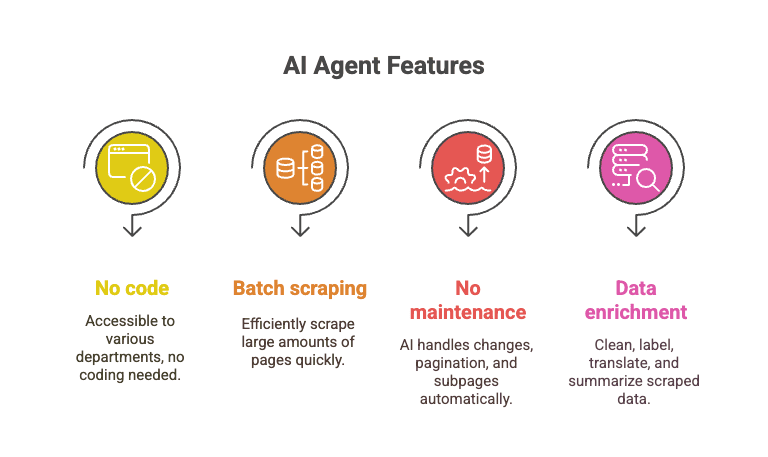

O agente de IA do Thunderbit lê a página, entende a estrutura e adapta-se a mudanças. É como ter um super-estagiário que nunca dorme e não se queixa quando mudam o nome das classes.

- Sem código: Qualquer pessoa pode usar — vendas, operações, marketing, etc.

- Raspagem em lote: Extrai 10.000+ páginas no tempo que levarias a depurar um script Python.

- Zero manutenção: A IA trata de mudanças de layout, paginação, subpáginas e mais.

- Enriquecimento de dados: Limpa, rotula, traduz e resume dados enquanto raspa.

Imagina extrair toda a lista dos 250 melhores do IMDb, mais detalhes de cada filme e avaliações, em poucos cliques — enquanto os teus scripts Python ainda estão presos no erro “NoneType”.

Passo a Passo: Extrair Avaliações de Filmes do IMDb com Thunderbit

Vê como o Thunderbit resolve a mesma tarefa do IMDb:

- Instala a .

- Vai à .

- Clica no ícone do Thunderbit.

- Clica em “IA Sugerir Campos”. O Thunderbit lê a página e sugere colunas (Título, Ano, Avaliação).

- Revê ou ajusta as colunas, se quiseres.

- Clica em “Raspar”. O Thunderbit extrai todas as 250 linhas em segundos.

- Exporta para Excel, Google Sheets, Notion ou CSV — como preferires.

E está feito. Sem código, sem depuração, sem listas vazias misteriosas.

Queres ver na prática? Espreita o para tutoriais em vídeo, ou lê o nosso para outro exemplo real.

Conclusão: Qual a Melhor Ferramenta para as Tuas Necessidades de Dados Web?

Parsers HTML em Python como BeautifulSoup e lxml são poderosos, flexíveis e gratuitos. São ótimos para quem gosta de programar e quer controlo total. Mas exigem aprendizagem, manutenção constante e têm custos escondidos — especialmente quando a escala aumenta.

Para equipas de negócio, vendas ou quem só quer os dados (e não o código), ferramentas com IA como o são um descanso. Permitem extrair, limpar e enriquecer dados da web em escala, sem programação e sem dores de cabeça.

O meu conselho? Usa Python se gostas de programar e precisas de personalização total. Mas se valorizas o teu tempo (e a tua sanidade), experimenta o Thunderbit. Para quê construir e manter scripts se a IA pode fazer o trabalho pesado por ti?

Queres aprender mais sobre raspagem de dados, extração e automação com IA? Explora outros tutoriais no , como ou .